Một bài viết kỹ thuật có tiêu đề “WWW: Tính toán trong bộ nhớ là gì, khi nào, ở đâu” được xuất bản bởi các nhà nghiên cứu tại Đại học Purdue.

Tóm tắt:

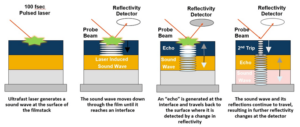

“Tính toán trong bộ nhớ (CiM) đã nổi lên như một giải pháp hấp dẫn nhằm giảm bớt chi phí di chuyển dữ liệu cao trong các máy von Neumann. CiM có thể thực hiện các phép toán nhân ma trận tổng quát (GEMM) song song ồ ạt trong bộ nhớ, tính toán chủ yếu trong suy luận Machine Learning (ML). Tuy nhiên, việc tái sử dụng bộ nhớ để tính toán đặt ra các câu hỏi chính về 1) Loại CiM nào sẽ được sử dụng: Với vô số CiM tương tự và kỹ thuật số, việc xác định tính phù hợp của chúng từ góc độ hệ thống là cần thiết. 2) Khi nào nên sử dụng CiM: Suy luận ML bao gồm các khối lượng công việc có nhiều yêu cầu về bộ nhớ và điện toán khác nhau, khiến khó xác định khi nào CiM có lợi hơn các lõi xử lý tiêu chuẩn. 3) Tích hợp CiM ở đâu: Mỗi cấp độ bộ nhớ có băng thông và dung lượng khác nhau, điều này ảnh hưởng đến việc di chuyển dữ liệu và lợi ích cục bộ của việc tích hợp CiM.

Trong bài viết này, chúng tôi khám phá câu trả lời cho những câu hỏi liên quan đến tích hợp CiM để tăng tốc suy luận ML. Chúng tôi sử dụng Timeloop-Accelergy để đánh giá sớm các nguyên mẫu CiM ở cấp độ hệ thống, bao gồm cả nguyên mẫu tương tự và kỹ thuật số. Chúng tôi tích hợp CiM vào các cấp bộ nhớ đệm khác nhau trong kiến trúc cơ bản giống Nvidia A100 và điều chỉnh luồng dữ liệu cho các khối lượng công việc ML khác nhau. Các thử nghiệm của chúng tôi cho thấy kiến trúc CiM cải thiện hiệu quả sử dụng năng lượng, đạt được mức năng lượng thấp hơn tới 0.12 lần so với mức cơ sở đã thiết lập với độ chính xác INT-8 và tăng hiệu suất lên tới 4 lần khi xen kẽ và sao chép trọng lượng. Công việc được đề xuất cung cấp thông tin chi tiết về loại CiM sẽ sử dụng cũng như thời điểm và vị trí để tích hợp nó một cách tối ưu trong hệ thống phân cấp bộ nhớ đệm để tăng tốc GEMM.”

Tìm giấy kỹ thuật tại đây. Được xuất bản vào tháng 2023 năm XNUMX (bản in trước).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty và Kaushik Roy. “WWW: Tính toán trong bộ nhớ cái gì, khi nào, ở đâu.” bản in trước arXiv arXiv:2312.15896 (2023).

Đọc liên quan

Tăng hiệu quả sử dụng năng lượng AI bằng tính toán trong bộ nhớ

Cách xử lý khối lượng công việc ở quy mô zetta và duy trì trong ngân sách điện năng cố định.

Mô hình hóa tính toán trong bộ nhớ với hiệu quả sinh học

AI sáng tạo buộc các nhà sản xuất chip sử dụng tài nguyên điện toán một cách thông minh hơn.

SRAM trong AI: Tương lai của bộ nhớ

Tại sao SRAM được xem là yếu tố quan trọng trong kiến trúc điện toán mới và truyền thống.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- : có

- :là

- :Ở đâu

- $ LÊN

- 1

- 2023

- a

- tăng tốc

- đạt được

- AI

- giảm bớt

- an

- và

- câu trả lời

- kiến trúc

- AS

- At

- Băng thông

- Baseline

- mang lại lợi ích

- Lợi ích

- cả hai

- ngân sách

- by

- bộ nhớ cache

- CAN

- Sức chứa

- thuyết phục

- tính toán

- Tính

- Chi phí

- quan trọng

- dữ liệu

- Tháng mười hai

- xác định

- khác nhau

- khó khăn

- kỹ thuật số

- có ưu thế

- mỗi

- Đầu

- hiệu quả

- thành phần

- xuất hiện

- năng lượng

- hiệu quả năng lượng

- thành lập

- đánh giá

- thí nghiệm

- khám phá

- cố định

- Trong

- Lực lượng

- từ

- tương lai

- thu nhập

- Tổng Quát

- được

- tại đây

- hệ thống cấp bậc

- Cao

- Tuy nhiên

- HTTPS

- xác định

- nâng cao

- in

- bao gồm

- Bao gồm

- những hiểu biết

- tích hợp

- hội nhập

- trong

- IT

- jpg

- Key

- học tập

- Cấp

- niveaux

- thấp hơn

- máy

- học máy

- Máy móc

- Làm

- ồ ạt

- Matrix

- Bộ nhớ

- ML

- chi tiết

- phong trào

- nhiều

- cần thiết

- Mới

- Nvidia

- of

- on

- mở

- Hoạt động

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- Giấy

- Song song

- thực hiện

- hiệu suất

- quan điểm

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- đặt ra

- quyền lực

- Độ chính xác

- quá trình

- xử lý

- đề xuất

- nguyên mẫu

- cung cấp

- công bố

- Câu hỏi

- về

- Yêu cầu

- nhà nghiên cứu

- Thông tin

- roy

- hiển thị

- giải pháp

- Tiêu chuẩn

- ở lại

- sự phù hợp

- hệ thống

- Kỹ thuật

- hơn

- việc này

- Sản phẩm

- Tương lai

- cung cấp their dịch

- Kia là

- điều này

- có tiêu đề

- đến

- truyền thống

- kiểu

- trường đại học

- sử dụng

- nhiều

- khác nhau

- Đã xem

- của

- là

- we

- trọng lượng

- Điều gì

- khi nào

- với

- ở trong

- Công việc

- zephyrnet