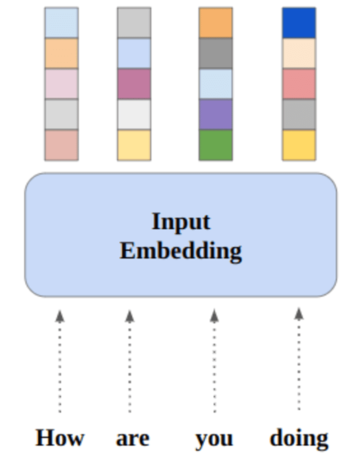

Hình ảnh của Tác giả

Trong bài đăng này, chúng ta sẽ khám phá mô hình nguồn mở tiên tiến nhất có tên Mixtral 8x7b. Chúng ta cũng sẽ tìm hiểu cách truy cập nó bằng thư viện LLaMA C++ và cách chạy các mô hình ngôn ngữ lớn trên khả năng tính toán và bộ nhớ giảm.

Hỗn hợp 8x7b là mô hình hỗn hợp chuyên gia thưa thớt (SMoE) chất lượng cao với trọng số mở, được tạo bởi Mistral AI. Nó được cấp phép theo Apache 2.0 và hoạt động tốt hơn Llama 2 70B trên hầu hết các điểm chuẩn trong khi có khả năng suy luận nhanh hơn 6 lần. Mixtral phù hợp hoặc đánh bại GPT3.5 trên hầu hết các điểm chuẩn tiêu chuẩn và là mô hình trọng lượng mở tốt nhất về chi phí/hiệu suất.

Hình ảnh từ Sự kết hợp của các chuyên gia

Mixtral 8x7B sử dụng mạng hỗn hợp chuyên gia thưa thớt chỉ có bộ giải mã. Điều này bao gồm một khối chuyển tiếp chọn từ 8 nhóm tham số, với mạng bộ định tuyến chọn hai trong số các nhóm này cho mỗi mã thông báo, kết hợp các đầu ra của chúng một cách bổ sung. Phương pháp này nâng cao số lượng tham số của mô hình trong khi quản lý chi phí và độ trễ, làm cho mô hình hoạt động hiệu quả như mô hình 12.9B, mặc dù có tổng số tham số là 46.7B.

Mô hình Mixtral 8x7B vượt trội trong việc xử lý bối cảnh rộng với 32 nghìn mã thông báo và hỗ trợ nhiều ngôn ngữ, bao gồm tiếng Anh, tiếng Pháp, tiếng Ý, tiếng Đức và tiếng Tây Ban Nha. Nó thể hiện hiệu suất mạnh mẽ trong việc tạo mã và có thể được tinh chỉnh thành mô hình tuân theo hướng dẫn, đạt được điểm số cao trên các điểm chuẩn như MT-Bench.

LLaMA.cpp là thư viện C/C++ cung cấp giao diện hiệu suất cao cho các mô hình ngôn ngữ lớn (LLM) dựa trên kiến trúc LLM của Facebook. Đây là một thư viện nhẹ và hiệu quả, có thể được sử dụng cho nhiều tác vụ khác nhau, bao gồm tạo văn bản, dịch thuật và trả lời câu hỏi. LLaMA.cpp hỗ trợ nhiều loại LLM, bao gồm LLaMA, LLaMA 2, Falcon, Alpaca, Mistral 7B, Mixtral 8x7B và GPT4ALL. Nó tương thích với tất cả các hệ điều hành và có thể hoạt động trên cả CPU và GPU.

Trong phần này, chúng ta sẽ chạy ứng dụng web llama.cpp trên Colab. Bằng cách viết một vài dòng mã, bạn sẽ có thể trải nghiệm hiệu suất của mô hình tiên tiến mới trên PC hoặc trên Google Colab.

Bắt đầu

Đầu tiên, chúng ta sẽ tải xuống kho lưu trữ llama.cpp GitHub bằng dòng lệnh bên dưới:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitSau đó, chúng ta sẽ thay đổi thư mục vào kho lưu trữ và cài đặt llama.cpp bằng lệnh `make`. Chúng tôi đang cài đặt llama.cpp cho GPU NVidia có cài đặt CUDA.

%cd llama.cpp

!make LLAMA_CUBLAS=1Tải xuống mô hình

Chúng ta có thể tải xuống mô hình từ Hugging Face Hub bằng cách chọn phiên bản thích hợp của tệp mô hình `.gguf`. Thông tin thêm về các phiên bản khác nhau có thể được tìm thấy trong TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF.

Hình ảnh từ TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

Bạn có thể sử dụng lệnh `wget` để tải xuống mô hình trong thư mục hiện tại.

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufĐịa chỉ bên ngoài cho máy chủ LLaMA

Khi chúng tôi chạy máy chủ LLaMA, nó sẽ cung cấp cho chúng tôi một IP localhost, điều này vô dụng đối với chúng tôi trên Colab. Chúng tôi cần kết nối với proxy localhost bằng cách sử dụng cổng proxy hạt nhân Colab.

Sau khi chạy mã bên dưới, bạn sẽ nhận được siêu liên kết toàn cầu. Chúng tôi sẽ sử dụng liên kết này để truy cập ứng dụng web của chúng tôi sau.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/Chạy máy chủ

Để chạy máy chủ LLaMA C++, bạn cần cung cấp cho lệnh máy chủ vị trí của tệp mô hình và số cổng chính xác. Điều quan trọng là đảm bảo rằng số cổng khớp với số cổng chúng tôi đã bắt đầu ở bước trước cho cổng proxy.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

Có thể truy cập ứng dụng web trò chuyện bằng cách nhấp vào siêu liên kết cổng proxy ở bước trước vì máy chủ không chạy cục bộ.

Ứng dụng web LLaMA C++

Trước khi bắt đầu sử dụng chatbot, chúng ta cần tùy chỉnh nó. Thay thế “LLaMA” bằng tên mẫu máy của bạn trong phần lời nhắc. Ngoài ra, hãy sửa đổi tên người dùng và tên bot để phân biệt giữa các phản hồi được tạo.

Bắt đầu trò chuyện bằng cách kéo xuống và gõ vào phần trò chuyện. Vui lòng đặt các câu hỏi kỹ thuật mà các mô hình nguồn mở khác không trả lời được.

Nếu gặp sự cố với ứng dụng, bạn có thể thử tự chạy ứng dụng bằng Google Colab của tôi: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

Hướng dẫn này cung cấp hướng dẫn toàn diện về cách chạy mô hình nguồn mở nâng cao, Mixtral 8x7b, trên Google Colab bằng thư viện LLaMA C++. So với các mô hình khác, Mixtral 8x7b mang lại hiệu suất và hiệu quả vượt trội, khiến nó trở thành giải pháp tuyệt vời cho những ai muốn thử nghiệm các mô hình ngôn ngữ lớn nhưng không có nguồn lực tính toán dồi dào. Bạn có thể dễ dàng chạy nó trên máy tính xách tay hoặc trên điện toán đám mây miễn phí. Nó thân thiện với người dùng và thậm chí bạn có thể triển khai ứng dụng trò chuyện của mình để người khác sử dụng và thử nghiệm.

Tôi hy vọng bạn thấy giải pháp đơn giản này để chạy mô hình lớn hữu ích. Tôi luôn tìm kiếm những lựa chọn đơn giản và tốt hơn. Nếu bạn có giải pháp nào tốt hơn nữa, vui lòng cho tôi biết và tôi sẽ đề cập đến giải pháp đó vào lần sau.

Abid Ali Awan (@ 1abidaliawan) là một nhà khoa học dữ liệu chuyên nghiệp được chứng nhận, người yêu thích việc xây dựng các mô hình học máy. Hiện tại, anh đang tập trung sáng tạo nội dung và viết blog kỹ thuật về công nghệ máy học và khoa học dữ liệu. Abid có bằng Thạc sĩ về Quản lý Công nghệ và bằng cử nhân về Kỹ thuật Viễn thông. Tầm nhìn của ông là xây dựng một sản phẩm AI bằng cách sử dụng mạng nơ-ron đồ thị cho những sinh viên đang chống chọi với bệnh tâm thần.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free

- :là

- :không phải

- 1

- 12

- 27

- 46

- 7

- 8

- a

- Có khả năng

- truy cập

- truy cập

- đạt được

- Ngoài ra

- địa chỉ

- tiên tiến

- AI

- Tất cả

- Ngoài ra

- luôn luôn

- am

- an

- và

- trả lời

- Apache

- ứng dụng

- Các Ứng Dụng

- thích hợp

- kiến trúc

- LÀ

- AS

- xin

- dựa

- BE

- bắt đầu

- phía dưới

- Điểm chuẩn

- BEST

- Hơn

- giữa

- Chặn

- blog

- Bot

- cả hai

- xây dựng

- Xây dựng

- nhưng

- by

- C + +

- gọi là

- CAN

- CHỨNG NHẬN

- thay đổi

- trò chuyện trên mạng

- chatbot

- tán gẫu

- lựa chọn

- đám mây

- mã

- kết hợp

- so

- tương thích

- toàn diện

- tính toán

- Tính

- máy tính

- liên quan

- nội dung

- tạo nội dung

- bối cảnh

- sửa chữa

- Phí Tổn

- che

- tạo ra

- tạo

- Current

- Hiện nay

- tùy chỉnh

- dữ liệu

- khoa học dữ liệu

- nhà khoa học dữ liệu

- Bằng cấp

- cung cấp

- chứng minh

- triển khai

- Mặc dù

- phân biệt

- do

- xuống

- tải về

- mỗi

- dễ dàng

- hiệu quả

- hiệu quả

- gặp gỡ

- Kỹ Sư

- Tiếng Anh

- Nâng cao

- Ngay cả

- tuyệt vời

- kinh nghiệm

- thử nghiệm

- các chuyên gia

- khám phá

- mở rộng

- Đối mặt

- thất bại

- chim ưng

- nhanh hơn

- cảm thấy

- vài

- Tập tin

- tập trung

- Trong

- tìm thấy

- Miễn phí

- Tiếng Pháp

- từ

- chức năng

- tạo ra

- thế hệ

- Tiếng Đức

- được

- GitHub

- Cho

- Toàn cầu

- GPU

- GPU

- đồ thị

- Mạng Neural Đồ thị

- Các nhóm

- hướng dẫn

- Xử lý

- Có

- có

- he

- hữu ích

- Cao

- hiệu suất cao

- chất lượng cao

- của mình

- giữ

- mong

- Độ đáng tin của

- Hướng dẫn

- HTTPS

- Hub

- i

- if

- bệnh

- nhập khẩu

- quan trọng

- in

- Bao gồm

- thông tin

- khởi xướng

- cài đặt, dựng lên

- Cài đặt

- Giao thức

- trong

- liên quan đến

- IP

- các vấn đề

- IT

- Tiếng Ý

- Xe đẩy

- Biết

- Ngôn ngữ

- Ngôn ngữ

- máy tính xách tay

- lớn

- Độ trễ

- một lát sau

- LEARN

- học tập

- cho phép

- Thư viện

- Cấp phép

- trọng lượng nhẹ

- Lượt thích

- Dòng

- dòng

- LINK

- Loài đà mã ở nam mỹ

- tại địa phương

- địa điểm thư viện nào

- tìm kiếm

- yêu

- máy

- học máy

- làm cho

- Làm

- quản lý

- quản lý

- chủ

- diêm

- me

- Bộ nhớ

- tâm thần

- Bệnh tâm thần

- phương pháp

- hỗn hợp

- kiểu mẫu

- mô hình

- sửa đổi

- chi tiết

- hầu hết

- nhiều

- my

- tên

- Cần

- mạng

- Thần kinh

- mạng lưới thần kinh

- Mới

- tiếp theo

- con số

- Nvidia

- of

- on

- ONE

- mở

- mã nguồn mở

- hoạt động

- các hệ điều hành

- Các lựa chọn

- or

- Nền tảng khác

- Khác

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- Vượt trội hơn

- đầu ra

- kết quả đầu ra

- riêng

- tham số

- thông số

- PC

- hiệu suất

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- xin vui lòng

- Bài đăng

- trước

- Sản phẩm

- chuyên nghiệp

- đúng

- cho

- cung cấp

- Proxy

- câu hỏi

- Câu hỏi

- phạm vi

- Giảm

- về

- thay thế

- kho

- nghiên cứu

- Thông tin

- phản ứng

- Router

- chạy

- chạy

- s

- Khoa học

- Nhà khoa học

- điểm

- cuộn

- Phần

- lựa chọn

- máy chủ

- Đơn giản

- kể từ khi

- giải pháp

- nguồn

- Tiếng Tây Ban Nha

- Tiêu chuẩn

- nhà nước-of-the-art

- Bước

- mạnh mẽ

- Đấu tranh

- Sinh viên

- cao

- Hỗ trợ

- chắc chắn

- hệ thống

- nhiệm vụ

- Kỹ thuật

- Công nghệ

- Công nghệ

- viễn thông

- văn bản

- tạo văn bản

- việc này

- Sản phẩm

- cung cấp their dịch

- Kia là

- điều này

- những

- thời gian

- đến

- mã thông báo

- Tokens

- Tổng số:

- Dịch

- thử

- hướng dẫn

- hai

- Dưới

- us

- sử dụng

- đã sử dụng

- người sử dang

- sử dụng

- sử dụng

- sử dụng

- nhiều

- khác nhau

- phiên bản

- tầm nhìn

- muốn

- we

- web

- Ứng dụng web

- cái nào

- trong khi

- CHÚNG TÔI LÀ

- rộng

- Phạm vi rộng

- sẽ

- với

- viết

- bạn

- trên màn hình

- zephyrnet