Bài đăng này được viết chung với Pramod Nayak, LakshmiKanth Mannem và Vivek Aggarwal từ Nhóm có độ trễ thấp của LSEG.

Phân tích chi phí giao dịch (TCA) được các nhà giao dịch, nhà quản lý danh mục đầu tư và nhà môi giới sử dụng rộng rãi để phân tích trước và sau giao dịch, đồng thời giúp họ đo lường và tối ưu hóa chi phí giao dịch cũng như hiệu quả của chiến lược giao dịch. Trong bài đăng này, chúng tôi phân tích chênh lệch giá chào bán quyền chọn từ Lịch sử đánh dấu LSEG – PCAP tập dữ liệu sử dụng Amazon Athena cho Apache Spark. Chúng tôi chỉ cho bạn cách truy cập dữ liệu, xác định các hàm tùy chỉnh để áp dụng trên dữ liệu, truy vấn và lọc tập dữ liệu cũng như trực quan hóa kết quả phân tích mà không phải lo lắng về việc thiết lập cơ sở hạ tầng hoặc định cấu hình Spark, ngay cả đối với các tập dữ liệu lớn.

Tiểu sử

Cơ quan báo cáo giá quyền chọn (OPRA) đóng vai trò là cơ quan xử lý thông tin chứng khoán quan trọng, thu thập, tổng hợp và phổ biến các báo cáo bán hàng cuối cùng, báo giá và thông tin thích hợp cho Quyền chọn Hoa Kỳ. Với 18 sàn giao dịch Quyền chọn Hoa Kỳ đang hoạt động và hơn 1.5 triệu hợp đồng đủ điều kiện, OPRA đóng vai trò then chốt trong việc cung cấp dữ liệu thị trường toàn diện.

Vào ngày 5 tháng 2024 năm 48, Tập đoàn Tự động hóa Công nghiệp Chứng khoán (SIAC) dự kiến nâng cấp nguồn cấp dữ liệu OPRA từ 96 lên 37.3 kênh phát đa hướng. Cải tiến này nhằm mục đích tối ưu hóa việc phân phối biểu tượng và sử dụng công suất đường dây để đáp ứng với hoạt động giao dịch leo thang và biến động trên thị trường quyền chọn Hoa Kỳ. SIAC đã khuyến nghị các công ty nên chuẩn bị cho tốc độ dữ liệu cao nhất lên tới XNUMX GBits mỗi giây.

Mặc dù việc nâng cấp không làm thay đổi ngay lập tức tổng khối lượng dữ liệu được xuất bản nhưng nó cho phép OPRA phổ biến dữ liệu với tốc độ nhanh hơn đáng kể. Quá trình chuyển đổi này rất quan trọng để giải quyết nhu cầu của thị trường quyền chọn năng động.

OPRA nổi bật là một trong những nguồn cấp dữ liệu có số lượng lớn nhất, với mức cao nhất là 150.4 tỷ tin nhắn trong một ngày vào quý 3 năm 2023 và yêu cầu về dung lượng khoảng 400 tỷ tin nhắn trong một ngày. Nắm bắt từng thông điệp là rất quan trọng để phân tích chi phí giao dịch, giám sát thanh khoản thị trường, đánh giá chiến lược giao dịch và nghiên cứu thị trường.

Về dữ liệu

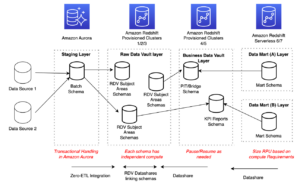

Lịch sử đánh dấu LSEG – PCAP là kho lưu trữ dựa trên đám mây, vượt quá 30 PB, chứa dữ liệu thị trường toàn cầu chất lượng cực cao. Dữ liệu này được thu thập một cách tỉ mỉ trực tiếp trong các trung tâm dữ liệu trao đổi, sử dụng các quy trình thu thập dự phòng được bố trí chiến lược tại các trung tâm dữ liệu trao đổi chính và dự phòng lớn trên toàn thế giới. Công nghệ chụp của LSEG đảm bảo thu thập dữ liệu không bị mất và sử dụng nguồn thời gian GPS để có độ chính xác về dấu thời gian ở nano giây. Ngoài ra, các kỹ thuật chênh lệch giá dữ liệu phức tạp được sử dụng để lấp đầy liền mạch mọi khoảng trống dữ liệu. Sau khi thu thập, dữ liệu trải qua quá trình xử lý và phân xử tỉ mỉ, sau đó được chuẩn hóa thành định dạng Parquet bằng cách sử dụng Thời gian thực siêu trực tiếp của LSEG (RTUD) trình xử lý nguồn cấp dữ liệu.

Quá trình chuẩn hóa, một phần không thể thiếu trong quá trình chuẩn bị dữ liệu để phân tích, tạo ra tối đa 6 TB tệp Parquet nén mỗi ngày. Khối lượng dữ liệu khổng lồ được cho là do tính chất bao trùm của OPRA, trải rộng trên nhiều sàn giao dịch và bao gồm nhiều hợp đồng quyền chọn được đặc trưng bởi các thuộc tính đa dạng. Biến động thị trường gia tăng và hoạt động tạo lập thị trường trên các sàn giao dịch quyền chọn góp phần làm tăng thêm khối lượng dữ liệu được công bố trên OPRA.

Các thuộc tính của Lịch sử đánh giá – PCAP cho phép các công ty tiến hành nhiều phân tích khác nhau, bao gồm:

- Phân tích trước giao dịch – Đánh giá tác động thương mại tiềm năng và khám phá các chiến lược thực hiện khác nhau dựa trên dữ liệu lịch sử

- Đánh giá sau giao dịch – Đo lường chi phí thực hiện thực tế so với tiêu chuẩn để đánh giá hiệu quả của các chiến lược thực hiện

- Tối ưu hóa thực hiện – Tinh chỉnh các chiến lược thực hiện dựa trên mô hình thị trường lịch sử để giảm thiểu tác động của thị trường và giảm chi phí giao dịch tổng thể

- Quản trị rủi ro – Xác định mô hình trượt giá, xác định các ngoại lệ và chủ động quản lý rủi ro liên quan đến hoạt động giao dịch

- Phân bổ hiệu suất – Tách biệt tác động của quyết định giao dịch khỏi quyết định đầu tư khi phân tích hiệu quả danh mục đầu tư

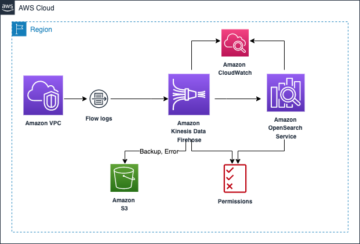

Lịch sử đánh dấu LSEG – Bộ dữ liệu PCAP có sẵn ở Trao đổi dữ liệu AWS và có thể được truy cập trên Thị trường AWS. Với Trao đổi dữ liệu AWS cho Amazon S3, bạn có thể truy cập dữ liệu PCAP trực tiếp từ LSEG Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3), loại bỏ nhu cầu các công ty lưu trữ bản sao dữ liệu của riêng họ. Cách tiếp cận này hợp lý hóa việc quản lý và lưu trữ dữ liệu, cung cấp cho khách hàng quyền truy cập ngay vào PCAP chất lượng cao hoặc dữ liệu được chuẩn hóa một cách dễ dàng sử dụng, tích hợp và tiết kiệm lưu trữ dữ liệu đáng kể.

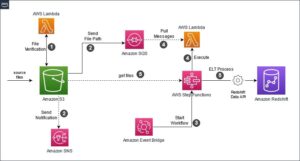

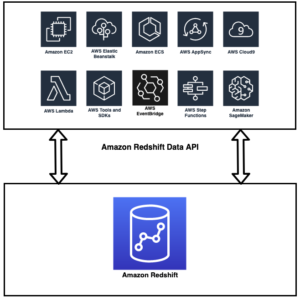

Athena cho Apache Spark

Đối với những nỗ lực phân tích, Athena cho Apache Spark cung cấp trải nghiệm máy tính xách tay đơn giản hóa có thể truy cập được thông qua bảng điều khiển Athena hoặc API Athena, cho phép bạn xây dựng các ứng dụng Apache Spark tương tác. Với thời gian chạy Spark được tối ưu hóa, Athena giúp phân tích hàng petabyte dữ liệu bằng cách điều chỉnh linh hoạt số lượng động cơ Spark trong thời gian chưa đầy một giây. Hơn nữa, các thư viện Python phổ biến như pandas và NumPy được tích hợp liền mạch, cho phép tạo ra logic ứng dụng phức tạp. Tính linh hoạt còn mở rộng đến việc nhập các thư viện tùy chỉnh để sử dụng trong sổ ghi chép. Athena cho Spark hỗ trợ hầu hết các định dạng dữ liệu mở và được tích hợp liền mạch với Keo AWS Danh mục dữ liệu.

Bộ dữ liệu

Để thực hiện phân tích này, chúng tôi đã sử dụng tập dữ liệu Lịch sử đánh dấu LSEG – PCAP OPRA từ ngày 17 tháng 2023 năm XNUMX. Tập dữ liệu này bao gồm các thành phần sau:

- Giá thầu và chào giá tốt nhất (BBO) – Báo cáo giá thầu cao nhất và yêu cầu bảo mật thấp nhất tại một sàn giao dịch nhất định

- Giá thầu và ưu đãi tốt nhất quốc gia (NBBO) – Báo cáo giá thầu cao nhất và yêu cầu bảo mật thấp nhất trên tất cả các sàn giao dịch

- Ngành nghề – Ghi lại các giao dịch đã hoàn thành trên tất cả các sàn giao dịch

Bộ dữ liệu bao gồm các khối dữ liệu sau:

- Ngành nghề – 160 MB được phân phối trên khoảng 60 tệp Parquet nén

- BBO – 2.4 TB được phân phối trên khoảng 300 tệp Parquet nén

- NBBO – 2.8 TB được phân phối trên khoảng 200 tệp Parquet nén

Tổng quan về phân tích

Phân tích dữ liệu Lịch sử đánh dấu OPRA để Phân tích chi phí giao dịch (TCA) bao gồm việc xem xét kỹ lưỡng các báo giá thị trường và giao dịch xung quanh một sự kiện giao dịch cụ thể. Chúng tôi sử dụng các số liệu sau đây như một phần của nghiên cứu này:

- Chênh lệch giá niêm yết (QS) – Được tính bằng chênh lệch giữa giá bán BBO và giá thầu BBO

- Lan truyền hiệu quả (ES) – Được tính bằng chênh lệch giữa giá giao dịch và điểm giữa của BBO (BBO bid + (BBO Ask – BBO bid)/2)

- Chênh lệch hiệu quả/báo giá (EQF) – Tính bằng (ES/QS)*100

Chúng tôi tính toán các mức chênh lệch này trước khi giao dịch và bổ sung vào bốn khoảng thời gian sau giao dịch (ngay sau, 1 giây, 10 giây và 60 giây sau giao dịch).

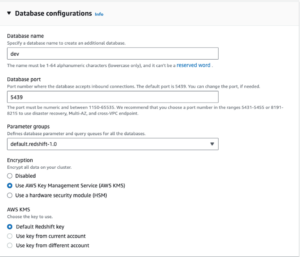

Định cấu hình Athena cho Apache Spark

Để định cấu hình Athena cho Apache Spark, hãy hoàn thành các bước sau:

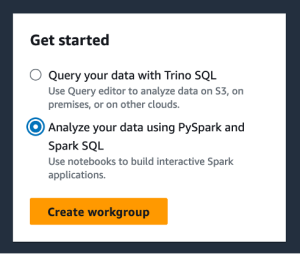

- Trên bảng điều khiển Athena, bên dưới Bắt đầu, lựa chọn Phân tích dữ liệu của bạn bằng PySpark và Spark SQL.

- Nếu đây là lần đầu tiên bạn sử dụng Athena Spark, hãy chọn Tạo nhóm làm việc.

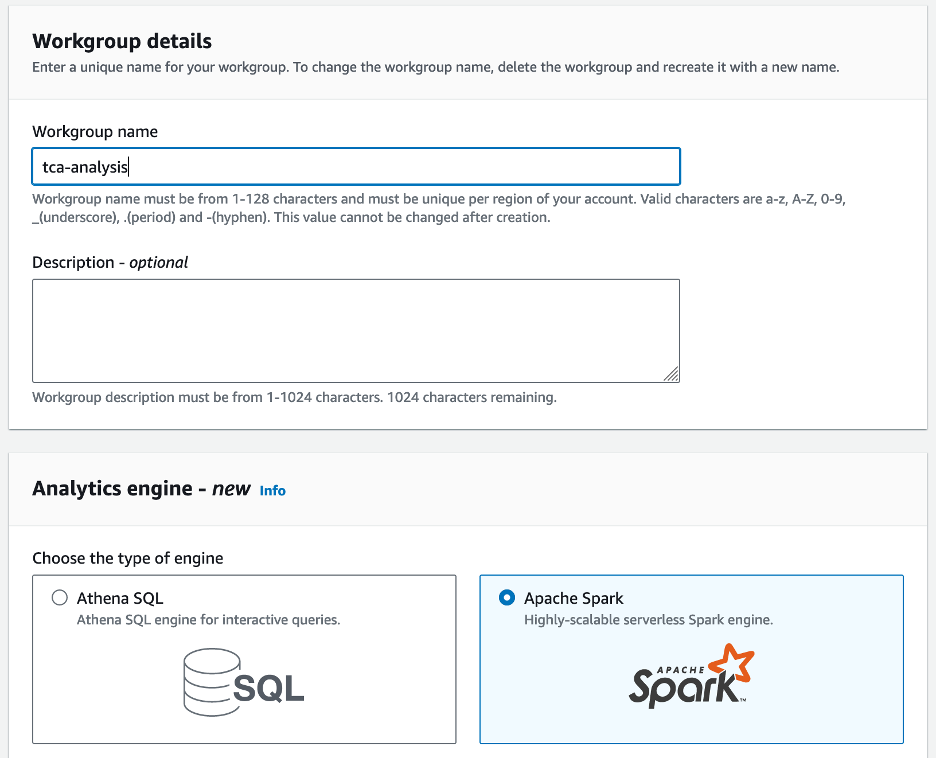

- Trong tên nhóm làm việc¸ nhập tên cho nhóm làm việc, chẳng hạn như

tca-analysis. - Trong tạp chí công cụ phân tích phần, chọn Apache Spark.

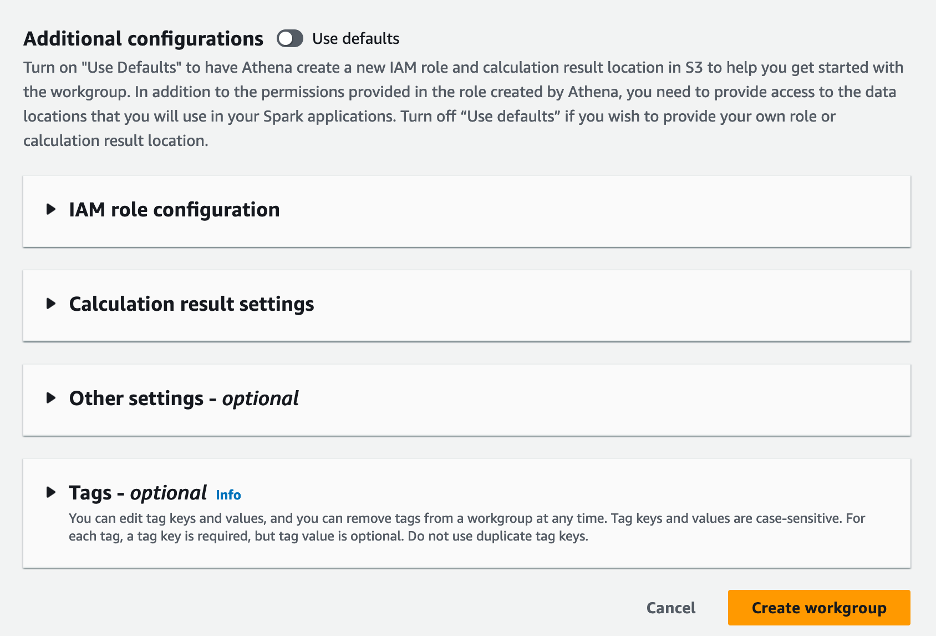

- Trong tạp chí Cấu hình bổ sung phần, bạn có thể chọn Mặc định sử dụng hoặc cung cấp một tùy chỉnh Quản lý truy cập và nhận dạng AWS (IAM) và vị trí Amazon S3 để có kết quả tính toán.

- Chọn Tạo nhóm làm việc.

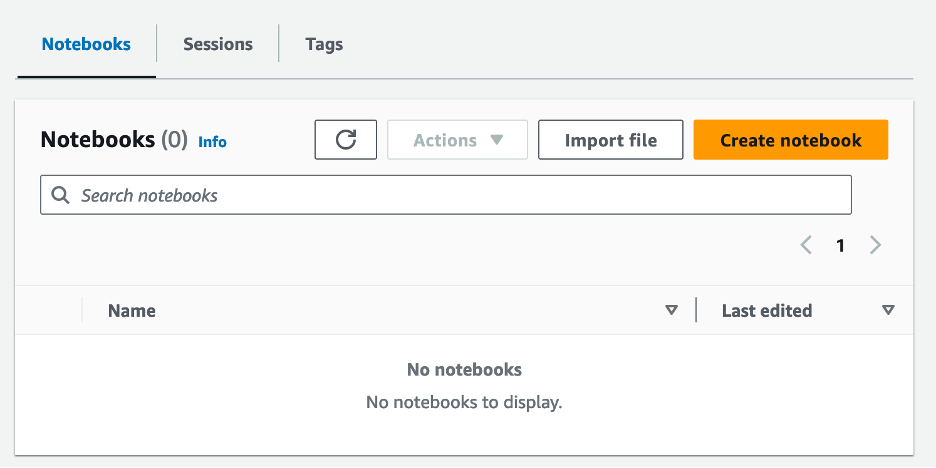

- Sau khi bạn tạo nhóm làm việc, hãy điều hướng đến máy tính xách tay tab và chọn Tạo sổ ghi chép.

- Nhập tên cho sổ ghi chép của bạn, chẳng hạn như

tca-analysis-with-tick-history. - Chọn Tạo để tạo sổ ghi chép của bạn.

Khởi chạy sổ ghi chép của bạn

Nếu bạn đã tạo nhóm làm việc Spark, hãy chọn Khởi chạy trình chỉnh sửa sổ ghi chép Dưới Bắt đầu.

Sau khi sổ ghi chép của bạn được tạo, bạn sẽ được chuyển hướng đến trình chỉnh sửa sổ ghi chép tương tác.

Bây giờ chúng ta có thể thêm và chạy đoạn mã sau vào sổ ghi chép của mình.

Tạo phân tích

Hoàn thành các bước sau để tạo bản phân tích:

- Nhập thư viện chung:

- Tạo khung dữ liệu của chúng tôi cho BBO, NBBO và giao dịch:

- Bây giờ chúng ta có thể xác định một giao dịch để sử dụng cho việc phân tích chi phí giao dịch:

Chúng tôi nhận được kết quả sau:

Chúng tôi sử dụng thông tin giao dịch được đánh dấu trong tương lai cho sản phẩm giao dịch (tp), giá giao dịch (tpr) và thời gian giao dịch (tt).

- Ở đây chúng tôi tạo ra một số hàm trợ giúp để phân tích

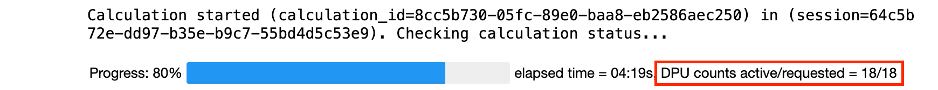

- Trong hàm sau, chúng tôi tạo tập dữ liệu chứa tất cả các báo giá trước và sau giao dịch. Athena Spark tự động xác định số lượng DPU sẽ khởi chạy để xử lý tập dữ liệu của chúng tôi.

- Bây giờ hãy gọi hàm phân tích TCA với thông tin từ giao dịch đã chọn của chúng tôi:

Trực quan hóa kết quả phân tích

Bây giờ hãy tạo các khung dữ liệu mà chúng ta sử dụng để trực quan hóa. Mỗi khung dữ liệu chứa các trích dẫn cho một trong năm khoảng thời gian cho mỗi nguồn cấp dữ liệu (BBO, NBBO):

Trong các phần sau, chúng tôi cung cấp mã ví dụ để tạo các hình ảnh trực quan khác nhau.

Vẽ biểu đồ QS và NBBO trước khi giao dịch

Sử dụng đoạn mã sau để vẽ biểu đồ chênh lệch được trích dẫn và NBBO trước khi giao dịch:

Vẽ biểu đồ QS cho từng thị trường và NBBO sau giao dịch

Sử dụng đoạn mã sau để vẽ biểu đồ chênh lệch giá được báo giá cho từng thị trường và NBBO ngay sau giao dịch:

Vẽ biểu đồ QS cho từng khoảng thời gian và từng thị trường cho BBO

Sử dụng đoạn mã sau để vẽ biểu đồ mức chênh lệch được trích dẫn cho từng khoảng thời gian và từng thị trường cho BBO:

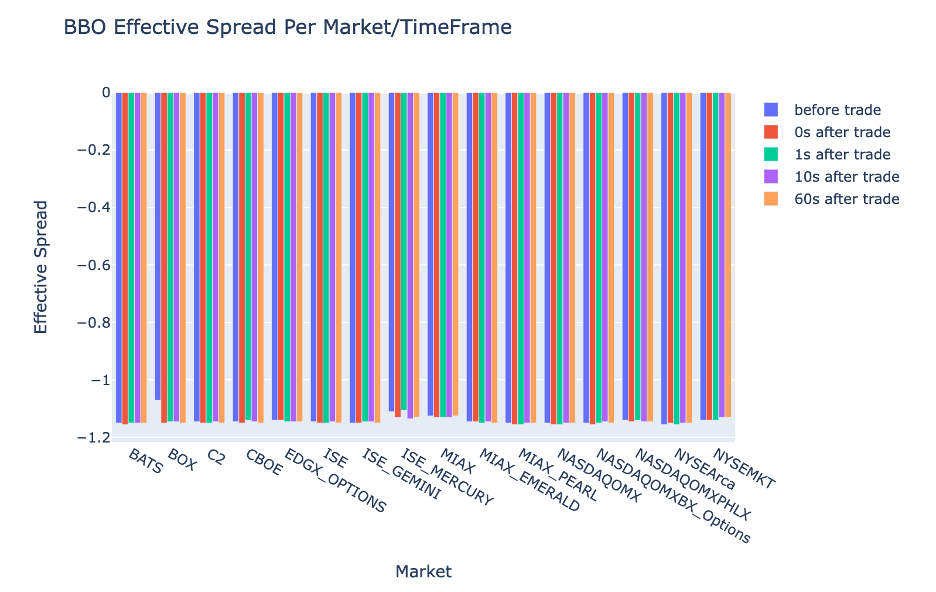

Vẽ ES cho từng khoảng thời gian và thị trường cho BBO

Sử dụng đoạn mã sau để vẽ biểu đồ mức chênh lệch hiệu quả cho từng khoảng thời gian và thị trường cho BBO:

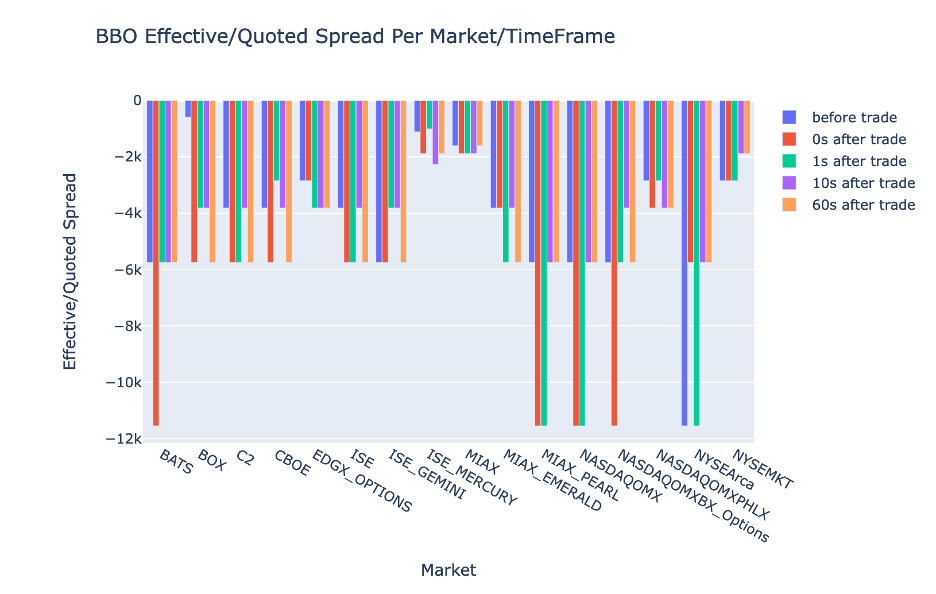

Vẽ biểu đồ EQF cho từng khoảng thời gian và thị trường cho BBO

Sử dụng đoạn mã sau để vẽ biểu đồ mức chênh lệch hiệu quả/được báo giá cho từng khoảng thời gian và thị trường cho BBO:

Hiệu suất tính toán của Athena Spark

Khi bạn chạy một khối mã, Athena Spark sẽ tự động xác định số lượng DPU cần thiết để hoàn thành việc tính toán. Trong khối mã cuối cùng, nơi chúng tôi gọi tca_analysis chức năng, chúng tôi thực sự đang hướng dẫn Spark xử lý dữ liệu và sau đó chúng tôi chuyển đổi các khung dữ liệu Spark thu được thành các khung dữ liệu Pandas. Đây là phần xử lý chuyên sâu nhất của phân tích và khi Athena Spark chạy khối này, nó sẽ hiển thị thanh tiến trình, thời gian đã trôi qua và số lượng DPU hiện đang xử lý dữ liệu. Ví dụ: trong phép tính sau, Athena Spark đang sử dụng 18 DPU.

Khi định cấu hình máy tính xách tay Athena Spark, bạn có tùy chọn đặt số lượng DPU tối đa mà nó có thể sử dụng. Mặc định là 20 DPU, nhưng chúng tôi đã thử nghiệm tính toán này với 10, 20 và 40 DPU để chứng minh cách Athena Spark tự động điều chỉnh quy mô để chạy phân tích của chúng tôi. Chúng tôi quan sát thấy Athena Spark chia tỷ lệ tuyến tính, mất 15 phút 21 giây khi máy tính xách tay được cấu hình với tối đa 10 DPU, 8 phút 23 giây khi máy tính xách tay được cấu hình với 20 DPU và 4 phút 44 giây khi máy tính xách tay được cấu hình với 40 DPU. được cấu hình với XNUMX DPU. Vì Athena Spark tính phí dựa trên mức sử dụng DPU nên chi phí của những tính toán này là tương tự nhau, nhưng nếu bạn đặt giá trị DPU tối đa cao hơn, Athena Spark có thể trả về kết quả phân tích nhanh hơn nhiều. Để biết thêm chi tiết về giá Athena Spark vui lòng nhấp vào tại đây.

Kết luận

Trong bài đăng này, chúng tôi đã trình bày cách bạn có thể sử dụng dữ liệu OPRA có độ chính xác cao từ Lịch sử đánh dấu-PCAP của LSEG để thực hiện phân tích chi phí giao dịch bằng Athena Spark. Tính sẵn có của dữ liệu OPRA một cách kịp thời, cùng với những cải tiến về khả năng tiếp cận của AWS Data Exchange cho Amazon S3, giúp giảm thời gian phân tích một cách chiến lược cho các công ty muốn tạo ra thông tin chi tiết có thể hành động cho các quyết định giao dịch quan trọng. OPRA tạo ra khoảng 7 TB dữ liệu Parquet được chuẩn hóa mỗi ngày và việc quản lý cơ sở hạ tầng để cung cấp phân tích dựa trên dữ liệu OPRA là một thách thức.

Khả năng mở rộng của Athena trong việc xử lý dữ liệu quy mô lớn cho Lịch sử đánh dấu – PCAP cho dữ liệu OPRA khiến nó trở thành lựa chọn hấp dẫn cho các tổ chức đang tìm kiếm giải pháp phân tích nhanh chóng và có thể mở rộng trong AWS. Bài đăng này cho thấy sự tương tác liền mạch giữa hệ sinh thái AWS và dữ liệu Lịch sử đánh dấu-PCAP cũng như cách các tổ chức tài chính có thể tận dụng sức mạnh tổng hợp này để thúc đẩy việc ra quyết định dựa trên dữ liệu cho các chiến lược đầu tư và giao dịch quan trọng.

Về các tác giả

Pramod Nayak là Giám đốc Quản lý Sản phẩm của Nhóm Độ trễ Thấp tại LSEG. Pramod có hơn 10 năm kinh nghiệm trong ngành công nghệ tài chính, tập trung vào phát triển phần mềm, phân tích và quản lý dữ liệu. Pramod là cựu kỹ sư phần mềm và đam mê dữ liệu thị trường và giao dịch định lượng.

Pramod Nayak là Giám đốc Quản lý Sản phẩm của Nhóm Độ trễ Thấp tại LSEG. Pramod có hơn 10 năm kinh nghiệm trong ngành công nghệ tài chính, tập trung vào phát triển phần mềm, phân tích và quản lý dữ liệu. Pramod là cựu kỹ sư phần mềm và đam mê dữ liệu thị trường và giao dịch định lượng.

LakshmiKanth Mannem là Giám đốc sản phẩm trong Nhóm có độ trễ thấp của LSEG. Ông tập trung vào dữ liệu và các sản phẩm nền tảng cho ngành dữ liệu thị trường có độ trễ thấp. LakshmiKanth giúp khách hàng xây dựng các giải pháp tối ưu nhất cho nhu cầu dữ liệu thị trường của họ.

LakshmiKanth Mannem là Giám đốc sản phẩm trong Nhóm có độ trễ thấp của LSEG. Ông tập trung vào dữ liệu và các sản phẩm nền tảng cho ngành dữ liệu thị trường có độ trễ thấp. LakshmiKanth giúp khách hàng xây dựng các giải pháp tối ưu nhất cho nhu cầu dữ liệu thị trường của họ.

Vivek Aggarwal là Kỹ sư dữ liệu cấp cao trong Nhóm có độ trễ thấp của LSEG. Vivek nỗ lực phát triển và duy trì các đường dẫn dữ liệu để xử lý và phân phối nguồn cấp dữ liệu thị trường đã nắm bắt và nguồn cấp dữ liệu tham chiếu.

Vivek Aggarwal là Kỹ sư dữ liệu cấp cao trong Nhóm có độ trễ thấp của LSEG. Vivek nỗ lực phát triển và duy trì các đường dẫn dữ liệu để xử lý và phân phối nguồn cấp dữ liệu thị trường đã nắm bắt và nguồn cấp dữ liệu tham chiếu.

Alket Memushaj là Kiến trúc sư chính trong nhóm Phát triển Thị trường Dịch vụ Tài chính tại AWS. Alket chịu trách nhiệm về chiến lược kỹ thuật, làm việc với các đối tác và khách hàng để triển khai ngay cả khối lượng công việc thị trường vốn đòi hỏi khắt khe nhất lên Đám mây AWS.

Alket Memushaj là Kiến trúc sư chính trong nhóm Phát triển Thị trường Dịch vụ Tài chính tại AWS. Alket chịu trách nhiệm về chiến lược kỹ thuật, làm việc với các đối tác và khách hàng để triển khai ngay cả khối lượng công việc thị trường vốn đòi hỏi khắt khe nhất lên Đám mây AWS.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/big-data/mastering-market-dynamics-transforming-transaction-cost-analytics-with-ultra-precise-tick-history-pcap-and-amazon-athena-for-apache-spark/

- : có

- :là

- :không phải

- :Ở đâu

- $ LÊN

- 1

- 10

- 100

- 12

- 15%

- 150

- 16

- 160

- 17

- 19

- 20

- 200

- 2023

- 2024

- 23

- 27

- 30

- 300

- 40

- 400

- 60

- 7

- 750

- 8

- 90

- a

- Giới thiệu

- truy cập

- truy cập

- khả năng tiếp cận

- có thể truy cập

- ngang qua

- hoạt động

- hoạt động

- thực tế

- thực sự

- thêm vào

- Ngoài ra

- giải quyết

- Lợi thế

- Sau

- chống lại

- Aggarwal

- Mục tiêu

- Tất cả

- Cho phép

- Đã

- đàn bà gan dạ

- amazon Athena

- Amazon Web Services

- an

- phân tích

- phân tích

- Phân tích

- phân tích

- phân tích

- phân tích

- và

- bất kì

- Apache

- Apache Spark

- API

- Các Ứng Dụng

- các ứng dụng

- Đăng Nhập

- phương pháp tiếp cận

- khoảng

- trao đổi chứng khóan

- trọng tài

- LÀ

- xung quanh

- AS

- xin

- đánh giá

- liên kết

- At

- thuộc tính

- ủy quyền

- tự động

- Tự động hóa

- sẵn có

- có sẵn

- AWS

- sao lưu

- thanh

- dựa

- BE

- bởi vì

- trước

- Điểm chuẩn

- BEST

- giữa

- thầu

- Tỷ

- Chặn

- môi giới

- xây dựng

- nhưng

- by

- tính toán

- tính

- phép tính

- cuộc gọi

- CAN

- Sức chứa

- vốn

- Thị trường vốn

- nắm bắt

- bị bắt

- Chụp

- Danh mục hàng

- Trung tâm

- thách thức

- kênh

- đặc trưng

- tải

- sự lựa chọn

- Chọn

- khách hàng

- đám mây

- mã

- Thu

- Chung

- thuyết phục

- hoàn thành

- Hoàn thành

- các thành phần

- toàn diện

- bao gồm

- Tiến hành

- cấu hình

- cấu hình

- An ủi

- củng cố

- chứa

- hợp đồng

- Góp phần

- chuyển đổi

- TẬP ĐOÀN

- Phí Tổn

- Chi phí

- đồng viết

- tạo

- tạo ra

- tạo

- quan trọng

- quan trọng

- Hiện nay

- khách hàng

- khách hàng

- Dash

- dữ liệu

- các trung tâm dữ liệu

- kỹ sư dữ liệu

- Trao đổi dữ liệu

- quản lý dữ liệu

- xử lý dữ liệu

- lưu trữ dữ liệu

- hướng dữ liệu

- bộ dữ liệu

- ngày

- Ra quyết định

- quyết định

- Mặc định

- định nghĩa

- giao hàng

- yêu cầu

- nhu cầu

- chứng minh

- chứng minh

- triển khai

- chi tiết

- xác định

- phát triển

- Phát triển

- nhóm phát triển

- sự khác biệt

- khác nhau

- trực tiếp

- Giám đốc

- phân phối

- phân phối

- khác nhau

- tăng gấp đôi

- lái xe

- năng động

- năng động

- động lực

- mỗi

- dễ dàng

- dễ sử dụng

- hệ sinh thái

- biên tập viên

- Hiệu quả

- hiệu quả

- đủ điều kiện

- loại bỏ

- việc làm

- thuê mướn

- cho phép

- cho phép

- bao trùm

- nỗ lực

- Động cơ

- ky sư

- Động cơ

- tăng cường

- đảm bảo

- đăng ký hạng mục thi

- leo lên bằng thang

- Ether (ETH)

- đánh giá

- đánh giá

- Ngay cả

- Sự kiện

- Mỗi

- ví dụ

- Sàn giao dịch

- Trao đổi

- thực hiện

- kinh nghiệm

- khám phá

- thể hiện

- kéo dài

- nhanh hơn

- Với

- Tháng Hai

- Sung

- Các tập tin

- điền

- lọc

- tài chính

- Học viện Tài chính

- dịch vụ tài chính

- công nghệ tài chính

- hãng

- Tên

- lần đầu tiên

- năm

- Linh hoạt

- tập trung

- tập trung

- tiếp theo

- Trong

- định dạng

- Cựu

- Forward

- 4

- FRAME

- từ

- chức năng

- chức năng

- xa hơn

- khoảng trống

- tạo

- được

- được

- Toàn cầu

- thị trường toàn cầu

- Go

- đi

- gps

- Nhóm

- Xử lý

- Có

- có

- he

- khoảng trống

- giúp

- chất lượng cao

- cao hơn

- cao nhất

- Nhấn mạnh

- lịch sử

- lịch sử

- nhà ở

- Độ đáng tin của

- Hướng dẫn

- http

- HTTPS

- IAM

- xác định

- Bản sắc

- if

- lập tức

- ngay

- Va chạm

- nhập khẩu

- in

- Bao gồm

- tăng

- ngành công nghiệp

- thông tin

- Cơ sở hạ tầng

- đổi mới

- những hiểu biết

- tổ chức

- thiếu

- tích hợp

- hội nhập

- tương tác

- tương tác

- trong

- phức tạp

- đầu tư

- liên quan đến

- IT

- jpg

- chỉ

- lớn

- quy mô lớn

- Họ

- Độ trễ

- phóng

- ít

- thư viện

- Dòng

- Thanh khoản

- địa điểm thư viện nào

- logic

- tìm kiếm

- Thấp

- thấp nhất

- duy trì

- chính

- LÀM CHO

- Làm

- quản lý

- quản lý

- giám đốc

- Quản lý

- quản lý

- cách thức

- nhiều

- thị trường

- Dữ liệu thị trường

- tác động thị trường

- nghiên cứu thị trường

- Sự biến động của thị trường

- Thị trường chứng khoán

- thị trường

- lớn

- Làm chủ

- tối đa

- Có thể..

- đo

- tin nhắn

- tin nhắn

- tỉ mỉ

- tỉ mỉ

- Metrics

- triệu

- giảm thiểu

- phút

- giám sát

- chi tiết

- Hơn thế nữa

- hầu hết

- nhiều

- nhiều

- tên

- Thiên nhiên

- Điều hướng

- Cần

- nhu cầu

- Không áp dụng

- máy tính xách tay

- máy tính xách tay

- con số

- nhiều

- cục mịch

- quan sát

- of

- cung cấp

- Cung cấp

- on

- ONE

- tối ưu

- Tối ưu hóa

- tối ưu hóa

- Tùy chọn

- Các lựa chọn

- or

- tổ chức

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- ra

- đầu ra

- kết thúc

- tổng thể

- riêng

- gấu trúc

- một phần

- Đối tác

- đam mê

- mô hình

- Đỉnh

- mỗi

- thực hiện

- hiệu suất

- quan trọng

- nền tảng

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- đóng

- xin vui lòng

- âm mưu

- danh mục đầu tư

- người quản lý danh mục đầu tư

- định vị

- Bài đăng

- Giao dịch sau

- tiềm năng

- Độ chính xác

- Chuẩn bị

- chuẩn bị

- giá

- giá

- chính

- Hiệu trưởng

- quá trình

- Quy trình

- xử lý

- Bộ xử lý

- Sản phẩm

- quản lý sản phẩm

- giám đốc sản xuất

- Sản phẩm

- Tiến độ

- cho

- cung cấp

- công bố

- Python

- Q3

- định lượng

- số lượng, lượng

- truy vấn

- dấu ngoặc kép

- Tỷ lệ

- Giá

- Đọc

- thực

- thời gian thực

- đề nghị

- hồ sơ

- đỏ

- giảm

- làm giảm

- tài liệu tham khảo

- refinitiv

- Báo cáo

- Báo cáo

- kho

- yêu cầu

- đòi hỏi

- nghiên cứu

- phản ứng

- chịu trách nhiệm

- kết quả

- kết quả

- Kết quả

- trở lại

- rủi ro

- Vai trò

- chạy

- chạy

- bán

- khả năng mở rộng

- khả năng mở rộng

- quy mô

- mở rộng quy mô

- liền mạch

- liền mạch

- Thứ hai

- giây

- Phần

- phần

- Chứng khoán

- an ninh

- tìm kiếm

- chọn

- chọn

- cao cấp

- riêng biệt

- phục vụ

- DỊCH VỤ

- định

- thiết lập

- hiển thị

- Chương trình

- đáng kể

- tương tự

- Đơn giản

- đơn giản hóa

- duy nhất

- trượt

- Phần mềm

- phát triển phần mềm

- Kỹ sư phần mềm

- Giải pháp

- tinh vi

- Vôn

- Spark

- riêng

- lan tràn

- Lây lan

- đứng

- Các bước

- là gắn

- hàng

- Chiến lược

- chiến lược

- Chiến lược

- sắp xếp hợp lý

- Học tập

- tiếp theo

- như vậy

- SWIFT

- biểu tượng

- sức mạnh tổng hợp

- Hãy

- dùng

- nhóm

- Kỹ thuật

- kỹ thuật

- Công nghệ

- thử nghiệm

- hơn

- việc này

- Sản phẩm

- thông tin

- cung cấp their dịch

- Them

- sau đó

- Kia là

- điều này

- Thông qua

- đánh dấu

- thời gian

- hợp thời

- dấu thời gian

- Yêu sách

- đến

- Tổng số:

- tp

- TPR

- thương mại

- Thương nhân

- ngành nghề

- Giao dịch

- Chiến lược giao dịch

- chiến lược kinh doanh

- giao dịch

- chi phí giao dịch

- biến đổi

- quá trình chuyển đổi

- Cực

- Dưới

- trải qua

- nâng cấp

- us

- Sử dụng

- sử dụng

- đã sử dụng

- sử dụng

- sử dụng

- Bằng cách sử dụng

- giá trị

- khác nhau

- hình dung

- hình dung

- Biến động

- khối lượng

- khối lượng

- là

- we

- web

- các dịch vụ web

- khi nào

- cái nào

- rộng rãi

- sẽ

- với

- ở trong

- không có

- Nhóm làm việc

- đang làm việc

- công trinh

- khắp thế giới

- lo

- X

- năm

- bạn

- trên màn hình

- zephyrnet