Giới thiệu

Thế hệ tăng cường truy xuất hay RAG là một cơ chế giúp các mô hình ngôn ngữ lớn (LLM) như GPT trở nên hữu ích và hiểu biết hơn bằng cách lấy thông tin từ kho dữ liệu hữu ích, giống như tìm nạp sách từ thư viện. Đây là cách RAG tạo nên điều kỳ diệu với quy trình làm việc AI đơn giản:

- Cơ sở kiến thức (Đầu vào): Hãy coi đây như một thư viện lớn chứa đầy nội dung hữu ích—Câu hỏi thường gặp, sách hướng dẫn, tài liệu, v.v. Khi một câu hỏi bật lên, đây là nơi hệ thống tìm kiếm câu trả lời.

- Kích hoạt/Truy vấn (Đầu vào): Đây là điểm khởi đầu. Thông thường, đó là một câu hỏi hoặc một yêu cầu từ người dùng để báo cho hệ thống biết: “Này, tôi cần bạn làm điều gì đó!”

- Nhiệm vụ/Hành động (Đầu ra): Khi hệ thống được kích hoạt, nó sẽ bắt đầu hoạt động. Nếu đó là một câu hỏi, nó sẽ tìm ra câu trả lời. Nếu đó là một yêu cầu để làm điều gì đó, nó sẽ thực hiện được điều đó.

Bây giờ, hãy chia cơ chế RAG thành các bước đơn giản:

- Truy xuất: Trước hết, khi có câu hỏi hoặc yêu cầu, RAG sẽ tìm kiếm trong Cơ sở Kiến thức để tìm thông tin liên quan.

- Mở rộng: Tiếp theo, nó lấy thông tin này và trộn nó với câu hỏi hoặc yêu cầu ban đầu. Điều này giống như việc thêm nhiều chi tiết hơn vào yêu cầu cơ bản để đảm bảo hệ thống hiểu đầy đủ về yêu cầu đó.

- Thế hệ: Cuối cùng, với tất cả thông tin phong phú này trong tay, nó sẽ đưa thông tin đó vào một mô hình ngôn ngữ lớn để sau đó tạo ra phản hồi đầy đủ thông tin hoặc thực hiện hành động được yêu cầu.

Vì vậy, tóm lại, RAG giống như có một trợ lý thông minh có nhiệm vụ tra cứu thông tin hữu ích trước tiên, kết hợp thông tin đó với câu hỏi hiện tại, sau đó đưa ra câu trả lời đầy đủ hoặc thực hiện một nhiệm vụ nếu cần. Bằng cách này, với RAG, hệ thống AI của bạn không chỉ hoạt động trong bóng tối; nó có một cơ sở thông tin vững chắc để làm việc, khiến nó trở nên đáng tin cậy và hữu ích hơn.

Họ giải quyết vấn đề gì?

Thu hẹp khoảng cách kiến thức

AI sáng tạo, được hỗ trợ bởi LLM, thành thạo trong việc tạo ra các phản hồi văn bản dựa trên lượng dữ liệu khổng lồ mà nó đã được đào tạo. Mặc dù khóa đào tạo này cho phép tạo văn bản chi tiết và dễ đọc nhưng tính chất tĩnh của dữ liệu đào tạo là một hạn chế nghiêm trọng. Thông tin trong mô hình sẽ trở nên lỗi thời theo thời gian và trong tình huống động như chatbot của công ty, việc thiếu dữ liệu theo thời gian thực hoặc dành riêng cho tổ chức có thể dẫn đến phản hồi không chính xác hoặc gây hiểu nhầm. Kịch bản này gây bất lợi vì nó làm suy yếu niềm tin của người dùng vào công nghệ, đặt ra thách thức đáng kể, đặc biệt là trong các ứng dụng lấy khách hàng làm trung tâm hoặc có nhiệm vụ quan trọng.

Giải pháp RAG

RAG ra tay giải cứu bằng cách kết hợp các khả năng tổng hợp của LLM với khả năng truy xuất thông tin có mục tiêu, theo thời gian thực mà không làm thay đổi mô hình cơ bản. Sự kết hợp này cho phép hệ thống AI cung cấp các phản hồi không chỉ phù hợp với ngữ cảnh mà còn dựa trên dữ liệu mới nhất. Ví dụ: trong kịch bản giải đấu thể thao, trong khi LLM có thể cung cấp thông tin chung về môn thể thao hoặc các đội, RAG trao quyền cho AI cung cấp thông tin cập nhật theo thời gian thực về các trận đấu gần đây hoặc chấn thương của người chơi bằng cách truy cập các nguồn dữ liệu bên ngoài như cơ sở dữ liệu, nguồn cấp tin tức hoặc thậm chí cả kho dữ liệu riêng của giải đấu.

Dữ liệu luôn được cập nhật

Bản chất của RAG nằm ở khả năng tăng cường LLM bằng dữ liệu mới, theo miền cụ thể. Việc cập nhật liên tục kho kiến thức trong RAG là một cách tiết kiệm chi phí để đảm bảo AI tổng hợp luôn cập nhật. Hơn nữa, nó cung cấp một lớp bối cảnh mà LLM tổng quát thiếu, do đó nâng cao chất lượng phản hồi. Khả năng xác định, sửa hoặc xóa thông tin không chính xác trong kho kiến thức của RAG càng làm tăng thêm sức hấp dẫn của nó, đảm bảo cơ chế tự sửa để truy xuất thông tin chính xác hơn.

Ví dụ về quy trình làm việc RAG

Trong lĩnh vực đang phát triển của trí tuệ nhân tạo, Thế hệ tăng cường truy xuất (RAG) đang tạo ra tác động đáng kể trên các lĩnh vực kinh doanh khác nhau bằng cách nâng cao đáng kể khả năng của Mô hình ngôn ngữ lớn (LLM). Chúng ta hãy xem xét một số ví dụ để hiểu cách quy trình công việc RAG tự động hóa các tác vụ –

- Truy xuất và chia sẻ kiến thức nội bộ của nhóm:

- kịch bản: Một tập đoàn đa quốc gia với danh mục dự án đa dạng thường phải đối mặt với những thách thức trong việc chia sẻ kiến thức và hiểu biết sâu sắc một cách hiệu quả giữa các nhóm của mình. Để giảm bớt điều này, công ty triển khai nền tảng tăng cường RAG để hợp lý hóa việc truy xuất và chia sẻ kiến thức nội bộ.

- Quy trình làm việc:

- Truy xuất:

- Truy vấn ví dụ: Người quản lý dự án hỏi: “Chúng tôi đã thực hiện bất kỳ dự án nào liên quan đến năng lượng tái tạo trong ba năm qua chưa?”

- Cơ chế RAG tìm kiếm ngay lập tức thông qua cơ sở dữ liệu nội bộ, báo cáo dự án trước đây và bất kỳ kho lưu trữ có liên quan nào khác để truy xuất thông tin liên quan đến sự tham gia của công ty vào các dự án năng lượng tái tạo trong khoảng thời gian được chỉ định.

- Mở rộng:

- Dữ liệu được truy xuất bao gồm tên dự án, nhân sự chủ chốt, sản phẩm bàn giao cuối cùng và kết quả của từng dự án.

- Nó cũng có thể tìm nạp các liên kết tới bất kỳ thông tin liên lạc, bài thuyết trình hoặc tài liệu nào có liên quan đã được chia sẻ nội bộ trong quá trình thực hiện các dự án này.

- Thế hệ:

- Câu trả lời mẫu: Hệ thống tạo ra phản hồi toàn diện:

“Đúng vậy, trong ba năm qua, chúng tôi đã tham gia vào ba dự án năng lượng tái tạo lớn. Dự án 'Đổi mới năng lượng mặt trời' do Sarah Johnson từ Nhóm Phát triển bền vững dẫn đầu và kết thúc vào tháng 2021 năm 2022 với việc phát triển nguyên mẫu trạm sạc chạy bằng năng lượng mặt trời. Dự án 'Hiệu quả Năng lượng Gió' do Mark D'Souza đứng đầu, nhằm nâng cao hiệu suất của tuabin gió và được hoàn thành vào tháng 2022 năm XNUMX. Cuối cùng, 'Vận động Chính sách Năng lượng Tái tạo' là một sáng kiến liên ngành được kết thúc vào tháng XNUMX năm XNUMX, tạo ra một đề xuất chính sách để thúc đẩy việc áp dụng năng lượng tái tạo trong cộng đồng địa phương. Các tài liệu, báo cáo và bài thuyết trình liên quan có thể được truy cập thông qua các liên kết được cung cấp.”

- Câu trả lời mẫu: Hệ thống tạo ra phản hồi toàn diện:

- Truy xuất:

- Chiến dịch tiếp thị tự động:

- Kịch bản: Một đại lý tiếp thị kỹ thuật số triển khai RAG để tự động hóa việc tạo và triển khai các chiến dịch tiếp thị dựa trên xu hướng thị trường và hành vi của người tiêu dùng theo thời gian thực.

- Quy trình làm việc:

- Truy xuất: Bất cứ khi nào có khách hàng tiềm năng mới vào hệ thống, cơ chế RAG sẽ tìm nạp các thông tin chi tiết có liên quan về khách hàng tiềm năng và tổ chức của họ, đồng thời kích hoạt quá trình bắt đầu quy trình làm việc.

- Mở rộng: Nó kết hợp dữ liệu này với các mục tiêu tiếp thị, nguyên tắc thương hiệu và nhân khẩu học mục tiêu của khách hàng.

- Thực hiện nhiệm vụ: Hệ thống tự động thiết kế và triển khai chiến dịch tiếp thị phù hợp trên nhiều kênh kỹ thuật số khác nhau để tận dụng xu hướng đã xác định, theo dõi hiệu suất của chiến dịch trong thời gian thực để có những điều chỉnh có thể.

- Nghiên cứu pháp lý và chuẩn bị hồ sơ:

- Kịch bản: Một công ty luật tích hợp RAG để đẩy nhanh quá trình nghiên cứu pháp lý và chuẩn bị hồ sơ.

- Quy trình làm việc:

- Truy xuất: Khi cung cấp thông tin về một vụ án mới, nó sẽ đưa ra các tiền lệ, quy chế và phán quyết gần đây có liên quan.

- Mở rộng: Nó tương quan dữ liệu này với các chi tiết trường hợp.

- Thế hệ: Hệ thống soạn thảo bản tóm tắt vụ việc sơ bộ, giúp giảm đáng kể thời gian luật sư dành cho việc nghiên cứu sơ bộ.

- Nâng cao dịch vụ khách hàng:

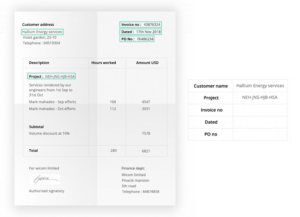

- Kịch bản: Một công ty viễn thông triển khai chatbot được tăng cường RAG để xử lý các thắc mắc của khách hàng về chi tiết gói, thanh toán và khắc phục các sự cố thường gặp.

- Quy trình làm việc:

- Truy xuất: Khi nhận được truy vấn về trợ cấp dữ liệu của một gói cụ thể, hệ thống sẽ tham chiếu các gói và ưu đãi mới nhất từ cơ sở dữ liệu của nó.

- Mở rộng: Nó kết hợp thông tin được truy xuất này với chi tiết gói hiện tại của khách hàng (từ hồ sơ khách hàng) và truy vấn ban đầu.

- Thế hệ: Hệ thống tạo ra phản hồi phù hợp, giải thích sự khác biệt về dung lượng dữ liệu giữa gói hiện tại của khách hàng và gói được truy vấn.

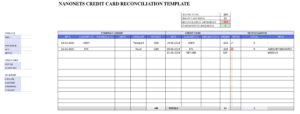

- Quản lý hàng tồn kho và sắp xếp lại:

- kịch bản: Một công ty thương mại điện tử sử dụng hệ thống tăng cường RAG để quản lý hàng tồn kho và tự động sắp xếp lại sản phẩm khi mức tồn kho giảm xuống dưới ngưỡng xác định trước.

- Quy trình làm việc:

- Truy xuất: Khi lượng tồn kho của sản phẩm đạt đến mức thấp, hệ thống sẽ kiểm tra lịch sử bán hàng, biến động nhu cầu theo mùa và xu hướng thị trường hiện tại từ cơ sở dữ liệu của nó.

- Tăng cường: Kết hợp dữ liệu được truy xuất với tần suất đặt hàng lại của sản phẩm, thời gian giao hàng và thông tin chi tiết về nhà cung cấp, nó sẽ xác định số lượng tối ưu để đặt hàng lại.

- Thực hiện nhiệm vụ: Sau đó, hệ thống sẽ giao tiếp với phần mềm mua sắm của công ty để tự động đặt hàng với nhà cung cấp, đảm bảo nền tảng thương mại điện tử không bao giờ hết sản phẩm được ưa chuộng.

- Giới thiệu nhân viên và thiết lập CNTT:

- kịch bản: Một tập đoàn đa quốc gia sử dụng hệ thống hỗ trợ RAG để hợp lý hóa quy trình làm quen với nhân viên mới, đảm bảo rằng tất cả các yêu cầu về CNTT đều được thiết lập trước ngày làm việc đầu tiên của nhân viên.

- Quy trình làm việc:

- Truy xuất: Khi nhận được thông tin chi tiết về nhân viên mới được tuyển dụng, hệ thống sẽ tham khảo cơ sở dữ liệu nhân sự để xác định vai trò, bộ phận và vị trí của nhân viên.

- Tăng cường: Nó liên kết thông tin này với các chính sách CNTT của công ty, xác định phần mềm, phần cứng và quyền truy cập mà nhân viên mới sẽ cần.

- Thực hiện nhiệm vụ: Sau đó, hệ thống sẽ liên lạc với hệ thống tạo yêu cầu của bộ phận CNTT, tự động tạo yêu cầu để thiết lập máy trạm mới, cài đặt phần mềm cần thiết và cấp quyền truy cập hệ thống phù hợp. Điều này đảm bảo rằng khi nhân viên mới bắt đầu, nơi làm việc của họ đã sẵn sàng và họ có thể ngay lập tức bắt tay vào thực hiện trách nhiệm của mình.

Những ví dụ này nhấn mạnh tính linh hoạt và lợi ích thiết thực của việc sử dụng quy trình làm việc RAG trong việc giải quyết các thách thức kinh doanh phức tạp, theo thời gian thực trên vô số lĩnh vực.

Kết nối dữ liệu và ứng dụng của bạn với Trợ lý AI Nanonets để trò chuyện với dữ liệu, triển khai các chatbot và tác nhân tùy chỉnh cũng như tạo quy trình công việc RAG.

Làm cách nào để xây dựng Quy trình làm việc RAG của riêng bạn?

Quy trình xây dựng quy trình làm việc RAG

Quá trình xây dựng quy trình làm việc Thế hệ tăng cường truy xuất (RAG) có thể được chia thành nhiều bước chính. Các bước này có thể được phân loại thành ba quy trình chính: tiêu hóa, thu hồivà thế hệ, cũng như một số chuẩn bị bổ sung:

1. Chuẩn bị:

- Chuẩn bị cơ sở kiến thức: Chuẩn bị kho lưu trữ dữ liệu hoặc cơ sở kiến thức bằng cách nhập dữ liệu từ nhiều nguồn khác nhau – ứng dụng, tài liệu, cơ sở dữ liệu. Dữ liệu này phải được định dạng để cho phép khả năng tìm kiếm hiệu quả, về cơ bản có nghĩa là dữ liệu này phải được định dạng thành một biểu diễn đối tượng 'Tài liệu' thống nhất.

2. Quá trình ăn vào:

- Thiết lập cơ sở dữ liệu vectơ: Sử dụng Cơ sở dữ liệu vectơ làm cơ sở kiến thức, sử dụng các thuật toán lập chỉ mục khác nhau để sắp xếp các vectơ chiều cao, cho phép khả năng truy vấn nhanh và mạnh mẽ.

- Trích xuất dữ liệu: Trích xuất dữ liệu từ các tài liệu này.

- Phân chia dữ liệu: Chia nhỏ tài liệu thành các phần dữ liệu.

- Nhúng dữ liệu: Chuyển đổi các phần này thành phần nhúng bằng cách sử dụng mô hình nhúng giống như mô hình do OpenAI cung cấp.

- Phát triển cơ chế để nhập truy vấn người dùng của bạn. Đây có thể là giao diện người dùng hoặc quy trình làm việc dựa trên API.

3. Quá trình truy xuất:

- Nhúng truy vấn: Nhận dữ liệu nhúng cho truy vấn của người dùng.

- Truy xuất đoạn: Thực hiện tìm kiếm kết hợp để tìm các khối được lưu trữ phù hợp nhất trong Cơ sở dữ liệu Vector dựa trên việc nhúng truy vấn.

- Kéo nội dung: Kéo nội dung phù hợp nhất từ cơ sở kiến thức của bạn vào lời nhắc làm ngữ cảnh.

4. Quá trình tạo:

- Tạo lời nhắc: Kết hợp thông tin được truy xuất với truy vấn ban đầu để tạo thành lời nhắc. Bây giờ, bạn có thể thực hiện –

- Tạo phản hồi: Gửi văn bản nhắc nhở kết hợp tới LLM (Mô hình ngôn ngữ lớn) để tạo phản hồi đầy đủ thông tin.

- Thực hiện nhiệm vụ: Gửi văn bản nhắc nhở kết hợp tới tác nhân dữ liệu LLM của bạn để suy ra nhiệm vụ chính xác cần thực hiện dựa trên truy vấn của bạn và thực hiện nó. Ví dụ: bạn có thể tạo tác nhân dữ liệu Gmail rồi nhắc tác nhân đó “gửi email quảng cáo tới khách hàng tiềm năng gần đây của Hubspot” và tác nhân dữ liệu sẽ –

- tìm nạp khách hàng tiềm năng gần đây từ Hubspot.

- sử dụng cơ sở kiến thức của bạn để có được thông tin liên quan về khách hàng tiềm năng. Cơ sở kiến thức của bạn có thể nhập dữ liệu từ nhiều nguồn dữ liệu – LinkedIn, API làm giàu khách hàng tiềm năng, v.v.

- quản lý các email quảng cáo được cá nhân hóa cho từng khách hàng tiềm năng.

- gửi những email này bằng cách sử dụng nhà cung cấp email/người quản lý chiến dịch email của bạn.

5. Cấu hình và tối ưu hóa:

- Customization: Tùy chỉnh quy trình làm việc để phù hợp với các yêu cầu cụ thể, có thể bao gồm việc điều chỉnh luồng nhập, chẳng hạn như tiền xử lý, phân nhóm và chọn mô hình nhúng.

- Tối ưu hóa: Triển khai các chiến lược tối ưu hóa để cải thiện chất lượng truy xuất và giảm số lượng mã thông báo cần xử lý, điều này có thể dẫn đến tối ưu hóa hiệu suất và chi phí trên quy mô lớn.

Tự mình thực hiện

Triển khai quy trình làm việc Thế hệ tăng cường truy xuất (RAG) là một nhiệm vụ phức tạp bao gồm nhiều bước và hiểu rõ về các thuật toán và hệ thống cơ bản. Dưới đây là những thách thức và bước nổi bật để vượt qua chúng đối với những người muốn triển khai quy trình làm việc RAG:

Những thách thức trong việc xây dựng quy trình làm việc RAG của riêng bạn:

- Tính mới và thiếu các thông lệ đã được thiết lập: RAG là một công nghệ tương đối mới, được đề xuất lần đầu tiên vào năm 2020 và các nhà phát triển vẫn đang tìm ra các phương pháp hay nhất để triển khai cơ chế truy xuất thông tin của nó trong Generative AI.

- Chi phí: Việc triển khai RAG sẽ tốn kém hơn so với việc chỉ sử dụng Mô hình ngôn ngữ lớn (LLM). Tuy nhiên, nó ít tốn kém hơn so với việc thường xuyên đào tạo lại LLM.

- Cấu trúc dữ liệu: Việc xác định cách mô hình hóa tốt nhất dữ liệu có cấu trúc và phi cấu trúc trong thư viện tri thức và cơ sở dữ liệu vectơ là một thách thức chính.

- Cung cấp dữ liệu gia tăng: Việc phát triển các quy trình để cung cấp dữ liệu dần dần vào hệ thống RAG là rất quan trọng.

- Xử lý sai sót: Việc áp dụng các quy trình để xử lý các báo cáo về sự không chính xác và sửa hoặc xóa các nguồn thông tin đó trong hệ thống RAG là cần thiết.

Kết nối dữ liệu và ứng dụng của bạn với Trợ lý AI Nanonets để trò chuyện với dữ liệu, triển khai các chatbot và tác nhân tùy chỉnh cũng như tạo quy trình công việc RAG.

Cách bắt đầu tạo Quy trình làm việc RAG của riêng bạn:

Việc triển khai quy trình làm việc RAG đòi hỏi sự kết hợp giữa kiến thức kỹ thuật, công cụ phù hợp cũng như học hỏi và tối ưu hóa liên tục để đảm bảo tính hiệu quả và hiệu suất của nó trong việc đáp ứng các mục tiêu của bạn. Đối với những người muốn tự mình triển khai quy trình công việc RAG, chúng tôi đã tuyển chọn một danh sách các hướng dẫn thực hành toàn diện để hướng dẫn bạn chi tiết về các quy trình triển khai –

Mỗi hướng dẫn đều có một cách tiếp cận hoặc nền tảng riêng để đạt được cách triển khai mong muốn đối với các chủ đề được chỉ định.

Nếu bạn đang muốn đi sâu vào việc xây dựng quy trình làm việc RAG của riêng mình, chúng tôi khuyên bạn nên xem tất cả các bài viết được liệt kê ở trên để có được cảm nhận tổng thể cần thiết để bắt đầu hành trình của mình.

Triển khai quy trình làm việc RAG bằng Nền tảng ML

Mặc dù sức hấp dẫn của việc xây dựng quy trình làm việc Thế hệ tăng cường truy xuất (RAG) ngay từ đầu mang lại cảm giác hoàn thành và tùy chỉnh nhất định, nhưng không thể phủ nhận đó là một nỗ lực phức tạp. Nhận thức được những phức tạp và thách thức, một số doanh nghiệp đã bước tới, cung cấp các nền tảng và dịch vụ chuyên biệt để đơn giản hóa quy trình này. Việc tận dụng các nền tảng này không chỉ có thể tiết kiệm thời gian và nguồn lực quý giá mà còn đảm bảo rằng việc triển khai dựa trên các phương pháp hay nhất trong ngành và được tối ưu hóa cho hiệu suất.

Đối với các tổ chức hoặc cá nhân có thể không có đủ băng thông hoặc chuyên môn để xây dựng hệ thống RAG từ đầu, các nền tảng ML này là một giải pháp khả thi. Bằng cách chọn các nền tảng này, người ta có thể:

- Bỏ qua sự phức tạp về mặt kỹ thuật: Tránh các bước phức tạp của quá trình cấu trúc, nhúng và truy xuất dữ liệu. Các nền tảng này thường đi kèm với các giải pháp và khung dựng sẵn phù hợp với quy trình công việc RAG.

- Tận dụng chuyên môn: Hưởng lợi từ kiến thức chuyên môn của các chuyên gia có hiểu biết sâu sắc về hệ thống RAG và đã giải quyết được nhiều thách thức liên quan đến việc triển khai hệ thống này.

- khả năng mở rộng: Các nền tảng này thường được thiết kế có tính đến khả năng mở rộng, đảm bảo rằng khi dữ liệu của bạn phát triển hoặc yêu cầu của bạn thay đổi, hệ thống có thể thích ứng mà không cần đại tu hoàn chỉnh.

- Hiệu quả chi phí: Mặc dù có chi phí liên quan đến việc sử dụng nền tảng nhưng về lâu dài, nó có thể tiết kiệm chi phí hơn, đặc biệt khi xem xét chi phí khắc phục sự cố, tối ưu hóa và khả năng triển khai lại.

Chúng ta hãy xem các nền tảng cung cấp khả năng tạo quy trình làm việc RAG.

Ống nano

Nanonets cung cấp trợ lý AI, chatbot và quy trình làm việc RAG an toàn được hỗ trợ bởi dữ liệu của công ty bạn. Nó cho phép đồng bộ hóa dữ liệu theo thời gian thực giữa các nguồn dữ liệu khác nhau, tạo điều kiện truy xuất thông tin toàn diện cho các nhóm. Nền tảng này cho phép tạo các chatbot cùng với việc triển khai các quy trình công việc phức tạp thông qua ngôn ngữ tự nhiên, được cung cấp bởi Mô hình ngôn ngữ lớn (LLM). Nó cũng cung cấp các trình kết nối dữ liệu để đọc và ghi dữ liệu trong ứng dụng của bạn cũng như khả năng sử dụng các tác nhân LLM để trực tiếp thực hiện các hành động trên các ứng dụng bên ngoài.

Trang sản phẩm trợ lý AI của Nanonets

AI sáng tạo AWS

AWS cung cấp nhiều dịch vụ và công cụ khác nhau dưới sự bảo trợ của Generative AI để phục vụ các nhu cầu kinh doanh khác nhau. Nó cung cấp quyền truy cập vào nhiều mô hình nền tảng hàng đầu trong ngành từ nhiều nhà cung cấp khác nhau thông qua Amazon Bedrock. Người dùng có thể tùy chỉnh các mô hình nền tảng này bằng dữ liệu của riêng họ để xây dựng trải nghiệm cá nhân hóa và khác biệt hơn. AWS nhấn mạnh đến tính bảo mật và quyền riêng tư, đảm bảo bảo vệ dữ liệu khi tùy chỉnh các mô hình nền tảng. Nó cũng nêu bật cơ sở hạ tầng tiết kiệm chi phí để mở rộng quy mô AI tổng hợp, với các tùy chọn như AWS Trainium, AWS Inferentia và GPU NVIDIA để đạt được hiệu suất ở mức giá tốt nhất. Hơn nữa, AWS còn tạo điều kiện thuận lợi cho việc xây dựng, đào tạo và triển khai các mô hình nền tảng trên Amazon SageMaker, mở rộng sức mạnh của các mô hình nền tảng cho các trường hợp sử dụng cụ thể của người dùng.

Trang sản phẩm AI sáng tạo của AWS

AI sáng tạo trên Google Cloud

AI sáng tạo của Google Cloud cung cấp một bộ công cụ mạnh mẽ để phát triển các mô hình AI, nâng cao khả năng tìm kiếm và hỗ trợ các cuộc hội thoại do AI điều khiển. Nó vượt trội trong phân tích tình cảm, xử lý ngôn ngữ, công nghệ giọng nói và quản lý tài liệu tự động. Ngoài ra, nó có thể tạo ra các quy trình làm việc RAG và các đại lý LLM, phục vụ các yêu cầu kinh doanh đa dạng bằng cách tiếp cận đa ngôn ngữ, biến nó thành một giải pháp toàn diện cho các nhu cầu khác nhau của doanh nghiệp.

AI sáng tạo trên nền tảng đám mây của Google

AI sáng tạo của Oracle

AI Sáng tạo của Oracle (OCI Generative AI) được thiết kế riêng cho doanh nghiệp, cung cấp các mô hình ưu việt kết hợp với khả năng quản lý dữ liệu, cơ sở hạ tầng AI và ứng dụng kinh doanh xuất sắc. Nó cho phép tinh chỉnh các mô hình sử dụng dữ liệu của chính người dùng mà không chia sẻ nó với các nhà cung cấp mô hình ngôn ngữ lớn hoặc khách hàng khác, do đó đảm bảo tính bảo mật và quyền riêng tư. Nền tảng này cho phép triển khai các mô hình trên các cụm AI chuyên dụng để có thể dự đoán được hiệu suất và giá cả. OCI Generative AI cung cấp nhiều trường hợp sử dụng khác nhau như tóm tắt văn bản, tạo bản sao, tạo chatbot, chuyển đổi phong cách, phân loại văn bản và tìm kiếm dữ liệu, giải quyết nhiều nhu cầu của doanh nghiệp. Nó xử lý dữ liệu đầu vào của người dùng, có thể bao gồm ngôn ngữ tự nhiên, ví dụ đầu vào/đầu ra và hướng dẫn để tạo, tóm tắt, chuyển đổi, trích xuất thông tin hoặc phân loại văn bản dựa trên yêu cầu của người dùng, gửi lại phản hồi ở định dạng đã chỉ định.

Cloudera

Trong lĩnh vực Generative AI, Cloudera nổi lên như một đồng minh đáng tin cậy cho các doanh nghiệp. Lakehouse dữ liệu mở của họ, có thể truy cập được trên cả đám mây công cộng và riêng tư, là nền tảng. Họ cung cấp một loạt dịch vụ dữ liệu hỗ trợ toàn bộ hành trình vòng đời dữ liệu, từ biên đến AI. Khả năng của họ mở rộng sang truyền dữ liệu theo thời gian thực, lưu trữ và phân tích dữ liệu trong các hồ mở cũng như triển khai và giám sát các mô hình học máy thông qua Nền tảng dữ liệu Cloudera. Điều đáng chú ý là Cloudera cho phép tạo ra các quy trình công việc của Thế hệ tăng cường truy xuất, kết hợp sự kết hợp mạnh mẽ giữa khả năng truy xuất và tạo cho các ứng dụng AI nâng cao.

Lượm lặt

Glean sử dụng AI để tăng cường tìm kiếm tại nơi làm việc và khám phá kiến thức. Nó tận dụng tìm kiếm vectơ và các mô hình ngôn ngữ lớn dựa trên học sâu để hiểu ngữ nghĩa của các truy vấn, liên tục cải thiện mức độ liên quan của tìm kiếm. Nó cũng cung cấp trợ lý Generative AI để trả lời các truy vấn và tóm tắt thông tin trên các tài liệu, yêu cầu, v.v. Nền tảng này cung cấp kết quả tìm kiếm được cá nhân hóa và đề xuất thông tin dựa trên hoạt động và xu hướng của người dùng, bên cạnh việc hỗ trợ thiết lập và tích hợp dễ dàng với hơn 100 trình kết nối với nhiều ứng dụng khác nhau.

đất đai

Landbot cung cấp một bộ công cụ để tạo ra trải nghiệm đàm thoại. Nó tạo điều kiện thuận lợi cho việc tạo ra khách hàng tiềm năng, thu hút khách hàng và hỗ trợ thông qua chatbot trên trang web hoặc WhatsApp. Người dùng có thể thiết kế, triển khai và mở rộng quy mô các chatbot bằng trình tạo không cần mã và tích hợp chúng với các nền tảng phổ biến như Slack và Messenger. Nó cũng cung cấp nhiều mẫu khác nhau cho các trường hợp sử dụng khác nhau như tạo khách hàng tiềm năng, hỗ trợ khách hàng và quảng bá sản phẩm

cơ sở trò chuyện

Chatbase cung cấp nền tảng để tùy chỉnh ChatGPT để phù hợp với đặc điểm của thương hiệu và giao diện trang web. Nó cho phép thu thập khách hàng tiềm năng, tóm tắt cuộc trò chuyện hàng ngày và tích hợp với các công cụ khác như Zapier, Slack và Messenger. Nền tảng này được thiết kế để cung cấp trải nghiệm chatbot được cá nhân hóa cho các doanh nghiệp.

Quy mô AI

AI quy mô giải quyết nút thắt dữ liệu trong phát triển ứng dụng AI bằng cách cung cấp tính năng tinh chỉnh và RLHF để điều chỉnh các mô hình nền tảng cho phù hợp với nhu cầu kinh doanh cụ thể. Nó tích hợp hoặc hợp tác với các mô hình AI hàng đầu, cho phép các doanh nghiệp kết hợp dữ liệu của họ để tạo sự khác biệt về mặt chiến lược. Cùng với khả năng tạo quy trình công việc RAG và tác nhân LLM, Scal AI cung cấp nền tảng AI toàn diện để tăng tốc phát triển ứng dụng AI.

Shakudo – LLM Solutions

Shakudo cung cấp giải pháp thống nhất để triển khai Mô hình ngôn ngữ lớn (LLM), quản lý cơ sở dữ liệu vectơ và thiết lập các đường dẫn dữ liệu mạnh mẽ. Nó hợp lý hóa quá trình chuyển đổi từ bản demo cục bộ sang dịch vụ LLM cấp sản xuất với tính năng giám sát thời gian thực và điều phối tự động. Nền tảng này hỗ trợ các hoạt động Generative AI linh hoạt, cơ sở dữ liệu vectơ thông lượng cao và cung cấp nhiều công cụ LLMOps chuyên dụng, nâng cao tính phong phú về chức năng của các nhóm công nghệ hiện có.

Trang sản phẩm quy trình làm việc của Shakundo RAG

Mỗi nền tảng/doanh nghiệp được đề cập đều có bộ tính năng và khả năng độc đáo riêng và có thể được khám phá thêm để hiểu cách chúng có thể được tận dụng để kết nối dữ liệu doanh nghiệp và triển khai quy trình công việc RAG.

Kết nối dữ liệu và ứng dụng của bạn với Trợ lý AI Nanonets để trò chuyện với dữ liệu, triển khai các chatbot và tác nhân tùy chỉnh cũng như tạo quy trình công việc RAG.

Quy trình làm việc RAG với Nanonet

Trong lĩnh vực tăng cường các mô hình ngôn ngữ để mang lại phản hồi chính xác và sâu sắc hơn, Thế hệ tăng cường truy xuất (RAG) đóng vai trò là một cơ chế then chốt. Quá trình phức tạp này nâng cao độ tin cậy và tính hữu dụng của các hệ thống AI, đảm bảo chúng không chỉ hoạt động trong môi trường chân không thông tin.

Trọng tâm của vấn đề này, Trợ lý AI Nanonets nổi lên như một người bạn đồng hành AI đa chức năng, an toàn được thiết kế để thu hẹp khoảng cách giữa kiến thức tổ chức của bạn và Mô hình ngôn ngữ lớn (LLM), tất cả đều nằm trong giao diện thân thiện với người dùng.

Dưới đây là cái nhìn thoáng qua về sự tích hợp liền mạch và cải tiến quy trình làm việc được cung cấp bởi khả năng RAG của Nanonets:

Kết nối dữ liệu:

Nanonet tạo điều kiện kết nối liền mạch với hơn 100 ứng dụng không gian làm việc phổ biến bao gồm Slack, Notion, Google Suite, Salesforce và Zendesk, cùng nhiều ứng dụng khác. Nó thành thạo trong việc xử lý nhiều loại dữ liệu, có thể là dữ liệu không có cấu trúc như tệp PDF, TXT, hình ảnh, âm thanh và video hoặc dữ liệu có cấu trúc như cơ sở dữ liệu CSV, bảng tính, MongoDB và SQL. Khả năng kết nối dữ liệu phổ rộng này đảm bảo nền tảng kiến thức vững chắc để cơ chế RAG có thể khai thác.

Tác nhân kích hoạt và hành động:

Với Nanonets, việc thiết lập các tác nhân kích hoạt/hành động thật dễ dàng. Các nhân viên này cảnh giác với các sự kiện trên các ứng dụng không gian làm việc của bạn, thực hiện các hành động theo yêu cầu. Ví dụ: thiết lập quy trình làm việc để theo dõi email mới tại support@your_company.com, sử dụng tài liệu của bạn và các cuộc trò chuyện qua email trước đây làm cơ sở kiến thức, soạn thảo một phản hồi email sâu sắc và gửi đi, tất cả đều được sắp xếp liền mạch.

Nhập và lập chỉ mục dữ liệu hợp lý:

Việc nhập và lập chỉ mục dữ liệu được tối ưu hóa là một phần của gói, đảm bảo quá trình xử lý dữ liệu suôn sẻ được xử lý ở chế độ nền bởi Trợ lý AI Nanonets. Sự tối ưu hóa này rất quan trọng để đồng bộ hóa thời gian thực với các nguồn dữ liệu, đảm bảo cơ chế RAG có thông tin mới nhất để hoạt động.

Để bắt đầu, bạn có thể thực hiện cuộc gọi với một trong các chuyên gia AI của chúng tôi và chúng tôi có thể cung cấp cho bạn bản demo và bản dùng thử được cá nhân hóa về Trợ lý AI Nanonets dựa trên trường hợp sử dụng của bạn.

Sau khi thiết lập, bạn có thể sử dụng Trợ lý AI Nanonets của mình để –

Tạo quy trình trò chuyện RAG

Trao quyền cho nhóm của bạn bằng thông tin toàn diện, theo thời gian thực từ tất cả các nguồn dữ liệu của bạn.

Tạo quy trình làm việc của đại lý RAG

Sử dụng ngôn ngữ tự nhiên để tạo và chạy các quy trình công việc phức tạp được hỗ trợ bởi LLM tương tác với tất cả ứng dụng và dữ liệu của bạn.

Triển khai Chatbots dựa trên RAG

Xây dựng và triển khai sẵn sàng sử dụng Chatbots AI tùy chỉnh có thể nhận biết bạn trong vòng vài phút.

Thúc đẩy hiệu quả nhóm của bạn

Với Nanonets AI, bạn không chỉ tích hợp dữ liệu; bạn đang tăng cường khả năng của nhóm mình. Bằng cách tự động hóa các nhiệm vụ đơn giản và đưa ra những phản hồi sâu sắc, nhóm của bạn có thể tái phân bổ trọng tâm vào các sáng kiến chiến lược.

Trợ lý AI điều khiển bằng RAG của Nanonets không chỉ là một công cụ; đó là chất xúc tác giúp hợp lý hóa các hoạt động, tăng cường khả năng tiếp cận dữ liệu và thúc đẩy tổ chức của bạn hướng tới một tương lai có khả năng ra quyết định và tự động hóa sáng suốt.

Kết nối dữ liệu và ứng dụng của bạn với Trợ lý AI Nanonets để trò chuyện với dữ liệu, triển khai các chatbot và tác nhân tùy chỉnh cũng như tạo quy trình công việc RAG.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://nanonets.com/blog/retrieval-augmented-generation/

- : có

- :là

- :không phải

- :Ở đâu

- $ LÊN

- 100

- 2020

- 2021

- 2022

- a

- có khả năng

- Giới thiệu

- ở trên

- tăng tốc

- truy cập

- truy cập

- khả năng tiếp cận

- có thể truy cập

- truy cập

- chính xác

- Đạt được

- ngang qua

- Hoạt động

- hành động

- hoạt động

- thích ứng

- thêm

- thêm vào

- Ngoài ra

- giải quyết

- địa chỉ

- giải quyết

- Thêm

- điều chỉnh

- điều chỉnh

- Nhận con nuôi

- vận động

- cơ quan

- Đại lý

- đại lý

- AI

- Trợ lý AI

- Mô hình AI

- Nền tảng AI

- Hệ thống AI

- nhằm vào

- thuật toán

- sắp xếp

- Tất cả

- giảm bớt

- cho phép

- cho phép

- quyến rũ

- Đồng minh

- cô đơn

- dọc theo

- Đã

- Ngoài ra

- đàn bà gan dạ

- Amazon SageMaker

- trong số

- số lượng

- an

- phân tích

- và

- trả lời

- câu trả lời

- bất kì

- API

- kháng cáo

- Các Ứng Dụng

- Phát triển ứng dụng

- các ứng dụng

- phương pháp tiếp cận

- thích hợp

- ứng dụng

- APT

- LÀ

- bài viết

- nhân tạo

- trí tuệ nhân tạo

- AS

- Trợ lý

- trợ lý

- liên kết

- At

- âm thanh

- tăng

- tăng cường

- tự động hóa

- Tự động

- tự động

- tự động hóa

- Tự động hóa

- tự chủ

- tránh

- AWS

- Suy luận AWS

- trở lại

- bối cảnh

- Băng thông

- cơ sở

- dựa

- cơ bản

- Về cơ bản

- BE

- trở nên

- trở thành

- trước

- hành vi

- phía dưới

- hưởng lợi

- Lợi ích

- ngoài ra

- BEST

- thực hành tốt nhất

- giữa

- lớn

- thanh toán

- Trộn

- pha trộn

- Blog

- cuốn sách

- cả hai

- thương hiệu

- Nghỉ giải lao

- CẦU

- Bị phá vỡ

- xây dựng

- xây dựng

- Xây dựng

- kinh doanh

- Ứng dụng kinh doanh

- các doanh nghiệp

- nhưng

- by

- cuộc gọi

- Chiến dịch

- Chiến dịch

- CAN

- Có thể có được

- khả năng

- tận

- trường hợp

- trường hợp

- Chất xúc tác

- phục vụ

- nhất định

- thách thức

- thách thức

- thay đổi

- kênh

- sạc

- chatbot

- chatbot

- ChatGPT

- kiểm tra

- Séc

- phân loại

- Phân loại

- đám mây

- Cloudera

- bộ sưu tập

- COM

- kết hợp

- kết hợp

- kết hợp

- kết hợp

- kết hợp

- Đến

- đến

- Chung

- Truyền thông

- Cộng đồng

- đồng

- công ty

- hoàn thành

- Hoàn thành

- phức tạp

- toàn diện

- kết luận

- Kết nối

- Kết nối

- Kết nối

- xem xét

- xây dựng

- người tiêu dùng

- hành vi tiêu dùng

- nội dung

- bối cảnh

- liên tục

- liên tục

- Conversation

- đàm thoại

- cuộc hội thoại

- Chuyển đổi

- nền tảng

- Doanh nghiệp

- TẬP ĐOÀN

- sửa chữa

- Phí Tổn

- chi phí-hiệu quả

- tốn kém

- Chi phí

- có thể

- kết

- khóa học mơ ước

- tạo

- Tạo

- tạo

- quan trọng

- quan trọng

- lưu trữ

- Current

- khách hàng

- khách hàng

- Cam kết của khách hàng

- Hỗ trợ khách hàng

- khách hàng

- tùy biến

- tùy chỉnh

- tiền thưởng

- tối

- dữ liệu

- quản lý dữ liệu

- Nền tảng dữ liệu

- xử lý dữ liệu

- bảo vệ dữ liệu

- lưu trữ dữ liệu

- Cơ sở dữ liệu

- cơ sở dữ liệu

- ngày

- Tháng mười hai

- Tháng Mười Hai 2021

- Ra quyết định

- dành riêng

- sâu

- cung cấp

- đào sâu

- Nhu cầu

- Demo

- Nhân khẩu học

- Demo

- bộ

- triển khai

- triển khai

- triển khai

- triển khai

- Thiết kế

- thiết kế

- thiết kế

- mong muốn

- chi tiết

- chi tiết

- chi tiết

- Xác định

- xác định

- xác định

- bất lợi

- phát triển

- phát triển

- Phát triển

- sự khác biệt

- khác nhau

- phân biệt

- kỹ thuật số

- thị kỹ thuật số

- trực tiếp

- phát hiện

- bổ nhào

- khác nhau

- đa dạng

- danh mục đầu tư đa dạng

- do

- tài liệu

- quản lý tài liệu

- tài liệu hướng dẫn

- tài liệu

- lĩnh vực

- thực hiện

- xuống

- dự thảo

- suốt trong

- năng động

- thương mại điện tử

- mỗi

- dễ dàng

- Cạnh

- hiệu quả

- hiệu quả

- hiệu quả

- hiệu quả

- hay

- độ cao

- nhúng

- nổi lên

- nhấn mạnh

- Công nhân

- nhân viên

- thuê mướn

- sử dụng

- trao quyền

- cho phép

- cho phép

- nỗ lực

- năng lượng

- hiệu quả năng lượng

- dự án năng lượng

- tham gia

- Tham gia

- nâng cao

- nâng cao

- tăng cường

- Nâng cao

- tăng cường

- đảm bảo

- đảm bảo

- đảm bảo

- Doanh nghiệp

- doanh nghiệp

- Toàn bộ

- đặc biệt

- bản chất

- thành lập

- thành lập

- thành lập

- vv

- Ether (ETH)

- Ngay cả

- sự kiện

- phát triển

- ví dụ

- ví dụ

- tuyệt vời

- thực hiện

- hiện tại

- giục

- đắt tiền

- kinh nghiệm

- Kinh nghiệm

- chuyên môn

- các chuyên gia

- giải thích

- Khám phá

- thêm

- mở rộng

- ngoài

- trích xuất

- khai thác

- khuôn mặt

- tạo điều kiện

- tạo điều kiện

- Rơi

- NHANH

- Tính năng

- cho ăn

- vài

- Các tập tin

- cuối cùng

- Tìm kiếm

- Công ty

- Tên

- phù hợp với

- linh hoạt

- dòng chảy

- biến động

- Tập trung

- Trong

- hình thức

- định dạng

- Forward

- Nền tảng

- khung

- tần số

- thường xuyên

- tươi

- từ

- Full

- đầy đủ

- chức năng

- xa hơn

- nhiệt hạch

- tương lai

- Trò chơi

- khoảng cách

- tạo ra

- tạo

- tạo ra

- thế hệ

- thế hệ

- Trí tuệ nhân tạo

- được

- gif

- Cho

- cho

- Nhìn thoáng qua

- gmail

- tốt

- GPU

- cấp

- Mặt đất

- Phát triển

- hướng dẫn

- Hướng dẫn

- tay

- xử lý

- Xử lý

- hands-on

- phần cứng

- Có

- có

- đứng đầu

- Trái Tim

- hữu ích

- giúp

- Nhấn mạnh

- nổi bật

- Thuê

- lịch sử

- toàn diện

- Độ đáng tin của

- Hướng dẫn

- Tuy nhiên

- hr

- HTTPS

- HubSpot

- Hỗn hợp

- i

- xác định

- xác định

- if

- hình ảnh

- ngay

- Va chạm

- thực hiện

- thực hiện

- thực hiện

- thực hiện

- nâng cao

- cải thiện

- in

- bao gồm

- bao gồm

- Bao gồm

- kết hợp

- các cá nhân

- ngành công nghiệp

- đầu ngành

- Thông tin

- thông tin

- thông báo

- Cơ sở hạ tầng

- bắt đầu

- Sáng kiến

- khả năng phán đoán

- đổi mới

- đầu vào

- sâu sắc

- những hiểu biết

- cài đặt, dựng lên

- ví dụ

- ngay lập tức

- hướng dẫn

- tích hợp

- Tích hợp

- Tích hợp

- hội nhập

- Sự thông minh

- tương tác

- Giao thức

- giao diện

- nội bộ

- nội bộ

- trong

- phức tạp

- phức tạp

- Giới thiệu

- hàng tồn kho

- sự tham gia

- liên quan đến

- các vấn đề

- IT

- ITS

- Johnson

- cuộc hành trình

- tháng sáu

- chỉ

- Key

- Biết

- kiến thức

- Thiếu sót

- Ngôn ngữ

- lớn

- cuối cùng

- mới nhất

- Luật

- công ty luật

- lớp

- dẫn

- hàng đầu

- Dẫn

- Liên minh

- học tập

- Led

- Hợp pháp

- ít

- cho phép

- Cấp

- niveaux

- tận dụng

- đòn bẩy

- tận dụng

- Thư viện

- nằm

- vòng đời

- Lượt thích

- giới hạn

- liên kết

- Danh sách

- Liệt kê

- địa phương

- địa điểm thư viện nào

- dài

- Xem

- tìm kiếm

- NHÌN

- Thấp

- máy

- học máy

- ma thuật

- Chủ yếu

- chính

- làm cho

- LÀM CHO

- Làm

- quản lý

- quản lý

- giám đốc

- quản lý

- nhiều

- dấu

- thị trường

- Xu hướng thị trường

- Marketing

- Cơ quan tiếp thị

- Chiến dịch quảng cáo

- Có thể..

- có nghĩa

- cơ chế

- cơ chế

- cuộc họp

- đề cập

- chỉ đơn thuần là

- sứ giả

- Might

- tâm

- phút

- gây hiểu lầm

- hỗn hợp

- ML

- kiểu mẫu

- mô hình

- MongoDB

- Màn Hình

- giám sát

- chi tiết

- Hơn thế nữa

- hầu hết

- nhiều

- đa quốc gia

- nhiều

- vô số

- Tự nhiên

- Ngôn ngữ tự nhiên

- Thiên nhiên

- cần thiết

- Cần

- cần thiết

- nhu cầu

- không bao giờ

- Mới

- tin tức

- tiếp theo

- Khái niệm

- tại

- nhiều

- Tóm lại

- Nvidia

- vật

- mục tiêu

- of

- off

- cung cấp

- cung cấp

- cung cấp

- Cung cấp

- thường

- on

- Tiếp nhận nhận việc

- hàng loạt

- ONE

- có thể

- mở

- dữ liệu mở

- OpenAI

- hoạt động

- Hoạt động

- tối ưu

- tối ưu hóa

- tối ưu hóa

- Các lựa chọn

- or

- oracle

- dàn xếp

- dàn nhạc

- gọi món

- cơ quan

- tổ chức

- tổ chức

- nguyên

- Nền tảng khác

- Khác

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- ra

- kết quả

- đầu ra

- kết thúc

- Vượt qua

- Đại tu

- riêng

- gói

- một phần

- Đối tác

- qua

- thực hiện

- hiệu suất

- thực hiện

- thời gian

- quyền

- Personality

- Cá nhân

- Nhân viên

- quan trọng

- Nơi

- kế hoạch

- kế hoạch

- nền tảng

- Nền tảng

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- máy nghe nhạc

- Điểm

- Chính sách

- điều luật

- Rất tiếc

- Phổ biến

- danh mục đầu tư

- có thể

- tiềm năng

- quyền lực

- -

- mạnh mẽ

- Thực tế

- thực hành

- cần

- Dự đoán

- sơ bộ

- chuẩn bị

- Chuẩn bị

- trình bày

- Thuyết trình

- giá

- giá

- riêng tư

- riêng

- Vấn đề

- quá trình

- Quy trình

- xử lý

- mua sắm

- Sản phẩm

- Sản phẩm

- chuyên gia

- Hồ sơ

- dự án

- dự án

- Thúc đẩy

- quảng cáo

- đề nghị

- đề xuất

- bảo vệ

- nguyên mẫu

- Chứng minh

- cho

- cung cấp

- nhà cung cấp dịch vụ

- nhà cung cấp

- cung cấp

- cung cấp

- công khai

- kéo

- Kéo

- mua

- đơn đặt hàng

- Đặt

- chất lượng

- số lượng, lượng

- truy vấn

- câu hỏi

- phạm vi

- RE

- Đạt

- Đọc

- sẵn sàng

- thời gian thực

- dữ liệu theo thời gian thực

- vương quốc

- nhận

- gần đây

- công nhận

- giới thiệu

- giảm

- giảm

- tài liệu tham khảo

- tinh luyện

- về

- liên quan

- tương đối

- sự liên quan

- có liên quan

- độ tin cậy

- đáng tin cậy

- vẫn còn

- Tái tạo

- năng lượng tái tạo

- Báo cáo

- kho

- đại diện

- yêu cầu

- yêu cầu

- cần phải

- Yêu cầu

- đòi hỏi

- giải cứu

- nghiên cứu

- Thông tin

- phản ứng

- phản ứng

- trách nhiệm

- Kết quả

- đào tạo lại

- Giàu

- ngay

- mạnh mẽ

- Vai trò

- chạy

- chạy

- s

- nhà làm hiền triết

- bán hàng

- lực lượng bán hàng

- Lưu

- khả năng mở rộng

- Quy mô

- quy mô ai

- mở rộng quy mô

- kịch bản

- xước

- liền mạch

- liền mạch

- Tìm kiếm

- tìm kiếm

- tìm kiếm

- theo mùa

- phần

- Ngành

- an toàn

- an ninh

- lựa chọn

- gửi

- gửi

- ý nghĩa

- tình cảm

- Tháng Chín

- dịch vụ

- DỊCH VỤ

- định

- thiết lập

- thiết lập

- một số

- chia sẻ

- chia sẻ

- chụp

- nên

- có ý nghĩa

- đáng kể

- Đơn giản

- đơn giản hóa

- lún xuống

- thông minh

- trơn tru

- So

- Phần mềm

- hệ mặt trời

- năng lượng mặt trời

- rắn

- giải pháp

- Giải pháp

- động SOLVE

- một số

- một cái gì đó

- nguồn

- chuyên nghành

- riêng

- quy định

- quang phổ

- phát biểu

- tiêu

- thể thao

- Thể thao

- SQL

- Stacks

- đứng

- Bắt đầu

- bắt đầu

- Bắt đầu

- bắt đầu

- trạm

- Các bước

- Vẫn còn

- cổ phần

- là gắn

- hàng

- lưu trữ

- Chiến lược

- chiến lược

- trực tuyến

- hợp lý hóa

- cấu trúc

- dữ liệu có cấu trúc và phi cấu trúc

- cấu trúc

- đáng kể

- như vậy

- Gợi ý

- bộ

- tóm tắt

- tăng áp

- cao

- nhà cung cấp

- hỗ trợ

- Hỗ trợ

- chắc chắn

- Tính bền vững

- Swings

- đồng bộ hóa

- hệ thống

- hệ thống

- phù hợp

- Hãy

- mất

- Mục tiêu

- nhắm mục tiêu

- Nhiệm vụ

- nhiệm vụ

- nhóm

- đội

- công nghệ cao

- Kỹ thuật

- Công nghệ

- Công nghệ

- viễn thông

- nói

- mẫu

- văn bản

- Phân loại văn bản

- hơn

- việc này

- Sản phẩm

- thông tin

- cung cấp their dịch

- Them

- tự

- sau đó

- Đó

- bằng cách ấy

- Kia là

- họ

- điều

- nghĩ

- điều này

- những

- số ba

- ngưỡng

- Thông qua

- Như vậy

- bán vé

- vé

- thời gian

- thời gian

- trò chơi

- đến

- mã thông báo

- công cụ

- công cụ

- Chủ đề

- đối với

- Theo dõi

- đào tạo

- Hội thảo

- Chuyển đổi

- quá trình chuyển đổi

- khuynh hướng

- Xu hướng

- thử nghiệm

- kích hoạt

- NIỀM TIN

- đáng tin cậy

- tuabin

- hướng dẫn

- loại

- ô

- không thể phủ nhận

- Dưới

- cơ bản

- nhấn mạnh

- hiểu

- sự hiểu biết

- hiểu

- thống nhât

- độc đáo

- tính năng độc đáo

- Cập nhật

- cập nhật

- trên

- us

- sử dụng

- ca sử dụng

- người sử dang

- Giao diện người dùng

- sử dụng

- Người sử dụng

- sử dụng

- sử dụng

- thường

- sử dụng

- Khoảng chân không

- Quý báu

- nhiều

- khác nhau

- tính linh hoạt

- thông qua

- khả thi

- Video

- đi bộ

- là

- Đường..

- we

- Website

- trang web

- TỐT

- là

- khi nào

- bất cứ khi nào

- cái nào

- trong khi

- CHÚNG TÔI LÀ

- rộng

- Phạm vi rộng

- sẽ

- gió

- năng lượng gió

- tuabin gió

- với

- ở trong

- không có

- Công việc

- làm việc

- quy trình làm việc

- Luồng công việc

- Nơi làm việc

- máy trạm

- viết

- năm

- Vâng

- bạn

- trên màn hình

- Zendesk

- zephyrnet