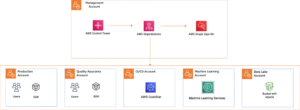

Tänään meillä on ilo ilmoittaa, että Mixtral-8x7B Mistral AI:n kehittämä laaja kielimalli (LLM) on asiakkaiden saatavilla kautta Amazon SageMaker JumpStart ottaa käyttöön yhdellä napsautuksella päättelyn suorittamiseksi. Mixtral-8x7B LLM on valmiiksi koulutettu harva asiantuntijamallin sekoitus, joka perustuu 7 miljardin parametrin runkoon, jossa on kahdeksan asiantuntijaa eteenpäinsyöttökerrosta kohti. Voit kokeilla tätä mallia SageMaker JumpStartilla, koneoppimiskeskuksella (ML), joka tarjoaa pääsyn algoritmeihin ja malleihin, jotta voit nopeasti aloittaa ML:n käytön. Tässä viestissä käymme läpi, kuinka löytää ja ottaa käyttöön Mixtral-8x7B-malli.

Mikä on Mixtral-8x7B

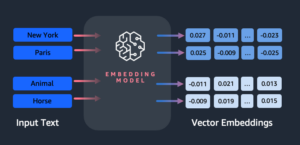

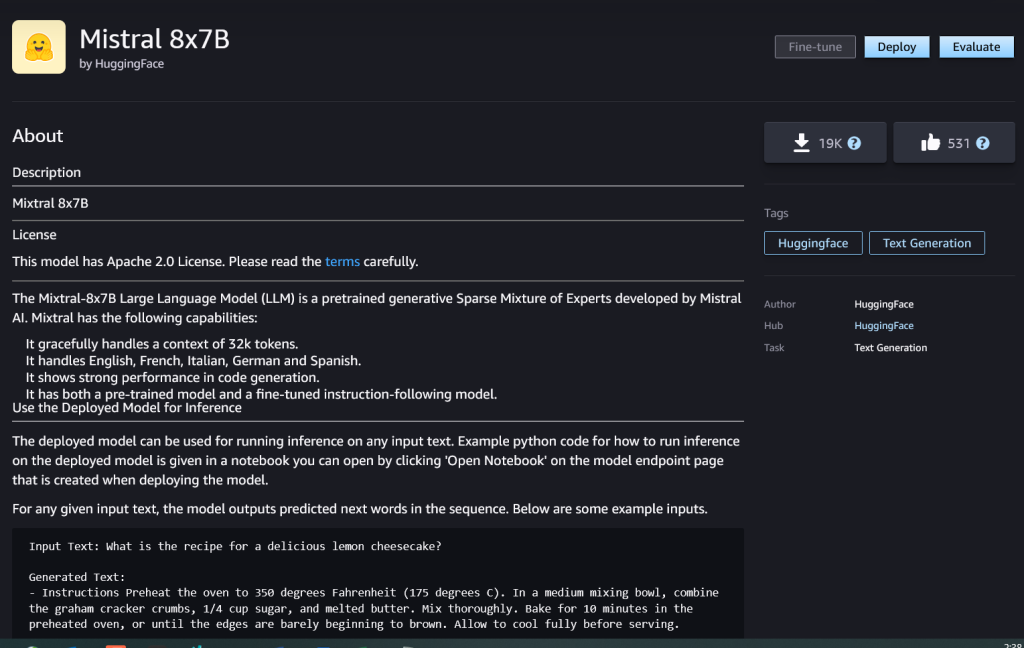

Mixtral-8x7B on Mistral AI:n kehittämä perusmalli, joka tukee englannin-, ranskan-, saksan-, italia- ja espanjankielistä tekstiä koodin luontikyvyllä. Se tukee useita käyttötapauksia, kuten tekstin yhteenvetoa, luokittelua, tekstin täydentämistä ja koodin viimeistelyä. Se käyttäytyy hyvin chat-tilassa. Mallin suoraviivaisen muokattavuuden osoittamiseksi Mistral AI on myös julkaissut Mixtral-8x7B-ohjemallin chat-käyttötapauksiin, joita on hienosäädetty käyttämällä erilaisia julkisesti saatavilla olevia keskustelutietosarjoja. Mixtral-malleilla on suuri kontekstipituus, jopa 32,000 XNUMX merkkiä.

Mixtral-8x7B tarjoaa merkittäviä suorituskyvyn parannuksia verrattuna aikaisempiin huippuluokan malleihin. Sen harva asiantuntija-arkkitehtuuri mahdollistaa paremman suorituskyvyn yhdeksässä 9:sta luonnollisen kielen käsittelyn (NLP) vertailuarvosta, jotka on testattu. Mistral AI. Mixtral vastaa tai ylittää mallien suorituskyvyn jopa 10 kertaa kokoonsa. Hyödyntämällä vain murto-osaa parametreista tunnistetta kohden, se saavuttaa nopeammat päättelynopeudet ja pienemmät laskentakustannukset verrattuna tiheisiin ja samankokoisiin malleihin – esimerkiksi yhteensä 46.7 miljardia parametria, mutta vain 12.9 miljardia tunnistetta kohden. Tämä korkean suorituskyvyn, monikielisen tuen ja laskentatehokkuuden yhdistelmä tekee Mixtral-8x7B:stä houkuttelevan valinnan NLP-sovelluksiin.

Malli on saatavilla sallitulla Apache 2.0 -lisenssillä käytettäväksi ilman rajoituksia.

Mikä on SageMaker JumpStart

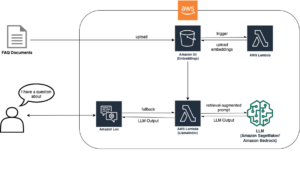

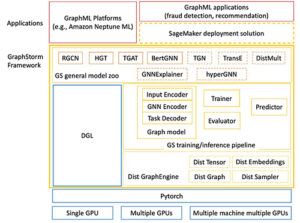

SageMaker JumpStartin avulla ML-harjoittajat voivat valita kasvavasta luettelosta parhaiten suoriutuvia meikkipohjamalleja. ML-ammattilaiset voivat ottaa käyttöön perustamismalleja omistettuihin Amazon Sage Maker instansseja verkosta eristetyssä ympäristössä ja mukauta malleja SageMakerin avulla mallin koulutusta ja käyttöönottoa varten.

Voit nyt löytää ja ottaa käyttöön Mixtral-8x7B:n muutamalla napsautuksella Amazon SageMaker Studio tai ohjelmallisesti SageMaker Python SDK:n kautta, jonka avulla voit johtaa mallin suorituskykyä ja MLOps-säätimiä SageMaker-ominaisuuksilla, kuten Amazon SageMaker -putkistot, Amazon SageMaker -korjaamotai konttitukkeja. Malli on otettu käyttöön suojatussa AWS-ympäristössä ja VPC-ohjaimissasi, mikä auttaa varmistamaan tietoturvan.

Tutustu malleihin

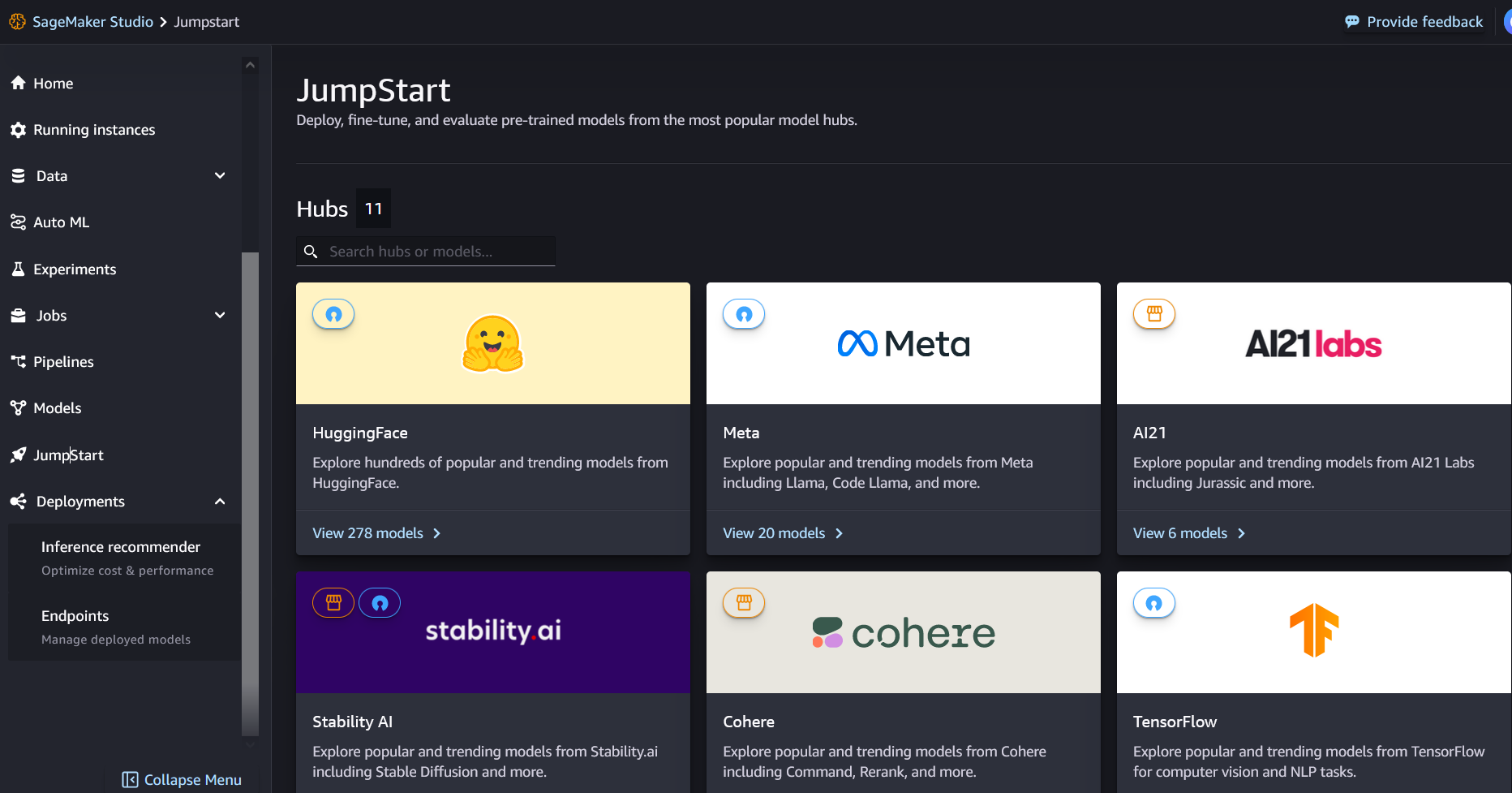

Pääset käsiksi Mixtral-8x7B-pohjamalleihin SageMaker JumpStartin kautta SageMaker Studion käyttöliittymässä ja SageMaker Python SDK:ssa. Tässä osiossa käymme läpi kuinka löytää mallit SageMaker Studiossa.

SageMaker Studio on integroitu kehitysympäristö (IDE), joka tarjoaa yhden web-pohjaisen visuaalisen käyttöliittymän, jossa voit käyttää tarkoitukseen rakennettuja työkaluja kaikkien ML-kehitysvaiheiden suorittamiseen tietojen valmistelusta ML-mallien rakentamiseen, koulutukseen ja käyttöönottoon. Katso lisätietoja SageMaker Studion aloittamisesta ja määrittämisestä Amazon SageMaker Studio.

SageMaker Studiossa pääset SageMaker JumpStartiin valitsemalla Kaapelikäynnistys navigointipaneelissa.

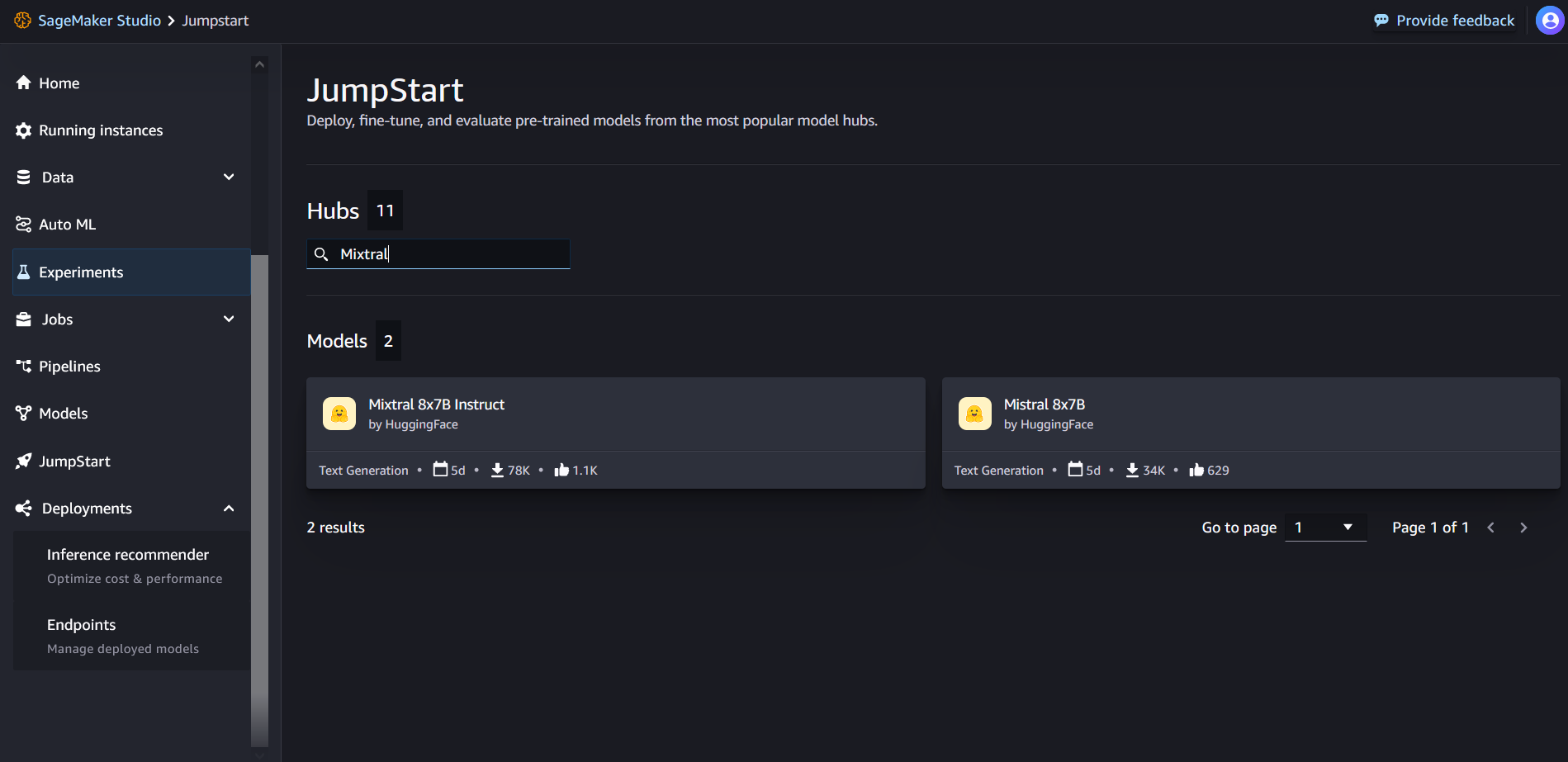

SageMaker JumpStart -aloitussivulta voit etsiä "Mixtral" hakukentästä. Näet hakutuloksissa Mixtral 8x7B ja Mixtral 8x7B Instruct.

Voit valita mallikortin nähdäksesi mallin tiedot, kuten lisenssin, koulutuksessa käytetyt tiedot ja käytön. Löydät myös Sijoittaa -painiketta, jonka avulla voit ottaa mallin käyttöön ja luoda päätepisteen.

Ota malli käyttöön

Käyttöönotto alkaa, kun valitset Sijoittaa. Kun käyttöönotto on valmis, sinulle on luotu päätepiste. Voit testata päätepistettä välittämällä esimerkkipäätelmäpyynnön hyötykuorman tai valitsemalla testausvaihtoehdon SDK:n avulla. Kun valitset SDK:n käyttövaihtoehdon, näet esimerkkikoodin, jota voit käyttää haluamassasi muistikirjaeditorissa SageMaker Studiossa.

Ottaaksesi käyttöön SDK:n avulla aloitamme valitsemalla Mixtral-8x7B-mallin, jonka määrittelee model_id with value huggingface-llm-mixtral-8x7b. Voit ottaa minkä tahansa valitun mallin käyttöön SageMakerissa seuraavalla koodilla. Vastaavasti voit ottaa käyttöön Mixtral-8x7B-ohjeen käyttämällä sen omaa mallitunnusta:

Tämä ottaa mallin käyttöön SageMakerissa oletuskokoonpanoilla, mukaan lukien oletusinstanssityypin ja VPC-oletuskokoonpanot. Voit muuttaa näitä määrityksiä määrittämällä ei-oletusarvoja JumpStartModel.

Kun se on otettu käyttöön, voit suorittaa päätelmiä käyttöön otettua päätepistettä vastaan SageMaker-ennustajan kautta:

Esimerkkikehotteet

Voit olla vuorovaikutuksessa Mixtral-8x7B-mallin kanssa kuten minkä tahansa tavallisen tekstin luontimallin kanssa, jossa malli käsittelee syöttösekvenssin ja tulostaa sarjan ennustetut seuraavat sanat. Tässä osiossa tarjoamme esimerkkikehotteita.

Koodin luonti

Edellisen esimerkin avulla voimme käyttää koodinluontikehotteita, kuten seuraavat:

Saat seuraavan tuloksen:

Tunneanalyysin kehotus

Mixtral 8x7B:n kanssa voit suorittaa tunneanalyysin käyttämällä seuraavanlaista kehotetta:

Saat seuraavan tuloksen:

Kysymyksiin vastaaminen

Voit käyttää Mixtral-8x7B:n kanssa seuraavan kaltaista kysymykseen vastauskehotetta:

Saat seuraavan tuloksen:

Mixtral-8x7B ohje

Mixtral-8x7B:n ohjeistettu versio hyväksyy muotoiltuja ohjeita, joissa keskusteluroolien on aloitettava käyttäjän kehotteella ja vaihdettava käyttäjän ohjeen ja avustajan välillä (mallivastaus). Ohjemuotoa on ehdottomasti noudatettava, muuten malli tuottaa optimaalista huonompia tuloksia. Instruct-mallin kehotteen luomiseen käytetty malli on määritelty seuraavasti:

Huomaa, että <s> ja </s> ovat erikoismerkkejä merkkijonon alkuun (BOS) ja merkkijonon loppuun (EOS), kun taas [INST] ja [/INST] ovat tavallisia merkkijonoja.

Seuraava koodi näyttää, kuinka voit muotoilla kehotteen ohjemuotoon:

Tietojen haku

Voit käyttää seuraavaa koodia tiedonhakukehotteeseen:

Saat seuraavan tuloksen:

Koodaus

Mixtral-mallit voivat osoittaa vertailukohtaisia vahvuuksia koodaustehtävissä seuraavan koodin osoittamalla tavalla:

Matematiikka ja päättely

Mixtral-mallit kertovat myös vahvuuksista matematiikan tarkkuudessa:

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26

- 30

- 32

- 46

- 50

- 600

- 7

- 72

- 8

- 9

- a

- kyvyt

- Meistä

- edellä

- kiihtyvä

- hyväksyy

- pääsy

- Tilit

- tarkkuus

- Saavuttaa

- päästään

- poikki

- aktiivinen

- lisä-

- lisää

- Jälkeen

- vastaan

- AI

- AI / ML

- algoritmit

- Kaikki

- Myös

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- määrä

- an

- analyysi

- ja

- ja infrastruktuuri

- Ilmoittaa

- vastaus

- Kaikki

- Apache

- miellyttävä

- sovellukset

- sovellettu

- Hakeminen

- arkkitehtuuri

- OVAT

- perustelu

- artikkeli

- AS

- Avustaja

- At

- saatavissa

- AWS

- takaisin

- Selkäranka

- perustua

- kemut

- akku

- Bayes

- BE

- koska

- ollut

- ennen

- Alku

- uskoo

- Soittokello

- vertailuanalyysi

- Viitearvot

- Paremmin

- välillä

- lasku

- laskutus

- Miljardi

- tappi

- osti

- Laatikko

- Tauko

- tuoda

- rakentaa

- Rakentaminen

- sisäänrakennettu

- liiketoiminta

- mutta

- by

- laskea

- soittaa

- nimeltään

- Puhelut

- CAN

- kortti

- tapaus

- tapauksissa

- solu

- muuttaa

- jutella

- valinta

- Valita

- valita

- chris

- luokittelu

- napsauttaa

- koodi

- Koodaus

- yhdistelmä

- verrattuna

- koottu

- valmistuminen

- laskennallinen

- Laskea

- tietokone

- Tietokoneen visio

- konferenssit

- alituisesti

- Kontti

- pitoisuus

- tausta

- jatkuu

- jatkuvasti

- valvonta

- Keskustelu

- Hinta

- kustannukset

- voisi

- Kerma

- luoda

- luotu

- ratkaiseva

- Kuppi

- Nykyinen

- Asiakkaat

- räätälöinnin

- räätälöidä

- tiedot

- tietoturva

- aineistot

- päivä

- päivää

- omistautunut

- oletusarvo

- määritelty

- Democratizing

- osoittaa

- tiheä

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- lauennut

- ajelehtia

- yksityiskohdat

- kehittää

- kehitetty

- Kehittäjä

- Kehitys

- DICT

- DID

- löytää

- do

- ei

- dollaria

- verkkotunnuksia

- tehty

- alas

- Pudota

- Herttua

- herttua yliopisto

- kukin

- Taloudellinen

- toimittaja

- tehokkuus

- Munat

- muu

- mahdollistaa

- mahdollistaa

- mahdollistaa

- loppu

- päätepiste

- Tekniikka

- Englanti

- varmistaa

- ympäristö

- EOS

- yhtäläinen

- Vastaava

- Eetteri (ETH)

- eettinen

- esimerkki

- ylittää

- innoissaan

- lukuun ottamatta

- asiantuntija

- asiantuntijat

- Selittää

- selitys

- laajentaminen

- perhe

- nopeampi

- Ominaisuudet

- harvat

- Asiakirjat

- suodattimet

- Löytää

- Etunimi

- jälkeen

- seuraa

- varten

- muoto

- perusta

- jae

- Ranskan

- alkaen

- toiminto

- tulevaisuutta

- yleinen tarkoitus

- tuottaa

- syntyy

- sukupolvi

- generatiivinen

- Generatiivinen AI

- Saksan

- saada

- Go

- hyvä

- sai

- Kasvava

- viha

- Olla

- he

- auttaa

- auttaa

- auttaa

- hänen

- tätä

- Korkea

- retkeily

- Hills

- hänen

- Miten

- Miten

- HTML

- HTTPS

- Napa

- i

- ICE

- jäätelö

- ICLR

- ID

- if

- Illinois

- sairaus

- tuoda

- tärkeä

- parantaa

- parannuksia

- in

- sisältää

- Mukaan lukien

- yhdistetty

- Infrastruktuuri

- ainekset

- panos

- tuloa

- esimerkki

- tapauksia

- ohjeet

- yhdistää

- integroitu

- olla vuorovaikutuksessa

- etu

- liitäntä

- keksi

- yksittäinen

- IT

- Italian

- SEN

- itse

- jpg

- Lasten

- tuntemus

- Kyle

- Labs

- lasku

- aloitussivu

- Kieli

- suuri

- Sukunimi

- kerros

- Liidit

- oppiminen

- Pituus

- antaa

- Lisenssi

- pitää

- tykkää

- rajat

- LINK

- Lista

- Kuunteleminen

- vähän

- logiikka

- näköinen

- alentaa

- kone

- koneoppiminen

- tehty

- TEE

- Tekeminen

- johtaja

- monet

- tulitikut

- matematiikka

- matematiikka

- me

- keskikokoinen

- seos

- ML

- MLOps

- tila

- malli

- mallit

- muokattu

- Kuukausi

- lisää

- moottoripyörä

- paljon

- kerrottuna

- Musiikki

- täytyy

- my

- Luonnollinen

- Luonnollinen kieli

- Luonnollinen kielen käsittely

- suunnistus

- negatiivinen

- verkko

- NeurIPS

- Neutraali

- Uusi

- seuraava

- NLP

- Ei eristetty

- huomata

- muistikirja

- nyt

- numero

- of

- Öljy

- on

- kerran

- ONE

- vain

- toiminta

- käyttöjärjestelmän

- Vaihtoehto

- or

- Muut

- muuten

- ulos

- ulostulo

- lähdöt

- ulkopuolella

- yli

- oma

- sivulla

- maksettu

- lasi

- paperit

- parametri

- parametrit

- Ohimenevä

- intohimo

- intohimoinen

- polut

- varten

- suorittaa

- suorituskyky

- phd

- puhelin

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- kannettava

- positiivinen

- Kirje

- edeltävä

- ennusti

- Predictor

- Suositut

- valmistelee

- edellinen

- Pääasiallinen

- Painaa

- prosessi

- Prosessit

- käsittely

- Tuotteet

- Ohjelma

- Ohjelmointi

- ohjeita

- hyvinvointi

- toimittaa

- tarjoajat

- tarjoaa

- julkisesti

- julkaistu

- Python

- Neljännes

- kysymys

- nopeasti

- RE

- Lukeminen

- resepti

- Rekursiivinen

- vähentää

- katso

- säännöllinen

- julkaistu

- raportti

- pyyntö

- tutkimus

- tutkija

- Esittelymateriaalit

- arvostettu

- vastaus

- vastuullinen

- rajoitukset

- johtua

- tulokset

- palata

- Tuotto

- ratsastus

- Riski

- Rooli

- roolit

- Huone

- ajaa

- juoksu

- s

- SA

- sagemaker

- suolaa

- skaalautuva

- Asteikko

- tiede

- Tiedemies

- sdk

- Haku

- Osa

- turvallinen

- turvallisuus

- nähdä

- valita

- valittu

- valitsemalla

- valinta

- vanhempi

- näkemys

- erillinen

- Järjestys

- Sarjat

- Palvelut

- setti

- osoittivat

- näyttää

- esitetty

- Näytä

- merkittävä

- samalla lailla

- Yksinkertainen

- koska

- single

- Koko

- So

- sosiaalinen

- yhteiskunta

- Tuotteemme

- ratkaisu

- Espanjan

- erityinen

- asiantuntija

- määritelty

- nopeudet

- menot

- standardi

- Alkaa

- alkoi

- alkaa

- huippu-

- tilastollinen

- Vaihe

- Askeleet

- Yhä

- pysähtynyt

- verkkokaupasta

- suora

- Strateginen

- virta

- vahvuudet

- jono

- jäsennelty

- studio

- niin

- tuki

- Tukea

- Tukee

- järjestelmä

- vie

- tehtävät

- näppäimet

- joukkue-

- Elektroniikka

- sapluuna

- testi

- testattu

- Testaus

- teksti

- tekstin luominen

- että

- -

- Tulevaisuus

- sitten

- Nämä

- ne

- tätä

- Kautta

- aika

- Aikasarja

- kertaa

- että

- yhdessä

- symbolinen

- tokens

- liian

- työkalut

- Yhteensä

- Juna

- koulutus

- totta

- yrittää

- piipittää

- tyyppi

- ui

- varten

- yliopisto

- unix

- avata

- asti

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- käyttötarkoituksiin

- käyttämällä

- Hyödyntämällä

- Laakso

- arvo

- arvot

- lajike

- versio

- Video

- Näytä

- visio

- Vierailla

- visuaalinen

- kävellä

- oli

- vesi

- we

- verkko

- verkkopalvelut

- Web-pohjainen

- HYVIN

- Mitä

- Mikä on

- kun

- taas

- joka

- valkoinen

- KUKA

- tulee

- with

- sisällä

- ilman

- sanoja

- Referenssit

- olisi

- kirjoittaa

- kirjallinen

- te

- Sinun

- zephyrnet

Rachna Chadha on AWS:n strategisten tilien pääratkaisuarkkitehti AI/ML. Rachna on optimisti, joka uskoo, että tekoälyn eettinen ja vastuullinen käyttö voi parantaa yhteiskuntaa tulevaisuudessa ja tuoda taloudellista ja sosiaalista vaurautta. Vapaa-ajallaan Rachna viettää mielellään aikaa perheensä kanssa, vaeltaa ja kuuntelee musiikkia.

Rachna Chadha on AWS:n strategisten tilien pääratkaisuarkkitehti AI/ML. Rachna on optimisti, joka uskoo, että tekoälyn eettinen ja vastuullinen käyttö voi parantaa yhteiskuntaa tulevaisuudessa ja tuoda taloudellista ja sosiaalista vaurautta. Vapaa-ajallaan Rachna viettää mielellään aikaa perheensä kanssa, vaeltaa ja kuuntelee musiikkia. Tohtori Kyle Ulrich on soveltuva tutkija

Tohtori Kyle Ulrich on soveltuva tutkija  Christopher Whitten on ohjelmistokehittäjä JumpStart-tiimissä. Hän auttaa skaalautumaan mallien valinnassa ja integroimaan malleja muihin SageMaker-palveluihin. Chris on intohimoinen tekoälyn yleistymisen nopeuttamiseen useilla liiketoiminta-alueilla.

Christopher Whitten on ohjelmistokehittäjä JumpStart-tiimissä. Hän auttaa skaalautumaan mallien valinnassa ja integroimaan malleja muihin SageMaker-palveluihin. Chris on intohimoinen tekoälyn yleistymisen nopeuttamiseen useilla liiketoiminta-alueilla. Tohtori Fabio Nonato de Paula on Senior Manager, Specialist GenAI SA, joka auttaa mallintarjoajia ja asiakkaita skaalaamaan generatiivista tekoälyä AWS:ssä. Fabiolla on intohimo demokratisoida pääsy generatiiviseen tekoälyteknologiaan. Töiden ulkopuolella voit löytää Fabio ajamassa moottoripyörällään Sonoma Valleyn kukkuloilla tai lukemassa ComiXologya.

Tohtori Fabio Nonato de Paula on Senior Manager, Specialist GenAI SA, joka auttaa mallintarjoajia ja asiakkaita skaalaamaan generatiivista tekoälyä AWS:ssä. Fabiolla on intohimo demokratisoida pääsy generatiiviseen tekoälyteknologiaan. Töiden ulkopuolella voit löytää Fabio ajamassa moottoripyörällään Sonoma Valleyn kukkuloilla tai lukemassa ComiXologya. Tohtori Ashish Khetan on vanhempi soveltuva tutkija, jolla on sisäänrakennetut Amazon SageMaker -algoritmit ja auttaa kehittämään koneoppimisalgoritmeja. Hän sai tohtorin tutkinnon Illinois Urbana-Champaignin yliopistosta. Hän on aktiivinen koneoppimisen ja tilastollisen päättelyn tutkija, ja hän on julkaissut monia artikkeleita NeurIPS-, ICML-, ICLR-, JMLR-, ACL- ja EMNLP-konferensseissa.

Tohtori Ashish Khetan on vanhempi soveltuva tutkija, jolla on sisäänrakennetut Amazon SageMaker -algoritmit ja auttaa kehittämään koneoppimisalgoritmeja. Hän sai tohtorin tutkinnon Illinois Urbana-Champaignin yliopistosta. Hän on aktiivinen koneoppimisen ja tilastollisen päättelyn tutkija, ja hän on julkaissut monia artikkeleita NeurIPS-, ICML-, ICLR-, JMLR-, ACL- ja EMNLP-konferensseissa. Karl Albertsen johtaa tuotteita, suunnittelua ja tiedettä Amazon SageMaker Algorithmsille ja JumpStartille, SageMakerin koneoppimiskeskukselle. Hän on intohimoinen koneoppimisen soveltamisesta liiketoiminnan arvon avaamiseen.

Karl Albertsen johtaa tuotteita, suunnittelua ja tiedettä Amazon SageMaker Algorithmsille ja JumpStartille, SageMakerin koneoppimiskeskukselle. Hän on intohimoinen koneoppimisen soveltamisesta liiketoiminnan arvon avaamiseen.