Giới thiệu

Hãy tưởng tượng bạn đang đứng trong một thư viện thiếu ánh sáng, cố gắng giải mã một tài liệu phức tạp trong khi phải xử lý hàng tá văn bản khác. Đây là thế giới của Transformers trước khi tờ báo “Chú ý là tất cả những gì bạn cần” tiết lộ tiêu điểm mang tính cách mạng của nó – cơ chế chú ý.

Mục lục

Hạn chế của RNN

Các mô hình tuần tự truyền thống, như Mạng thần kinh tái phát (RNN), ngôn ngữ được xử lý từng chữ, dẫn đến một số hạn chế:

- Sự phụ thuộc trong phạm vi ngắn: RNN gặp khó khăn trong việc nắm bắt mối liên hệ giữa các từ ở xa, thường hiểu sai ý nghĩa của các câu như “người đàn ông đã đến thăm sở thú ngày hôm qua”, trong đó chủ ngữ và động từ cách xa nhau.

- Sự song song hạn chế: Việc xử lý thông tin theo trình tự vốn đã chậm, cản trở việc đào tạo và sử dụng hiệu quả các tài nguyên tính toán, đặc biệt đối với các chuỗi dài.

- Tập trung vào bối cảnh địa phương: RNN chủ yếu xem xét các hàng xóm ngay lập tức, có khả năng thiếu thông tin quan trọng từ các phần khác của câu.

Những hạn chế này đã cản trở khả năng Transformers thực hiện các nhiệm vụ phức tạp như dịch máy và hiểu ngôn ngữ tự nhiên. Sau đó đến cơ chế chú ý, một điểm sáng mang tính cách mạng làm sáng tỏ những kết nối tiềm ẩn giữa các từ, làm thay đổi hiểu biết của chúng ta về xử lý ngôn ngữ. Nhưng chính xác thì sự chú ý đã giải quyết được điều gì và nó đã thay đổi cuộc chơi của Transformers như thế nào?

Hãy tập trung vào ba lĩnh vực chính:

Sự phụ thuộc tầm xa

- Vấn đề: Những người mẫu truyền thống thường vấp phải những câu như “Người phụ nữ sống trên đồi đêm qua đã nhìn thấy một ngôi sao băng”. Họ gặp khó khăn trong việc kết nối “người phụ nữ” và “sao băng” do khoảng cách xa nhau, dẫn đến hiểu sai.

- Cơ chế chú ý: Hãy tưởng tượng người mẫu chiếu một chùm sáng xuyên qua câu, kết nối trực tiếp “người phụ nữ” với “ngôi sao băng” và hiểu toàn bộ câu. Khả năng nắm bắt các mối quan hệ bất kể khoảng cách là rất quan trọng đối với các tác vụ như dịch máy và tóm tắt.

Cũng đọc: Tổng quan về Trí nhớ Ngắn hạn Dài hạn (LSTM)

Sức mạnh xử lý song song

- Vấn đề: Các mô hình truyền thống xử lý thông tin theo trình tự, giống như đọc từng trang sách. Điều này chậm và không hiệu quả, đặc biệt đối với các văn bản dài.

- Cơ chế chú ý: Hãy tưởng tượng nhiều đèn chiếu quét thư viện đồng thời, phân tích song song các phần khác nhau của văn bản. Điều này tăng tốc đáng kể công việc của mô hình, cho phép nó xử lý lượng lớn dữ liệu một cách hiệu quả. Sức mạnh xử lý song song này rất cần thiết để đào tạo các mô hình phức tạp và đưa ra dự đoán theo thời gian thực.

Nhận thức bối cảnh toàn cầu

- Vấn đề: Các mô hình truyền thống thường tập trung vào từng từ riêng lẻ mà bỏ qua ngữ cảnh rộng hơn của câu. Điều này dẫn đến hiểu lầm trong những trường hợp như mỉa mai hoặc mang ý nghĩa kép.

- Cơ chế chú ý: Hãy tưởng tượng ánh đèn sân khấu quét qua toàn bộ thư viện, thu hút mọi cuốn sách và hiểu chúng liên quan với nhau như thế nào. Nhận thức về bối cảnh toàn cầu này cho phép mô hình xem xét toàn bộ văn bản khi diễn giải từng từ, dẫn đến sự hiểu biết phong phú và nhiều sắc thái hơn.

Định hướng các từ đa nghĩa

- Vấn đề: Những từ như “ngân hàng” hoặc “quả táo” có thể là danh từ, động từ hoặc thậm chí là công ty, tạo ra sự mơ hồ mà các mô hình truyền thống gặp khó khăn để giải quyết.

- Cơ chế chú ý: Hãy tưởng tượng mô hình chiếu đèn chiếu vào tất cả các lần xuất hiện của từ “ngân hàng” trong một câu, sau đó phân tích bối cảnh xung quanh và mối quan hệ với các từ khác. Bằng cách xem xét cấu trúc ngữ pháp, các danh từ gần đó và thậm chí cả các câu trong quá khứ, cơ chế chú ý có thể suy ra ý nghĩa dự định. Khả năng phân biệt các từ đa nghĩa này rất quan trọng đối với các tác vụ như dịch máy, tóm tắt văn bản và hệ thống đối thoại.

Bốn khía cạnh này – sự phụ thuộc tầm xa, sức mạnh xử lý song song, nhận thức bối cảnh toàn cầu và sự định hướng – thể hiện sức mạnh biến đổi của các cơ chế chú ý. Họ đã đưa Transformers lên vị trí hàng đầu trong lĩnh vực xử lý ngôn ngữ tự nhiên, cho phép họ giải quyết các tác vụ phức tạp với độ chính xác và hiệu quả vượt trội.

Khi NLP và cụ thể là LLM tiếp tục phát triển, các cơ chế chú ý chắc chắn sẽ đóng một vai trò quan trọng hơn nữa. Chúng là cầu nối giữa chuỗi từ tuyến tính và tấm thảm phong phú của ngôn ngữ con người, và cuối cùng, là chìa khóa để mở ra tiềm năng thực sự của những tuyệt tác ngôn ngữ này. Bài viết này đi sâu vào các loại cơ chế chú ý khác nhau và chức năng của chúng.

1. Tự chú ý: Ngôi sao dẫn đường của Người máy biến hình

Hãy tưởng tượng bạn đang sử dụng nhiều cuốn sách và cần tham khảo các đoạn cụ thể trong mỗi cuốn khi viết tóm tắt. Tính năng tự chú ý hoặc sự chú ý của Sản phẩm chấm theo tỷ lệ hoạt động giống như một trợ lý thông minh, giúp các mô hình thực hiện tương tự với dữ liệu tuần tự như câu hoặc chuỗi thời gian. Nó cho phép mỗi phần tử trong chuỗi tham dự vào mọi phần tử khác, nắm bắt một cách hiệu quả các mối quan hệ phụ thuộc lâu dài và các mối quan hệ phức tạp.

Dưới đây là cái nhìn sâu hơn về các khía cạnh kỹ thuật cốt lõi của nó:

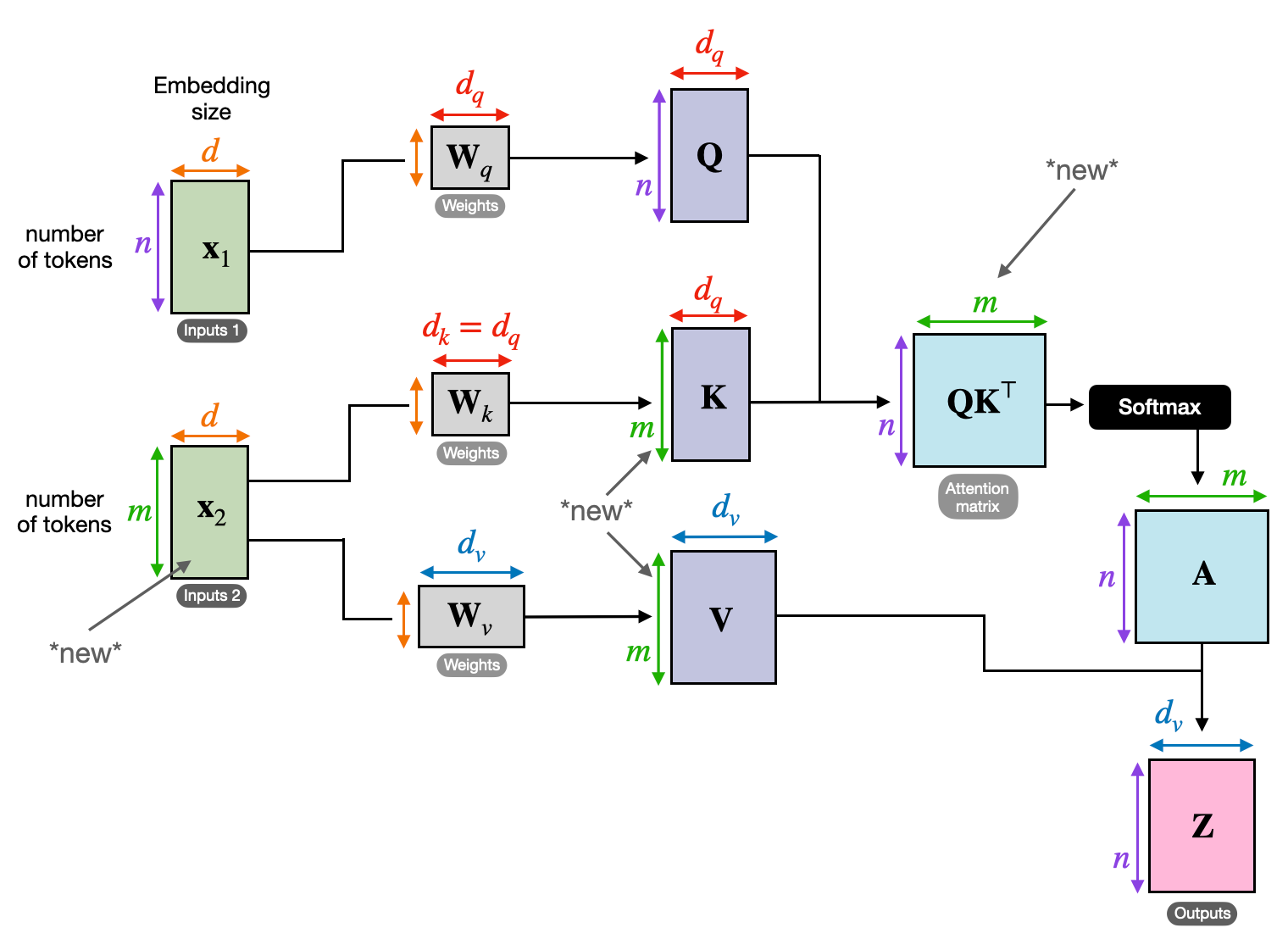

Biểu diễn véc tơ

Mỗi phần tử (từ, điểm dữ liệu) được chuyển đổi thành một vectơ chiều cao, mã hóa nội dung thông tin của nó. Không gian vectơ này đóng vai trò là nền tảng cho sự tương tác giữa các phần tử.

Chuyển đổi QKV

Ba ma trận chính được xác định:

- Truy vấn (Q): Thể hiện “câu hỏi” mà mỗi phần tử đặt ra cho những phần tử khác. Q nắm bắt nhu cầu thông tin của phần tử hiện tại và hướng dẫn tìm kiếm thông tin liên quan trong chuỗi.

- Chìa khóa (K): Giữ “chìa khóa” cho thông tin của từng phần tử. K mã hóa bản chất nội dung của từng thành phần, cho phép các thành phần khác xác định mức độ liên quan tiềm ẩn dựa trên nhu cầu của chính chúng.

- Giá trị (V): Lưu trữ nội dung thực tế mà mỗi phần tử muốn chia sẻ. V chứa thông tin chi tiết mà các phần tử khác có thể truy cập và tận dụng dựa trên điểm chú ý của chúng.

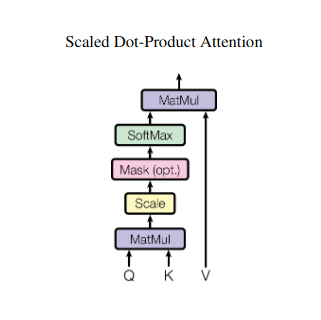

Tính điểm chú ý

Khả năng tương thích giữa mỗi cặp phần tử được đo thông qua tích vô hướng giữa các vectơ Q và K tương ứng của chúng. Điểm cao hơn cho thấy mức độ liên quan tiềm năng mạnh mẽ hơn giữa các yếu tố.

Trọng số chú ý theo tỷ lệ

Để đảm bảo tầm quan trọng tương đối, các điểm tương thích này được chuẩn hóa bằng hàm softmax. Điều này dẫn đến trọng số chú ý, nằm trong khoảng từ 0 đến 1, biểu thị tầm quan trọng có trọng số của từng phần tử đối với bối cảnh của phần tử hiện tại.

Tổng hợp bối cảnh có trọng số

Trọng số chú ý được áp dụng cho ma trận V, về cơ bản làm nổi bật thông tin quan trọng từ mỗi phần tử dựa trên mức độ liên quan của nó với phần tử hiện tại. Tổng có trọng số này tạo ra sự trình bày theo ngữ cảnh cho phần tử hiện tại, kết hợp những hiểu biết sâu sắc thu thập được từ tất cả các phần tử khác trong chuỗi.

Biểu diễn phần tử nâng cao

Với cách biểu diễn phong phú, phần tử hiện có sự hiểu biết sâu sắc hơn về nội dung của chính nó cũng như mối quan hệ của nó với các phần tử khác trong chuỗi. Biểu diễn được biến đổi này tạo thành cơ sở cho quá trình xử lý tiếp theo trong mô hình.

Quá trình gồm nhiều bước này cho phép bạn tự chú ý đến:

- Nắm bắt các phụ thuộc tầm xa: Mối quan hệ giữa các yếu tố ở xa trở nên rõ ràng ngay cả khi bị ngăn cách bởi nhiều yếu tố can thiệp.

- Mô hình tương tác phức tạp: Sự phụ thuộc và mối tương quan tinh tế trong trình tự được đưa ra ánh sáng, dẫn đến sự hiểu biết phong phú hơn về cấu trúc và động lực dữ liệu.

- Bối cảnh hóa từng yếu tố: Mô hình phân tích từng phần tử không phải một cách riêng lẻ mà trong khuôn khổ rộng hơn của trình tự, dẫn đến các dự đoán hoặc biểu diễn chính xác hơn và nhiều sắc thái hơn.

Sự tự chú ý đã cách mạng hóa cách các mô hình xử lý dữ liệu tuần tự, mở ra những khả năng mới trên nhiều lĩnh vực khác nhau như dịch máy, tạo ngôn ngữ tự nhiên, dự báo chuỗi thời gian, v.v. Khả năng tiết lộ các mối quan hệ ẩn giấu trong các chuỗi cung cấp một công cụ mạnh mẽ để khám phá những hiểu biết sâu sắc và đạt được hiệu suất vượt trội trong nhiều nhiệm vụ.

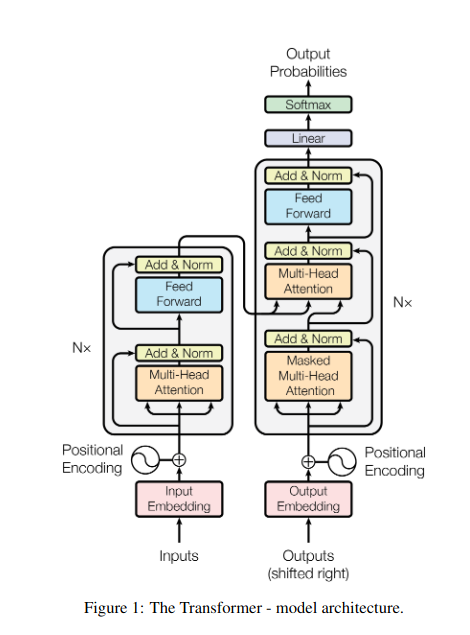

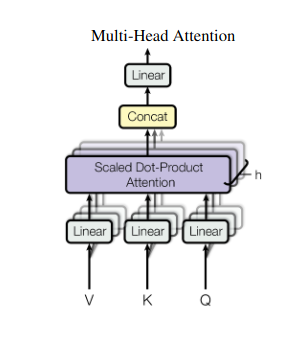

2. Chú ý bằng nhiều đầu: Nhìn qua các lăng kính khác nhau

Sự tự chú ý mang lại cái nhìn toàn diện, nhưng đôi khi việc tập trung vào các khía cạnh cụ thể của dữ liệu là rất quan trọng. Đó là lúc cần có sự chú ý của nhiều người. Hãy tưởng tượng có nhiều trợ lý, mỗi người được trang bị một ống kính khác nhau:

- Nhiều “đầu” được tạo, mỗi chuỗi tham gia vào chuỗi đầu vào thông qua các ma trận Q, K và V của chính nó.

- Mỗi người đứng đầu học cách tập trung vào các khía cạnh khác nhau của dữ liệu, như sự phụ thuộc tầm xa, mối quan hệ cú pháp hoặc tương tác từ địa phương.

- Sau đó, các đầu ra từ mỗi đầu được nối và chiếu thành bản trình bày cuối cùng, nắm bắt được bản chất nhiều mặt của đầu vào.

Điều này cho phép mô hình xem xét đồng thời nhiều khía cạnh khác nhau, dẫn đến sự hiểu biết phong phú hơn và nhiều sắc thái hơn về dữ liệu.

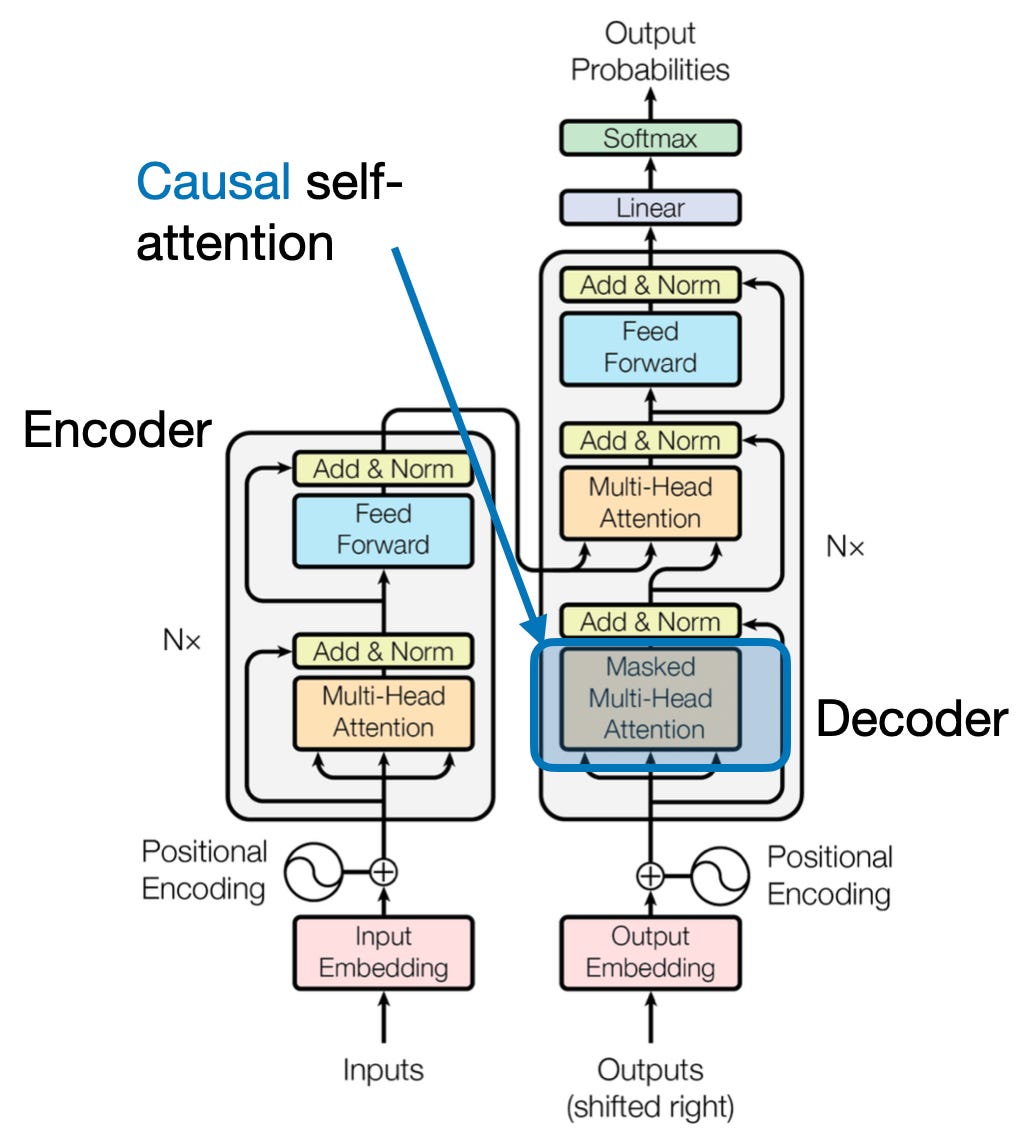

3. Chú ý chéo: Xây dựng cầu nối giữa các chuỗi

Khả năng hiểu các kết nối giữa các phần thông tin khác nhau là rất quan trọng đối với nhiều nhiệm vụ NLP. Hãy tưởng tượng bạn đang viết một bài đánh giá về một cuốn sách - bạn sẽ không chỉ tóm tắt văn bản từng chữ mà còn rút ra những hiểu biết sâu sắc và mối liên hệ giữa các chương. Đi vào sự chú ý chéo, một cơ chế mạnh mẽ giúp xây dựng cầu nối giữa các chuỗi, trao quyền cho các mô hình tận dụng thông tin từ hai nguồn riêng biệt.

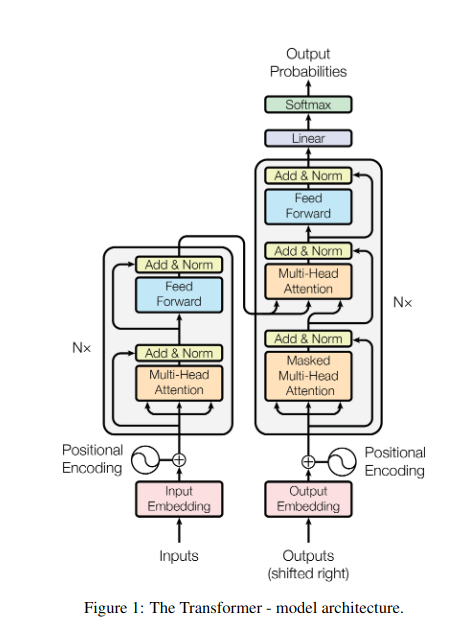

- Trong các kiến trúc bộ mã hóa-giải mã như Transformers, mã hóa xử lý chuỗi đầu vào (cuốn sách) và tạo ra một biểu diễn ẩn.

- Sản phẩm bộ giải mã sử dụng tính năng chú ý chéo để chú ý đến phần trình bày ẩn của bộ mã hóa ở mỗi bước trong khi tạo chuỗi đầu ra (đánh giá).

- Ma trận Q của bộ giải mã tương tác với ma trận K và V của bộ mã hóa, cho phép nó tập trung vào các phần có liên quan của cuốn sách trong khi viết từng câu của bài đánh giá.

Cơ chế này rất có giá trị đối với các tác vụ như dịch máy, tóm tắt và trả lời câu hỏi, trong đó việc hiểu mối quan hệ giữa các chuỗi đầu vào và đầu ra là điều cần thiết.

4. Chú ý nhân quả: Duy trì dòng thời gian

Hãy tưởng tượng dự đoán từ tiếp theo trong câu mà không cần nhìn trước. Các cơ chế chú ý truyền thống gặp khó khăn với các nhiệm vụ đòi hỏi phải duy trì trật tự thông tin theo thời gian, chẳng hạn như tạo văn bản và dự báo chuỗi thời gian. Họ sẵn sàng “nhìn trước” theo trình tự, dẫn đến những dự đoán không chính xác. Sự chú ý nhân quả giải quyết hạn chế này bằng cách đảm bảo các dự đoán chỉ phụ thuộc vào thông tin được xử lý trước đó.

Đây là cách nó hoạt động

- Cơ chế che giấu: Một mặt nạ cụ thể được áp dụng cho các trọng số chú ý, ngăn chặn hiệu quả quyền truy cập của mô hình vào các phần tử trong tương lai trong chuỗi. Ví dụ: khi dự đoán từ thứ hai trong “người phụ nữ…”, mô hình chỉ có thể xem xét “the” chứ không phải “ai” hoặc các từ tiếp theo.

- Xử lý tự hồi quy: Thông tin chảy một cách tuyến tính, với cách biểu diễn của mỗi phần tử chỉ được xây dựng từ các phần tử xuất hiện trước nó. Mô hình xử lý chuỗi từng từ, tạo ra dự đoán dựa trên ngữ cảnh được thiết lập cho đến thời điểm đó.

Sự chú ý nhân quả là rất quan trọng đối với các nhiệm vụ như tạo văn bản và dự báo chuỗi thời gian, trong đó việc duy trì thứ tự thời gian của dữ liệu là rất quan trọng để dự đoán chính xác.

5. Sự chú ý toàn cầu và địa phương: Tạo sự cân bằng

Các cơ chế chú ý phải đối mặt với sự đánh đổi quan trọng: nắm bắt các yếu tố phụ thuộc tầm xa và duy trì khả năng tính toán hiệu quả. Điều này thể hiện ở hai cách tiếp cận chính: sự chú ý toàn cầu và sự chú ý của địa phương. Hãy tưởng tượng việc đọc toàn bộ cuốn sách thay vì tập trung vào một chương cụ thể. Sự chú ý chung xử lý toàn bộ chuỗi cùng một lúc, trong khi sự chú ý cục bộ tập trung vào một cửa sổ nhỏ hơn:

- Sự chú ý toàn cầu nắm bắt được sự phụ thuộc tầm xa và bối cảnh tổng thể nhưng có thể tốn kém về mặt tính toán đối với các chuỗi dài.

- Sự chú ý của địa phương hiệu quả hơn nhưng có thể bỏ lỡ các mối quan hệ ở xa.

Sự lựa chọn giữa sự chú ý toàn cầu và địa phương phụ thuộc vào một số yếu tố:

- Yêu cầu nhiệm vụ: Các nhiệm vụ như dịch máy yêu cầu nắm bắt các mối quan hệ ở xa, thu hút sự chú ý của toàn cầu, trong khi phân tích tình cảm có thể thu hút sự chú ý của địa phương.

- Độ dài trình tự: Các chuỗi dài hơn làm cho sự chú ý toàn cầu trở nên tốn kém về mặt tính toán, đòi hỏi các phương pháp tiếp cận cục bộ hoặc kết hợp.

- Công suất mô hình: Những hạn chế về nguồn lực có thể đòi hỏi sự chú ý của địa phương ngay cả đối với những nhiệm vụ đòi hỏi bối cảnh toàn cầu.

Để đạt được sự cân bằng tối ưu, các mô hình có thể sử dụng:

- Chuyển mạch động: sử dụng sự chú ý toàn cầu cho các yếu tố chính và sự chú ý cục bộ cho các yếu tố khác, điều chỉnh dựa trên tầm quan trọng và khoảng cách.

- phương pháp lai: kết hợp cả hai cơ chế trong cùng một lớp, tận dụng sức mạnh tương ứng của chúng.

Cũng đọc: Phân tích các loại mạng lưới thần kinh trong học sâu

Kết luận

Cuối cùng, cách tiếp cận lý tưởng nằm trên phạm vi giữa sự chú ý của toàn cầu và địa phương. Hiểu được những sự đánh đổi này và áp dụng các chiến lược phù hợp cho phép các mô hình khai thác hiệu quả thông tin liên quan trên các quy mô khác nhau, dẫn đến sự hiểu biết phong phú và chính xác hơn về trình tự.

dự án

- Raschka, S. (2023). “Hiểu và mã hóa sự chú ý của bản thân, sự chú ý của nhiều người, sự chú ý chéo và sự chú ý nhân quả trong LLM.”

- Vaswani, A., và cộng sự. (2017). “Sự chú ý là tất cả những gì bạn cần.”

- Radford, A., và cộng sự. (2019). “Mô hình ngôn ngữ là những người học đa nhiệm không được giám sát.”

Sản phẩm liên quan

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.analyticsvidhya.com/blog/2024/01/different-types-of-attention-mechanisms/

- : có

- :là

- :không phải

- :Ở đâu

- $ LÊN

- 1

- 2017

- 2019

- 2023

- 302

- 320

- 321

- 7

- a

- có khả năng

- truy cập

- chính xác

- chính xác

- Đạt được

- đạt được

- ngang qua

- hành vi

- thực tế

- địa chỉ

- Nhận nuôi

- trước

- AL

- Tất cả

- Cho phép

- cho phép

- am

- Sự mơ hồ

- số lượng

- an

- phân tích

- phân tích

- phân tích

- và

- trả lời

- ngoài

- rõ ràng

- áp dụng

- phương pháp tiếp cận

- cách tiếp cận

- LÀ

- khu vực

- bài viết

- AS

- các khía cạnh

- Trợ lý

- trợ lý

- At

- hy vọng

- tham dự

- sự chú ý

- nhận thức

- Cân đối

- dựa

- cơ sở

- BE

- Chùm tia

- trở nên

- trước

- giữa

- Ngoài

- ngăn chặn

- cuốn sách

- Sách

- cả hai

- CẦU

- cầu

- Tươi

- rộng hơn

- Mang lại

- Xây dựng

- xây dựng

- xây dựng

- nhưng

- by

- đến

- CAN

- nắm bắt

- chụp

- Chụp

- trường hợp

- thay đổi

- Chương

- chương

- sự lựa chọn

- gần gũi hơn

- Lập trình

- kết hợp

- đến

- Các công ty

- khả năng tương thích

- phức tạp

- tính toán

- tính toán

- Kết nối

- Kết nối

- Kết nối

- Hãy xem xét

- xem xét

- khó khăn

- chứa

- nội dung

- bối cảnh

- tiếp tục

- Trung tâm

- tương quan

- tạo ra

- tạo ra

- Tạo

- quan trọng

- quan trọng

- Current

- dữ liệu

- khoa học dữ liệu

- Giải mã

- sâu

- sâu sắc hơn

- xác định

- đào sâu

- phụ thuộc

- phụ thuộc

- phụ thuộc

- Phụ thuộc

- phụ thuộc

- chi tiết

- Đối thoại

- ĐÃ LÀM

- khác nhau

- trực tiếp

- khoảng cách

- Xa xôi

- khác biệt

- khác nhau

- do

- tài liệu

- DOT

- tăng gấp đôi

- hàng chục

- đột ngột

- vẽ tranh

- hai

- động lực

- E&T

- mỗi

- hiệu quả

- hiệu quả

- hiệu quả

- hiệu quả

- thành phần

- các yếu tố

- nâng cao vị thế

- cho phép

- cho phép

- mã hóa

- Làm giàu

- đảm bảo

- đảm bảo

- đăng ký hạng mục thi

- Toàn bộ

- toàn bộ

- đã trang bị

- đặc biệt

- bản chất

- thiết yếu

- chủ yếu

- thành lập

- Ngay cả

- Mỗi

- phát triển

- chính xác

- đắt tiền

- Khai thác

- trích xuất

- Đối mặt

- các yếu tố

- xa

- ủng hộ

- lĩnh vực

- Lĩnh vực

- cuối cùng

- dòng chảy

- Chảy

- Tập trung

- tập trung

- tập trung

- tập trung

- Trong

- đi đầu

- các hình thức

- Nền tảng

- 4

- Khung

- từ

- chức năng

- chức năng

- tương lai

- trò chơi

- tạo

- tạo ra

- thế hệ

- Toàn cầu

- bối cảnh toàn cầu

- sự hiểu biết

- Phát triển

- Hướng dẫn

- hướng dẫn

- xử lý

- Có

- có

- cái đầu

- giúp đỡ

- Thành viên ẩn danh

- Cao

- cao hơn

- làm nổi bật

- giữ

- toàn diện

- Độ đáng tin của

- HTTPS

- Nhân loại

- Hỗn hợp

- i

- lý tưởng

- xác định

- if

- hình ảnh

- lập tức

- tầm quan trọng

- quan trọng

- in

- không chính xác

- kết hợp

- chỉ

- hệ thống riêng biệt,

- không hiệu quả

- thông tin

- vốn có

- đầu vào

- những hiểu biết

- ví dụ

- Thông minh

- dự định

- tương tác

- tương tác

- tương tác

- can thiệp

- trong

- vô giá

- cô lập

- IT

- ITS

- jpg

- chỉ

- Key

- Những vùng trọng điểm

- Ngôn ngữ

- Họ

- lớp

- hàng đầu

- LEARN

- Học hỏi và trưởng thành

- người học

- học tập

- Led

- ống kính

- ống kính

- Tỉ lệ đòn bẩy

- tận dụng

- Thư viện

- nằm

- ánh sáng

- Lượt thích

- giới hạn

- hạn chế

- địa phương

- dài

- còn

- Xem

- yêu

- máy

- học máy

- dịch máy

- duy trì

- làm cho

- Làm

- người đàn ông

- nhiều

- mặt nạ

- Matrix

- max-width

- có nghĩa là

- ý nghĩa

- đo

- cơ chế

- cơ chế

- Bộ nhớ

- Might

- bỏ lỡ

- mất tích

- kiểu mẫu

- mô hình

- chi tiết

- hiệu quả hơn

- nhiều mặt

- nhiều

- Tự nhiên

- Ngôn ngữ tự nhiên

- Tạo ngôn ngữ tự nhiên

- Xử lý ngôn ngữ tự nhiên

- Hiểu ngôn ngữ tự nhiên

- Thiên nhiên

- Cần

- cần

- nhu cầu

- người hàng xóm

- mạng

- Thần kinh

- mạng thần kinh

- Mới

- tiếp theo

- đêm

- nlp

- danh từ

- tại

- sắc thái

- of

- thường

- on

- hàng loạt

- có thể

- tối ưu

- or

- gọi món

- Nền tảng khác

- Khác

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- ra

- đầu ra

- kết quả đầu ra

- tổng thể

- tổng quan

- riêng

- trang

- đôi

- Giấy

- Song song

- các bộ phận

- đoạn

- qua

- mô hình

- thực hiện

- hiệu suất

- quan điểm

- miếng

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- Play

- Điểm

- đặt ra

- sở hữu

- khả năng

- mạnh

- tiềm năng

- có khả năng

- quyền lực

- mạnh mẽ

- dự đoán

- Dự đoán

- bảo quản

- ngăn chặn

- trước đây

- chủ yếu

- chính

- quá trình

- xử lý

- Quy trình

- xử lý

- Sức mạnh xử lý

- Sản phẩm

- dự

- đẩy ra

- cung cấp

- câu hỏi

- phạm vi

- khác nhau,

- hơn

- Đọc

- sẵn sàng

- Reading

- thời gian thực

- tài liệu tham khảo

- Bất kể

- Mối quan hệ

- tương đối

- sự liên quan

- có liên quan

- đáng chú ý

- đại diện

- đại diện

- đại diện cho

- yêu cầu

- giải quyết

- tài nguyên

- Thông tin

- mà

- Kết quả

- xem xét

- cách mạng

- cách mạng hóa

- Giàu

- Vai trò

- s

- tương tự

- Mỉa mai

- thấy

- quy mô

- quét

- Khoa học

- Điểm số

- điểm

- Tìm kiếm

- Thứ hai

- nhìn thấy

- kết án

- tình cảm

- Trình tự

- Loạt Sách

- phục vụ

- một số

- Chia sẻ

- sáng

- chụp

- ngắn

- giới thiệu

- đồng thời

- chậm

- nhỏ hơn

- chỉ duy nhất

- động SOLVE

- đôi khi

- nguồn

- Không gian

- riêng

- đặc biệt

- quang phổ

- tốc độ

- Spotlight

- đứng

- Ngôi sao

- Bước

- cửa hàng

- chiến lược

- thế mạnh

- mạnh mẽ hơn

- cấu trúc

- Đấu tranh

- Đấu tranh

- Tiêu đề

- tiếp theo

- như vậy

- phù hợp

- tổng hợp

- tóm tắt

- TÓM TẮT

- cao

- Xung quanh

- hệ thống

- giải quyết

- dùng

- tấm thảm

- nhiệm vụ

- Kỹ thuật

- kỳ hạn

- văn bản

- tạo văn bản

- việc này

- Sản phẩm

- thế giới

- cung cấp their dịch

- Them

- sau đó

- Kia là

- họ

- điều này

- số ba

- Thông qua

- thời gian

- Chuỗi thời gian

- đến

- công cụ

- truyền thống

- Hội thảo

- biến đổi

- chuyển đổi

- biến áp

- máy biến áp

- biến đổi

- Dịch

- đúng

- hai

- loại

- Cuối cùng

- hiểu

- sự hiểu biết

- Chắc chắn

- mở khóa

- công bố

- Tiết lộ

- sử dụng

- sử dụng

- sử dụng

- khác nhau

- Lớn

- Versus

- Xem

- đến thăm

- quan trọng

- vs

- muốn

- muốn

- là

- TỐT

- Điều gì

- khi nào

- trong khi

- CHÚNG TÔI LÀ

- toàn bộ

- rộng

- Phạm vi rộng

- sẽ

- cửa sổ

- với

- ở trong

- không có

- người phụ nữ

- Từ

- từ

- Công việc

- thế giới

- viết

- hôm qua

- bạn

- zephyrnet

- VƯỜN BÁCH THÚ