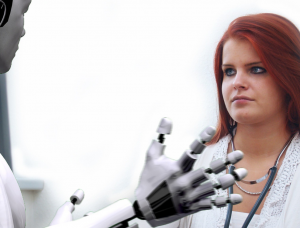

Trí tuệ nhân tạo (AI) đã cách mạng hóa nhiều ngành công nghiệp khác nhau, mang lại nhiều lợi ích và cơ hội. Tuy nhiên, những lo ngại đã xuất hiện liên quan đến khả năng AI duy trì sự phân biệt đối xử và thành kiến. Bài viết này khám phá chủ đề phân biệt đối xử AI, làm sáng tỏ những thách thức trong việc xác định và giải quyết các thành kiến được nhúng trong các hệ thống AI. Những người trong ngành bày tỏ nghi ngờ về ý nghĩa đạo đức và luân lý của AI, viện dẫn những lo ngại về thông tin sai lệch, sai lệch trong thuật toán và việc tạo ra nội dung gây hiểu lầm. Khi các cuộc tranh luận xung quanh AI ngày càng gay gắt, ngày càng có nhiều lời kêu gọi về quy định có ý nghĩa để đảm bảo tính minh bạch, trách nhiệm giải trình và bảo vệ các quyền cơ bản.

Thách thức đối với ngành tài chính với AI

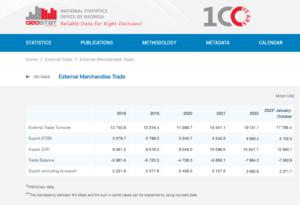

Theo Nabil Manji, người đứng đầu bộ phận tiền điện tử và Web3 tại Worldpay của FIS, hiệu quả của các sản phẩm AI phụ thuộc rất nhiều vào chất lượng của tài liệu nguồn được sử dụng để đào tạo. Trong một cuộc phỏng vấn với CNBC, Manji giải thích rằng hai yếu tố chính góp phần vào hiệu suất của AI: dữ liệu mà nó có quyền truy cập và khả năng của mô hình ngôn ngữ lớn.

Để minh họa tầm quan trọng của dữ liệu, Manji đã đề cập rằng các công ty như Reddit đã tuyên bố công khai các hạn chế đối với việc thu thập dữ liệu, yêu cầu trả tiền để có quyền truy cập. Trong lĩnh vực dịch vụ tài chính, ông nhấn mạnh thách thức của hệ thống dữ liệu bị phân mảnh ở nhiều ngôn ngữ và định dạng khác nhau. Việc thiếu hợp nhất và hài hòa này đã hạn chế hiệu quả của các sản phẩm do AI điều khiển, đặc biệt khi so sánh với các ngành có cơ sở hạ tầng dữ liệu được tiêu chuẩn hóa và hiện đại hóa.

Theo Manji, việc sử dụng công nghệ chuỗi khối hoặc sổ cái phân tán có thể đưa ra một giải pháp tiềm năng để giải quyết vấn đề này. Cách tiếp cận sáng tạo này có thể mang lại tính minh bạch cao hơn cho dữ liệu bị phân mảnh được lưu trữ trong các hệ thống phức tạp của các ngân hàng thông thường. Tuy nhiên, ông thừa nhận rằng tính chất quản lý chặt chẽ và hoạt động chậm chạp của các ngân hàng có thể cản trở khả năng áp dụng nhanh chóng các công cụ AI mới của họ, không giống như các công ty công nghệ nhanh nhẹn hơn như Microsoft và Google, những công ty đã đi đầu trong việc thúc đẩy đổi mới trong thời gian qua. nhiều thập kỷ.

Xem xét các yếu tố này, rõ ràng là ngành tài chính phải đối mặt với những thách thức đặc biệt trong việc tận dụng AI do sự phức tạp của việc tích hợp dữ liệu và bản chất vốn có của ngành ngân hàng.

Theo Rumman Chowdhury, cựu giám đốc đạo đức học máy, tính minh bạch và trách nhiệm giải trình tại Twitter, cho vay là một ví dụ đáng chú ý về mức độ thiên vị trong các hệ thống AI có thể ảnh hưởng xấu đến các cộng đồng bị thiệt thòi. Phát biểu tại một cuộc thảo luận nhóm ở Amsterdam, Chowdhury đã nêu bật thực tiễn lịch sử về việc “xếp lại” ở Chicago trong những năm 1930. Redlined liên quan đến việc từ chối các khoản vay đối với các khu dân cư chủ yếu là người Mỹ gốc Phi dựa trên nhân khẩu học chủng tộc.

Chowdhury giải thích rằng mặc dù các thuật toán hiện đại có thể không bao gồm chủng tộc một cách rõ ràng như một điểm dữ liệu, nhưng các thành kiến vẫn có thể được mã hóa hoàn toàn. Khi phát triển các thuật toán để đánh giá mức độ rủi ro của các khu vực và cá nhân cho mục đích cho vay, dữ liệu lịch sử chứa các thành kiến có thể vô tình kéo dài sự phân biệt đối xử.

Angle Bush, người có tầm nhìn xa đằng sau Phụ nữ da đen trong Trí tuệ nhân tạo, đã nhấn mạnh tầm quan trọng của việc thừa nhận những nguy cơ liên quan đến việc tái tạo các thành kiến được nhúng trong dữ liệu lịch sử khi sử dụng các hệ thống AI để đưa ra quyết định phê duyệt khoản vay. Thực tiễn như vậy có thể dẫn đến việc tự động từ chối các đơn xin vay vốn từ các cộng đồng yếu thế, do đó kéo dài sự bất bình đẳng về chủng tộc hoặc giới tính.

Frost Li, một nhà phát triển AI có kinh nghiệm, đã chỉ ra những thách thức của việc cá nhân hóa trong Tích hợp AI. Việc chọn “các tính năng cốt lõi” để đào tạo các mô hình AI đôi khi có thể liên quan đến các yếu tố không liên quan có thể dẫn đến kết quả sai lệch. Li đã đưa ra một ví dụ về cách các công ty khởi nghiệp fintech nhắm mục tiêu đến người nước ngoài có thể phải đối mặt với các tiêu chí đánh giá tín dụng khác so với các ngân hàng địa phương, vốn quen thuộc hơn với các trường học và cộng đồng địa phương.

Niklas Guske, COO của Taktile, một công ty khởi nghiệp chuyên tự động hóa việc ra quyết định cho fintech, đã làm rõ rằng AI tổng quát thường không được sử dụng để tạo điểm tín dụng hoặc chấm điểm rủi ro của người tiêu dùng. Ngược lại, sức mạnh của nó nằm ở việc tiền xử lý dữ liệu phi cấu trúc, chẳng hạn như tệp văn bản, để nâng cao chất lượng dữ liệu cho các mô hình bảo lãnh phát hành thông thường.

Tóm lại, việc sử dụng AI trong các dịch vụ cho vay và tài chính làm dấy lên mối lo ngại về sự thiên vị và phân biệt đối xử. Những sai lệch lịch sử được nhúng trong dữ liệu và việc lựa chọn các tính năng không liên quan trong quá trình đào tạo AI có thể dẫn đến những kết quả không công bằng. Điều quan trọng đối với các ngân hàng và tổ chức tài chính là phải nhận ra và giải quyết những vấn đề này để ngăn chặn tình trạng phân biệt đối xử vô tình xảy ra khi triển khai các giải pháp AI.

Chứng minh AI-Phân biệt đối xử

Việc chứng minh sự phân biệt đối xử dựa trên AI có thể là một thách thức, được nêu bật bởi các ví dụ như trường hợp liên quan đến Apple và Goldman Sachs. Bộ Dịch vụ Tài chính của Bang New York đã bác bỏ cáo buộc áp đặt các giới hạn thấp hơn đối với Thẻ Apple dành cho phụ nữ, với lý do thiếu bằng chứng xác thực.

Kim Smouter, giám đốc Mạng lưới chống phân biệt chủng tộc châu Âu, chỉ ra rằng việc triển khai AI hàng loạt mang lại sự mờ mịt trong quá trình ra quyết định, khiến các cá nhân khó xác định và giải quyết vấn đề phân biệt đối xử.

Smouter giải thích rằng các cá nhân thường có kiến thức hạn chế về cách thức hoạt động của các hệ thống AI, khiến việc phát hiện các trường hợp phân biệt đối xử hoặc thành kiến hệ thống trở nên khó khăn. Nó càng trở nên phức tạp hơn khi sự phân biệt đối xử là một phần của vấn đề rộng lớn hơn ảnh hưởng đến nhiều cá nhân. Smouter đề cập đến vụ bê bối phúc lợi trẻ em ở Hà Lan, trong đó một số lượng lớn các yêu cầu trợ cấp đã bị dán nhãn sai là gian lận do định kiến của thể chế. Việc phát hiện ra những rối loạn chức năng như vậy là một thách thức và việc khắc phục có thể khó khăn và tốn thời gian, dẫn đến tác hại đáng kể và đôi khi không thể đảo ngược.

Những ví dụ này minh họa những khó khăn cố hữu trong việc chứng minh sự phân biệt đối xử dựa trên AI và đạt được các biện pháp khắc phục khi sự phân biệt đối xử đó xảy ra. Sự phức tạp của các hệ thống AI và sự thiếu minh bạch trong quá trình ra quyết định có thể khiến các cá nhân gặp khó khăn trong việc nhận ra và giải quyết các trường hợp phân biệt đối xử một cách hiệu quả.

Theo Chowdhury, nhu cầu cấp thiết về một cơ quan quản lý toàn cầu tương tự như Liên Hợp Quốc để giải quyết các rủi ro liên quan đến AI. Trong khi AI đã cho thấy sự đổi mới đáng chú ý, các nhà công nghệ và nhà đạo đức đã nêu lên những lo ngại về ý nghĩa đạo đức và luân lý của nó. Những lo ngại này bao gồm các vấn đề như thông tin sai lệch, thành kiến về chủng tộc và giới tính trong thuật toán AI cũng như việc tạo ra nội dung gây hiểu lầm bằng các công cụ như ChatGPT.

Chowdhury bày tỏ sự lo lắng khi bước vào một thế giới hậu sự thật, nơi thông tin trực tuyến, bao gồm văn bản, video và âm thanh, trở nên không đáng tin cậy do trí tuệ nhân tạo AI. Điều này đặt ra câu hỏi về cách chúng tôi có thể đảm bảo tính toàn vẹn của thông tin và cách chúng tôi có thể dựa vào thông tin đó để đưa ra các quyết định sáng suốt. Lấy Đạo luật AI của Liên minh Châu Âu làm ví dụ, quy định có ý nghĩa về AI là rất quan trọng tại thời điểm này. Tuy nhiên, có những lo ngại về thời gian dài để các đề xuất quy định có hiệu lực, có khả năng trì hoãn các hành động cần thiết.

Smouter nhấn mạnh nhu cầu về tính minh bạch và trách nhiệm giải trình cao hơn trong các thuật toán AI. Điều này bao gồm làm cho các thuật toán trở nên dễ hiểu hơn đối với những người không phải là chuyên gia, tiến hành kiểm tra và công bố kết quả, thiết lập các quy trình khiếu nại độc lập, tiến hành kiểm tra và báo cáo định kỳ, đồng thời thu hút sự tham gia của các cộng đồng phân biệt chủng tộc trong việc thiết kế và triển khai công nghệ. Việc thực thi Đạo luật AI, có quan điểm về quyền cơ bản và đưa ra các khái niệm như bồi thường, dự kiến sẽ bắt đầu sau khoảng hai năm. Việc rút ngắn thời gian này sẽ là một lợi thế để duy trì tính minh bạch và trách nhiệm giải trình như những khía cạnh không thể thiếu của đổi mới.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Ô tô / Xe điện, Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- BlockOffsets. Hiện đại hóa quyền sở hữu bù đắp môi trường. Truy cập Tại đây.

- nguồn: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- : có

- :là

- :không phải

- :Ở đâu

- a

- có khả năng

- Giới thiệu

- truy cập

- trách nhiệm

- thừa nhận

- Hành động

- hành động

- địa chỉ

- giải quyết

- nhận nuôi

- thuận lợi

- bất lợi

- ảnh hưởng đến

- Phi

- chống lại

- nhanh nhẹn

- AI

- Đạo luật AI

- Hệ thống AI

- Đào tạo AI

- thuật toán

- Lời cáo buộc

- Mặc dù

- American

- amsterdam

- an

- và

- Dự đoán

- Apple

- Thẻ táo

- các ứng dụng

- phương pháp tiếp cận

- phê duyệt

- khoảng

- LÀ

- bài viết

- nhân tạo

- trí tuệ nhân tạo

- AS

- các khía cạnh

- đánh giá

- thẩm định, lượng định, đánh giá

- liên kết

- At

- âm thanh

- kiểm toán

- Tự động

- tự động hóa

- Ngân hàng

- khu vực ngân hàng

- Ngân hàng

- dựa

- BE

- trở nên

- trở thành

- được

- sau

- hưởng lợi

- Lợi ích

- thiên vị

- có thành kiến

- thành kiến

- Đen

- blockchain

- thân hình

- Mang lại

- rộng hơn

- by

- cuộc gọi

- CAN

- khả năng

- thẻ

- trường hợp

- thách thức

- thách thức

- thách thức

- ChatGPT

- Chicago

- trẻ em

- tuyên bố

- làm rõ

- CNBC

- Cộng đồng

- Các công ty

- so

- khiếu nại

- phức tạp

- phức tạp

- phức tạp

- khái niệm

- Mối quan tâm

- Tiến hành

- hợp nhất

- Người tiêu dùng

- chứa

- nội dung

- trái

- Góp phần

- thông thường

- thì thầm

- Tạo

- tín dụng

- tiêu chuẩn

- quan trọng

- Crypto

- nguy hiểm

- dữ liệu

- cơ sở hạ tầng dữ liệu

- tích hợp dữ liệu

- chất lượng dữ liệu

- cuộc tranh luận

- thập kỷ

- Ra quyết định

- quyết định

- Nhân khẩu học

- bộ

- phụ thuộc

- triển khai

- Thiết kế

- Nhà phát triển

- phát triển

- khác nhau

- khó khăn

- khó khăn

- Giám đốc

- phát hiện

- Phân biệt đối xử

- thảo luận

- phân phối

- Sổ cái phân phối

- công nghệ sổ kế toán phân phối

- lái xe

- hai

- suốt trong

- Tiếng Hà Lan

- Hiệu quả

- hiệu quả

- hiệu quả

- nhúng

- xuất hiện

- nhấn mạnh

- bao gồm

- thực thi

- nâng cao

- nâng cao

- đảm bảo

- vào

- đặc biệt

- thành lập

- đạo đức

- đạo đức

- Châu Âu

- Ngay cả

- bằng chứng

- hiển nhiên

- ví dụ

- ví dụ

- kinh nghiệm

- Giải thích

- Giải thích

- khám phá

- thể hiện

- Đối mặt

- khuôn mặt

- các yếu tố

- quen

- Tính năng

- vài

- Các tập tin

- tài chính

- ngành tài chính

- Học viện Tài chính

- dịch vụ tài chính

- fintech

- khởi nghiệp fintech

- fintechs

- FIS

- Trong

- đi đầu

- Cựu

- phân mảnh

- lừa đảo

- từ

- cơ bản

- Giới Tính

- thế hệ

- thế hệ

- Trí tuệ nhân tạo

- Toàn cầu

- goldman

- Goldman Sachs

- lớn hơn

- Phát triển

- làm hại

- Có

- he

- cái đầu

- nặng nề

- Nhấn mạnh

- cao

- lịch sử

- Độ đáng tin của

- Tuy nhiên

- HTTPS

- xác định

- xác định

- thực hiện

- hàm ý

- tầm quan trọng

- áp đặt

- in

- bao gồm

- bao gồm

- Bao gồm

- độc lập

- các cá nhân

- các ngành công nghiệp

- ngành công nghiệp

- bất bình đẳng

- thông tin

- thông báo

- Cơ sở hạ tầng

- vốn có

- sự đổi mới

- sáng tạo

- Thể chế

- tổ chức

- thiếu

- hội nhập

- tính toàn vẹn

- Sự thông minh

- Phỏng vấn

- trong

- Giới thiệu

- liên quan

- tham gia

- liên quan đến

- vấn đề

- các vấn đề

- IT

- ITS

- kiến thức

- Thiếu sót

- Ngôn ngữ

- Ngôn ngữ

- lớn

- dẫn

- hàng đầu

- học tập

- Ledger

- cho vay

- tận dụng

- li

- nằm

- ánh sáng

- Lượt thích

- Hạn chế

- giới hạn

- cho vay

- Các khoản cho vay

- địa phương

- NGÂN HÀNG ĐỊA PHƯƠNG

- thấp hơn

- máy

- học máy

- Chủ yếu

- làm cho

- Làm

- Thánh Lễ

- vật liệu

- Có thể..

- có ý nghĩa

- đề cập

- microsoft

- Might

- Thông tin sai

- gây hiểu lầm

- kiểu mẫu

- mô hình

- hiện đại

- thời điểm

- đạo đức

- chi tiết

- nhiều

- Quốc

- Thiên nhiên

- cần thiết

- Cần

- mạng

- Mới

- Newyork

- Bang New York

- Bộ dịch vụ tài chính bang New York

- không phải chuyên gia

- Nổi bật

- con số

- nhiều

- nhiều lợi ích

- có được

- of

- cung cấp

- cung cấp

- thường

- on

- Trực tuyến

- hoạt động

- Cơ hội

- or

- ra

- kết quả

- bảng điều khiển

- thảo luận nhóm

- một phần

- qua

- thanh toán

- hiệu suất

- định kỳ

- cá nhân

- quan điểm

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- Điểm

- điểm

- tiềm năng

- có khả năng

- thực hành

- chủ yếu

- nhấn

- ngăn chặn

- Vấn đề

- Quy trình

- Sản phẩm

- Đề xuất

- bảo vệ

- cho

- cung cấp

- công khai

- Xuất bản

- mục đích

- chất lượng

- Câu hỏi

- Cuộc đua

- phân biệt chủng tộc

- nâng lên

- tăng giá

- công nhận

- giảm

- tài liệu tham khảo

- về

- quy định

- Quy định

- nhà quản lý

- dựa

- đáng chú ý

- Báo cáo

- hạn chế

- Kết quả

- cách mạng hóa

- quyền

- Nguy cơ

- rủi ro

- Sachs

- Scandal

- Trường học

- điểm

- ghi bàn

- cào

- ngành

- lựa chọn

- lựa chọn

- DỊCH VỤ

- thể hiện

- ý nghĩa

- có ý nghĩa

- tương tự

- giải pháp

- Giải pháp

- nguồn

- nói

- chuyên

- khởi động

- Startups

- Tiểu bang

- Bộ Ngoại giao

- Vẫn còn

- lưu trữ

- sức mạnh

- như vậy

- TÓM TẮT

- Xung quanh

- nhanh chóng

- hệ thống

- hệ thống

- giải quyết

- mất

- nhắm mục tiêu

- công nghệ cao

- công ty công nghệ cao

- nhà công nghệ

- Công nghệ

- kiểm tra

- việc này

- Sản phẩm

- Nguồn

- cung cấp their dịch

- Đó

- bằng cách ấy

- Kia là

- điều này

- mất thời gian

- timeline

- dòng thời gian

- đến

- công cụ

- chủ đề

- Hội thảo

- Minh bạch

- hai

- thường

- dễ hiểu

- bảo lãnh phát hành

- không công bằng

- độc đáo

- Kỳ

- liên Hiệp Quốc

- không giống

- Ưu tiên

- khẩn cấp

- sử dụng

- đã sử dụng

- khác nhau

- Video

- nhìn xa trông rộng

- we

- Web3

- Phúc lợi

- là

- khi nào

- cái nào

- trong khi

- với

- ở trong

- Dành cho Nữ

- thế giới

- WorldPay

- lo

- sẽ

- năm

- york

- zephyrnet