Hệ thống trí tuệ nhân tạo (AI) mới được tạo dựa trên học tăng cường sâu (DRL) có thể phản ứng với những kẻ tấn công trong môi trường mô phỏng và chặn 95% các cuộc tấn công mạng trước khi chúng leo thang.

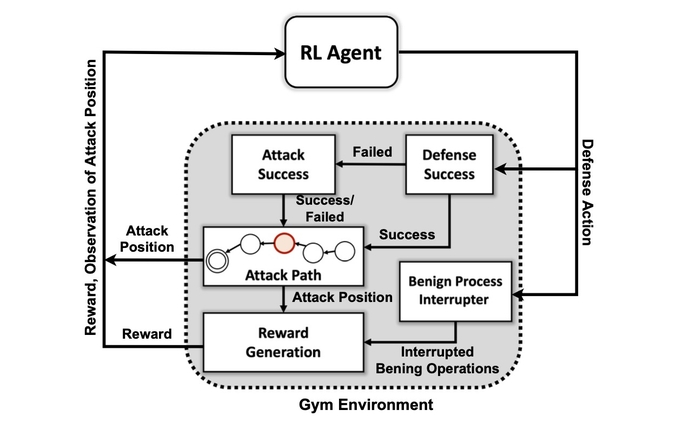

Đó là theo các nhà nghiên cứu từ Phòng thí nghiệm quốc gia Tây Bắc Thái Bình Dương của Bộ Năng lượng, họ đã xây dựng một mô phỏng trừu tượng về xung đột kỹ thuật số giữa những kẻ tấn công và những người bảo vệ trong một mạng và huấn luyện bốn mạng thần kinh DRL khác nhau để tối đa hóa phần thưởng dựa trên việc ngăn chặn sự thỏa hiệp và giảm thiểu sự gián đoạn mạng.

Những kẻ tấn công mô phỏng đã sử dụng một loạt các chiến thuật dựa trên MITER ATT & CK framework để chuyển từ giai đoạn truy cập và trinh sát ban đầu sang các giai đoạn tấn công khác cho đến khi đạt được mục tiêu: giai đoạn tác động và trích xuất.

Samrat Chatterjee, nhà khoa học dữ liệu, người đã trình bày công việc của nhóm tại cuộc họp thường niên của Hiệp hội cho biết, việc đào tạo thành công hệ thống AI trên môi trường tấn công đơn giản hóa chứng tỏ rằng các phản ứng phòng thủ trước các cuộc tấn công trong thời gian thực có thể được xử lý bằng mô hình AI. Sự tiến bộ của Trí tuệ nhân tạo ở Washington, DC vào ngày 14 tháng XNUMX.

“Bạn không muốn chuyển sang những kiến trúc phức tạp hơn nếu bạn thậm chí không thể hiện được sự hứa hẹn của những kỹ thuật này,” ông nói. “Trước tiên, chúng tôi muốn chứng minh rằng chúng tôi thực sự có thể huấn luyện DRL thành công và cho thấy một số kết quả thử nghiệm tốt trước khi tiếp tục.”

Việc áp dụng các kỹ thuật máy học và trí tuệ nhân tạo vào các lĩnh vực khác nhau trong an ninh mạng đã trở thành xu hướng nóng trong thập kỷ qua, từ việc sớm tích hợp máy học vào các cổng bảo mật email. trong những 2010 đầu tiên đến những nỗ lực gần đây hơn để sử dụng ChatGPT để phân tích mã hoặc tiến hành phân tích pháp y. Hiện nay, hầu hết các sản phẩm bảo mật đều có — hoặc tuyên bố là có — một vài tính năng được hỗ trợ bởi các thuật toán máy học được đào tạo trên các bộ dữ liệu lớn.

Tuy nhiên, việc tạo ra một hệ thống AI có khả năng phòng thủ chủ động tiếp tục là khát vọng hơn là thực tế. Trong khi vẫn còn nhiều rào cản đối với các nhà nghiên cứu, nghiên cứu của PNNL cho thấy rằng một người bảo vệ AI có thể khả thi trong tương lai.

Nhóm nghiên cứu PNNL “Đánh giá nhiều thuật toán DRL được đào tạo trong các môi trường đối nghịch khác nhau là một bước quan trọng hướng tới các giải pháp phòng thủ mạng tự động thực tế”. nêu trong bài báo của họ. “Các thử nghiệm của chúng tôi cho thấy rằng các thuật toán DRL không có mô hình có thể được đào tạo một cách hiệu quả trong các cấu hình tấn công nhiều giai đoạn với mức độ kỹ năng và sự kiên trì khác nhau, mang lại kết quả phòng thủ thuận lợi trong các bối cảnh gây tranh cãi.”

Cách Hệ thống Sử dụng MITRE ATT&CK

Mục tiêu đầu tiên của nhóm nghiên cứu là tạo ra một môi trường mô phỏng tùy chỉnh dựa trên bộ công cụ mã nguồn mở có tên là Mở phòng tập AI. Sử dụng môi trường đó, các nhà nghiên cứu đã tạo ra các thực thể kẻ tấn công có các cấp độ kỹ năng và sự kiên trì khác nhau với khả năng sử dụng một tập hợp con gồm 7 chiến thuật và 15 kỹ thuật từ khuôn khổ MITRE ATT&CK.

Mục tiêu của các tác nhân tấn công là di chuyển qua bảy bước của chuỗi tấn công, từ truy cập ban đầu đến thực thi, từ kiên trì đến chỉ huy và kiểm soát, và từ thu thập đến tác động.

Chatterjee của PNNL cho biết, đối với kẻ tấn công, việc điều chỉnh chiến thuật của họ cho phù hợp với trạng thái môi trường và hành động hiện tại của người phòng thủ có thể rất phức tạp.

Ông nói: “Đối thủ phải điều hướng theo cách của chúng từ trạng thái trinh sát ban đầu đến trạng thái xâm nhập hoặc tác động nào đó. “Chúng tôi không cố gắng tạo ra một loại mô hình để ngăn chặn kẻ thù trước khi chúng xâm nhập vào môi trường - chúng tôi cho rằng hệ thống đã bị xâm phạm.”

Các nhà nghiên cứu đã sử dụng bốn cách tiếp cận mạng lưới thần kinh dựa trên học tập tăng cường. Học tăng cường (RL) là một phương pháp học máy mô phỏng hệ thống phần thưởng của bộ não con người. Mạng nơ-ron học hỏi bằng cách tăng cường hoặc làm suy yếu một số thông số nhất định cho từng nơ-ron riêng lẻ để thưởng cho các giải pháp tốt hơn, được đo bằng điểm số cho biết hệ thống hoạt động tốt như thế nào.

Mahantesh Halappanavar, một nhà nghiên cứu của PNNL và là tác giả của bài báo cho biết, học tăng cường về cơ bản cho phép máy tính tạo ra một cách tiếp cận vấn đề hiện tại tốt, nhưng không hoàn hảo.

Ông nói: “Nếu không sử dụng bất kỳ phương pháp học tăng cường nào, chúng tôi vẫn có thể làm được điều đó, nhưng sẽ là một vấn đề thực sự lớn khi không có đủ thời gian để thực sự nghĩ ra bất kỳ cơ chế tốt nào”. “Nghiên cứu của chúng tôi… cung cấp cho chúng tôi cơ chế này, trong đó học tăng cường sâu gần như bắt chước một số hành vi của con người ở một mức độ nào đó và nó có thể khám phá không gian rất rộng lớn này một cách rất hiệu quả.”

Chưa sẵn sàng cho thời gian chính

Các thí nghiệm đã phát hiện ra rằng một phương pháp học tăng cường cụ thể, được gọi là Mạng Deep Q, đã tạo ra một giải pháp mạnh mẽ cho vấn đề phòng thủ, bắt 97% kẻ tấn công trong tập dữ liệu thử nghiệm. Tuy nhiên, nghiên cứu chỉ là sự khởi đầu. Các chuyên gia bảo mật không nên tìm kiếm một người bạn đồng hành AI để giúp họ sớm xử lý sự cố và pháp y.

Trong số nhiều vấn đề vẫn cần giải quyết là học tăng cường và mạng lưới thần kinh sâu để giải thích các yếu tố ảnh hưởng đến quyết định của họ, một lĩnh vực nghiên cứu gọi là học tăng cường có thể giải thích được (XRL).

Ngoài ra, sự mạnh mẽ của các thuật toán AI và việc tìm ra cách đào tạo mạng lưới thần kinh hiệu quả đều là những vấn đề cần được giải quyết, Chatterjee của PNNL cho biết.

Ông nói: “Tạo ra một sản phẩm— đó không phải là động lực chính cho nghiên cứu này. “Đây là về thử nghiệm khoa học và khám phá thuật toán nhiều hơn.”

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. Truy cập Tại đây.

- nguồn: https://www.darkreading.com/emerging-tech/researchers-create-ai-cyber-defender-that-reacts-to-attackers

- 7

- 95%

- a

- có khả năng

- Giới thiệu

- TÓM TẮT

- truy cập

- Theo

- hành động

- thực sự

- Ngoài ra

- thăng tiến

- đối thủ

- đại lý

- AI

- Hỗ trợ AI

- thuật toán

- thuật toán

- Tất cả

- cho phép

- Đã

- phân tích

- phân tích

- và

- hàng năm

- Các Ứng Dụng

- phương pháp tiếp cận

- cách tiếp cận

- KHU VỰC

- nhân tạo

- trí tuệ nhân tạo

- Trí tuệ nhân tạo (AI)

- Hiệp hội

- tấn công

- Các cuộc tấn công

- tác giả

- tự trị

- dựa

- trở nên

- trước

- Hơn

- giữa

- lớn

- Chặn

- Brain

- xây dựng

- gọi là

- không thể

- có khả năng

- nhất định

- chuỗi

- ChatGPT

- xin

- phân loại

- bộ sưu tập

- Đến

- phức tạp

- Thỏa hiệp

- máy tính

- Tiến hành

- xung đột

- liên tiếp

- điều khiển

- có thể

- tạo

- tạo ra

- Tạo

- Current

- khách hàng

- không gian mạng

- Tấn công mạng

- An ninh mạng

- dữ liệu

- nhà khoa học dữ liệu

- tập dữ liệu

- bộ dữ liệu

- dc

- thập kỷ

- quyết định

- quyết định

- sâu

- mạng lưới thần kinh sâu

- Hậu vệ

- Phòng thủ

- phòng thủ

- chứng minh

- chứng minh

- bộ

- Bộ Năng lượng

- khác nhau

- kỹ thuật số

- phát hiện

- Gián đoạn

- khác nhau

- DOE

- Đầu

- hiệu quả

- hiệu quả

- hiệu quả

- những nỗ lực

- bảo mật email

- năng lượng

- đủ

- thực thể

- Môi trường

- chủ yếu

- Ether (ETH)

- đánh giá

- Ngay cả

- thực hiện

- sự lọc ra

- Giải thích

- khám phá

- các yếu tố

- Tính năng

- vài

- Lĩnh vực

- tìm kiếm

- Tên

- dòng chảy

- Pháp y

- pháp y

- Forward

- tìm thấy

- Khung

- từ

- tương lai

- được

- nhận được

- cho

- mục tiêu

- Các mục tiêu

- tốt

- tay

- giúp đỡ

- NÓNG BỨC

- Độ đáng tin của

- HTTPS

- Nhân loại

- Vượt rào

- Va chạm

- quan trọng

- in

- sự cố

- ứng phó sự cố

- chỉ ra

- hệ thống riêng biệt,

- bị ảnh hưởng

- ban đầu

- hội nhập

- Sự thông minh

- IT

- chính nó

- Loại

- nổi tiếng

- phòng thí nghiệm

- lớn

- học tập

- niveaux

- Xem

- máy

- học máy

- Chủ yếu

- nhiều

- max-width

- Tối đa hóa

- cơ chế

- cuộc họp

- phương pháp

- giảm thiểu

- kiểu mẫu

- chi tiết

- Động lực

- di chuyển

- di chuyển

- nhiều

- quốc dân

- Điều hướng

- Cần

- mạng

- mạng

- Thần kinh

- mạng lưới thần kinh

- mạng thần kinh

- Neurons

- mở

- mã nguồn mở

- Nền tảng khác

- Hòa bình

- Giấy

- thông số

- qua

- hoàn hảo

- thực hiện

- kiên trì

- giai đoạn

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- có thể

- -

- Thực tế

- trình bày

- ngăn chặn

- Thủ tướng Chính phủ

- Chủ động

- Vấn đề

- vấn đề

- Sản phẩm

- chuyên gia

- Profiles

- lời hứa

- RE

- đạt

- Phản ứng

- tạo ra phản ứng

- sẵn sàng

- thực

- thời gian thực

- gần đây

- học tăng cường

- vẫn

- nghiên cứu

- nhà nghiên cứu

- nhà nghiên cứu

- phản ứng

- Khen thưởng

- Thưởng

- sự mạnh mẽ

- nói

- Nhà khoa học

- an ninh

- Loạt Sách

- định

- thiết lập

- XNUMX

- nên

- hiển thị

- Chương trình

- đơn giản hóa

- mô phỏng

- kỹ năng

- giải pháp

- Giải pháp

- một số

- Chẳng bao lâu

- nguồn

- Không gian

- riêng

- Bắt đầu

- Tiểu bang

- Bước

- Các bước

- Vẫn còn

- Dừng

- tăng cường

- mạnh mẽ

- thành công

- Thành công

- hệ thống

- chiến thuật

- nhóm

- kỹ thuật

- Kiểm tra

- Sản phẩm

- Tương lai

- Nhà nước

- cung cấp their dịch

- Thông qua

- thời gian

- đến

- bộ công cụ

- đối với

- Train

- đào tạo

- Hội thảo

- khuynh hướng

- Dưới

- us

- sử dụng

- nhiều

- Lớn

- muốn

- Washington

- cách

- trong khi

- CHÚNG TÔI LÀ

- sẽ

- ở trong

- không có

- Công việc

- sẽ

- năng suất

- zephyrnet