Những tiến bộ gần đây trong việc phát triển LLM đã phổ biến việc sử dụng chúng cho các nhiệm vụ NLP đa dạng mà trước đây được giải quyết bằng các phương pháp học máy cũ hơn. Các mô hình ngôn ngữ lớn có khả năng giải quyết nhiều vấn đề ngôn ngữ như phân loại, tóm tắt, truy xuất thông tin, tạo nội dung, trả lời câu hỏi và duy trì cuộc trò chuyện - tất cả chỉ sử dụng một mô hình duy nhất. Nhưng làm thế nào để chúng ta biết họ đang làm tốt tất cả những nhiệm vụ khác nhau này?

Sự nổi lên của LLM đã làm sáng tỏ một vấn đề chưa được giải quyết: chúng ta không có tiêu chuẩn đáng tin cậy để đánh giá chúng. Điều khiến việc đánh giá trở nên khó khăn hơn là chúng được sử dụng cho các nhiệm vụ rất đa dạng và chúng tôi thiếu định nghĩa rõ ràng về câu trả lời phù hợp cho từng trường hợp sử dụng.

Bài viết này thảo luận về các phương pháp tiếp cận hiện tại để đánh giá LLM và giới thiệu bảng xếp hạng LLM mới tận dụng đánh giá con người nhằm cải thiện các kỹ thuật đánh giá hiện có.

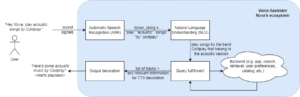

Hình thức đánh giá ban đầu đầu tiên và thông thường là chạy mô hình trên một số bộ dữ liệu được quản lý và kiểm tra hiệu suất của nó. HuggingFace đã tạo một Bảng xếp hạng LLM mở trong đó các mô hình lớn truy cập mở được đánh giá bằng bốn bộ dữ liệu nổi tiếng (Thử thách suy luận AI2 , HellaSwag , MMLU , Trung thựcQA). Điều này tương ứng với việc đánh giá tự động và kiểm tra khả năng của mô hình trong việc lấy thông tin thực tế cho một số câu hỏi cụ thể.

Đây là một ví dụ về câu hỏi của MMLU tập dữ liệu.

Chủ đề: đại học_y học

Câu hỏi: Tác dụng phụ dự kiến của việc bổ sung creatine là.

- A) yếu cơ

- B) tăng khối lượng cơ thể

- C) chuột rút cơ bắp

- D) mất chất điện giải

Đáp án: (B)

Việc chấm điểm mô hình khi trả lời loại câu hỏi này là một số liệu quan trọng và phục vụ tốt cho việc kiểm tra thực tế nhưng nó không kiểm tra khả năng tổng hợp của mô hình. Đây có lẽ là nhược điểm lớn nhất của phương pháp đánh giá này vì việc tạo văn bản miễn phí là một trong những tính năng quan trọng nhất của LLM.

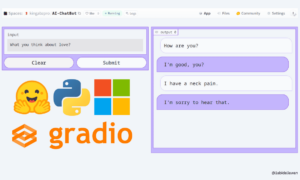

Dường như có sự đồng thuận trong cộng đồng rằng để đánh giá mô hình một cách chính xác, chúng ta cần có sự đánh giá của con người. Điều này thường được thực hiện bằng cách so sánh phản hồi từ các mô hình khác nhau.

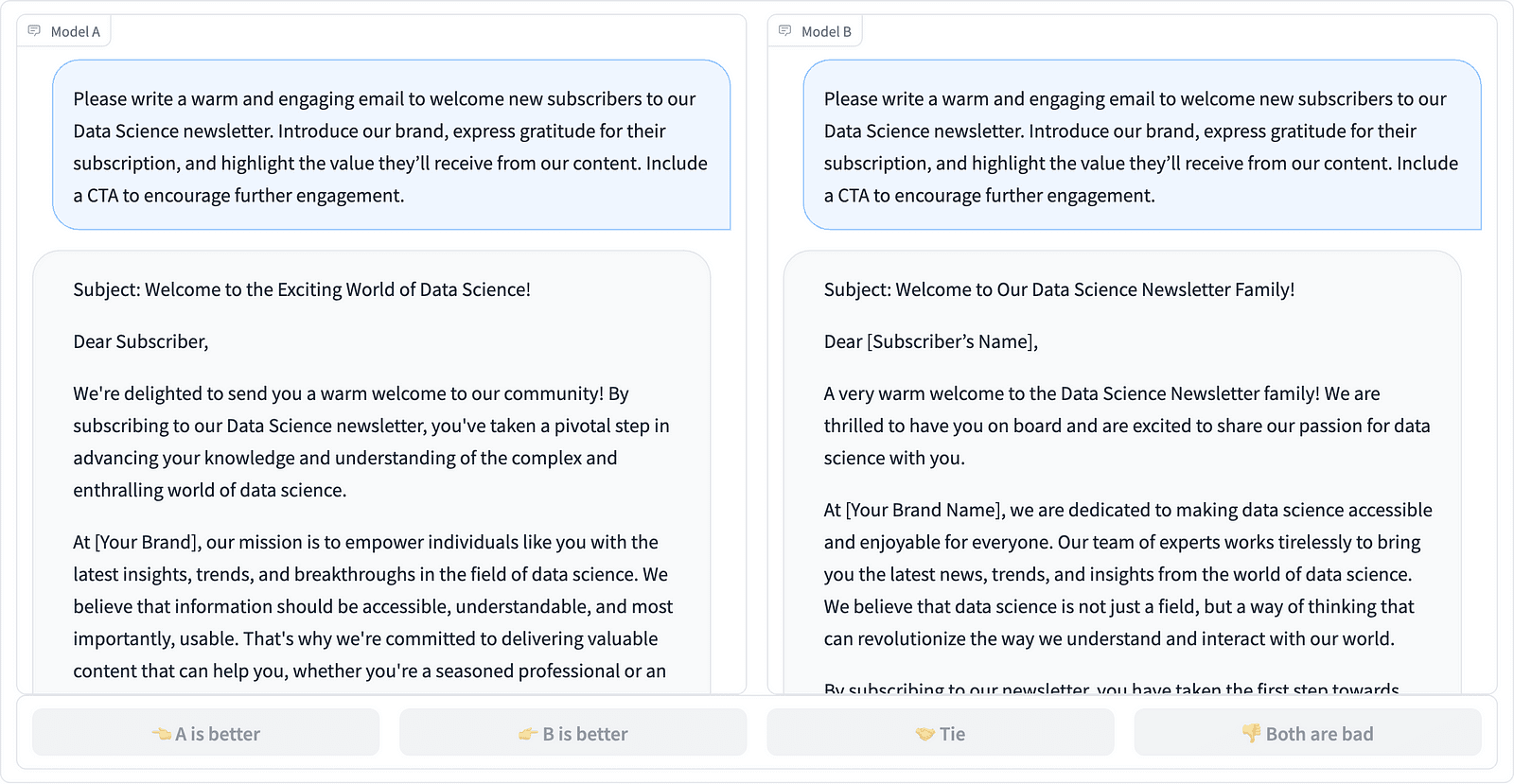

So sánh hai lần hoàn thành nhanh chóng trong dự án LMSYS – ảnh chụp màn hình của Tác giả

Người chú thích quyết định phản hồi nào tốt hơn, như đã thấy trong ví dụ trên và đôi khi định lượng sự khác biệt về chất lượng của các lần hoàn thành nhanh chóng. Tổ chức LMSYS đã tạo ra một bảng dẫn sử dụng kiểu đánh giá con người này và so sánh 17 mô hình khác nhau, báo cáo kết quả Xếp hạng elo cho mỗi mô hình.

Vì khó có thể mở rộng quy mô đánh giá của con người nên đã có nhiều nỗ lực mở rộng quy mô và đẩy nhanh quá trình đánh giá và điều này dẫn đến một dự án thú vị có tên là AlpacaEval. Ở đây, mỗi mô hình được so sánh với đường cơ sở (văn bản-davinci-003 do GPT-4 cung cấp) và đánh giá của con người được thay thế bằng phán đoán của GPT-4. Điều này thực sự nhanh và có thể mở rộng nhưng chúng ta có thể tin tưởng mô hình ở đây để thực hiện việc tính điểm không? Chúng ta cần nhận thức được những thành kiến của mô hình. Dự án thực sự đã chỉ ra rằng GPT-4 có thể ưu tiên các câu trả lời dài hơn.

Các phương pháp đánh giá LLM đang tiếp tục phát triển khi cộng đồng AI tìm kiếm các phương pháp tiếp cận dễ dàng, công bằng và có thể mở rộng. Sự phát triển mới nhất đến từ nhóm Toloka với một tính năng mới bảng dẫn nhằm nâng cao hơn nữa các tiêu chuẩn đánh giá hiện tại.

Mới bảng dẫn so sánh các phản hồi của mô hình với lời nhắc của người dùng trong thế giới thực được phân loại theo các tác vụ NLP hữu ích như được nêu trong bài viết Hướng dẫnGPT này. Nó cũng hiển thị tỷ lệ thắng chung của từng mô hình trên tất cả các danh mục.

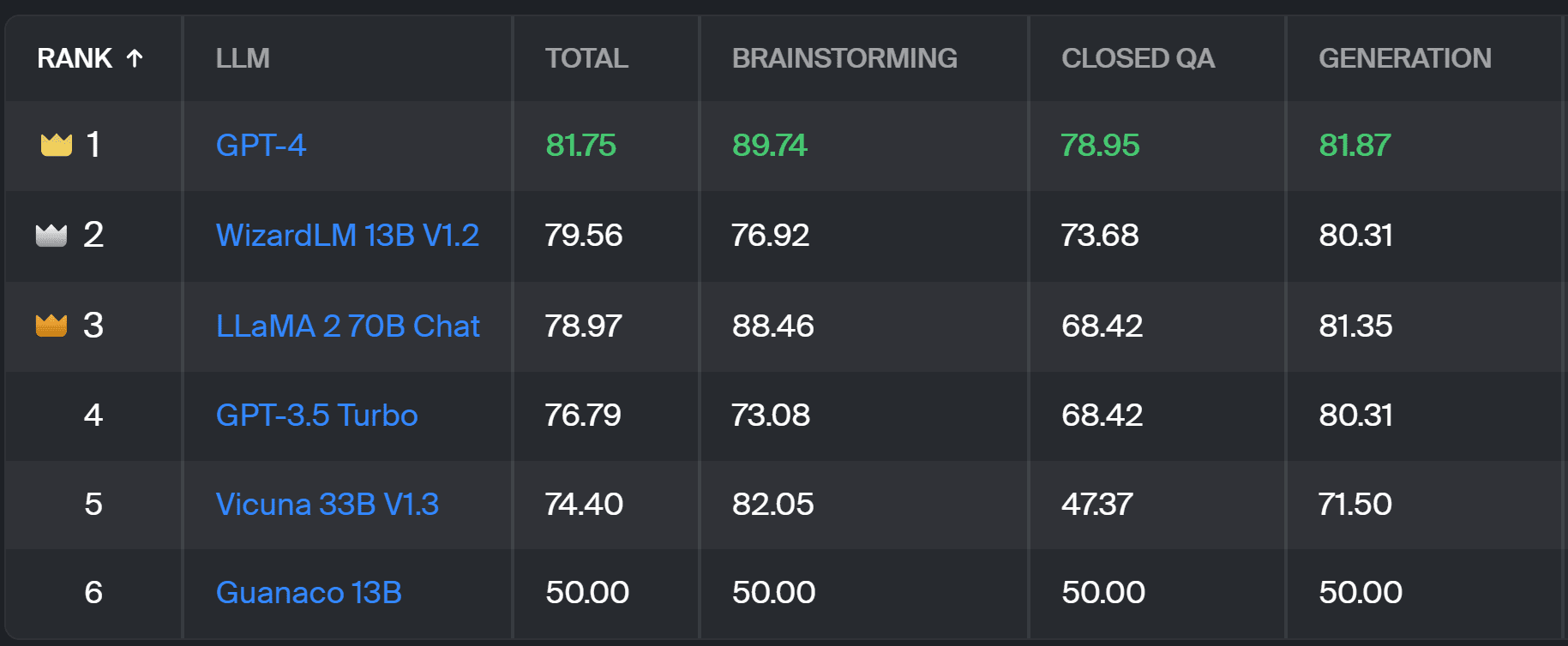

Bảng xếp hạng Toloka – ảnh chụp màn hình của Tác giả

Đánh giá được sử dụng cho dự án này tương tự như đánh giá được thực hiện trong AlpacaEval. Điểm số trên bảng xếp hạng thể hiện tỷ lệ thắng của mô hình tương ứng so với mô hình Guanaco 13B mô hình, được dùng ở đây như một sự so sánh cơ bản. Việc lựa chọn Guanaco 13B là một cải tiến cho phương pháp AlpacaEval, sử dụng mô hình text-davinci-003 sắp lỗi thời làm cơ sở.

Việc đánh giá thực tế được thực hiện bởi chuyên gia chú thích con người dựa trên một tập hợp các lời nhắc trong thế giới thực. Đối với mỗi lời nhắc, người chú thích được đưa ra hai câu hoàn thành và được hỏi họ thích câu nào hơn. Bạn có thể tìm thấy thông tin chi tiết về phương pháp tại đây.

Kiểu đánh giá con người này hữu ích hơn bất kỳ phương pháp đánh giá tự động nào khác và sẽ cải thiện việc đánh giá con người được sử dụng cho Bảng xếp hạng LMSYS. Nhược điểm của phương pháp LMSYS là bất kỳ ai có Link có thể tham gia đánh giá, đặt ra những câu hỏi nghiêm túc về chất lượng dữ liệu được thu thập theo cách này. Một nhóm chuyên gia chú thích kín có tiềm năng tốt hơn để có kết quả đáng tin cậy và Toloka áp dụng các kỹ thuật kiểm soát chất lượng bổ sung để đảm bảo chất lượng dữ liệu.

Trong bài viết này, chúng tôi đã giới thiệu một giải pháp mới đầy hứa hẹn để đánh giá LLM - Bảng xếp hạng Toloka. Cách tiếp cận này mang tính đổi mới, kết hợp điểm mạnh của các phương pháp hiện có, bổ sung độ chi tiết cho từng nhiệm vụ cụ thể và sử dụng các kỹ thuật chú thích đáng tin cậy của con người để so sánh các mô hình.

Khám phá bảng và chia sẻ ý kiến cũng như đề xuất cải tiến của bạn với chúng tôi.

Magdalena Konkiewicz là Nhà truyền bá dữ liệu tại Toloka, một công ty toàn cầu hỗ trợ phát triển AI nhanh chóng và có thể mở rộng. Cô có bằng Thạc sĩ về Trí tuệ nhân tạo tại Đại học Edinburgh và đã từng làm Kỹ sư, Nhà phát triển và Nhà khoa học dữ liệu NLP cho các doanh nghiệp ở Châu Âu và Châu Mỹ. Cô cũng đã tham gia giảng dạy và cố vấn cho các Nhà khoa học dữ liệu và thường xuyên đóng góp cho các ấn phẩm về Khoa học dữ liệu và Học máy.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- : có

- :là

- :không phải

- :Ở đâu

- $ LÊN

- 17

- a

- có khả năng

- Giới thiệu

- ở trên

- ngang qua

- thực tế

- thực sự

- thêm vào

- Thêm

- tiến

- tiến bộ

- AI

- Tất cả

- Ngoài ra

- Mỹ

- an

- và

- trả lời

- câu trả lời

- bất kì

- áp dụng

- phương pháp tiếp cận

- cách tiếp cận

- LÀ

- Arena

- bài viết

- nhân tạo

- trí tuệ nhân tạo

- AS

- At

- Tự động

- nhận thức

- b

- Baseline

- BE

- bởi vì

- được

- Hơn

- thành kiến

- lớn nhất

- bảng

- thân hình

- Mang lại

- các doanh nghiệp

- nhưng

- by

- CAN

- có khả năng

- trường hợp

- đố

- thách thức

- Séc

- sự lựa chọn

- phân loại

- trong sáng

- đóng cửa

- kết hợp

- đến

- cộng đồng

- công ty

- so sánh

- so

- so sánh

- sự so sánh

- Sự đồng thuận

- nội dung

- tạo nội dung

- tiếp tục

- đóng góp

- điều khiển

- Conversation

- tương ứng

- tạo ra

- tạo

- đám đông

- lưu trữ

- Current

- dữ liệu

- chất lượng dữ liệu

- khoa học dữ liệu

- nhà khoa học dữ liệu

- bộ dữ liệu

- quyết định

- định nghĩa

- Bằng cấp

- chi tiết

- Nhà phát triển

- Phát triển

- sự khác biệt

- khác nhau

- Bất lợi

- khác nhau

- do

- làm

- làm

- thực hiện

- dont

- nhược điểm

- mỗi

- dễ dàng

- Edinburgh

- hiệu lực

- những nỗ lực

- điện

- ky sư

- đảm bảo

- Châu Âu

- đánh giá

- đánh giá

- đánh giá

- đánh giá

- Thuyết phúc âm

- phát triển

- kiểm tra

- ví dụ

- hiện tại

- dự kiến

- chuyên gia

- sự kiện

- công bằng

- NHANH

- ủng hộ

- Tính năng

- Tìm kiếm

- Tên

- Trong

- hình thức

- 4

- Miễn phí

- từ

- xa hơn

- Thu được

- tập hợp

- tạo ra

- thế hệ

- được

- GitHub

- được

- Toàn cầu

- tốt

- làm tốt lắm

- Cứng

- khó hơn

- Có

- tại đây

- cao

- giữ

- Độ đáng tin của

- HTTPS

- ÔmKhuôn Mặt

- Nhân loại

- quan trọng

- nâng cao

- cải thiện

- cải tiến

- cải thiện

- in

- thông tin

- ban đầu

- sáng tạo

- Sự thông minh

- thú vị

- giới thiệu

- Giới thiệu

- tham gia

- IT

- ITS

- Việc làm

- chỉ

- chỉ một

- Xe đẩy

- Biết

- Thiếu sót

- Ngôn ngữ

- lớn

- mới nhất

- học tập

- tận dụng

- ánh sáng

- còn

- sự mất

- máy

- học máy

- duy trì

- LÀM CHO

- cách thức

- Thánh Lễ

- chủ

- Có thể..

- tư vấn

- phương pháp

- Phương pháp luận

- phương pháp

- số liệu

- kiểu mẫu

- mô hình

- chi tiết

- hầu hết

- cơ bắp

- Cần

- Mới

- giải pháp mới

- nlp

- of

- cũ

- on

- ONE

- mở

- Ý kiến

- Nền tảng khác

- nêu

- tổng thể

- một phần

- thực hiện

- hiệu suất

- thực hiện

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- tiềm năng

- thích hơn

- trước đây

- có lẽ

- Vấn đề

- vấn đề

- quá trình

- dự án

- hứa hẹn

- nhắc nhở

- đúng

- cung cấp

- ấn phẩm

- chất lượng

- câu hỏi

- Câu hỏi

- nâng cao

- Tỷ lệ

- thế giới thực

- thường xuyên

- đáng tin cậy

- thay thế

- Báo cáo

- đại diện

- mà

- phản ứng

- phản ứng

- dẫn

- Kết quả

- Tăng lên

- chạy

- s

- khả năng mở rộng

- Quy mô

- Khoa học

- Nhà khoa học

- các nhà khoa học

- điểm

- ghi bàn

- tìm kiếm

- dường như

- đã xem

- nghiêm trọng

- phục vụ

- định

- một số

- Chia sẻ

- chị ấy

- nên

- thể hiện

- Chương trình

- bên

- tương tự

- duy nhất

- giải pháp

- Giải quyết

- một số

- đôi khi

- riêng

- tốc độ

- Tiêu chuẩn

- tiêu chuẩn

- thế mạnh

- như vậy

- Hỗ trợ

- Hãy

- nhiệm vụ

- Giảng dạy

- nhóm

- kỹ thuật

- thử nghiệm

- văn bản

- hơn

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- Đó

- Kia là

- họ

- điều này

- đến

- NIỀM TIN

- hai

- kiểu

- thường

- trường đại học

- trên

- us

- Sử dụng

- sử dụng

- ca sử dụng

- đã sử dụng

- người sử dang

- sử dụng

- sử dụng

- bình thường

- nhiều

- Đường..

- we

- điểm yếu

- TỐT

- nổi tiếng

- là

- Điều gì

- Là gì

- cái nào

- giành chiến thắng

- với

- ở trong

- làm việc

- bạn

- trên màn hình

- zephyrnet