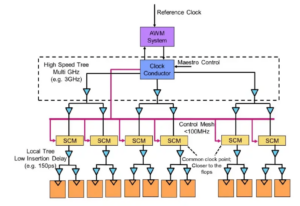

Експерти за столом: Semiconductor Engineering обговорили шляхи розвитку пам’яті у все більш гетерогенних системах із Френком Ферро, директором групи з управління продуктами в Каденція; Стівен Ву, колега та видатний винахідник Рамбус; Джонсін Юн, технолог пам'яті в Siemens EDA; Ренді Уайт, менеджер програми з рішень для пам’яті Кейсайт; і Френк Ширмайстер, віце-президент із рішень і розвитку бізнесу в Артеріда. Далі – уривки з цієї розмови. Першу частину цього обговорення можна знайти тут.

![[LR]: Френк Ферро, Cadence; Стівен Ву, Рамбус; Jongsin Yun, Siemens EDA; Ренді Вайт, Keysight; і Френк Ширмайстер, Артеріс.](https://platoaistream.com/wp-content/uploads/2024/01/rethinking-memory.png)

[LR]: Френк Ферро, Cadence; Стівен Ву, Рамбус; Jongsin Yun, Siemens EDA; Ренді Вайт, Keysight; і Френк Ширмайстер, Артеріс

SE: Оскільки ми боремося з AI/ML і вимогами до потужності, які конфігурації потрібно переглянути? Чи побачимо ми відхід від архітектури фон Неймана?

Ву: Що стосується системних архітектур, то в галузі відбувається роздвоєння. Традиційні програми, які є домінуючими робочими конячками, які ми запускаємо в хмарі на серверах на базі x86, не зникнуть. Існують десятиліття програмного забезпечення, яке створювалося та розвивалося, і яке покладатиметься на цю архітектуру, щоб працювати добре. Навпаки, AI/ML — це новий клас. Люди переосмислили архітектури та створили процесори, орієнтовані на певну область. Ми бачимо, що близько двох третин енергії витрачається просто на переміщення даних між процесором і пристроєм HBM, тоді як лише близько третини витрачається на фактичний доступ до бітів у ядрах DRAM. Переміщення даних тепер набагато складніше та дорожче. Ми не позбавляємося пам’яті. Нам це потрібно, тому що набори даних стають більшими. Тож виникає запитання: «Який правильний шлях уперед?» Було багато дискусій про стекування. Якщо ми візьмемо цю пам’ять і розмістимо її безпосередньо на процесорі, вона зробить для вас дві речі. По-перше, пропускна здатність сьогодні обмежена береговою зоною або периметром мікросхеми. Ось де йдуть вводи-виводи. Але якщо ви розмістите його безпосередньо на процесорі, тепер ви зможете використовувати всю площу чіпа для розподілених з’єднань, і ви зможете отримати більшу пропускну здатність у самій пам’яті, і вона може подаватись безпосередньо до процесор. Посилання стають набагато коротшими, а енергоефективність, ймовірно, зростає приблизно в 5-6 разів. По-друге, обсяг пропускної здатності, який ви можете отримати завдяки з’єднанню більшої площі масиву з пам’яттю, також зростає на кілька цілих факторів. Виконання цих двох речей разом може забезпечити більшу пропускну здатність і зробити його більш ефективним. Індустрія розвивається відповідно до будь-яких потреб, і це, безумовно, один із способів, як ми побачимо, як системи пам’яті почнуть розвиватися в майбутньому, щоб стати більш енергоефективними та забезпечити більшу пропускну здатність.

залізо: Коли я вперше почав працювати над HBM приблизно в 2016 році, деякі з більш досвідчених клієнтів запитали, чи можна це стекувати. Вони досить довго шукали, як розташувати DRAM зверху, оскільки є очевидні переваги. З фізичного рівня PHY стає практично незначним, що значно економить енергію та ефективність. Але тепер у вас є процесор із потужністю кілька 100 Вт, який має пам’ять поверх нього. Пам'ять не витримує жару. Ймовірно, це найслабша ланка теплового ланцюга, що створює ще одну проблему. Переваги є, але вони ще повинні зрозуміти, як боротися з терміками. Зараз є більше стимулів розвивати цей тип архітектури, оскільки він справді заощаджує вашу загальну продуктивність і потужність, а також підвищить ефективність обчислень. Але є деякі фізичні труднощі дизайну, які необхідно вирішити. Як казав Стів, ми бачимо всі види архітектур, які виходять. Я повністю згоден, що архітектури GPU/CPU нікуди не подінуться, вони все ще будуть домінуючими. У той же час кожна компанія на планеті намагається придумати кращу мишоловку для створення свого ШІ. Ми бачимо вбудовану SRAM і комбінацію пам’яті з високою пропускною здатністю. У ці дні LPDDR трохи підняв голову щодо того, як скористатися перевагами LPDDR у центрі обробки даних через потужність. Ми навіть бачили, як GDDR використовується в деяких додатках штучного інтелекту, а також у всіх старих системах пам’яті. Зараз вони намагаються вичавити якомога більше пам’яті DDR5. Я бачив будь-яку архітектуру, яку тільки можна придумати, будь то DDR, HBM, GDDR чи інші. Це залежить від ядра вашого процесора з точки зору вашої загальної доданої вартості, а потім, як ви можете пробитися через вашу конкретну архітектуру. Система пам’яті, яка йде разом із ним, тож ви можете створювати свій ЦП та архітектуру пам’яті залежно від того, що доступно.

Юн: Ще одна проблема – енергонезалежність. Наприклад, якщо штучному інтелекту доводиться мати справу з інтервалом живлення між запуском штучного інтелекту на основі IoT, тоді нам потрібно багато вимикань і вмикань, і вся ця інформація для навчання штучного інтелекту має обертатися знову і знову. Якщо у нас є якісь типи рішень, де ми можемо зберігати ці ваги в чіпі, щоб нам не довелося завжди рухатися туди-сюди для тієї самої ваги, тоді це буде значна економія електроенергії, особливо для ШІ на основі IoT. Буде інше рішення, щоб задовольнити ці потреби в електроенергії.

Ширмайстер: З точки зору NoC, я вважаю захоплюючим те, що вам потрібно оптимізувати ці шляхи від процесора, що проходить через NoC, доступу до інтерфейсу пам’яті з контролером, який потенційно проходить через UCIe, щоб передати чіплет іншому чіплету, який потім має пам’ять у це. Справа не в тому, що архітектури фон Неймана мертві. Але зараз існує так багато варіантів, залежно від робочого навантаження, яке ви хочете обчислити. Їх потрібно розглядати в контексті пам’яті, а пам’ять – це лише один аспект. Звідки ви отримуєте дані з локалізації даних, як вони організовані в цій DRAM? Ми працюємо над усіма цими речами, такими як аналіз продуктивності пам’яті, а потім оптимізація системної архітектури. Це стимулює багато інновацій для нових архітектур, про які я ніколи не думав, коли навчався в університеті про фон Неймана. На крайньому іншому кінці у вас є такі речі, як сітки. Зараз існує набагато більше архітектур, які слід розглядати, і це залежить від пропускної здатності пам’яті, обчислювальних можливостей тощо, що не зростає з однаковою швидкістю.

Білий: Існує тенденція до дезагрегованих обчислень або розподілених обчислень, що означає, що архітектор повинен мати більше інструментів у своєму розпорядженні. Ієрархія пам'яті розширилася. Включено семантику, а також CXL та різні гібридні пам’яті, які доступні для флеш-пам’яті та DRAM. Паралельний додаток до центру обробки даних – автомобільний. Автомобільна промисловість завжди обчислювала цей датчик із ECU (електронними блоками керування). Я в захопленні від того, як це еволюціонувало до центру обробки даних. Швидко вперед, і сьогодні ми маємо розподілені обчислювальні вузли, які називаються контролерами домену. Це те саме. Він намагається відповісти на те, що, можливо, потужність не є такою важливою проблемою, оскільки масштаби комп’ютерів не такі великі, але затримка, безумовно, є великою проблемою для автомобільної промисловості. ADAS потребує надвисокої пропускної здатності, і у вас є різні компроміси. Крім того, у вас є більше механічних датчиків, але подібні обмеження в центрі обробки даних. У вас є холодне сховище, яке не потребує низької затримки, а потім у вас є інші програми з високою пропускною здатністю. Захоплююче спостерігати, наскільки розвинулися інструменти та можливості для архітектора. Індустрія справді добре реагує, і всі ми пропонуємо різноманітні рішення, які надходять на ринок.

SE: Як розвивалися інструменти проектування пам’яті?

Ширмайстер: Коли я починав із перших своїх мікросхем у 90-х, найбільш використовуваним системним інструментом був Excel. З тих пір я завжди сподівався, що в один момент він може зламати для речей, які ми робимо на системному рівні, пам’яті, аналізі пропускної здатності тощо. Це дуже вплинуло на мої команди. На той час це була дуже просунута річ. Але на думку Ренді, тепер певні складні речі потрібно змоделювати з рівнем точності, який раніше був неможливий без обчислень. Наприклад, припущення певної затримки для доступу до DRAM може призвести до неправильних рішень щодо архітектури та потенційно неправильного проектування архітектур транспортування даних на мікросхемі. Зворотний бік теж вірний. Якщо ви завжди припускаєте найгірший випадок, ви перепроектуєте архітектуру. Наявність інструментів, які виконують аналіз DRAM та продуктивності, а також відповідні моделі, доступні для контролерів, дозволяють архітектору симулювати все це, це захоплююче середовище. Я сподіваюся з 90-х років, що Excel одного разу може зруйнуватися як інструмент системного рівня може справді стати реальністю, тому що деякі динамічні ефекти ви більше не можете виконувати в Excel, тому що вам потрібно їх симулювати — особливо коли ви додаєте інтерфейс die-to-die із характеристиками PHY, а потім рівень зв’язку такі характеристики, як усі перевірки, чи все було правильно, і потенційне повторне надсилання даних. Відсутність цих симуляцій призведе до неоптимальної архітектури.

залізо: Перший крок у більшості оцінок, які ми робимо, — це надати їм тестовий стенд пам’яті, щоб почати дивитися на ефективність DRAM. Це величезний крок, навіть робити такі прості речі, як запуск локальних інструментів для моделювання DRAM, а потім переходити до повномасштабного моделювання. Ми бачимо, що більше клієнтів запитують такий тип моделювання. Дуже важливим першим кроком у будь-якій оцінці є переконання, що ефективність вашої DRAM досягає 90-х.

Ву: Зростання повноцінних інструментів симуляції системи пояснюється тим, що DRAM стали набагато складнішими. Зараз дуже важко бути навіть у плані для деяких із цих складних робочих навантажень, використовуючи такі прості інструменти, як Excel. Якщо ви подивитеся на таблицю даних для DRAM у 90-х роках, ці таблиці даних складаються з 40 сторінок. Тепер це сотні сторінок. Це лише говорить про складність пристрою для отримання високої пропускної здатності. Ви поєднуєте це з тим фактом, що пам’ять є таким драйвером вартості системи, а також пропускної здатності та затримки, пов’язаних із продуктивністю процесора. Це також великий рушійний фактор у потужності, тому вам потрібно симулювати на більш детальному рівні. З точки зору потоку інструментів, системні архітектори розуміють, що пам'ять є величезним драйвером. Отже, інструменти мають бути складнішими та добре взаємодіяти з іншими інструментами, щоб системний архітектор мав найкраще загальне уявлення про те, що відбувається — особливо про те, як пам’ять впливає на систему.

Юн: Коли ми рухаємось до епохи ШІ, використовується багато багатоядерних систем, але ми не знаємо, які дані куди йдуть. Він також йде більш паралельно чіпу. Обсяг пам'яті значно більший. Якщо ми використовуємо штучний інтелект типу ChatGPT, то для обробки даних для моделей потрібно близько 350 МБ даних, що є величезною кількістю даних лише для ваги, а фактичний вхід/вихід набагато більший. Це збільшення обсягу необхідних даних означає, що є багато ймовірнісних ефектів, яких ми раніше не бачили. Це надзвичайно складний тест, щоб побачити всі помилки, пов’язані з таким великим об’ємом пам’яті. І ECC використовується всюди, навіть у SRAM, яка традиційно не використовувала ECC, але зараз це дуже поширене явище для найбільших систем. Тестування всього цього є дуже складним і потребує підтримки рішень EDA, щоб перевірити всі ці різні умови.

SE: З якими викликами стикаються команди інженерів щодня?

Білий: У будь-який день ви знайдете мене в лабораторії. Закочую рукави, а руки брудні, тицяю дроти, паяю і ще таке. Я багато думаю про пост-силіконову перевірку. Ми говорили про раннє моделювання та інструменти на матриці — BiST тощо. Зрештою, перед відправкою ми хочемо провести певну перевірку системи або тести на рівні пристрою. Ми говорили про те, як подолати стіну пам'яті. Ми розміщуємо пам’ять, HBM тощо. Якщо ми подивимося на еволюцію технологій пакування, ми почали з етилованих упаковок. Вони були не дуже хороші для цілісності сигналу. Десятиліттями пізніше ми перейшли до оптимізованої цілісності сигналу, як-от масиви кулькових сіток (BGA). Ми не могли отримати до нього доступ, а це означало, що ви не могли його перевірити. Тож ми придумали цю концепцію під назвою пристрій проміжного пристрою — проміжний пристрій BGA — і це дозволило нам створити сендвіч із спеціальним пристосуванням, яке направляло сигнали. Тоді ми могли підключити його до тестового обладнання. Перемотайте вперед до сьогоднішнього дня, і тепер у нас є HBM і мікросхеми. Як розмістити мій світильник між силіконовим інтерпозером? Ми не можемо, і це боротьба. Це виклик, який не дає мені спати ночами. Як ми виконуємо аналіз несправностей у польових умовах із замовником OEM або системою, де вони не досягають 90% ефективності. У посиланні є інші помилки, їх не вдається правильно ініціалізувати, а навчання не працює. Це проблема цілісності системи?

Ширмайстер: Хіба ви не віддасте перевагу робити це з дому за допомогою віртуального інтерфейсу, ніж пішки до лабораторії? Хіба відповідь не більше аналітики, яку ви вбудовуєте в чіп? З мікросхемами ми ще більше інтегруємо все. Доставити туди свій паяльник насправді неможливо, тому потрібен спосіб для аналізу на чіпі. У нас така ж проблема для NoC. Люди дивляться на NoC, а ви надсилаєте дані, а потім вони зникають. Нам потрібна аналітика, щоб люди могли виконувати налагодження, і це поширюється на рівень виробництва, щоб ви нарешті могли працювати вдома і робити все це на основі аналітики мікросхем.

залізо: Особливо з високою пропускною здатністю пам’яті, ви не можете фізично потрапити туди. Коли ми ліцензуємо PHY, у нас також є продукт, який поєднується з цим, тож ви можете поглянути на кожен із цих 1,024 бітів. Ви можете почати зчитувати та записувати DRAM з інструменту, тому вам не доведеться фізично заходити туди. Мені подобається ідея інтерпозиції. Під час тестування ми видаляємо деякі контакти з інтерпозера, чого ви не можете зробити в системі. Потрапити в ці 3D-системи справді складно. Навіть з точки зору потоку інструментів проектування, схоже, що більшість компаній роблять свій власний індивідуальний потік для багатьох із цих 2.5D інструментів. Ми починаємо розробляти більш стандартизований спосіб побудови 2.5D системи, починаючи з цілісності сигналу, потужності та всього потоку.

Білий: Сподіваюся, що все буде розвиватися, ми все ще зможемо зберегти той самий рівень точності. Я належу до групи відповідності форм-фактору UCIe. Я шукаю, як охарактеризувати завідомо хороший кубик, золотий кубик. Згодом це займе набагато більше часу, але ми знайдемо оптимальне співвідношення між продуктивністю й точністю тестування, які нам потрібні, і вбудованою гнучкістю.

Ширмайстер: Якщо я розглядаю чіплети та їх впровадження у більш відкритому виробничому середовищі, тестування є однією з найбільших проблем у тому, щоб змусити його працювати правильно. Якщо я велика компанія, і я контролюю всі її сторони, я можу обмежити речі належним чином, щоб тестування тощо стало можливим. Якщо я хочу перейти до гасла UCIe, згідно з яким UCI лише одна буква від PCI, і я уявляю майбутнє, де збірка UCIe стане, з точки зору виробництва, подібною до слотів PCI у ПК сьогодні, тоді аспекти тестування для цього дійсно виклик. Нам потрібно знайти рішення. Є багато роботи.

Статті по темі

Майбутнє пам'яті (Частина 1 вище округленої)

Від спроб вирішити проблеми тепла та живлення до ролей CXL та UCIe, майбутнє містить ряд можливостей для пам’яті.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://semiengineering.com/rethinking-memory/

- : має

- :є

- : ні

- :де

- $UP

- 1

- 2016

- 3d

- 40

- a

- МЕНЮ

- вище

- доступ

- доступ до

- точність

- фактичний

- насправді

- ADAs

- додавати

- адреса

- Прийняття

- просунутий

- Перевага

- Переваги

- знову

- AI

- Навчання AI

- AI / ML

- ВСІ

- дозволено

- дозволяє

- Також

- завжди

- кількість

- an

- аналіз

- аналітика

- та

- Інший

- відповідь

- будь-який

- більше

- де-небудь

- додаток

- застосування

- відповідним чином

- архітектори

- архітектура

- ЕСТЬ

- ПЛОЩА

- навколо

- влаштований

- масив

- AS

- запитувач

- зовнішній вигляд

- аспекти

- збірка

- припустити

- At

- Спроби

- автомобільний

- доступний

- геть

- назад

- поганий

- м'яч

- ширина смуги

- бар

- заснований

- В основному

- основа

- BE

- оскільки

- ставати

- стає

- було

- перед тим

- буття

- Переваги

- КРАЩЕ

- Краще

- між

- Великий

- більший

- Біт

- Перерва

- приносити

- будувати

- побудований

- бізнес

- розвиток бізнесу

- але

- by

- Каденція

- званий

- прийшов

- CAN

- Може отримати

- можливості

- випадок

- Центр

- певний

- звичайно

- ланцюг

- виклик

- проблеми

- складні

- характеристика

- охарактеризувати

- контроль

- чіп

- Чіпси

- клас

- ясно

- хмара

- холодний

- зберігання в холодильнику

- комбінації

- Приходити

- майбутній

- загальний

- Компанії

- компанія

- комплекс

- складність

- дотримання

- складний

- обчислення

- комп'ютери

- обчислення

- концепція

- Умови

- З'єднуватися

- вважається

- обмеження

- контекст

- контрастність

- контроль

- контролер

- Розмова

- Core

- виправити

- Коштувати

- може

- Пара

- центральний процесор

- створює

- клієнт

- Клієнти

- дані

- Центр обробки даних

- набори даних

- день

- з дня на день

- Днів

- мертвий

- угода

- десятиліття

- рішення

- безумовно

- запити

- Залежно

- залежить

- дизайн

- проектування

- докладно

- розробка

- пристрій

- Померти

- різний

- важкий

- безпосередньо

- Директор

- обговорення

- розпорядження

- Видатний

- розподілений

- розподілені обчислення

- do

- робить

- Ні

- справи

- домен

- домінуючий

- зроблений

- Не знаю

- вниз

- керований

- водій

- під час

- динамічний

- Рано

- ефекти

- ефективність

- ефективний

- Electronic

- кінець

- енергія

- Машинобудування

- Весь

- Навколишнє середовище

- обладнання

- Епоха

- помилки

- особливо

- Ефір (ETH)

- оцінка

- оцінки

- Навіть

- врешті-решт

- Кожен

- все

- скрізь

- еволюція

- еволюціонувати

- еволюціонували

- еволюціонує

- приклад

- перевершувати

- розширений

- дорогий

- продовжується

- екстремальний

- надзвичайно

- очі

- Face

- факт

- фактор

- Провал

- захоплюючий

- ШВИДКО

- реально

- fellow

- вірність

- поле

- Рисунок

- в кінці кінців

- знайти

- Перший

- спалах

- Гнучкість

- Flip

- потік

- слідує

- Слід

- для

- форма

- вперед

- Вперед

- знайдений

- відвертий

- від

- Повний

- далі

- майбутнє

- отримати

- отримання

- Давати

- даний

- Глобальний

- Go

- йде

- буде

- Золотий

- пішов

- добре

- хороша робота

- є

- сітка

- Group

- Зростання

- було

- Обробка

- Руки

- щасливий

- Мати

- має

- голова

- допомога

- ієрархія

- Високий

- тримає

- Головна

- надія

- Як

- How To

- HTML

- HTTPS

- величезний

- Сотні

- гібрид

- i

- ідея

- if

- картина

- вплив

- впливає

- важливо

- удосконалювати

- in

- Стимул

- включені

- невірно

- Augmenter

- все більше і більше

- індивідуальний

- промисловість

- інформація

- інновація

- всередині

- інтегрувати

- цілісність

- взаємозв'язки

- інтерфейс

- в

- за участю

- питання

- питання

- IT

- ЙОГО

- сам

- робота

- просто

- Знати

- відомий

- lab

- великий

- більше

- найбільших

- Затримка

- пізніше

- шар

- вести

- вивчення

- лист

- рівень

- ліцензія

- як

- обмеженою

- LINK

- зв'язку

- місцевий

- подивитися

- шукати

- серія

- багато

- низький

- підтримувати

- зробити

- Робить

- управління

- менеджер

- виробництво

- багато

- ринок

- макс-ширина

- може бути

- me

- засоби

- означав

- механічний

- середа

- пам'яті

- пам'ять

- може бути

- Моделі

- більше

- найбільш

- рухатися

- переїхав

- руху

- переміщення

- багато

- my

- Необхідність

- потреби

- ніколи

- Нові

- ніч

- вузли

- зараз

- номер

- of

- від

- Старий

- on

- ONE

- тільки

- відкрити

- Можливості

- Оптимізувати

- оптимізований

- оптимізуючий

- варіант

- Опції

- or

- порядок

- Інше

- інші

- з

- загальний

- Подолати

- власний

- пакети

- упаковка

- сторінок

- Паралельні

- частина

- приватність

- проходити

- шлях

- стежки

- PC

- Люди

- виконувати

- продуктивність

- перспектива

- фізичний

- Фізично

- сосна

- планета

- plato

- Інформація про дані Платона

- PlatoData

- точка

- це можливо

- потенційно

- влада

- президент

- раніше

- ймовірно

- Проблема

- процесор

- процесори

- Product

- Управління продуктом

- Production

- програма

- правильний

- правильно

- забезпечувати

- put

- питання

- досить

- залучення

- ставка

- швидше

- читання

- насправді

- пов'язаний

- покладатися

- вимагається

- Вимагається

- рішення

- відповідаючи

- результат

- позбавитися

- право

- Зростання

- ролі

- Котити

- прогін

- біг

- то ж

- зберегти

- Економія

- приказка

- шкала

- другий

- побачити

- бачачи

- Здається,

- бачив

- семантика

- напівпровідник

- послати

- датчик

- датчиків

- сервери

- кілька

- Листи

- зсув

- судно

- сторона

- Сторони

- Сіменс

- Сигнал

- сигнали

- Кремній

- аналогічний

- простий

- моделювання

- моделювання

- з

- один

- Розмір

- ігрові автомати

- So

- Софтвер

- рішення

- Рішення

- деякі

- складний

- Говорить

- спеціальний

- відпрацьований

- Вичавлювати

- стек

- укладені

- укладання

- нормований

- точки зору

- старт

- почалася

- Починаючи

- Крок

- Стів

- Стівен

- Як і раніше

- зберігання

- зберігати

- боротьба

- такі

- Підтриманий

- Переконайтеся

- система

- Systems

- таблиця

- Приймати

- балаканина

- команди

- технолог

- Технологія

- terms

- тест

- Тестування

- Тести

- ніж

- Що

- Команда

- Майбутнє

- їх

- Їх

- потім

- Там.

- теплової

- Ці

- вони

- річ

- речі

- думати

- третій

- це

- ті

- думка

- через

- час

- до

- сьогодні

- разом

- інструмент

- інструменти

- топ

- ТОТАЛЬНО

- компроміси

- традиційний

- традиційно

- Навчання

- перевезення

- Trend

- правда

- намагається

- два

- дві третини

- тип

- розуміти

- одиниць

- університет

- us

- використання

- використовуваний

- використання

- перевірка достовірності

- значення

- варіації

- різний

- дуже

- віце

- Віцепрезидент

- вид

- Віртуальний

- з

- ходьба

- Стіна

- хотіти

- було

- шлях..

- we

- вага

- ДОБРЕ

- були

- Що

- будь

- коли

- Чи

- який

- в той час як

- білий

- всі

- чому

- волі

- з

- без

- свататися

- Work

- працювати вдома

- робочий

- найгірше

- лист

- ви

- вашу

- зефірнет