Методи скінченних елементів для аналізу виникають у багатьох сферах проектування електронних систем: аналіз механічної напруги в системах із кількома матрицями, термічний аналіз як аналог охолодження та аналізу напруги (наприклад, викривлення) та аналіз електромагнітної відповідності. (Обчислювальна динаміка рідини – CFD – це інший звір, про який я міг би розповісти в окремому блозі.) Я висвітлював теми в цій галузі з іншим клієнтом і продовжує знаходити область привабливою, оскільки вона резонує з моїм досвідом фізики та моїм внутрішнім математиком. (розв’язування диференціальних рівнянь). Тут я досліджую a недавній документ від Siemens AG спільно з Технічними університетами Мюнхена та Брауншвейга.

Постановка проблеми

Методи скінченних елементів — це методи чисельного розв’язування систем 2D/3D рівнянь із частковими похідними (PDE), які виникають у багатьох фізичних аналізах. Вони можуть поширюватися від того, як тепло розповсюджується в складному SoC, до електромагнітного аналізу для автомобільних радарів, до того, як механічна конструкція згинається під навантаженням, до того, як передня частина автомобіля м’ється під час аварії.

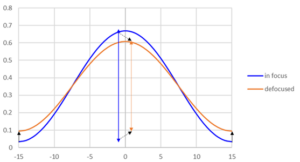

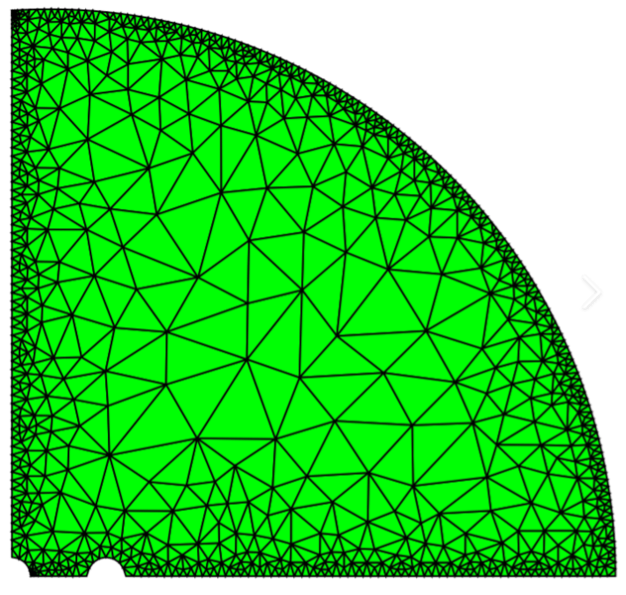

Для FEM сітка будується у фізичному просторі як дискретна структура для аналізу, більш дрібнозерниста навколо кордонів і особливо швидко змінних граничних умов, і більш грубозерниста в інших місцях. Пропускаючи криваві деталі, метод оптимізує лінійні суперпозиції простих функцій по всій сітці, змінюючи коефіцієнти в суперпозиції. Оптимізація має на меті знайти найкращу відповідність у межах деякого прийнятного допуску, що відповідає дискретним проксі для PDE разом із початковими умовами та граничними умовами за допомогою лінійної алгебри та інших методів.

Зазвичай для досягнення прийнятної точності потрібні дуже великі сітки, що призводить до дуже тривалого часу виконання рішень методу кінцевих елементів для реалістичних задач, що стає ще більш обтяжливим під час виконання кількох аналізів для вивчення можливостей оптимізації. Кожен запуск по суті починається з нуля без використання важелів навчання між запусками, що передбачає можливість використовувати методи ML для прискорення аналізу.

Способи використання ML з FEM

Широко використовуваним підходом для прискорення FEM-аналізу (FEA) є створення сурогатних моделей. Це як абстрактні моделі в інших областях – спрощені версії повної складності вихідної моделі. Експерти FEA говорять про моделі скороченого порядку (ROM), які продовжують демонструвати хороше наближення (дискретизованої) фізичної поведінки вихідної моделі, але обходять необхідність запускати FEA, принаймні на етапі оптимізації дизайну, хоча працюють набагато швидше, ніж FEA .

Один із способів створити сурогат — це почати з купи FEA, використовуючи цю інформацію як навчальну базу даних для створення сурогату. Однак це все ще вимагає тривалого аналізу для створення навчальних наборів вхідних і вихідних даних. Автори також вказують на ще один недолік такого підходу. ML не має рідного розуміння фізичних обмежень, важливих для всіх таких програм, і тому схильний до галюцинацій, якщо йому представити сценарій за межами його навчального набору.

І навпаки, заміна FEM на a фізично інформована нейронна мережа (PINN) включає фізичні PDE в обчислення функції втрат, по суті вводячи фізичні обмеження в оптимізацію на основі градієнта. Це розумна ідея, хоча подальші дослідження показали, що хоча метод працює на простих проблемах, він руйнується за наявності високочастотних і багатомасштабних функцій. Також розчаровує те, що час навчання для таких методів може бути довшим, ніж час виконання FEA.

У цьому документі пропонується інтригуюча альтернатива для більш тісного поєднання FEA та навчання ML, щоб функції втрат ML тренувалися на обчисленнях помилок FEA під час встановлення пробних рішень по сітці. Існує певна схожість із підходом PINN, але з важливою відмінністю: ця нейронна мережа працює разом із FEA, щоб прискорити конвергенцію до рішення під час навчання. Що, очевидно, призводить до швидшого навчання. У висновках модель нейронної мережі працює без необхідності FEA. За побудовою, модель, навчена таким чином, повинна точно відповідати фізичним обмеженням реальної проблеми, оскільки вона була навчена дуже тісно проти фізично обізнаного вирішувача.

Я думаю, що моє тлумачення тут досить точне. Я вітаю виправлення від експертів!

Поділитися цим дописом через:

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://semiwiki.com/artificial-intelligence/341034-blending-finite-element-methods-and-ml/

- : має

- :є

- $UP

- a

- МЕНЮ

- РЕЗЮМЕ

- прискорювати

- прийнятний

- точність

- точний

- через

- AG

- проти

- Цілі

- ВСІ

- Також

- альтернатива

- an

- аналізи

- аналіз

- та

- Інший

- застосування

- підхід

- ЕСТЬ

- ПЛОЩА

- що виникають

- навколо

- AS

- At

- привабливий

- authors

- автомобільний

- знати

- фон

- BE

- оскільки

- становлення

- було

- поведінка

- КРАЩЕ

- між

- змішування

- Блог

- обидва

- Межі

- ламається

- будувати

- гроно

- але

- by

- обходити

- CAN

- автомобіль

- CFD

- клієнт

- тісно

- об'єднувати

- зазвичай

- комплекс

- складність

- дотримання

- обчислювальна

- Умови

- послідовний

- обмеження

- побудований

- будівництво

- продовжувати

- Зближення

- Виправлення

- копія

- обкладинка

- покритий

- Крах

- урожай

- Database

- дизайн

- деталі

- різниця

- різний

- розчаровує

- домен

- домени

- вниз

- динаміка

- кожен

- Electronic

- елемент

- в іншому місці

- рівняння

- помилка

- особливо

- сутність

- по суті

- Навіть

- проявляти

- experts

- дослідити

- продовжити

- достатньо

- швидше

- риси

- знайти

- відповідати

- пристосування

- рідина

- Динаміка рідини

- для

- Рамки

- частота

- від

- перед

- Повний

- функція

- Функції

- Майстер

- породжувати

- добре

- Мати

- тут

- Високий

- Як

- Однак

- HTTPS

- i

- ідея

- if

- важливо

- in

- В інших

- об'єднує

- інформація

- повідомив

- початковий

- внутрішній

- витрати

- інтерпретація

- в

- інтригуючий

- введення

- IT

- ЙОГО

- великий

- провідний

- вивчення

- найменш

- Важіль

- як

- Довго

- довше

- від

- багато

- математики

- макс-ширина

- механічний

- Зустрічатися

- сітці

- метод

- методика

- може бути

- хвилин

- ML

- модель

- Моделі

- більше

- багато

- множинний

- Мюнхен

- my

- рідний

- Необхідність

- необхідний

- мережу

- Нейронний

- немає

- of

- on

- Можливість

- оптимізація

- Оптимізує

- порядок

- оригінал

- Інше

- з

- виходи

- поза

- Папір

- фаза

- фізичний

- Фізично

- Фізика

- plato

- Інформація про дані Платона

- PlatoData

- точка

- можливостей

- пошта

- наявність

- представлений

- Проблема

- проблеми

- проксі

- радар

- швидко

- реальний

- реалістичний

- Знижений

- Вимагається

- дослідження

- резонує

- результати

- прогін

- біг

- пробіжки

- сценарій

- подряпати

- окремий

- комплект

- набори

- Повинен

- показаний

- Сіменс

- простий

- спрощений

- з

- So

- рішення

- Рішення

- ВИРІШИТИ

- Розв’язування

- деякі

- Source

- Простір

- старт

- починається

- Як і раніше

- стрес

- структура

- наступні

- такі

- Запропонує

- суперпозиція

- система

- Systems

- балаканина

- технічний

- методи

- ніж

- Що

- Команда

- Джерело

- Там.

- отже

- теплової

- Ці

- думати

- це

- хоча?

- через

- час

- times

- до

- разом

- терпимість

- теми

- поїзд

- навчений

- Навчання

- суд

- при

- розуміння

- університети

- використання

- використовуваний

- використання

- різний

- версії

- дуже

- через

- шлях..

- слабкість

- ласкаво просимо

- коли

- який

- в той час як

- широко

- з

- в

- без

- працює

- б

- зефірнет