I dag er det World Backup Day, vår årlige påminnelse om viktigheten av å være nøye med å sikkerhetskopiere data for å forhindre tap av data. Men faktum er at hastigheten med hvilken datanivåer eksploderer i størrelse er langt høyere enn hva eldre sikkerhetskopieringssystemer kan oppnå. Måten vi har gjort backup på de siste 20 årene er ødelagt, spesielt i stor skala. Ettersom datamengden fortsetter å øke – både i antall filer og mengden data som genereres – er sikkerhetskopieringssystemer som skanner filsystemer ikke lenger gjennomførbare, spesielt når vi går inn i riket med milliarder av filer og petabyte eller mer data.

IDCs Global DataSphere, som anslår mengden data som vil bli opprettet årlig, spår at data vil vokse med en sammensatt årlig vekstrate (CAGR) på 21.2 % for å nå mer enn 221,000 1,000 exabyte (en exabyte er 2026 XNUMX petabyte) innen XNUMX.

Å holde store datasett sikre og robuste er en betydelig utfordring for organisasjoner, og tradisjonelle sikkerhetskopieringsløsninger er ikke utstyrt for å møte denne utfordringen. I tillegg blir bedrifter stadig mer sårbare for korrupsjon, skadelig programvare, utilsiktet sletting av filer og mer etter hvert som dataene vokser. Å miste viktige data kan være ødeleggende og føre til økonomiske tap, personlige og forretningsmessige forstyrrelser, eller til og med juridiske problemer.

Andre konsekvenser kan omfatte omdømmeskader og kostnadene ved å implementere nye sikkerhetstiltak. Ransomware vil koste sine ofre nær $ 265 milliarder årlig innen 2031, med et nytt angrep på en forbruker eller bedrift hvert annet sekund, ettersom ransomware-gjerningsmenn aggressivt foredler skadelig programvare og relaterte utpressingsaktiviteter.

Eldre datasikkerhetskopiering er ikke lenger mulig

Tradisjonell sikkerhetskopiering fungerer ved å skanne et filsystem for å finne og lage kopier av nye og endrede filer. Skanning tar imidlertid lengre tid ettersom antall filer vokser – så mye at det blir umulig å fullføre skanninger innen en rimelig tidsramme. De kjører vanligvis om natten når systemene sannsynligvis er mindre flyktige.

I tillegg er sikkerhetskopier satt til å kjøre i intervaller, noe som betyr at enhver endring før neste skanning vil gå tapt hvis det oppstår en systemfeil. Tradisjonell sikkerhetskopiering oppfyller ikke målet om null datatap, og gjenoppretting av data i petabyte-store depoter er tidkrevende. Og gjenopprettingsprosessen er ikke hva den burde være – den er kjedelig og sakte.

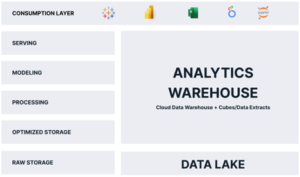

Selv "inkrementell for alltid med syntetiske fulle sikkerhetskopier" kan kanskje ikke behandle endrede data innenfor det nødvendige sikkerhetskopieringsvinduet. Selv om skyen nå ofte brukes til sikkerhetskopiering av data, er tilnærmingen med å overføre petabyte med data til skyen og lagre disse dataene i skyen verken praktisk eller kostnadseffektiv, melder IDC.

Å oppnå dataresiliens i stor skala er stadig viktigere i dagens data-drevet verden. Organisasjoner må gå sømløst tilbake, redusere risikoen for tap av data og minimere virkningen av nedetid, strømbrudd, datainnbrudd og naturkatastrofer. For altfor lenge har bedriftsledere måttet akseptere et nivå av datatap, som definert av gjenopprettingspunktmål (RPO), og noe nedetid, som definert av gjenopprettingstidsmål (RTO).

En radikal ny tilnærming: Skift fokus fra vellykkede sikkerhetskopier til vellykkede gjenopprettinger

Mange av de generelle konseptene og praksisene for databeskyttelse, og sikkerhetskopiering og gjenoppretting spesielt, har ikke endret seg siden de ble utviklet i klient/server-tiden. Men med betydelige teknologiske fremskritt og den konstante bølgen av cyberangrep som fungerer som en katalysator, er sikkerhetskopieringshorisonten i ferd med å endre seg. Tradisjonell sikkerhetskopiering er utformet for å være uavhengig av filsystemet som en separat enhet. En ny tilnærming gjør filsystemet og sikkerhetskopien til det samme – sikkerhetskopien ligger inne i databanen. Som et resultat blir hver endring i filsystemet registrert mens den skjer, sluttbrukere kan gjenopprette tapte data uten hjelp fra IT, og det er enkelt å finne filer, uavhengig av når de kan ha eksistert, og over hele tidskontinuumet.

Denne modellen vil redefinere bedriftslagring ved å konvergere lagring og datamotstand i ett system slik at hver endring i databanen blir fanget opp. Det øker datamotstandskraften og gir en sterk førstelinje i forsvar mot cyberlåsing med løsepengeprogramvare, noe som gjør det mulig for organisasjoner å gjenopprette kompromitterte data enkelt og raskt. Brukere eller IT-administratorer kan bokstavelig talt gå tilbake til et hvilket som helst tidspunkt for å gjenopprette nødvendige filer – selv i tilfelle et nettangrep der filer er kryptert.

Tenk på hvordan du kan behandle et hus på fjellet og beskytte det mot brann. Du kan ta forholdsregler som å fjerne trær rundt huset, sikre brannskiller, rense tak og takrenner for døde løv og andre forebyggende tiltak. Eller du kan passivt ikke gjøre noe og bare vente på at huset brenner ned, i håp om at forsikringen er tilstrekkelig til å dekke tapet. Den første tilnærmingen er proaktiv – unngå katastrofen i utgangspunktet. Den andre er reaktiv – en dårlig ting skjedde, og nå vil vi bruke mye tid, krefter og penger og håper vi kan komme oss tilbake til der vi var før arrangementet.

Dette eksemplet illustrerer forskjellen mellom gjenoppretting fra en tilstand av kontinuitet (kontinuerlig datatilgjengelighet) og diskontinuitet (en katastrofe som inntreffer). En proaktiv strategi utnytter kontinuerlig integrert datatilgang, eliminerer kostnadene og forretningseffekten av tapte data, og gir mulighet for følgende fordeler:

- Muligheten til å rulle tilbake løsepengevare-angrep og gi den første forsvarslinjen mot bedriftstap og sterk beskyttelse mot kriminelle som holder en virksomhet og dens data som gisler i løpet av på det meste minutter i stedet for dager, uker eller mer.

- Kontinuerlig databeskyttelse gjør det mulig å oppnå kontinuitet i tjenesten i stor skala med muligheten til å umiddelbart slappe av filsystemet slik at det fremstår slik det var på det valgte tidspunktet før datakorrupsjonen, maskinvarefeilen eller ondsinnet hendelse. Den leverer datasikkerhet og robusthet i stor skala med ekstremt rask datagjenoppretting og null datatap oppnådd ved å forene filsystemet og datastoff.

- Fremskyndet datagjenoppretting gjør det mulig for brukere å interaktivt finne og gjenopprette det de trenger – en "gjør-det-selv" datasøk og gjenopprettingsprosess som eliminerer behovet for IT-intervensjon.

Kontinuerlig datatilgjengelighet fokuserer på gjenoppretting i stedet for sikkerhetskopiering. Den hjelper organisasjoner med å utnytte monumentale mengder data for robusthet og overvinne hindringene for eldre sikkerhetskopiering som blir stadig mer foreldet. Ikke bli holdt som gissel for en backup-tilnærming som er flere tiår gammel, i håp om at en katastrofe ikke vil skje. Vedta en proaktiv strategi som er avhengig av kontinuerlig integrert datatilgang for å eliminere kostnadene og forretningseffekten av tapte data og risikoen for cybertrusler.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://www.dataversity.net/dont-be-held-hostage-by-legacy-data-backup/

- :er

- $OPP

- 000

- 1

- 2%

- 20 år

- a

- evne

- I stand

- Om oss

- Aksepterer

- adgang

- oppnådd

- Oppnå

- tvers

- Handling

- Aktiviteter

- tillegg

- fremskritt

- mot

- tillater

- Selv

- beløp

- beløp

- og

- årlig

- Årlig

- vises

- tilnærming

- ER

- rundt

- AS

- Assistanse

- bistår

- At

- angripe

- Angrep

- tilgjengelighet

- tilbake

- backing

- Backup

- sikkerhetskopier

- dårlig

- BE

- bli

- bli

- før du

- være

- Fordeler

- mellom

- milliarder

- brudd

- pauser

- Brutt

- brenne

- virksomhet

- Forretningsmessig påvirkning

- by

- CAGR

- CAN

- Catalyst

- utfordre

- endring

- Rengjøring

- Lukke

- Cloud

- vanligvis

- Selskaper

- fullføre

- Compound

- kompromittert

- konsepter

- Konsekvenser

- konstant

- forbruker

- fortsetter

- kontinuerlig

- Kontinuum

- konvergerende

- kopier

- Bedriftens

- Korrupsjon

- Kostnad

- kostnadseffektiv

- kunne

- skape

- opprettet

- kriminelle

- kritisk

- cyber

- Cyber Attacks

- Cyber angrep

- dato

- data tilgang

- Databrudd

- Data Loss

- databeskyttelse

- datasikkerhet

- datasett

- DATAVERSITET

- dag

- Dager

- død

- tiår

- Forsvar

- definert

- leverer

- designet

- ødeleggende

- utviklet

- forskjell

- katastrofe

- katastrofer

- forstyrrelser

- ikke

- ned

- nedetid

- lett

- innsats

- eliminere

- eliminerer

- eliminere

- muliggjør

- muliggjør

- kryptert

- sikrer

- Enter

- Enterprise

- Hele

- enhet

- utstyrt

- Era

- spesielt

- Selv

- Event

- Hver

- eksempel

- omfattende

- utpressing

- ekstremt

- Failure

- FAST

- gjennomførbart

- filet

- Filer

- finansiell

- Finn

- finne

- Brann

- Først

- Fokus

- fokuserer

- etter

- Til

- for alltid

- RAMME

- fersk

- fra

- fullt

- Dess

- general

- generert

- Global

- Go

- Grow

- Vokser

- Vekst

- skje

- skjedde

- skjer

- maskinvare

- Utnyttelse

- Ha

- Held

- holder

- håp

- håper

- horisont

- hus

- Hvordan

- Men

- HTTPS

- Påvirkning

- implementere

- betydning

- viktig

- umulig

- in

- inkludere

- Øke

- øker

- stadig

- uavhengig

- forsikring

- intervensjon

- saker

- IT

- DET ER

- jpg

- storskala

- ledere

- Legacy

- Lovlig

- Juridiske problemer

- Nivå

- nivåer

- utnytter

- i likhet med

- Sannsynlig

- linje

- Lang

- lenger

- å miste

- tap

- tap

- Lot

- GJØR AT

- malware

- midler

- målinger

- Møt

- kunne

- minutter

- penger

- monumental

- mer

- mest

- Naturlig

- nødvendig

- Trenger

- nødvendig

- Ingen

- Ny

- neste

- natt

- Antall

- Målet

- mål

- foreldet

- hindringer

- of

- Gammel

- on

- ONE

- organisasjoner

- Annen

- brudd

- Spesielt

- spesielt

- Past

- banen

- personlig

- Sted

- plato

- Platon Data Intelligence

- PlatonData

- Point

- mulig

- Praktisk

- praksis

- spår

- forebygge

- Proaktiv

- prosess

- beskytte

- beskyttelse

- gi

- gir

- radikal

- ransomware

- Ransomware-angrep

- Sats

- heller

- å nå

- rimelig

- registrert

- Gjenopprette

- utvinne

- utvinning

- redusere

- avgrense

- Uansett

- i slekt

- fjerne

- resiliens

- spenstig

- resultere

- Risiko

- Rull

- Kjør

- samme

- Skala

- skanne

- skanning

- sømløst

- Søk

- Sekund

- sekunder

- sikre

- sikkerhet

- valgt

- tjeneste

- sett

- sett

- SKIFTENDE

- bør

- signifikant

- siden

- Størrelse

- langsom

- So

- Solutions

- noen

- bruke

- vår

- Tilstand

- lagring

- Strategi

- streik

- sterk

- vellykket

- bølge

- syntetisk

- system

- Systemer

- Ta

- tar

- Teknologi

- Det

- De

- deres

- ting

- trusler

- tid

- til

- også

- tradisjonelle

- Overføre

- behandle

- Trær

- koble av

- Brukere

- vanligvis

- ofre

- volatile

- Sårbar

- vente

- Vei..

- uker

- Hva

- hvilken

- vil

- med

- innenfor

- uten

- virker

- verden

- år

- zephyrnet

- null