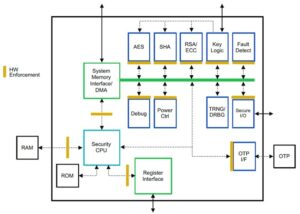

Suresh is a technology executive with deep technical expertise in semiconductors, artificial intelligence, cybersecurity, internet-of-things, hardware, software, etc. He spent 20 years in the industry, most recently serving as an Executive Director for open-source zero-trust chip development at Technology Innovation Institute, Abu Dhabi, and in other Fortune 500 semiconductor companies such as Intel, Qualcomm, and MediaTek in various leadership roles, where he researched and developed high-performant, energy-efficient, post-quantum secure, safe microchips/ system-on-chips (SoCs)/ accelerators for the Datacenter, Client, Smartphone, Networking, IoT, and AI/ML markets. He contributed to the Falcon LLM (ranked #1 in huggingface) and was the lead architect for the custom AI hardware platform (canceled – priorities changed). He holds 15+ US Patents and has published/presented at more than 20+ conferences.

Suresh is a technology executive with deep technical expertise in semiconductors, artificial intelligence, cybersecurity, internet-of-things, hardware, software, etc. He spent 20 years in the industry, most recently serving as an Executive Director for open-source zero-trust chip development at Technology Innovation Institute, Abu Dhabi, and in other Fortune 500 semiconductor companies such as Intel, Qualcomm, and MediaTek in various leadership roles, where he researched and developed high-performant, energy-efficient, post-quantum secure, safe microchips/ system-on-chips (SoCs)/ accelerators for the Datacenter, Client, Smartphone, Networking, IoT, and AI/ML markets. He contributed to the Falcon LLM (ranked #1 in huggingface) and was the lead architect for the custom AI hardware platform (canceled – priorities changed). He holds 15+ US Patents and has published/presented at more than 20+ conferences.

Suresh emellett aktívan dolgozik vezető pozícióban a RISC-V Internationalnél, ahol a Trusted Computing Group elnöke a RISC-V bizalmas számítási képességének fejlesztése érdekében, és az AI/ML Group elnöke, hogy RISC-V hardveres gyorsítást fejlesszen ki AI/ML munkaterhelésekhez, mint pl. Transformer Large Language Models használt ChatGPT típusú alkalmazások. Ezenkívül tanácsot ad startupoknak és kockázatitőke-cégeknek befektetési döntések támogatásával, termékstratégiával, technológiai átvilágítással stb.

MBA fokozatot szerzett az INSEAD-tól, MS-fokozatot a Birla Institute of Technology & Science Pilani-tól, rendszermérnöki tanúsítványt az MIT-től, AI-tanúsítványt a Stanfordtól és gépjármű-funkcionális biztonsági tanúsítványt a TÜV SÜD-től.

Meséljen nekünk a cégéről

"Mastiṣka AI” (A Mastiṣka szanszkritul agyat jelent) egy mesterséges intelligencia-vállalat, amely agyszerű számítógépek építésére összpontosít, hogy hatékonyabban futtasson alapmodelleket a holnapi generatív mesterséges intelligencia felhasználási eseteihez.

Milyen problémákat old meg?

Tekintettel az AI/GenAI előnyeire, kereslete csak növekedni fog, és a bolygónkra gyakorolt mellékhatásai is. Hogyan csökkenthetjük vagy semlegesíthetjük a mesterséges intelligencia mellékhatásait bolygónkon? A szén-dioxid-leválasztás és az atomenergia jó irányba halad. De alapvetően újra kell gondolnunk a mesterséges intelligencia végzésének módját, vajon rossz módszer-e tonna mátrixszorzás?

Agyunk képes tanulni és számos feladatot elvégezni párhuzamosan, 10 W-on és 10 W alatt, de miért fogyasztanak ezek az AI-rendszerek XNUMX megawattot a modellek betanítására?

Talán a jövő olyan energiahatékony architektúrákat tartogat, mint például a neuromorf architektúrák és az emberi agyhoz legközelebb eső neurális hálózat alapú transzformátorok, amelyek 100-1000-szer kevesebb energiát fogyaszthatnak, ezáltal csökkentve a mesterséges intelligencia használatának költségeit, ezáltal demokratizálva és megmentve az emberi agyat. bolygó.

A mesterséges intelligencia jelenlegi kihívásai, nevezetesen a) elérhetőség, b) hozzáférhetőség, c) megfizethetőség és d) környezetbiztonság, valamint néhány javaslat a megoldásukra.

Ha előre látjuk a jövőt, néhány hasznos AGI-koncepciót mutat be a „HER” című film, ahol „Samantha” karakter – egy beszélgető ágens, aki természetes, megérti az érzelmeket, empátiát mutat, csodálatos másodpilóta a munkában – és tovább fut. kézi eszközöket egész nap, akkor lehet, hogy most meg kell küzdenünk az alábbi kihívásokkal.

1. probléma: Egy LLM képzése 150 10 és 10+ millió dollár közötti összegbe kerülhet, és csak a mélyebb zsebekkel rendelkezők számára teszi lehetővé az AI fejlesztését. Ráadásul a következtetés költségei is hatalmasak (tízszer többe kerül, mint egy internetes keresés)

-> Javítanunk kell a modellek/hardverek energiahatékonyságát, hogy demokratizáljuk a mesterséges intelligenciát az emberiség javára.

2. probléma: Hatalmas mesterséges intelligencia-modellek futtatása beszélgetőpartnerekhez vagy ajánlórendszerekhez, károsítja a környezetet az áramfogyasztás és a hűtés tekintetében.

-> Javítanunk kell a modellek/hardverek energiahatékonyságát, hogy megmentsük bolygónkat gyermekeink számára.

3. probléma: Az emberi agy képes és képes többfeladatos feladatok elvégzésére, de megawatt helyett csak 10 wattot fogyaszt.

—> Talán olyan gépeket kellene építeni, mint az agyunk, és nem a reguláris mátrixszorzókat gyorsabban.

Az emberiség csak fenntartható innovációkkal tud boldogulni, nem pedig úgy, hogy az innováció nevében minden erdőt kivágunk és felforraljuk az óceánokat. Meg kell védenünk bolygónkat gyermekeink és a következő generációk jóléte érdekében…

Mely alkalmazási területek a legerősebbek?

Transformer (és jövőbeli neurális architektúra) alapú alapmodellek betanítása és következtetése, 50-100x energiahatékonyabb a mai GPU-alapú megoldásokhoz képest.

Mi tartja fenn az ügyfeleit éjszaka?

Problémák azon ügyfelek számára, akik jelenleg más termékeket használnak:

A humungos nyelvi modellek betanításának villamosenergia-fogyasztása túl van a tetőn, például egy 13B paraméterű LLM képzése 390B szöveges tokeneken 200 GPU-n 7 napon keresztül 151,744 XNUMX dollárba kerül (Forrás: HuggingFace új képzési klaszter szolgáltatás oldala – https://lnkd.in/g6Vc5cz3). És még nagyobb, 100+B paraméterekkel rendelkező modellek 10+M dollárba kerülnek csak a betanítás. Ezután fizessen a következtetésért minden alkalommal, amikor új felszólítás érkezik.

A hűtéshez szükséges vízfogyasztás – a Kaliforniai Egyetem (Riverside) kutatói felbecsülték a ChatGPT-szerű szolgáltatás környezetre gyakorolt hatását, és azt mondják, hogy minden alkalommal 500 milliliter vizet nyel fel (közel egy 16 unciás vizes palackban található mennyiséghez). 5-50 felszólítást vagy kérdést tartalmazó sorozat. A tartomány a szerverek elhelyezkedésétől és az évszaktól függően változik. A becslés tartalmazza a közvetett vízhasználatot, amelyet a vállalatok nem mérnek – például az adatközpontokat árammal ellátó erőművek hűtésére. (Forrás: https://lnkd.in/gybcxX8C)

Problémák a jelenlegi termékek nem vásárlói számára:

Nem engedheti meg magának a CAPEX hardvert vásárolni

Nem engedheti meg magának a felhőszolgáltatások használatát

Nem lehet újítani vagy kihasználni az AI-t – megragadt a szolgáltatási modellnél, amely kiiktat minden versenyelőnyt

Hogyan néz ki a versenykörnyezet, és hogyan lehet megkülönböztetni egymástól?

- A GPU-k uralják a képzési teret, bár a speciális ASIC-ek is versenyeznek ebben a szegmensben

- A Cloud & Edge következtetés túl sok lehetőséget kínál

Digitális, analóg, fotonikus – nevezzük az embereknek ugyanazt a problémát.

Megosztaná gondolatait az AI/ML chiparchitektúrájának jelenlegi állapotáról, vagyis miben látja jelenleg a legjelentősebb trendeket és lehetőségeket?

A következő trendek:

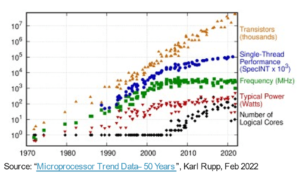

1. trend: 10 évvel ezelőtt virágzott a hardveralapú mély tanulás, most pedig ugyanez a hardver gátolja a fejlődést. A modellek üzemeltetéséhez szükséges hatalmas hardver- és villamosenergia-költségek miatt kihívást jelent a hardverhez való hozzáférés. Csak a nagy zsebekkel rendelkező cégek engedhetik meg maguknak ezeket és válnak monopóliumokká.

2. trend: Most, hogy ezek a modellek megvannak, gyakorlati célokra kell használnunk őket, hogy megnőjön a következtetési terhelés, így az AI-gyorsítóval ellátott CPU-k ismét a rivaldafénybe kerülhetnek.

3. trend: A startupok olyan alternatív lebegőpontos számábrázolásokat próbálnak kidolgozni, amelyekre a hagyományos IEEE formátum – például a logaritmikus és a poziciós alapú – jó, de nem elég. A PPA$ tervezési téroptimalizálása robbanásszerű, ha megpróbáljuk optimalizálni az egyiket, és a másik feldobásra megy.

4. trend: Az iparág elmozdul a mesterséges intelligencia szolgáltatásalapú modelljétől, és saját telephelyén helyezi el saját privát modelljeit – de a hardverhez való hozzáférés kihívást jelent az ellátási hiányok, a szankciók stb. miatt.

A dolgok jelenlegi állása:

10 évvel ezelőtt a hardver és az adatok elérhetősége ösztönözte az AI növekedését, most pedig ugyanaz a hardver gátolja – hadd magyarázzam el

Amióta a CPU-k szerencsétlenül működtek, és a GPU-kat újra AI-ra tervezték, sok minden történt

A vállalatok az AI/ML 4 szegmensével foglalkoztak, nevezetesen – 1) a felhőalapú képzéssel, 2) a felhőalapú következtetésekkel, 3) az élvonalkövetkeztetéssel és 4) az élvonalbeli képzéssel (egyesített tanulás az adatvédelmi érzékeny alkalmazásokhoz).

Digitális és analóg

Képzési oldal – GPU-kat, RISC-V-n alapuló ügyfélgyorsítókat, wafer-méretű chipeket (850K mag) és így tovább, ahol a hagyományos CPU-k hiányoznak (általános rendeltetésük). Következtetési oldal – Az NN-gyorsítók minden gyártótól elérhetőek okostelefonokban, laptopokban és más élvonalbeli eszközökben.

Az analóg memrisztor alapú architektúrák is megjelentek egy ideje.

Úgy gondoljuk, hogy a CPU-k nagyon jók lehetnek a következtetésekben, ha ezt gyorsítással, például mátrixbővítésekkel javítjuk

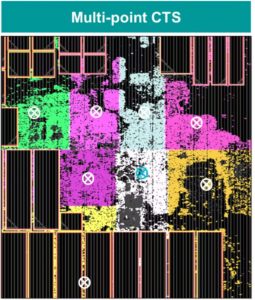

A dolgok RISC-V oldala:

A dolgok RISC-V oldalán gyorsítókat fejlesztünk a mátrixműveletekhez és más nemlineáris műveletekhez, hogy kiküszöböljük a transzformátorok munkaterhelésének lehetséges szűk keresztmetszeit. A Von Neumann szűk keresztmetszeteit a számítástechnikához közelebb álló memóriák felépítése is megszünteti, így végül az AI-gyorsítással rendelkező CPU-k a megfelelő választás a következtetésekhez.

lehetőségek:

Egyedülálló lehetőségek vannak az alapozómodellek piacának betöltésére. Példa – Az OpenAI megemlítette, hogy nem tud elég mesterséges intelligencia-számítógépet (GPU) biztosítani ahhoz, hogy továbbra is terjessze a ChatGPT szolgáltatásait… a hírek pedig arról szólnak, hogy a rendszeres internetes keresés 10-szeres villamosenergia-költsége és 500 ml víz szükséges a rendszerek hűtéséhez. minden lekérdezéshez. Van itt egy piac, amelyet ki kell tölteni – ez nem egy rése, hanem a teljes piac, amely demokratizálja az AI-t, és megbirkózik a fent említett kihívásokkal – a) elérhetőség, b) hozzáférhetőség, c) megfizethetőség és d) környezetbiztonság

Milyen új funkciókon/technológián dolgozik?

Olyan agyat építünk, mint a számítógép, kihasználva a neuromodrfikus technikákat és testreszabva a modelleket, hogy kihasználjuk az energiahatékony hardver előnyeit, felhasználva a rendelkezésre álló nyílt keretrendszerek lehetőségét.

Hogyan képzeli el az AI/ML szektor növekedését vagy változását a következő 12-18 hónapban?

Mivel a GPU-k iránti kereslet megcsappant (mintegy 30 XNUMX dollárba kerül), és a világ egyes részein szankciókkal néznek szembe ezeknek a GPU-knak a megvásárlása miatt, a világ egyes részein úgy érzik, hogy befagytak az AI-kutatásban és -fejlesztésben anélkül, hogy hozzáférnének a GPU-khoz. Alternatív hardverplatformok fogják megragadni a piacot.

A modellek talán zsugorodni fognak – az egyedi modellek, vagy akár alapvetően az információsűrűség növekedni fog

Ugyanez a kérdés, de mi lesz a növekedéssel és a változással a következő 3-5 évben?

a) Az AI-bővítésekkel rendelkező CPU-k megragadják az AI-következtetési piacot

b) A modellek fürgevé válnak, és a paraméterek kiesnek, ahogy az információsűrűség 16%-ról 90%-ra javul

c) Javul az energiahatékonyság, csökken a CO2 lábnyom

d) Új architektúrák jelennek meg

e) csökkennek a hardver- és energiaköltségek, így a modellek létrehozására és betanítására irányuló kisebb vállalatok belépési korlátja megfizethetővé válik

f) az emberek az AGI előtti pillanatokról beszélnek, de az én etalonom a karakteres Samantha (beszélgető mesterséges intelligencia) lenne a „her” című filmben. Ez talán nem valószínű, tekintettel a felnagyítás magas költségeire.

Melyek azok a kihívások, amelyek befolyásolhatják vagy korlátozhatják az AI/ML szektor növekedését?

a) Hozzáférés a hardverhez

b) Energiaköltségek és hűtési költségek és környezeti ártalmak

Is Read:

CEO Interjú: David Moore, a Pragmatic

Vezérigazgatói interjú: Dr. Meghali Chopra a Sandbox Semiconductortól

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :van

- :is

- :nem

- :ahol

- $ UP

- 1

- 10

- 150

- 20

- 20 év

- 200

- 50

- 500

- 7

- a

- Képes

- Rólunk

- felett

- abu dhabi

- gyorsulás

- gyorsítók

- hozzáférés

- megközelíthetőség

- aktívan

- cím

- címzett

- címzés

- Előny

- ügyek

- újra

- Ügynök

- szerek

- AGI

- Augusztus

- AI

- AI modellek

- ai kutatás

- AI rendszerek

- ai használati esetek

- AI / ML

- igazított

- Minden termék

- lehetővé téve

- lehetővé teszi, hogy

- mentén

- Is

- alternatív

- elképesztő

- an

- és a

- Másik

- bármilyen

- bárhol

- Alkalmazás

- alkalmazások

- építészet

- VANNAK

- területek

- érkezik

- mesterséges

- mesterséges intelligencia

- AS

- Asics

- kérdez

- At

- autóipari

- elérhetőség

- elérhető

- el

- b

- korlát

- alapján

- BE

- válik

- válik

- egyre

- óta

- hogy

- Hisz

- lent

- benchmark

- haszon

- Előnyök

- között

- Túl

- szűk

- köteles

- Agy

- agyvelő

- épít

- Épület

- de

- megvesz

- by

- Kalifornia

- TUD

- törölve

- képesség

- képes

- tőke

- elfog

- szén

- szén-dioxid-leválasztás

- esetek

- Centers

- vezérigazgató

- Vezérigazgatói interjú

- igazolás

- kihívás

- kihívások

- változik

- megváltozott

- változó

- karakter

- ChatGPT

- Gyerekek

- csip

- játékpénz

- választás

- Chopra

- vásárló

- közel

- közelebb

- felhő

- Fürt

- co2

- hogyan

- Companies

- vállalat

- képest

- versenyez

- versenyképes

- Kiszámít

- számítógép

- számítógépek

- számítástechnika

- fogalmak

- konferenciák

- fogyaszt

- fogyasztás

- folytatódik

- hozzájárultak

- társalgó

- társalgási AI

- Hűvös

- Költség

- kiadások

- tudott

- teremt

- Jelenlegi

- Jelenlegi állapot

- Jelenleg

- szokás

- vevő

- Ügyfelek

- vágás

- Kiberbiztonság

- dátum

- adatközpontok

- Datacenter

- David

- nap

- Nap

- döntés

- mély

- mély tanulás

- mélyebb

- Kereslet

- demokratizálni

- demokratizálásának

- igazolták

- sűrűség

- attól

- Design

- Fejleszt

- fejlett

- fejlesztése

- Fejlesztés

- Eszközök

- Dhabi

- különbséget

- szorgalom

- irány

- Igazgató

- do

- nem

- Ennek

- dollár

- ne

- le-

- dr

- Csepp

- két

- szerzett

- él

- hatások

- hatékonyság

- hatékony

- eredményesen

- villamos energia

- villamosenergia-fogyasztás

- megszüntetése

- megszünteti

- érzelmek

- Átélés

- energia

- energiahatékonyság

- Mérnöki

- növelése

- elég

- Egész

- belépés

- Környezet

- környezeti

- felidézi vminek a képét

- becslés

- becsült

- stb.

- Eter (ETH)

- Még

- végül is

- Minden

- példa

- végrehajtó

- Ügyvezető igazgató

- létezik

- szakvélemény

- felrobban

- kiterjesztések

- Arc

- néző

- sólyom

- gyorsabb

- érzés

- kitöltése

- cégek

- úszó

- összpontosított

- Láb

- A

- előre lát

- formátum

- Szerencse

- Alapítvány

- keretek

- ból ből

- fagyasztva

- táplálta

- funkcionális

- alapvetően

- jövő

- általános

- generációk

- nemző

- Generatív AI

- adott

- Go

- Goes

- megy

- jó

- GPU

- Csoport

- Növekvő

- Növekedés

- hardver

- Legyen

- he

- ennélfogva

- itt

- Magas

- tart

- tárhely

- Hogyan

- HTTPS

- hatalmas

- HuggingFace

- emberi

- Emberiség

- IEEE

- if

- kép

- Hatás

- javul

- javítja

- in

- Más

- magában foglalja a

- Növelje

- ipar

- információ

- újít

- Innováció

- újítások

- helyette

- Intézet

- Intel

- Intelligencia

- Nemzetközi

- Internet

- Interjú

- beruházás

- tárgyak internete

- IT

- ITS

- éppen

- gyerekek

- Kedves

- hiány

- táj

- nyelv

- laptopok

- nagy

- nagyobb

- vezet

- Vezetés

- TANUL

- tanulás

- hadd

- Tőkeáttétel

- erőfölény

- mint

- rivaldafény

- LIMIT

- kiszámításának

- található

- néz

- hasonló

- alacsonyabb

- gép

- Gyártás

- Gyártó

- sok

- piacára

- piacok

- Mátrix

- max-width

- Lehet..

- talán

- MBA

- me

- jelenti

- eszközök

- intézkedés

- Memories

- említett

- esetleg

- millió

- millió dollár

- MIT

- modell

- modellek

- pillanat

- monopóliumok

- hónap

- több

- a legtöbb

- film

- mozgó

- MS

- kell

- my

- név

- ugyanis

- Természetes

- Szükség

- hálózati alapú

- hálózatba

- ideg-

- Új

- hír

- következő

- fülke

- éjszaka

- fürge

- Most

- nukleáris

- Atomenergia

- szám

- óceánok

- of

- on

- ONE

- csak

- nyitva

- nyílt forráskódú

- OpenAI

- Művelet

- Lehetőségek

- optimalizálás

- Optimalizálja

- Opciók

- or

- Más

- mi

- ki

- saját

- oldal

- Párhuzamos

- paraméter

- paraméterek

- alkatrészek

- Szabadalmak

- Fizet

- Emberek (People)

- talán

- bolygó

- növények

- emelvény

- Platformok

- Plató

- Platón adatintelligencia

- PlatoData

- rengeteg

- plusz

- zsebek

- pont

- pozíció

- lehetséges

- hatalom

- erőművek

- Gyakorlati

- magán

- Probléma

- problémák

- Termékek

- Termékek

- profil

- Haladás

- utasításokat

- védelme

- cél

- célokra

- Nyomja

- helyezi

- Qualcomm

- kérdés

- Kérdések

- hatótávolság

- rangsorolt

- Olvass

- nemrég

- Ajánlást

- ajánlások

- csökkenteni

- csökkentő

- szabályos

- Jelentések

- kérni

- kutatás

- kutatás és fejlesztés

- kutatók

- jobb

- Folyóparti

- szerepek

- tető

- futás

- futás

- fut

- biztonságos

- Biztonság

- azonos

- Szankciók

- sandbox

- Megtakarítás

- megtakarítás

- azt mondják

- skálázás

- Tudomány

- Keresés

- Évad

- szektor

- biztonság

- lát

- szegmensek

- félvezető

- Félvezetők

- Series of

- szerverek

- szolgáltatás

- Szolgáltatások

- szolgáló

- Megosztás

- hiány

- kellene

- kimutatta,

- Műsorok

- oldal

- jelentős

- óta

- kisebb

- okostelefon

- okostelefonok

- So

- szoftver

- Megoldások

- Megoldása

- néhány

- forrás

- Hely

- specializált

- költött

- Stanford

- kezdet

- Startups

- Állami

- Stratégia

- legerősebb

- ilyen

- kínálat

- támogatás

- fenntartható

- Systems

- felszerelés

- szerelések

- szabászat

- Vesz

- Beszél

- feladatok

- Műszaki

- Technológia

- technológiai innováció

- feltételek

- szöveg

- mint

- hogy

- A

- A jövő

- az információ

- a világ

- azok

- Őket

- akkor

- Ott.

- ezáltal

- Ezek

- ők

- dolgok

- ezt

- azok

- bár?

- Gyarapodás

- idő

- nak nek

- mai

- tokenek

- holnap

- is

- felső

- dobás

- hagyományos

- Vonat

- Képzések

- transzformátor

- transzformerek

- Trends

- Megbízható

- megpróbál

- próbál

- alatt

- megérti

- egyetemi

- University of California

- valószínűtlen

- us

- Használat

- használ

- használt

- segítségével

- különféle

- vállalkozás

- kockázati tőke

- kockázati tőke cégek

- nagyon

- az

- volt

- Víz

- Út..

- we

- háló

- Jólét

- voltak

- Mit

- amikor

- ami

- WHO

- miért

- lesz

- val vel

- nélkül

- Munka

- dolgozó

- világ

- lenne

- Rossz

- év

- te

- A te

- zephyrnet