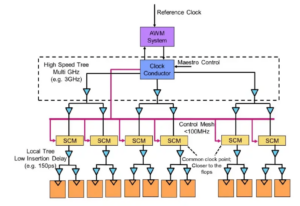

Szakértők az asztalnál: A Semiconductor Engineering leült, hogy a memória fejlődésének útjáról beszéljen az egyre heterogénebb rendszerekben, és Frank Ferro csoportigazgató, termékmenedzsment hanglejtés; Steven Woo, a munkatárs és kiváló feltaláló Rambus; Jongsin Yun, memóriatechnológus a cégnél Siemens EDA; Randy White, memóriamegoldások programvezetője Kulcslátó; és Frank Schirrmeister, a megoldásokért és üzletfejlesztésért felelős alelnöke Arteris. What follows are excerpts of that conversation. Part one of this discussion can be found itt.

![[LR]: Frank Ferro, Cadence; Steven Woo, Rambus; Jongsin Yun, Siemens EDA; Randy White, Keysight; és Frank Schirrmeister, Arteris.](https://platoaistream.com/wp-content/uploads/2024/01/rethinking-memory.png)

[LR]: Frank Ferro, Cadence; Steven Woo, Rambus; Jongsin Yun, Siemens EDA; Randy White, Keysight; és Frank Schirrmeister, Arteris

SE: Miközben az AI/ML-el és az energiaigényekkel küzdünk, milyen konfigurációkat kell újragondolni? Látunk-e elmozdulást a Von Neumann építészettől?

Udvarol: Ami a rendszerarchitektúrát illeti, az iparágban elágazás zajlik. Nem tűnnek el a domináns igáslónak számító hagyományos alkalmazások, amelyeket felhőben futtatunk x86-alapú szervereken. Évtizedek óta építettek és fejlesztettek szoftvereket, amelyek ezen architektúrára fognak támaszkodni, hogy jól teljesítsenek. Ezzel szemben az AI/ML egy új osztály. Az emberek újragondolták az architektúrákat, és nagyon tartomány-specifikus processzorokat építettek. Azt látjuk, hogy az energia körülbelül kétharmadát csak az adatok mozgatására fordítják a processzor és a HBM-eszköz között, míg csak körülbelül egyharmadát a DRAM magjaiban lévő bitek tényleges elérése. Az adatmozgatás ma már sokkal nagyobb kihívást jelent és drágább. Nem fogunk megszabadulni az emlékezettől. Szükségünk van rá, mert az adatkészletek egyre nagyobbak. Tehát a kérdés az: "Mi a helyes út a továbbiakban?" Sokat vitatkoztak a halmozásról. Ha ezt a memóriát közvetlenül a processzor tetejére tesszük, akkor két dolgot csinálunk. Először is, a sávszélességet ma korlátozza a partvonal vagy a chip kerülete. Ide mennek az I/O-k. De ha közvetlenül a processzor tetejére helyezné, akkor most a chip teljes területét kihasználhatja az elosztott összeköttetésekre, és több sávszélességet kaphat magában a memóriában, és közvetlenül továbbítható a processzor. A linkek sokkal rövidebbek, és az energiahatékonyság valószínűleg 5-6X nagyságrenddel nő. Másodszor, a memória több területi tömbös összekapcsolása miatt elérhető sávszélesség is több egész számmal nő. E két dolog együttes végrehajtása nagyobb sávszélességet és energiahatékonyabbá tehet. Az iparág az igényeknek megfelelően fejlődik, és ez minden bizonnyal az egyik módja annak, hogy a memóriarendszerek a jövőben elkezdjenek fejlődni, hogy energiahatékonyabbak legyenek és nagyobb sávszélességet biztosítsanak.

Vas: Amikor 2016 körül először elkezdtem dolgozni a HBM-en, néhány haladó ügyfél megkérdezte, hogy összerakható-e. Már egy ideje vizsgálják, hogyan lehet a DRAM-ot a tetejére rakni, mert ennek egyértelmű előnyei vannak. A fizikai rétegből a PHY alapvetően elhanyagolhatóvá válik, ami rengeteg energiát és hatékonyságot takarít meg. De most van egy több 100 W-os processzora, amelyen van egy memória. A memória nem bírja a meleget. Valószínűleg ez a leggyengébb láncszem a hőláncban, ami újabb kihívást jelent. Vannak előnyei, de még ki kell találniuk, hogyan kezeljék a termikeket. Most már nagyobb az ösztönzés az ilyen típusú architektúra továbbfejlesztésére, mert ez valóban megtakarítja a teljesítményt és a teljesítményt, és javítja a számítási hatékonyságot. De van néhány fizikai tervezési kihívás, amelyekkel meg kell küzdeni. Ahogy Steve mondta, mindenféle architektúrát látunk, ami megjelenik. Abban teljesen egyetértek, hogy a GPU/CPU architektúrák nem vezetnek sehova, továbbra is dominánsak maradnak. Ugyanakkor a bolygó minden vállalata megpróbál egy jobb egérfogót kitalálni a mesterséges intelligencia elvégzéséhez. Látjuk a chipen lévő SRAM-ot és a nagy sávszélességű memória kombinációit. Az LPDDR mostanában eléggé felkapta a fejét, hogy miként lehetne kihasználni az LPDDR előnyeit az adatközpontban az áram miatt. Még azt is láttuk, hogy a GDDR-t egyes mesterséges intelligencia-következtető alkalmazásokban, valamint az összes régi memóriarendszerben használják. Most megpróbálnak minél több DDR5-öt egy lábnyomra szorítani. Láttam minden olyan architektúrát, ami eszedbe jut, legyen az DDR, HBM, GDDR vagy más. A processzormagtól függ, hogy mi az általános hozzáadott érték, és hogyan tud áttörni az adott architektúrán. A hozzá tartozó memóriarendszer, így a rendelkezésre álló lehetőségektől függően alakíthatja ki CPU-ját és memóriaarchitektúráját.

És egy: Egy másik probléma a nem volatilitás. Ha például az AI-nak meg kell küzdenie az IoT-alapú mesterséges intelligencia futtatása közötti energiaintervallumokkal, akkor sok ki- és bekapcsolásra van szükségünk, és ennek az információnak az AI képzéséhez újra és újra meg kell forognia. Ha vannak olyan megoldásaink, ahol ezeket a súlyokat a chipben tárolhatjuk, hogy ne kelljen mindig oda-vissza mozognunk ugyanazért a súlyért, akkor az sok energiamegtakarítást jelent, különösen az IoT-alapú mesterséges intelligencia esetében. Lesz egy másik megoldás is az energiaigények kielégítésére.

Schirrmeister: Amit lenyűgözőnek találok a NoC szemszögéből, az az, amikor optimalizálni kell ezeket az útvonalakat egy NoC-n átmenő processzortól, egy memóriainterfész eléréséhez egy esetlegesen az UCIe-n átmenő vezérlővel, hogy átadhassa a chipletet egy másik chipletnek, amelyben aztán memória van. azt. Nem arról van szó, hogy a Von Neumann architektúrák halottak. De most nagyon sok változat létezik, attól függően, hogy mekkora terhelést szeretne kiszámítani. Ezeket az emlékezet kontextusában kell figyelembe venni, és az emlékezés csak az egyik szempont. Honnan szerzi be az adatokat az adathelyről, hogyan van elrendezve ebben a DRAM-ban? Mindezeken a dolgokon dolgozunk, mint például a memóriák teljesítményelemzésén, majd optimalizáljuk rajta a rendszerarchitektúrát. Ez sok innovációt ösztönöz az új architektúrákban, amire soha nem gondoltam, amikor az egyetemen tanultam Von Neumannról. A másik végén olyan dolgok vannak, mint a hálók. Sokkal több architektúra van most a kettő között, amelyet figyelembe kell venni, és ezt a memória sávszélessége, a számítási képességek és így tovább hajtják, nem ugyanabban az ütemben.

Fehér: Van egy olyan tendencia, amely magában foglalja a dezaggregált vagy elosztott számításokat, ami azt jelenti, hogy az építésznek több eszközre van szüksége. A memóriahierarchia bővült. Vannak benne szemantika, valamint CXL és különböző hibrid memóriák, amelyek flash-hez és DRAM-ban is elérhetők. Az adatközpont párhuzamos alkalmazása az autóipar. Az autóiparban ez az érzékelő mindig ECU-kkal (elektronikus vezérlőegységekkel) működött. Lenyűgözött, hogyan fejlődött az adatközponttá. Gyorsan előre, és ma már elosztott számítási csomópontokat, úgynevezett tartományvezérlőket kínálunk. Ez ugyanaz. Azt próbálja kezelni, hogy talán az energia nem olyan nagy probléma, mert a számítógépek mérete nem olyan nagy, de a késleltetés minden bizonnyal nagy probléma az autóiparban. Az ADAS-nak szuper nagy sávszélességre van szüksége, és különböző kompromisszumokat kínál. És akkor több mechanikus érzékelő van, de hasonló megszorítások az adatközpontban. Hűtőtárolója van, amelynek nem kell alacsony késleltetésűnek lennie, és van más nagy sávszélességű alkalmazása. Lenyűgöző látni, hogy az építész eszközei és lehetőségei mennyit fejlődtek. Az iparág nagyon jó munkát végzett a válaszadás során, és mindannyian különféle megoldásokat kínálunk, amelyek behatolnak a piacba.

SE: Hogyan fejlődtek a memóriatervező eszközök?

Schirrmeister: Amikor a 90-es években elkezdtem az első chipemmel, a leggyakrabban használt rendszereszköz az Excel volt. Azóta mindig abban reménykedem, hogy egy ponton megszakad a rendszerszintű tevékenységeink, a memória, a sávszélesség-elemzés és így tovább. Ez nagy hatással volt a csapatomra. Akkoriban ez nagyon fejlett dolog volt. De Randy szerint most bizonyos összetett dolgokat olyan hűségszinten kell szimulálni, ami korábban nem volt lehetséges a számítás nélkül. Például, ha egy DRAM-hozzáféréshez bizonyos késleltetést feltételezünk, az rossz architektúra-döntésekhez és potenciálisan helytelen adatátviteli architektúrákhoz vezethet a chipen. A másik oldala is igaz. Ha mindig a legrosszabb esetet feltételezi, akkor túltervezi az architektúrát. A DRAM-ot és a teljesítményelemzést végrehajtó eszközök, valamint a megfelelő modellek a vezérlők számára lehetővé teszi az építész számára, hogy mindezt szimulálja, ez egy lenyűgöző környezet. A '90-es évektől remélem, hogy az Excel egy ponton összeomlik. A rendszerszintű eszköz valóban megvalósulhat, mert bizonyos dinamikus hatások, amelyeket már nem lehet végrehajtani az Excelben, mert ki kell őket szimulálni – különösen, ha bedobja a PHY-jellemzőkkel rendelkező interfészeket, majd összekapcsolja a réteget. olyan jellemzők, mint az összes ellenőrzés, hogy minden helyes-e, és az adatok esetleges újraküldése. Ha nem végzik el ezeket a szimulációkat, akkor az architektúra nem optimális.

Vas: A legtöbb értékelésnél az első lépés, hogy megadjuk nekik a memória tesztpadot, hogy elkezdjék megvizsgálni a DRAM hatékonyságát. Ez óriási lépés, még olyan egyszerű dolgokat is megtehet, mint a helyi eszközök futtatása a DRAM-szimuláció elvégzéséhez, de aztán teljes körű szimulációkba kezd. Azt látjuk, hogy több ügyfél kér ilyen típusú szimulációt. Minden értékelés első nagyon fontos lépése annak biztosítása, hogy a DRAM hatékonysága a 90-es évek csúcsára emelkedjen.

Udvarol: A teljes rendszerszimulációs eszközök elterjedésének egyik oka az, hogy a DRAM-ok sokkal bonyolultabbá váltak. Most már nagyon nehéz a sávban maradni néhány ilyen összetett munkaterhelésnél egyszerű eszközök, például az Excel használatával. Ha megnézzük a 90-es években a DRAM adatlapját, ezek az adatlapok 40 oldalasak voltak. Most már több száz oldalasak. Ez csak az eszköz összetettségéről beszél a nagy sávszélességek kihasználása érdekében. Ez párosul azzal a ténnyel, hogy a memória nagy szerepet játszik a rendszer költségében, valamint a processzor teljesítményéhez kapcsolódó sávszélességben és késleltetésben. Ez egyben nagy erőt is jelent, így most sokkal részletesebb szinten kell szimulálnia. Az eszközáramlást illetően a rendszertervezők megértik, hogy a memória hatalmas hajtóerő. Tehát az eszközöknek kifinomultabbaknak kell lenniük, és nagyon jól kell kapcsolódniuk más eszközökhöz, hogy a rendszertervező a lehető legjobb globális képet kaphassa arról, hogy mi történik – különösen azzal kapcsolatban, hogy a memória hogyan hat a rendszerre.

És egy: Ahogy haladunk az AI-korszak felé, sok többmagos rendszert használnak, de nem tudjuk, melyik adat hova kerül. Ez is inkább párhuzamos a chippel. A memória mérete sokkal nagyobb. Ha a ChatGPT-típusú mesterséges intelligenciát használjuk, akkor a modellek adatkezelése körülbelül 350 MB adatot igényel, ami egy súlyozáshoz képest hatalmas adatmennyiség, és a tényleges bemenet/kimenet sokkal nagyobb. A szükséges adatmennyiség növekedése azt jelenti, hogy sok olyan valószínűségi hatás jelentkezik, amelyet korábban nem láttunk. Ez egy rendkívül nagy kihívást jelentő teszt az ehhez a nagy mennyiségű memóriához kapcsolódó összes hiba kiderítésére. Az ECC-t pedig mindenhol használják, még az SRAM-ban is, amely hagyományosan nem használt ECC-t, de ma már nagyon elterjedt a legnagyobb rendszerekben. Mindezek tesztelése nagy kihívást jelent, és ezt az EDA-megoldásoknak is támogatniuk kell a különböző feltételek teszteléséhez.

SE: Milyen kihívásokkal szembesülnek a mérnöki csapatok a mindennapokban?

Fehér: Bármelyik napon megtalálsz a laborban. Feltűröm az ingujjamat, és piszkos a kezem, drótokat piszkálok, forrasztok, meg miegymás. Sokat gondolok a szilícium utáni érvényesítésre. Beszéltünk a korai szimulációról és az azonnali eszközökről – a BiST-ről és hasonló dolgokról. A nap végén, a kiszállítás előtt, szeretnénk valamilyen rendszerellenőrzést vagy eszközszintű teszteket végezni. Arról beszélgettünk, hogyan lehet legyőzni az emlékfalat. Együtt keresünk memóriát, HBM-et, és ehhez hasonló dolgokat. Ha a csomagolási technológia fejlődését nézzük, akkor az ólmozott csomagokkal kezdtük. Nem voltak túl jók a jel integritására. Évtizedekkel később áttértünk az optimalizált jelintegritásra, például a golyós rácstömbökre (BGA-k). Nem tudtuk elérni, ami azt jelentette, hogy nem tudta tesztelni. Ezért kitaláltuk ezt a koncepciót, amelyet eszközbevivőnek nevezünk – BGA interposernek –, és ez lehetővé tette számunkra, hogy egy speciális fixture-t szendvicsszereljünk, amely jeleket továbbít. Ezután csatlakoztathattuk a tesztberendezéshez. Gyorsan előre a mai napra, és most megvan a HBM és a chiplet. Hogyan helyezhetem el a szerelvényemet a szilícium közbeiktatón? Nem tehetjük, és ez a küzdelem. Ez egy olyan kihívás, ami miatt ébren tartok éjszaka. Hogyan végezzünk hibaelemzést terepen egy OEM- vagy rendszervevővel, ahol nem éri el a 90%-os hatékonyságot. Több hiba van a linkben, nem tudnak megfelelően inicializálni, és a képzés sem működik. Ez rendszerintegritási probléma?

Schirrmeister: Nem tenné ezt inkább otthonról egy virtuális felülettel, mint hogy sétáljon a laborba? A válasz nem a chipbe épített elemzés? A chipletekkel mindent még jobban integrálunk. A forrasztópáka behelyezése nem igazán lehetséges, ezért módot kell találni a chip-elemzésre. Ugyanez a probléma a NoC-vel. Az emberek megnézik a NoC-t, és elküldöd az adatokat, aztán eltűnnek. Szükségünk van az elemzésekre, hogy az emberek elvégezhessék a hibakeresést, és ez kiterjed a gyártási szintre is, hogy végre otthonról dolgozhasson, és mindezt chipelemzés alapján végezze.

Vas: Főleg nagy sávszélességű memóriával fizikailag nem lehet oda bejutni. Amikor licenceljük a PHY-t, van egy termékünk is, amely hozzá tartozik, így az 1,024 bit mindegyikére felfigyelhet. Elkezdheti olvasni és írni a DRAM-ot az eszközről, így nem kell fizikailag bejutnia. Tetszik az interposer ötlet. A tesztelés során kihozunk néhány tűt az interposerből, amit a rendszerben nem lehet megtenni. Igazán kihívás bekerülni ezekbe a 3D rendszerekbe. Még a tervezőeszköz-folyamat szempontjából is úgy tűnik, hogy a legtöbb vállalat saját egyéni folyamatot hajt végre sok ilyen 2.5D-s eszközön. Elkezdünk egy szabványosabb módszert összeállítani egy 2.5D-s rendszer felépítésére a jelintegritásból, a teljesítményből és a teljes áramlásból.

Fehér: Ahogy a dolgok haladnak előre, remélem, továbbra is meg tudjuk őrizni ugyanazt a pontossági szintet. Az UCIe formatényező megfelelőségi csoportjába tartozom. Azt nézem, hogyan lehet jellemezni egy ismert jó kockát, egy aranykockát. Végül ez sokkal több időt vesz igénybe, de megtaláljuk a boldog közeget a szükséges tesztelés teljesítménye és pontossága, valamint a beépített rugalmasság között.

Schirrmeister: Ha megnézem a chipleteket és azok bevezetését egy nyitottabb termelési környezetben, akkor a tesztelés jelenti az egyik legnagyobb kihívást a megfelelő működés érdekében. Ha egy nagy cég vagyok, és minden oldalát én irányítom, akkor megfelelően korlátozhatom a dolgokat, hogy a tesztelés és egyebek megvalósíthatóvá váljanak. Ha az UCIe szlogenjére akarok menni, miszerint az UCI csak egy betűre van a PCI-től, és elképzelek egy olyan jövőt, ahol az UCIe összeszerelés gyártási szempontból olyan lesz, mint manapság egy PC-ben a PCI slot, akkor ennek a tesztelési szempontjai valóban kihívást jelentő. Megoldást kell találnunk. Rengeteg munka van.

Kapcsolódó cikkek

Az emlékezet jövője (Part 1 of above roundable)

A hő- és energiaproblémák megoldására tett kísérletektől a CXL és az UCIe szerepéig a jövő számos lehetőséget tartogat a memória számára.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://semiengineering.com/rethinking-memory/

- :van

- :is

- :nem

- :ahol

- $ UP

- 1

- 2016

- 3d

- 40

- a

- Rólunk

- felett

- hozzáférés

- Hozzáférés

- pontosság

- tényleges

- tulajdonképpen

- ADAs

- hozzá

- cím

- Örökbefogadás

- fejlett

- Előny

- előnyei

- újra

- AI

- AI képzés

- AI / ML

- Minden termék

- megengedett

- lehetővé teszi, hogy

- Is

- mindig

- összeg

- an

- elemzés

- analitika

- és a

- Másik

- válasz

- bármilyen

- Már

- bárhol

- Alkalmazás

- alkalmazások

- megfelelő

- építészek

- építészet

- VANNAK

- TERÜLET

- körül

- elrendezve

- Sor

- AS

- kér

- megjelenés

- szempontok

- Assembly

- feltételezni

- At

- Kísérletek

- autóipari

- elérhető

- el

- vissza

- Rossz

- labda

- Sávszélesség

- bár

- alapján

- Alapvetően

- alap

- BE

- mert

- válik

- válik

- óta

- előtt

- hogy

- Előnyök

- BEST

- Jobb

- között

- Nagy

- nagyobb

- Bit

- szünet

- hoz

- épít

- épült

- üzleti

- üzlet fejlesztés

- de

- by

- hanglejtés

- hívott

- jött

- TUD

- Kaphat

- képességek

- eset

- Központ

- bizonyos

- biztosan

- lánc

- kihívás

- kihívások

- kihívást

- jellemzők

- jellemez

- ellenőrzése

- csip

- játékpénz

- osztály

- világos

- felhő

- hideg

- Hideg tárolás

- kombinációk

- hogyan

- érkező

- Közös

- Companies

- vállalat

- bonyolult

- bonyolultság

- teljesítés

- bonyolult

- Kiszámít

- számítógépek

- számítástechnika

- koncepció

- Körülmények

- Csatlakozás

- figyelembe vett

- korlátok

- kontextus

- kontraszt

- ellenőrzés

- ellenőr

- Beszélgetés

- Mag

- kijavítására

- Költség

- tudott

- Pár

- CPU

- teremt

- vevő

- Ügyfelek

- dátum

- Adatközpont

- adatkészletek

- nap

- napról napra

- Nap

- halott

- üzlet

- évtizedek

- határozatok

- minden bizonnyal

- igények

- attól

- függ

- Design

- tervezés

- részletes

- Fejlesztés

- eszköz

- az

- különböző

- nehéz

- közvetlenül

- Igazgató

- vita

- ártalmatlanítása

- Kiváló

- megosztott

- elosztott számítástechnika

- do

- nem

- Nem

- Ennek

- domain

- uralkodó

- csinált

- ne

- le-

- hajtott

- gépkocsivezető

- alatt

- dinamikus

- Korai

- hatások

- hatékonyság

- hatékony

- Elektronikus

- végén

- energia

- Mérnöki

- Egész

- Környezet

- felszerelés

- Ez volt

- hibák

- különösen

- Eter (ETH)

- értékelés

- értékelések

- Még

- végül is

- Minden

- minden

- mindenhol

- evolúció

- fejlődik

- alakult ki

- fejlődik

- példa

- Excel

- kiterjesztett

- drága

- nyúlik

- szélső

- rendkívüli módon

- Szemek

- Arc

- tény

- tényező

- Kudarc

- elbűvölő

- GYORS

- megvalósítható

- fickó

- hűség

- mező

- Ábra

- Végül

- Találjon

- vezetéknév

- Vaku

- Rugalmasság

- Flip

- áramlási

- következik

- Lábnyom

- A

- forma

- tovább

- Előre

- talált

- őszinte

- ból ből

- Tele

- további

- jövő

- kap

- szerzés

- Ad

- adott

- Globális

- Go

- Goes

- megy

- Aranysárga

- elmúlt

- jó

- jó munkát

- kapott

- Rács

- Csoport

- Növekvő

- kellett

- Kezelés

- kezek

- boldog

- Legyen

- tekintettel

- fej

- segít

- hierarchia

- Magas

- tart

- Kezdőlap

- remény

- Hogyan

- How To

- HTML

- HTTPS

- hatalmas

- Több száz

- hibrid

- i

- ötlet

- if

- kép

- befolyásolta

- ütköztető

- fontos

- javul

- in

- Ösztönző

- beleértve

- tévesen

- Növelje

- egyre inkább

- egyéni

- ipar

- információ

- Innováció

- belső

- integrálni

- sértetlenség

- összeköti

- Felület

- bele

- bevonásával

- kérdés

- kérdések

- IT

- ITS

- maga

- Munka

- éppen

- Ismer

- ismert

- labor

- nagy

- nagyobb

- legnagyobb

- Késleltetés

- a későbbiekben

- réteg

- vezet

- tanulás

- levél

- szint

- Engedély

- mint

- Korlátozott

- LINK

- linkek

- helyi

- néz

- keres

- Sok

- sok

- Elő/Utó

- fenntartása

- csinál

- Gyártás

- vezetés

- menedzser

- gyártási

- sok

- piacára

- max-width

- talán

- me

- eszközök

- jelentett

- mechanikai

- közepes

- Memories

- Memory design

- esetleg

- modellek

- több

- a legtöbb

- mozog

- áthelyezve

- mozgalom

- mozgó

- sok

- my

- Szükség

- igények

- soha

- Új

- éjszaka

- csomópontok

- Most

- szám

- of

- kedvezmény

- Régi

- on

- ONE

- csak

- nyitva

- Lehetőségek

- Optimalizálja

- optimalizált

- optimalizálása

- opció

- Opciók

- or

- érdekében

- Más

- Egyéb

- ki

- átfogó

- Overcome

- saját

- csomagok

- csomagolás

- oldalak

- Párhuzamos

- rész

- különös

- elhalad

- ösvény

- utak

- PC

- Emberek (People)

- teljesít

- teljesítmény

- perspektíva

- fizikai

- fizikailag

- csapok

- bolygó

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- lehetséges

- potenciálisan

- hatalom

- elnök

- korábban

- valószínűleg

- Probléma

- Processzor

- processzorok

- Termékek

- termékmenedzsment

- Termelés

- Program

- megfelelő

- megfelelően

- ad

- tesz

- kérdés

- egészen

- emelés

- Arány

- Inkább

- Olvasás

- tényleg

- összefüggő

- támaszkodnak

- kötelező

- megköveteli,

- megoldása

- válaszol

- eredményez

- megszabadít

- jobb

- Emelkedik

- szerepek

- Tekercs

- futás

- futás

- azonos

- Megtakarítás

- Megtakarítás

- mondás

- Skála

- Második

- lát

- látás

- Úgy tűnik,

- látott

- szemantika

- félvezető

- küld

- érzékelő

- érzékelők

- szerverek

- számos

- lap

- váltás

- hajó

- oldal

- Sides

- Siemens

- Jel

- jelek

- Szilícium

- hasonló

- Egyszerű

- tettetés

- szimulációk

- óta

- egyetlen

- Méret

- nyílások

- So

- szoftver

- megoldások

- Megoldások

- néhány

- kifinomult

- beszél

- speciális

- költött

- Présel

- verem

- egymásra rakva

- felhalmozás

- szabvány

- álláspont

- kezdet

- kezdődött

- Kezdve

- Lépés

- Steve

- steven

- Még mindig

- tárolás

- tárolni

- Küzdelem

- ilyen

- Támogatott

- biztos

- rendszer

- Systems

- táblázat

- Vesz

- Beszél

- csapat

- technológus

- Technológia

- feltételek

- teszt

- Tesztelés

- tesztek

- mint

- hogy

- A

- A jövő

- azok

- Őket

- akkor

- Ott.

- termikus

- Ezek

- ők

- dolog

- dolgok

- Szerintem

- Harmadik

- ezt

- azok

- gondoltam

- Keresztül

- idő

- nak nek

- Ma

- együtt

- szerszám

- szerszámok

- felső

- TELJESEN

- kompromisszumok

- hagyományos

- hagyományosan

- Képzések

- szállítható

- tendencia

- igaz

- próbál

- kettő

- kétharmadát

- típus

- megért

- egységek

- egyetemi

- us

- használ

- használt

- segítségével

- érvényesítés

- érték

- variációk

- különféle

- nagyon

- vice

- Alelnök

- Megnézem

- Tényleges

- az

- gyalogos

- Fal

- akar

- volt

- Út..

- we

- súly

- JÓL

- voltak

- Mit

- bármi

- amikor

- vajon

- ami

- míg

- fehér

- egész

- miért

- lesz

- val vel

- nélkül

- udvarol

- Munka

- otthonról dolgozni

- dolgozó

- Legrosszabb

- írás

- te

- A te

- zephyrnet