Kuva tekijältä

Datan hallinta ja tekoälyn väsyminen kuulostavat kahdelta eri käsitteeltä, mutta näiden kahden välillä on luontainen yhteys. Ymmärtääksemme sitä paremmin, aloitetaan heidän määritelmästään.

Se on ollut datateollisuuden painopiste jo pitkään.

Google ilmaisee asian hyvin – "Tietojen hallinta on kaikkea mitä teet varmistaaksesi, että tiedot ovat turvallisia, yksityisiä, tarkkoja, saatavilla ja käyttökelpoisia. Se sisältää sisäisten standardien – tietokäytäntöjen – asettamisen, jotka koskevat tietojen keräämistä, tallentamista, käsittelyä ja hävittämistä."

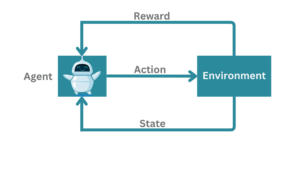

Kuten tämä määritelmä korostaa, datan hallinnassa on kyse tietojen hallinnasta – juuri moottorin ohjaamista tekoälymalleja käyttävistä malleista.

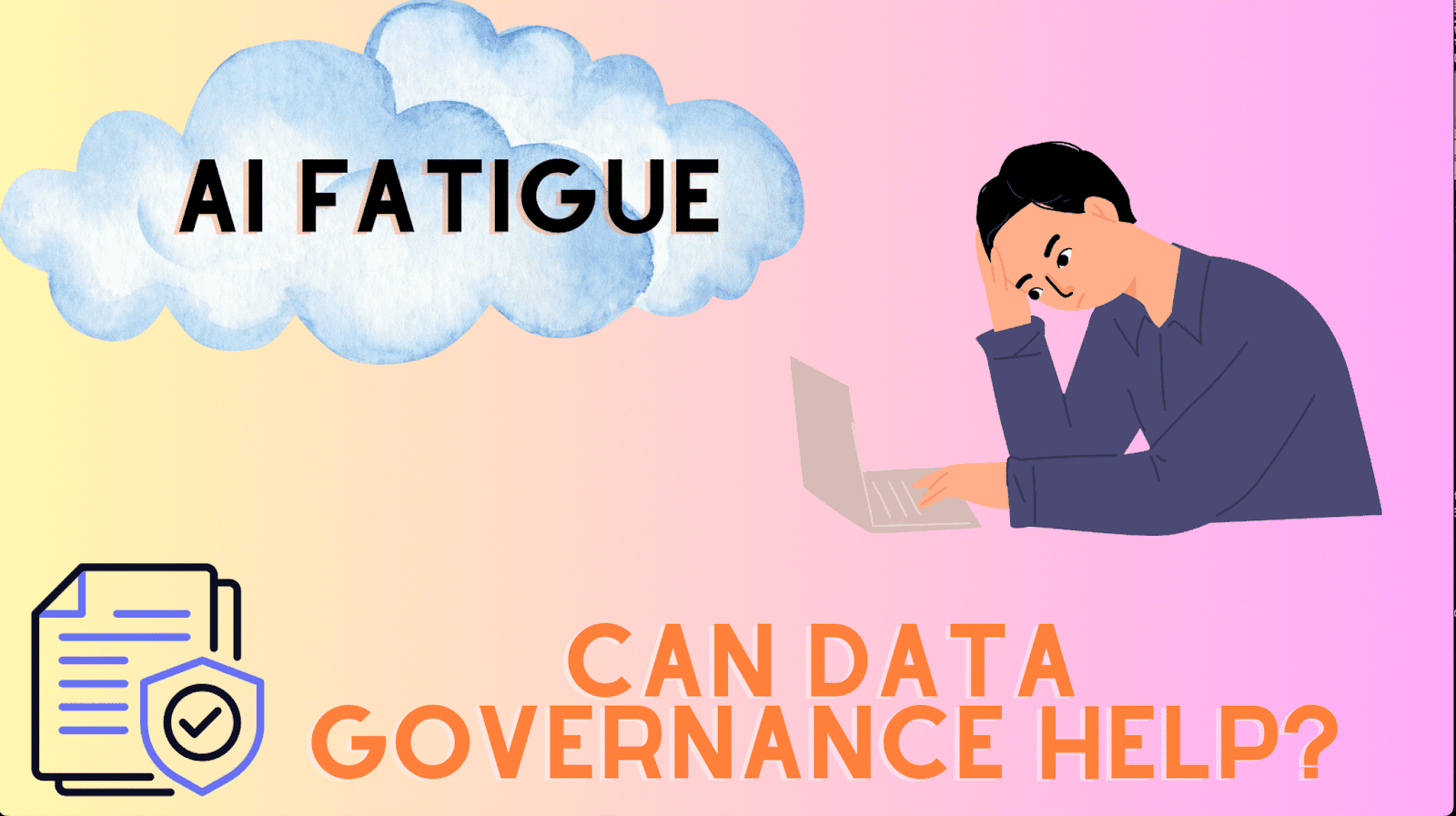

Nyt kun ensimmäiset merkit tiedonhallinnan ja tekoälyn välisestä yhteydestä ovat alkaneet näkyä, liitetään se tekoälyn väsymiseen. Vaikka nimi kertookin sen, tällaiseen väsymykseen johtaneiden syiden korostaminen varmistaa, että tätä termiä käytetään johdonmukaisesti koko postauksen ajan.

Tekoälyväsymys johtuu organisaatioiden, kehittäjien tai tiimien kohtaamista takaiskuista ja haasteista, mikä usein johtaa epäonnistuneeseen tekoälyjärjestelmien arvon toteutumiseen tai käyttöönottoon.

Se alkaa enimmäkseen epärealistisista odotuksista siitä, mihin tekoäly pystyy. Tekoälyn kaltaisten kehittyneiden teknologioiden osalta keskeisten sidosryhmien on mukauduttava tekoälyn kykyjen ja mahdollisuuksien lisäksi myös sen rajoituksiin ja riskeihin.

Riskeistä puhuttaessa etiikkaa pidetään usein jälkikäteen, joka johtaa vaatimustenvastaisten tekoälyaloitteiden poistamiseen.

Ihmettelet varmasti tiedonhallinnan roolia tekoälyn väsymisen aiheuttajana – tämän viestin lähtökohta.

Sinne olemme menossa seuraavaksi.

Tekoälyväsymys voidaan yleisesti luokitella ennen käyttöönottoa ja käyttöönoton jälkeen. Keskitytään ensin käyttöönottoa edeltävään käyttöön.

Käyttöönottoa edeltävä

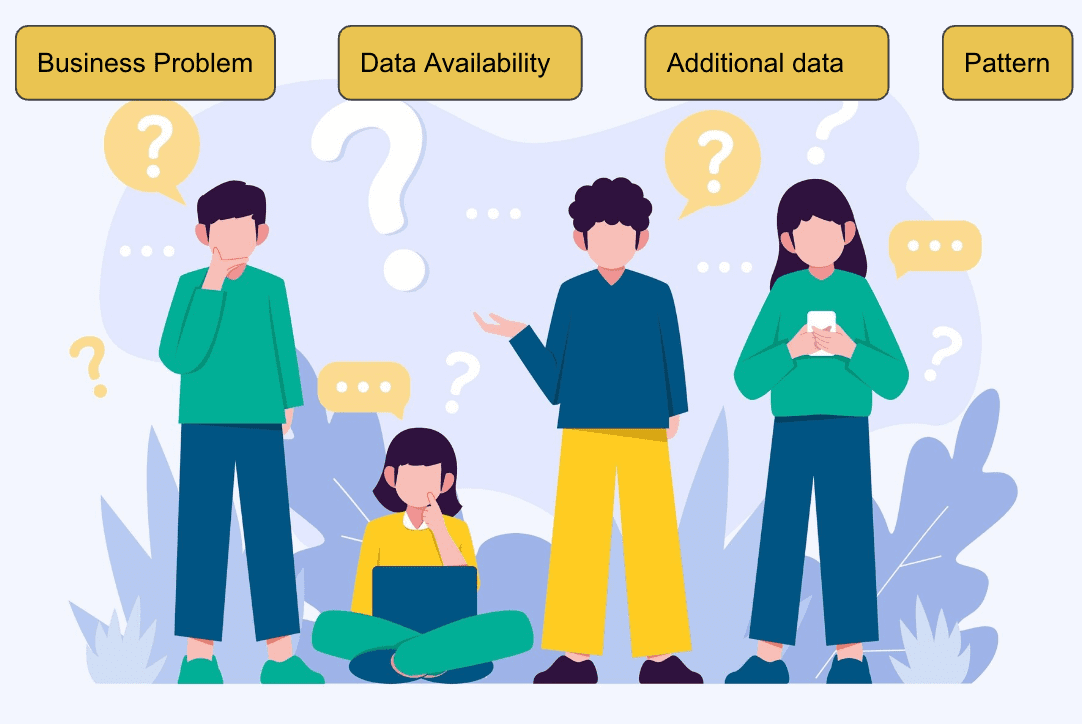

Useat tekijät vaikuttavat Proof of Conceptin (PoC) valmistumiseen käyttöönotolle, kuten:

- Mitä yritämme ratkaista?

- Miksi priorisoiminen nyt on pakottava ongelma?

- Mitä tietoja on saatavilla?

- Onko se ML-ratkaistu ylipäätään?

- Onko tiedoilla kaava?

- Onko ilmiö toistettava?

- Mitkä lisätiedot parantaisivat mallin suorituskykyä?

Kuva Freepik

Kun olemme arvioineet, että ongelma voidaan ratkaista parhaiten ML-algoritmeilla, datatieteen tiimi suorittaa tutkivan data-analyysin. Tässä vaiheessa paljastetaan monia taustalla olevia datakuvioita, jotka osoittavat, onko annetussa datassa runsaasti signaalia. Se auttaa myös luomaan suunniteltuja ominaisuuksia, jotka nopeuttavat algoritmin oppimisprosessia.

Seuraavaksi tiimi rakentaa ensimmäisen perusmallin, usein havaitessaan, että se ei toimi hyväksyttävällä tasolla. Malli, jonka tulos on yhtä hyvä kuin kolikonheitin, ei lisää arvoa. Tämä on yksi ensimmäisistä takaiskuista, eli oppitunteja, kun rakennetaan ML-malleja.

Organisaatiot voivat siirtyä liiketoimintaongelmasta toiseen ja aiheuttaa väsymystä. Silti, jos taustalla olevat tiedot eivät kuljeta rikasta signaalia, mikään AI-algoritmi ei voi rakentaa sitä. Mallin on opittava tilastolliset assosiaatiot harjoitustiedoista yleistääkseen näkymättömään dataan.

Käyttöönoton jälkeinen

Huolimatta siitä, että koulutettu malli näyttää lupaavia tuloksia validointisarjassa, pätevien liiketoimintakriteerien, kuten 70 % tarkkuuden, mukaisesti, väsymystä voi silti esiintyä, jos malli ei toimi riittävästi tuotantoympäristössä.

Tällaista tekoälyn väsymistä kutsutaan käyttöönoton jälkeiseksi vaiheeksi.

Lukemattomat syyt voivat johtaa suorituskyvyn heikkenemiseen, jolloin huono tiedonlaatu on yleisin mallia vaivaava ongelma. Se rajoittaa mallin kykyä ennustaa tarkasti kohdevastetta ilman tärkeitä ominaisuuksia.

Ajattele, kun yksi tärkeimmistä ominaisuuksista, joka puuttui vain 10 % harjoitustiedoista, muuttuu nyt tyhjäksi 50 % ajasta tuotantotiedoissa, mikä johtaa virheellisiin ennusteisiin. Tällaiset iteraatiot ja pyrkimykset varmistaa johdonmukaisesti toimivien mallien uupuminen väsyttävät datatieteilijöitä ja yritystiimejä, mikä heikentää luottamusta dataputkiin ja vaarantaa projektiin tehdyt investoinnit.

Vahvat tiedonhallintatoimenpiteet ovat kriittisiä molempien tekoälyn väsymisen torjunnassa. Koska data on ML-mallien ytimessä, signaalirikas, virheetön ja korkealaatuinen data on ML-projektin onnistumisen edellytys. Tekoälyväsymyksen käsitteleminen edellyttää vahvaa keskittymistä tiedonhallintaan. Meidän on siis työskenneltävä tiukasti varmistaaksemme oikean datan laadun ja luodaksemme pohjan uusimpien mallien rakentamiselle ja luotettavien liiketoimintanäkemysten tarjoamiselle.

Tietojen laatu

Tietojen laatu, avain kukoistavaan tiedonhallintaan, on kriittinen menestystekijä koneoppimisalgoritmille. Organisaatioiden tulee panostaa tiedon laatuun, kuten raporttien julkaisemiseen tiedon kuluttajille. Datatieteen projekteissa mieti, mitä tapahtuu, kun huonolaatuista dataa pääsee malleihin, mikä voi johtaa huonoon suorituskykyyn.

Vasta virheanalyysin aikana tiimit pääsisivät tunnistamaan tiedon laatuongelmat, jotka alkupään korjattavaksi lähetettynä aiheuttavat ryhmien väsymystä.

On selvää, että kyse ei ole vain ponnisteluista, vaan paljon aikaa menetetään, ennen kuin oikeat tiedot alkavat tulla sisään.

Siksi on aina suositeltavaa korjata tietoongelmat niiden lähteellä, jotta vältetään tällaiset aikaa vievät iteraatiot. Lopulta julkaistut tietojen laaturaportit viittaavat datatieteiden tiimiin (tai muihin jatkokäyttäjiin ja datan kuluttajiin), jotka ymmärtävät saapuvan tiedon hyväksyttävän laadun.

Ilman tietojen laatua ja hallintaa koskevia toimenpiteitä datatieteilijöille aiheutuisi ylikuormitusta tietoongelmista, mikä myötävaikuttaisi epäonnistuneisiin malleihin, jotka aiheuttavat tekoälyn väsymistä.

Viesti korosti kahta vaihetta, joissa tekoälyn väsyminen alkaa, ja esitteli, kuinka tiedonhallintatoimenpiteet, kuten tiedon laaturaportit, voivat auttaa luotettavien ja kestävien mallien rakentamisessa.

Luomalla vankan perustan tiedonhallinnan avulla organisaatiot voivat rakentaa etenemissuunnitelman onnistuneeseen ja saumattomaan tekoälyn kehittämiseen ja käyttöönottoon, mikä herättää innostusta.

Varmistaakseni, että postaus antaa kokonaisvaltaisen yleiskatsauksen erilaisista tavoista käsitellä tekoälyväsymystä, korostan myös organisaatiokulttuurin roolia, joka yhdistettynä muihin parhaisiin käytäntöihin, kuten tiedonhallintaan, mahdollistaa ja antaa datatieteiden ryhmille mahdollisuuden rakentaa mielekästä tekoälyä nopeammin. nopeammin.

Vidhi Chugh on tekoälystrategi ja digitaalisen muutoksen johtaja, joka työskentelee tuotteiden, tieteiden ja tekniikan risteyksessä rakentaakseen skaalautuvia koneoppimisjärjestelmiä. Hän on palkittu innovaatiojohtaja, kirjailija ja kansainvälinen puhuja. Hänen tehtävänsä on demokratisoida koneoppimista ja murtaa ammattikieltä, jotta kaikki voivat olla osa tätä muutosta.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://www.kdnuggets.com/can-data-governance-address-ai-fatigue?utm_source=rss&utm_medium=rss&utm_campaign=can-data-governance-address-ai-fatigue

- :on

- :On

- :ei

- :missä

- $ YLÖS

- a

- kyky

- Meistä

- hyväksyttävä

- tarkka

- tarkasti

- lisä-

- osoite

- käsitellään

- Lisää

- asianmukaisesti

- Hyväksyminen

- neuvoi

- AI

- AI-mallit

- AI-järjestelmät

- alias

- algoritmi

- algoritmit

- kohdista

- Myös

- aina

- keskuudessa

- an

- analyysi

- ja

- Toinen

- Kaikki

- käyttää

- OVAT

- nousta

- AS

- yhdistykset

- At

- attribuutteja

- kirjoittaja

- saatavissa

- Palkittu

- pois

- Huono

- Lähtötilanne

- BE

- tulee

- ollut

- PARAS

- parhaat käytännöt

- Paremmin

- välillä

- sekä

- Tauko

- laajasti

- rakentaa

- Rakentaminen

- rakentaa

- liiketoiminta

- mutta

- by

- nimeltään

- CAN

- kyvyt

- kykenee

- kuljettaa

- aiheuttaen

- haasteet

- Kolikko

- yhdistetty

- Yhteinen

- pakottava

- käsite

- käsitteet

- huolenaiheet

- luottamus

- liitäntä

- harkittu

- johdonmukainen

- johdonmukaisesti

- Kuluttajat

- edistävät

- edistää

- maksut

- Ydin

- voisi

- luoda

- kriteerit

- kriittinen

- ratkaiseva

- Kulttuuri

- tiedot

- tietojen analysointi

- tiedon laatu

- tietojenkäsittely

- määritelmä

- toimittaa

- demokratisoida

- käyttöönotto

- kehittäjille

- Kehitys

- eri

- digitaalinen

- Digital Transformation

- do

- ei

- ajo

- kaksi

- aikana

- vaivaa

- ponnisteluja

- ilmaantua

- painottaa

- valtuuttaa

- mahdollistaa

- mahdollistaja

- loppu

- Moottori

- suunniteltu

- Tekniikka

- varmistaa

- varmistaa

- innostus

- ympäristö

- virhe

- olennainen

- perustamisesta

- Eetteri (ETH)

- etiikka

- arvioitu

- lopulta

- jokainen

- kaikki

- odotukset

- Tutkimusaineistoanalyysi

- Kasvot

- tekijä

- tekijät

- epäonnistuu

- nopeampi

- väsymys

- Ominaisuudet

- löytäminen

- Etunimi

- Korjata

- kiinteä

- Kääntää

- Keskittää

- varten

- perusta

- alkaen

- kokosi

- saada

- tietty

- antaa

- hyvä

- hallinto

- perustus

- tapahtuu

- Olla

- Otsikko

- auttaa

- korkealaatuisia

- Korostettu

- korostus

- raidat

- kokonaisvaltainen

- Miten

- HTTPS

- i

- tunnistaa

- if

- täytäntöönpano

- in

- Saapuva

- teollisuus

- aloitteita

- Innovaatio

- oivalluksia

- sisäinen

- kansainvälisesti

- leikkauspiste

- tulee

- luontainen

- Investoida

- Investoinnit

- liittyy

- kysymys

- kysymykset

- IT

- toistojen

- SEN

- ammattikieli

- vain

- KDnuggets

- avain

- muuttamisesta

- johtaa

- johtaja

- johtava

- Liidit

- OPPIA

- oppiminen

- Lessons

- antaa

- Taso

- pitää

- rajoitukset

- rajat

- linja

- LINK

- Pitkät

- pitkä aika

- menetetty

- Erä

- kone

- koneoppiminen

- tehty

- tehdä

- TEE

- toimitusjohtaja

- monet

- asia

- Saattaa..

- mielekäs

- toimenpiteet

- keskikokoinen

- puuttuva

- Tehtävä

- ML

- ML-algoritmit

- malli

- mallit

- eniten

- enimmäkseen

- liikkua

- täytyy

- nimi

- Tarve

- seuraava

- Nro

- nyt

- of

- usein

- on

- ONE

- vain

- or

- organisatorinen

- organisaatioiden

- Muut

- ulostulo

- yleiskatsaus

- osa

- Kuvio

- kuviot

- suorittaa

- suorituskyky

- esittävä

- suorittaa

- vaihe

- ilmiö

- putki

- Paikka

- Platon

- Platonin tietotieto

- PlatonData

- PoC

- kehno

- mahdollisuuksia

- Kirje

- käytännöt

- tarkasti

- Tarkkuus

- ennustaa

- Ennusteet

- esitetty

- estää

- Asettaa etusijalle

- yksityinen

- Ongelma

- prosessi

- jalostettu

- Tuotteet

- tuotanto

- projekti

- hankkeet

- lupaava

- todiste

- todiste käsitteestä

- julkaistu

- Julkaiseminen

- puts

- ajot

- laatu

- laadukkaita tietoja

- toteutuminen

- syistä

- toistettavissa

- Raportit

- Vaatii

- vastaus

- tulokset

- Rikas

- oikein

- riskeeraa

- riskit

- roadmap

- luja

- Rooli

- skaalautuva

- tiede

- tieteet

- tutkijat

- saumaton

- turvallinen

- lähetetty

- setti

- takaiskuja

- Setit

- asetus

- hän

- näyttää

- signaali

- Signs

- So

- vankka

- SOLVE

- ratkaistu

- hienostunut

- kuulostaa

- lähde

- Kaiutin

- nopeus

- Vaihe

- vaiheissa

- sidosryhmien

- Alkaa

- alkoi

- alkaa

- huippu-

- tilastollinen

- Yhä

- tallennettu

- Strategi

- vahva

- menestys

- onnistunut

- niin

- järjestelmät

- puuttumalla

- Kohde

- joukkue-

- tiimit

- Technologies

- termi

- että

- -

- heidän

- Siellä.

- siten

- ajatella

- tätä

- vaikka?

- kukoistava

- Kautta

- kauttaaltaan

- aika

- aikaavievä

- että

- koulutettu

- koulutus

- Muutos

- luotettava

- yrittää

- kaksi

- tyyppi

- tyypit

- kattamaton

- taustalla oleva

- ymmärtää

- ymmärtäminen

- asti

- päälle

- us

- käyttökelpoinen

- käyttää

- Käyttäjät

- käyttämällä

- validointi

- arvo

- oli

- Tapa..

- tavalla

- we

- HYVIN

- Mitä

- kun

- onko

- joka

- vaikka

- jonka

- tulee

- with

- Mietitkö

- Referenssit

- työskentely

- olisi

- te

- zephyrnet