Kun hermohakutoiminto käynnistettiin Amazon OpenSearch-palvelu OpenSearch 2.9:ssä on nyt vaivatonta integroida AI/ML-malleihin semanttisen haun ja muiden käyttötapausten tehostamiseksi. OpenSearch Service on tukenut sekä leksikaalista että vektorihakua siitä lähtien, kun sen k-lähin naapuri (k-NN) otettiin käyttöön vuonna 2020; semanttisen haun määrittäminen edellytti kuitenkin kehyksen rakentamista koneoppimismallien (ML) integroimiseksi hakuun ja hakuun. Hermohakuominaisuus helpottaa tekstin muuntamista vektoriksi haun ja haun aikana. Kun käytät hermokyselyä haun aikana, kysely käännetään vektoriupotukseksi ja k-NN:tä käytetään palauttamaan lähimmät vektoriupotukset korpusesta.

Jotta voit käyttää hermohakua, sinun on määritettävä ML-malli. Suosittelemme AI/ML-liittimien määrittämistä AWS AI- ja ML-palveluihin (esim Amazon Sage Maker or Amazonin kallioperä) tai kolmannen osapuolen vaihtoehtoja. OpenSearch-palvelun versiosta 2.9 alkaen AI/ML-liittimet integroituvat hermohakuun, mikä yksinkertaistaa ja mahdollistaa tietokorpusi ja kyselyjen kääntämisen vektoriupotuksiksi, mikä poistaa suuren osan vektorin hydratoinnin ja haun monimutkaisuudesta.

Tässä viestissä näytämme, kuinka AI/ML-liittimet määritetään ulkoisiin malleihin OpenSearch Service -konsolin kautta.

Ratkaisun yleiskatsaus

Erityisesti tämä viesti opastaa sinut yhdistämään malliin SageMakerissa. Tämän jälkeen opastamme sinut liittimen avulla määrittämään semanttinen haku OpenSearch Servicessä esimerkkinä käyttötapauksesta, jota tuetaan yhteyden kautta ML-malliin. Amazon Bedrock- ja SageMaker-integraatioita tuetaan tällä hetkellä OpenSearch Service -konsolin käyttöliittymässä, ja käyttöliittymän tukemien ensimmäisen ja kolmannen osapuolen integraatioiden luettelo kasvaa edelleen.

Kaikki mallit, joita ei tueta käyttöliittymän kautta, voit sen sijaan määrittää ne käyttämällä saatavilla olevia sovellusliittymiä ja ML piirustuksia. Lisätietoja on kohdassa Johdatus OpenSearch-malleihin. Löydät piirustukset jokaisesta liittimestä kohdasta ML Commons GitHub -arkisto.

Edellytykset

Ennen kuin yhdistät mallin OpenSearch Service -konsolin kautta, luo OpenSearch Service -toimialue. Kartta an AWS-henkilöllisyyden ja käyttöoikeuksien hallinta (IAM) roolin nimen mukaan LambdaInvokeOpenSearchMLCommonsRole taustaroolina ml_full_access rooli käyttämällä OpenSearch-hallintapaneelien suojauslaajennusta, kuten seuraavassa videossa näkyy. OpenSearch-palvelun integrointityönkulku on esitäytetty, jotta voit käyttää LambdaInvokeOpenSearchMLCommonsRole IAM-rooli oletuksena luo liittimen OpenSearch Service -toimialueen ja SageMakerissa käyttöön otetun mallin välille. Jos käytät mukautettua IAM-roolia OpenSearch Service -konsoliintegraatioissa, varmista, että mukautettu rooli on kartoitettu taustarooliksi ml_full_access käyttöoikeudet ennen mallin käyttöönottoa.

Ota malli käyttöön AWS CloudFormationin avulla

Seuraava video näyttää vaiheet OpenSearch Service -konsolin avulla mallin käyttöönottoon muutamassa minuutissa Amazon SageMakerissa ja mallitunnuksen luomiseen AI-liittimien kautta. Ensimmäinen askel on valita Integraatiot OpenSearch Service AWS -konsolin navigointiruudussa, joka ohjaa käytettävissä olevien integraatioiden luetteloon. Integrointi määritetään käyttöliittymän kautta, joka pyytää sinua syöttämään tarvittavat tiedot.

Integroinnin määrittäminen edellyttää vain OpenSearch Service -toimialueen päätepisteen ja mallin nimen antamista malliyhteyden yksilöimiseksi. Oletusarvoisesti malli käyttää Hugging Face lausemuuntajamallia, djl://ai.djl.huggingface.pytorch/sentence-transformers/all-MiniLM-L6-v2.

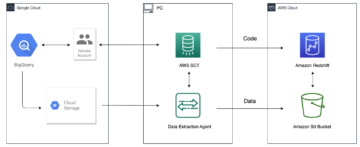

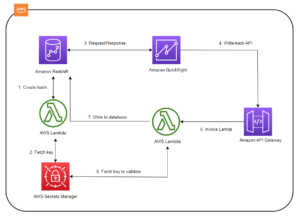

Kun valitset Luo pino, sinut ohjataan osoitteeseen AWS-pilven muodostuminen konsoli. CloudFormation-malli ottaa käyttöön seuraavassa kaaviossa kuvatun arkkitehtuurin.

CloudFormation-pino luo AWS Lambda sovellus, joka ottaa käyttöön mallin Amazonin yksinkertainen tallennuspalvelu (Amazon S3), luo liittimen ja luo mallin tunnuksen ulostuloon. Voit sitten käyttää tätä mallitunnusta semanttisen indeksin luomiseen.

Jos oletusarvoinen all-MiniLM-L6-v2-malli ei palvele tarkoitustasi, voit ottaa käyttöön minkä tahansa valitsemasi tekstin upotusmallin valitulle malliisännälle (SageMaker tai Amazon Bedrock) tarjoamalla malliesi artefaktit saavutettavana S3-objektina. Vaihtoehtoisesti voit valita jonkin seuraavista valmiiksi koulutetut kielimallit ja ota se käyttöön SageMakerissa. Katso ohjeet päätepisteen ja mallien määrittämiseen Saatavilla Amazon SageMaker -kuvat.

SageMaker on täysin hallittu palvelu, joka kokoaa yhteen laajan joukon työkaluja, jotka mahdollistavat tehokkaan ja edullisen ML:n kaikissa käyttötapauksissa. Se tarjoaa keskeisiä etuja, kuten mallin valvonnan, palvelimettoman isännöinnin ja työnkulun automatisoinnin jatkuvaa koulutusta ja käyttöönottoa varten. SageMakerin avulla voit isännöidä ja hallita tekstin upotusmallien elinkaarta ja käyttää niitä semanttisten hakukyselyiden tehostamiseen OpenSearch Servicessä. Kun yhteys on muodostettu, SageMaker isännöi mallejasi ja OpenSearch-palvelua käytetään kyselyihin SageMakerin johtopäätöstulosten perusteella.

Tarkastele käyttöön otettua mallia OpenSearch-hallintapaneelien kautta

Voit varmistaa, että CloudFormation-malli on ottanut mallin käyttöön OpenSearch Service -verkkotunnuksessa ja saada mallitunnuksen, käyttämällä ML Commons REST GET -sovellusliittymää OpenSearch Dashboards Dev Toolsin kautta.

GET _plugins REST API tarjoaa nyt lisäsovellusliittymiä mallin tilan tarkasteluun. Seuraavan komennon avulla voit nähdä etämallin tilan:

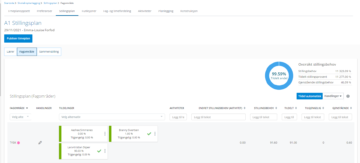

Kuten seuraavassa kuvakaappauksessa näkyy, a DEPLOYED vastauksen tila osoittaa, että malli on otettu käyttöön OpenSearch-palveluklusterissa.

Vaihtoehtoisesti voit tarkastella OpenSearch Service -verkkotunnuksessasi käyttöön otettua mallia käyttämällä Koneen oppiminen OpenSearch Dashboards -sivulla.

Tällä sivulla luetellaan mallin tiedot ja kaikkien käyttöön otettujen mallien tilat.

Luo hermoputki käyttämällä mallitunnusta

Kun mallin tila näkyy joko DEPLOYED Dev Toolsissa tai vihreällä ja vastaaminen OpenSearch Dashboardsissa voit käyttää mallitunnusta hermoston käsittelyputken rakentamiseen. Verkkotunnuksesi OpenSearch Dashboards Dev Tools -työkaluissa suoritetaan seuraava käsittelyputki. Varmista, että korvaat mallitunnuksen yksilöllisellä tunnuksella, joka on luotu verkkotunnuksessasi käyttöönotetulle mallille.

Luo semanttinen hakuindeksi käyttämällä hermoputkia oletusliukuhihnana

Voit nyt määrittää indeksikartoituksen oletusliukuhihnalla, joka on määritetty käyttämään uutta hermoputkilinjaa, jonka loit edellisessä vaiheessa. Varmista, että vektorikentät on ilmoitettu muodossa knn_vector ja mitat sopivat SageMakerissa käytettävään malliin. Jos olet säilyttänyt oletusasetukset all-MiniLM-L6-v2-mallin käyttöönottamiseksi SageMakerissa, säilytä seuraavat asetukset ennallaan ja suorita komento Dev Toolsissa.

Ota malliasiakirjoja vektoreiden luomiseksi

Tätä demoa varten voit käyttää näyte vähittäiskaupan demokaupan tuoteluettelosta uuteen semantic_demostore indeksi. Korvaa käyttäjänimi, salasana ja verkkotunnuksen päätepiste verkkotunnuksesi tiedoilla ja syötä raakadata OpenSearch-palveluun:

Vahvista uusi semantic_demostore-indeksi

Nyt kun olet syöttänyt tietojoukkosi OpenSearch Service -verkkotunnukseen, tarkista, onko vaaditut vektorit luotu yksinkertaisella haulla kaikkien kenttien hakemiseksi. Tarkista, onko kentät määritetty muodossa knn_vectors niillä on tarvittavat vektorit.

Vertaa leksikaalista hakua ja semanttista hakua hermohaun avulla käyttämällä Vertaa hakutuloksia -työkalua

- Vertaa hakutuloksia -työkalu OpenSearch Dashboardsissa on saatavilla tuotantotyökuormille. Voit navigoida kohteeseen Vertaa hakutuloksia sivua ja vertailla kyselyn tuloksia leksikaalisen haun ja hermohaun välillä, jotka on määritetty käyttämään aiemmin luotua mallitunnusta.

Puhdistaa

Voit poistaa luomasi resurssit noudattamalla tämän viestin ohjeita poistamalla CloudFormation-pinon. Tämä poistaa Lambda-resurssit ja S3-alueen, jotka sisältävät SageMakerissa käyttöön otetun mallin. Suorita seuraavat vaiheet:

- Siirry AWS CloudFormation -konsolissa pinon tietosivulle.

- Valita Poista.

- Valita Poista vahvistaa.

Voit seurata pinon poistamisen edistymistä AWS CloudFormation -konsolissa.

Huomaa, että CloudFormation-pinon poistaminen ei poista SageMaker-verkkotunnuksessa käyttöön otettua mallia ja luotua AI/ML-liitintä. Tämä johtuu siitä, että nämä mallit ja liitin voidaan liittää useisiin indekseihin toimialueen sisällä. Jos haluat poistaa mallin ja siihen liittyvän liittimen, käytä mallin sovellusliittymiä seuraavien kuvakaappausten mukaisesti.

Ensimmäinen, undeploy malli OpenSearch-palvelun toimialueen muistista:

Sitten voit poistaa mallin mallihakemistosta:

Poista lopuksi liitin liitinhakemistosta:

Yhteenveto

Tässä viestissä opit ottamaan mallin käyttöön SageMakerissa, luomaan AI/ML-liittimen OpenSearch Service -konsolin avulla ja rakentamaan hermohakuindeksin. Mahdollisuus määrittää AI/ML-liittimiä OpenSearch-palvelussa yksinkertaistaa vektorin hydratointiprosessia tekemällä integroinnista ulkoisiin malleihin natiivia. Voit luoda hermohakuindeksin minuuteissa käyttämällä hermohakua ja hermohakua, jotka käyttävät mallitunnusta vektorin upotuksen luomiseen lennossa käsittelyn ja haun aikana.

Lisätietoja näistä AI/ML-liittimistä on kohdassa Amazon OpenSearch Servicen AI-liittimet AWS-palveluille, AWS CloudFormation -malliintegraatiot semanttista hakua vartenja Liittimien luominen kolmannen osapuolen ML-alustoille.

Tietoja Tekijät

Aruna Govindaraju on Amazon OpenSearch Specialist Solutions Architect ja on työskennellyt monien kaupallisten ja avoimen lähdekoodin hakukoneiden kanssa. Hän on intohimoinen hakuun, osuvuuteen ja käyttökokemukseen. Hänen asiantuntemuksensa loppukäyttäjien signaalien korreloinnista hakukoneiden käyttäytymiseen on auttanut monia asiakkaita parantamaan hakukokemustaan.

Aruna Govindaraju on Amazon OpenSearch Specialist Solutions Architect ja on työskennellyt monien kaupallisten ja avoimen lähdekoodin hakukoneiden kanssa. Hän on intohimoinen hakuun, osuvuuteen ja käyttökokemukseen. Hänen asiantuntemuksensa loppukäyttäjien signaalien korreloinnista hakukoneiden käyttäytymiseen on auttanut monia asiakkaita parantamaan hakukokemustaan.

Dagney Braun on AWS:n päätuotepäällikkö, joka keskittyy OpenSearchiin.

Dagney Braun on AWS:n päätuotepäällikkö, joka keskittyy OpenSearchiin.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/big-data/power-neural-search-with-ai-ml-connectors-in-amazon-opensearch-service/

- :on

- :On

- :ei

- $ YLÖS

- 1

- 100

- 12

- 15%

- 2020

- 25

- 7

- 8

- 9

- a

- kyky

- Meistä

- pääsy

- saatavilla

- lisä-

- AI

- AI / ML

- Kaikki

- mahdollistaa

- Myös

- vaihtoehdot

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- an

- ja

- Kaikki

- api

- API

- Hakemus

- sopiva

- arkkitehtuuri

- OVAT

- AS

- liittyvä

- At

- Automaatio

- saatavissa

- AWS

- AWS-pilven muodostuminen

- taustaosa

- perustua

- BE

- koska

- käyttäytyminen

- Hyödyt

- välillä

- sekä

- Tuo

- laaja

- rakentaa

- Rakentaminen

- by

- CAN

- tapaus

- tapauksissa

- luettelo

- valinta

- Valita

- valittu

- Cluster

- kaupallinen

- Alahuone

- verrata

- täydellinen

- monimutkaisuus

- Konfigurointi

- määritetty

- konfigurointi

- Vahvistaa

- kytketty

- Kytkeminen

- liitäntä

- Console

- sisältää

- jatkaa

- jatkuva

- korreloivat

- luoda

- luotu

- luo

- Tällä hetkellä

- asiakassuhde

- Asiakkaat

- mittaristot

- tiedot

- oletusarvo

- määritellä

- määritelty

- tuottaa

- esittely

- osoittaa

- osoittaa

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- lauennut

- kuvaus

- yksityiskohtainen

- yksityiskohdat

- dev

- Ulottuvuus

- mitat

- asiakirjat

- ei

- verkkotunnuksen

- aikana

- kukin

- Aikaisemmin

- vaivaton

- myöskään

- upottamisen

- mahdollistaa

- päätepiste

- Moottori

- Moottorit

- varmistaa

- Eetteri (ETH)

- esimerkki

- experience

- asiantuntemus

- ulkoinen

- Kasvot

- Helpottaa

- Ominaisuus

- Fields

- Löytää

- Etunimi

- keskityttiin

- jälkeen

- varten

- Puitteet

- alkaen

- täysin

- tuottaa

- syntyy

- synnyttää

- saada

- gif

- GitHub

- Vihreä

- Kasvaa

- ohjaavat

- Olla

- auttanut

- hänen

- korkea suorituskyky

- isäntä

- hotellit

- isännät

- Miten

- Miten

- Kuitenkin

- HTML

- http

- HTTPS

- HalaaKasvot

- nesteytys

- IAM

- ID

- tunnistaa

- Identiteetti

- if

- parantaa

- in

- indeksi

- indeksit

- ilmaisee

- tiedot

- tuloa

- sen sijaan

- ohjeet

- yhdistää

- integraatio

- integraatiot

- tulee

- esittely

- IT

- SEN

- jpg

- json

- Pitää

- avain

- Kieli

- käynnistää

- OPPIA

- oppinut

- oppiminen

- elinkaari

- Lista

- Listat

- edullisia

- kone

- koneoppiminen

- tehdä

- Tekeminen

- hoitaa

- onnistui

- johtaja

- monet

- kartta

- kartoitus

- Muisti

- menetelmä

- pöytäkirja

- ML

- malli

- mallit

- monitori

- seuranta

- lisää

- paljon

- moninkertainen

- täytyy

- nimi

- syntyperäinen

- Navigoida

- suunnistus

- välttämätön

- Tarve

- hermo-

- Uusi

- nyt

- objekti

- of

- on

- ONE

- vain

- avata

- avoimen lähdekoodin

- or

- Muut

- ulostulo

- sivulla

- lasi

- intohimoinen

- Salasana

- Oikeudet

- putki

- Platon

- Platonin tietotieto

- PlatonData

- kytkeä

- Kirje

- teho

- powered

- edellinen

- Pääasiallinen

- Aikaisempi

- prosessi

- prosessorit

- Tuotteet

- tuotepäällikkö

- tuotanto

- Edistyminen

- ominaisuudet

- toimittaa

- tarjoaa

- tarjoamalla

- tarkoitus

- kyselyt

- raaka

- raakadata

- suositella

- katso

- kaukosäädin

- poistamalla

- korvata

- tarvitaan

- Esittelymateriaalit

- vastaus

- REST

- tulokset

- vähittäiskauppa

- säilytetään

- palata

- Rooli

- reitit

- ajaa

- sagemaker

- kuvakaappauksia

- Haku

- hakukone

- Hakukoneet

- turvallisuus

- nähdä

- valita

- palvella

- serverless

- palvelu

- Palvelut

- setti

- settings

- hän

- esitetty

- Näytä

- signaalit

- Yksinkertainen

- yksinkertaistetaan

- yksinkertaistaa

- koska

- Ratkaisumme

- lähde

- asiantuntija

- erityisesti

- pino

- Aloita

- Tila

- Vaihe

- Askeleet

- Levytila

- Onnistuneesti

- niin

- Tuetut

- varma

- sapluuna

- teksti

- että

- -

- heidän

- Niitä

- sitten

- siten

- Nämä

- kolmannen osapuolen

- tätä

- Kautta

- että

- yhdessä

- työkalut

- koulutus

- Muutos

- Kääntäminen

- totta

- tyyppi

- ui

- unique

- ainoastaan

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjäkokemus

- käyttämällä

- VAHVISTA

- todentaa

- versio

- kautta

- Video

- Näytä

- kävelee

- oli

- we

- verkko

- verkkopalvelut

- kun

- joka

- tulee

- with

- sisällä

- työskenteli

- työnkulku

- työnkulun automaatio

- te

- Sinun

- zephyrnet