Tämä on Qualcomm AI:n AK Royn vieraspostaus.

Amazon Elastic Compute Cloud (Amazon EC2) Qualcomm AI 2 Standard -kiihdyttimien tuottamia DL100q-instanssien avulla voidaan kustannustehokkaasti ottaa käyttöön syvän oppimisen (DL) työkuormia pilvessä. Niitä voidaan myös käyttää Qualcomm-laitteissa käyttöönotettavien DL-työkuormien suorituskyvyn ja tarkkuuden kehittämiseen ja vahvistamiseen. DL2q-instanssit ovat ensimmäiset esiintymät, jotka tuovat Qualcommin keinotekoisen älykkään (AI) -teknologian pilveen.

Kahdeksalla Qualcomm AI 100 Standard -kiihdyttimellä ja 128 gigatavulla kiihdytinmuistilla asiakkaat voivat myös käyttää DL2q-instanssia suosittujen luovien tekoälysovellusten, kuten sisällön luomiseen, tekstin yhteenvetoon ja virtuaaliassistenttien, sekä klassisten tekoälysovellusten suorittamiseen luonnollisen kielen käsittelyyn. ja tietokonenäkö. Lisäksi Qualcomm AI 100 -kiihdyttimissä on sama AI-tekniikka, jota käytetään älypuhelimissa, autonomisessa ajamisessa, henkilökohtaisissa tietokoneissa ja laajennetun todellisuuden kuulokkeissa, joten DL2q-instanssien avulla voidaan kehittää ja validoida näitä tekoälyn työkuormia ennen käyttöönottoa.

Uudet DL2q-esiintymän kohokohdat

Jokainen DL2q-esiintymä sisältää kahdeksan Qualcomm Cloud AI100 -kiihdytintä, joiden yhteenlaskettu suorituskyky on yli 2.8 PetaOps of Int8 -johtopäätössuorituskykyä ja 1.4 PetaFlops of FP16 -päätelmäsuorituskykyä. Instanssissa on yhteensä 112 AI-ydintä, kiihdytinmuistikapasiteetti 128 Gt ja muistin kaistanleveys 1.1 TB sekunnissa.

Jokaisessa DL2q-esiintymässä on 96 vCPU:ta, järjestelmämuistikapasiteetti 768 Gt ja se tukee 100 Gbps:n verkkokaistanleveyttä sekä Amazon Elastic Block Store (Amazon EBS) tallennus 19 Gbps.

| Esineen nimi | vCPU: t | Cloud AI100 -kiihdytin | Kiihdytin muisti | Kiihdytinmuisti BW (aggregoitu) | Esimerkkimuisti | Esineiden verkostoituminen | Tallennus (Amazon EBS) kaistanleveys |

| DL2q.24xsuuri | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 -kiihdytininnovaatio

Cloud AI100 -kiihdytin system-on-chip (SoC) on tarkoitukseen rakennettu, skaalautuva moniytiminen arkkitehtuuri, joka tukee laajaa valikoimaa syvälle oppivia käyttötapauksia, jotka ulottuvat palvelinkeskuksesta reunaan. SoC käyttää skalaari-, vektori- ja tensorilaskentaytimiä alan johtavalla 126 Mt:n SRAM-muistilla. Ytimet on yhdistetty suuren kaistanleveyden matalan latenssin verkko-sirulla (NoC) -verkkoon.

AI100-kiihdytin tukee laajaa ja kattavaa valikoimaa malleja ja käyttötapauksia. Alla oleva taulukko korostaa mallituen valikoimaa.

| Malliluokka | Lukumäärä mallien | Esimerkkejä |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-koodi MOE |

| Generatiivinen AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generatiivinen tekoäly – kuva | 3 | Vakaa diffuusio v1.5 ja v2.1, OpenAI CLIP |

| CV – Kuvaluokitus | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Objektin tunnistus | 23 | YOLO v2, v3, v4, v5 ja v7, SSD-ResNet, RetinaNet |

| CV – muu | 15 | LPRnet, superresoluutio/SRGAN, ByteTrack |

| Autoalan verkostot* | 53 | Havainto ja LIDAR, jalankulkijan, kaistan ja liikennevalojen tunnistus |

| Kaikki yhteensä | > 300 ---- | ---- |

* Useimmat autoteollisuuden verkot ovat yhdistelmäverkkoja, jotka koostuvat yksittäisten verkkojen fuusiosta.

DL2q-kiihdyttimen suuri sisäänrakennettu SRAM mahdollistaa edistyneiden suorituskykytekniikoiden tehokkaan toteutuksen, kuten MX6-mikroeksponenttitarkkuuden painojen tallentamiseen ja MX9-mikroeksponentin tarkkuuden kiihdytin-kiihdytin-kommunikaatioon. Mikroeksponenttitekniikka on kuvattu seuraavassa Open Compute Project (OCP) -alan ilmoituksessa: AMD, Arm, Intel, Meta, Microsoft, NVIDIA ja Qualcomm standardoivat seuraavan sukupolven kapeita tarkkuusdatamuotoja tekoälylle » Open Compute Project.

Ilmentymän käyttäjä voi käyttää seuraavaa strategiaa maksimoidakseen tehokkuuden hintakohtaisesti:

- Tallenna painot MX6-mikroeksponenttitarkkuudella kiihdyttimen DDR-muistiin. MX6-tarkkuuden käyttö maksimoi käytettävissä olevan muistikapasiteetin ja muistin kaistanleveyden käytön luokkansa parhaan suorituskyvyn ja latenssin saavuttamiseksi.

- Laske FP16:ssa saadaksesi vaaditun käyttötapauksen tarkkuuden, samalla kun käytät ylivoimaista sirulla olevaa SRAM-muistia ja kortin vara-TOP-kortteja, jotta voit toteuttaa tehokkaat matalan latenssin MX6–FP16-ytimet.

- Käytä optimoitua erästrategiaa ja suurempaa eräkokoa käyttämällä käytettävissä olevaa suurta sirulla olevaa SRAM-muistia painojen uudelleenkäytön maksimoimiseksi, samalla kun aktivoit sirulla mahdollisimman paljon.

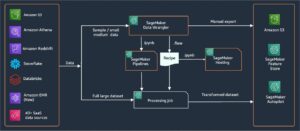

DL2q AI pino ja työkaluketju

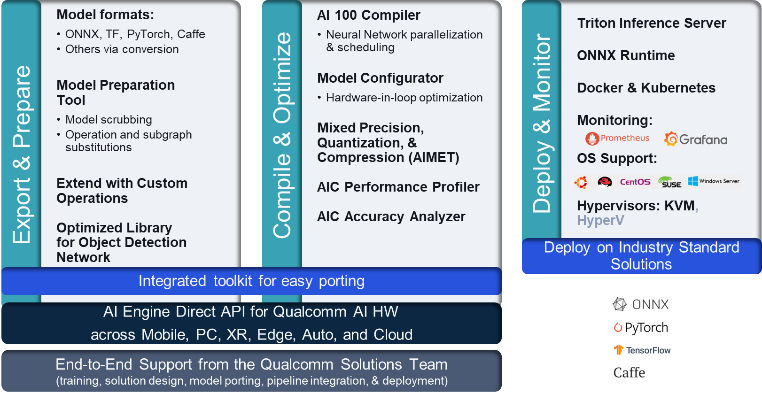

DL2q-esiintymän mukana tulee Qualcomm AI Stack, joka tarjoaa yhtenäisen kehittäjäkokemuksen Qualcomm AI:lle pilvessä ja muissa Qualcommin tuotteissa. Sama Qualcomm AI pino ja perus AI -tekniikka toimii DL2q-esiintymissä ja Qualcomm Edge -laitteissa, mikä tarjoaa asiakkaille yhtenäisen kehittäjäkokemuksen ja yhtenäisen APIn pilvi-, auto-, tietokone-, laajennetun todellisuuden ja älypuhelinkehitysympäristöissä.

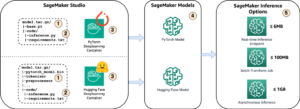

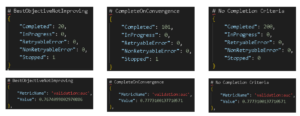

Työkaluketjun avulla ilmentymän käyttäjä voi nopeasti omaksua aiemmin koulutetun mallin, koota ja optimoida mallin ilmentymien ominaisuuksien mukaan ja ottaa sen jälkeen käyttöön käännetyt mallit tuotantopäätelmien käyttötapauksissa seuraavassa kuvassa esitetyssä kolmessa vaiheessa.

Lisätietoja mallin suorituskyvyn säätämisestä on kohdassa Cloud AI 100 Key Performance Parameters Dokumentointi.

Aloita DL2q-esiintymien käyttö

Tässä esimerkissä käännät ja otat käyttöön esikoulutetun BERT malli alkaen Halaaminen kasvot EC2 DL2q -esiintymässä käyttämällä valmiiksi rakennettua saatavilla olevaa DL2q AMI:tä neljässä vaiheessa.

Voit käyttää joko valmiiksi rakennettua Qualcomm DLAMI tai aloita Amazon Linux2 AMI:llä ja rakenna oma DL2q AMI Cloud AI 100 -alustan ja Apps SDK:n avulla. Amazonin yksinkertainen tallennuspalvelu (Amazon S3) ämpäri: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Seuraavissa vaiheissa käytetään valmiiksi rakennettua DL2q AMI:tä, Qualcomm Base AL2 DLAMI.

Käytä SSH:ta päästäksesi DL2q-esiintymääsi Qualcomm Base AL2 DLAMI AMI:n avulla ja seuraa vaiheita 1–4.

Vaihe 1. Määritä ympäristö ja asenna tarvittavat paketit

- Asenna Python 3.8.

- Asenna Python 3.8 -virtuaaliympäristö.

- Aktivoi Python 3.8 -virtuaaliympäristö.

- Asenna tarvittavat paketit, jotka näkyvät kohdassa követelmények.txt-tiedosto saatavilla Qualcommin julkiselta Github-sivustolta.

- Tuo tarvittavat kirjastot.

Vaihe 2. Tuo malli

- Tuo malli ja tokenoi se.

- Määritä näytesyöttö ja pura se

inputIdsjaattentionMask. - Muunna malli ONNX:ksi, joka voidaan sitten välittää kääntäjälle.

- Käytät mallia FP16-tarkkuudella. Joten sinun on tarkistettava, sisältääkö malli vakioita FP16-alueen ulkopuolella. Välitä malli

fix_onnx_fp16-toiminnolla luodaan uusi ONNX-tiedosto, jossa on tarvittavat korjaukset.

Vaihe 3. Kokoa malli

- qaic-exec Mallin kääntämiseen käytetään komentoriviliittymän (CLI) kääntäjätyökalua. Tämän kääntäjän syöte on vaiheessa 2 luotu ONNX-tiedosto. Kääntäjä tuottaa binääritiedoston (ns. QPCVarten Qualcomm-ohjelmasäiliö) määrittämällä polulla -aic-binary-dir Perustelu.

Alla olevassa käännöskomennossa käytät neljää tekoälylaskentaydintä ja yhden eräkokoa mallin kääntämiseen.

QPC luodaan bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc kansio.

Vaihe 4. Suorita malli

Määritä istunto suorittaaksesi päättelyn Cloud AI100 Qualcomm -kiihdyttimellä DL2q-instanssissa.

Qualcomm qaic Python -kirjasto on joukko API-liittymiä, jotka tukevat päättelyjen suorittamista Cloud AI100 -kiihdytinssä.

- Käytä Session API -kutsua istunnon esiintymän luomiseen. Session API -kutsu on aloituskohta qaic Python -kirjaston käyttöön.

- Järjestä tiedot uudelleen lähtöpuskurista käyttämällä

output_shapejaoutput_type. - Dekoodaa tuotettu tulos.

Tässä ovat ulostulot syöttölauseelle "Koira [MASKI] matolla".

Se siitä. Muutamalla askeleella käänsit ja suoritit PyTorch-mallin Amazon EC2 DL2q -esiintymässä. Lisätietoja DL2q-esiintymän mallien käyttöönotosta ja kääntämisestä on kohdassa Cloud AI100 -opastusdokumentaatio.

Saat lisätietoja siitä, mitkä DL-malliarkkitehtuurit sopivat hyvin AWS DL2q -esiintymiin ja nykyiseen mallin tukimatriisiin, katso Qualcomm Cloud AI100 -dokumentaatio.

Saatavana nyt

Voit käynnistää DL2q-esiintymiä tänään Yhdysvaltain länsiosassa (Oregon) ja Euroopassa (Frankfurt) AWS-alueilla Tarpeen vaatiessa, varattuja Paikalliset tapaukset, tai osana a Säästösuunnitelma. Kuten tavallista Amazon EC2:n kanssa, maksat vain siitä, mitä käytät. Katso lisätietoja Amazon EC2 -hinnoittelu.

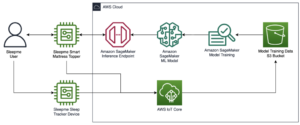

DL2q-ilmentymiä voidaan ottaa käyttöön käyttämällä AWS Deep Learning AMI (DLAMI), ja säilökuvat ovat saatavilla hallittujen palveluiden, kuten Amazon Sage Maker, Amazon Elastic Kubernetes Service (Amazon EKS), Amazonin elastisten säiliöiden palvelu (Amazon ECS)ja AWS ParallelCluster.

Lisätietoja saat käymällä Amazon EC2 DL2q -esiintymä sivulle ja lähetä palautetta osoitteeseen AWS re:Post for EC2 tai tavallisten AWS-tukikontaktiesi kautta.

Tietoja kirjoittajista

AK Roy on Qualcommin tuotehallinnan johtaja pilvi- ja datakeskuksen tekoälytuotteista ja -ratkaisuista. Hänellä on yli 20 vuoden kokemus tuotestrategiasta ja -kehityksestä. Hän keskittyy tällä hetkellä luokkansa parhaaseen suorituskykyyn / $ päästä päähän -ratkaisuihin tekoälyn päättelyyn pilvessä, monenlaisiin käyttötapauksiin, mukaan lukien GenAI, LLM:t, Auto ja Hybrid AI.

AK Roy on Qualcommin tuotehallinnan johtaja pilvi- ja datakeskuksen tekoälytuotteista ja -ratkaisuista. Hänellä on yli 20 vuoden kokemus tuotestrategiasta ja -kehityksestä. Hän keskittyy tällä hetkellä luokkansa parhaaseen suorituskykyyn / $ päästä päähän -ratkaisuihin tekoälyn päättelyyn pilvessä, monenlaisiin käyttötapauksiin, mukaan lukien GenAI, LLM:t, Auto ja Hybrid AI.

Jianying Lang on pääratkaisuarkkitehti AWS Worldwide Specialist Organizationissa (WWSO). Hänellä on yli 15 vuoden työkokemus HPC- ja tekoälyalalta. AWS:ssä hän keskittyy auttamaan asiakkaita ottamaan käyttöön, optimoimaan ja skaalaamaan tekoälyn/ML-työkuormituksensa nopeutetuissa laskentatapauksissa. Hän on intohimoinen HPC:n ja tekoälyn tekniikoiden yhdistämisestä. Jianyingilla on tohtorin tutkinto laskennallisesta fysiikasta Coloradon yliopistosta Boulderissa.

Jianying Lang on pääratkaisuarkkitehti AWS Worldwide Specialist Organizationissa (WWSO). Hänellä on yli 15 vuoden työkokemus HPC- ja tekoälyalalta. AWS:ssä hän keskittyy auttamaan asiakkaita ottamaan käyttöön, optimoimaan ja skaalaamaan tekoälyn/ML-työkuormituksensa nopeutetuissa laskentatapauksissa. Hän on intohimoinen HPC:n ja tekoälyn tekniikoiden yhdistämisestä. Jianyingilla on tohtorin tutkinto laskennallisesta fysiikasta Coloradon yliopistosta Boulderissa.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :on

- :On

- $ YLÖS

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 vuotta

- 15%

- 17

- 19

- 20

- 20 vuotta

- 22

- 23

- 46

- 7

- 75

- 8

- 84

- a

- Meistä

- edellä

- kiihtyi

- kiihdytin

- kiihdyttimiä

- pääsy

- liitettävä

- tarkkuus

- poikki

- aktivoinnit

- Lisäksi

- kehittynyt

- aggregaatti

- AI

- AI / ML

- Kaikki

- Myös

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- ja

- Ilmoitus

- Kaikki

- api

- API

- sovellukset

- sovellukset

- arkkitehtuuri

- OVAT

- perustelu

- ARM

- keinotekoinen

- AS

- avustajat

- At

- auto

- Automotive

- autonominen

- saatavissa

- AWS

- AKSELIT

- kaistanleveys

- pohja

- annostelu-

- BE

- ennen

- alle

- Jälkeen

- BIN

- Tukkia

- Kukinta

- tuoda

- laaja

- puskuri

- rakentaa

- by

- soittaa

- nimeltään

- CAN

- kyvyt

- Koko

- kortti

- tapaus

- tarkastaa

- klassinen

- pilvi

- Colorado

- yhdistely

- Viestintä

- koottu

- kattava

- laskennallinen

- Laskea

- tietokone

- Tietokoneen visio

- tietokoneet

- tietojenkäsittely

- johdonmukainen

- Koostuu

- Yhteydet

- Kontti

- sisältää

- pitoisuus

- luoda

- Nykyinen

- Asiakkaat

- tiedot

- Datacenter

- syvä

- syvä oppiminen

- määritelty

- Aste

- toimittaa

- Antaa

- sijoittaa

- käyttöön

- käyttöönotto

- on kuvattu

- kehittää

- Kehittäjä

- Kehitys

- laite

- Laitteet

- Diffuusio

- Johtaja

- dokumentointi

- Koira

- ajo

- dynaaminen

- EBS

- reuna

- tehokas

- myöskään

- työllistää

- mahdollistaa

- päittäin

- merkintä

- ympäristö

- ympäristöissä

- Eetteri (ETH)

- Eurooppa

- esimerkki

- experience

- laajennettu todellisuus

- uute

- väärä

- Ominaisuus

- palaute

- harvat

- ala

- Fields

- Kuva

- filee

- Etunimi

- sovittaa

- korjaukset

- Keskittää

- keskittyy

- seurata

- jälkeen

- varten

- löytyi

- neljä

- Frankfurt

- alkaen

- toiminto

- fuusio

- yleensä

- tuottaa

- syntyy

- sukupolvi

- generatiivinen

- Generatiivinen AI

- GitHub

- tietty

- hyvä

- vieras

- vieras Lähetä

- he

- kuulokkeet

- auttaa

- tätä

- korkea suorituskyky

- korkeampi

- raidat

- pitää

- hpc

- HTML

- HTTPS

- Hybridi

- i

- IDX

- if

- kuva

- kuvien

- toteuttaa

- täytäntöönpano

- tuoda

- in

- Mukaan lukien

- sisältää

- henkilökohtainen

- teollisuus

- alan johtava

- tiedot

- panos

- asentaa

- esimerkki

- tapauksia

- Intel

- Älykäs

- toisiinsa

- liitäntä

- IT

- jpg

- vain

- avain

- Kubernetes

- kaista

- Kieli

- suuri

- Viive

- käynnistää

- OPPIA

- oppiminen

- kirjastot

- Kirjasto

- käsitellä

- valo

- linja

- kuormat

- onnistui

- johto

- naamio

- Matriisi

- max

- Maksimoida

- Maksimoi

- maksimi

- Muisti

- verkko

- Meta

- Microsoft

- minuuttia

- malli

- mallit

- muokattu

- lisää

- eniten

- nimi

- Luonnollinen

- Luonnollinen kieli

- Luonnollinen kielen käsittely

- välttämätön

- Tarve

- verkko

- verkostoituminen

- verkot

- Uusi

- seuraavan sukupolven

- nyt

- numpy

- Nvidia

- objekti

- of

- on

- Laivalla

- perehdytyksessä

- ONE

- vain

- avata

- OpenAI

- Optimoida

- optimoitu

- or

- Oregon

- organisaatio

- OS

- Muut

- ulos

- ulostulo

- lähdöt

- yli

- oma

- paketit

- sivulla

- osa

- kulkea

- Hyväksytty

- intohimoinen

- polku

- Maksaa

- varten

- suorituskyky

- henkilöstö

- Henkilökohtaiset tietokoneet

- phd

- Fysiikka

- foorumi

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- Suosittu

- mahdollinen

- Kirje

- powered

- Tarkkuus

- aiemmin

- Pääasiallinen

- käsittely

- valmistettu

- tuottaa

- Tuotteet

- tuotehallinta

- tuotanto

- Tuotteemme

- Ohjelma

- projekti

- tarjoaa

- tarjoamalla

- julkinen

- Python

- pytorch

- Qualcomm

- nopeasti

- alue

- RE

- Lukeminen

- Todellisuus

- alueet

- tarvitaan

- vaatimukset

- säilyttäen

- palata

- uudelleenkäyttö

- roy

- ajaa

- juoksu

- toimii

- sama

- Säästä

- tallentaa

- skaalautuva

- Asteikko

- sdk

- Toinen

- nähdä

- lähettää

- tuomita

- Järjestys

- palvelu

- Palvelut

- Istunto

- setti

- hän

- esitetty

- Yksinkertainen

- yksinkertaistaa

- paikka

- Koko

- älypuhelin

- älypuhelimet

- So

- Ratkaisumme

- jännitys

- asiantuntija

- pino

- standardi

- Alkaa

- alkoi

- Vaihe

- Askeleet

- Levytila

- verkkokaupasta

- Strategia

- Myöhemmin

- niin

- esimies

- tuki

- Tukea

- Tukee

- järjestelmä

- taulukko

- tekniikat

- Elektroniikka

- teksti

- että

- -

- heidän

- sitten

- Nämä

- ne

- tätä

- kolmella

- Kautta

- suoritusteho

- kautta

- että

- tänään

- merkitä

- työkalu

- Topit

- taskulamppu

- Yhteensä

- liikenne

- koulutettu

- muuntajat

- totta

- oppitunti

- yhdistynyt

- yliopisto

- us

- käyttää

- käyttölaukku

- Käytä koteloita

- käytetty

- käyttäjä

- käyttämällä

- tavallinen

- v1

- VAL

- VAHVISTA

- arvo

- Virtual

- visio

- Vierailla

- we

- verkko

- verkkopalvelut

- HYVIN

- Länsi

- Mitä

- joka

- vaikka

- leveä

- Laaja valikoima

- tulee

- with

- sana

- työskentely

- maailmanlaajuisesti

- vuotta

- te

- Sinun

- zephyrnet