Josh Lospinosos erstes Cybersicherheits-Startup wurde 2017 von Raytheon/Forcepoint übernommen. Sein Stellvertreter, Shift5, arbeitet mit dem US-Militär, Bahnbetreibern und Fluggesellschaften, darunter JetBlue, zusammen. Der 2009-jährige ehemalige Hauptmann der Armee, Absolvent von West Point 36 und Rhodes-Stipendiat, verbrachte mehr als ein Jahrzehnt damit Erstellung von Hacking-Tools für die National Security Agency und das US Cyber Command.

Lospinoso erklärte kürzlich einem Unterausschuss für Streitkräfte des Senats, wie künstliche Intelligenz zum Schutz militärischer Operationen beitragen kann. Der CEO/Programmierer diskutierte das Thema mit The Associated Press und wie Software-Schwachstellen in Waffensystemen eine große Bedrohung für das US-Militär darstellen. Das Interview wurde aus Gründen der Klarheit und Länge bearbeitet.

F: In Ihrer Aussage haben Sie zwei Hauptbedrohungen für KI-gestützte Technologien beschrieben: Die eine ist Diebstahl. Das ist selbsterklärend. Das andere ist Datenvergiftung. Kannst du das erklären?

A: Eine Art, über Datenvergiftung nachzudenken, ist die digitale Desinformation. Wenn es Angreifern gelingt, die Daten zu manipulieren, die KI-gestützte Technologien sehen, können sie die Funktionsweise dieser Technologie tiefgreifend beeinflussen.

F: Kommt es zu einer Datenvergiftung?

A: Wir sehen es nicht allgemein. Aber es ist geschehen. Einer der bekanntesten Fälle ereignete sich im Jahr 2016. Microsoft veröffentlichte einen Twitter-Chatbot namens Tay, der aus Online-Gesprächen lernte. Böswillige Benutzer haben sich verschworen, um beleidigende und beleidigende Ausdrücke zu twittern. Tay begann, hetzerische Inhalte zu erzeugen. Microsoft hat es offline genommen.

F: KI besteht nicht nur aus Chatbots. Es ist schon lange ein wesentlicher Bestandteil der Cybersicherheit, oder?

A: KI wird in E-Mail-Filtern verwendet, um zu versuchen, Junk-Mails und Phishing-Köder zu kennzeichnen und zu trennen. Ein weiteres Beispiel sind Endpunkte, wie das Antivirenprogramm auf Ihrem Laptop – oder Malware-Erkennungssoftware, die in Netzwerken ausgeführt wird. Natürlich nutzen auch offensive Hacker KI, um diese Klassifizierungssysteme zu umgehen. Das nennt man gegnerische KI.

F: Reden wir über militärische Softwaresysteme. Ein alarmierendes Jahr 2018 Bericht des Government Accountability Office sagte, dass fast alle neu entwickelten Waffensysteme geschäftskritische Schwachstellen aufwiesen. Und das Pentagon denkt darüber nach, KI in solche Systeme einzubauen?

A: Hier gibt es zwei Probleme. Erstens müssen wir die bestehenden Waffensysteme ausreichend sichern. Das ist eine technische Schuld, die wir haben und deren Begleichung sehr lange dauern wird. Dann gibt es eine neue Grenze zur Sicherung von KI-Algorithmen – neuartige Dinge, die wir installieren würden. Der GAO-Bericht sprach nicht wirklich über KI. Vergessen Sie also für eine Sekunde die KI. Wenn diese Systeme einfach so bleiben, wie sie sind, sind sie immer noch zutiefst verwundbar.

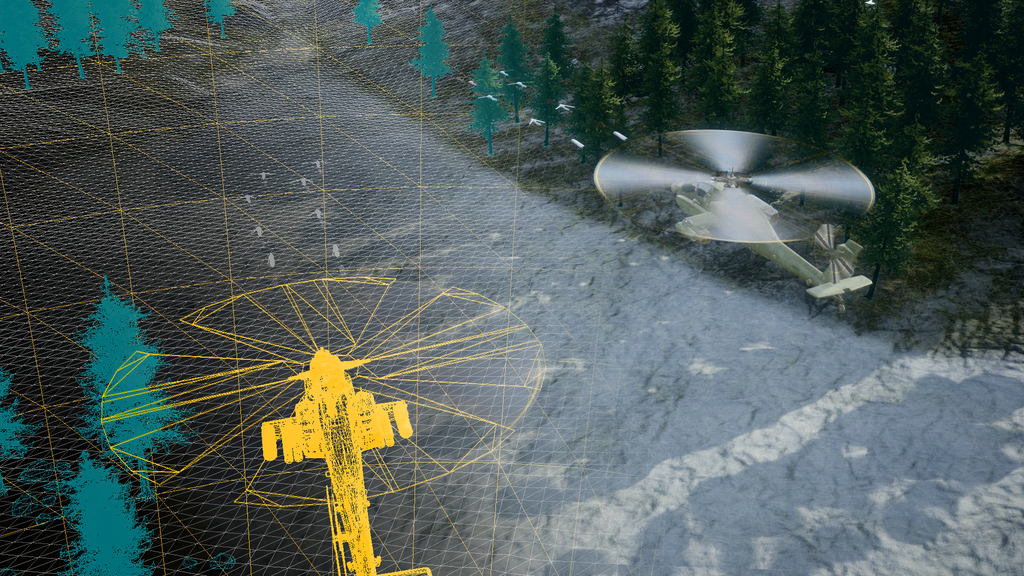

Wir diskutieren darüber, an die Grenzen zu gehen und KI-gestützte Funktionen für Dinge wie verbesserte Wartung und Betriebsintelligenz hinzuzufügen. Alles Gut. Aber wir bauen auf einem Kartenhaus. Viele Systeme sind Jahrzehnte alt und mit digitalen Technologien nachgerüstet. Flugzeuge, Bodenfahrzeuge, Raumfahrzeuge, U-Boote. Sie sind jetzt miteinander verbunden. Wir tauschen Daten ein und aus. Die Systeme sind porös, schwer zu aktualisieren und könnten angegriffen werden. Sobald sich ein Angreifer Zugang verschafft, ist das Spiel vorbei.

Manchmal ist es einfacher, eine neue Plattform aufzubauen, als die digitalen Komponenten bestehender Systeme neu zu gestalten. Bei der Sicherung dieser Systeme spielt die KI jedoch eine Rolle. KI kann zur Verteidigung eingesetzt werden, wenn jemand versucht, sie zu kompromittieren.

F: Sie haben ausgesagt, dass es eine schlechte Idee wäre, die KI-Forschung einzustellen, wie einige gefordert haben, weil dadurch China und andere Konkurrenten begünstigt würden. Sie haben aber auch Bedenken wegen des rasanten Ansturms auf KI-Produkte. Warum?

A: Ich hasse es, fatalistisch zu klingen, aber der sogenannte „Burn-Use“-Fall scheint zuzutreffen. Ein überstürzt auf den Markt gebrachtes Produkt fängt oft Feuer (wird gehackt, versagt, verursacht unbeabsichtigten Schaden). Und wir sagen: „Junge, wir hätten Sicherheit einbauen sollen.“ Ich gehe davon aus, dass sich das Tempo der KI-Entwicklung beschleunigen wird, und wir werden möglicherweise nicht genug innehalten, um dies auf sichere und verantwortungsvolle Weise zu tun. Zumindest diskutieren das Weiße Haus und der Kongress über diese Themen.

F: Es scheint, als ob eine Reihe von Unternehmen – auch aus dem Verteidigungssektor – sich beeilen, unausgegorene KI-Produkte anzukündigen.

A: Jedes Technologieunternehmen und viele Nicht-Technologieunternehmen haben eine fast überraschende Wende in Richtung KI vollzogen. Es kommen wirtschaftliche Verwerfungen. Geschäftsmodelle werden sich grundlegend ändern. Verwerfungen sind bereits im Gange oder zeichnen sich ab – und Unternehmensführer versuchen, nicht auf dem falschen Fuß erwischt zu werden.

F: Wie sieht es mit dem Einsatz von KI bei militärischen Entscheidungen wie der Zielerfassung aus?

A: Ich glaube nicht und kategorisch nicht, dass die Algorithmen der künstlichen Intelligenz – die Daten, die wir sammeln – bereit sind für die Entscheidungsfindung eines tödlichen Waffensystems. Davon sind wir einfach so weit entfernt.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Kaufen und verkaufen Sie Anteile an PRE-IPO-Unternehmen mit PREIPO®. Hier zugreifen.

- Quelle: https://www.defensenews.com/artificial-intelligence/2023/05/29/adversarial-ai-a-threat-to-military-systems-shift5s-lospinoso-says/

- :hast

- :Ist

- :nicht

- 2016

- 2017

- 2018

- 70

- a

- Fähig

- Über uns

- beschleunigen

- Zugang

- Rechenschaftspflicht

- erworben

- Hinzufügen

- angemessen

- widersprüchlich

- Agentur

- AI

- ai Forschung

- Flugzeug

- Fluggesellschaften

- Algorithmen

- Alle

- bereits

- ebenfalls

- an

- und

- Bekannt geben

- Ein anderer

- Antivirus

- Jetzt bewerben

- SIND

- bewaffnet

- Armee

- künstlich

- künstliche Intelligenz

- AS

- Details

- damit verbundenen

- At

- Badewanne

- BE

- weil

- war

- begann

- allgemein

- bauen

- Building

- erbaut

- Haufen

- Geschäft

- aber

- by

- namens

- CAN

- Fähigkeiten

- Karten

- Häuser

- Fälle

- gefangen

- Übernehmen

- Chatbot

- Chatbots

- China

- Clarity

- Einstufung

- Das Sammeln

- Kommen

- Unternehmen

- Unternehmen

- Konkurrenz

- Komponenten

- Kompromiss

- Bedenken

- Kongress

- Inhalt

- Gespräche

- könnte

- Kurs

- Handwerk

- kritischem

- Cyber-

- Internet-Sicherheit

- technische Daten

- Schulden

- Jahrzehnte

- Jahrzehnte

- Decision Making

- Entscheidungen

- Militär

- beschrieben

- Entdeckung

- entwickelt

- Entwicklung

- digital

- diskutiert

- diskutieren

- Desinformation

- do

- die

- einfacher

- Wirtschaftlich

- genug

- Jedes

- Beispiel

- vorhandenen

- erwarten

- Erklären

- scheitert

- weit

- Favor

- Filter

- Feuer

- Vorname

- Aussichten für

- Früher

- für

- Grenze

- grundlegend

- Gewinne

- Spiel

- GAO

- erzeugen

- bekommen

- gehen

- groß

- Boden

- gehackt

- Hacker

- Hacking

- hätten

- passiert

- Los

- hart

- Haben

- kopfüber

- Hilfe

- hier

- seine

- Horizont

- Häuser

- Ultraschall

- HTTPS

- i

- Idee

- if

- Bilder

- Impact der HXNUMXO Observatorien

- verbessert

- in

- Einschließlich

- installieren

- Integral

- Intelligenz

- verbunden

- Interview

- in

- Probleme

- IT

- jetBlue

- nur

- Sprache

- Laptop

- Führung

- gelernt

- am wenigsten

- Länge

- Gefällt mir

- Lang

- lange Zeit

- gemacht

- Wartung

- Dur

- Making

- Malware

- Malware-Erkennung

- viele

- Markt

- Microsoft

- könnte

- Militär

- Ziel

- für

- mehr

- Namens

- National

- nationale Sicherheit

- National Security Agency

- fast

- Need

- Netzwerke

- Neu

- Neue Plattform

- Roman

- jetzt an

- aufgetreten

- of

- Offensive

- Office

- Offline-Bereich.

- vorgenommen,

- Alt

- on

- einmal

- EINEM

- Online

- arbeitet

- Betriebs-

- Einkauf & Prozesse

- Betreiber

- or

- Andere

- übrig

- Frieden

- Pause

- AUFMERKSAMKEIT

- Pentagon

- Phishing

- Drehpunkt

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Presse

- Prime

- Principal

- Produkt

- Produkte

- Programm

- Risiken zu minimieren

- Schieben

- Putting

- Schiene

- bereit

- wirklich

- kürzlich

- Redesign

- freigegeben

- berichten

- Forschungsprojekte

- für ihren Verlust verantwortlich.

- Recht

- Rollen

- überstürzen

- s

- Said

- sagen

- sagt

- Zweite

- Bibliotheken

- Verbindung

- Sicherung

- Sicherheitdienst

- sehen

- Sehen

- scheint

- Senat

- Leistungen

- sollte

- So

- bis jetzt

- Software

- einige

- Jemand,

- Klingen

- Raumfahrt

- verbrachte

- Anfang

- blieb

- Immer noch

- Unterausschuss

- Fach

- so

- Austausch

- System

- Systeme und Techniken

- Nehmen

- Reden

- Targeting

- Tech

- Technologieunternehmen

- Technische

- Technologies

- Technologie

- bezeugt

- Zeugnis

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Diebstahl

- Sie

- dann

- Dort.

- Diese

- vom Nutzer definierten

- think

- Denken

- fehlen uns die Worte.

- diejenigen

- Bedrohung

- Bedrohungen

- Zeit

- zu

- nahm

- Top

- gegenüber

- versuchen

- Tweet

- XNUMX

- uns

- mehr Stunden

- -

- benutzt

- Nutzer

- Fahrzeuge

- sehr

- Sicherheitslücken

- Verwundbar

- wurde

- Weg..

- we

- Waffen

- GUT

- West

- Was

- Weiß

- Weißen Haus

- warum

- mit

- Werk

- würde

- U

- Ihr

- Zephyrnet