Dies ist ein Gastbeitrag von AK Roy von Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) DL2q-Instanzen, die auf Qualcomm AI 100 Standard-Beschleunigern basieren, können zur kosteneffizienten Bereitstellung von Deep-Learning-Workloads (DL) in der Cloud verwendet werden. Sie können auch zur Entwicklung und Validierung der Leistung und Genauigkeit von DL-Workloads verwendet werden, die auf Qualcomm-Geräten bereitgestellt werden. DL2q-Instanzen sind die ersten Instanzen, die die künstliche Intelligenz (KI) von Qualcomm in die Cloud bringen.

Mit acht Qualcomm AI 100 Standard-Beschleunigern und 128 GiB Gesamtbeschleunigerspeicher können Kunden DL2q-Instanzen auch zum Ausführen beliebter generativer KI-Anwendungen wie Inhaltsgenerierung, Textzusammenfassung und virtueller Assistenten sowie klassischer KI-Anwendungen für die Verarbeitung natürlicher Sprache verwenden und Computer Vision. Darüber hinaus verfügen die Qualcomm AI 100-Beschleuniger über dieselbe KI-Technologie, die auch für Smartphones, autonomes Fahren, PCs und Extended-Reality-Headsets verwendet wird, sodass DL2q-Instanzen zur Entwicklung und Validierung dieser KI-Workloads vor der Bereitstellung verwendet werden können.

Highlights der neuen DL2q-Instanz

Jede DL2q-Instanz umfasst acht Qualcomm Cloud AI100-Beschleuniger mit einer Gesamtleistung von über 2.8 PetaOps der Int8-Inferenzleistung und 1.4 PetaFlops der FP16-Inferenzleistung. Die Instanz verfügt über insgesamt 112 KI-Kerne, eine Beschleunigerspeicherkapazität von 128 GB und eine Speicherbandbreite von 1.1 TB pro Sekunde.

Jede DL2q-Instanz verfügt über 96 vCPUs, eine Systemspeicherkapazität von 768 GB und unterstützt eine Netzwerkbandbreite von 100 Gbit/s Amazon Elastic Block Store (Amazon EBS) Speicher von 19 Gbit/s.

| Instanzname | vCPUs | Cloud AI100-Beschleuniger | Beschleunigerspeicher | Beschleunigerspeicher BW (aggregiert) | Instanzspeicher | Instanzvernetzung | Speicherbandbreite (Amazon EBS). |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100-Beschleuniger-Innovation

Das Cloud AI100 Accelerator System-on-Chip (SoC) ist eine speziell entwickelte, skalierbare Multi-Core-Architektur, die eine breite Palette von Deep-Learning-Anwendungsfällen unterstützt, die vom Rechenzentrum bis zum Edge reichen. Der SoC verwendet Skalar-, Vektor- und Tensor-Rechenkerne mit einer branchenführenden On-Die-SRAM-Kapazität von 126 MB. Die Kerne sind über ein Network-on-Chip-Netz (NoC) mit hoher Bandbreite und geringer Latenz miteinander verbunden.

Der AI100-Beschleuniger unterstützt ein breites und umfassendes Spektrum an Modellen und Anwendungsfällen. Die folgende Tabelle zeigt den Umfang der Modellunterstützung.

| Modellkategorie | Anzahl der Modelle | Beispiele |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-Code MOE |

| Generative KI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generative KI – Bild | 3 | Stabile Verbreitung v1.5 und v2.1, OpenAI CLIP |

| Lebenslauf – Bildklassifizierung | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Objekterkennung | 23 | YOLO v2, v3, v4, v5 und v7, SSD-ResNet, RetinaNet |

| Lebenslauf – Sonstiges | 15 | LPRNet, Superauflösung/SRGAN, ByteTrack |

| Automotive-Netzwerke* | 53 | Wahrnehmung und LIDAR-, Fußgänger-, Spur- und Ampelerkennung |

| Gesamt | > 300 | |

* Die meisten Automobilnetzwerke sind zusammengesetzte Netzwerke, die aus der Fusion einzelner Netzwerke bestehen.

Der große On-Die-SRAM des DL2q-Beschleunigers ermöglicht die effiziente Implementierung fortschrittlicher Leistungstechniken wie MX6-Mikroexponentenpräzision zum Speichern der Gewichte und MX9-Mikroexponentenpräzision für die Beschleuniger-zu-Beschleuniger-Kommunikation. Die Mikroexponenten-Technologie wird in der folgenden Branchenankündigung des Open Compute Project (OCP) beschrieben: AMD, Arm, Intel, Meta, Microsoft, NVIDIA und Qualcomm standardisieren Narrow-Precision-Datenformate der nächsten Generation für KI » Open Compute Project.

Der Instanzbenutzer kann die folgende Strategie verwenden, um die Leistung pro Kosten zu maximieren:

- Speichern Sie Gewichte mit der MX6-Mikroexponentengenauigkeit im On-Accelerator-DDR-Speicher. Der Einsatz der MX6-Präzision maximiert die Nutzung der verfügbaren Speicherkapazität und der Speicherbandbreite, um den besten Durchsatz und die beste Latenz seiner Klasse zu liefern.

- Berechnen Sie in FP16, um die erforderliche Anwendungsfallgenauigkeit zu liefern, und nutzen Sie gleichzeitig das überlegene On-Chip-SRAM und Ersatz-TOPs auf der Karte, um hochleistungsfähige MX6- bis FP16-Kernel mit geringer Latenz zu implementieren.

- Nutzen Sie eine optimierte Batch-Strategie und eine höhere Batch-Größe, indem Sie den großen verfügbaren On-Chip-SRAM nutzen, um die Wiederverwendung von Gewichten zu maximieren und gleichzeitig die On-Chip-Aktivierungen so weit wie möglich beizubehalten.

DL2q AI Stack und Toolchain

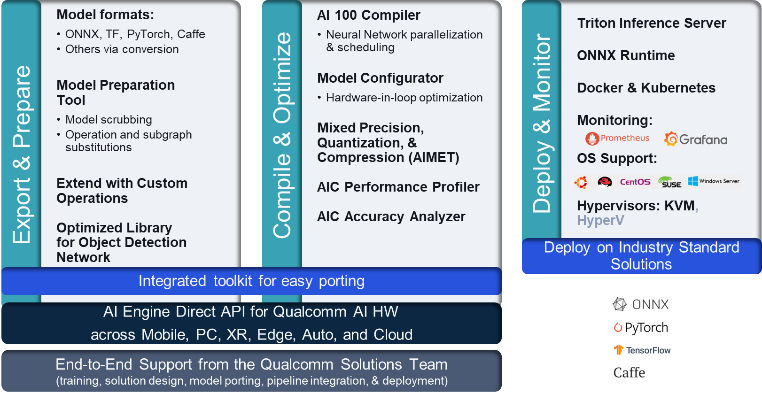

Die DL2q-Instanz wird vom Qualcomm AI Stack begleitet, der ein konsistentes Entwicklererlebnis für Qualcomm AI in der Cloud und andere Qualcomm-Produkte bietet. Derselbe Qualcomm-KI-Stack und die gleiche Basis-KI-Technologie laufen auf den DL2q-Instanzen und Qualcomm-Edge-Geräten und bieten Kunden ein konsistentes Entwicklererlebnis mit einer einheitlichen API in ihren Entwicklungsumgebungen für Cloud, Automotive, Personal Computer, Extended Reality und Smartphone.

Die Toolchain ermöglicht es dem Instanzbenutzer, ein zuvor trainiertes Modell schnell zu integrieren, das Modell für die Instanzfunktionen zu kompilieren und zu optimieren und anschließend die kompilierten Modelle für Produktionsinferenz-Anwendungsfälle in drei Schritten bereitzustellen, die in der folgenden Abbildung dargestellt sind.

Weitere Informationen zum Optimieren der Leistung eines Modells finden Sie unter Wichtige Leistungsparameter von Cloud AI 100 Dokumentation.

Beginnen Sie mit DL2q-Instanzen

In diesem Beispiel kompilieren und stellen Sie eine vorab trainierte Version bereit BERT-Modell für Gesicht umarmen auf einer EC2 DL2q-Instanz mithilfe eines vorgefertigten verfügbaren DL2q-AMI in vier Schritten.

Sie können entweder eine vorgefertigte Version verwenden Qualcomm DLAMI auf der Instanz oder beginnen Sie mit einem Amazon Linux2 AMI und erstellen Sie Ihr eigenes DL2q AMI mit dem darin verfügbaren Cloud AI 100 Platform and Apps SDK Einfacher Amazon-Speicherdienst (Amazon S3) Eimer: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Die folgenden Schritte verwenden das vorgefertigte DL2q-AMI. Qualcomm Base AL2 DLAMI.

Verwenden Sie SSH, um mit dem Qualcomm Base AL2 DLAMI AMI auf Ihre DL2q-Instanz zuzugreifen, und befolgen Sie die Schritte 1 bis 4.

Schritt 1: Richten Sie die Umgebung ein und installieren Sie die erforderlichen Pakete

- Installieren Sie Python 3.8.

- Richten Sie die virtuelle Python 3.8-Umgebung ein.

- Aktivieren Sie die virtuelle Umgebung von Python 3.8.

- Installieren Sie die erforderlichen Pakete, wie in der Abbildung gezeigt Anforderungen.txt-Dokument verfügbar auf der öffentlichen Github-Website von Qualcomm.

- Importieren Sie die erforderlichen Bibliotheken.

Schritt 2. Importieren Sie das Modell

- Importieren und tokenisieren Sie das Modell.

- Definieren Sie eine Beispieleingabe und extrahieren Sie sie

inputIdsundattentionMask. - Konvertieren Sie das Modell in ONNX, das dann an den Compiler übergeben werden kann.

- Sie führen das Modell mit FP16-Präzision aus. Sie müssen also prüfen, ob das Modell Konstanten enthält, die über den FP16-Bereich hinausgehen. Übergeben Sie das Modell an die

fix_onnx_fp16Funktion zum Generieren der neuen ONNX-Datei mit den erforderlichen Korrekturen.

Schritt 3. Kompilieren Sie das Modell

Das qaic-exec Zum Kompilieren des Modells wird das Befehlszeilenschnittstellen-Compilertool (CLI) verwendet. Die Eingabe für diesen Compiler ist die in Schritt 2 generierte ONNX-Datei. Der Compiler erzeugt eine Binärdatei (genannt QPCZ. Qualcomm-Programmcontainer) im durch definierten Pfad -aic-binary-dir Argument.

Im folgenden Kompilierungsbefehl verwenden Sie vier KI-Rechenkerne und eine Stapelgröße von eins, um das Modell zu kompilieren.

Der QPC wird im generiert bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc -Ordner.

Schritt 4: Führen Sie das Modell aus

Richten Sie eine Sitzung ein, um die Inferenz auf einem Cloud AI100 Qualcomm-Beschleuniger in der DL2q-Instanz auszuführen.

Die Qaic-Python-Bibliothek von Qualcomm besteht aus einer Reihe von APIs, die Unterstützung für die Ausführung von Inferenzen auf dem Cloud AI100-Beschleuniger bieten.

- Verwenden Sie den Session-API-Aufruf, um eine Sitzungsinstanz zu erstellen. Der Session-API-Aufruf ist der Einstiegspunkt zur Verwendung der qaic-Python-Bibliothek.

- Restrukturieren Sie die Daten aus dem Ausgabepuffer mit

output_shapeundoutput_type. - Dekodieren Sie die erzeugte Ausgabe.

Hier sind die Ausgaben für den Eingabesatz „Der Hund [MASKE] auf der Matte“.

Das ist es. Mit nur wenigen Schritten haben Sie ein PyTorch-Modell kompiliert und auf einer Amazon EC2 DL2q-Instanz ausgeführt. Weitere Informationen zum Onboarding und Kompilieren von Modellen auf der DL2q-Instanz finden Sie unter Cloud AI100-Tutorial-Dokumentation.

Weitere Informationen darüber, welche DL-Modellarchitekturen gut für AWS DL2q-Instanzen geeignet sind, und die aktuelle Modellunterstützungsmatrix finden Sie unter Qualcomm Cloud AI100-Dokumentation.

Sofort verfügbar

Sie können DL2q-Instanzen noch heute in den AWS-Regionen USA West (Oregon) und Europa (Frankfurt) starten Auf Nachfrage, Reserviert und Spot Instances, oder als Teil eines Sparplan. Wie bei Amazon EC2 üblich, zahlen Sie nur für das, was Sie nutzen. Weitere Informationen finden Sie unter Amazon EC2-Preise.

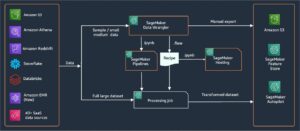

DL2q-Instanzen können mit bereitgestellt werden AWS Deep Learning AMIs (DLAMI), und Container-Images sind über verwaltete Dienste wie verfügbar Amazon Sage Maker, Amazon Elastic Kubernetes-Dienst (Amazon EKS), Amazon Elastic Container-Service (Amazon ECS) und AWS-ParallelCluster.

Um mehr zu erfahren, besuchen Sie die Amazon EC2 DL2q-Instanz Seite und senden Sie Feedback an AWS re:Post für EC2 oder über Ihre üblichen AWS-Supportkontakte.

Über die Autoren

AK Roy ist Director of Product Management bei Qualcomm für Cloud- und Datacenter-KI-Produkte und -Lösungen. Er verfügt über mehr als 20 Jahre Erfahrung in der Produktstrategie und -entwicklung, mit dem aktuellen Schwerpunkt auf erstklassiger Leistung und Performance/$-End-to-End-Lösungen für KI-Inferenz in der Cloud für ein breites Spektrum an Anwendungsfällen. einschließlich GenAI, LLMs, Auto- und Hybrid-KI.

AK Roy ist Director of Product Management bei Qualcomm für Cloud- und Datacenter-KI-Produkte und -Lösungen. Er verfügt über mehr als 20 Jahre Erfahrung in der Produktstrategie und -entwicklung, mit dem aktuellen Schwerpunkt auf erstklassiger Leistung und Performance/$-End-to-End-Lösungen für KI-Inferenz in der Cloud für ein breites Spektrum an Anwendungsfällen. einschließlich GenAI, LLMs, Auto- und Hybrid-KI.

Jianying Lang ist Principal Solutions Architect bei AWS Worldwide Specialist Organization (WWSO). Sie verfügt über mehr als 15 Jahre Berufserfahrung im HPC- und KI-Bereich. Bei AWS konzentriert sie sich darauf, Kunden bei der Bereitstellung, Optimierung und Skalierung ihrer KI/ML-Workloads auf Accelerated-Computing-Instanzen zu unterstützen. Ihre Leidenschaft liegt in der Kombination der Techniken in den Bereichen HPC und KI. Jianying hat einen Doktortitel in Computerphysik von der University of Colorado in Boulder.

Jianying Lang ist Principal Solutions Architect bei AWS Worldwide Specialist Organization (WWSO). Sie verfügt über mehr als 15 Jahre Berufserfahrung im HPC- und KI-Bereich. Bei AWS konzentriert sie sich darauf, Kunden bei der Bereitstellung, Optimierung und Skalierung ihrer KI/ML-Workloads auf Accelerated-Computing-Instanzen zu unterstützen. Ihre Leidenschaft liegt in der Kombination der Techniken in den Bereichen HPC und KI. Jianying hat einen Doktortitel in Computerphysik von der University of Colorado in Boulder.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :hast

- :Ist

- $UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 Jahre

- 15%

- 17

- 19

- 20

- 20 Jahre

- 22

- 23

- 46

- 7

- 75

- 8

- 84

- a

- LiveBuzz

- oben

- beschleunigt

- Beschleuniger

- Beschleuniger

- Zugang

- Begleitet

- Genauigkeit

- über

- Aktivierungen

- zusätzlich

- advanced

- Aggregat

- AI

- AI / ML

- Alle

- ebenfalls

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- und

- Ankündigung

- jedem

- Bienen

- APIs

- Anwendungen

- Apps

- Architektur

- SIND

- Argument

- ARM

- künstlich

- AS

- Assistenten

- At

- Auto

- Automobilindustrie

- Autonom

- verfügbar

- AWS

- ACHSEN

- Bandbreite

- Base

- Dosierung

- BE

- Bevor

- unten

- Beyond

- BIN

- Blockieren

- Blühen

- bringen

- breit

- puffern

- bauen

- by

- rufen Sie uns an!

- namens

- CAN

- Fähigkeiten

- Kapazität

- Karte

- Häuser

- aus der Ferne überprüfen

- klassisch

- Cloud

- Colorados

- Vereinigung

- Kommunikation

- kompiliert

- umfassend

- rechnerisch

- Berechnen

- Computer

- Computer Vision

- Computer

- Computing

- konsistent

- Bestehend

- Kontakte

- Container

- enthält

- Inhalt

- erstellen

- Strom

- Kunden

- technische Daten

- Datacenter

- tief

- tiefe Lernen

- definiert

- Grad

- Übergeben

- liefert

- einsetzen

- Einsatz

- Einsatz

- beschrieben

- entwickeln

- Entwickler:in / Unternehmen

- Entwicklung

- Gerät

- Geräte

- Rundfunk

- Direktor

- Dokumentation

- Hund

- Fahren

- dynamisch

- ebs

- Edge

- effizient

- entweder

- beschäftigt

- ermöglicht

- End-to-End

- Eintrag

- Arbeitsumfeld

- Umgebungen

- Äther (ETH)

- Europa

- Beispiel

- ERFAHRUNGEN

- erweiterte Realität

- Extrakt

- falsch

- Merkmal

- Feedback

- wenige

- Feld

- Felder

- Abbildung

- Reichen Sie das

- Vorname

- passen

- Fixes

- Setzen Sie mit Achtsamkeit

- konzentriert

- folgen

- Folgende

- Aussichten für

- gefunden

- vier

- Frankfurt

- für

- Funktion

- Verschmelzung

- allgemein

- erzeugen

- erzeugt

- Generation

- generativ

- Generative KI

- GitHub

- gegeben

- gut

- GUEST

- Guest Post

- he

- Headsets

- Unternehmen

- hier

- Hohe Leistungsfähigkeit

- höher

- Highlights

- hält

- hpc

- HTML

- HTTPS

- Hybrid

- i

- IDX

- if

- Image

- Bilder

- implementieren

- Implementierung

- importieren

- in

- Einschließlich

- beinhaltet

- Krankengymnastik

- Energiegewinnung

- branchenführend

- Information

- Varianten des Eingangssignals:

- installieren

- Instanz

- Instanzen

- Intel

- Intelligent

- verbunden

- Schnittstelle

- IT

- jpg

- nur

- Wesentliche

- Kubernetes

- Spur

- Sprache

- grosse

- Latency

- starten

- LERNEN

- lernen

- Bibliotheken

- Bibliothek

- Deal

- !

- Line

- Belastungen

- verwaltet

- Management

- Maske"

- Matrix

- max

- Maximieren

- maximiert

- maximal

- Memory

- ineinander greifen

- Meta

- Microsoft

- Min.

- Modell

- für

- geändert

- mehr

- vor allem warme

- Name

- Natürliche

- Natürliche Sprache

- Verarbeitung natürlicher Sprache

- notwendig,

- Need

- Netzwerk

- Vernetzung

- Netzwerke

- Neu

- nächste Generation

- jetzt an

- numpig

- Nvidia

- Objekt

- of

- on

- Onboard

- Einsteigen

- EINEM

- einzige

- XNUMXh geöffnet

- OpenAI

- Optimieren

- optimiert

- or

- Oregon

- Organisation

- OS

- Andere

- Möglichkeiten für das Ausgangssignal:

- Ausgänge

- übrig

- besitzen

- Pakete

- Seite

- Teil

- passieren

- Bestanden

- leidenschaftlich

- Weg

- AUFMERKSAMKEIT

- für

- Leistung

- persönliche

- Persönliche Computer

- phd

- Physik

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Beliebt

- möglich

- Post

- angetriebene

- Präzision

- vorher

- Principal

- Verarbeitung

- Produziert

- produziert

- Produkt

- Produktmanagement

- Produktion

- Produkte

- Programm

- Projekt

- bietet

- Bereitstellung

- Öffentlichkeit

- Python

- Pytorch

- Qualcomm

- schnell

- Angebot

- RE

- Lesebrillen

- Realität

- Regionen

- falls angefordert

- Voraussetzungen:

- Halte

- Rückkehr

- Wiederverwendung

- roy

- Führen Sie

- Laufen

- läuft

- gleich

- Speichern

- Einsparung

- skalierbaren

- Skalieren

- Sdk

- Zweite

- sehen

- senden

- Satz

- Reihenfolge

- Lösungen

- Sitzung

- kompensieren

- sie

- gezeigt

- Einfacher

- vereinfachen

- am Standort

- Größe

- Smartphone

- Smartphones

- So

- Lösungen

- überspannend

- Spezialist

- Stapel

- Standard

- Anfang

- begonnen

- Schritt

- Shritte

- Lagerung

- speichern

- Strategie

- Anschließend

- so

- Oberteil

- Support

- Unterstützung

- Unterstützt

- System

- Tabelle

- Techniken

- Technologie

- Text

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- dann

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- nach drei

- Durch

- Durchsatz

- thru

- zu

- heute

- tokenisieren

- Werkzeug

- Tops & Pullover

- Fackel

- Gesamt

- der Verkehr

- trainiert

- Transformer

- was immer dies auch sein sollte.

- Lernprogramm

- einheitlich

- Universität

- us

- -

- Anwendungsfall

- Anwendungsfälle

- benutzt

- Mitglied

- Verwendung von

- üblich

- v1

- VAL

- BESTÄTIGEN

- Wert

- Assistent

- Seh-

- Besuchen Sie

- we

- Netz

- Web-Services

- GUT

- West

- Was

- welche

- während

- breit

- Große Auswahl

- werden wir

- mit

- Word

- arbeiten,

- Das weltweit

- Jahr

- U

- Ihr

- Zephyrnet