Дослідники з Університету Пердью опублікували технічну статтю під назвою «WWW: що, коли і де обчислювати в пам’яті».

Анотація:

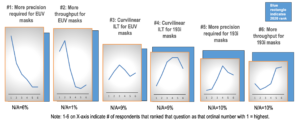

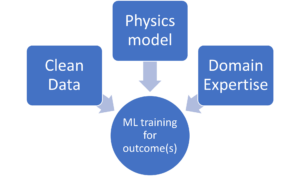

«Compute-in-memory (CiM) став переконливим рішенням для зменшення високих витрат на переміщення даних у машинах фон Неймана. CiM може виконувати масово паралельні операції множення загальної матриці (GEMM) у пам’яті, домінуюче обчислення в машинному навчанні (ML). Однак перепрофілювання пам’яті для обчислень ставить ключові питання щодо 1) Якого типу CiM використовувати: враховуючи безліч аналогових і цифрових CiM, необхідно визначити їх придатність з точки зору системи. 2) Коли використовувати CiM: висновок ML включає робочі навантаження з різноманітними вимогами до пам’яті та обчислень, що ускладнює визначення того, коли CiM є більш корисним, ніж стандартні процесорні ядра. 3) Куди інтегрувати CiM: кожен рівень пам’яті має різну пропускну здатність і ємність, що впливає на переміщення даних і переваги локальності інтеграції CiM.

У цій статті ми досліджуємо відповіді на ці запитання щодо інтеграції CiM для прискорення логічного висновку ML. Ми використовуємо Timeloop-Accelergy для ранньої оцінки на системному рівні прототипів CiM, включаючи як аналогові, так і цифрові примітиви. Ми інтегруємо CiM у різні рівні кеш-пам’яті в базовій архітектурі, схожій на Nvidia A100, і адаптуємо потік даних для різних робочих навантажень ML. Наші експерименти показують, що архітектури CiM покращують енергоефективність, досягаючи до 0.12 разів нижчого споживання енергії, ніж встановлена базова лінія з точністю INT-8, і до 4-кратного підвищення продуктивності завдяки чергуванню ваги та дублюванню. Пропонована робота дає зрозуміти, який тип CiM використовувати, а також коли і де оптимально інтегрувати його в ієрархію кешу для прискорення GEMM».

Знайти технічний документ тут. Опубліковано грудень 2023 р. (препринт).

Шарма, Танві, Мустафа Алі, Індраніл Чакраборті та Каушік Рой. «WWW: що, коли, де обчислювати в пам’яті». Препринт arXiv arXiv:2312.15896 (2023).

Пов'язане читання

Підвищення енергоефективності ШІ за допомогою обчислень у пам’яті

Як обробляти робочі навантаження zettascale і залишатися в межах фіксованого бюджету електроенергії.

Моделювання обчислень у пам’яті з біологічною ефективністю

Generative AI змушує виробників чіпів використовувати обчислювальні ресурси більш розумно.

SRAM в штучному інтелекті: майбутнє пам’яті

Чому SRAM розглядається як критичний елемент у нових і традиційних обчислювальних архітектурах.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- : має

- :є

- :де

- $UP

- 1

- 2023

- a

- прискорення

- досягнення

- AI

- полегшувати

- an

- та

- Відповіді

- архітектура

- AS

- At

- ширина смуги

- Базова лінія

- корисний

- Переваги

- обидва

- бюджет

- by

- cache

- CAN

- потужність

- переконливий

- обчислення

- обчислення

- витрати

- критичний

- дані

- Грудень

- визначення

- різний

- важкий

- цифровий

- домінуючий

- кожен

- Рано

- ефективність

- елемент

- з'явився

- енергія

- енергоефективності

- встановлений

- оцінка

- Експерименти

- дослідити

- фіксованою

- для

- Війська

- від

- майбутнє

- прибуток

- Загальне

- даний

- тут

- ієрархія

- Високий

- Однак

- HTTPS

- ідентифікувати

- удосконалювати

- in

- includes

- У тому числі

- розуміння

- інтегрувати

- інтеграція

- в

- IT

- JPG

- ключ

- вивчення

- рівень

- рівні

- знизити

- машина

- навчання за допомогою машини

- Машинки для перманенту

- Робить

- масово

- Матриця

- пам'ять

- ML

- більше

- руху

- безліч

- необхідний

- Нові

- Nvidia

- of

- on

- відкрити

- операції

- наші

- Папір

- Паралельні

- виконувати

- продуктивність

- перспектива

- plato

- Інформація про дані Платона

- PlatoData

- позах

- влада

- Точність

- процес

- обробка

- запропонований

- Прототипи

- забезпечує

- опублікований

- питань

- про

- Вимога

- Дослідники

- ресурси

- Рой

- Показувати

- рішення

- standard

- залишатися

- придатність

- Systems

- технічний

- ніж

- Що

- Команда

- Майбутнє

- їх

- Ці

- це

- під назвою

- до

- традиційний

- тип

- університет

- використання

- різноманітність

- різний

- переглянуті

- з

- було

- we

- вага

- Що

- коли

- з

- в

- Work

- зефірнет