Після багатьох років розробки Meta може нарешті випустити свої власні прискорювачі ШІ цього року.

Цього тижня імперія Facebook підтвердила своє бажання доповнити розгортання графічних процесорів Nvidia H100 і AMD MI300X сімейством чіпів Meta Training Inference Accelerator (MTIA). Зокрема, Meta розгорне процесор, оптимізований для висновків, згідно з кодовою назвою Артеміда, заснований на частинах першого покоління гіганта Кремнієвої долини дражнили минулого року.

«Ми в захваті від прогресу, якого ми досягли у наших внутрішніх зусиллях із кремнію з MTIA, і ми на шляху до того, щоб розпочати розгортання нашого варіанту висновків у виробництві в 2024 році», — сказав представник Meta. Реєстр в четвер.

«Ми вважаємо, що наші власно розроблені прискорювачі доповнюють комерційно доступні графічні процесори, забезпечуючи оптимальне поєднання продуктивності та ефективності для мета-специфічних робочих навантажень», — продовжив представник. Деталі? ні. Прес-секретар сказав нам: «Ми з нетерпінням чекаємо поділитися новинами щодо наших майбутніх планів MTIA пізніше цього року».

Ми розуміємо, що чіп другого покоління, орієнтований на логічний висновок, широко поширюється після версії першого покоління, призначеної лише для лабораторних висновків, і пізніше ми можемо дізнатися про частини, призначені в основному для навчання або навчання та висновків.

Meta стала одним із найкращих клієнтів Nvidia та AMD, оскільки розгортання робочих навантажень штучного інтелекту зростає, зростає потреба та використання спеціалізованого кремнію, щоб програмне забезпечення для машинного навчання працювало якомога швидше. Таким чином, рішення гіганта Instagram розробити власні процесори не є таким дивним.

Насправді мега-корпорація, на перший погляд, відносно пізно вийшла на власну кремнієву партію AI з точки зору розгортання в реальному світі. Amazon і Google уже кілька років використовують власні компоненти для прискорення внутрішніх систем машинного навчання, наприклад моделі рекомендацій і код клієнтського машинного навчання. Між тим минулого року Microsoft показала свої домашні прискорювачі.

Але окрім того факту, що Meta масштабно розгортає чіп висновку MTIA, соціальна мережа не розкрила свою точну архітектуру, ані те, які робочі навантаження вона резервує для внутрішнього кремнію, а які передає на графічні процесори AMD і Nvidia.

Цілком ймовірно, що Meta запускатиме встановлені моделі на своїх спеціальних ASIC, щоб звільнити ресурси графічного процесора для більш динамічних або розвиваються програм. Раніше ми бачили, як Meta йшла цим шляхом із спеціальними прискорювачами, призначеними для розвантаження даних і обчислення інтенсивних навантажень відео.

Що стосується основного дизайну, спостерігачі галузі в SemiAnalysis кажуть нам, що новий чіп тісно заснований на архітектурі частин першого покоління Meta.

Сходинки

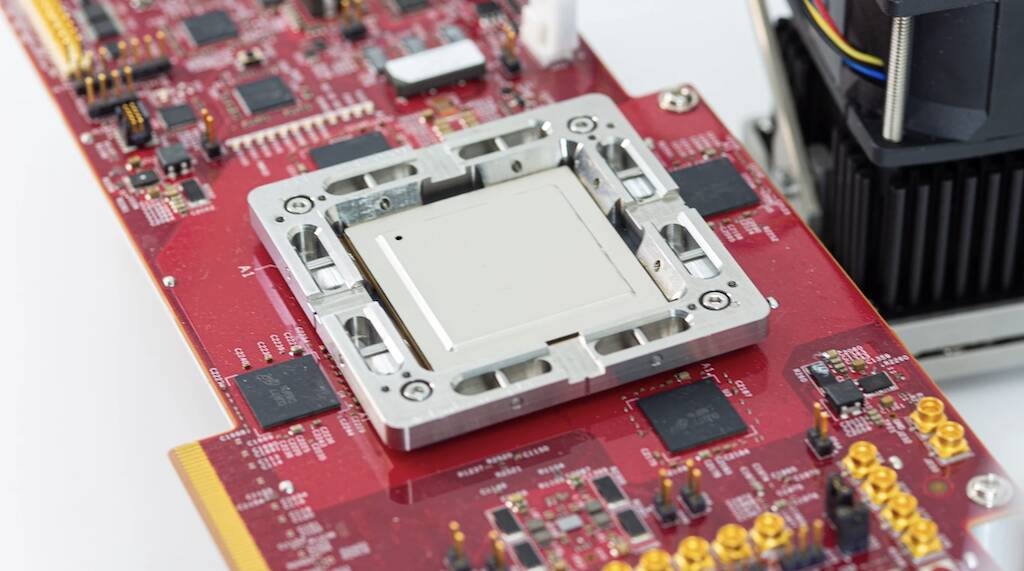

Частини Meta MTIA v2023, анонсовані на початку 1 року після трьох років розробки, які наші друзі з Наступна платформа подивився на минулої весни були розроблені спеціально з урахуванням моделей рекомендацій глибокого навчання.

Чіп першого покоління був побудований навколо кластера ЦП RISC-V і виготовлений за 7-нм техпроцесом TSMC. Під капотом компонент використовував матрицю процесорних елементів розміром вісім на вісім, кожне з яких оснащено двома ядрами ЦП RV, одне з яких обладнано розширеннями векторної математики. Ці ядра живляться від 128 МБ вбудованої пам’яті SRAM і до 128 ГБ пам’яті LPDDR5.

Як Meta стверджувала минулого року, чіп працював на частоті 800 МГц і досяг 102.4 трильйона операцій в секунду продуктивності INT8 або 51.2 тераФЛОПС із половинною точністю (FP16). Для порівняння, H100 від Nvidia здатний досягти майже чотирьох петаФЛОПС із низькою продуктивністю FP8. Незважаючи на те, що чіп не був настільки потужним, як графічні процесори Nvidia або AMD, він мав одну головну перевагу: енергоспоживання. Сам чіп мав теплову проектну потужність лише 25 Вт.

За оцінками Напіваналіз, останній чіп Meta може похвалитися вдосконаленими ядрами та обмінювати LPDDR5 на пам’ять із високою пропускною здатністю, упаковану за технологією TSMC chip-on-wafer-on-substrate (CoWoS).

Ще одна помітна відмінність полягає в тому, що чіп другого покоління Meta фактично отримає широке розгортання в інфраструктурі центру обробки даних. За словами титана Facebook, хоча частина першого покоління використовувалася для запуску виробничих рекламних моделей, вона ніколи не залишала лабораторію.

Гонитва за загальним штучним інтелектом

Крім нестандартних деталей, батьківська компанія Facebook і Instagram відмовилася мільярди доларів на графічні процесори в останні роки для прискорення всіх видів завдань, які погано підходять для звичайних платформ ЦП. Однак поява великих мовних моделей, таких як GPT-4 і власна Llama 2 від Meta, змінила ландшафт і спонукала до розгортання масивних кластерів GPU.

У масштабах діяльності Meta ці тенденції вимагають кардинальних змін у її інфраструктурі, зокрема переконструювати кількох центрів обробки даних для підтримки величезних вимог до електроенергії та охолодження, пов’язаних із розгортанням великого AI.

І розгортання Meta тільки збільшиться протягом наступних кількох місяців, оскільки компанія переносить фокус з метавсесвіту на розробка загального штучного інтелекту. Імовірно, робота над ШІ допоможе сформувати метавсесвіт або щось подібне.

За словами генерального директора Марка Цукерберга, лише цього року Meta планує розгорнути 350,000 100 Nvidia HXNUMX.

Підприємство також оголосило про плани нового розгортання AMD запущений Графічні процесори MI300X у своїх центрах обробки даних. Цукерберг заявив, що його корпорація закінчить рік з обчислювальною потужністю, еквівалентною 600,000 100 HXNUMX. Тож явно чіпи MTIA від Meta не замінять графічні процесори найближчим часом. ®

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- : має

- :є

- $UP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- МЕНЮ

- прискорювати

- прискорювач

- прискорювачі

- За

- через

- насправді

- Перевага

- реклама

- після

- AI

- ВСІ

- тільки

- пліч-о-пліч

- Також

- Amazon

- AMD

- an

- та

- оголошений

- застосування

- архітектура

- ЕСТЬ

- навколо

- штучний

- штучний загальний інтелект

- AS

- Asics

- aside

- асоційований

- At

- доступний

- заснований

- BE

- ставати

- було

- перед тим

- КРАЩЕ

- За

- бізнес

- має

- побудований

- by

- здатний

- Генеральний директор

- змінилися

- Зміни

- чіп

- Чіпси

- стверджував,

- очевидно

- тісно

- кластер

- CO

- код

- комерційно

- компанія

- порівняння

- взаємодоповнюючі

- компонент

- Компоненти

- обчислення

- обчислення

- обчислювальна потужність

- Підтверджено

- споживання

- триває

- звичайний

- КОРПОРАЦІЯ

- центральний процесор

- виготовлений на замовлення

- клієнт

- Клієнти

- дані

- Дата-центр

- рішення

- надання

- розгортання

- розгортання

- розгортання

- розгортання

- дизайн

- призначений

- бажання

- деталі

- розвивати

- розвиненою

- розробка

- DID

- різниця

- доларів

- зроблений

- вниз

- керований

- динамічний

- кожен

- Рано

- ефективність

- зусилля

- або

- елементи

- Імперія

- працевлаштований

- кінець

- обладнаний

- Еквівалент

- встановлений

- Ефір (ETH)

- еволюціонує

- збуджений

- Розширення

- Face

- факт

- сім'я

- ШВИДКО

- Fed

- кілька

- в кінці кінців

- знайти

- Сфокусувати

- після

- для

- форма

- Вперед

- чотири

- Безкоштовна

- друзі

- від

- майбутнє

- Загальне

- загальний інтелект

- щедрий

- отримати

- гігант

- Go

- буде

- GPU

- Графічні процесори

- вирощений

- було

- Половина

- Мати

- допомога

- дуже

- його

- домашній

- капот

- Однак

- HTTPS

- величезний

- поліпшений

- in

- У тому числі

- зростаючий

- промисловість

- Інфраструктура

- Інтелект

- призначених

- інтенсивний

- внутрішній

- внутрішньо

- isn

- IT

- ЙОГО

- сам

- JPG

- просто

- lab

- ландшафт

- мова

- великий

- більше

- останній

- Минулого року

- Пізно

- пізніше

- останній

- залишити

- як

- Ймовірно

- Лама

- подивитися

- made

- основний

- зробити

- манера

- багато

- позначити

- Марк Цукерберг

- масивний

- математики

- Матриця

- Може..

- значити

- значущим

- Між тим

- пам'ять

- Meta

- Метавеси

- Microsoft

- mind

- змішувати

- ML

- Моделі

- місяців

- більше

- Близько

- майже

- Необхідність

- мережу

- ніколи

- Нові

- новий чіп

- нещодавно

- наступний

- ні

- Помітний

- Nvidia

- of

- on

- ONE

- тільки

- працює

- операції

- оптимальний

- or

- наші

- з

- над

- власний

- упаковані

- частина

- частини

- партія

- для

- продуктивність

- плани

- Платформи

- plato

- Інформація про дані Платона

- PlatoData

- це можливо

- влада

- потужний

- необхідність

- Точність

- в першу чергу

- процес

- обробка

- процесор

- процесори

- Production

- прогрес

- RE

- Реальний світ

- останній

- щодо

- Вимога

- ресурси

- Reuters

- Показали

- Зростання

- Котити

- рухомий

- Маршрут

- прогін

- s

- шкала

- другий

- побачити

- бачив

- кілька

- поділ

- Зміни

- Кремній

- Силіконова долина

- So

- соціальна

- соціальна мережа

- Софтвер

- деякі

- що в сім'ї щось

- Скоро

- рідкісний

- спеціалізований

- конкретно

- доповідач

- весна

- старт

- такі

- доповнювати

- підтримка

- дивно

- Systems

- T

- взяття

- завдання

- технології

- сказати

- terms

- Що

- Команда

- Пейзаж

- Метаверс

- теплової

- Ці

- це

- На цьому тижні

- У цьому році

- три

- четвер, четвер

- Таким чином

- велетень

- до

- сказав

- увінчаний

- трек

- торги

- Навчання

- Тенденції

- трильйон

- tsmc

- два

- при

- що лежить в основі

- Updates

- us

- використання

- використовуваний

- використання

- v1

- Долина

- варіант

- Ve

- вектор

- версія

- Відео

- було

- шлях..

- we

- week

- були

- який

- в той час як

- широко

- широко поширений

- волі

- з

- Виграв

- Work

- б

- рік

- років

- зефірнет

- Цукерберг