З огляду на останні 15 місяців, прогрес, досягнутий у генеративному штучному інтелекті та великих мовних моделях (LLM) після впровадження та доступності ChatGPT для громадськості, домінував у заголовках.

Будівельним блоком для цього прогресу стала архітектура моделі Transformer, викладена групою дослідників Google у статті під назвою «Увага – це все, що вам потрібно.” Як видно з назви, ключовою особливістю всіх моделей Transformer є механізм уваги, визначений у статті таким чином:

«Функція уваги може бути описана як зіставлення запиту та набору пар ключ-значення з результатом, де запит, ключі, значення та результат є векторами. Вихідні дані обчислюються як зважена сума значень, де вага, призначена кожному значенню, обчислюється функцією сумісності запиту з відповідним ключем».

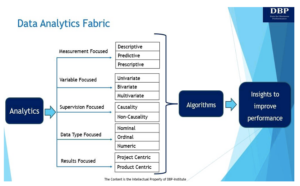

Характеристикою генеративних моделей ШІ є велике споживання вхідних даних, які можуть складатися з тексту, зображень, аудіофайлів, відеофайлів або будь-якої комбінації вхідних даних (цей випадок зазвичай називають «мультимодальним»). З точки зору авторського права, важливим питанням (з багатьох важливих питань), яке слід поставити, є те, чи зберігаються навчальні матеріали в велика модель мови (LLM), виготовлені різними постачальниками LLM. Щоб відповісти на це питання, нам потрібно зрозуміти, як обробляються текстові матеріали. Зосереджуючись на тексті, далі є короткий, нетехнічний опис саме цього аспекту навчання LLM.

Люди спілкуються природною мовою, розміщуючи слова в послідовності; правила про послідовність і конкретну форму слова продиктовані конкретною мовою (наприклад, англійською). Суттєвою частиною архітектури для всіх програмних систем, які обробляють текст (і, отже, для всіх систем штучного інтелекту, які це роблять), є те, як представити цей текст, щоб функції системи могли виконуватися найбільш ефективно. Таким чином, ключовим кроком в обробці текстового введення в мовних моделях є поділ введеного користувачем слова на спеціальні «слова», які може зрозуміти система ШІ. Ці спеціальні слова називаються «токени». Компонент, який за це відповідає, називається «токенизатор». Існує багато типів токенайзерів. Наприклад, OpenAI і Azure OpenAI використовують метод токенізації підслова під назвою «Кодування пари байтів (BPE)» для своїх моделей на основі Generative Pretrained Transformer (GPT). BPE — це метод, який об’єднує пари символів або байтів, які найчастіше зустрічаються, в один маркер, доки не буде досягнуто певної кількості маркерів або розміру словника. Чим більший розмір словника, тим різноманітніші та виразніші тексти, які може створити модель.

Після того як система штучного інтелекту відобразила вхідний текст у токени, вона кодує токени в числа та перетворює оброблені нею послідовності як вектори, що називаються «вбудованими словами». Вектор — це впорядкований набір чисел — його можна уявити як рядок або стовпець у таблиці. Ці вектори є представленнями токенів, які зберігають своє оригінальне представлення природної мови, надане як текст. Важливо розуміти роль вбудованих слів, коли йдеться про авторське право, оскільки вбудовані форми утворюють представлення (або кодування) цілих речень або навіть абзаців, а отже, у векторних комбінаціях, навіть цілих документів у багатовимірному векторному просторі. Саме через ці вбудовування система штучного інтелекту фіксує та зберігає значення та зв’язки слів із природної мови.

Вбудовування використовуються практично в кожному завданні, яке виконує генеративна система ШІ (наприклад, генерація тексту, підсумовування тексту, класифікація тексту, переклад тексту, генерація зображень, генерація коду тощо). Вбудовані слова зазвичай зберігаються у векторних базах даних, але детальний опис усіх підходів до зберігання виходить за рамки цієї публікації, оскільки існує велика різноманітність постачальників, процесів і практик.

Як згадувалося, майже всі LLM базуються на архітектурі Transformer, яка викликає механізм уваги. Останнє дозволяє технології AI переглядати цілі речення та навіть абзаци цілком, а не просто послідовність символів. Це дозволяє програмному забезпеченню фіксувати різні контексти, в яких може зустрічатися слово, і оскільки ці контексти надаються роботами, які використовуються в навчанні, включно з роботами, захищеними авторським правом, вони не є довільними. Таким чином, оригінальне використання слів, вираження оригінального твору, зберігається в системі ШІ. Його можна відтворити й проаналізувати, а також стати основою для нових виразів (які, залежно від конкретних обставин, можна охарактеризувати як «похідну роботу» на мові авторського права).

LLM зберігають вираження оригінальних творів, на яких вони навчалися. Вони формують внутрішні репрезентації тексту в спеціально створених векторних просторах і, враховуючи відповідний вхід як тригер, вони можуть відтворювати оригінальні твори, які використовувалися в їхньому навчанні. Системи штучного інтелекту отримують постійну вигоду від вмісту, включно з вмістом, захищеним авторським правом, який використовується для навчання LLM, на якому вони засновані. LLM розпізнають контекст слів на основі вираження слів в оригінальній роботі. І цей контекст сукупно приносить користь системі штучного інтелекту в тисячах або мільйонах творів, захищених авторським правом, які використовуються під час навчання. Ці оригінальні роботи можуть бути відтворені системою штучного інтелекту, оскільки вони зберігаються у векторах – векторно-просторових представленнях токенів, які зберігають своє оригінальне представлення природною мовою – захищеного авторським правом твору. З точки зору авторського права, визначення того, чи навчальні матеріали зберігаються в LLM, є основою питання, і очевидно, що відповідь на це запитання - так.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.dataversity.net/heart-of-the-matter-demystifying-copying-in-the-training-of-llms/

- : має

- :є

- : ні

- :де

- 15%

- a

- МЕНЮ

- через

- Ad

- AI

- Моделі AI

- Системи ШІ

- ВСІ

- дозволяє

- майже

- an

- проаналізовані

- та

- відповідь

- будь-який

- підходи

- відповідний

- довільний

- архітектура

- ЕСТЬ

- AS

- запитати

- зовнішній вигляд

- призначений

- At

- увагу

- аудіо

- наявність

- Лазурний

- заснований

- основа

- BE

- оскільки

- було

- Переваги

- За

- Блокувати

- Створюємо

- але

- by

- званий

- CAN

- захоплення

- захвати

- випадок

- певний

- характеристика

- характеризується

- символи

- ChatGPT

- обставин

- класифікація

- ясно

- код

- Колонка

- поєднання

- комбінації

- приходить

- спілкуватися

- сумісність

- компонент

- обчислений

- споживання

- зміст

- контекст

- контексти

- копіювання

- авторське право

- Відповідний

- може

- дані

- базами даних

- ПЕРЕДАЧА

- певний

- Залежно

- дрейф

- описаний

- description

- докладно

- визначення

- продиктовано

- Різне

- DM

- do

- документація

- домінують

- e

- кожен

- продуктивно

- кодування

- англійська

- Весь

- Озаглавлений

- істотний

- Ефір (ETH)

- Навіть

- Event

- Кожен

- точно

- приклад

- вираз

- вирази

- виразний

- особливість

- Файли

- фокусування

- після

- слідує

- для

- форма

- часто

- від

- функція

- Функції

- породжувати

- покоління

- генеративний

- Генеративний ШІ

- даний

- Мати

- Headlines

- Серце

- допомога

- Як

- How To

- HTTPS

- зображення

- генерація зображень

- зображень

- важливо

- in

- У тому числі

- вхід

- витрати

- внутрішній

- в

- Вступ

- викликає

- IT

- ключ

- ключі

- мова

- великий

- більше

- llm

- made

- багато

- відображення

- масивний

- Матеріали

- Матерія

- Може..

- сенс

- механізм

- згаданий

- меров

- зливається

- метод

- мільйони

- модель

- Моделі

- місяців

- більше

- найбільш

- Природний

- Природна мова

- Необхідність

- NeurIPS

- Нові

- Інформаційний бюлетень

- нетехнічні

- номер

- номера

- відбуваються

- трапляються

- of

- on

- OpenAI

- or

- оригінал

- викладені

- вихід

- пар

- Папір

- частина

- Минуле

- виконується

- виступає

- Вічний

- перспектива

- розміщення

- plato

- Інформація про дані Платона

- PlatoData

- пошта

- практично

- практики

- збереглися

- процес

- оброблена

- процеси

- обробка

- Вироблений

- прогрес

- за умови

- громадськість

- запит

- питання

- питань

- швидше

- досяг

- визнавати

- називають

- Відносини

- представляти

- подання

- Дослідники

- відповідальний

- зберігати

- зберігся

- Роль

- ROW

- Правила

- сфера

- послідовності

- комплект

- один

- Розмір

- So

- Софтвер

- Простір

- пробіли

- спеціальний

- конкретний

- Крок

- зберігання

- зберігати

- магазинів

- Запропонує

- сума

- система

- Systems

- таблиця

- Завдання

- команда

- Технологія

- текст

- Класифікація тексту

- генерація тексту

- текстуальний

- ніж

- Що

- Команда

- їх

- Там.

- отже

- Ці

- вони

- думати

- це

- ті

- тисячі

- через

- назва

- до

- знак

- Токенізація

- Жетони

- поїзд

- навчений

- Навчання

- трансформатор

- Переклад

- викликати

- Типи

- розуміти

- до

- на

- використання

- використовуваний

- користувач

- зазвичай

- значення

- Цінності

- різноманітність

- різний

- постачальники

- Відео

- вид

- переглянуті

- було

- шлях..

- we

- тижні

- вага

- були

- Що

- коли

- Чи

- який

- всі

- широкий

- з

- в

- слово

- слова

- Work

- працює

- так

- ви

- зефірнет