Yazara göre resim

Veri Yönetişimi ve Yapay Zeka yorgunluğu iki farklı kavram gibi görünse de ikisi arasında içsel bir bağlantı var. Daha iyi anlamak için tanımlarıyla başlayalım.

Uzun zamandır veri endüstrisinin temel odak noktası olmuştur.

Google bunu çok iyi ifade ediyor: “Veri yönetimi, verilerin güvenli, özel, doğru, kullanılabilir ve kullanılabilir olmasını sağlamak için yaptığınız her şeydir. Verilerin nasıl toplandığı, saklandığı, işlendiği ve imha edildiğine ilişkin iç standartların (veri politikalarının) belirlenmesini içerir."

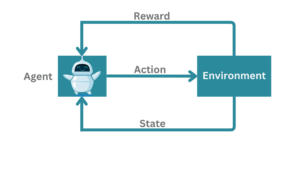

Bu tanımın da vurguladığı gibi, veri yönetişimi, verileri yönetmekle, yani yapay zeka modellerini yönlendiren motorla ilgilidir.

Artık veri yönetimi ile yapay zeka arasındaki bağlantının ilk işaretleri ortaya çıkmaya başladığına göre, bunu yapay zeka yorgunluğuyla ilişkilendirelim. Adı belli olsa da, bu yorgunluğa yol açan nedenlerin vurgulanması, bu terimin yazı boyunca tutarlı bir şekilde kullanılmasını sağlar.

Yapay zeka yorgunluğu, kuruluşların, geliştiricilerin veya ekiplerin karşılaştığı aksaklıklar ve zorluklar nedeniyle ortaya çıkar ve çoğu zaman yapay zeka sistemlerinin başarısız değer gerçekleştirmesine veya uygulanmasına yol açar.

Çoğunlukla yapay zekanın neler yapabileceğine dair gerçekçi olmayan beklentilerle başlar. Yapay zeka gibi gelişmiş teknolojiler için, kilit paydaşların yalnızca yapay zekanın yetenekleri ve olanaklarına değil, aynı zamanda sınırlamalarına ve risklerine de uyum sağlaması gerekir.

Risklerden bahsetmişken, etik genellikle sonradan akla gelen ve uyumlu olmayan yapay zeka girişimlerinin hurdaya çıkarılmasına yol açan bir düşünce olarak görülüyor.

Bu yazının amacı olan yapay zeka yorgunluğuna neden olan veri yönetiminin rolünü merak ediyor olmalısınız.

Bundan sonra gideceğimiz yer orası.

Yapay zeka yorgunluğu genel olarak dağıtım öncesi ve dağıtım sonrası olarak kategorize edilebilir. Öncelikle ön dağıtıma odaklanalım.

Dağıtım Öncesi

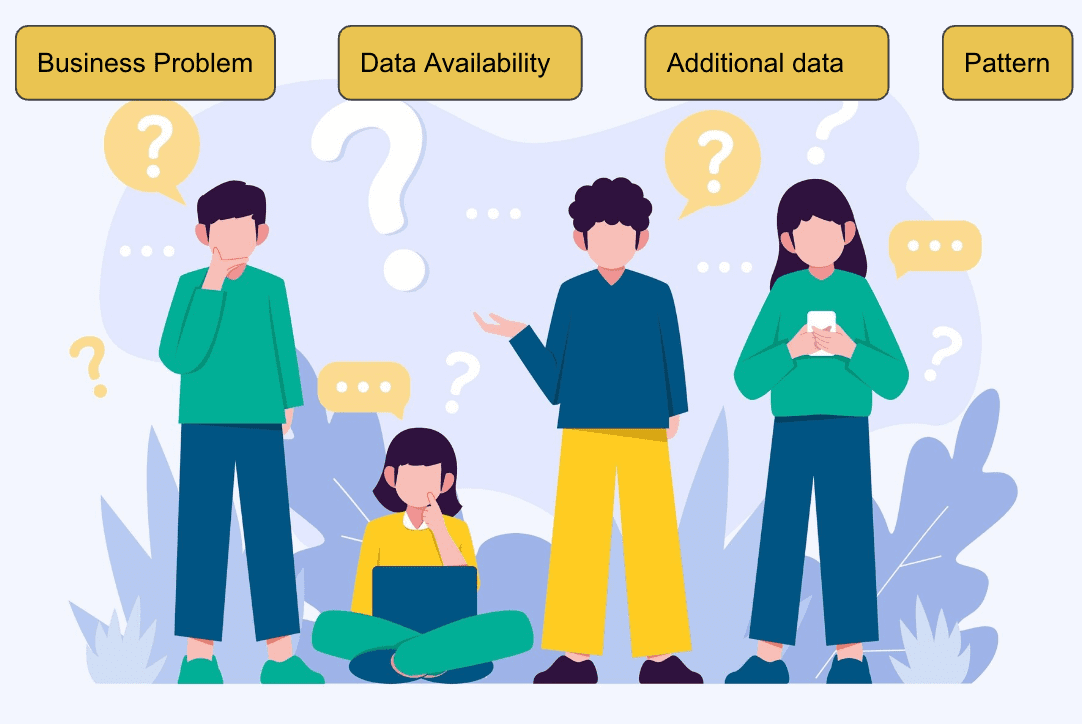

Konsept Kanıtının (PoC) dağıtım için derecelendirilmesine çeşitli faktörler katkıda bulunur, örneğin:

- Neyi çözmeye çalışıyoruz?

- Şimdi öncelik vermek neden zorlayıcı bir sorun haline geliyor?

- Hangi veriler mevcut?

- İlk etapta ML ile çözülebilir mi?

- Verilerin bir düzeni var mı?

- Bu fenomen tekrarlanabilir mi?

- Hangi ek veriler model performansını artırır?

Image Freepik

Sorunun en iyi şekilde ML algoritmaları kullanılarak çözülebileceğini değerlendirdikten sonra veri bilimi ekibi, keşfedici bir veri analizi gerçekleştirir. Bu aşamada, verilen verilerin sinyal açısından zengin olup olmadığı vurgulanarak, temeldeki birçok veri modeli ortaya çıkarılır. Ayrıca algoritmanın öğrenme sürecini hızlandıracak mühendislik özellikleri oluşturmaya da yardımcı olur.

Daha sonra ekip, genellikle kabul edilebilir seviyede performans göstermediğini tespit ederek ilk temel modeli oluşturur. Yazı-tura kadar iyi çıktısı olan bir modelin hiçbir değeri yoktur. Bu, makine öğrenimi modelleri oluştururken karşılaşılan ilk aksaklıklardan, yani derslerden biridir.

Organizasyonlar bir iş probleminden diğerine geçerek yorgunluğa neden olabilir. Yine de temeldeki veriler zengin bir sinyal taşımıyorsa hiçbir yapay zeka algoritması bunun üzerine inşa edilemez. Modelin, görünmeyen veriler üzerinde genelleme yapmak için eğitim verilerinden istatistiksel ilişkileri öğrenmesi gerekir.

Dağıtım Sonrası

Eğitilen modelin doğrulama setinde umut verici sonuçlar vermesine rağmen, %70 hassasiyet gibi nitelikli iş kriterlerine uygun olarak, model üretim ortamında yeterli performansı gösteremezse yorgunluk yine de ortaya çıkabilir.

Bu tür yapay zeka yorgunluğuna dağıtım sonrası aşama denir.

Sayısız neden, performansın düşmesine neden olabilir; burada zayıf veri kalitesi, modeli rahatsız eden en yaygın sorundur. Önemli niteliklerin yokluğunda modelin hedef tepkisini doğru bir şekilde tahmin etme yeteneğini sınırlar.

Eğitim verilerinde yalnızca %10'u eksik olan temel özelliklerden birinin artık üretim verilerinde zamanın %50'sinde geçersiz hale geldiğini ve hatalı tahminlere yol açtığını düşünün. Modellerin tutarlı bir şekilde performans göstermesini sağlamaya yönelik bu tür yinelemeler ve çabalar, veri bilimcileri ve iş ekiplerinde yorgunluk yaratır, dolayısıyla veri hatlarına olan güveni aşındırır ve projeye yapılan yatırımları riske atar.

Güçlü veri yönetimi önlemleri, her iki türdeki yapay zeka yorgunluğunun üstesinden gelmede kritik öneme sahiptir. Verilerin ML modellerinin merkezinde yer aldığı göz önüne alındığında, sinyal açısından zengin, hatasız ve yüksek kaliteli veriler, bir ML projesinin başarısı için bir zorunluluktur. Yapay zeka yorgunluğunu gidermek, veri yönetimine güçlü bir şekilde odaklanmayı gerektirir. Bu nedenle, doğru veri kalitesini sağlamak için titizlikle çalışmalı, en son teknolojiye sahip modeller oluşturmanın ve güvenilir iş öngörüleri sunmanın temelini atmalıyız.

Veri kalitesi

Başarılı veri yönetiminin anahtarı olan veri kalitesi, makine öğrenimi algoritmaları için kritik bir başarı faktörüdür. Kuruluşların, veri tüketicilerine rapor yayınlamak gibi veri kalitesine yatırım yapması gerekir. Veri bilimi projelerinde, kötü kaliteli veriler modellere ulaştığında, performansın düşmesine yol açabilecek şeyleri düşünün.

Ekipler, yalnızca hata analizi sırasında veri kalitesiyle ilgili endişeleri belirleyebilir ve bunlar yukarı yönde düzeltilmek üzere gönderildiğinde ekipler arasında yorgunluğa neden olur.

Açıkçası, bu sadece harcanan çabadan ibaret değil, aynı zamanda doğru veriler gelmeye başlayana kadar kaybedilen çok fazla zaman da var.

Bu nedenle, bu tür zaman alıcı yinelemeleri önlemek için veri sorunlarının her zaman kaynağında düzeltilmesi önerilir. Sonuç olarak, yayınlanan veri kalitesi raporları, veri bilimi ekibine (veya bu konuda diğer alt kullanıcılara ve veri tüketicilerine) gelen verilerin kabul edilebilir kalitesini anlayarak atıfta bulunur.

Veri kalitesi ve yönetişim önlemleri olmasaydı, veri bilimcileri veri sorunlarıyla aşırı yüklenecek ve başarısız modellerin yapay zeka yorgunluğuna yol açmasına katkıda bulunacaktı.

Gönderide, yapay zeka yorgunluğunun ortaya çıktığı iki aşama vurgulandı ve veri kalitesi raporları gibi veri yönetişimi önlemlerinin, güvenilir ve sağlam modeller oluşturmaya nasıl yardımcı olabileceği sunuldu.

Kuruluşlar, veri yönetimi aracılığıyla sağlam bir temel oluşturarak, başarılı ve kusursuz yapay zeka geliştirme ve benimsemeye yönelik bir yol haritası oluşturabilir ve heyecan uyandırabilir.

Gönderinin yapay zeka yorgunluğunu ele almanın çeşitli yollarına bütünsel bir genel bakış sunmasını sağlamak için, veri yönetimi gibi diğer en iyi uygulamalarla birleştiğinde veri bilimi ekiplerinin anlamlı yapay zeka katkılarını daha kısa sürede oluşturmasını sağlayacak ve güçlendirecek organizasyon kültürünün rolünü de vurguluyorum. Daha hızlı.

Vidhi Chugh ölçeklenebilir makine öğrenimi sistemleri oluşturmak için ürün, bilim ve mühendisliğin kesiştiği noktada çalışan bir yapay zeka stratejisti ve dijital dönüşüm lideridir. Ödüllü bir inovasyon lideri, yazar ve uluslararası bir konuşmacıdır. Makine öğrenimini demokratikleştirme ve herkesin bu dönüşümün bir parçası olması için jargonu kırma misyonunda.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.kdnuggets.com/can-data-governance-address-ai-fatigue?utm_source=rss&utm_medium=rss&utm_campaign=can-data-governance-address-ai-fatigue

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- a

- kabiliyet

- Hakkımızda

- kabul edilebilir

- doğru

- tam olarak

- Ek

- adres

- adresleme

- Ekler

- yeterli olarak

- Benimseme

- tavsiye

- AI

- AI modelleri

- AI sistemleri

- aka

- algoritma

- algoritmalar

- hizalamak

- Ayrıca

- her zaman

- arasında

- an

- analiz

- ve

- Başka

- herhangi

- Tamam

- ARE

- ortaya

- AS

- dernekler

- At

- öznitelikleri

- yazar

- mevcut

- Ödüllü

- uzakta

- Kötü

- Temel

- BE

- olur

- olmuştur

- İYİ

- en iyi uygulamalar

- Daha iyi

- arasında

- her ikisi de

- mola

- geniş

- inşa etmek

- bina

- inşa

- iş

- fakat

- by

- denilen

- CAN

- yetenekleri

- yetenekli

- taşımak

- neden olan

- zorluklar

- Sikke

- kombine

- ortak

- zorlayıcı

- kavram

- kavramlar

- Endişeler

- güven

- bağ

- kabul

- tutarlı

- sürekli

- Tüketiciler

- katkıda bulunmak

- katkıda

- katkıları

- çekirdek

- olabilir

- yaratmak

- kriterleri

- kritik

- çok önemli

- Kültür

- veri

- veri analizi

- veri kalitesi

- veri bilimi

- tanım

- teslim etmek

- demokratikleştirmek

- açılma

- geliştiriciler

- gelişme

- farklı

- dijital

- dijital Dönüşüm

- do

- yok

- sürme

- gereken

- sırasında

- çaba

- çabaları

- çıkmak

- vurgulamak

- güçlendirmek

- etkinleştirmek

- enabler

- son

- Motor

- mühendislik

- Mühendislik

- sağlamak

- olmasını sağlar

- coşku

- çevre

- hata

- gerekli

- kurulması

- Eter (ETH)

- etik

- değerlendirilir

- sonunda

- herkes

- her şey

- beklentileri

- Açıklayıcı Veri Analizi

- Yüz

- faktör

- faktörler

- başarısız

- Daha hızlı

- yorgunluk

- Özellikler

- bulma

- Ad

- sabit

- sabit

- Fiske

- odak

- İçin

- vakıf

- itibaren

- toplanmış

- almak

- verilmiş

- verir

- Tercih Etmenizin

- yönetim

- zemin

- olur

- Var

- Başlık

- yardımcı olur

- Yüksek kaliteli

- Vurgulanan

- vurgulayarak

- özeti

- bütünsel

- Ne kadar

- HTTPS

- i

- belirlemek

- if

- uygulama

- in

- Gelen

- sanayi

- girişimler

- Yenilikçilik

- anlayışlar

- iç

- Uluslararası

- kavşak

- içine

- gerçek

- Yatırım yapmak

- Yatırımlar

- içerir

- konu

- sorunlar

- IT

- yineleme

- ONUN

- jargon

- sadece

- KDNuggets

- anahtar

- döşeme

- öncülük etmek

- lider

- önemli

- İlanlar

- ÖĞRENİN

- öğrenme

- Dersler

- izin

- seviye

- sevmek

- sınırlamaları

- sınırları

- çizgi

- LINK

- Uzun

- uzun zaman

- kayıp

- Çok

- makine

- makine öğrenme

- yapılmış

- yapmak

- YAPAR

- yönetme

- çok

- Mesele

- Mayıs..

- anlamlı

- önlemler

- orta

- eksik

- Misyonumuz

- ML

- ML algoritmaları

- model

- modelleri

- çoğu

- çoğunlukla

- hareket

- şart

- isim

- gerek

- sonraki

- yok hayır

- şimdi

- of

- sık sık

- on

- ONE

- bir tek

- or

- örgütsel

- organizasyonlar

- Diğer

- çıktı

- genel bakış

- Bölüm

- model

- desen

- yapmak

- performans

- icra

- gerçekleştirir

- faz

- fenomen

- boru

- yer

- Platon

- Plato Veri Zekası

- PlatoVeri

- PoC

- yoksul

- olanakları

- Çivi

- uygulamalar

- tam

- Hassas

- tahmin

- Tahminler

- sundu

- önlemek

- Öncelik

- özel

- Sorun

- süreç

- işlenmiş

- PLATFORM

- üretim

- proje

- Projeler

- umut verici

- kanıt

- kavramın ispatı

- yayınlanan

- Yayıncılık

- koyar

- niteleyici

- kalite

- kaliteli veri

- gerçekleşme

- nedenleri

- tekrarlanabilir

- Raporlar

- gerektirir

- yanıt

- Sonuçlar

- Zengin

- krallar gibi yaşamaya

- riske

- riskler

- yol haritası

- gürbüz

- Rol

- ölçeklenebilir

- Bilim

- BİLİMLERİ

- bilim adamları

- sorunsuz

- güvenli

- gönderdi

- set

- terslikler

- Setleri

- ayar

- o

- gösterme

- işaret

- İşaretler

- So

- katı

- ÇÖZMEK

- çözülmüş

- sofistike

- Ses

- Kaynak

- konuşmacı

- hız

- Aşama

- aşamaları

- paydaşlar

- başlama

- başladı

- başlar

- state-of-the-art

- istatistiksel

- Yine

- saklı

- Stratejist

- güçlü

- başarı

- başarılı

- böyle

- Sistemler

- tackling

- Hedef

- takım

- takım

- Teknolojileri

- dönem

- o

- The

- ve bazı Asya

- Orada.

- böylece

- düşünmek

- Re-Tweet

- gerçi?

- gelişen

- İçinden

- boyunca

- zaman

- zaman tükeniyor

- için

- eğitilmiş

- Eğitim

- Dönüşüm

- güvenilir

- çalışıyor

- iki

- tip

- türleri

- açık

- altında yatan

- anlamak

- anlayış

- kadar

- üzerine

- us

- kullanılabilir

- kullanım

- kullanıcılar

- kullanma

- onaylama

- değer

- oldu

- Yol..

- yolları

- we

- İYİ

- Ne

- ne zaman

- olup olmadığını

- hangi

- süre

- kimin

- irade

- ile

- merak

- İş

- çalışma

- olur

- sen

- zefirnet