Suresh, yarı iletkenler, yapay zeka, siber güvenlik, nesnelerin interneti, donanım, yazılım vb. konularda derin teknik uzmanlığa sahip bir teknoloji yöneticisidir. Sektörde 20 yıl geçirdi ve son olarak açık kaynak sıfır-kaynaklı ürünlerde İcra Direktörü olarak görev yaptı. Abu Dabi'deki Teknoloji İnovasyon Enstitüsü'nde ve Intel, Qualcomm ve MediaTek gibi diğer Fortune 500 yarı iletken şirketlerinde çeşitli liderlik rollerinde çip geliştirmeye güveniyor; burada yüksek performanslı, enerji tasarruflu, kuantum sonrası güvenli, emniyetli çipleri araştırıp geliştirdi Veri Merkezi, İstemci, Akıllı Telefon, Ağ İletişimi, Nesnelerin İnterneti ve AI/ML pazarları için mikroçipler/çip üzerinde sistem (SoC'ler)/ hızlandırıcılar. Falcon LLM'ye katkıda bulundu (kucaklayan yüz sıralamasında 1. sırada yer aldı) ve özel yapay zeka donanım platformunun baş mimarıydı (iptal edildi; öncelikler değişti). 15'ten fazla ABD Patentine sahiptir ve 20'den fazla konferansta yayınlanmış/sunum yapmıştır.

Suresh, yarı iletkenler, yapay zeka, siber güvenlik, nesnelerin interneti, donanım, yazılım vb. konularda derin teknik uzmanlığa sahip bir teknoloji yöneticisidir. Sektörde 20 yıl geçirdi ve son olarak açık kaynak sıfır-kaynaklı ürünlerde İcra Direktörü olarak görev yaptı. Abu Dabi'deki Teknoloji İnovasyon Enstitüsü'nde ve Intel, Qualcomm ve MediaTek gibi diğer Fortune 500 yarı iletken şirketlerinde çeşitli liderlik rollerinde çip geliştirmeye güveniyor; burada yüksek performanslı, enerji tasarruflu, kuantum sonrası güvenli, emniyetli çipleri araştırıp geliştirdi Veri Merkezi, İstemci, Akıllı Telefon, Ağ İletişimi, Nesnelerin İnterneti ve AI/ML pazarları için mikroçipler/çip üzerinde sistem (SoC'ler)/ hızlandırıcılar. Falcon LLM'ye katkıda bulundu (kucaklayan yüz sıralamasında 1. sırada yer aldı) ve özel yapay zeka donanım platformunun baş mimarıydı (iptal edildi; öncelikler değişti). 15'ten fazla ABD Patentine sahiptir ve 20'den fazla konferansta yayınlanmış/sunum yapmıştır.

Suresh ayrıca RISC-V International'da aktif olarak liderlik pozisyonunda görev yapıyor ve burada RISC-V gizli bilgi işlem yeteneğini geliştirmek üzere Güvenilir Bilgi İşlem Grubu'na başkanlık ediyor ve aşağıdakiler gibi AI/ML iş yükleri için RISC-V donanım hızlandırmayı geliştirmek üzere AI/ML Grubuna başkanlık ediyor. ChatGPT türü uygulamalarda kullanılan Transformer Büyük Dil Modelleri. Ayrıca yeni kurulan şirketlere ve risk sermayesi şirketlerine yatırım kararı desteği, ürün stratejisi, teknoloji durum tespiti vb. konularda danışmanlık yapmaktadır.

INSEAD'den MBA, Birla Institute of Technology & Science Pilani'den yüksek lisans, MIT'den Sistem Mühendisliği sertifikası, Stanford'dan AI sertifikası ve TÜV SÜD'den otomotiv fonksiyonel güvenlik sertifikası aldı.

Bize şirketinizden bahsedin

"Mastiṣka AI” (Mastiṣka, Sanskritçe'de Beyin anlamına gelir), yarının Üretken Yapay Zeka kullanım durumları için temel modelleri daha verimli bir şekilde çalıştırmak amacıyla beyin benzeri bilgisayarlar oluşturmaya odaklanmış bir Yapay Zeka şirketidir.

Hangi sorunları çözüyorsunuz?

AI/GenAI'nin yararları göz önüne alındığında, ona olan talebin artması kaçınılmazdır ve gezegenimiz üzerindeki yan etkileri de artacaktır. Yapay zekanın gezegenimiz üzerindeki yan etkilerini nasıl azaltabiliriz veya etkisiz hale getirebiliriz? Karbon yakalama ve nükleer enerji doğru yolda. Ancak yapay zeka yapma şeklimizi temel olarak yeniden düşünmemiz gerekiyor; tonlarca matris çarpımı yapmanın yanlış yolu mu bu?

Beynimiz 10W'ta ve altında birçok görevi paralel olarak öğrenebilir ve yapabilir, ancak bu yapay zeka sistemleri modelleri eğitmek için neden 10'larca megavat tüketiyor?

Belki de gelecekte, insan beynine en yakın olan, 100-1000 kat daha az enerji tüketebilecek, dolayısıyla yapay zekayı kullanmanın maliyetini azaltabilecek, böylece yapay zekayı demokratikleştirip tasarruf edebilecek nöromorfik mimariler ve sinir ağı tabanlı transformatörler gibi enerji verimli mimariler var. gezegen.

Yapay zeka ile karşılaştığımız mevcut zorluklar, yani a) kullanılabilirlik, b) erişilebilirlik, c) karşılanabilirlik ve d) çevre güvenliği ve bunların üstesinden gelmek için bazı öneriler.

Gelecekte öngörüde bulunursak, bazı yararlı YGZ konseptleri "HER" filminde gösteriliyor; burada doğal, duyguları anlayan, empati gösteren, iş yerinde harika bir yardımcı pilot olan 'Samantha' karakteri bir konuşma aracısı olarak çalışıyor. tüm gün boyunca elde taşınır cihazlarla çalışırsak, o zaman aşağıdaki zorlukları hemen şimdi çözmemiz gerekebilir.

Sorun 1: Bir Yüksek Lisans eğitiminin maliyeti 150 ila 10+ milyon dolar arasında olabilir ve bu yalnızca bütçesi daha geniş olanların yapay zeka geliştirmesine olanak tanır. Üstelik, çıkarım maliyetleri de çok büyük (web aramasından 10 kat daha pahalı)

—> Yapay zekayı insanlığın yararına demokratikleştirmek için modellerin/donanımların enerji verimliliğini artırmamız gerekiyor.

Sorun 2: Konuşma aracıları veya öneri sistemleri için devasa yapay zeka modellerini çalıştırmak, elektrik tüketimi ve soğutma açısından çevreye zarar veriyor.

—> Gezegenimizi çocuklarımız için kurtarmak amacıyla modellerin/donanımların enerji verimliliğini artırmamız gerekiyor.

Sorun 3: İnsan beyni birden fazla görevi yerine getirme yeteneğine sahiptir ancak Megawatt yerine yalnızca 10 Watt tüketir.

-> Belki de normal matris çarpanlarını daha hızlı değil, beynimiz gibi makineler yapmalıyız.

İnsanlık ancak sürdürülebilir yeniliklerle gelişebilir; yenilik adına tüm ormanları kesip okyanusları kaynatarak değil. Çocuklarımızın ve gelecek nesillerin refahı için gezegenimizi korumalıyız…

En güçlü olduğunuz uygulama alanları hangileri?

Günümüzün GPU tabanlı çözümleri ile karşılaştırıldığında 50-100 kat daha fazla enerji verimliliğiyle Transformer (ve geleceğin sinir mimarisi) tabanlı temel modellerinin Eğitimi ve Çıkarımı.

Müşterilerinizi gece ayakta tutan nedir?

Halihazırda diğer ürünleri kullanan müşteriler için sorunlar:

Devasa dil modellerini eğitmek için elektrik tüketimi haddini aşıyor; örneğin, 13 gün boyunca 390 GPU üzerindeki 200B metin belirteçleri üzerinde 7B parametreli bir LLM'nin eğitiminin maliyeti 151,744 ABD dolarıdır (Kaynak: HuggingFace yeni eğitim kümesi hizmet sayfası – https://lnkd.in/g6Vc5cz3). Ve 100+B parametrelerine sahip daha büyük modellerin bile yalnızca eğitim maliyeti 10+M $'dır. Daha sonra her yeni bilgi istemi isteği geldiğinde çıkarım için ödeme yapın.

Soğutma için su tüketimi, Riverside Kaliforniya Üniversitesi'ndeki araştırmacılar, ChatGPT benzeri hizmetin çevresel etkisini tahmin etti ve her sorduğunuzda 500 mililitre su (16 onsluk bir su şişesindekine yakın) tükettiğini söylüyor. 5 ila 50 arası bilgi istemi veya sorudan oluşan bir dizi. Aralık, sunucularının bulunduğu yere ve sezona bağlı olarak değişir. Tahmin, veri merkezlerine elektrik sağlayan enerji santrallerini soğutmak gibi şirketlerin ölçmediği dolaylı su kullanımını da içeriyor. (Kaynak: https://lnkd.in/gybcxX8C)

Mevcut ürünlerin müşterisi olmayanlar için sorunlar:

Donanım satın almak için CAPEX'i karşılayamıyorum

Bulut hizmetlerini kullanmaya gücüm yetmiyor

Yenilik yapamıyor veya yapay zekadan yararlanamıyor; her türlü rekabet avantajını ortadan kaldıran hizmet modeline takılıp kalıyoruz

Rekabet ortamı nasıl görünüyor ve nasıl farklılaşıyorsunuz?

- Uzman ASIC'ler de bu segmentte rekabet etse de GPU'lar eğitim alanına hakim durumda

- Bulut ve Kenar çıkarımının çok fazla seçeneği var

Dijital, Analog, Fotonik; adını siz koyun, insanlar aynı sorunu çözmeye çalışıyor.

AI/ML için çip mimarisinin mevcut durumu hakkındaki düşüncelerinizi paylaşabilir misiniz, yani şu anda en önemli trendler ve fırsatlar olarak neleri görüyorsunuz?

Aşağıdaki trendler:

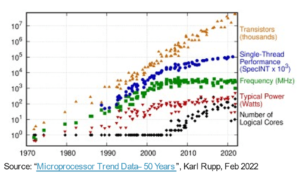

Eğilim 1: 10 yıl önce donanım destekli derin öğrenme gelişti ve şimdi aynı donanım ilerlemeyi engelliyor. Modellerin çalıştırılması için gereken yüksek donanım ve elektrik maliyetleri nedeniyle, donanıma erişim zor hale geldi. Yalnızca cebi geniş olan şirketler bunları karşılayabiliyor ve tekel haline geliyor.

Eğilim 2: Artık bu modeller mevcut olduğuna göre, çıkarım yükünün artması ve AI hızlandırıcılara sahip CPU'ların yeniden ilgi odağı haline gelmesi için bunları pratik amaçlarla kullanmamız gerekiyor.

Eğilim 3: Startup'lar, logaritmik ve pozitif tabanlı gibi geleneksel IEEE formatının iyi ancak yeterli olmadığını gösteren alternatif kayan noktalı sayı temsilleri bulmaya çalışıyor. PPA $ tasarım alanı optimizasyonu, birini optimize etmeye çalıştığımızda patlıyor ve diğeri çöpe gidiyor.

Eğilim 4: Sektör, hizmet tabanlı yapay zeka modelinden kendi özel modellerini kendi tesislerinde barındırmaya doğru ilerliyor; ancak donanıma erişim, arz kıtlığı, yaptırımlar vb. nedeniyle bir zorluk.

Mevcut durum:

Donanım ve verilerin kullanılabilirliği 10 yıl önce yapay zekanın büyümesini hızlandırmıştı, şimdi aynı donanım bunu bir nevi engelliyor - açıklayayım

CPU'lar kötü durumda olduğundan ve GPU'lar yapay zeka yapmak üzere yeniden tasarlandığından beri pek çok şey oldu

Şirketler AI/ML'nin 4 segmentini ele alıyor: 1) bulut eğitimi, 2) bulut çıkarımı, 3) uç çıkarımı ve 4) uç eğitimi (gizliliğe duyarlı uygulamalar için birleşik öğrenme).

Dijital ve Analog

Eğitim tarafı - GPU'lar, RISC-V'ye dayalı müşteri hızlandırıcıları, yonga ölçeğinde yongalar (850K çekirdek) ve benzeri geleneksel CPU'ların eksik olduğu yerlerde (genel amaçları) çalışan çok sayıda şirket. Çıkarım tarafı – NN hızlandırıcıları akıllı telefonlarda, dizüstü bilgisayarlarda ve diğer uç cihazlarda her üreticide mevcuttur.

Analog memristör tabanlı mimariler de bir süre önce ortaya çıktı.

Matris uzantıları gibi hızlandırmalarla geliştirirsek CPU'ların çıkarım yapmada çok iyi olabileceğine inanıyoruz.

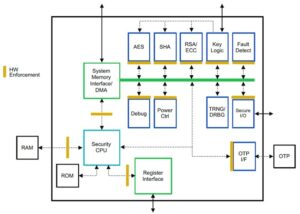

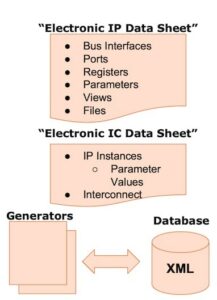

İşin RISC-V tarafı:

İşin RISC-V tarafında, transformatör iş yüklerindeki olası darboğazları ortadan kaldırmak amacıyla matris işlemleri ve diğer doğrusal olmayan işlemler için hızlandırıcılar geliştiriyoruz. Von Neumann darboğazları, belleklerin bilişime daha yakın tasarlanmasıyla da ele alınıyor ve sonunda yapay zeka hızlandırmalı CPU'lar çıkarım için doğru seçim haline geliyor.

Olanakları:

Temel modelleri pazarını doldurmak için benzersiz fırsatlar mevcuttur. Örnek – OpenAI, ChatGPT hizmetlerini zorlamaya devam etmek için yeterli yapay zeka hesaplamasını (GPU) güvence altına alamadıklarını belirtiyor… ve normal internet aramasının 10 katı elektrik maliyetleri ve sistemleri soğutmak için 500 ml su ile ilgili haberler her sorgu için. Burada doldurulması gereken bir pazar var - bu bir niş değil, yukarıda belirtilen tüm zorlukların üstesinden gelerek yapay zekayı demokratikleştirecek olan pazarın tamamıdır - a) kullanılabilirlik, b) erişilebilirlik, c) satın alınabilirlik ve d) çevresel güvenlik

Hangi yeni özellikler/teknoloji üzerinde çalışıyorsunuz?

Mevcut birçok açık çerçeveyi yeniden kullanarak, nöromodrifik tekniklerden yararlanan ve enerji tasarruflu donanımdan yararlanmak için modelleri uyarlayan bilgisayar benzeri beyinler inşa ediyoruz.

Önümüzdeki 12-18 ay içinde AI/ML sektörünün nasıl büyüyeceğini veya değişeceğini öngörüyorsunuz?

GPU'lara olan talebin azalması (maliyeti 30 bin dolar gibi) ve dünyanın bazı bölgeleri bu GPU'ları satın almak için yaptırımlarla karşı karşıya kalırken, dünyanın bazı bölgeleri GPU'lara erişim olmaksızın yapay zeka araştırma ve geliştirmesinin donduğunu düşünüyor. Alternatif donanım platformları pazarı ele geçirecek.

Modeller belki küçülmeye başlayacak; özel modeller ve hatta temelde bilgi yoğunluğu artacak

Aynı soru ama önümüzdeki 3-5 yıldaki büyüme ve değişim ne olacak?

a) Yapay Zeka uzantılarına sahip CPU'lar, Yapay Zeka çıkarım pazarını ele geçirebilir

b) Bilgi yoğunluğu %16'dan %90'a çıktıkça modeller çevik hale gelecek ve parametreler devre dışı kalacaktır

c) Enerji verimliliği artar, CO2 ayak izi azalır

d) Yeni mimariler ortaya çıkıyor

e) donanım maliyetleri ve enerji maliyetleri düşer, böylece küçük şirketlerin modeller oluşturması ve eğitmesi için giriş engeli karşılanabilir hale gelir

f) insanlar AGI öncesi andan bahsediyor, ancak benim referansım "her" filmindeki karakter Samantha (konuşmacı yapay zeka) olacaktır.. ölçeği büyütmenin yüksek maliyeti göz önüne alındığında bu pek mümkün olmayabilir

AI/ML sektöründeki büyümeyi etkileyebilecek veya sınırlayabilecek zorluklardan bazıları nelerdir?

a) Donanıma erişim

b) Enerji maliyetleri ve soğutma maliyetleri ve çevreye zarar

Ayrıca Oku:

CEO Röportajı: Pragmatic'ten David Moore

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 150

- 20

- 20 yıl

- 200

- 50

- 500

- 7

- a

- Yapabilmek

- Hakkımızda

- yukarıdaki

- abu dhabi

- hızlanma

- hızlandırıcılar

- erişim

- ulaşabilme

- aktif

- adres

- ele

- adresleme

- avantaj

- Işler

- tekrar

- Danışman

- ajanları

- AGI

- önce

- AI

- AI modelleri

- ai araştırma

- AI sistemleri

- AI kullanım durumları

- AI / ML

- hizalı

- Türkiye

- Izin

- veriyor

- boyunca

- Ayrıca

- alternatif

- şaşırtıcı

- an

- ve

- Başka

- herhangi

- hiçbir yerde

- Uygulama

- uygulamaları

- mimari

- ARE

- alanlar

- Geldiğinde

- yapay

- yapay zeka

- AS

- Asics

- sormak

- At

- otomotiv

- kullanılabilirliği

- mevcut

- uzakta

- b

- bariyer

- merkezli

- BE

- müşterimiz

- olur

- olma

- olmuştur

- olmak

- Inanmak

- altında

- kıyaslama

- yarar

- faydaları

- arasında

- Ötesinde

- darboğazları

- bağlı

- Beyin

- beyin

- inşa etmek

- bina

- fakat

- satın almak

- by

- Kaliforniya

- CAN

- iptal edildi

- kabiliyet

- yetenekli

- Başkent

- ele geçirmek

- karbon

- karbon yakalama

- durumlarda

- Merkezleri

- ceo

- CEO Röportajı

- sertifika

- meydan okuma

- zorluklar

- değişiklik

- değişmiş

- değiştirme

- karakter

- ChatGPT

- Çocuk

- yonga

- cips

- seçim

- Chopra

- müşteri

- Kapanış

- yakın

- bulut

- Küme

- co2

- nasıl

- Şirketler

- şirket

- karşılaştırıldığında

- yarışmak

- rekabet

- hesaplamak

- bilgisayar

- bilgisayarlar

- bilgisayar

- kavramlar

- konferanslar

- tüketmek

- tüketim

- devam etmek

- katkıda

- konuşkan

- konuşma yapay zekası

- Serin

- Ücret

- maliyetler

- olabilir

- yaratmak

- akım

- Şu anki durum

- Şu anda

- görenek

- müşteri

- Müşteriler

- kesim

- Siber güvenlik

- veri

- veri merkezleri

- Datacenter

- David

- gün

- Günler

- karar

- derin

- derin öğrenme

- derin

- Talep

- demokratikleştirmek

- Demokratikleştirilmesi

- gösterdi

- yoğunluk

- bağlı

- Dizayn

- geliştirmek

- gelişmiş

- gelişen

- gelişme

- Cihaz

- Dabi

- farklılaştırmak

- çalışkanlık

- yön

- yönetmen

- do

- yok

- yapıyor

- dolar

- Dont

- aşağı

- dr

- Damla

- gereken

- Kazanılan

- kenar

- etkileri

- verim

- verimli

- verimli biçimde

- elektrik

- elektrik tüketimi

- gidermek

- ortadan kaldırır

- duygular

- Empati

- enerji

- enerji verimliliği

- Mühendislik

- artırmak

- yeterli

- Tüm

- giriş

- çevre

- çevre

- gözünün önüne getirmek

- tahmin

- tahmini

- vb

- Eter (ETH)

- Hatta

- sonunda

- Her

- örnek

- yürütme

- Yetliki Direktör

- mevcut

- Uzmanlık

- Patlar

- uzantıları

- Yüz

- karşı

- şahin

- Daha hızlı

- duygu

- doldurmak

- firmalar

- yüzer

- odaklanmış

- Ayak

- İçin

- önceden görmek

- biçim

- Kısmet

- vakıf

- çerçeveler

- itibaren

- dondurulmuş

- yakıtlı

- fonksiyonel

- esasen

- gelecek

- genel

- nesiller

- üretken

- üretken yapay zeka

- verilmiş

- Go

- Goes

- gidiş

- Tercih Etmenizin

- GPU'lar

- grup

- Büyüyen

- Büyüme

- donanım

- Var

- he

- bundan dolayı

- okuyun

- Yüksek

- tutar

- hosting

- Ne kadar

- HTTPS

- Kocaman

- SarılmaYüz

- insan

- İnsanlık

- IEEE

- if

- görüntü

- darbe

- iyileştirmek

- geliştirir

- in

- Diğer

- içerir

- Artırmak

- sanayi

- bilgi

- yenilik yapmak

- Yenilikçilik

- yenilikler

- yerine

- Enstitü

- Intel

- İstihbarat

- Uluslararası

- Internet

- görüşme

- yatırım

- IOT

- IT

- ONUN

- sadece

- çocuklar

- Nezaket.

- Eksiklik

- manzara

- dil

- dizüstü bilgisayarlar

- büyük

- büyük

- öncülük etmek

- Liderlik

- ÖĞRENİN

- öğrenme

- izin

- Kaldıraç

- kaldıraç

- sevmek

- sahne ışığı

- LİMİT

- yük

- bulunan

- Bakın

- gibi görünmek

- alt

- Makineler

- Yapımı

- Üretici firma

- çok

- pazar

- Piyasalar

- Matris

- maksimum genişlik

- Mayıs..

- olabilir

- MBA

- me

- anlam

- anlamına geliyor

- ölçmek

- hatıralar

- adı geçen

- olabilir

- milyon

- milyon dolar

- İLE

- model

- modelleri

- an

- tekeller

- ay

- Daha

- çoğu

- film

- hareketli

- MS

- şart

- my

- isim

- yani

- Doğal (Madenden)

- gerek

- ağ tabanlı

- ağ

- sinirsel

- yeni

- haber

- sonraki

- niş

- gece

- çevik

- şimdi

- nükleer

- Nükleer güç

- numara

- okyanuslar

- of

- on

- ONE

- bir tek

- açık

- açık kaynak

- OpenAI

- Operasyon

- Fırsatlar

- optimizasyon

- optimize

- Opsiyonlar

- or

- Diğer

- bizim

- dışarı

- kendi

- Kanal

- Paralel

- parametre

- parametreler

- parçalar

- Patentler

- İnsanlar

- belki

- gezegen

- bitkiler

- platform

- Platformlar

- Platon

- Plato Veri Zekası

- PlatoVeri

- bolluk

- artı

- cepler

- Nokta

- pozisyon

- mümkün

- güç kelimesini seçerim

- santraller

- Pratik

- özel

- Sorun

- sorunlar

- PLATFORM

- Ürünler

- Profil

- Ilerleme

- istemleri

- korumak

- amaç

- amaçlı

- Itmek

- koyar

- Qualcomm

- soru

- Sorular

- menzil

- sırada

- Okumak

- geçenlerde

- Tavsiye

- tavsiyeler

- azaltmak

- azaltarak

- düzenli

- Raporlar

- talep

- araştırma

- araştırma ve geliştirme

- Araştırmacılar

- krallar gibi yaşamaya

- Nehir kenarı

- rolleri

- çatı

- koşmak

- koşu

- ishal

- güvenli

- Güvenlik

- aynı

- Yaptırımlar

- kum havuzu

- İndirim

- tasarruf

- söylemek

- ölçekleme

- Bilim

- Ara

- sezon

- sektör

- güvenli

- görmek

- segmentler

- yarıiletken

- Yarı iletkenler

- Dizi

- sunucular

- hizmet

- Hizmetler

- servis

- paylaş

- sıkıntısı

- meli

- gösterdi

- Gösteriler

- yan

- önemli

- beri

- daha küçük

- akıllı telefon

- akıllı telefonlar

- So

- Yazılım

- Çözümler

- Çözme

- biraz

- Kaynak

- uzay

- özel

- harcanmış

- stanford

- başlama

- Startups

- Eyalet

- Stratejileri

- güçlü

- böyle

- arz

- destek

- sürdürülebilir

- Sistemler

- ele almak

- tackling

- terzilik

- Bizi daha iyi tanımak için

- Konuşmak

- görevleri

- Teknik

- Teknoloji

- teknoloji yeniliği

- şartlar

- metin

- göre

- o

- The

- Gelecek

- Bilgi

- Dünya

- ve bazı Asya

- Onları

- sonra

- Orada.

- böylece

- Bunlar

- onlar

- işler

- Re-Tweet

- Bu

- gerçi?

- Gelişmek

- zaman

- için

- bugünkü

- Jeton

- yarın

- çok

- üst

- atmak

- geleneksel

- Tren

- Eğitim

- transformatör

- transformatörler

- Trendler

- Güvenilir

- denemek

- çalışıyor

- altında

- anlar

- üniversite

- California Üniversitesi

- olası

- us

- kullanım

- kullanım

- Kullanılmış

- kullanma

- çeşitli

- girişim

- girişim sermayesi

- Girişim sermayesi firmaları

- çok

- arasında

- oldu

- Su

- Yol..

- we

- ağ

- Refah

- vardı

- Ne

- ne zaman

- hangi

- DSÖ

- neden

- irade

- ile

- olmadan

- İş

- çalışma

- Dünya

- olur

- Yanlış

- yıl

- sen

- zefirnet