ด้วยการเปิดตัวฟีเจอร์การค้นหาแบบนิวรัลสำหรับ บริการ Amazon OpenSearch ใน OpenSearch 2.9 ขณะนี้การผสานรวมกับโมเดล AI/ML เพื่อขับเคลื่อนการค้นหาความหมายและกรณีการใช้งานอื่นๆ เป็นเรื่องง่าย OpenSearch Service รองรับทั้งการค้นหาคำศัพท์และเวกเตอร์นับตั้งแต่เปิดตัวฟีเจอร์ k-nearest Neighbor (k-NN) ในปี 2020 อย่างไรก็ตาม การกำหนดค่าการค้นหาเชิงความหมายจำเป็นต้องสร้างเฟรมเวิร์กเพื่อรวมโมเดลการเรียนรู้ของเครื่อง (ML) เพื่อนำเข้าและค้นหา คุณลักษณะการค้นหาแบบนิวรัลช่วยอำนวยความสะดวกในการแปลงข้อความเป็นเวกเตอร์ในระหว่างการนำเข้าและการค้นหา เมื่อคุณใช้การสืบค้นแบบนิวรัลระหว่างการค้นหา การสืบค้นจะถูกแปลเป็นการฝังเวกเตอร์ และใช้ k-NN เพื่อส่งคืนการฝังเวกเตอร์ที่ใกล้ที่สุดจากคลังข้อมูล

หากต้องการใช้การค้นหาแบบนิวรัล คุณต้องตั้งค่าโมเดล ML เราขอแนะนำให้กำหนดค่าตัวเชื่อมต่อ AI/ML กับบริการ AWS AI และ ML (เช่น อเมซอน SageMaker or อเมซอน เบดร็อค) หรือทางเลือกอื่นของบุคคลที่สาม ตั้งแต่เวอร์ชัน 2.9 บน OpenSearch Service ตัวเชื่อมต่อ AI/ML จะผสานรวมกับการค้นหาแบบนิวรัล เพื่อลดความซับซ้อนและดำเนินการการแปลคลังข้อมูลและการสืบค้นของคุณเป็นการฝังเวกเตอร์ ดังนั้นจึงช่วยขจัดความซับซ้อนของการไฮเดรชั่นและการค้นหาเวกเตอร์ได้มาก

ในโพสต์นี้ เราจะสาธิตวิธีกำหนดค่าตัวเชื่อมต่อ AI/ML ให้กับโมเดลภายนอกผ่านคอนโซล OpenSearch Service

ภาพรวมโซลูชัน

โดยเฉพาะ โพสต์นี้จะแนะนำคุณตลอดขั้นตอนการเชื่อมต่อกับโมเดลใน SageMaker จากนั้นเราจะแนะนำคุณตลอดการใช้ตัวเชื่อมต่อเพื่อกำหนดค่าการค้นหาเชิงความหมายบน OpenSearch Service เป็นตัวอย่างกรณีการใช้งานที่รองรับผ่านการเชื่อมต่อกับโมเดล ML ขณะนี้การผสานรวม Amazon Bedrock และ SageMaker ได้รับการสนับสนุนบน UI คอนโซล OpenSearch Service และรายการการผสานรวมจากบุคคลที่หนึ่งและบุคคลที่สามที่รองรับ UI จะยังคงเพิ่มขึ้นต่อไป

สำหรับโมเดลใดๆ ที่ไม่รองรับผ่าน UI คุณสามารถตั้งค่าโดยใช้ API ที่มีอยู่และ พิมพ์เขียว ML. สำหรับข้อมูลเพิ่มเติม โปรดดูที่ ข้อมูลเบื้องต้นเกี่ยวกับโมเดล OpenSearch. คุณสามารถค้นหาพิมพ์เขียวสำหรับตัวเชื่อมต่อแต่ละตัวได้ใน พื้นที่เก็บข้อมูล ML Commons GitHub.

เบื้องต้น

ก่อนที่จะเชื่อมต่อโมเดลผ่านคอนโซล OpenSearch Service ให้สร้างโดเมน OpenSearch Service แผนที่ AWS Identity และการจัดการการเข้าถึง (IAM) บทบาทตามชื่อ LambdaInvokeOpenSearchMLCommonsRole ในฐานะบทบาทแบ็กเอนด์ใน ml_full_access บทบาทโดยใช้ปลั๊กอินความปลอดภัยบน OpenSearch Dashboards ดังที่แสดงในวิดีโอต่อไปนี้ เวิร์กโฟลว์การรวม OpenSearch Service ได้รับการกรอกไว้ล่วงหน้าเพื่อใช้ LambdaInvokeOpenSearchMLCommonsRole บทบาท IAM ตามค่าเริ่มต้นเพื่อสร้างตัวเชื่อมต่อระหว่างโดเมน OpenSearch Service และโมเดลที่ใช้งานบน SageMaker หากคุณใช้บทบาท IAM ที่กำหนดเองในการรวมคอนโซล OpenSearch Service ตรวจสอบให้แน่ใจว่าบทบาทที่กำหนดเองได้รับการแมปเป็นบทบาทแบ็กเอนด์ด้วย ml_full_access สิทธิ์ก่อนที่จะปรับใช้เทมเพลต

ปรับใช้โมเดลโดยใช้ AWS CloudFormation

วิดีโอต่อไปนี้สาธิตขั้นตอนในการใช้คอนโซล OpenSearch Service เพื่อปรับใช้โมเดลภายในไม่กี่นาทีบน Amazon SageMaker และสร้าง ID โมเดลผ่านตัวเชื่อมต่อ AI ขั้นตอนแรกคือการเลือก integrations ในบานหน้าต่างนำทางบนคอนโซล OpenSearch Service AWS ซึ่งกำหนดเส้นทางไปยังรายการการผสานรวมที่มีอยู่ การผสานรวมได้รับการตั้งค่าผ่าน UI ซึ่งจะแจ้งให้คุณป้อนข้อมูลที่จำเป็น

ในการตั้งค่าการรวม คุณจะต้องระบุตำแหน่งข้อมูลโดเมน OpenSearch Service และระบุชื่อโมเดลเพื่อระบุการเชื่อมต่อโมเดลโดยไม่ซ้ำกัน ตามค่าเริ่มต้น เทมเพลตจะปรับใช้โมเดลตัวแปลงประโยค Hugging Face djl://ai.djl.huggingface.pytorch/sentence-transformers/all-MiniLM-L6-v2.

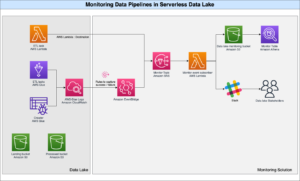

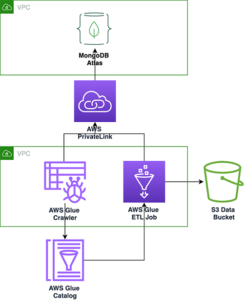

เมื่อคุณเลือก สร้างกองคุณถูกส่งไปยัง การก่อตัวของ AWS Cloud คอนโซล เทมเพลต CloudFormation ปรับใช้สถาปัตยกรรมที่มีรายละเอียดในไดอะแกรมต่อไปนี้

สแต็ก CloudFormation สร้างไฟล์ AWS แลมบ์ดา แอปพลิเคชันที่ปรับใช้โมเดลจาก บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (Amazon S3) สร้างตัวเชื่อมต่อ และสร้าง ID โมเดลในเอาต์พุต จากนั้นคุณสามารถใช้รหัสโมเดลนี้เพื่อสร้างดัชนีความหมายได้

หากโมเดล all-MiniLM-L6-v2 เริ่มต้นไม่ตอบสนองวัตถุประสงค์ของคุณ คุณสามารถปรับใช้โมเดลการฝังข้อความใดๆ ที่คุณเลือกบนโฮสต์โมเดลที่เลือก (SageMaker หรือ Amazon Bedrock) โดยการจัดเตรียมอาร์ติแฟกต์โมเดลของคุณเป็นอ็อบเจ็กต์ S3 ที่สามารถเข้าถึงได้ หรือคุณสามารถเลือกรายการใดรายการหนึ่งต่อไปนี้ แบบจำลองภาษาที่ได้รับการฝึกอบรมล่วงหน้า และปรับใช้กับ SageMaker หากต้องการคำแนะนำในการตั้งค่าตำแหน่งข้อมูลและโมเดลของคุณ โปรดดูที่ อิมเมจของ Amazon SageMaker ที่มีจำหน่าย.

SageMaker เป็นบริการที่มีการจัดการเต็มรูปแบบซึ่งรวบรวมชุดเครื่องมือที่หลากหลายเพื่อเปิดใช้งาน ML ประสิทธิภาพสูงและราคาประหยัดสำหรับทุกกรณีการใช้งาน โดยมอบคุณประโยชน์ที่สำคัญ เช่น การตรวจสอบโมเดล โฮสติ้งแบบไร้เซิร์ฟเวอร์ และระบบอัตโนมัติของเวิร์กโฟลว์สำหรับการฝึกอบรมและการปรับใช้อย่างต่อเนื่อง SageMaker ช่วยให้คุณสามารถโฮสต์และจัดการวงจรชีวิตของโมเดลการฝังข้อความ และใช้โมเดลเหล่านี้เพื่อขับเคลื่อนคำค้นหาเชิงความหมายใน OpenSearch Service เมื่อเชื่อมต่อแล้ว SageMaker จะโฮสต์โมเดลของคุณ และใช้ OpenSearch Service เพื่อสืบค้นตามผลการอนุมานจาก SageMaker

ดูโมเดลที่ปรับใช้ผ่าน OpenSearch Dashboards

หากต้องการตรวจสอบว่าเทมเพลต CloudFormation ปรับใช้โมเดลบนโดเมน OpenSearch Service และรับ ID โมเดลได้สำเร็จ คุณสามารถใช้ ML Commons REST GET API ผ่าน OpenSearch Dashboards Dev Tools

ขณะนี้ GET _plugins REST API มี API เพิ่มเติมเพื่อดูสถานะของโมเดลด้วย คำสั่งต่อไปนี้ช่วยให้คุณเห็นสถานะของโมเดลระยะไกล:

ดังที่แสดงในภาพหน้าจอต่อไปนี้ DEPLOYED สถานะในการตอบกลับบ่งชี้ว่าโมเดลถูกปรับใช้บนคลัสเตอร์ OpenSearch Service เรียบร้อยแล้ว

หรือคุณสามารถดูโมเดลที่ใช้งานบนโดเมน OpenSearch Service ของคุณโดยใช้ เครื่องเรียนรู้ หน้าแดชบอร์ด OpenSearch

หน้านี้แสดงรายการข้อมูลโมเดลและสถานะของโมเดลทั้งหมดที่ปรับใช้

สร้างไปป์ไลน์ประสาทโดยใช้รหัสโมเดล

เมื่อสถานะของโมเดลแสดงเป็นอย่างใดอย่างหนึ่ง DEPLOYED ในเครื่องมือ Dev หรือสีเขียวและ การตอบสนอง ใน OpenSearch Dashboards คุณสามารถใช้รหัสโมเดลเพื่อสร้างไปป์ไลน์การนำเข้าประสาทของคุณได้ ไปป์ไลน์การนำเข้าต่อไปนี้ทำงานในเครื่องมือนักพัฒนา OpenSearch Dashboards Dev ของโดเมนของคุณ ตรวจสอบให้แน่ใจว่าคุณแทนที่รหัสโมเดลด้วยรหัสเฉพาะที่สร้างขึ้นสำหรับโมเดลที่ใช้งานบนโดเมนของคุณ

สร้างดัชนีการค้นหาความหมายโดยใช้ไปป์ไลน์ประสาทเป็นไปป์ไลน์เริ่มต้น

ตอนนี้คุณสามารถกำหนดการแมปดัชนีของคุณด้วยไปป์ไลน์เริ่มต้นที่กำหนดค่าให้ใช้ไปป์ไลน์ประสาทใหม่ที่คุณสร้างในขั้นตอนก่อนหน้า ตรวจสอบให้แน่ใจว่าฟิลด์เวกเตอร์ได้รับการประกาศเป็น knn_vector และมิติข้อมูลมีความเหมาะสมกับโมเดลที่ใช้งานบน SageMaker หากคุณคงการกำหนดค่าเริ่มต้นเพื่อปรับใช้โมเดล all-MiniLM-L6-v2 บน SageMaker ให้คงการตั้งค่าต่อไปนี้ตามเดิม และเรียกใช้คำสั่งในเครื่องมือ Dev

นำเข้าเอกสารตัวอย่างเพื่อสร้างเวกเตอร์

สำหรับการสาธิตนี้ คุณสามารถนำเข้าไฟล์ ตัวอย่างแค็ตตาล็อกผลิตภัณฑ์สาธิตร้านค้าปลีก ไปที่ใหม่ semantic_demostore ดัชนี. แทนที่ชื่อผู้ใช้ รหัสผ่าน และตำแหน่งข้อมูลโดเมนด้วยข้อมูลโดเมนของคุณ และนำเข้าข้อมูลดิบลงใน OpenSearch Service:

ตรวจสอบดัชนี semantic_demostore ใหม่

เมื่อคุณได้นำเข้าชุดข้อมูลของคุณไปยังโดเมน OpenSearch Service แล้ว ให้ตรวจสอบว่าเวกเตอร์ที่จำเป็นถูกสร้างขึ้นหรือไม่โดยใช้การค้นหาแบบง่ายๆ เพื่อดึงข้อมูลทุกช่อง ตรวจสอบว่าฟิลด์ที่กำหนดเป็น knn_vectors มีเวกเตอร์ที่ต้องการ

เปรียบเทียบการค้นหาคำศัพท์และการค้นหาความหมายที่ขับเคลื่อนโดยการค้นหาแบบนิวรัลโดยใช้เครื่องมือเปรียบเทียบผลลัพธ์การค้นหา

พื้นที่ เปรียบเทียบเครื่องมือผลการค้นหา บน OpenSearch Dashboards พร้อมใช้งานสำหรับปริมาณงานการผลิต คุณสามารถนำทางไปยัง เปรียบเทียบผลการค้นหา หน้าและเปรียบเทียบผลลัพธ์การค้นหาระหว่างการค้นหาคำศัพท์และการค้นหาแบบประสาทที่กำหนดค่าให้ใช้รหัสโมเดลที่สร้างขึ้นก่อนหน้านี้

ทำความสะอาด

คุณสามารถลบทรัพยากรที่คุณสร้างได้โดยทำตามคำแนะนำในโพสต์นี้โดยการลบสแตก CloudFormation การดำเนินการนี้จะลบทรัพยากร Lambda และบัคเก็ต S3 ที่มีโมเดลที่ใช้งานกับ SageMaker ทำตามขั้นตอนต่อไปนี้:

- บนคอนโซล AWS CloudFormation ให้ไปที่หน้ารายละเอียดสแต็กของคุณ

- Choose ลบ.

- Choose ลบ เพื่อยืนยัน.

คุณสามารถตรวจสอบความคืบหน้าการลบสแต็กได้บนคอนโซล AWS CloudFormation

โปรดทราบว่าการลบสแตก CloudFormation จะไม่ลบโมเดลที่ใช้งานบนโดเมน SageMaker และตัวเชื่อมต่อ AI/ML ที่สร้างขึ้น เนื่องจากโมเดลเหล่านี้และตัวเชื่อมต่อสามารถเชื่อมโยงกับหลายดัชนีภายในโดเมนได้ หากต้องการลบโมเดลและตัวเชื่อมต่อที่เกี่ยวข้องโดยเฉพาะ ให้ใช้ API โมเดลตามที่แสดงในภาพหน้าจอต่อไปนี้

ประการแรก undeploy โมเดลจากหน่วยความจำโดเมน OpenSearch Service:

จากนั้นคุณสามารถลบโมเดลออกจากดัชนีโมเดลได้:

สุดท้าย ลบตัวเชื่อมต่อออกจากดัชนีตัวเชื่อมต่อ:

สรุป

ในโพสต์นี้ คุณได้เรียนรู้วิธีปรับใช้โมเดลใน SageMaker สร้างตัวเชื่อมต่อ AI/ML โดยใช้คอนโซล OpenSearch Service และสร้างดัชนีการค้นหาแบบนิวรัล ความสามารถในการกำหนดค่าตัวเชื่อมต่อ AI/ML ใน OpenSearch Service ช่วยลดความยุ่งยากของกระบวนการเวคเตอร์ไฮเดรชั่นโดยทำการผสานรวมกับโมเดลภายนอกแบบเนทิฟ คุณสามารถสร้างดัชนีการค้นหานิวรอลได้ภายในไม่กี่นาทีโดยใช้ไปป์ไลน์การนำเข้าประสาทและการค้นหานิวรัลที่ใช้รหัสโมเดลเพื่อสร้างเวกเตอร์ที่ฝังทันทีระหว่างการนำเข้าและการค้นหา

หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับตัวเชื่อมต่อ AI/ML โปรดดูที่ ตัวเชื่อมต่อ Amazon OpenSearch Service AI สำหรับบริการ AWS, การผสานรวมเทมเพลต AWS CloudFormation สำหรับการค้นหาความหมายและ การสร้างตัวเชื่อมต่อสำหรับแพลตฟอร์ม ML บุคคลที่สาม.

เกี่ยวกับผู้เขียน

อรุณา โกวินทราชู เป็นสถาปนิกโซลูชันผู้เชี่ยวชาญของ Amazon OpenSearch และเคยทำงานร่วมกับเสิร์ชเอ็นจิ้นเชิงพาณิชย์และโอเพ่นซอร์สมากมาย เธอหลงใหลในการค้นหา ความเกี่ยวข้อง และประสบการณ์ของผู้ใช้ ความเชี่ยวชาญของเธอในการเชื่อมโยงสัญญาณของผู้ใช้ปลายทางกับพฤติกรรมของเครื่องมือค้นหาได้ช่วยให้ลูกค้าจำนวนมากปรับปรุงประสบการณ์การค้นหาของตน

อรุณา โกวินทราชู เป็นสถาปนิกโซลูชันผู้เชี่ยวชาญของ Amazon OpenSearch และเคยทำงานร่วมกับเสิร์ชเอ็นจิ้นเชิงพาณิชย์และโอเพ่นซอร์สมากมาย เธอหลงใหลในการค้นหา ความเกี่ยวข้อง และประสบการณ์ของผู้ใช้ ความเชี่ยวชาญของเธอในการเชื่อมโยงสัญญาณของผู้ใช้ปลายทางกับพฤติกรรมของเครื่องมือค้นหาได้ช่วยให้ลูกค้าจำนวนมากปรับปรุงประสบการณ์การค้นหาของตน

แด็กนีย์ เบราน์ เป็นผู้จัดการผลิตภัณฑ์หลักที่ AWS ซึ่งเน้นเรื่อง OpenSearch

แด็กนีย์ เบราน์ เป็นผู้จัดการผลิตภัณฑ์หลักที่ AWS ซึ่งเน้นเรื่อง OpenSearch

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/big-data/power-neural-search-with-ai-ml-connectors-in-amazon-opensearch-service/

- :มี

- :เป็น

- :ไม่

- $ ขึ้น

- 1

- 100

- 12

- 15%

- 2020

- 25

- 7

- 8

- 9

- a

- ความสามารถ

- เกี่ยวกับเรา

- เข้า

- สามารถเข้าถึงได้

- เพิ่มเติม

- AI

- AI / ML

- ทั้งหมด

- ช่วยให้

- ด้วย

- ทางเลือก

- อเมซอน

- อเมซอน SageMaker

- Amazon Web Services

- an

- และ

- ใด

- API

- APIs

- การใช้งาน

- เหมาะสม

- สถาปัตยกรรม

- เป็น

- AS

- ที่เกี่ยวข้อง

- At

- อัตโนมัติ

- ใช้ได้

- AWS

- การก่อตัวของ AWS Cloud

- แบ็กเอนด์

- ตาม

- BE

- เพราะ

- พฤติกรรม

- ประโยชน์ที่ได้รับ

- ระหว่าง

- ทั้งสอง

- นำ

- กว้าง

- สร้าง

- การก่อสร้าง

- by

- CAN

- กรณี

- กรณี

- แค็ตตาล็อก

- ทางเลือก

- Choose

- เลือก

- Cluster

- เชิงพาณิชย์

- สภาสามัญ

- เปรียบเทียบ

- สมบูรณ์

- ความซับซ้อน

- องค์ประกอบ

- การกำหนดค่า

- การกำหนดค่า

- ยืนยัน

- งานที่เชื่อมต่อ

- การเชื่อมต่อ

- การเชื่อมต่อ

- ปลอบใจ

- บรรจุ

- ต่อ

- ต่อเนื่องกัน

- สัมพันธ์กัน

- สร้าง

- ที่สร้างขึ้น

- สร้าง

- ขณะนี้

- ประเพณี

- ลูกค้า

- แดชบอร์ด

- ข้อมูล

- ค่าเริ่มต้น

- กำหนด

- กำหนด

- การส่งมอบ

- ทดลอง

- สาธิต

- แสดงให้เห็นถึง

- ปรับใช้

- นำไปใช้

- ปรับใช้

- การใช้งาน

- Deploys

- ลักษณะ

- รายละเอียด

- รายละเอียด

- dev

- Dimension

- มิติ

- เอกสาร

- ไม่

- โดเมน

- ในระหว่าง

- แต่ละ

- ก่อน

- ง่ายดาย

- ทั้ง

- การฝัง

- ทำให้สามารถ

- ปลายทาง

- เครื่องยนต์

- เครื่องยนต์

- ทำให้มั่นใจ

- อีเธอร์ (ETH)

- ตัวอย่าง

- ประสบการณ์

- ความชำนาญ

- ภายนอก

- ใบหน้า

- อำนวยความสะดวก

- ลักษณะ

- สาขา

- หา

- ชื่อจริง

- มุ่งเน้น

- ดังต่อไปนี้

- สำหรับ

- กรอบ

- ราคาเริ่มต้นที่

- อย่างเต็มที่

- สร้าง

- สร้าง

- สร้าง

- ได้รับ

- GIF

- GitHub

- สีเขียว

- ขึ้น

- ให้คำแนะนำ

- มี

- ช่วย

- เธอ

- ประสิทธิภาพสูง

- เจ้าภาพ

- โฮสติ้ง

- เจ้าภาพ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- HTML

- ที่ http

- HTTPS

- กอดใบหน้า

- ความชุ่มชื้น

- AMI

- ID

- แยกแยะ

- เอกลักษณ์

- if

- ปรับปรุง

- in

- ดัชนี

- ดัชนี

- บ่งชี้ว่า

- ข้อมูล

- ปัจจัยการผลิต

- แทน

- คำแนะนำการใช้

- รวบรวม

- บูรณาการ

- การผสานรวม

- เข้าไป

- บทนำ

- IT

- ITS

- jpg

- JSON

- เก็บ

- คีย์

- ภาษา

- เปิดตัว

- เรียนรู้

- ได้เรียนรู้

- การเรียนรู้

- วงจรชีวิต

- รายการ

- รายการ

- ที่มีราคาต่ำ

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- การทำ

- จัดการ

- การจัดการ

- ผู้จัดการ

- หลาย

- แผนที่

- การทำแผนที่

- หน่วยความจำ

- วิธี

- นาที

- ML

- แบบ

- โมเดล

- การตรวจสอบ

- การตรวจสอบ

- ข้อมูลเพิ่มเติม

- มาก

- หลาย

- ต้อง

- ชื่อ

- พื้นเมือง

- นำทาง

- การเดินเรือ

- จำเป็น

- จำเป็นต้อง

- ประสาท

- ใหม่

- ตอนนี้

- วัตถุ

- of

- on

- ONE

- เพียง

- เปิด

- โอเพนซอร์ส

- or

- อื่นๆ

- เอาท์พุต

- หน้า

- บานหน้าต่าง

- หลงใหล

- รหัสผ่าน

- สิทธิ์

- ท่อ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เสียบเข้าไป

- โพสต์

- อำนาจ

- ขับเคลื่อน

- ก่อน

- หลัก

- ก่อน

- กระบวนการ

- โปรเซสเซอร์

- ผลิตภัณฑ์

- ผู้จัดการผลิตภัณฑ์

- การผลิต

- ความคืบหน้า

- คุณสมบัติ

- ให้

- ให้

- การให้

- วัตถุประสงค์

- คำสั่ง

- ดิบ

- ข้อมูลดิบ

- แนะนำ

- อ้างอิง

- รีโมท

- ลบ

- แทนที่

- จำเป็นต้องใช้

- แหล่งข้อมูล

- คำตอบ

- REST

- ผลสอบ

- ค้าปลีก

- เก็บไว้

- กลับ

- บทบาท

- เส้นทาง

- วิ่ง

- sagemaker

- ภาพหน้าจอ

- ค้นหา

- เครื่องมือค้นหา

- เครื่องมือค้นหา

- ความปลอดภัย

- เห็น

- เลือก

- ให้บริการ

- serverless

- บริการ

- บริการ

- ชุด

- การตั้งค่า

- เธอ

- แสดง

- แสดงให้เห็นว่า

- สัญญาณ

- ง่าย

- ช่วยลดความยุ่งยาก

- ลดความซับซ้อน

- ตั้งแต่

- โซลูชัน

- แหล่ง

- ผู้เชี่ยวชาญ

- เฉพาะ

- กอง

- ที่เริ่มต้น

- Status

- ขั้นตอน

- ขั้นตอน

- การเก็บรักษา

- ประสบความสำเร็จ

- อย่างเช่น

- ที่สนับสนุน

- แน่ใจ

- เทมเพลต

- ข้อความ

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- แล้วก็

- ดังนั้น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- ของบุคคลที่สาม

- นี้

- ตลอด

- ไปยัง

- ร่วมกัน

- เครื่องมือ

- การฝึกอบรม

- การแปลง

- การแปลภาษา

- จริง

- ชนิด

- ui

- เป็นเอกลักษณ์

- ที่ไม่ซ้ำกัน

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ประสบการณ์ของผู้ใช้

- การใช้

- ตรวจสอบความถูกต้อง

- ตรวจสอบ

- รุ่น

- ผ่านทาง

- วีดีโอ

- รายละเอียด

- เดิน

- คือ

- we

- เว็บ

- บริการเว็บ

- เมื่อ

- ที่

- จะ

- กับ

- ภายใน

- ทำงาน

- เวิร์กโฟลว์

- เวิร์กโฟลว์อัตโนมัติ

- เธอ

- ของคุณ

- ลมทะเล