จากศูนย์ข้อมูลไปจนถึงปลายทาง ความต้องการหน่วยความจำที่เพิ่มขึ้นกำลังเปลี่ยนโฉมสถาปัตยกรรมแบบดั้งเดิม

หน่วยความจำเป็นส่วนประกอบสำคัญในระบบคอมพิวเตอร์ทุกเครื่อง ตั้งแต่สมาร์ทโฟนในกระเป๋าเสื้อไปจนถึงศูนย์ข้อมูลขนาดยักษ์ที่ขับเคลื่อนแอปพลิเคชัน AI ชั้นนำของโลก เนื่องจาก AI ยังคงเพิ่มการเข้าถึงและความซับซ้อนอย่างต่อเนื่อง ความต้องการหน่วยความจำที่เพิ่มขึ้นจากศูนย์ข้อมูลไปยังอุปกรณ์ปลายทางจึงกำลังปรับเปลี่ยนความต้องการของอุตสาหกรรมและวิธีการดั้งเดิมในด้านสถาปัตยกรรมหน่วยความจำ

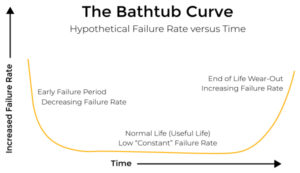

ตามที่ OpenAIปริมาณการประมวลผลที่ใช้ในการฝึกอบรม AI ที่ใหญ่ที่สุดได้เพิ่มขึ้นในอัตรา 10 เท่าต่อปีนับตั้งแต่ปี 2012 ตัวอย่างหนึ่งที่น่าสนใจซึ่งแสดงให้เห็นถึงความต้องการหน่วยความจำที่มากขึ้นนี้คือ ChatGPT ของ OpenAI ซึ่งเป็นโมเดลภาษาขนาดใหญ่ (LLM) ที่ได้รับการพูดถึงมากที่สุด ปีนี้. เมื่อเปิดตัวสู่สาธารณะครั้งแรกในเดือนพฤศจิกายน 2022 GPT-3 ถูกสร้างขึ้นโดยใช้พารามิเตอร์ 175 พันล้านพารามิเตอร์ GPT-4 ซึ่งเปิดตัวเพียงไม่กี่เดือนหลังจากนั้น มีรายงานว่าใช้พารามิเตอร์มากกว่า 1.5 ล้านล้านรายการ การเติบโตอย่างน่าตกใจในช่วงเวลาสั้นๆ และการเติบโตที่ต้องอาศัยการพัฒนาอย่างต่อเนื่องของเทคโนโลยีหน่วยความจำที่ใช้ในการประมวลผลข้อมูลจำนวนมหาศาลเหล่านี้

เนื่องจากแอปพลิเคชัน AI พัฒนาและมีความซับซ้อนมากขึ้น โมเดลขั้นสูงยิ่งขึ้น ชุดข้อมูลที่ใหญ่ขึ้นและความต้องการในการประมวลผลข้อมูลจำนวนมากจึงต้องการเวลาแฝงที่ต่ำกว่า หน่วยความจำแบนด์วิธที่สูงขึ้น รวมถึงพื้นที่จัดเก็บที่เพิ่มขึ้น และความสามารถในการประมวลผล CPU ที่ทรงพลังยิ่งขึ้น ตอนนี้เรามาดูเทคโนโลยีหน่วยความจำที่ทำให้ AI เกิดขึ้นกันดีกว่า

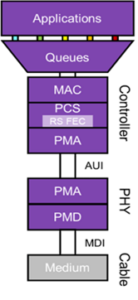

HBM3 และ GDDR6 เป็นเทคโนโลยีหน่วยความจำสองชนิดที่สำคัญสำหรับการสนับสนุนการพัฒนาการฝึกอบรมและการอนุมาน AI HBM3 ซึ่งใช้สถาปัตยกรรมหน่วยความจำ 2.5D/3D ประสิทธิภาพสูง ให้แบนด์วิธสูงและใช้พลังงานต่ำสำหรับการส่งข้อมูลระหว่างหน่วยความจำและหน่วยประมวลผล HBM3 ยังมีเวลาแฝงที่โดดเด่นและขนาดที่กะทัดรัด ทำให้เป็นตัวเลือกที่เหนือกว่าสำหรับฮาร์ดแวร์การฝึกอบรม AI ที่อยู่ใจกลางศูนย์ข้อมูล

GDDR6 เป็นเทคโนโลยีหน่วยความจำประสิทธิภาพสูงที่ให้แบนด์วิธสูง เวลาแฝงต่ำ และมีความซับซ้อนในการใช้งานน้อยกว่า HBM3 ประสิทธิภาพราคาที่ยอดเยี่ยมของหน่วยความจำ GDDR6 ซึ่งสร้างขึ้นจากกระบวนการผลิตที่ผ่านการทดสอบตามเวลา ทำให้เป็นตัวเลือกที่ยอดเยี่ยมสำหรับแอปพลิเคชันการอนุมาน AI โดยเฉพาะอย่างยิ่งในขณะที่เคลื่อนไปยัง Edge และไปยังจุดสิ้นสุดอัจฉริยะ

เทคโนโลยีที่สำคัญอีกประการหนึ่งที่ทำให้ AI ใช้งานได้คือหน่วยความจำหลักของ CPU ของเซิร์ฟเวอร์ CPU ใช้สำหรับการจัดการระบบ เช่นเดียวกับการเข้าถึงและการแปลงข้อมูลที่จะป้อนให้กับตัวเร่งความเร็วการฝึกอบรม ซึ่งมีบทบาทสำคัญในการรักษาไปป์ไลน์การฝึกอบรมที่มีความต้องการสูงให้เต็มอยู่เสมอ DDR5 ให้อัตราการส่งข้อมูลที่สูงกว่าและความจุที่มากกว่า DDR4 รุ่นก่อนหน้า รองรับการประมวลผลข้อมูลที่รวดเร็วและมีประสิทธิภาพยิ่งขึ้น DDR5 4800 MT/s DRAM ใช้ในเซิร์ฟเวอร์ CPU รุ่นล่าสุด และจะปรับขนาดเป็น 8000 MT/s และสูงกว่าเพื่อรองรับรุ่นต่อๆ ไปมากมาย

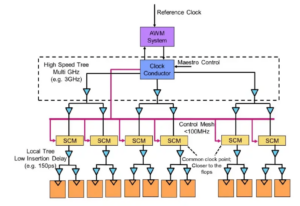

ที่เชื่อมโยงกับหน่วยความจำหลักของเซิร์ฟเวอร์คือ Compute Express Link (CXL) ซึ่งเป็นการเชื่อมต่อแคชมาตรฐานแบบเปิดที่เชื่อมโยงกันระหว่างโปรเซสเซอร์ ตัวเร่งความเร็ว และอุปกรณ์หน่วยความจำ คุณสมบัติที่โดดเด่น เช่น การรวมกลุ่มหน่วยความจำและการสลับ CXL จะช่วยให้สามารถปรับใช้ระดับหน่วยความจำใหม่ที่สามารถเชื่อมช่องว่างเวลาแฝงระหว่างหน่วยความจำหลักและพื้นที่จัดเก็บข้อมูล SSD ระดับหน่วยความจำใหม่เหล่านี้จะเพิ่มแบนด์วิธ ความจุ ประสิทธิภาพที่เพิ่มขึ้น และต้นทุนรวมในการเป็นเจ้าของ (TCO) ที่ลดลง ซึ่งเป็นองค์ประกอบที่สำคัญทั้งหมดสำหรับแอปพลิเคชัน AI

เหล่านี้คือเทคโนโลยีหน่วยความจำหลักบางส่วนที่อุตสาหกรรมจะต้องพึ่งพาเพื่อยกระดับประสิทธิภาพของแอปพลิเคชัน AI ไปสู่ระดับที่ดียิ่งขึ้นในอนาคต เมื่อเดือนที่แล้ว Dr. Steve Woo เพื่อนของ Rambus ได้เป็นเจ้าภาพจัดการอภิปรายในการประชุมสุดยอด AI Hardware & Edge AI ในหัวข้อ “ความท้าทายของหน่วยความจำสำหรับการประมวลผล AI/ML ยุคหน้า” หากคุณสนใจที่จะอ่านเพิ่มเติมเกี่ยวกับความท้าทายและโอกาสที่อุตสาหกรรมหน่วยความจำต้องเผชิญเมื่อพูดถึง AI โปรดดู สรุปบล็อกของการสนทนาที่ AI Hardware Summit.

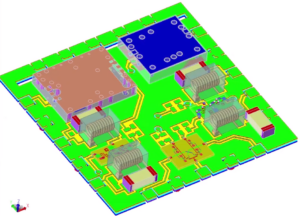

แรมบัส ชิปอินเทอร์เฟซหน่วยความจำ DDR5, ไอพีอินเทอร์เฟซหน่วยความจำและ ไอพีเชื่อมต่อระหว่างกัน ทั้งหมดนี้มอบความเร็วและความจุที่จำเป็นสำหรับปริมาณงาน AI ที่ต้องการทั้งในปัจจุบันและในอนาคต ด้วยความกว้าง พอร์ตโฟลิโอ IP ความปลอดภัย, Rambus ยังเปิดใช้งานการรักษาความปลอดภัยที่ล้ำสมัยสำหรับตัวเร่งความเร็ว AI ที่ใช้ฮาร์ดแวร์ ในขณะที่อุตสาหกรรมมีการพัฒนาอย่างต่อเนื่อง ความเชี่ยวชาญของ Rambus ในชิปอินเทอร์เฟซหน่วยความจำ และอินเทอร์เฟซและโซลูชัน IP ความปลอดภัย สามารถมีส่วนช่วยอย่างมากต่อการพัฒนาฮาร์ดแวร์ประสิทธิภาพสูงสำหรับเวิร์กโหลด AI ที่มีความต้องการสูง

ทิม เมสเซกี

(ทุกกระทู้)

Tim Messegee เป็นผู้อำนวยการอาวุโสฝ่ายการตลาดโซลูชันที่ Rambus

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://semiengineering.com/memory-technologies-key-to-advancing-ai-applications/

- :มี

- :เป็น

- 1

- 2012

- 2022

- 26

- 27

- 8

- 8000

- a

- เกี่ยวกับเรา

- ข้างบน

- เร่ง

- การเข้าถึง

- เพิ่ม

- สูง

- advancing

- หลังจาก

- AI

- การฝึกอบรม AI

- AI / ML

- ทั้งหมด

- โพสต์ทั้งหมด

- ด้วย

- จำนวน

- จำนวน

- an

- และ

- การใช้งาน

- วิธีการ

- สถาปัตยกรรม

- เป็น

- AS

- At

- แบนด์วิดธ์

- ตาม

- BE

- กลายเป็น

- ระหว่าง

- พันล้าน

- สะพาน

- กว้าง

- สร้าง

- CAN

- ความสามารถในการ

- ความจุ

- ศูนย์

- ศูนย์

- ความท้าทาย

- ChatGPT

- ตรวจสอบ

- ชิป

- ทางเลือก

- มา

- กะทัดรัด

- จับใจ

- ซับซ้อน

- ความซับซ้อน

- ส่วนประกอบ

- คำนวณ

- คอมพิวเตอร์

- การคำนวณ

- การบริโภค

- อย่างต่อเนื่อง

- อย่างต่อเนื่อง

- สนับสนุน

- ราคา

- ซีพียู

- วิกฤติ

- สำคัญมาก

- ตัดขอบ

- ข้อมูล

- ศูนย์ข้อมูล

- ศูนย์ข้อมูล

- การประมวลผล

- ชุดข้อมูล

- ความต้องการ

- เรียกร้อง

- การใช้งาน

- พัฒนาการ

- อุปกรณ์

- ผู้อำนวยการ

- การสนทนา

- dr

- ขอบ

- อย่างมีประสิทธิภาพ

- ที่มีประสิทธิภาพ

- องค์ประกอบ

- ทำให้สามารถ

- ช่วยให้

- การเปิดใช้งาน

- ปลายทาง

- อีเธอร์ (ETH)

- แม้

- ทุกๆ

- วิวัฒนาการ

- คาย

- ตัวอย่าง

- ยอดเยี่ยม

- ความชำนาญ

- ด่วน

- หันหน้าไปทาง

- เร็วขึ้น

- คุณสมบัติ

- เฟด

- มนุษย์

- สองสาม

- ที่เต็มไป

- ชื่อจริง

- รอยพระบาท

- สำหรับ

- ราคาเริ่มต้นที่

- อนาคต

- ช่องว่าง

- รุ่น

- ชั่วอายุคน

- ยักษ์

- ยิ่งใหญ่

- มากขึ้น

- อย่างมาก

- การเจริญเติบโต

- เกิดขึ้น

- ฮาร์ดแวร์

- หัวใจสำคัญ

- จุดสูง

- ประสิทธิภาพสูง

- สูงกว่า

- ของเขา

- เป็นเจ้าภาพ

- HTTPS

- if

- แสดง

- การดำเนินการ

- in

- เพิ่มขึ้น

- อุตสาหกรรม

- ของอุตสาหกรรม

- สำคัญ

- สนใจ

- อินเตอร์เฟซ

- เข้าไป

- IP

- IT

- เพียงแค่

- การเก็บรักษา

- คีย์

- ภาษา

- ใหญ่

- ที่มีขนาดใหญ่

- ใหญ่ที่สุด

- ชื่อสกุล

- ความแอบแฝง

- ล่าสุด

- น้อยลง

- ระดับ

- กดไลก์

- LINK

- ดู

- ต่ำ

- ลด

- หลัก

- ทำให้

- การทำ

- การจัดการ

- การผลิต

- หลาย

- การตลาด

- มาก

- หน่วยความจำ

- แบบ

- โมเดล

- เดือน

- เดือน

- ข้อมูลเพิ่มเติม

- มีประสิทธิภาพมากขึ้น

- มากที่สุด

- ย้าย

- จำเป็นต้อง

- ความต้องการ

- ใหม่

- รุ่นต่อไป

- พฤศจิกายน

- ตอนนี้

- of

- เสนอ

- on

- ONE

- เปิด

- โอกาส

- ของเรา

- ออก

- โดดเด่น

- ของตนเอง

- การเป็นเจ้าของ

- แผง

- พารามิเตอร์

- โดยเฉพาะ

- ต่อ

- การปฏิบัติ

- ระยะเวลา

- ท่อ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- กระเป๋า

- ความนิยม

- โพสต์

- อำนาจ

- ที่มีประสิทธิภาพ

- powering

- ก่อน

- กระบวนการ

- กระบวนการ

- การประมวลผล

- โปรเซสเซอร์

- แวว

- ให้

- ให้

- สาธารณะ

- คะแนน

- ราคา

- มาถึง

- การอ่าน

- ปะยางรถ

- การเผยแพร่

- วางใจ

- รายงาน

- ต้องการ

- จำเป็นต้องใช้

- ความต้องการ

- การก่อร่างใหม่

- ขึ้น

- บทบาท

- แถว

- ขนาด

- ความปลอดภัย

- ระดับอาวุโส

- ให้บริการ

- เซิร์ฟเวอร์

- การให้บริการ

- ชุดอุปกรณ์

- สั้น

- ตั้งแต่

- สมาร์ท

- มาร์ทโฟน

- โซลูชัน

- บาง

- ความเร็ว

- ส่าย

- มาตรฐาน

- สตีฟ

- การเก็บรักษา

- อย่างเช่น

- ประชุมสุดยอด

- เหนือกว่า

- ที่สนับสนุน

- ระบบ

- เอา

- เทคโนโลยี

- เทคโนโลยี

- กว่า

- ที่

- พื้นที่

- ก้าวสู่อนาคต

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- ในปีนี้

- เวลา

- ไปยัง

- หัวข้อ

- รวม

- แบบดั้งเดิม

- การฝึกอบรม

- การเปลี่ยนแปลง

- ล้านล้าน

- สอง

- หน่วย

- สูงกว่า

- ใช้

- มือสอง

- การใช้

- มาก

- คือ

- ดี

- เมื่อ

- จะ

- กับ

- แอ่ว

- ของโลก

- ปี

- ลมทะเล