Vsi želimo videti naše idealne človeške vrednote, ki se odražajo v naših tehnologijah. Pričakujemo, da nam tehnologije, kot je umetna inteligenca (AI), ne bodo lagale, ne bodo diskriminirale in bodo varne za uporabo za nas in naše otroke. Kljub temu se številni ustvarjalci umetne inteligence trenutno soočajo z nasprotovanjem zaradi pristranskosti, netočnosti in problematičnih podatkovnih praks, ki so izpostavljene v njihovih modelih. Ta vprašanja zahtevajo več kot le tehnično, algoritemsko rešitev ali rešitev, ki temelji na umetni inteligenci. V resnici je potreben celovit, družbeno-tehnični pristop.

Matematika razkriva močno resnico

Vsi napovedni modeli, vključno z AI, so natančnejši, če vključujejo raznoliko človeško inteligenco in izkušnje. To ni mnenje; ima empirično veljavo. Upoštevajte izrek o napovedi raznolikosti. Preprosto povedano, ko je raznolikost v skupini velika, je napaka množice majhna – kar podpira koncept »modrosti množice«. V vplivni študiji je bilo dokazano, da lahko različne skupine reševalcev težav z nizkimi sposobnostmi prekašajo skupine reševalcev težav z visokimi sposobnostmi (Hong & Page, 2004).

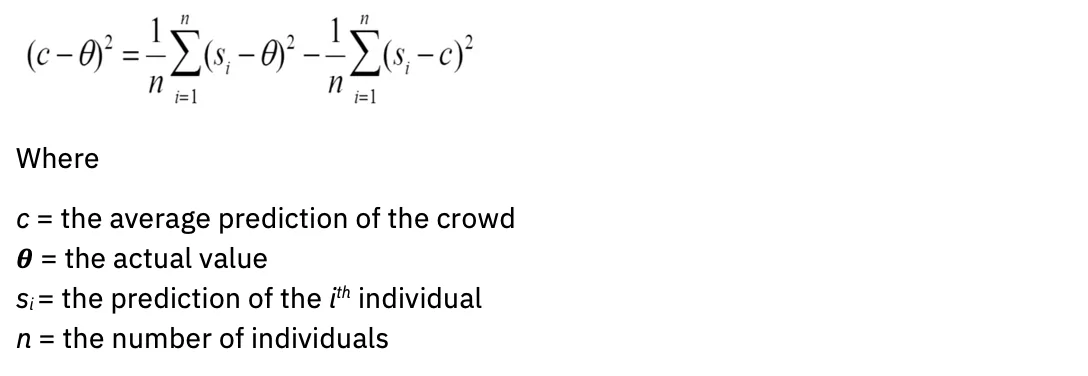

V matematičnem jeziku: širša kot je vaša varianca, bolj standardno je vaše povprečje. Enačba izgleda takole:

A nadaljni študij zagotovil več izračunov, ki izpopolnjujejo statistične definicije modre množice, vključno z nepoznavanjem napovedi drugih članov in vključitvijo tistih z maksimalno drugačna (negativno korelirane) napovedi ali presoje. Napovedi torej ne izboljšujejo le obseg, temveč tudi raznolikost. Kako lahko ta vpogled vpliva na oceno modelov AI?

(Ne)natančnost modela

Če citiram pogost aforizem, so vsi modeli napačni. To velja za področja statistike, znanosti in umetne inteligence. Modeli, ustvarjeni s pomanjkanjem strokovnega znanja o domeni, lahko vodijo do zmotno rezultatov.

Danes majhna homogena skupina ljudi določa, katere podatke uporabiti za usposabljanje generativnih modelov umetne inteligence, ki so črpani iz virov, ki v veliki meri predstavljajo angleščino. »Za večino od več kot 6,000 jezikov na svetu razpoložljivi besedilni podatki ne zadoščajo za usposabljanje obsežnega temeljnega modela« (iz »O priložnostih in tveganjih temeljnih modelov,« Bommasani et al., 2022).

Poleg tega so modeli sami ustvarjeni iz omejenih arhitektur: »Skoraj vsi najsodobnejši modeli NLP so zdaj prilagojeni iz enega od nekaj temeljnih modelov, kot so BERT, RoBERTa, BART, T5 itd. Medtem ko ta homogenizacija proizvaja izjemno visok finančni vzvod (kakršne koli izboljšave temeljnih modelov lahko vodijo do takojšnjih koristi v celotnem NLP), je tudi odgovornost; vsi sistemi AI lahko podedujejo iste problematične pristranskosti nekaj temeljnih modelov (Bommasani et al.) "

Da bi generativna umetna inteligenca bolje odražala raznolike skupnosti, ki jim služi, mora biti v modelih predstavljen veliko več različnih podatkov o ljudeh.

Ocenjevanje točnosti modela gre z roko v roki z ocenjevanjem pristranskosti. Vprašati se moramo, kakšen je namen modela in za koga je optimiziran? Razmislite na primer o tem, kdo ima največ koristi od algoritmov za priporočanje vsebine in algoritmov iskalnikov. Zainteresirane strani imajo lahko zelo različne interese in cilje. Algoritmi in modeli zahtevajo cilje ali posrednike za Bayesovo napako: najmanjšo napako, ki jo mora model izboljšati. Ta posrednik je pogosto oseba, na primer strokovnjak za določeno področje s strokovnim znanjem na tem področju.

Zelo človeški izziv: ocena tveganja pred nabavo ali razvojem modela

Nastajajoči predpisi in akcijski načrti o umetni inteligenci vse bolj poudarjajo pomen algoritemskih obrazcev za oceno učinka. Cilj teh obrazcev je zajeti ključne informacije o modelih umetne inteligence, tako da lahko skupine za upravljanje ocenijo in obravnavajo svoja tveganja, preden jih uvedejo. Tipična vprašanja vključujejo:

- Kakšen je primer uporabe vašega modela?

- Kakšna so tveganja za različne učinke?

- Kako ocenjujete pravičnost?

- Kako naredite svoj model razložljiv?

Čeprav je zasnovan z dobrimi nameni, je težava v tem, da večina lastnikov modelov AI ne razume, kako oceniti tveganja za svoj primer uporabe. Pogost refren bi lahko bil: "Kako je lahko moj model nepošten, če ne zbira osebno določljivih podatkov (PII)?" Zato so obrazci redko izpolnjeni s premišljenostjo, ki je potrebna za sisteme upravljanja za natančno označevanje dejavnikov tveganja.

Tako je poudarjena socialno-tehnična narava rešitve. Lastniku modela – posamezniku – ni mogoče preprosto dati seznama potrditvenih polj, da bi ocenil, ali bo njihov primer uporabe povzročil škodo. Namesto tega so potrebne skupine ljudi z zelo različnimi življenjskimi izkušnjami, ki se zberejo v skupnostih, ki nudijo psihološko varnost za težke pogovore o različnih učinkih.

Pozdravljanje širših perspektiv za zaupanja vredno umetno inteligenco

IBM® verjame v pristop »ničelne stranke«, implementacijo priporočil in sistemov, ki bi jih izdelal za lastne stranke v okviru svetovanja in rešitev, ki temeljijo na izdelkih. Ta pristop se razširi na etične prakse, zato je IBM ustvaril zaupanja vreden center odličnosti AI (COE).

Kot je razloženo zgoraj, je raznolikost izkušenj in spretnosti ključnega pomena za pravilno ovrednotenje učinkov umetne inteligence. Toda možnost sodelovanja v centru odličnosti bi lahko bila zastrašujoča v podjetju, polnem inovatorjev, strokovnjakov in uglednih inženirjev, zato je treba gojiti skupnost psihološke varnosti. IBM to jasno sporoča z besedami: »Vas zanima AI? Vas zanima etika umetne inteligence? Imate sedež za to mizo."

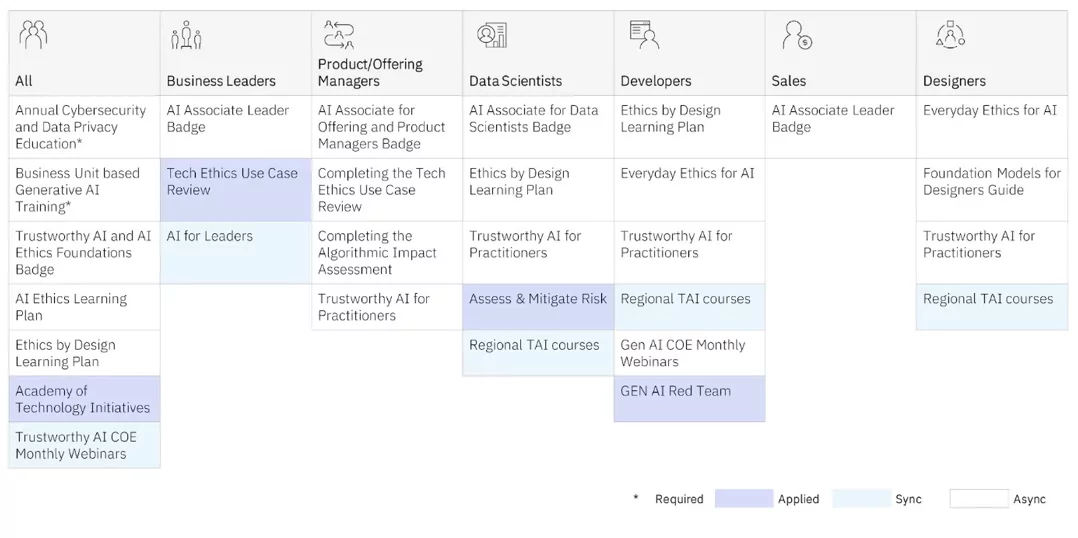

COE ponuja usposabljanje o etiki umetne inteligence za praktike na vseh ravneh. Na voljo so tako sinhrono učenje (učitelj in učenci v razredu) kot asinhroni (samovodeni) programi.

Ampak to je COE uporabna usposabljanje, ki daje našim izvajalcem najgloblji vpogled, saj delajo z globalnimi, raznolikimi, multidisciplinarnimi ekipami na resničnih projektih, da bi bolje razumeli različne učinke. Prav tako izkoriščajo okvire oblikovalskega razmišljanja IBM-a Oblikovanje za AI skupina uporablja interno in s strankami za ocenjevanje nenamernih učinkov modelov umetne inteligence, pri čemer ohranja tiste, ki so pogosto marginalizirani, na prvem mestu. (Glej Sylvia Duckworth Kolo moči in privilegijev za primere, kako se osebne lastnosti prepletajo, da privilegirajo ali marginalizirajo ljudi.) IBM je veliko ogrodij podaril tudi skupnosti odprtokodnih virov. Oblikujte etično.

Spodaj je nekaj poročil, ki jih je IBM javno objavil o teh projektih:

Samodejna orodja za upravljanje modela AI so potrebna za pridobivanje pomembnih vpogledov o tem, kako deluje vaš model AI. Vendar upoštevajte, da je optimalno zajeti tveganje veliko preden je bil vaš model razvit in v proizvodnji. Z ustvarjanjem skupnosti raznolikih multidisciplinarnih strokovnjakov, ki ljudem ponujajo varen prostor za težke pogovore o različnih vplivih, lahko začnete svojo pot k operacionalizaciji svojih načel in odgovornemu razvoju umetne inteligence.

V praksi, ko najemate izvajalce umetne inteligence, upoštevajte, da je več kot 70 % truda pri ustvarjanju modelov namenjeno kuriranju pravih podatkov. Želite najeti ljudi, ki vedo, kako zbrati podatke, ki so reprezentativni in se zbirajo tudi s soglasjem. Prav tako želite, da ljudje, ki vedo, tesno sodelujejo s strokovnjaki za področje, da se prepričate, ali imajo pravilen pristop. Ključnega pomena je zagotoviti, da imajo ti izvajalci čustveno inteligenco, da pristopijo k izzivu odgovornega kuriranja AI s ponižnostjo in razsodnostjo. Namerno se moramo naučiti, kako prepoznati, kako in kdaj lahko sistemi umetne inteligence povečajo neenakost prav toliko, kot lahko povečajo človeško inteligenco.

Ponovno odkrijte, kako vaše podjetje deluje z AI

Je bil ta članek v pomoč?

DaNe

Več od Umetna inteligenca

IBM-ove novice

Prejemajte naša glasila in posodobitve tem, ki prinašajo najnovejše miselno vodstvo in vpogled v nastajajoče trende.

Naročite zdaj

Več glasil

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- :ima

- : je

- :ne

- :kje

- $GOR

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- sposobnost

- O meni

- nad

- AC

- pospeši

- natančnost

- natančna

- natančno

- čez

- Ukrep

- prilagojeno

- Naslov

- priznati

- sprejme

- Oglaševanje

- nasveti

- vplivajo

- agenti

- AI

- AI modeli

- AI sistemi

- Cilj

- AL

- algoritmični

- algoritmi

- vsi

- Prav tako

- vedno

- amp

- an

- analitika

- in

- kaj

- uporaba

- aplikacije

- pristop

- SE

- območja

- članek

- umetni

- Umetna inteligenca

- Umetna inteligenca (AI)

- AS

- vprašati

- oceniti

- Ocenjevanje

- ocenjevanje

- pomočniki

- pomoč

- At

- audio

- povečanje

- Avtor

- Na voljo

- izogniti

- nazaj

- uravnoteženje

- BE

- bilo

- pred

- začetek

- počutje

- meni

- Prednosti

- Boljše

- Poleg

- pristranskosti

- pristranskosti

- Blog

- blogi

- Modra

- maribor

- tako

- širši

- Building

- poslovni

- poslovne funkcije

- podjetja

- vendar

- Gumb

- by

- CAN

- zajemanje

- Zajemanje

- ogljika

- kartice

- Kartice

- ki

- primeru

- CAT

- Kategorija

- Vzrok

- center

- Center odličnosti

- Osrednji

- nekatere

- izziv

- lastnosti

- klepetalnice

- preveriti

- otrok

- Otroci

- krogi

- CIS

- razred

- jasno

- stranke

- tesno

- Cloud

- barva

- kombinacija

- prihajajo

- Skupno

- skupnosti

- skupnost

- Podjetja

- podjetje

- Končana

- Koncept

- Soglasje

- Posledično

- Razmislite

- svetovanje

- Posoda

- naprej

- pogovorov

- Core

- popravi

- korelacija

- strošek

- bi

- ustvaril

- Ustvarjanje

- Ustvarjalci

- kritično

- Množica

- CSS

- kustos

- Trenutno

- po meri

- stranka

- Izkušnje s strankami

- Stranke, ki so

- datum

- Datum

- odločitve

- najgloblje

- privzeto

- definicije

- poda

- dokazuje,

- uvajanja

- opis

- Oblikovanje

- Oblikovanje razmišljanje

- zasnovan

- Ugotovite,

- Razvoj

- razvili

- drugačen

- težko

- digitalni

- Digitalni Transformation

- različno

- Razločen

- razne

- raznolikost

- do

- domena

- daroval

- sestavljene

- pogon

- E&T

- Učinki

- prizadevanje

- odstranjevanje

- vdelava

- objem

- smirkovim

- Zaposleni

- omogočajo

- angažiran

- Motor

- Inženirji

- Angleščina

- dovolj

- zagotoviti

- Vnesite

- Napaka

- itd

- Eter (ETH)

- etično

- etika

- oceniti

- ocenjevanje

- Ocena

- Tudi

- Tudi vsak

- Povsod

- poslabšati

- Primer

- Primeri

- Odličnost

- Izhod

- pričakovati

- izkušnje

- Doživetja

- strokovnjak

- strokovno znanje

- Strokovnjaki

- razložiti

- izpostavljena

- Se razširi

- izredno

- facebook messenger

- olajšati

- s katerimi se sooča

- dejavniki

- pravičnost

- false

- daleč

- FAST

- Nekaj

- Najdi

- Osredotočite

- sledi

- po

- pisave

- za

- ospredju

- Obrazci

- Fundacija

- okviri

- iz

- spredaj

- funkcije

- zbiranje

- zbranih

- zbiranje

- generativno

- Generativna AI

- generator

- dobili

- dana

- daje

- Globalno

- Cilj

- Cilji

- goes

- dobro

- upravljanje

- Grammar

- zelo

- Mreža

- skupina

- Skupine

- Rast

- vodi

- škodovalo

- Imajo

- Postavka

- slišati

- višina

- pomoč

- pomoč

- visoka

- ga

- najem

- Najem

- njegov

- drži

- celosten

- Domov

- Kako

- Kako

- HTTPS

- človeškega

- človeško inteligenco

- ponižnost

- Hybrid

- hibridni oblak

- i

- Bom

- IBM

- ICO

- ICON

- idealen

- identificirati

- if

- Nevednost

- slika

- Takojšen

- vpliv

- Vplivi

- izvajati

- izvajanja

- Pomembnost

- Pomembno

- izboljšanje

- Izboljšave

- izboljšuje

- in

- vključujejo

- Vključno

- vključitev

- vključi

- vedno

- inkrementalno

- Indeks

- Industrija

- Vplivno

- Podatki

- Inovacije

- inovatorji

- vhod

- vpogled

- vpogledi

- takoj

- Namesto

- Inštitut

- zavarovanje

- Zavarovalnice

- Intelligence

- Inteligentna

- namen

- namerna

- namere

- zainteresirani

- interesi

- interno

- Intersect

- intervencije

- zastrašujoče

- intrinzično

- isn

- vprašanje

- Vprašanja

- IT

- ITS

- januar

- pridružite

- Pridruži se nam

- Potovanje

- jpg

- samo

- vzdrževanje

- Ključne

- Vedite

- znano

- Pomanjkanje

- jezik

- jeziki

- velika

- obsežne

- Zadnji

- vodi

- Vodja

- Vodstvo

- učenje

- Naj

- Stopnja

- Vzvod

- odgovornosti

- laž

- kot

- Limited

- Seznam

- lokalna

- locale

- POGLEDI

- Znamka

- Izdelava

- upravljanje

- Navodilo

- več

- math

- matematični

- Matter

- max širine

- Maj ..

- me

- pomeni

- Srečati

- Messenger

- morda

- minut

- moti

- minimalna

- min

- Mobilni

- Model

- modeli

- modernizacija

- več

- Najbolj

- premikanje

- veliko

- multidisciplinarno

- morajo

- my

- Narava

- ostalo

- potrebno

- Nimate

- potrebna

- potrebe

- negativno

- Novo

- novi izdelki

- glasila

- nlp

- št

- Upoštevajte

- nič

- zdaj

- številne

- of

- off

- ponudba

- ponujen

- Ponudbe

- pogosto

- on

- ONE

- open source

- Mnenje

- Priložnosti

- optimalna

- optimizirana

- or

- organizacije

- Ostalo

- naši

- Izboljšati

- izhodi

- več

- lastne

- Lastniki

- Stran

- sodelujejo

- mimo

- ljudje

- izvajati

- oseba

- Osebni

- Osebno

- perspektive

- PHP

- pii

- načrti

- platon

- Platonova podatkovna inteligenca

- PlatoData

- vključiti

- politika

- Stališče

- Prispevek

- potencial

- potencialne stranke

- moč

- močan

- praksa

- vaje

- napoved

- Napovedi

- napovedno

- primarni

- Načela

- Prednost

- privilegij

- problem

- naročil

- proizvaja

- proizvodnja

- produktivnost

- Izdelki

- programi

- projekti

- pravilno

- možnosti

- če

- zagotavljanje

- pooblaščenci

- proxy

- psihološko

- javno

- objavljeno

- dal

- vprašanja

- hitro

- kvota

- redko

- Pripravljenost

- reading

- pravo

- Reality

- priznajo

- Priporočila

- zmanjšanje

- izboljšati

- odražajo

- odsevalo

- predpisi

- Poročila

- predstavnik

- zastopan

- zahteva

- zahteva

- obvezna

- Raziskave

- odziva

- odgovorna

- odgovorno

- odziven

- prihodki

- rast prihodkov

- Pravica

- Tveganje

- dejavniki tveganja

- tveganja

- cesta

- roboti

- varna

- Varnost

- Je dejal

- Enako

- rek

- Lestvica

- skaliranje

- Znanost

- Zaslon

- skripte

- Iskalnik

- iskalnik

- zavarovanje

- glej

- seo

- služi

- nastavitve

- shouldnt

- pokazale

- preprosto

- spletna stran

- Slack

- majhna

- pametna

- Pametni zvočniki

- SMS

- So

- Rešitev

- rešitve

- nekaj

- Viri

- Vesolje

- zvočniki

- Sponzorirane

- kvadratov

- interesne skupine

- standardna

- Začetek

- state-of-the-art

- Statistično

- Statistika

- Študenti

- študija

- predmet

- naročiti

- taka

- podpora

- Podpora

- SVG

- sistemi

- T

- miza

- ob

- Cilji

- Učitelj

- Skupine

- tehnični

- Tehnologije

- terciarno

- besedilo

- kot

- hvala

- da

- O

- svet

- njihove

- Njih

- tema

- sami

- te

- jih

- mislim

- Razmišljanje

- ta

- tisti,

- mislil

- miselno vodstvo

- 3

- skozi

- čas

- Naslov

- do

- skupaj

- orodja

- vrh

- temo

- težko

- Vlak

- usposabljanje

- Preoblikovanje

- Trends

- Res

- zaupanja

- dva

- tip

- tipičen

- razumeli

- nepošteno

- edinstven

- odklepanje

- posodobitve

- naprej

- URL

- us

- uporaba

- primeru uporabe

- uporablja

- Uporaben

- vrednost

- Vrednote

- raznolikost

- različno

- zelo

- Virtual

- Obseg

- W

- želeli

- je

- we

- Dobro

- Kaj

- Kaj je

- kdaj

- ali

- ki

- medtem

- WHO

- koga

- zakaj

- pogosto

- širše

- bo

- modrost

- MODER

- z

- beseda

- WordPress

- delo

- deluje

- svet

- bi

- pisni

- Napačen

- še

- jo

- Vaša rutina za

- zefirnet