Un aspect al înțelepciunii primite cu privire la AI a fost că toată inovația începe în marile motoare de învățare/formare automată din cloud. Unele dintre aceste inovații ar putea migra în cele din urmă într-o formă redusă/limitată la margine. Acest lucru a reflectat parțial noutatea domeniului. Poate că, de asemenea, parțial, a reflectat nevoia de soluții preambalate, care se potrivesc cu multe pentru widget-uri IoT. Acolo unde designerii doreau inteligență în produsele lor, dar nu erau tocmai pregătiți să devină experți în design ML. Dar acum acei designeri ajung din urmă. Ei citesc aceleași comunicate de presă și cercetări pe care le facem cu toții, la fel ca și concurenții lor. Ei doresc să profite de aceleași progrese, respectând constrângerile de putere și costuri.

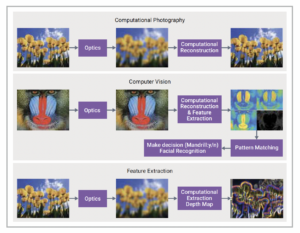

Recunoastere faciala

Diferențierea AI la margine

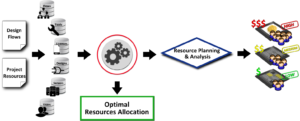

Totul este despre diferențierea într-un pachet acceptabil cost/putere. Este greu de obținut din soluții preambalate. La urma urmei, concurenții au acces la aceleași soluții. Ceea ce îți dorești cu adevărat este un set de opțiuni de algoritm modelate în procesor ca acceleratoare dedicate gata de a fi utilizate, cu capacitatea de a-ți stratifica propria valoare adăugată bazată pe software. S-ar putea să credeți că nu pot fi multe de făcut aici, în afara unor admin și tuning. Vremurile s-au schimbat. CEVA a introdus recent procesorul AI încorporat NeuPro-M, care permite optimizarea utilizând unele dintre cele mai recente progrese ML, adânc în proiectarea algoritmului.

OK, deci mai mult control asupra algoritmului, dar cu ce scop? Doriți să optimizați performanța pe watt, dar metrica standard – TOPS/W – este prea grosieră. Aplicațiile de imagistică trebuie măsurate în raport cu cadre pe secundă (fps) pe watt. Pentru aplicațiile de securitate, pentru siguranța auto sau pentru evitarea coliziunilor cu drone, timpii de recunoaștere per cadru sunt mult mai relevanți decât operațiunile brute pe secundă. Deci, o platformă precum NeuPro-M, care poate furniza până la mii de fps/W, în principiu, va gestiona rate realiste de fps de 30-60 de cadre pe secundă la o putere foarte mică. Acesta este un avans real față de soluțiile tradiționale de IA pre-ambalate.

Făcând posibil

Algoritmii definitivi sunt construiți prin apelarea caracteristicilor despre care ați citit, începând cu o gamă largă de opțiuni de cuantizare. Același lucru se aplică diversității tipurilor de date în activare și ponderi într-o gamă de dimensiuni de biți. Unitatea de multiplicare neuronală (NMU) acceptă în mod optim mai multe opțiuni de lățime de biți pentru activare și greutăți, cum ar fi 8×2 sau 16×4 și va accepta, de asemenea, variante precum 8×10.

Procesorul acceptă Winograd Transforms sau convoluții eficiente, oferind un câștig de performanță de până la 2X și o putere redusă cu o degradare limitată a preciziei. Adăugați motorul sparsity la model pentru o accelerație de până la 4X, în funcție de cantitatea de valori zero (fie în date, fie în greutăți). Aici, unitatea de multiplicare neuronală acceptă, de asemenea, o gamă de tipuri de date, fixate de la 2×2 la 16×16 și virgulă mobilă (și Bfloat) de la 16×16 la 32×32.

Logica de streaming oferă opțiuni pentru scalarea punctului fix, activare și grupare. Procesorul vectorial vă permite să adăugați propriile straturi personalizate la model. „Deci, toată lumea susține asta”, ați putea crede, dar vedeți mai jos despre debit. Există, de asemenea, un set de caracteristici AI de generația următoare, inclusiv transformatoare de viziune, convoluție 3D, suport RNN și descompunere a matricei.

O mulțime de opțiuni de algoritm, toate susținute de o optimizare a rețelei pentru soluția dvs. încorporată prin cadrul CDNN pentru a exploata pe deplin puterea algoritmilor dvs. ML. CDNN este o combinație între un compilator de grafice de inferență în rețea și un instrument de completare dedicat PyTorch. Acest instrument va tăia modelul, acceptă opțional compresia modelului prin descompunerea matricei și adaugă re-antrenamentul conștient de cuantizare.

Optimizarea debitului

În majoritatea sistemelor AI, unele dintre aceste funcții pot fi gestionate în motoare specializate, necesitând descărcarea datelor și reîncărcarea transformării când este finalizată. Aceasta înseamnă multă latență adăugată (și poate compromisuri de putere), subminând complet performanța în modelul tău, altfel puternic. NeuPro-M elimină această problemă prin conectare toate aceste acceleratoare direct la un cache L1 partajat. Susține o lățime de bandă mult mai mare decât veți găsi în acceleratoarele convenționale.

Ca exemplu izbitor, unitatea de procesare vectorială, utilizată de obicei pentru a defini straturi personalizate, se află la același nivel cu celelalte acceleratoare. Algoritmii dvs. implementați în VPU beneficiază de aceeași accelerație ca și restul modelului. Din nou, nu este nevoie de descărcare și reîncărcare pentru a accelera straturile personalizate. În plus, puteți avea până la 8 dintre aceste motoare NPM (toate acceleratoarele, plus memoria cache NPM L1). NeuPro-M oferă, de asemenea, un nivel semnificativ de optimizare a lățimii de bandă controlată de software între cache-ul L2 și cache-ul L1, optimizând gestionarea cadrelor și minimizând nevoia de acces DDR.

Desigur, NeuPro-M va minimiza și traficul de date și greutate. Pentru date, acceleratoarele partajează același cache L1. Un procesor gazdă poate comunica datele direct cu NeuPro-M L2, reducând din nou nevoia de transferuri DDR. NeuPro-M comprimă și decomprimă greutățile de pe cip în transfer cu memoria DDR. Se poate face același lucru cu activările.

Dovada în accelerație fps/W

CEVA a rulat benchmark-uri standard folosind o combinație de algoritmi modelați în acceleratoare, de la nativ prin Winograd, la Winograd+Sparsity, la Winograd+Sparsity+4×4. Ambele benchmark-uri au arătat îmbunătățiri de performanță de până la 3X, cu putere (fps/W) de aproximativ 5X pentru un ISP NN. Soluția NeuPro-M a furnizat o suprafață mai mică, o performanță de 4X, 1/3 din putere, în comparație cu generația lor anterioară NeuPro-S.

Există o tendință pe care o văd în general, de a obține cea mai bună performanță prin combinarea mai multor algoritmi. Ceea ce CEVA a făcut posibil acum cu această platformă. Puteți citi mai multe AICI.

Distribuie această postare prin: Sursa: https://semiwiki.com/artificial-intelligence/306655-ai-at-the-edge-no-longer-means-dumbed-down-ai/

- 3d

- Despre Noi

- acceleratoare

- acces

- peste

- Add-on

- plus

- admin

- Avantaj

- AI

- Sisteme AI

- Algoritmul

- algoritmi

- TOATE

- aplicatii

- ZONĂ

- în jurul

- auto

- cache

- CEVA

- Cloud

- combinaţie

- concurenți

- de date

- Amenajări

- Diversitate

- zbârnâi

- Margine

- exemplu

- experți

- Exploata

- Față

- recunoașterea feței

- DESCRIERE

- formă

- Cadru

- funcții

- Manipularea

- aici

- HTTPS

- Imaging

- implementat

- Inclusiv

- Inovaţie

- introdus

- IoT

- ISP

- IT

- Ultimele

- Nivel

- Limitat

- Matrice

- ML

- Algoritmi ML

- model

- mai mult

- necesar

- reţea

- neural

- promoții

- Operațiuni

- Opţiuni

- Altele

- in caz contrar

- performanță

- poate

- platformă

- putere

- Precizie

- presa

- Comunicate de presă

- Produse

- dovadă

- furnizează

- pirtorh

- gamă

- tarife

- Crud

- realist

- Lansări

- cercetare

- REST

- Siguranţă

- scalare

- securitate

- set

- Distribuie

- comun

- So

- soluţii

- de specialitate

- a sustine

- Suportat

- Sprijină

- sisteme

- Prin

- instrument

- tradiţional

- trafic

- Transforma

- viziune

- Ce

- în