A primeira startup de segurança cibernética de Josh Lospinoso foi adquirida em 2017 pela Raytheon/Forcepoint. Seu segundo, Shift5, trabalha com os militares dos EUA, operadores ferroviários e companhias aéreas, incluindo a JetBlue. Formado em West Point em 2009 e bolsista da Rhodes, o ex-capitão do Exército de 36 anos passou mais de uma década ferramentas de hacking de autoria para a Agência de Segurança Nacional e o Comando Cibernético dos EUA.

Lospinoso disse recentemente a um subcomitê de Serviços Armados do Senado como a inteligência artificial pode ajudar a proteger as operações militares. O CEO/programador discutiu o assunto com a Associated Press e também como as vulnerabilidades de software em sistemas de armas são uma grande ameaça para as forças armadas dos EUA. A entrevista foi editada para maior clareza e duração.

P: Em seu depoimento, você descreveu duas ameaças principais às tecnologias habilitadas para IA: uma é o roubo. Isso é auto-explicativo. O outro é o envenenamento de dados. Você pode explicar isso?

R: Uma maneira de pensar sobre envenenamento de dados é como desinformação digital. Se os adversários forem capazes de criar os dados que as tecnologias habilitadas para IA veem, eles podem impactar profundamente como essa tecnologia opera.

P: O envenenamento de dados está acontecendo?

R: Não estamos vendo isso de forma ampla. Mas ocorreu. Um dos casos mais conhecidos aconteceu em 2016. A Microsoft lançou um chatbot do Twitter chamado Tay que aprendeu com as conversas que teve online. Usuários mal-intencionados conspiraram para tuitar linguagem ofensiva e abusiva. Tay começou a gerar conteúdo inflamatório. A Microsoft colocou offline.

P: AI não é apenas chatbots. Há muito tempo é parte integrante da segurança cibernética, certo?

R: A IA é usada em filtros de e-mail para tentar sinalizar e separar lixo eletrônico e iscas de phishing. Outro exemplo são os endpoints, como o programa antivírus em seu laptop – ou software de detecção de malware executado em redes. Claro, hackers ofensivos também usam IA para tentar derrotar esses sistemas de classificação. Isso é chamado de IA adversária.

P: Vamos falar sobre sistemas de software militar. Um 2018 alarmante Relatório do Government Accountability Office disse que quase todos os sistemas de armas recém-desenvolvidos tinham vulnerabilidades de missão crítica. E o Pentágono está pensando em colocar IA nesses sistemas?

R: Há dois problemas aqui. Primeiro, precisamos proteger adequadamente os sistemas de armas existentes. Essa é uma dívida técnica que a gente tem que vai demorar muito para pagar. Depois, há uma nova fronteira de segurança de algoritmos de IA – coisas novas que instalaríamos. O relatório do GAO realmente não falava sobre IA. Então esqueça a IA por um segundo. Se esses sistemas permanecerem do jeito que estão, eles ainda são profundamente vulneráveis.

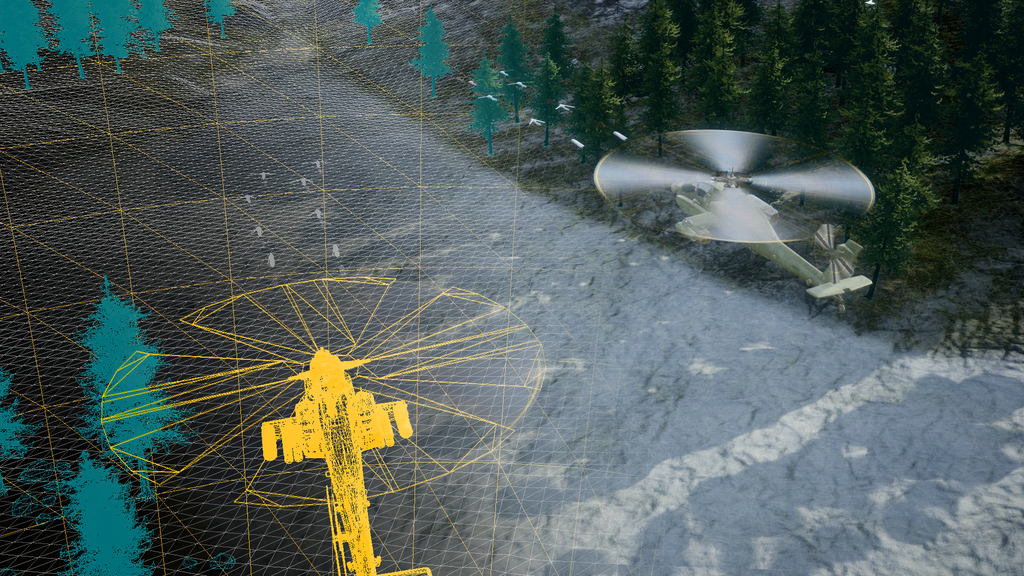

Estamos discutindo a possibilidade de inovar e adicionar recursos habilitados para IA para itens como manutenção aprimorada e inteligência operacional. Tudo ótimo. Mas estamos construindo em cima de um castelo de cartas. Muitos sistemas têm décadas de idade, adaptados com tecnologias digitais. Aeronaves, veículos terrestres, ativos espaciais, submarinos. Eles agora estão interligados. Estamos trocando dados dentro e fora. Os sistemas são porosos, difíceis de atualizar e podem ser atacados. Assim que um invasor obtém acesso, o jogo termina.

Às vezes é mais fácil construir uma nova plataforma do que redesenhar os componentes digitais dos sistemas existentes. Mas há um papel para a IA na proteção desses sistemas. A IA pode ser usada para defender se alguém tentar comprometê-los.

P: Você testemunhou que interromper a pesquisa de IA, como alguns insistem, seria uma má ideia porque favoreceria a China e outros concorrentes. Mas você também tem preocupações com a corrida desenfreada para produtos de IA. Por que?

R: Odeio parecer fatalista, mas o chamado caso de “uso em chamas” parece se aplicar. Um produto lançado às pressas no mercado geralmente pega fogo (é hackeado, falha, causa danos não intencionais). E dizemos: 'Rapaz, devíamos ter construído em segurança.' Espero que o ritmo de desenvolvimento da IA acelere e talvez não paremos o suficiente para fazer isso de maneira segura e responsável. Pelo menos a Casa Branca e o Congresso estão discutindo essas questões.

P: Parece que várias empresas – inclusive no setor de defesa – estão correndo para anunciar produtos de IA incompletos.

R: Todas as empresas de tecnologia e muitas empresas não-tecnológicas fizeram um pivô quase chocante em direção à IA. Deslocamentos econômicos estão chegando. Os modelos de negócios vão mudar fundamentalmente. Deslocamentos já estão acontecendo ou estão no horizonte – e os líderes empresariais estão tentando não ser pegos de surpresa.

P: E quanto ao uso de IA na tomada de decisões militares, como a seleção de alvos?

R: Eu não acho, categoricamente, que os algoritmos de inteligência artificial - os dados que estamos coletando - estão prontos para o horário nobre para um sistema de armas letais tomar decisões. Estamos tão longe disso.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoAiStream. Inteligência de Dados Web3. Conhecimento Amplificado. Acesse aqui.

- Cunhando o Futuro com Adryenn Ashley. Acesse aqui.

- Compre e venda ações em empresas PRE-IPO com PREIPO®. Acesse aqui.

- Fonte: https://www.defensenews.com/artificial-intelligence/2023/05/29/adversarial-ai-a-threat-to-military-systems-shift5s-lospinoso-says/

- :tem

- :é

- :não

- 2016

- 2017

- 2018

- 70

- a

- Capaz

- Sobre

- acelerar

- Acesso

- responsabilidade

- adquirido

- acrescentando

- adequadamente

- adversarial

- agência

- AI

- ai pesquisa

- aeronave

- Companhias Aéreas

- algoritmos

- Todos os Produtos

- já

- tb

- an

- e

- Anunciar

- Outro

- antivirus

- Aplicar

- SOMOS

- armado

- Exército

- artificial

- inteligência artificial

- AS

- Ativos

- associado

- At

- Mau

- BE

- Porque

- sido

- começou

- amplamente

- construir

- Prédio

- construído

- Monte

- negócio

- mas a

- by

- chamado

- CAN

- capacidades

- Cartões

- casas

- casos

- apanhados

- alterar

- chatbot

- chatbots

- China

- clareza

- classificação

- Coleta

- vinda

- Empresas

- Empresa

- concorrentes

- componentes

- compromisso

- Preocupações

- Congresso

- conteúdo

- conversas

- poderia

- curso

- artesanato

- crítico

- cibernético

- Cíber segurança

- dados,

- Dívida

- década

- décadas

- Tomada de Decisão

- decisões

- Defesa

- descrito

- Detecção

- desenvolvido

- Desenvolvimento

- digital

- discutido

- discutir

- desinformação

- do

- parece

- mais fácil

- Econômico

- suficiente

- Cada

- exemplo

- existente

- esperar

- Explicação

- falha

- longe

- favorecer

- filtros

- Fogo

- Primeiro nome

- Escolha

- Antigo

- da

- Frontier

- fundamentalmente

- Ganhos

- jogo

- GAO

- gerar

- ter

- vai

- ótimo

- Solo

- hackeado

- hackers

- hacker

- tinha

- aconteceu

- Acontecimento

- Queijos duros

- Ter

- precipitadamente

- ajudar

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- sua

- horizonte

- House

- Como funciona o dobrador de carta de canal

- HTTPS

- i

- idéia

- if

- imagens

- Impacto

- melhorado

- in

- Incluindo

- instalar

- integral

- Inteligência

- interconectado

- Interview

- para dentro

- questões

- IT

- jetblue

- apenas por

- língua

- laptop

- líderes

- aprendido

- mínimo

- Comprimento

- como

- longo

- muito tempo

- moldadas

- manutenção

- principal

- Fazendo

- malwares

- detecção de malware

- muitos

- mercado

- Microsoft

- poder

- Militar

- Missão

- modelos

- mais

- Nomeado

- Nacional

- segurança nacional

- Agência de Segurança Nacional

- quase

- você merece...

- redes

- Novo

- Nova Plataforma

- romance

- agora

- ocorreu

- of

- ofensivo

- Office

- modo offline

- frequentemente

- Velho

- on

- uma vez

- ONE

- online

- opera

- operacional

- Operações

- operadores

- or

- Outros

- Fora

- Acima de

- Paz

- pausa

- Pagar

- pentágono

- Phishing

- articulação

- plataforma

- platão

- Inteligência de Dados Platão

- PlatãoData

- ponto

- imprensa

- Prime

- Diretor

- Produto

- Produtos

- Agenda

- proteger

- Empurrando

- Colocar

- Barra

- pronto

- clientes

- recentemente

- redesenhar

- liberado

- Denunciar

- pesquisa

- responsável

- certo

- Tipo

- apressar

- s

- Dito

- dizer

- diz

- Segundo

- setor

- seguro

- assegurando

- segurança

- Vejo

- visto

- parece

- Senado

- Serviços

- rede de apoio social

- So

- até aqui

- Software

- alguns

- Alguém

- Parecer

- Espaço

- gasto

- inicialização

- fiquei

- Ainda

- subcomissão

- sujeito

- tal

- troca

- .

- sistemas

- Tire

- Converse

- alvejando

- tecnologia

- Empresa de Tecnologia

- Dados Técnicos:

- Tecnologias

- Equipar

- testemunhou

- testemunho

- do que

- que

- A

- roubo

- Eles

- então

- Lá.

- Este

- deles

- coisas

- think

- Pensando

- isto

- aqueles

- ameaça

- ameaças

- tempo

- para

- levou

- topo

- para

- tentar

- Tweet

- dois

- nos

- atualização

- usar

- usava

- usuários

- Veículos

- muito

- vulnerabilidades

- Vulnerável

- foi

- Caminho..

- we

- armas

- BEM

- Ocidente

- O Quê

- branco

- a Casa Branca

- porque

- com

- trabalho

- seria

- Você

- investimentos

- zefirnet