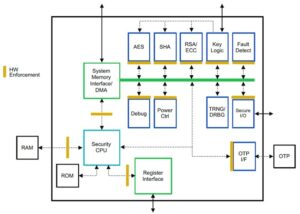

Suresh é um executivo de tecnologia com profundo conhecimento técnico em semicondutores, inteligência artificial, segurança cibernética, internet das coisas, hardware, software, etc. Ele passou 20 anos na indústria, mais recentemente atuando como Diretor Executivo de código aberto zero- desenvolvimento de chips confiáveis no Technology Innovation Institute, Abu Dhabi, e em outras empresas de semicondutores da Fortune 500, como Intel, Qualcomm e MediaTek em vários cargos de liderança, onde pesquisou e desenvolveu alto desempenho, eficiência energética, pós-quântico seguro, seguro microchips/system-on-chips (SoCs)/aceleradores para os mercados de datacenter, cliente, smartphone, rede, IoT e IA/ML. Ele contribuiu para o Falcon LLM (classificado em primeiro lugar em huggingface) e foi o arquiteto principal da plataforma de hardware de IA personalizada (cancelada – prioridades alteradas). Ele possui mais de 1 patentes nos EUA e publicou/apresentou em mais de 15 conferências.

Suresh é um executivo de tecnologia com profundo conhecimento técnico em semicondutores, inteligência artificial, segurança cibernética, internet das coisas, hardware, software, etc. Ele passou 20 anos na indústria, mais recentemente atuando como Diretor Executivo de código aberto zero- desenvolvimento de chips confiáveis no Technology Innovation Institute, Abu Dhabi, e em outras empresas de semicondutores da Fortune 500, como Intel, Qualcomm e MediaTek em vários cargos de liderança, onde pesquisou e desenvolveu alto desempenho, eficiência energética, pós-quântico seguro, seguro microchips/system-on-chips (SoCs)/aceleradores para os mercados de datacenter, cliente, smartphone, rede, IoT e IA/ML. Ele contribuiu para o Falcon LLM (classificado em primeiro lugar em huggingface) e foi o arquiteto principal da plataforma de hardware de IA personalizada (cancelada – prioridades alteradas). Ele possui mais de 1 patentes nos EUA e publicou/apresentou em mais de 15 conferências.

Suresh também atua ativamente em uma posição de liderança na RISC-V International, onde preside o Trusted Computing Group para desenvolver capacidade de computação confidencial RISC-V e preside o Grupo AI/ML para desenvolver aceleração de hardware RISC-V para cargas de trabalho de AI/ML, como Modelos de linguagem grande do Transformer usados em aplicativos do tipo ChatGPT. Ele também assessora startups e empresas de capital de risco no apoio à decisão de investimentos, estratégia de produtos, due diligence tecnológica, etc.

Ele obteve um MBA pelo INSEAD, um mestrado pelo Birla Institute of Technology & Science Pilani, um certificado de Engenharia de Sistemas do MIT, um certificado de IA de Stanford e um certificado de segurança funcional automotiva da TÜV SÜD.

Conte-nos sobre sua empresa

"Mastiṣka AI”(Mastiṣka significa Cérebro em sânscrito) é uma empresa de IA focada na construção de computadores semelhantes a cérebros para executar modelos básicos com mais eficiência para os casos de uso de IA generativa de amanhã.

Que problemas você está resolvendo?

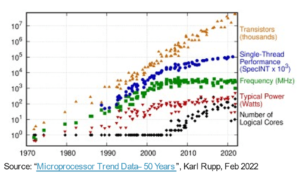

Dados os benefícios da IA/GenAI, a sua procura só irá aumentar, assim como os seus efeitos secundários no nosso planeta. Como podemos reduzir ou neutralizar os efeitos colaterais da IA no nosso planeta? A captura de carbono e a energia nuclear estão na direção certa. Mas precisamos repensar fundamentalmente a forma como fazemos IA. Será a maneira errada de fazer toneladas de multiplicações de matrizes?

Nosso cérebro pode aprender e realizar muitas tarefas em paralelo, em até 10 W, mas por que esses sistemas de IA consomem dezenas de megawatts para treinar modelos?

Talvez o futuro reserve arquiteturas energeticamente eficientes, como arquiteturas neuromórficas e transformadores baseados em redes neurais que estão mais próximos do cérebro humano, que podem consumir 100-1000 vezes menos energia, reduzindo assim o custo do uso de IA, democratizando-a e salvando nossos planeta.

Os desafios atuais que enfrentamos com a IA, nomeadamente a) disponibilidade, b) acessibilidade, c) acessibilidade e d) segurança ambiental, juntamente com algumas recomendações para enfrentá-los.

Se prevermos o futuro, alguns conceitos úteis de AGI são demonstrados no filme “HER”, onde a personagem ‘Samantha’ – uma agente conversadora que é natural, entende emoções, mostra empatia, é uma copilota incrível no trabalho – e segue em frente dispositivos portáteis o dia inteiro, talvez tenhamos que enfrentar os desafios abaixo agora mesmo.

Questão 1: Treinar um LLM pode custar de 150 mil a mais de 10 milhões de dólares e permite que apenas aqueles com recursos mais profundos desenvolvam IA. Além disso, os custos de inferência também são enormes (custa 10 vezes mais do que uma pesquisa na web)

—> Precisamos melhorar a eficiência energética dos modelos/hardware para democratizar a IA para o benefício da humanidade.

Questão 2: A execução de enormes modelos de IA para agentes de conversação ou sistemas de recomendação prejudica o meio ambiente em termos de consumo de eletricidade e refrigeração.

-> Precisamos melhorar a eficiência energética dos modelos/hardware para salvar o planeta para os nossos filhos.

Questão 3: O cérebro humano é capaz e pode realizar multitarefas, mas consome apenas 10 Watts em vez de Megawatts.

-> Talvez devêssemos construir máquinas como nossos cérebros e não os multiplicadores de matrizes regulares mais rápido.

A humanidade só pode prosperar com inovações sustentáveis, e não derrubando todas as florestas e fervendo os oceanos em nome da inovação. Devemos proteger o nosso planeta para o bem-estar dos nossos filhos e das gerações futuras…

Quais áreas de aplicação são suas mais fortes?

Treinamento e inferência de modelos básicos baseados em transformadores (e futuras arquiteturas neurais), com 50 a 100 vezes mais eficiência energética em comparação com as soluções atuais baseadas em GPU.

O que mantém seus clientes acordados à noite?

Problemas para clientes que atualmente usam outros produtos:

O consumo de eletricidade para treinar modelos de linguagem gigantescos está além do teto, por exemplo, treinar um LLM de parâmetro 13B em tokens de texto de 390B em 200 GPUs por 7 dias custa US$ 151,744 (Fonte: página de serviço do novo cluster de treinamento HuggingFace – https://lnkd.in/g6Vc5cz3). E modelos ainda maiores com parâmetros 100+B custam US$ 10+ milhões apenas para treinar. Em seguida, pague pela inferência sempre que uma nova solicitação imediata chegar.

Consumo de água para resfriamento, pesquisadores da Universidade da Califórnia, em Riverside, estimaram o impacto ambiental de um serviço semelhante ao ChatGPT e dizem que ele engole 500 mililitros de água (perto do que há em uma garrafa de água de 16 onças) cada vez que você pergunta. série de 5 a 50 solicitações ou perguntas. O intervalo varia dependendo de onde seus servidores estão localizados e da temporada. A estimativa inclui o uso indireto de água que as empresas não medem – como para resfriar usinas de energia que abastecem os data centers com eletricidade. (Fonte: https://lnkd.in/gybcxX8C)

Problemas para não clientes de produtos atuais:

Não posso pagar CAPEX para comprar hardware

Não posso me dar ao luxo de usar serviços em nuvem

Não é possível inovar ou aproveitar a IA – preso a um modelo de serviços que elimina qualquer vantagem competitiva

Como é o cenário competitivo e como você se diferencia?

- As GPUs dominam o espaço de treinamento, embora ASICs especializados também concorram neste segmento

- A inferência Cloud & Edge tem muitas opções disponíveis

Digital, analógico, fotônico - você escolhe, as pessoas estão tentando resolver o mesmo problema.

Você pode compartilhar sua opinião sobre o estado atual da arquitetura de chips para IA/ML, ou seja, o que você vê como as tendências e oportunidades mais significativas no momento?

Seguindo tendências:

Tendência 1: Há 10 anos, a aprendizagem profunda habilitada por hardware floresceu e agora o mesmo hardware está inibindo o progresso. Devido ao enorme custo de hardware e eletricidade para operar os modelos, o acesso ao hardware tornou-se um desafio. Apenas as empresas com grandes recursos conseguem arcar com estes custos e estão a tornar-se monopólios.

Tendência 2: Agora que esses modelos estão aí, precisamos usá-los para fins práticos para que a carga de inferência aumente, permitindo que CPUs com aceleradores de IA voltem ao centro das atenções.

Tendência 3: As startups estão tentando criar representações alternativas de números de ponto flutuante que o formato tradicional do IEEE – como logarítmico e baseado em posit – são bons, mas não suficientes. A otimização do espaço de design do PPA$ explode quando tentamos otimizar um e outro vai para o lixo.

Tendência 4: A indústria está se afastando do modelo de IA baseado em serviços para hospedar seus próprios modelos privados em suas próprias instalações – mas o acesso ao hardware é um desafio devido à escassez de fornecimento, sanções, etc.

Situação atual:

A disponibilidade de hardware e dados impulsionou o crescimento da IA há 10 anos, agora o mesmo hardware está inibindo isso - deixe-me explicar

Desde que as CPUs estavam péssimas e as GPUs foram reaproveitadas para fazer IA, muitas coisas aconteceram

As empresas têm abordado 4 segmentos de IA/ML, nomeadamente – 1) treinamento em nuvem, 2) inferência em nuvem, 3) inferência na borda e 4) treinamento na borda (aprendizagem federada para aplicações sensíveis à privacidade).

Digital e Analógico

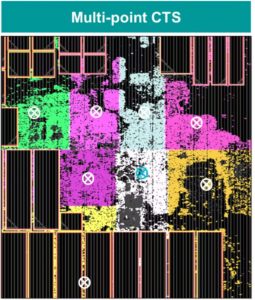

Lado do treinamento – uma infinidade de empresas que fabricam GPUs, aceleradores de clientes baseados em RISC-V, chips em escala de wafer (850 mil núcleos) e assim por diante, onde faltam CPUs tradicionais (seu propósito geral). Lado de inferência – os aceleradores NN estão disponíveis em todos os fabricantes, em smartphones, laptops e outros dispositivos de ponta.

Arquiteturas analógicas baseadas em memristores também apareceram há algum tempo.

Acreditamos que as CPUs podem ser muito boas em inferência se as aprimorarmos com aceleração, como extensões de matriz

Lado RISC-V das coisas:

No lado RISC-V, estamos desenvolvendo aceleradores para operações matriciais e outras operações não lineares para eliminar possíveis gargalos nas cargas de trabalho do transformador. Os gargalos de Von Neumann também estão sendo resolvidos pela arquitetura de memórias mais próximas da computação, tornando as CPUs com aceleração de IA a escolha certa para inferência.

Oportunidades:

Existem oportunidades únicas para preencher o mercado de modelos de fundações. Exemplo – OpenAI tem mencionado que não foi capaz de proteger computação de IA (GPUs) suficiente para continuar a promover seus serviços ChatGPT… e as notícias sobre custos de eletricidade de 10x mais do que a pesquisa regular na Internet e 500ml de água para resfriar os sistemas para cada consulta. Há um mercado a ser preenchido aqui - não é um nicho, mas é todo o mercado que democratizará a IA, enfrentando todos os desafios mencionados acima - a) disponibilidade, b) acessibilidade, c) acessibilidade, ed) segurança ambiental

Em quais novos recursos/tecnologia você está trabalhando?

Estamos construindo um cérebro semelhante a um computador, aproveitando técnicas neuromodórficas e adaptando modelos para aproveitar as vantagens do hardware com eficiência energética, reutilizando muitas das estruturas abertas disponíveis.

Como você vê o setor de IA/ML crescendo ou mudando nos próximos 12 a 18 meses?

À medida que a procura por GPUs diminuiu (custando cerca de 30 mil dólares) e algumas partes do mundo enfrentam sanções para comprar estas GPUs, algumas partes do mundo sentem que estão congeladas na investigação e desenvolvimento de IA sem acesso a GPUs. Plataformas de hardware alternativas vão conquistar o mercado.

Os modelos talvez comecem a diminuir – modelos personalizados ou mesmo fundamentalmente a densidade da informação aumentaria

A mesma pergunta, mas e quanto ao crescimento e às mudanças nos próximos 3-5 anos?

a) CPUs com extensões de IA capturariam o mercado de inferência de IA

b) Os modelos se tornariam ágeis e os parâmetros cairiam à medida que a densidade da informação aumentasse de 16% para 90%

c) A eficiência energética melhora, a pegada de CO2 reduz

d) Novas arquiteturas surgem

e) os custos de hardware e de energia diminuem, de modo que a barreira de entrada para empresas menores criarem e treinarem modelos se torna acessível

f) as pessoas falam sobre o momento pré-AGI, mas minha referência seria a personagem Samantha (IA conversacional) no filme “ela”.. isso talvez improvável dado o alto custo de expansão

Quais são alguns dos desafios que podem impactar ou limitar o crescimento do setor de IA/ML?

a) Acesso ao hardware

b) Custos de energia e custos de refrigeração e danos ambientais

Leia também:

Entrevista com o CEO: David Moore da Pragmatic

Entrevista com o CEO: Dra. Meghali Chopra da Sandbox Semiconductor

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :tem

- :é

- :não

- :onde

- $UP

- 1

- 10

- 150

- 20

- 20 anos

- 200

- 50

- 500

- 7

- a

- Capaz

- Sobre

- acima

- abu dhabi

- aceleração

- aceleradores

- Acesso

- acessibilidade

- ativamente

- endereço

- endereçado

- endereçando

- Vantagem

- Negócios

- novamente

- Agente

- agentes

- AGI

- atrás

- AI

- Modelos de IA

- ai pesquisa

- Sistemas de IA

- casos de uso ai

- AI / ML

- alinhado

- Todos os Produtos

- Permitindo

- permite

- juntamente

- tb

- alternativa

- surpreendente

- an

- e

- Outro

- qualquer

- qualquer lugar

- Aplicação

- aplicações

- arquitetura

- SOMOS

- áreas

- Chega

- artificial

- inteligência artificial

- AS

- Asics

- perguntar

- At

- automotivo

- disponibilidade

- disponível

- longe

- b

- barreira

- baseado

- BE

- tornam-se

- torna-se

- tornando-se

- sido

- ser

- Acreditar

- abaixo

- referência

- beneficiar

- Benefícios

- entre

- Pós

- gargalos

- obrigado

- Cérebro

- miolos

- construir

- Prédio

- mas a

- comprar

- by

- Califórnia

- CAN

- cancelado

- capacidade

- capaz

- capital

- capturar

- carbono

- captura de carbono

- casos

- Centros

- Chefe executivo

- Entrevista do CEO

- certificado

- desafiar

- desafios

- alterar

- mudado

- mudança

- personagem

- ChatGPT

- Crianças

- lasca

- Chips

- escolha

- Chopra

- cliente

- Fechar

- mais próximo

- Na nuvem

- Agrupar

- co2

- como

- Empresas

- Empresa

- comparado

- competir

- competitivo

- Computar

- computador

- computadores

- computação

- conceitos

- conferências

- consumir

- consumo

- continuar

- contribuiu

- conversação

- IA conversacional

- Legal

- Custo

- custos

- poderia

- crio

- Atual

- Estado atual

- Atualmente

- personalizadas

- cliente

- Clientes

- corte

- Cíber segurança

- dados,

- centros de dados

- Datacenter

- David

- dia

- dias

- decisão

- profundo

- deep learning

- mais profunda

- Demanda

- democratizar

- Democratizando

- demonstraram

- densidade

- Dependendo

- Design

- desenvolver

- desenvolvido

- em desenvolvimento

- Desenvolvimento

- Dispositivos/Instrumentos

- Dhabi

- diferenciar

- diligência

- direção

- Diretor

- do

- parece

- fazer

- dólares

- não

- down

- dr

- Cair

- dois

- ganhou

- borda

- efeitos

- eficiência

- eficiente

- eficientemente

- eletricidade

- consumo elétrico

- eliminado

- elimina

- emoções

- Empatia

- energia

- eficiência energética

- Engenharia

- aumentar

- suficiente

- Todo

- entrada

- Meio Ambiente

- ambiental

- visionar

- estimativa

- estimado

- etc.

- Éter (ETH)

- Mesmo

- eventualmente

- Cada

- exemplo

- executivo

- Diretora Executiva

- existir

- experiência

- Explode

- extensões

- Rosto

- enfrentando

- falcão

- mais rápido

- sentindo-me

- preencher

- empresas

- flutuante

- focado

- Pé

- Escolha

- prever

- formato

- Fortune

- Foundation

- enquadramentos

- da

- congelado

- alimentaram

- funcional

- fundamentalmente

- futuro

- Geral

- Gerações

- generativo

- IA generativa

- dado

- Go

- vai

- vai

- Bom estado, com sinais de uso

- GPUs

- Grupo

- Crescente

- Growth

- Hardware

- Ter

- he

- conseqüentemente

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- detém

- hospedagem

- Como funciona o dobrador de carta de canal

- HTTPS

- enorme

- Abraçando o Rosto

- humano

- Humanidade

- IEEE

- if

- imagem

- Impacto

- melhorar

- melhora

- in

- Em outra

- inclui

- Crescimento

- indústria

- INFORMAÇÕES

- inovar

- Inovação

- e inovações

- em vez disso

- Instituto

- Intel

- Inteligência

- Internacionais

- Internet

- Entrevista

- investimento

- iot

- IT

- ESTÁ

- apenas por

- crianças

- Tipo

- Falta

- paisagem

- língua

- laptops

- grande

- Maior

- conduzir

- Liderança

- APRENDER

- aprendizagem

- deixar

- Alavancagem

- aproveitando

- como

- ribalta

- LIMITE

- carregar

- localizado

- olhar

- parece

- diminuir

- máquinas

- Fazendo

- Fabricante

- muitos

- mercado

- Mercados

- Matriz

- max-width

- Posso..

- talvez

- MBA

- me

- significado

- significa

- a medida

- Memórias

- mencionado

- poder

- milhão

- Milhão de dolares

- MIT

- modelo

- modelos

- momento

- monopólios

- mês

- mais

- a maioria

- filme

- em movimento

- MS

- devo

- my

- nome

- nomeadamente

- natural

- você merece...

- baseado em rede

- networking

- Neural

- Novo

- notícias

- Próximo

- nicho

- noite

- ágil

- agora

- nuclear

- Poder nuclear

- número

- oceanos

- of

- on

- ONE

- só

- aberto

- open source

- OpenAI

- Operações

- oportunidades

- otimização

- Otimize

- Opções

- or

- Outros

- A Nossa

- Fora

- próprio

- página

- Paralelo

- parâmetro

- parâmetros

- peças

- Patentes

- Pagar

- Pessoas

- possivelmente

- avião

- plantas

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- abundância

- mais

- bolsos

- ponto

- posição

- possível

- poder

- usinas de energia

- Prática

- Impressão

- privado

- Problema

- problemas

- Produto

- Produtos

- Perfil

- Progresso

- solicita

- proteger

- propósito

- fins

- Empurrar

- Coloca

- Qualcomm

- questão

- Frequentes

- alcance

- classificado

- Leia

- recentemente

- Recomendação

- recomendações

- reduzir

- redução

- regular

- Relatórios

- solicitar

- pesquisa

- pesquisa e desenvolvimento

- pesquisadores

- certo

- Ribeira

- papéis

- telhado

- Execute

- corrida

- é executado

- seguro

- Segurança

- mesmo

- Sanções

- sandbox

- Salvar

- poupança

- dizer

- dimensionamento

- Ciência

- Pesquisar

- Épocas

- setor

- seguro

- Vejo

- segmentos

- Semicondutor

- Semicondutores

- Série

- Servidores

- serviço

- Serviços

- de servir

- Partilhar

- escassez

- rede de apoio social

- mostrou

- Shows

- lado

- periodo

- desde

- menor

- smartphones

- Smartphones

- So

- Software

- Soluções

- Resolvendo

- alguns

- fonte

- Espaço

- especializado

- gasto

- Stanford

- começo

- Startups

- Estado

- Estratégia

- mais forte

- tal

- supply

- ajuda

- sustentável

- sistemas

- equipamento

- abordando

- alfaiataria

- Tire

- Converse

- tarefas

- Dados Técnicos:

- Tecnologia

- inovação tecnológica

- condições

- texto

- do que

- que

- A

- O Futuro

- as informações

- o mundo

- deles

- Eles

- então

- Lá.

- assim

- Este

- deles

- coisas

- isto

- aqueles

- Apesar?

- Prosperar

- tempo

- para

- hoje

- Tokens

- amanhã

- também

- topo

- lançar

- tradicional

- Trem

- Training

- transformador

- transformadores

- Tendências

- confiável

- tentar

- tentando

- para

- entende

- universidade

- Universidade da Califórnia

- improvável

- us

- Uso

- usar

- usava

- utilização

- vário

- risco

- capitale a rischio,en

- empresas de capital de risco

- muito

- de

- foi

- Água

- Caminho..

- we

- web

- Bem-estar

- foram

- O Quê

- quando

- qual

- QUEM

- porque

- precisarão

- de

- sem

- Atividades:

- trabalhar

- mundo

- seria

- Errado

- anos

- Você

- investimentos

- zefirnet