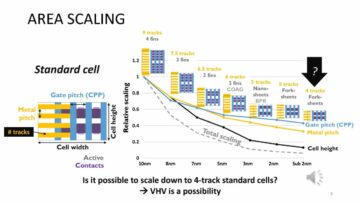

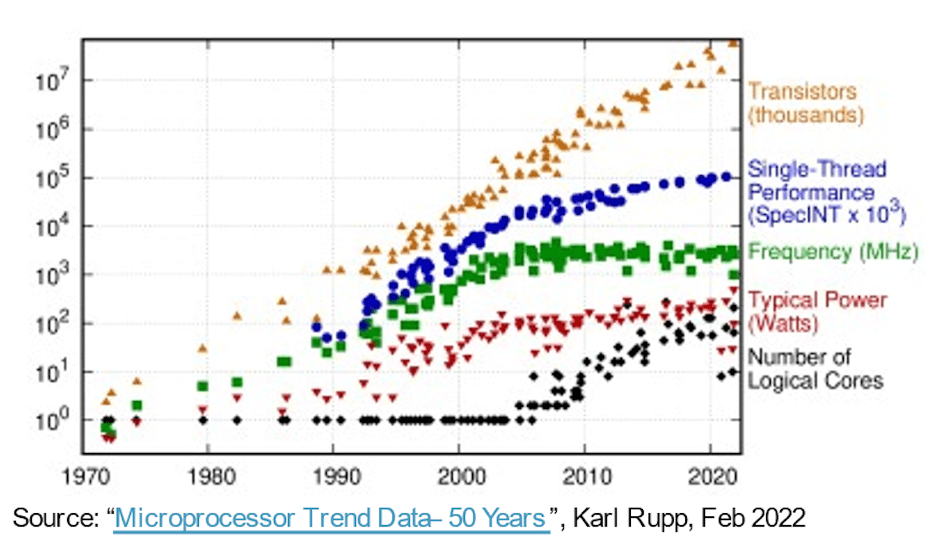

Na marcha para sistemas mais capazes, mais rápidos, menores e de menor consumo de energia, a Lei de Moore deu ao software uma carona por mais de 30 anos ou mais, puramente na evolução do processo de semicondutores. O hardware de computação fornece métricas de desempenho/área/potência aprimoradas a cada ano, permitindo que o software se expanda em complexidade e ofereça mais capacidade sem desvantagens. Então as vitórias fáceis tornaram-se menos fáceis. Processos mais avançados continuaram a fornecer contagens de portas mais altas por unidade de área, mas os ganhos em desempenho e potência começaram a diminuir. Como nossas expectativas de inovação não pararam, os avanços na arquitetura de hardware tornaram-se mais importantes para compensar a lacuna.

Drivers para aumentar a contagem de núcleos

Um passo inicial nessa direção usou CPUs multinúcleo para acelerar o rendimento total, encadeando ou virtualizando uma combinação de tarefas simultâneas entre núcleos, reduzindo a energia conforme necessário, inativando ou desligando núcleos inativos. Multi-core é padrão hoje e uma tendência em muitos núcleos (ainda mais CPUs em um chip) já é evidente nas opções de instâncias de servidor disponíveis em plataformas de nuvem da AWS, Azure, Alibaba e outras.

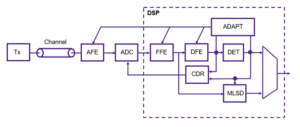

As arquiteturas com vários/muitos núcleos são um avanço, mas o paralelismo por meio de clusters de CPU é grosseiro e tem seus próprios limites de desempenho e potência, graças à lei de Amdahl. As arquiteturas tornaram-se mais heterogêneas, adicionando aceleradores para imagem, áudio e outras necessidades especializadas. Os aceleradores de IA também impulsionaram o paralelismo refinado, passando para matrizes sistólicas e outras técnicas específicas de domínio. Que estava funcionando muito bem até que o ChatGPT apareceu com 175 bilhões de parâmetros, com o GPT-3 evoluindo para o GPT-4 com 100 trilhões de parâmetros – ordens de magnitude mais complexas do que os sistemas de IA atuais – forçando recursos de aceleração ainda mais especializados nos aceleradores de IA.

Numa frente diferente, os sistemas multissensores em aplicações automotivas estão agora integrados em SoCs únicos para melhorar a consciência ambiental e melhorar o PPA. Aqui, novos níveis de autonomia no setor automotivo dependem da fusão de entradas de vários tipos de sensores em um único dispositivo, em subsistemas replicados em 2X, 4X ou 8X.

De acordo com Michał Siwinski (CMO da Arteris), a amostragem de mais de um mês de discussões com diversas equipes de design em uma ampla gama de aplicações sugere que essas equipes estão ativamente recorrendo a contagens de núcleos mais altas para atender às metas de capacidade, desempenho e potência. Ele me disse que eles também veem essa tendência se acelerando. Os avanços no processo ainda ajudam na contagem de portas SoC, mas a responsabilidade pelo cumprimento das metas de desempenho e potência está agora firmemente nas mãos dos arquitetos.

Mais núcleos, mais interconexão

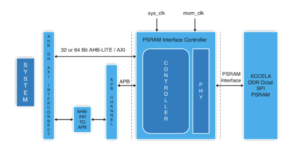

Mais núcleos em um chip implicam em mais conexões de dados entre esses núcleos. Dentro de um acelerador entre elementos de processamento vizinhos, para cache local, para aceleradores para matriz esparsa e outras manipulações especializadas. Adicione conectividade hierárquica entre blocos aceleradores e barramentos de nível de sistema. Adicione conectividade para armazenamento de peso no chip, descompressão, transmissão, coleta e recompactação. Adicione conectividade HBM para cache funcional. Adicione um motor de fusão, se necessário.

O cluster de controle baseado em CPU deve se conectar a cada um desses subsistemas replicados e a todas as funções usuais – codecs, gerenciamento de memória, ilha de segurança e raiz de confiança, se apropriado, UCIe se for uma implementação de múltiplos chips, PCIe para E/S de alta largura de banda. e Ethernet ou fibra para rede.

Isso representa muita interconexão, com consequências diretas para a comercialização do produto. Em processos abaixo de 16nm, a infraestrutura NoC contribui agora com 10-12% em área. Ainda mais importante, como via de comunicação entre núcleos, pode ter um impacto significativo no desempenho e na potência. Existe um perigo real de que uma implementação abaixo do ideal desperdice o desempenho esperado da arquitetura e os ganhos de energia ou, pior ainda, resulte em numerosos ciclos de redesenho para convergir. No entanto, encontrar uma boa implementação em uma planta baixa de SoC complexa ainda depende de otimizações lentas de tentativa e erro em cronogramas de projeto já apertados. Precisamos dar o salto para um design NoC fisicamente consciente, para garantir desempenho total e suporte de energia de hierarquias NoC complexas e precisamos fazer essas otimizações mais rapidamente.

Projetos NoC fisicamente conscientes mantêm a lei de Moore no caminho certo

A lei de Moore pode não estar morta, mas os avanços em desempenho e potência hoje vêm da arquitetura e da interconexão NoC, e não do processo. A arquitetura está impulsionando mais núcleos aceleradores, mais aceleradores dentro de aceleradores e mais replicação de subsistemas no chip. Todos aumentam a complexidade da interconexão no chip. À medida que os projetos aumentam a contagem de núcleos e passam para geometrias de processo de 16nm e abaixo, as numerosas interconexões NoC que abrangem o SoC e seus subsistemas só podem suportar todo o potencial desses projetos complexos se forem implementadas de forma otimizada contra restrições físicas e de tempo – por meio de redes fisicamente conscientes. no design de chips.

Se você também se preocupa com essas tendências, talvez queira saber mais sobre a tecnologia Arteris FlexNoC 5 IP AQUI.

Compartilhe esta postagem via:

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://semiwiki.com/artificial-intelligence/326727-interconnect-under-the-spotlight-as-core-counts-accelerate/

- :é

- $UP

- 100

- a

- Sobre

- acelerar

- acelerando

- aceleração

- acelerador

- aceleradores

- em

- ativamente

- avançado

- avanços

- contra

- AI

- Sistemas de IA

- Alibaba

- Todos os Produtos

- Permitindo

- já

- e

- apareceu

- aplicações

- apropriado

- arquitetura

- SOMOS

- ÁREA

- AS

- At

- auditivo

- automotivo

- disponível

- consciência

- AWS

- Azul

- Largura de Banda

- BE

- tornam-se

- abaixo

- entre

- bilhão

- transmissão

- ônibus

- by

- esconderijo

- CAN

- capaz

- ChatGPT

- lasca

- Na nuvem

- Agrupar

- CMO

- como

- Comunicação

- integrações

- complexidade

- Computar

- concorrente

- Contato

- Coneções

- Conectividade

- Consequências

- restrições

- continuou

- ao controle

- Convergem

- núcleo

- CPU

- PERIGO

- dados,

- morto

- entregar

- entregue

- depende

- Design

- projetos

- dispositivo

- diferente

- diretamente

- direção

- discussões

- down

- desvantagens

- cada

- Cedo

- elementos

- Motor

- Meio Ambiente

- Mesmo

- Cada

- evolução

- evolução

- Expandir

- expectativas

- esperado

- mais rápido

- Funcionalidades

- descoberta

- firmemente

- Escolha

- para a frente

- Gratuito

- da

- frente

- cheio

- funções

- fusão

- Ganhos

- Objetivos

- Bom estado, com sinais de uso

- garanta

- Manipulação

- mãos

- Hardware

- Ter

- ajudar

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- superior

- Rodovia

- HTTPS

- imagem

- Impacto

- implementação

- implementado

- importante

- melhorado

- in

- inativo

- Crescimento

- aumentando

- Infraestrutura

- Inovação

- instância

- Integração

- IP

- ilha

- IT

- ESTÁ

- saltar

- Escritórios de

- APRENDER

- Nível

- níveis

- limites

- local

- lote

- fazer

- de grupos

- Março

- Matriz

- max-width

- Conheça

- reunião

- Memória

- Métrica

- poder

- Mês

- mais

- mover

- em movimento

- múltiplo

- você merece...

- necessário

- Cria

- rede

- networking

- Novo

- numeroso

- of

- on

- Opções

- ordens

- Outros

- Outros

- próprio

- parâmetros

- atuação

- físico

- Fisicamente

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- Publique

- potencial

- poder

- Powering

- bastante

- processo

- processos

- em processamento

- Produto

- puramente

- empurrado

- Empurrando

- alcance

- em vez

- reais

- redução

- replicado

- réplica

- responsabilidade

- resultar

- Viajar

- raiz

- Segurança

- Semicondutor

- periodo

- desde

- solteiro

- folga

- lento

- menor

- So

- Software

- matriz esparsa

- especializado

- Holofote

- padrão

- começado

- Passo

- Ainda

- Dê um basta

- armazenamento

- Sugere

- ajuda

- .

- sistemas

- tarefas

- equipes

- técnicas

- Tecnologia

- conta

- que

- A

- Este

- Através da

- Taxa de transferência

- cronometragem

- para

- hoje

- hoje

- Total

- Trend

- Tendências

- Trilhão

- Confiança

- Passando

- tipos

- para

- unidade

- via

- peso

- BEM

- qual

- Largo

- Ampla variedade

- precisarão

- Vitórias

- de

- dentro

- trabalhar

- ano

- anos

- zefirnet