Suresh jest dyrektorem ds. technologii posiadającym głęboką wiedzę techniczną w zakresie półprzewodników, sztucznej inteligencji, cyberbezpieczeństwa, internetu rzeczy, sprzętu, oprogramowania itp. Spędził 20 lat w branży, a ostatnio pełnił funkcję dyrektora wykonawczego ds. oprogramowania typu open source zero- Trust ds. rozwoju chipów w Instytucie Innowacji Technologicznych w Abu Zabi oraz w innych firmach z listy Fortune 500 zajmujących się półprzewodnikami, takich jak Intel, Qualcomm i MediaTek, na różnych stanowiskach kierowniczych, gdzie badał i rozwijał wysokowydajne, energooszczędne, zabezpieczone postkwantowo i bezpieczne mikrochipy/system-on-chip (SoC)/akceleratory dla rynków centrów danych, klientów, smartfonów, sieci, IoT i AI/ML. Brał udział w rozwoju Falcon LLM (nr 1 w rankingu huggingface) i był głównym architektem niestandardowej platformy sprzętowej AI (anulowana – zmieniono priorytety). Posiada ponad 15 patentów w USA i opublikował/prezentował na ponad 20 konferencjach.

Suresh jest dyrektorem ds. technologii posiadającym głęboką wiedzę techniczną w zakresie półprzewodników, sztucznej inteligencji, cyberbezpieczeństwa, internetu rzeczy, sprzętu, oprogramowania itp. Spędził 20 lat w branży, a ostatnio pełnił funkcję dyrektora wykonawczego ds. oprogramowania typu open source zero- Trust ds. rozwoju chipów w Instytucie Innowacji Technologicznych w Abu Zabi oraz w innych firmach z listy Fortune 500 zajmujących się półprzewodnikami, takich jak Intel, Qualcomm i MediaTek, na różnych stanowiskach kierowniczych, gdzie badał i rozwijał wysokowydajne, energooszczędne, zabezpieczone postkwantowo i bezpieczne mikrochipy/system-on-chip (SoC)/akceleratory dla rynków centrów danych, klientów, smartfonów, sieci, IoT i AI/ML. Brał udział w rozwoju Falcon LLM (nr 1 w rankingu huggingface) i był głównym architektem niestandardowej platformy sprzętowej AI (anulowana – zmieniono priorytety). Posiada ponad 15 patentów w USA i opublikował/prezentował na ponad 20 konferencjach.

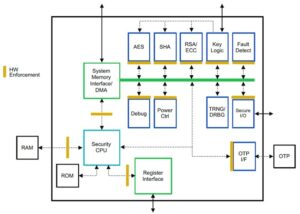

Suresh aktywnie zajmuje także stanowisko kierownicze w RISC-V International, gdzie przewodniczy Trusted Computing Group zajmującej się rozwojem możliwości przetwarzania poufnego RISC-V oraz przewodniczy Grupie AI/ML zajmującej się opracowywaniem akceleracji sprzętowej RISC-V dla obciążeń AI/ML, takich jak Modele wielkojęzyczne transformatorów używane w aplikacjach typu ChatGPT. Doradza także start-upom i firmom venture capital w zakresie wsparcia decyzji inwestycyjnych, strategii produktowej, due diligence technologii itp.

Uzyskał tytuł MBA w INSEAD, tytuł magistra w Birla Institute of Technology & Science Pilani, certyfikat inżynierii systemów na MIT, certyfikat AI na Uniwersytecie Stanford oraz certyfikat bezpieczeństwa funkcjonalnego motoryzacji wydany przez TÜV SÜD.

Opowiedz nam o swojej firmie

"Mastiṣka AI” (Mastiṣka oznacza w sanskrycie mózg) to firma zajmująca się sztuczną inteligencją, skupiająca się na budowaniu komputerów przypominających mózg, aby wydajniej uruchamiać podstawowe modele na potrzeby przyszłych zastosowań generatywnej sztucznej inteligencji.

Jakie problemy rozwiązujesz?

Biorąc pod uwagę korzyści płynące ze sztucznej inteligencji/GenAI, jej popyt z pewnością wzrośnie, podobnie jak skutki uboczne dla naszej planety. Jak możemy zmniejszyć lub zneutralizować skutki uboczne AI na naszej planecie? Wychwytywanie dwutlenku węgla i energia jądrowa idą we właściwym kierunku. Musimy jednak zasadniczo przemyśleć sposób, w jaki robimy sztuczną inteligencję, czy jest to niewłaściwy sposób wykonywania ton mnożenia macierzy?

Nasz mózg może uczyć się i wykonywać wiele zadań równolegle, przy poborze mocy 10 W i mniejszym, ale dlaczego te systemy AI zużywają 10 megawatów na szkolenie modeli?

Być może przyszłość kryje w sobie energooszczędne architektury, takie jak architektury neuromorficzne i transformatory oparte na sieciach neuronowych, które znajdują się najbliżej ludzkiego mózgu i które mogą zużywać 100–1000 razy mniej energii, zmniejszając w ten sposób koszty korzystania ze sztucznej inteligencji, a tym samym demokratyzując ją i oszczędzając nasze planeta.

Obecne wyzwania, przed którymi stoimy w związku ze sztuczną inteligencją, to a) dostępność, b) dostępność, c) przystępność cenowa i d) bezpieczeństwo środowiskowe wraz z pewnymi zaleceniami dotyczącymi ich rozwiązania.

Jeśli przewidujemy przyszłość, kilka przydatnych koncepcji AGI zostało zademonstrowanych w filmie „HER”, w którym postać „Samantha” – rozmówczyni, która jest naturalna, rozumie emocje, okazuje empatię, jest niesamowitym drugim pilotem w pracy – i biegnie dalej urządzeń przenośnych przez cały dzień, być może będziemy musieli już teraz zająć się poniższymi wyzwaniami.

Problem 1: Szkolenie LLM może kosztować od 150 tys. do ponad 10 milionów dolarów i umożliwia rozwój sztucznej inteligencji tylko osobom z większymi kieszeniami. Co więcej, koszty wnioskowania są również ogromne (kosztują 10 razy więcej niż wyszukiwanie w Internecie)

—> Musimy poprawić efektywność energetyczną modeli/sprzętu, aby zdemokratyzować sztuczną inteligencję z korzyścią dla ludzkości.

Problem 2: Uruchamianie gigantycznych modeli sztucznej inteligencji dla agentów konwersacyjnych lub systemów rekomendacji ma negatywny wpływ na środowisko w zakresie zużycia energii elektrycznej i chłodzenia.

—> Musimy poprawić efektywność energetyczną modeli/sprzętu, aby ocalić naszą planetę dla naszych dzieci.

Problem 3: Ludzki mózg jest zdolny i może wykonywać wiele zadań jednocześnie, ale zużywa tylko 10 watów zamiast megawatów.

—> Być może powinniśmy szybciej budować maszyny podobne do naszych mózgów, a nie zwykłe mnożniki macierzy.

Ludzkość może prosperować jedynie dzięki zrównoważonym innowacjom, a nie wycinaniu wszystkich lasów i gotowaniu oceanów w imię innowacji. Musimy chronić naszą planetę dla dobra naszych dzieci i przyszłych pokoleń…

Jakie obszary zastosowań są dla Ciebie najmocniejsze?

Uczenie i wnioskowanie modeli podstawowych opartych na transformatorach (i przyszłej architekturze neuronowej) przy 50–100 razy większej efektywności energetycznej w porównaniu z dzisiejszymi rozwiązaniami opartymi na procesorach graficznych.

Co nie daje zasnąć Twoim klientom w nocy?

Problemy dla klientów, którzy obecnie korzystają z innych produktów:

Zużycie energii elektrycznej do uczenia modeli języków olbrzymich jest ogromne, na przykład szkolenie LLM z parametrem 13B na tokenach tekstowych 390B na 200 procesorach graficznych przez 7 dni kosztuje 151,744 XNUMX USD (Źródło: nowa strona usługi klastra szkoleniowego HuggingFace – https://lnkd.in/g6Vc5cz3). Samo wyszkolenie nawet większych modeli z parametrami 100+B kosztuje 10+M USD. Następnie płać za wnioskowanie za każdym razem, gdy nadejdzie nowe żądanie monitu.

Naukowcy z Uniwersytetu Kalifornijskiego w Riverside oszacowali zużycie wody do chłodzenia, jaki wpływ na środowisko ma usługa typu ChatGPT i twierdzą, że za każdym razem, gdy ją poprosisz, połyka ona 500 mililitrów wody (prawie tyle, ile mieści się w 16-uncjowej butelce wody). serię od 5 do 50 podpowiedzi lub pytań. Zasięg różni się w zależności od lokalizacji serwerów i pory roku. Szacunki obejmują pośrednie zużycie wody, którego firmy nie mierzą – na przykład do chłodzenia elektrowni zasilających centra danych w energię elektryczną. (Źródło: https://lnkd.in/gybcxX8C)

Problemy dla osób niebędących klientami aktualnych produktów:

Nie stać mnie na CAPEX na zakup sprzętu

Nie stać Cię na korzystanie z usług w chmurze

Nie potrafi wprowadzać innowacji ani wykorzystywać sztucznej inteligencji – utknął w modelu usług, który eliminuje jakąkolwiek przewagę konkurencyjną

Jak wygląda krajobraz konkurencyjny i jak się wyróżniasz?

- W przestrzeni szkoleniowej dominują procesory graficzne, mimo że w tym segmencie konkurują także wyspecjalizowane układy ASIC

- Wnioskowanie w chmurze i na krawędzi ma zbyt wiele dostępnych opcji

Cyfrowe, analogowe, fotoniczne — jakkolwiek to nazwać, ludzie próbują rozwiązać ten sam problem.

Czy możesz podzielić się swoimi przemyśleniami na temat obecnego stanu architektury chipów dla AI/ML, czyli jakie są obecnie według Ciebie najważniejsze trendy i możliwości?

Następujące trendy:

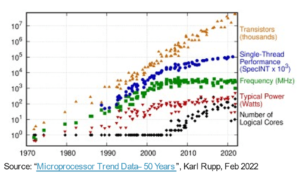

Trend 1: 10 lat temu głębokie uczenie się oparte na sprzęcie rozkwitło, a teraz ten sam sprzęt hamuje postęp. Ze względu na ogromne koszty sprzętu i energii elektrycznej potrzebnej do uruchomienia modeli, dostęp do sprzętu stał się wyzwaniem. Mogą sobie na to pozwolić tylko firmy z głębokimi kieszeniami i stają się monopolistami.

Trend 2: Teraz, gdy te modele już istnieją, musimy wykorzystać je do celów praktycznych, aby zwiększyć obciążenie wnioskowania, dzięki czemu procesory wyposażone w akceleratory AI ponownie znajdą się w centrum uwagi.

Trend 3: Startupy próbują wymyślić alternatywne reprezentacje liczb zmiennoprzecinkowych, które uznają, że tradycyjny format IEEE – taki jak logarytmiczny i oparty na pozycjach – jest dobry, ale niewystarczający. Optymalizacja przestrzeni projektowej PPA$ eksploduje, gdy próbujemy zoptymalizować jedną, a druga zostaje wyrzucona.

Trend 4: Branża odchodzi od modelu sztucznej inteligencji opartego na usługach na rzecz hostowania własnych, prywatnych modeli we własnej siedzibie, ale dostęp do sprzętu stanowi wyzwanie ze względu na niedobory dostaw, sankcje itp.

Aktualny stan rzeczy:

Dostępność sprzętu i danych napędzała rozwój sztucznej inteligencji 10 lat temu, teraz ten sam sprzęt w pewnym sensie go hamuje — pozwólcie, że wyjaśnię

Odkąd procesory radziły sobie fatalnie, a procesory graficzne zostały przystosowane do obsługi sztucznej inteligencji, wiele się wydarzyło

Firmy zajmują się 4 segmentami AI/ML, a mianowicie – 1) szkoleniem w chmurze, 2) wnioskowaniem w chmurze, 3) wnioskowaniem brzegowym i 4) szkoleniem brzegowym (uczenie się federacyjne dla aplikacji wrażliwych na prywatność).

Cyfrowe i analogowe

Strona szkoleniowa – mnóstwo firm zajmujących się procesorami graficznymi, akceleratorami klientów opartymi na RISC-V, chipami w skali waflowej (rdzeni 850 tys.) i tak dalej tam, gdzie brakuje tradycyjnych procesorów (ich ogólne przeznaczenie). Wnioski – akceleratory NN są dostępne u każdego producenta, w smartfonach, laptopach i innych urządzeniach brzegowych.

Jakiś czas temu pojawiły się także analogowe architektury oparte na memrystorach.

Wierzymy, że procesory mogą być bardzo dobre w wnioskowaniu, jeśli ulepszymy je za pomocą akceleracji, takiej jak rozszerzenia macierzy

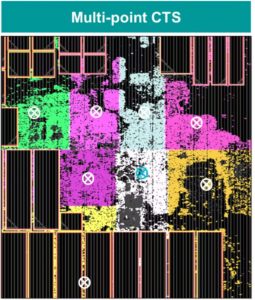

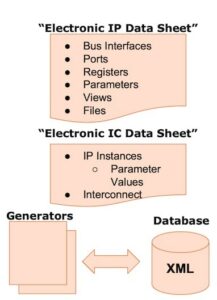

Strona RISC-V:

Po stronie RISC-V opracowujemy akceleratory do operacji macierzowych i innych operacji nieliniowych, aby wyeliminować możliwe wąskie gardła w obciążeniach transformatora. Rozwiązano także problem wąskich gardeł Von Neumanna poprzez projektowanie pamięci bliższych obliczeniom obliczeniowym, co ostatecznie sprawi, że procesory wyposażone w akcelerację AI będą właściwym wyborem do wnioskowania.

Szanse:

Istnieją wyjątkowe możliwości wypełnienia rynku modeli fundamentów. Przykład – OpenAI wspominało, że nie było w stanie zabezpieczyć wystarczającej liczby mocy obliczeniowych AI (GPU), aby nadal rozwijać swoje usługi ChatGPT… oraz doniesienia prasowe o kosztach energii elektrycznej 10-krotnie wyższych niż zwykłe wyszukiwanie w Internecie i 500 ml wody do ochłodzenia systemów dla każdego zapytania. Jest tu rynek do zapełnienia — nie jest to nisza, ale cały rynek, który zdemokratyzuje sztuczną inteligencję, stawiając czoła wszystkim wymienionym wyzwaniom – a) dostępność, b) dostępność, c) przystępność cenowa i d) bezpieczeństwo środowiskowe

Nad jakimi nowymi funkcjami/technologiami pracujesz?

Budujemy mózg przypominający komputer, wykorzystując techniki neuromodrficzne i dostosowując modele, aby wykorzystać energooszczędny sprzęt, ponownie wykorzystując wiele dostępnych otwartych struktur

Jak wyobrażasz sobie rozwój lub zmiany sektora AI/ML w ciągu najbliższych 12–18 miesięcy?

Ponieważ popyt na procesory graficzne spadł (kosztują około 30 tys. dolarów), a niektóre części świata stoją w obliczu sankcji za zakup tych procesorów graficznych, niektóre części świata mają poczucie, że są zamrożone w badaniach i rozwoju sztucznej inteligencji bez dostępu do procesorów graficznych. Alternatywne platformy sprzętowe zamierzają podbić rynek.

Być może modele zaczną się kurczyć – modele niestandardowe lub nawet zasadniczo wzrośnie gęstość informacji

To samo pytanie, ale co z rozwojem i zmianami w ciągu najbliższych 3-5 lat?

a) Procesory z rozszerzeniami AI przejęłyby rynek wnioskowania AI

b) Modele staną się zwinne, a parametry zaczną spadać wraz ze wzrostem gęstości informacji z 16% do 90%

c) Poprawia się efektywność energetyczna, zmniejsza się ślad CO2

d) Pojawiają się nowe architektury

e) koszty sprzętu i energii spadają, w związku z czym bariera wejścia dla mniejszych przedsiębiorstw w zakresie tworzenia i szkolenia modeli staje się przystępna cenowo

f) ludzie mówią o momencie sprzed AGI, ale moim punktem odniesienia byłaby Samanta (konwersacyjna sztuczna inteligencja) w filmie „ona”. Może to być mało prawdopodobne, biorąc pod uwagę wysokie koszty zwiększania skali

Jakie wyzwania mogą mieć wpływ lub ograniczyć rozwój sektora AI/ML?

a) Dostęp do sprzętu

b) Koszty energii i koszty chłodzenia oraz szkody dla środowiska

Przeczytaj także:

Wywiad z dyrektorem generalnym: David Moore z Pragmatic

Wywiad z dyrektorem generalnym: dr Meghali Chopra z Sandbox Semiconductor

Wywiad z dyrektorem generalnym: dr J. Provine z Aligned Carbon

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 10

- 150

- 20

- 20 roku

- 200

- 50

- 500

- 7

- a

- Zdolny

- O nas

- powyżej

- Abu Dabi

- przyśpieszenie

- akceleratory

- dostęp

- dostępność

- aktywnie

- adres

- zaadresowany

- adresowanie

- Korzyść

- Sprawy

- ponownie

- Agent

- agentów

- AGI

- temu

- AI

- Modele AI

- ai badania

- Systemy SI

- przypadki użycia ai

- AI / ML

- wyrównany

- Wszystkie kategorie

- Pozwalać

- pozwala

- wzdłuż

- również

- alternatywny

- zdumiewający

- an

- i

- Inne

- każdy

- nigdzie

- Zastosowanie

- aplikacje

- architektura

- SĄ

- obszary

- Przybywa

- sztuczny

- sztuczna inteligencja

- AS

- Asics

- zapytać

- At

- motoryzacyjny

- dostępność

- dostępny

- z dala

- b

- bariera

- na podstawie

- BE

- stają się

- staje się

- staje

- być

- jest

- uwierzyć

- poniżej

- Benchmark

- korzyści

- Korzyści

- pomiędzy

- Poza

- wąskie gardła

- związany

- Mózg

- mózg

- budować

- Budowanie

- ale

- kupować

- by

- California

- CAN

- anulowany

- zdolność

- zdolny

- kapitał

- zdobyć

- węgiel

- wychwytywanie dwutlenku węgla

- Etui

- Centra

- ceo

- Wywiad z prezesem

- świadectwo

- wyzwanie

- wyzwania

- zmiana

- zmieniony

- wymiana pieniędzy

- charakter

- ChatGPT

- Dzieci

- żeton

- Frytki

- wybór

- Chopra

- klient

- Zamknij

- bliższy

- Chmura

- Grupa

- co2

- jak

- Firmy

- sukcesy firma

- w porównaniu

- rywalizować

- konkurencyjny

- obliczać

- komputer

- komputery

- computing

- Koncepcje

- konferencje

- konsumować

- konsumpcja

- kontynuować

- przyczyniły

- konwersacyjny

- konwersacyjna sztuczna inteligencja

- Chłodny

- Koszty:

- Koszty:

- mógłby

- Stwórz

- Aktualny

- Stan aktulany

- Obecnie

- zwyczaj

- klient

- Klientów

- tnący

- Bezpieczeństwo cybernetyczne

- dane

- centra danych

- Datacenter

- David

- dzień

- Dni

- decyzja

- głęboko

- głęboka nauka

- głębiej

- Kreowanie

- zdemokratyzować

- Demokratyzować

- wykazać

- gęstość

- W zależności

- Wnętrze

- rozwijać

- rozwinięty

- rozwijanie

- oprogramowania

- urządzenia

- Dhabi

- różnicować

- pracowitość

- kierunek

- Dyrektor

- do

- robi

- robi

- dolarów

- nie

- na dół

- dr

- Spadek

- z powodu

- zdobył

- krawędź

- ruchomości

- efektywność

- wydajny

- skutecznie

- elektryczność

- pobór prądu

- wyeliminować

- eliminuje

- emocje

- Empatia

- energia

- efektywności energetycznej

- Inżynieria

- wzmacniać

- dość

- Cały

- wejście

- Środowisko

- środowiskowy

- wyobrażać sobie

- oszacowanie

- szacunkowa

- itp

- Eter (ETH)

- Parzyste

- ostatecznie

- Każdy

- przykład

- wykonawczy

- Dyrektor wykonawczy

- istnieć

- ekspertyza

- Wybucha

- rozszerzenia

- Twarz

- okładzina

- sokół

- szybciej

- uczucie

- wypełniać

- firmy

- unoszący się

- koncentruje

- Stopa

- W razie zamówieenia projektu

- przewidywać

- format

- Majątek

- Fundacja

- Ramy

- od

- zamrożone

- podsycane

- funkcjonalny

- zasadniczo

- przyszłość

- Ogólne

- Pokoleń

- generatywny

- generatywna sztuczna inteligencja

- dany

- Go

- Goes

- będzie

- dobry

- GPU

- Zarządzanie

- Rozwój

- Wzrost

- sprzęt komputerowy

- Have

- he

- stąd

- tutaj

- Wysoki

- posiada

- Hosting

- W jaki sposób

- HTTPS

- olbrzymi

- Przytulanie twarzy

- człowiek

- Ludzkość

- IEEE

- if

- obraz

- Rezultat

- podnieść

- poprawia

- in

- W innych

- obejmuje

- Zwiększać

- przemysł

- Informacja

- wprowadzać innowacje

- Innowacja

- innowacje

- zamiast

- Instytut

- Intel

- Inteligencja

- na świecie

- Internet

- Wywiad

- inwestycja

- Internet przedmiotów

- IT

- JEGO

- właśnie

- dzieci

- Uprzejmy

- Brak

- krajobraz

- język

- laptopy

- duży

- większe

- prowadzić

- Przywództwo

- UCZYĆ SIĘ

- nauka

- niech

- Dźwignia

- lewarowanie

- lubić

- światło wapienne

- LIMIT

- załadować

- usytuowany

- Popatrz

- wygląda jak

- niższy

- maszyny

- Dokonywanie

- Producent

- wiele

- rynek

- rynki

- Matrix

- Maksymalna szerokość

- Może..

- może

- MBA

- me

- znaczenie

- znaczy

- zmierzyć

- wspomnienia

- wzmiankowany

- może

- milion

- milion dolarów

- MIT

- model

- modele

- moment

- monopole

- miesięcy

- jeszcze

- większość

- film

- przeniesienie

- MS

- musi

- my

- Nazwa

- mianowicie

- Naturalny

- Potrzebować

- oparty na sieci

- sieci

- Nerwowy

- Nowości

- aktualności

- Następny

- nisza

- noc

- zwinny

- już dziś

- jądrowy

- Energia atomowa

- numer

- oceany

- of

- on

- ONE

- tylko

- koncepcja

- open source

- OpenAI

- operacje

- Szanse

- optymalizacja

- Optymalizacja

- Opcje

- or

- Inne

- ludzkiej,

- na zewnątrz

- własny

- strona

- Parallel

- parametr

- parametry

- strony

- Patenty

- Zapłacić

- Ludzie

- może

- planeta

- Rośliny

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- nadmiar

- plus

- kieszenie

- punkt

- position

- możliwy

- power

- elektrownie

- Praktyczny

- prywatny

- Problem

- problemy

- Produkt

- Produkty

- Profil

- Postęp

- monity

- chronić

- cel

- cele

- Naciskać

- Stawia

- Qualcomm

- pytanie

- pytania

- zasięg

- w rankingu

- Czytaj

- niedawno

- Rekomendacja

- zalecenia

- zmniejszyć

- redukcja

- regularny

- Raporty

- zażądać

- Badania naukowe

- badania i rozwój

- Badacze

- prawo

- Nadrzeczny

- role

- dach

- run

- bieganie

- działa

- "bezpiecznym"

- Bezpieczeństwo

- taki sam

- Sankcje

- piaskownica

- Zapisz

- oszczędność

- powiedzieć

- skalowaniem

- nauka

- Szukaj

- Pora roku

- sektor

- bezpieczne

- widzieć

- Segmenty

- Semiconductor

- Półprzewodniki

- Serie

- serwery

- usługa

- Usługi

- służąc

- Share

- braki

- powinien

- pokazał

- Targi

- bok

- znaczący

- ponieważ

- mniejszy

- smartphone

- smartfony

- So

- Tworzenie

- Rozwiązania

- Rozwiązywanie

- kilka

- Źródło

- Typ przestrzeni

- wyspecjalizowanym

- spędził

- Stanford

- początek

- Startups

- Stan

- Strategia

- najsilniejszy

- taki

- Dostawa

- wsparcie

- zrównoważone

- systemy

- sprzęt

- zwalczanie

- krawiectwo

- Brać

- Mówić

- zadania

- Techniczny

- Technologia

- innowacje technologiczne

- REGULAMIN

- XNUMX

- niż

- że

- Połączenia

- Przyszłość

- Informacje

- świat

- ich

- Im

- następnie

- Tam.

- a tym samym

- Te

- one

- rzeczy

- to

- tych

- chociaż?

- Prosperować

- czas

- do

- dzisiaj

- Żetony

- jutro

- także

- Top

- podrzucać

- tradycyjny

- Pociąg

- Trening

- transformator

- Transformatory

- Trendy

- zaufany

- próbować

- stara

- dla

- rozumie

- uniwersytet

- University of California

- mało prawdopodobne,

- us

- Stosowanie

- posługiwać się

- używany

- za pomocą

- różnorodny

- przedsięwzięcie

- venture capital

- firmy venture capital

- początku.

- z

- była

- Woda

- Droga..

- we

- sieć

- Dobrobyt

- były

- Co

- jeśli chodzi o komunikację i motywację

- który

- KIM

- dlaczego

- będzie

- w

- bez

- Praca

- pracujący

- świat

- by

- Źle

- lat

- ty

- Twój

- zefirnet