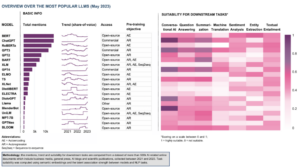

W szybko rozwijającej się dziedzinie sztucznej inteligencji przetwarzanie języka naturalnego stało się centralnym punktem zarówno naukowców, jak i programistów. Opierając się na fundamentach Architektura transformatora i Dwukierunkowa aktualizacja BERT, w ostatnich latach pojawiło się kilka przełomowych modeli językowych, przesuwając granice tego, co maszyny mogą rozumieć i generować.

W tym artykule zagłębimy się w najnowsze postępy w świecie wielkoskalowych modeli językowych, eksplorując ulepszenia wprowadzone przez każdy model, ich możliwości i potencjalne zastosowania. Przyjrzymy się również modelom języka wizualnego (VLM), które są szkolone do przetwarzania nie tylko danych tekstowych, ale także wizualnych.

Jeśli chcesz pominąć, oto modele językowe, które przedstawiliśmy:

- GPT-3 firmy OpenAI

- LaMDA od Google

- PaLM od Google

- Flaming od DeepMind

- BLIP-2 firmy Salesforce

- LLaMA autorstwa Meta AI

- GPT-4 firmy OpenAI

Jeśli te dogłębne treści edukacyjne są dla Ciebie przydatne, możesz zapisz się na naszą listę dyskusyjną AI zostać powiadomionym, gdy wydamy nowy materiał.

Najważniejsze duże modele językowe (LLM) i modele języka wizualnego (VLM) w 2023 r.

1. GPT-3 firmy OpenAI

Podsumowanie

Zespół OpenAI wprowadził GPT-3 jako alternatywę dla zestawu danych z etykietami dla każdego nowego zadania językowego. Zasugerowali, że skalowanie modeli językowych może poprawić wydajność kilku strzałów niezależnie od zadań. Aby przetestować tę sugestię, wytrenowali autoregresyjny model języka z parametrami 175B, zwany GPT-3i ocenili jego wydajność w ponad dwudziestu zadaniach NLP. Ocena w ramach uczenia się kilku strzałów, uczenia się jednego strzału i uczenia się zero strzałów wykazała, że GPT-3 osiągnął obiecujące wyniki, a nawet czasami przewyższał najnowocześniejsze wyniki osiągane przez precyzyjnie dostrojone modele.

Jaki jest cel?

- Aby zaproponować alternatywne rozwiązanie istniejącego problemu, gdy dla każdego nowego zadania językowego potrzebny jest zestaw danych z etykietami.

Jak podchodzi się do problemu?

- Naukowcy zasugerowali zwiększenie skali modeli językowych, aby poprawić wydajność kilku strzałów niezależnie od zadań.

- Połączenia GPT-3 model wykorzystuje ten sam model i architekturę co GPT-2, w tym zmodyfikowaną inicjalizację, wstępną normalizację i odwracalną tokenizację.

- Jednak w przeciwieństwie do GPT-2, używa naprzemiennych gęstych i lokalnie pasmowanych rzadkich wzorców uwagi w warstwach transformatora, jak w Rzadki transformator.

Jakie są rezultaty?

- Model GPT-3 bez dostrajania osiąga obiecujące wyniki w wielu zadaniach NLP, a czasami nawet przewyższa najnowocześniejsze modele, które zostały dostrojone do tego konkretnego zadania:

- Na CoQA benchmark, 81.5 F1 w ustawieniu zerowym, 84.0 F1 w ustawieniu jednostrzałowym i 85.0 F1 w ustawieniu kilku strzałów, w porównaniu z wynikiem 90.7 F1 osiągniętym przez precyzyjnie dostrojony SOTA.

- Na Ciekawostki benchmark, dokładność 64.3% w ustawieniu zerowym, 68.0% w ustawieniu jednostrzałowym i 71.2% w ustawieniu kilku strzałów, przewyższając stan techniki (68%) o 3.2%.

- Na LAMBADA zestaw danych, 76.2% dokładność w trybie zerowym, 72.5% w trybie jednostrzałowym i 86.4% w trybie kilku strzałów, przewyższając stan techniki (68%) o 18%.

- Artykuły prasowe generowane przez model GPT-175 o parametrach 3B są trudne do odróżnienia od prawdziwych, według ludzkich ocen (z dokładnością niewiele przekraczającą poziom szansy na poziomie ~ 52%).

- Pomimo niezwykłej wydajności GPT-3 otrzymał mieszane recenzje od społeczności AI:

- „Hype na GPT-3 to zdecydowanie za dużo. Robi wrażenie (dzięki za miłe komplementy!), Ale wciąż ma poważne słabości i czasami popełnia bardzo głupie błędy. Sztuczna inteligencja zmieni świat, ale GPT-3 to tylko bardzo wczesny rzut oka. Mamy jeszcze wiele do rozwiązania ”. - Sam Altman, CEO i współzałożyciel OpenAI.

- „Jestem zszokowany, jak trudno jest wygenerować tekst o muzułmanach z GPT-3, który nie ma nic wspólnego z przemocą… lub śmiercią…” - Abubakar Abid, dyrektor generalny i założyciel Gradio.

- "Nie. GPT-3 zasadniczo nie rozumie świata, o którym mówi. Dalsze powiększanie korpusu pozwoli na wygenerowanie bardziej wiarygodnego pastiszu, ale nie naprawi jego fundamentalnego braku zrozumienia świata. Demonstracje GPT-4 nadal będą wymagały wybierania przez ludzi ”. - Gary Marcus, dyrektor generalny i założyciel Robust.ai.

- „Ekstrapolacja spektakularnej wydajności GPT3 na przyszłość sugeruje, że odpowiedź na życie, wszechświat i wszystko to zaledwie 4.398 biliona parametrów”. - Geoffrey Hinton, zdobywca nagrody Turinga.

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

- Sam kod nie jest dostępny, ale niektóre statystyki zbioru danych wraz z bezwarunkowymi, niefiltrowanymi próbkami tokenów 2048 z GPT-3 są publikowane w GitHub.

2. LaMDA od Google

Podsumowanie

Lajęzyk Mzapachy dla Ddialog Aaplikacje (MDA) powstały w procesie dostrajania grupy neuronowych modeli językowych opartych na Transformer, które są specjalnie zaprojektowane do dialogów. Modele te mają maksymalnie 137B parametrów i zostały przeszkolone w zakresie korzystania z zewnętrznych źródeł wiedzy. Deweloperzy LaMDA mieli na uwadze trzy kluczowe cele – jakość, bezpieczeństwo i uziemienie. Wyniki pokazały, że precyzyjne dostrojenie umożliwia zmniejszenie luki jakościowej do poziomu ludzkiego, ale wydajność modelu pozostawała poniżej poziomu ludzkiego pod względem bezpieczeństwa i uziemienia.

Bard Google'a, wydany ostatnio jako alternatywa dla ChatGPT, jest zasilany przez LaMDA. Pomimo tego, że Bard jest często określany jako nudny, można to postrzegać jako dowód zaangażowania Google w priorytetowe traktowanie bezpieczeństwa, nawet pośród intensywnej rywalizacji między Google i Microsoft o ustanowienie dominacji w dziedzinie generatywnej sztucznej inteligencji.

Jaki jest cel?

- Zbudowanie modelu dla aplikacji dialogowych w domenie otwartej, w których agent dialogu jest w stanie rozmawiać na dowolny temat z odpowiedziami rozsądnymi, specyficznymi dla kontekstu, opartymi na wiarygodnych źródłach i etycznymi.

Jak podchodzi się do problemu?

- LaMDA jest zbudowany na Transformator, architektura sieci neuronowej wymyślona przez Google Research i udostępniona jako open source w 2017 roku.

- Podobnie jak inne duże modele językowe, w tym BERT i GPT-3, LaMDA jest szkolony na terabajtach danych tekstowych, aby dowiedzieć się, w jaki sposób słowa odnoszą się do siebie, a następnie przewidzieć, jakie słowa prawdopodobnie pojawią się w następnej kolejności.

- Jednak w przeciwieństwie do większości modeli językowych, LaMDA został przeszkolony w zakresie dialogu, aby wychwycić niuanse, które odróżniają rozmowę otwartą od innych form języka.

- Model jest również dopracowany w celu poprawy wrażliwości, bezpieczeństwa i specyficzności jego odpowiedzi. Chociaż wyrażenia takie jak „to miłe” i „nie wiem” mogą mieć znaczenie w wielu scenariuszach dialogowych, prawdopodobnie nie doprowadzą do interesujących i wciągających rozmów.

- Generator LaMDA najpierw generuje kilka odpowiedzi kandydatów, z których wszystkie są oceniane na podstawie tego, jak bezpieczne, rozsądne, konkretne i interesujące są. Odpowiedzi z niskimi wynikami bezpieczeństwa są odfiltrowywane, a następnie jako odpowiedź wybierany jest wynik najwyżej oceniony.

Jakie są rezultaty?

- Liczne eksperymenty pokazują, że LaMDA może uczestniczyć w angażujących otwartych rozmowach na różne tematy.

- Seria ocen jakościowych potwierdziła, że odpowiedzi modelu wydają się być sensowne, konkretne, interesujące i oparte na wiarygodnych źródłach zewnętrznych, ale wciąż istnieje pole do poprawy.

- Pomimo wszystkich dotychczasowych postępów, autorzy uznają, że model nadal ma wiele ograniczeń, które mogą skutkować generowaniem niewłaściwych lub nawet szkodliwych odpowiedzi.

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

- Implementacja PyTorch typu open source dla architektury przedtreningowej LaMDA jest dostępna na GitHub.

3. PaLM od Google

Podsumowanie

Patak LAnguage Model (Palma) to parametr o wartości 540 miliardów, model językowy oparty na transformatorach. PaLM został przeszkolony na chipach 6144 TPU v4 przy użyciu Pathways, nowego systemu ML do wydajnego szkolenia w wielu kapsułach TPU. Model demonstruje korzyści płynące ze skalowania uczenia się w kilku krokach, osiągając najnowocześniejsze wyniki w setkach testów rozumienia języka i generowania. PaLM przewyższa precyzyjnie dostrojone najnowocześniejsze modele w wieloetapowych zadaniach rozumowania i przekracza średnią wydajność człowieka w teście porównawczym BIG-bench.

Jaki jest cel?

- Aby lepiej zrozumieć, w jaki sposób skalowanie dużych modeli językowych wpływa na uczenie się w kilku strzałach.

Jak podchodzi się do problemu?

- Kluczową ideą jest skalowanie szkolenia modelu języka o parametrach 540 miliardów za pomocą systemu Pathways:

- Zespół używał równoległości danych na poziomie podów w dwóch podach Cloud TPU v4, podczas gdy w każdym pode używał standardowego równoległości danych i modeli.

- Udało im się skalować szkolenie do 6144 chipów TPU v4, największej konfiguracji systemu opartej na TPU używanej do tej pory do szkolenia.

- Model osiągnął efektywność uczenia na poziomie 57.8% wykorzystania sprzętowych FLOP, co, jak twierdzą autorzy, jest najwyższą dotychczas osiągniętą efektywnością uczenia dla dużych modeli językowych na tę skalę.

- Dane szkoleniowe dla modelu PaLM obejmowały kombinację angielskich i wielojęzycznych zestawów danych zawierających wysokiej jakości dokumenty internetowe, książki, Wikipedię, konwersacje i kod GitHub.

Jakie są rezultaty?

- Liczne eksperymenty pokazują, że wydajność modelu gwałtownie wzrosła wraz ze skalowaniem zespołu do największego modelu.

- PaLM 540B osiągnął przełomową wydajność w wielu bardzo trudnych zadaniach:

- Rozumienie języka i generowanie. Wprowadzony model przewyższył kilkuetapową wydajność wcześniejszych dużych modeli w 28 z 29 zadań, które obejmują zadania polegające na odpowiadaniu na pytania, zadania polegające na zamykaniu zdań i uzupełnianiu zdań, zadania czytania ze zrozumieniem w kontekście, zadania rozumowania zdroworozsądkowego, zadania SuperGLUE i więcej. Wydajność PaLM w zadaniach BIG-bench pokazała, że potrafi rozróżnić przyczynę i skutek, a także zrozumieć kombinacje pojęciowe w odpowiednich kontekstach.

- Rozumowanie. Dzięki podpowiedziom 8-strzałowym PaLM rozwiązuje 58% problemów w GSM8K, wzorzec tysięcy trudnych pytań matematycznych na poziomie szkoły podstawowej, przewyższając poprzedni najwyższy wynik 55% osiągnięty przez dostrojenie modelu GPT-3 175B. PaLM demonstruje również zdolność do generowania wyraźnych wyjaśnień w sytuacjach, które wymagają złożonej kombinacji wieloetapowego wnioskowania logicznego, wiedzy o świecie i głębokiego zrozumienia języka.

- Generowanie kodu. PaLM działa na równi z dopracowanym Codexem 12B, zużywając 50 razy mniej kodu Pythona do szkolenia, co potwierdza, że duże modele językowe skuteczniej przenoszą naukę zarówno z innych języków programowania, jak i danych z języka naturalnego.

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

- Nieoficjalna implementacja PyTorch określonej architektury Transformer z artykułu badawczego PaLM jest dostępna na GitHub. Nie będzie się skalować i jest publikowany wyłącznie w celach edukacyjnych.

4. Flaming firmy DeepMind

Podsumowanie

Flamingo to najnowocześniejsza rodzina modeli języka wizualnego (VLM), wyszkolonych na wielkoskalowych multimodalnych korpusach internetowych z mieszanym tekstem i obrazami. Dzięki temu szkoleniu modele mogą dostosowywać się do nowych zadań przy użyciu minimalnych przykładów z adnotacjami, dostarczanych jako monit. Flamingo zawiera kluczowe ulepszenia architektoniczne zaprojektowane w celu połączenia mocnych stron wstępnie wyszkolonych modeli tylko wizyjnych i tylko językowych, przetwarzania sekwencji zmiennie przeplatanych danych wizualnych i tekstowych oraz bezproblemowego przyjmowania obrazów lub filmów jako danych wejściowych. Modele wykazują imponującą zdolność adaptacji do szeregu zadań związanych z obrazami i wideo, takich jak odpowiadanie na pytania wizualne, zadania z napisami i wizualne odpowiadanie na pytania wielokrotnego wyboru, ustanawiając nowe standardy wydajności za pomocą monitów specyficznych dla zadania w nauce kilku ujęć.

Jaki jest cel?

- Aby poczynić postępy w kierunku umożliwienia modelom multimodalnym szybkiego uczenia się i wykonywania nowych zadań w oparciu o krótkie instrukcje:

- Powszechnie stosowany paradygmat wstępnego uczenia modelu na dużej ilości nadzorowanych danych, a następnie dostrajania go do konkretnego zadania, wymaga dużych zasobów i tysięcy punktów danych z adnotacjami oraz starannego dostrajania hiperparametrów dla poszczególnych zadań.

- Obecne modele, które wykorzystują kontrastowy cel, pozwalają na zerową adaptację do nowych zadań, ale nie radzą sobie z bardziej otwartymi zadaniami, takimi jak napisy lub wizualne odpowiadanie na pytania, ponieważ brakuje im możliwości generowania języka.

- Badania te mają na celu wprowadzenie nowego modelu, który skutecznie rozwiązuje te problemy i wykazuje doskonałą wydajność w systemach o małej ilości danych.

Jak podchodzi się do problemu?

- Firma DeepMind wprowadziła Flamingo, VLM przeznaczone do szybkiego uczenia się różnych otwartych zadań wzrokowych i językowych, wykorzystując tylko kilka przykładów wejścia/wyjścia.

- Modele Flamingo to uwarunkowane wizualnie autoregresyjne modele generowania tekstu, które mogą przetwarzać tokeny tekstowe zmieszane z obrazami i/lub filmami oraz generować tekst jako dane wyjściowe.

- Architektura Flamingo obejmuje dwa uzupełniające się, wstępnie wytrenowane i zamrożone modele:

- Model wizyjny zdolny do „postrzegania” scen wizualnych.

- Duży model językowy, którego zadaniem jest przeprowadzanie podstawowego rozumowania.

- Komponenty nowej architektury integrują te modele w sposób, który zachowuje wiedzę zdobytą podczas intensywnego obliczeniowo wstępnego szkolenia.

- Ponadto modele Flamingo mają architekturę opartą na Perceiver, umożliwiając im przetwarzanie obrazów lub filmów w wysokiej rozdzielczości. Ta architektura może generować stałą liczbę tokenów wizualnych na obraz/wideo z szerokiego i zmiennego zestawu wizualnych funkcji wejściowych.

Jakie są rezultaty?

- Badania pokazują, że podobnie jak LLM, które są dobrymi uczniami, VLM mogą uczyć się na kilku przykładach wejścia/wyjścia dla zadań związanych ze zrozumieniem obrazów i wideo, takich jak klasyfikacja, napisy lub odpowiadanie na pytania.

- Flamingo ustanawia nowy punkt odniesienia w nauce kilku strzałów, wykazując doskonałą wydajność w szerokim zakresie 16 multimodalnych zadań rozumienia języka i obrazu/wideo.

- W przypadku 6 z tych 16 zadań Flamingo przewyższa wydajność najnowocześniejszych, nawet jeśli wykorzystuje tylko 32 przykłady konkretnych zadań – około 1000 razy mniej danych treningowych dotyczących konkretnych zadań niż obecne modele o najwyższej wydajności.

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

- DeepMind nie udostępnił oficjalnej implementacji Flamingo.

- Możesz znaleźć implementację open source wprowadzonego podejścia w Repozytorium OpenFlamingo Github.

- Dostępna jest alternatywna implementacja PyTorch tutaj.

5. BLIP-2 firmy Salesforce

Podsumowanie

BLIP-2 to wydajna i ogólna struktura przedtreningowa dla modeli wzrokowo-językowych, zaprojektowana w celu obejścia coraz bardziej zaporowych kosztów wielkoskalowych modeli przedtreningowych. BLIP-2 wykorzystuje gotowe, zamrożone, wstępnie wytrenowane kodery obrazu i zamrożone duże modele językowe do początkowego wstępnego szkolenia języka wizyjnego, zawierającego lekki transformator zapytań, wstępnie wyszkolony w dwóch etapach. Pierwszy etap inicjuje uczenie się reprezentacji języka wizyjnego z zamrożonego kodera obrazu, a drugi etap napędza generatywne uczenie się języka wizyjnego z zamrożonego modelu językowego. Pomimo znacznie mniejszej liczby parametrów, które można trenować, BLIP-2 przewyższa najnowocześniejsze metody, przewyższając Flamingo80B firmy DeepMind o 8.7% w przypadku VQAv2 bez strzału z 54 razy mniejszą liczbą parametrów, które można trenować. Model wykazuje również obiecujące możliwości generowania obrazu na tekst w trybie zero-shot zgodnie z instrukcjami języka naturalnego.

Jaki jest cel?

- Aby uzyskać najnowocześniejszą wydajność zadań związanych z językiem wizyjnym, przy jednoczesnym obniżeniu kosztów obliczeniowych.

Jak podchodzi się do problemu?

- Zespół Salesforce wprowadził nową strukturę przedtreningową języka wizyjnego, nazwaną BLIP-2, Bzawijanie Ljęzyk-Imag Pprzekwalifikowanie z zamrożonymi modelami unimodalnymi:

- Wstępnie wytrenowane modele unimodalne pozostają zamrożone podczas wstępnego uczenia, aby zmniejszyć koszty obliczeń i uniknąć problemu katastrofalnego zapominania.

- Aby ułatwić dopasowanie międzymodalne i wypełnić lukę modalną między wstępnie wytrenowanymi modelami wizyjnymi a wstępnie wytrenowanymi modelami językowymi, zespół proponuje lekki transformator zapytań (Q-Former), który działa jako wąskie gardło informacyjne między zamrożonym koderem obrazu a zamrożonym LLM.

- Q-former jest wstępnie przeszkolony w zakresie nowej dwuetapowej strategii:

- Pierwszy etap przedtreningowy polega na uczeniu się reprezentacji języka wizyjnego. Zmusza to Q-Former do nauczenia się reprezentacji wizualnej najbardziej odpowiedniej dla tekstu.

- Drugi etap szkolenia wstępnego polega na generatywnym uczeniu się od wizji do języka poprzez połączenie danych wyjściowych Q-Former z zamrożonym LLM. Q-Former jest szkolony w taki sposób, że jego wizualna reprezentacja wyjściowa może być interpretowana przez LLM.

Jakie są rezultaty?

- BLIP-2 zapewnia wyjątkowe, najnowocześniejsze wyniki w różnych zadaniach wizualno-językowych, obejmujących wizualne odpowiadanie na pytania, podpisy obrazów i wyszukiwanie tekstu obrazów.

- Na przykład przewyższa Flamingo o 8.7% w przypadku VQAv2 bez strzału.

- Co więcej, ta wyjątkowa wydajność została osiągnięta przy znacznie wyższej wydajności komputera:

- BLIP-2 przewyższa Flamingo-80B przy użyciu 54 razy mniej parametrów, które można trenować.

- BLIP-2 ma zdolność generowania obrazu na tekst w trybie zero-shot w odpowiedzi na instrukcje języka naturalnego, torując w ten sposób drogę do rozwijania umiejętności, takich jak między innymi rozumowanie wiedzy wizualnej i rozmowa wizualna.

- Na koniec należy zauważyć, że BLIP-2 to wszechstronne podejście, które może wykorzystać bardziej wyrafinowane modele jednomodalne w celu dalszego zwiększenia wydajności wstępnego szkolenia wizualno-językowego.

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

Oficjalna implementacja BLIP-2 jest dostępna na GitHub.

6. LLaMA autorstwa Meta AI

Podsumowanie

Zespół Meta AI twierdzi, że mniejsze modele przeszkolone na większej liczbie tokenów są łatwiejsze do przekwalifikowania i dostrojenia pod kątem określonych zastosowań produktu. Dlatego wprowadzają Lama (LArge Lajęzyk Model Meta AI), zbiór podstawowych modeli językowych z parametrami od 7B do 65B. LLaMA 33B i 65B zostały wyszkolone na 1.4 biliona tokenów, podczas gdy najmniejszy model, LLaMA 7B, został wyszkolony na jednym bilionie tokenów. Korzystali wyłącznie z publicznie dostępnych zbiorów danych, nie polegając na danych zastrzeżonych lub zastrzeżonych. Zespół wdrożył również kluczowe ulepszenia architektury i techniki optymalizacji szybkości szkolenia. W rezultacie LLaMA-13B przewyższał GPT-3, będąc ponad 10 razy mniejszy, a LLaMA-65B wykazywał konkurencyjne wyniki z PaLM-540B.

Jaki jest cel?

- Aby zademonstrować wykonalność szkolenia modeli o najwyższej wydajności wyłącznie na publicznie dostępnych zestawach danych, bez polegania na zastrzeżonych lub zastrzeżonych źródłach danych.

- Zapewnienie społeczności badawczej mniejszych i bardziej wydajnych modeli, a tym samym umożliwienie tym, którzy nie mają dostępu do dużej ilości infrastruktury, badania dużych modeli językowych.

Jak podchodzi się do problemu?

- Aby wyszkolić model LLaMA, badacze wykorzystali wyłącznie dane, które są publicznie dostępne i zgodne z otwartym źródłem.

- Wprowadzili również kilka ulepszeń do standardowej architektury Transformera:

- Przyjmując metodologię GPT-3, stabilność treningu została zwiększona poprzez normalizację wejścia dla każdej podwarstwy transformatora, zamiast normalizacji wyjścia.

- Zainspirowani modelami PaLM, naukowcy zastąpili nieliniowość ReLU funkcją aktywacji SwiGLU, aby poprawić wydajność.

- Zainspirowany Su i wsp. (2021), wyeliminowali bezwzględne osadzenie pozycyjne i zamiast tego włączyli obrotowe osadzenie pozycyjne (RoPE) w każdej warstwie sieci.

- Wreszcie, zespół Meta AI poprawił szybkość uczenia swojego modelu poprzez:

- Korzystanie z efektywnej przyczynowej wielogłowej implementacji uwagi poprzez niezapisywanie wag uwagi lub obliczanie zamaskowanych wyników klucza/zapytania.

- Korzystanie z punktów kontrolnych w celu zminimalizowania przeliczonych aktywacji podczas podania wstecz.

- Nakładanie się obliczeń aktywacji i komunikacji między procesorami graficznymi w sieci (ze względu na operacje all_reduce).

Jakie są rezultaty?

- LLaMA-13B przewyższa GPT-3, mimo że jest ponad 10 razy mniejszy, podczas gdy LLaMA-65B dorównuje PaLM-540B.

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

- Meta AI zapewnia dostęp do LLaMA naukowcom akademickim, osobom związanym z rządem, społeczeństwem obywatelskim, instytucjami akademickimi i globalnymi laboratoriami badawczymi przemysłu na podstawie indywidualnej oceny przypadku. Aby złożyć wniosek, przejdź do poniższych Repozytorium GitHub.

7. GPT-4 firmy OpenAI

Podsumowanie

GPT-4 jest multimodalnym modelem na dużą skalę, który akceptuje dane wejściowe w postaci obrazu i tekstu oraz generuje dane wyjściowe w postaci tekstu. Ze względów związanych z konkurencją i bezpieczeństwem szczegółowe informacje na temat architektury modelu i szkolenia są ukrywane. Pod względem wydajności GPT-4 przewyższa poprzednie modele językowe w tradycyjnych testach porównawczych i wykazuje znaczną poprawę zrozumienia intencji użytkownika i właściwości bezpieczeństwa. Model osiąga również wydajność na poziomie człowieka w różnych egzaminach, w tym najwyższy wynik 10% w symulowanym jednolitym egzaminie adwokackim.

Jaki jest cel?

- Opracowanie multimodalnego modelu na dużą skalę, który może akceptować dane wejściowe obrazu i tekstu oraz generować dane wyjściowe w postaci tekstu.

- Aby opracować infrastrukturę i metody optymalizacji, które zachowują się przewidywalnie w szerokim zakresie skal.

Jak podchodzi się do problemu?

- Ze względu na konkurencyjny krajobraz i wpływ na bezpieczeństwo OpenAI zdecydowało się nie ujawniać szczegółów dotyczących architektury, rozmiaru modelu, sprzętu, obliczeń szkoleniowych, konstrukcji zestawu danych i metod szkoleniowych.

- Ujawniają, że:

- GPT-4 to model oparty na transformatorze, wstępnie przeszkolony do przewidywania następnego tokena w dokumencie.

- Wykorzystuje publicznie dostępne dane i licencjonowane dane stron trzecich.

- Model został dopracowany przy użyciu uczenia się ze wzmocnieniem na podstawie informacji zwrotnych od ludzi (RLHF).

- Niepotwierdzone informacje sugerują, że GPT-4 nie jest pojedynczym gęstym modelem, jak jego poprzednicy, ale potężną koalicją ośmiu oddzielnych modeli, z których każdy ma oszałamiającą liczbę 220 miliardów parametrów.

Jakie są rezultaty?

- GPT-4 osiąga wydajność na poziomie człowieka na większości egzaminów zawodowych i akademickich, w szczególności uzyskując wynik w 10% najlepszych na symulowanym jednolitym egzaminie adwokackim.

- Wstępnie wytrenowany podstawowy model GPT-4 przewyższa istniejące modele językowe i wcześniejsze najnowocześniejsze systemy w tradycyjnych testach porównawczych NLP, bez tworzenia specyficznych testów porównawczych lub dodatkowych protokołów szkoleniowych.

- GPT-4 wykazuje znaczną poprawę w podążaniu za intencjami użytkownika, a jego odpowiedzi są preferowane w stosunku do odpowiedzi GPT-3.5 w 70.2% z 5,214 monitów z ChatGPT i OpenAI API.

- Właściwości bezpieczeństwa GPT-4 znacznie się poprawiły w porównaniu z GPT-3.5, z 82% spadkiem odpowiedzi na prośby o niedozwolone treści i 29% wzrostem zgodności z zasadami dotyczącymi wrażliwych próśb (np. porad medycznych i samookaleczeń).

Gdzie można dowiedzieć się więcej o tym badaniu?

Gdzie można uzyskać kod implementacyjny?

- Implementacja kodu GPT-4 nie jest dostępna.

Zastosowania w świecie rzeczywistym dużych (wizyjnych) modeli językowych

Najbardziej znaczące przełomy w badaniach nad sztuczną inteligencją ostatnich lat pochodzą z dużych modeli sztucznej inteligencji wyszkolonych na ogromnych zbiorach danych. Modele te wykazują imponującą wydajność i fascynujące jest myślenie o tym, jak sztuczna inteligencja może zrewolucjonizować całe branże, takie jak obsługa klienta, marketing, handel elektroniczny, opieka zdrowotna, tworzenie oprogramowania, dziennikarstwo i wiele innych.

Duże modele językowe mają wiele zastosowań w świecie rzeczywistym. GPT-4 zawiera następujące informacje:

- Rozumienie i generowanie języka naturalnego dla chatbotów i wirtualnych asystentów.

- Tłumaczenie maszynowe między językami.

- Streszczenia artykułów, raportów lub innych dokumentów tekstowych.

- Analiza sentymentu do badań rynkowych lub monitoringu mediów społecznościowych.

- Generowanie treści na potrzeby marketingu, mediów społecznościowych lub kreatywnego pisania.

- Systemy odpowiedzi na pytania do obsługi klienta lub baz wiedzy.

- Klasyfikacja tekstu do filtrowania spamu, kategoryzacji tematów lub organizacji dokumentów.

- Spersonalizowane narzędzia do nauki i korepetycji językowych.

- Generowanie kodu i pomoc w rozwoju oprogramowania.

- Analiza i pomoc w zakresie dokumentacji medycznej, prawnej i technicznej.

- Narzędzia ułatwień dostępu dla osób niepełnosprawnych, takie jak zamiana tekstu na mowę i konwersję mowy na tekst.

- Usługi rozpoznawania i transkrypcji mowy.

Jeśli dodamy część wizualną, obszary możliwych zastosowań rozszerzą się jeszcze bardziej:

Śledzenie najnowszych przełomów w dziedzinie sztucznej inteligencji i myślenie o ich potencjalnych zastosowaniach w świecie rzeczywistym jest bardzo ekscytujące. Jednak przed wdrożeniem tych modeli w prawdziwym życiu musimy zająć się odpowiednimi zagrożeniami i ograniczeniami, które niestety są dość znaczące.

Ryzyka i ograniczenia

Jeśli zapytasz GPT-4 o związane z nim ryzyko i ograniczenia, prawdopodobnie dostarczy Ci długą listę istotnych obaw. Po przefiltrowaniu tej listy i dodaniu kilku dodatkowych uwag doszedłem do następującego zestawu kluczowych zagrożeń i ograniczeń posiadanych przez nowoczesne duże modele językowe:

- Uprzedzenia i dyskryminacja: modele te uczą się na podstawie ogromnych ilości danych tekstowych, które często zawierają uprzedzenia i treści dyskryminujące. W rezultacie generowane dane wyjściowe mogą nieumyślnie utrwalać stereotypy, obraźliwy język i dyskryminację ze względu na takie czynniki, jak płeć, rasa lub religia.

- Mylna informacja: duże modele językowe mogą generować treści, które są niezgodne ze stanem faktycznym, wprowadzają w błąd lub są nieaktualne. Chociaż modele są szkolone na różnych źródłach, nie zawsze mogą dostarczać najdokładniejszych lub aktualnych informacji. Często dzieje się tak, ponieważ model priorytetowo traktuje generowanie danych wyjściowych, które są poprawne gramatycznie lub wydają się spójne, nawet jeśli wprowadzają w błąd.

- Brak zrozumienia: Chociaż wydaje się, że te modele rozumieją ludzki język, działają one głównie poprzez identyfikację wzorców i powiązań statystycznych w danych treningowych. Nie mają głębokiego zrozumienia generowanych przez siebie treści, co czasami może skutkować bezsensownymi lub nieistotnymi wynikami.

- Niewłaściwa zawartość: modele językowe mogą czasami generować treści, które są obraźliwe, szkodliwe lub nieodpowiednie. Chociaż podejmowane są wysiłki w celu zminimalizowania takich treści, mogą one nadal wystąpić ze względu na charakter danych szkoleniowych i niezdolność modeli do rozpoznania kontekstu lub intencji użytkownika.

Wnioski

Duże modele językowe niewątpliwie zrewolucjonizowały dziedzinę przetwarzania języka naturalnego i wykazały ogromny potencjał w zwiększaniu produktywności w różnych rolach i branżach. Ich zdolność do generowania tekstu podobnego do ludzkiego, automatyzacji przyziemnych zadań oraz zapewniania pomocy w procesach twórczych i analitycznych uczyniła z nich niezastąpione narzędzia w dzisiejszym szybkim, napędzanym technologią świecie.

Jednak kluczowe znaczenie ma uznanie i zrozumienie ograniczeń i zagrożeń związanych z tymi potężnymi modelami. Kwestie takie jak stronniczość, dezinformacja i możliwość złośliwego wykorzystania nie mogą być ignorowane. Ponieważ nadal integrujemy te technologie oparte na sztucznej inteligencji w naszym codziennym życiu, konieczne jest znalezienie równowagi między wykorzystaniem ich możliwości a zapewnieniem nadzoru człowieka, szczególnie w sytuacjach wrażliwych i wysokiego ryzyka.

Jeśli uda nam się odpowiedzialnie wdrożyć generatywne technologie sztucznej inteligencji, utorujemy drogę do przyszłości, w której sztuczna inteligencja i ludzka wiedza będą współpracować, aby napędzać innowacje i tworzyć lepszy świat dla wszystkich.

Podoba ci się ten artykuł? Zarejestruj się, aby otrzymywać więcej aktualizacji badań AI.

Damy Ci znać, gdy wydamy więcej artykułów podsumowujących takich jak ten.

Związane z

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- zdolność

- Zdolny

- O nas

- powyżej

- bezwzględny

- akademicki

- Akceptuj

- Akceptuje

- dostęp

- dostępny

- pomieścić

- Stosownie

- precyzja

- dokładny

- osiągnięty

- Osiąga

- osiągnięcia

- uznać

- w poprzek

- Aktywacja

- aktywacje

- Dzieje Apostolskie

- przystosować

- adaptacja

- Dodaj

- dodanie

- dodatek

- Dodatkowy

- adres

- Adresy

- Przyjęcie

- postępy

- Rada

- Po

- przed

- Agent

- AI

- ai badania

- Cele

- AL

- zarówno

- Wszystkie kategorie

- dopuszczać

- Pozwalać

- pozwala

- wzdłuż

- również

- alternatywny

- Chociaż

- zawsze

- wśród

- wśród

- ilość

- kwoty

- an

- analiza

- Analityczny

- i

- Inne

- odpowiedź

- każdy

- api

- zjawić się

- aplikacje

- Aplikuj

- podejście

- właściwy

- w przybliżeniu

- architektoniczny

- architektura

- SĄ

- obszary

- na około

- Szyk

- Sztuka

- artykuł

- towary

- sztuczny

- sztuczna inteligencja

- AS

- Wsparcie

- asystenci

- powiązany

- stowarzyszenia

- At

- Uwaga

- Autorzy

- zautomatyzować

- dostępny

- średni

- uniknąć

- nagroda

- Bilans

- bar

- baza

- na podstawie

- podstawowy

- podstawa

- BE

- bo

- stają się

- zanim

- jest

- poniżej

- Benchmark

- Benchmarki

- Korzyści

- Ulepsz Swój

- pomiędzy

- stronniczość

- uprzedzenia

- Miliard

- Książki

- Bootstrap

- obie

- Granice

- przełom

- przełomy

- BRIDGE

- szeroki

- budować

- Budowanie

- wybudowany

- ale

- by

- nazywa

- CAN

- kandydat

- nie może

- możliwości

- zdolny

- Pojemność

- ostrożny

- walizka

- katastrofalny

- Spowodować

- ceo

- CEO i założyciel

- wyzwanie

- szansa

- zmiana

- nasze chatboty

- ChatGPT

- Frytki

- roszczenie

- klasyfikacja

- Chmura

- Współzałożyciel

- kod

- ZGODNY

- kolekcja

- połączenie

- kombinacje

- jak

- zobowiązanie

- Komunikacja

- społeczność

- w porównaniu

- zgodny

- konkurencyjny

- uzupełniający

- kompleks

- spełnienie

- składniki

- obliczenia

- obliczać

- komputer

- computing

- koncepcyjnego

- Obawy

- systemu

- ZATWARDZIAŁY

- Podłączanie

- w konsekwencji

- Rozważania

- Budowa

- zawartość

- kontekst

- konteksty

- kontynuować

- kontrast

- Rozmowa

- rozmowy

- Konwersja

- skorygowania

- Odpowiedni

- Koszty:

- Koszty:

- mógłby

- Stwórz

- stworzony

- Twórczy

- wiarygodny

- istotny

- Aktualny

- klient

- Obsługa klienta

- Obsługa klienta

- pionierski nowatorski

- codziennie

- dane

- punkty danych

- zbiory danych

- Data

- postanowiła

- spadek

- głęboko

- DeepMind

- dostarcza

- wykazać

- wykazać

- demonstruje

- demonstrowanie

- Demos

- W zależności

- wdrażanie

- zaprojektowany

- Mimo

- detale

- rozwijać

- deweloperzy

- rozwijanie

- oprogramowania

- Dialog

- Dialog

- trudny

- niepełnosprawnych

- Ujawniać

- dyskryminacja

- rozróżniać

- inny

- do

- dokument

- dokumenty

- robi

- Przewaga

- nie

- tuzin

- napęd

- dubbingowane

- z powodu

- podczas

- e

- e-commerce

- E i T

- każdy

- Wcześnie

- łatwiej

- edukacyjny

- efekt

- faktycznie

- efektywność

- wydajny

- starania

- wyłączony

- wyłonił

- umożliwiać

- umożliwiając

- obejmujący

- ujmujący

- Angielski

- wzmacniać

- wzmocnione

- ulepszenia

- wzmocnienie

- zapewnienie

- niezbędny

- zapewniają

- ustanawia

- etyczny

- oceniane

- ewaluację

- oceny

- Parzyste

- Każdy

- wszystko

- dowód

- ewoluuje

- badanie

- przykład

- przykłady

- przekracza

- wyjątkowy

- ekscytujący

- wyłącznie

- eksponaty

- Przede wszystkim system został opracowany

- Rozszerzać

- eksperymenty

- ekspertyza

- Exploring

- zewnętrzny

- f1

- ułatwiać

- Czynniki

- Spadać

- członków Twojej rodziny

- daleko

- fascynujący

- w szybkim tempie

- Cecha

- polecane

- Korzyści

- informacja zwrotna

- kilka

- mniej

- pole

- Postać

- filtracja

- Znajdź

- i terminów, a

- Fix

- ustalony

- obserwuj

- następujący

- W razie zamówieenia projektu

- formularze

- Fundamenty

- założyciel

- Framework

- od

- zamrożone

- funkcjonować

- fundamentalny

- zasadniczo

- dalej

- przyszłość

- zdobyte

- szczelina

- Płeć

- Generować

- wygenerowane

- generuje

- generujący

- generacja

- generatywny

- generatywna sztuczna inteligencja

- generator

- otrzymać

- GitHub

- Dojrzeć

- Globalne

- Go

- cel

- będzie

- dobry

- Google'a

- Rząd

- GPU

- stopień

- przełomowy

- Zarządzanie

- miał

- dzieje

- Ciężko

- sprzęt komputerowy

- szkodliwy

- Have

- mający

- opieki zdrowotnej

- tutaj

- wysokiej jakości

- wysoka rozdzielczość

- wysokie ryzyko

- wyższy

- Najwyższa

- posiada

- W jaki sposób

- Jednak

- HTML

- HTTPS

- olbrzymi

- człowiek

- Setki

- Szum

- Dostrajanie hiperparametrów

- pomysł

- identyfikacja

- if

- obraz

- zdjęcia

- ogromny

- realizacja

- realizowane

- implikacje

- ważny

- imponujący

- podnieść

- ulepszony

- poprawa

- ulepszenia

- in

- informacje

- niemożność

- zawierać

- włączony

- Włącznie z

- Rejestrowy

- zawiera

- włączenie

- Zwiększać

- wzrosła

- wzrastający

- coraz bardziej

- indywidualny

- osób

- przemysłowa

- przemysł

- Informacja

- Infrastruktura

- Inicjuje

- Innowacja

- wkład

- Wejścia

- zamiast

- instytucje

- instrukcje

- integrować

- Inteligencja

- zamiar

- ciekawy

- najnowszych

- przedstawiać

- wprowadzono

- Zmyślony

- problem

- problemy

- IT

- JEGO

- samo

- dziennikarstwo

- jpg

- właśnie

- Klawisz

- kluczowe cele

- Wiedzieć

- wiedza

- Labs

- Brak

- krajobraz

- język

- Języki

- duży

- na dużą skalę

- największym

- firmy

- warstwa

- nioski

- prowadzić

- UCZYĆ SIĘ

- nauka

- Regulamin

- mniej

- poziom

- poziomy

- Dźwignia

- wykorzystuje

- lewarowanie

- Upoważniony

- życie

- lekki

- lubić

- Prawdopodobnie

- Ograniczenia

- Lista

- wykazy

- Zyje

- Lama

- lokalnie

- logiczny

- długo

- Popatrz

- Partia

- niski

- maszyny

- zrobiony

- robić

- WYKONUJE

- wiele

- Marcus

- rynek

- badania rynku

- Marketing

- materiał

- matematyka

- Maksymalna szerokość

- maksymalny

- Może..

- wymowny

- Media

- medyczny

- Łączyć

- Meta

- Metodologia

- metody

- Microsoft

- nic

- minimalny

- Mylna informacja

- zwodniczy

- błędy

- mieszany

- ML

- model

- modele

- Nowoczesne technologie

- zmodyfikowano

- monitorowanie

- jeszcze

- większość

- dużo

- wielokrotność

- muzułmanie

- Naturalny

- Język naturalny

- Przetwarzanie języka naturalnego

- Natura

- Potrzebować

- potrzebne

- sieć

- Nerwowy

- Język neuronowy

- sieci neuronowe

- Nowości

- aktualności

- Następny

- miło

- nlp

- szczególnie

- nic

- numer

- liczny

- cel

- Cele

- występować

- of

- obraźliwy

- urzędnik

- często

- on

- ONE

- te

- tylko

- koncepcja

- open source

- OpenAI

- działać

- operacje

- optymalizacja

- or

- organizacja

- Inne

- Pozostałe

- ludzkiej,

- na zewnątrz

- lepsze wyniki

- Przewyższa

- wydajność

- wybitny

- koniec

- własny

- palma

- Papier

- paradygmat

- parametr

- parametry

- część

- uczestniczyć

- szczególnie

- przechodzić

- wzory

- wybrukować

- Chodnik

- dla

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywania

- wykonuje

- Zwroty

- wybierać

- plato

- Analiza danych Platona

- PlatoDane

- pods

- punkt

- zwrotnica

- polityka

- możliwy

- potencjał

- powered

- mocny

- przewidzieć

- Korzystny

- poprzedni

- głównie

- Wcześniejszy

- ustalanie priorytetów

- Problem

- problemy

- wygląda tak

- procesów

- przetwarzanie

- produkować

- Produkt

- wydajność

- profesjonalny

- Programowanie

- języki programowania

- Postęp

- obiecujący

- niska zabudowa

- proponuje

- własność

- protokoły

- zapewniać

- pod warunkiem,

- zapewnia

- publicznie

- opublikowany

- cele

- Popychanie

- Python

- płomień

- jakościowy

- jakość

- pytanie

- pytania

- szybko

- Wyścig

- zasięg

- szybko

- raczej

- Czytający

- real

- prawdziwe życie

- Prawdziwy świat

- niedawny

- niedawno

- uznanie

- rozpoznać

- zmniejszyć

- redukcja

- reżimy

- uczenie się wzmacniania

- zwolnić

- wydany

- rzetelny

- zaufane źródła

- religia

- opierając się

- pozostawać

- pozostał

- znakomity

- otrzymuje

- Raporty

- reprezentacja

- wywołań

- wymagać

- Wymaga

- Badania naukowe

- Społeczność Badania

- Badacze

- zasobochłonne

- poszanowanie

- odpowiadanie

- odpowiedź

- Odpowiedzi

- ograniczony

- dalsze

- Efekt

- zachowuje

- Recenzje

- zrewolucjonizować

- zrewolucjonizował

- ryzyko

- rywalizacja

- krzepki

- role

- Pokój

- "bezpiecznym"

- Bezpieczeństwo

- sprzedawca

- taki sam

- Skala

- waga

- skalowaniem

- scenariusze

- Sceny

- Szkoła

- wynik

- wyniki

- punktacji

- płynnie

- druga

- wydać się

- widziany

- wybrany

- wrażliwy

- oddzielny

- Serie

- poważny

- usługa

- Usługi

- zestaw

- ustawienie

- kilka

- wstrząśnięty

- Short

- pokazać

- pokazał

- Targi

- znak

- znaczący

- znacznie

- Podobnie

- liczba pojedyncza

- sytuacje

- Rozmiar

- umiejętności

- mniejszy

- So

- dotychczas

- Obserwuj Nas

- Media społecznościowe

- Społeczeństwo

- Tworzenie

- rozwoju oprogramowania

- Wyłącznie

- rozwiązanie

- Rozwiązuje

- kilka

- wyrafinowany

- Źródło

- Źródła

- Sourcing

- spam

- specyficzny

- swoiście

- specyficzność

- spektakularny

- zamiana mowy na tekst

- prędkość

- Stabilność

- STAGE

- etapy

- standard

- standardy

- Stan

- state-of-the-art

- statystyczny

- statystyka

- Nadal

- Strategia

- silne strony

- strajk

- Badanie

- znaczny

- osiągnąć sukces

- taki

- sugerować

- Wskazuje

- PODSUMOWANIE

- przełożony

- nadzór

- wsparcie

- przewyższał

- system

- systemy

- Rozmowy

- Zadanie

- zadania

- zespół

- Techniczny

- Techniki

- Technologies

- REGULAMIN

- test

- generowanie tekstu

- Text-to-Speech

- niż

- dzięki

- że

- Połączenia

- Przyszłość

- Państwo

- świat

- ich

- Im

- następnie

- Tam.

- a tym samym

- w związku z tym

- Te

- one

- myśleć

- innych firm

- to

- tych

- chociaż?

- tysiące

- trzy

- Przez

- czasy

- do

- dzisiaj

- razem

- żeton

- tokenizacja

- Żetony

- także

- narzędzia

- Top

- TOPBOTY

- aktualny

- tematy

- w kierunku

- tradycyjny

- Pociąg

- przeszkolony

- Trening

- przenieść

- transformator

- transformatorowy

- Tłumaczenie

- Trylion

- Turinga

- Korepetycje

- drugiej

- bezwarunkowy

- dla

- zrozumieć

- zrozumienie

- podjąć

- niewątpliwie

- Niestety

- Wszechświat

- w odróżnieniu

- nowomodny

- Nowości

- posługiwać się

- używany

- Użytkownik

- zastosowania

- za pomocą

- wykorzystuje

- różnorodność

- różnorodny

- Naprawiono

- wszechstronny

- początku.

- Wideo

- Filmy

- Wirtualny

- wizja

- VOX

- była

- Droga..

- we

- sieć

- DOBRZE

- były

- Co

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- KIM

- cały

- szeroki

- Szeroki zasięg

- Wikipedia

- będzie

- w

- w ciągu

- bez

- słowa

- Praca

- pracować razem

- świat

- pisanie

- lat

- jeszcze

- ty

- zefirnet

- Nauka zero-shot