Wygenerowane za pomocą Midjourney

Przedsiębiorstwa ze wszystkich branż i zakątków świata spieszą się, aby zintegrować moc dużych modeli językowych (LLM), takich jak ChatGPT firmy OpenAI, Claude firmy Anthropic i Jurassic firmy AI12Lab, aby zwiększyć wydajność w szerokim zakresie aplikacji biznesowych, takich jak badania rynku, obsługa klienta i generowania treści.

Jednak budowanie aplikacji LLM na skalę przedsiębiorstwa wymaga innego zestawu narzędzi i zrozumienia niż budowanie tradycyjnych aplikacji uczenia maszynowego (ML). Liderzy biznesowi i kadra kierownicza, którzy chcą zachować głos marki i niezawodną jakość usług, muszą pogłębić zrozumienie działania LLM oraz zalet i wad różnych narzędzi w stosie aplikacji LLM.

W tym artykule przedstawimy podstawowe wprowadzenie do strategii i narzędzi wysokiego poziomu potrzebnych do zbudowania i uruchomienia aplikacji LLM dla Twojej firmy.

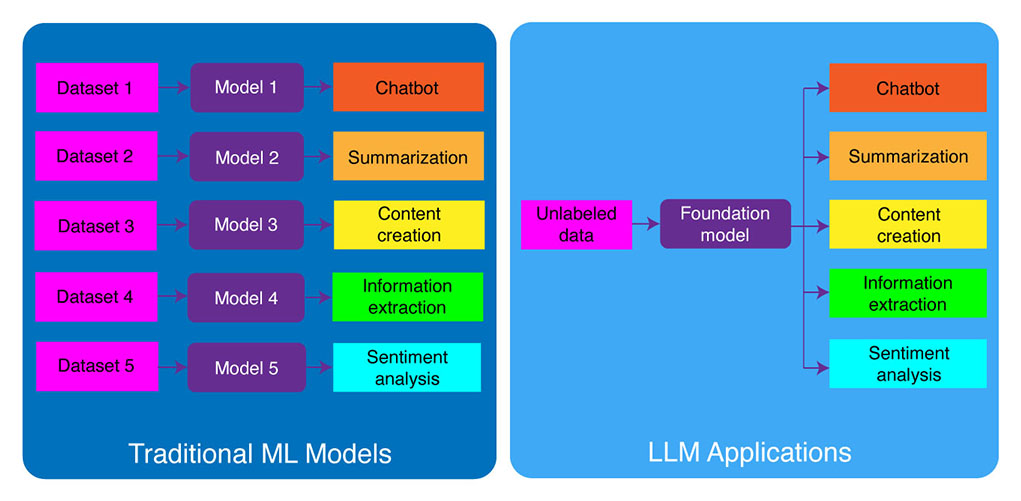

Tradycyjne tworzenie ML a aplikacje LLM

Tradycyjne modele uczenia maszynowego były specyficzne dla zadania, co oznacza, że trzeba było zbudować osobny model dla każdego innego zadania. Na przykład, jeśli chcesz przeanalizować nastroje klientów, musisz zbudować jeden model, a jeśli chcesz zbudować chatbota do obsługi klienta, musisz zbudować inny model.

Ten proces budowania i trenowania modeli ML specyficznych dla zadań jest czasochłonny i wymaga dużej ilości danych. Rodzaje zestawów danych potrzebnych do trenowania tych różnych modeli uczenia maszynowego również będą się różnić w zależności od zadania. Aby wytrenować model do analizowania nastrojów klientów, potrzebny byłby zestaw danych recenzji klientów, które zostały oznaczone odpowiednim nastrojem (pozytywnym, negatywnym, neutralnym). Aby wyszkolić model do zbudowania chatbota obsługi klienta, potrzebny byłby zestaw danych rozmów między klientami a pomocą techniczną.

Zmieniły to duże modele językowe. LLM są wstępnie przeszkoleni w zakresie ogromnego zestawu danych tekstu i kodu, co pozwala im dobrze wykonywać szeroki zakres zadań od razu po wyjęciu z pudełka, w tym:

- Podsumowanie tekstu

- Tworzenie treści

- Tłumaczenie

- Ekstrakcja informacji

- Odpowiadanie na pytania

- Analiza sentymentów

- Obsługa klienta

- Wsparcie sprzedaży

Proces tworzenia aplikacji LLM można podzielić na cztery podstawowe etapy:

- Wybierz odpowiedni model fundamentu. Jest to kluczowy składnik określający wydajność Twojej aplikacji LLM.

- W razie potrzeby dostosuj model. Może być konieczne dostrojenie modelu lub rozszerzenie go o dodatkową bazę wiedzy, aby spełnić określone potrzeby.

- Skonfiguruj infrastrukturę ML. Obejmuje to sprzęt i oprogramowanie potrzebne do uruchomienia Twojej aplikacji (tj. półprzewodniki, układy scalone, hosting w chmurze, wnioskowanie i wdrożenie).

- Rozszerz swoją aplikację o dodatkowe narzędzia. Narzędzia te mogą pomóc w zwiększeniu wydajności, wydajności i bezpieczeństwa aplikacji.

Przyjrzyjmy się teraz odpowiedniemu stosowi technologii.

Jeśli te szczegółowe treści edukacyjne są dla Ciebie przydatne, zapisz się na naszą listę mailingową AI zostać powiadomionym, gdy wydamy nowy materiał.

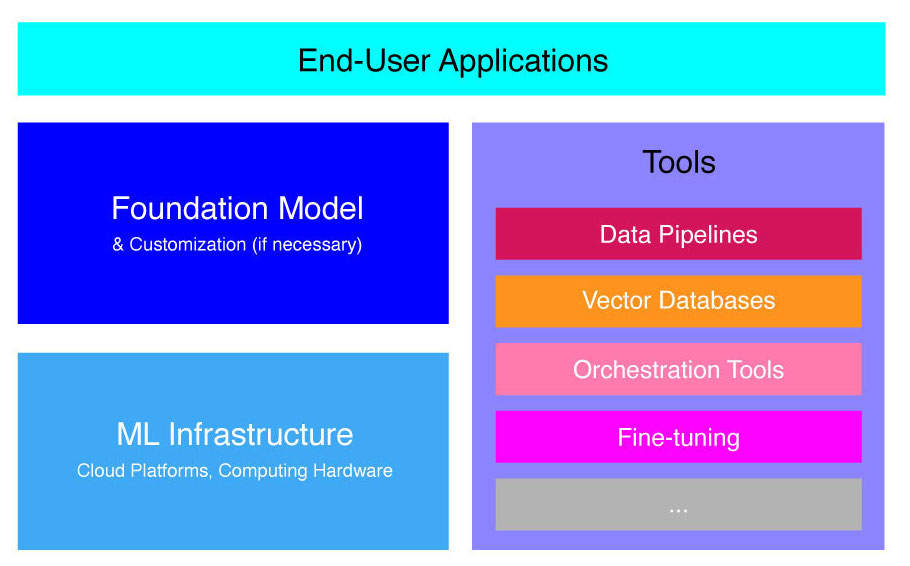

Stos aplikacji LLM wysokiego poziomu

Aplikacje LLM są zbudowane na kilku kluczowych komponentach, w tym:

- Model fundamentu, co może wymagać dostosowania w określonych przypadkach użycia.

- Infrastruktura ML wystarczających zasobów obliczeniowych za pośrednictwem platform chmurowych lub własnego sprzętu firmy.

- Dodatkowe narzędzia, takich jak potoki danych, wektorowe bazy danych, narzędzia do orkiestracji, dostrajające platformy ML, narzędzia do monitorowania wydajności modeli itp.

Pokrótce przeprowadzimy Cię przez te składniki, abyś mógł lepiej zrozumieć zestaw narzędzi potrzebny do zbudowania i wdrożenia aplikacji LLM.

Czym są modele podstawowe?

Korzystanie z jednego wstępnie przeszkolonego LLM może zaoszczędzić dużo czasu i zasobów. Jednak wyszkolenie takiego modelu od podstaw jest procesem czasochłonnym i kosztownym, przekraczającym możliwości większości firm z wyjątkiem nielicznej elity liderów technologicznych.

Kilka firm i zespołów badawczych przeszkoliło te modele i umożliwiło korzystanie z nich innym firmom. Wiodące przykłady to ChatGPT, Claude, Llama, Jurassic i T5. Te publicznie dostępne modele nazywane są modelami podstawowymi. Niektóre z nich są zastrzeżone i można uzyskać do nich dostęp za pośrednictwem wywołań API za opłatą. Inne są otwarte i można z nich korzystać za darmo. Modele te są wstępnie szkolone na ogromnym zbiorze nieoznakowanych danych tekstowych, dzięki czemu mogą wykonywać szeroki zakres zadań, od tworzenia kreatywnych kopii reklam po komunikowanie się z klientami w ich ojczystym języku w imieniu firmy.

Istnieją dwa główne typy modeli podstawowych: zastrzeżone i otwarte.

Własne modele są własnością jednej firmy lub organizacji i zazwyczaj są dostępne tylko za opłatą. Niektóre z najpopularniejszych przykładów zastrzeżonych modeli obejmują modele GPT firmy OpenAI, modele Claude firmy Anthropic i modele Jurassic firmy AI21 Labs.

Modele open-source są zwykle dostępne za darmo dla każdego, kto chce z nich korzystać. Jednak niektóre modele open source mają ograniczenia w ich użyciu, takie jak: (1) są dostępne tylko do celów badawczych, (2) są dostępne tylko do użytku komercyjnego przez firmy o określonej wielkości. Społeczność open source twierdzi, że nałożenie takich ograniczeń nie pozwala na zakwalifikowanie modelu jako „open source”. Jednak najbardziej znanymi przykładami modeli językowych, z których można korzystać za darmo, są modele Llama firmy Meta, modele Falcon opracowane przez Technology Innovation Institute w Abu Dhabi oraz modele StableLM opracowane przez Stability AI. Przeczytaj więcej o modelach open source i związanych z nimi zagrożeniach tutaj.

Omówmy teraz kilka czynników, które należy wziąć pod uwagę przy wyborze modelu podstawowego dla aplikacji LLM.

Wybierz model podstawowy

Wybór najlepszego modelu fundamentu dla aplikacji LLM może być trudnym procesem, ale zasadniczo możemy go podzielić na trzy etapy:

- Wybieraj pomiędzy modelami zastrzeżonymi i open-source. Własne modele są zwykle większe i bardziej wydajne niż modele open source, ale mogą być droższe w użyciu i mniej elastyczne. Ponadto kod nie jest tak przejrzysty, co utrudnia debugowanie lub rozwiązywanie problemów z wydajnością zastrzeżonych modeli. Z drugiej strony modele open source zwykle otrzymują mniej aktualizacji i mniejsze wsparcie ze strony programistów.

- Wybierz rozmiar modelu. Większe modele zwykle lepiej radzą sobie z zadaniami wymagającymi dużej wiedzy, takimi jak odpowiadanie na pytania lub generowanie kreatywnego tekstu. Jednak większe modele są również bardziej kosztowne obliczeniowo w użyciu. Możesz zacząć od eksperymentowania z większymi modelami, a następnie przejść do mniejszych, o ile wydajność modelu jest zadowalająca dla twojego przypadku użycia.

- Wybierz konkretny model. Możesz zacząć od przejrzenia ogólnych testów porównawczych, aby sporządzić krótką listę modeli do testów. Następnie przejdź do testowania różnych modeli dla swoich zadań specyficznych dla aplikacji. W przypadku niestandardowych testów porównawczych rozważ obliczenia Wyniki BLEU i ROUGE, metryki, które pomagają oszacować liczbę poprawek niezbędnych do tekstu wygenerowanego przez sztuczną inteligencję przed udostępnieniem danych wyjściowych dla aplikacji typu „człowiek w pętli”.

Aby lepiej zrozumieć różnice między różnymi modelami językowymi, sprawdź nasz przegląd najpotężniejszych modeli językowych (LLM) i wizualnych modeli językowych (VLM).

Po wybraniu modelu podstawowego dla swojej aplikacji możesz rozważyć, czy potrzebujesz dostosować model, aby uzyskać jeszcze lepszą wydajność.

Dostosuj model podstawy

W niektórych przypadkach możesz chcieć dostosować model języka podstawowego, aby uzyskać lepszą wydajność w konkretnym przypadku użycia. Na przykład możesz chcieć zoptymalizować pod kątem:

- Domena. Jeśli działasz w określonych domenach, takich jak prawo, finanse lub opieka zdrowotna, możesz chcieć wzbogacić słownictwo modelu w tej dziedzinie, aby mógł lepiej rozumieć zapytania użytkowników końcowych i odpowiadać na nie.

- Zadanie. Na przykład, jeśli chcesz, aby model generował kampanie marketingowe, możesz dostarczyć mu konkretne przykłady markowych treści marketingowych. Pomoże to modelowi nauczyć się wzorców i stylów, które są odpowiednie dla Twojej firmy i odbiorców.

- Ton głosu. Jeśli potrzebujesz, aby model używał określonego tonu głosu, możesz dostosować model na zestawie danych, który zawiera przykłady docelowych próbek językowych.

Istnieją trzy możliwe sposoby dostosowania modelu języka podstawowego:

- Strojenie: zapewnia modelowi zestaw danych z etykietami dla określonej domeny zawierający około 100-500 rekordów. Wagi modelu są aktualizowane, co powinno skutkować lepszą wydajnością zadań reprezentowanych przez ten zestaw danych.

- Adaptacja domeny: zapewnia modelowi nieoznaczony zestaw danych specyficzny dla domeny, który zawiera duży zbiór danych z odpowiedniej domeny. W tym przypadku wagi modeli są również aktualizowane.

- Wyszukiwanie informacji: rozszerza model podstawowy o wiedzę w domenie zamkniętej. Model nie jest ponownie szkolony, a waga modelu pozostaje taka sama. Jednak model może pobierać informacje z wektorowej bazy danych zawierającej odpowiednie dane.

Pierwsze dwa podejścia wymagają znacznych zasobów obliczeniowych do ponownego nauczenia modelu, co jest zwykle wykonalne tylko w przypadku dużych firm z odpowiednimi talentami technicznymi do zarządzania dostosowaniem. Mniejsze firmy zazwyczaj stosują bardziej powszechne podejście polegające na rozszerzaniu modelu o wiedzę dziedzinową za pośrednictwem wektorowej bazy danych, co szczegółowo opisujemy w dalszej części tego artykułu w sekcji dotyczącej narzędzi LLM.

Skonfiguruj infrastrukturę ML

Składnik infrastruktury ML krajobrazu LLMOps obejmuje platformy chmurowe, sprzęt komputerowy i inne zasoby potrzebne do wdrażania i uruchamiania LLM. Ten składnik jest szczególnie przydatny, jeśli zdecydujesz się użyć modelu typu open source lub dostosować model do swojej aplikacji. W takim przypadku możesz potrzebować znacznych zasobów obliczeniowych, aby w razie potrzeby dostroić model i uruchomić go.

Istnieje wiele platform chmurowych, które oferują usługi wdrażania LLM, w tym Google Cloud Platform, Amazon Web Services i Microsoft Azure. Platformy te zapewniają szereg funkcji, które ułatwiają wdrażanie i uruchamianie LLM, w tym:

- Wstępnie wytrenowane modele, które można dostosować do konkretnego zastosowania

- Zarządzana infrastruktura, która dba o podstawowy sprzęt i oprogramowanie

- Narzędzia i usługi do monitorowania i debugowania Twoich LLM

Ilość potrzebnych zasobów obliczeniowych będzie zależała od rozmiaru i złożoności modelu, zadań, które ma on wykonywać, oraz skali działalności biznesowej, w której chcesz wdrożyć ten model.

Augment Z Narzędziami

Dodatkowe sąsiednie narzędzia LLM mogą służyć do dalszego zwiększania wydajności aplikacji LLM.

Potoki danych

Jeśli musisz użyć swoich danych w swoim produkcie LLM, potok wstępnego przetwarzania danych będzie podstawowym filarem Twojego nowego stosu technologicznego, podobnie jak w tradycyjnym stosie sztucznej inteligencji w przedsiębiorstwie. Narzędzia te obejmują łączniki do pozyskiwania danych z dowolnego źródła, warstwę transformacji danych i łączniki podrzędne. Wiodący dostawcy potoków danych, tacy jak Databricks i Snowflake, oraz nowi gracze, jak Unstructured, ułatwiają programistom wskazywanie dużych i wysoce heterogenicznych korpusów danych w języku naturalnym (np. itp.) do pojedynczego punktu dostępu lub nawet do jednego dokumentu, który może być dalej wykorzystywany przez aplikacje LLM.

Wektorowe bazy danych

Duże modele językowe są ograniczone do przetwarzania kilku tysięcy słów naraz, więc nie mogą efektywnie przetwarzać dużych dokumentów samodzielnie. Aby wykorzystać moc dużych dokumentów, firmy muszą korzystać z wektorowych baz danych.

Wektorowe bazy danych to systemy pamięci masowej, które przekształcają duże dokumenty otrzymywane za pośrednictwem potoków danych w łatwe do zarządzania wektory lub elementy osadzone. Aplikacje LLM mogą następnie wysyłać zapytania do tych baz danych, aby wskazać właściwe wektory, wydobywając tylko niezbędne samorodki informacji.

Niektóre z najbardziej znanych obecnie dostępnych baz danych wektorowych to Pinecone, Chroma i Weaviate.

Narzędzia orkiestracji

Gdy użytkownik przesyła zapytanie do aplikacji LLM, takie jak pytanie dotyczące obsługi klienta, aplikacja musi utworzyć serię monitów przed przesłaniem tego zapytania do modelu językowego. Ostateczne żądanie do modelu językowego zazwyczaj składa się z szablonu zachęty zakodowanego na stałe przez programistę, przykładów prawidłowych wyników zwanych przykładami kilku ujęć, wszelkich niezbędnych informacji pobranych z zewnętrznych interfejsów API oraz zestawu odpowiednich dokumentów pobranych z bazy danych wektorowych . Narzędzia orkiestracyjne firm takich jak LangChain czy LlamaIndex mogą pomóc usprawnić ten proces, udostępniając gotowe do użycia ramy do zarządzania monitami i ich wykonywania.

Strojenie

Duże modele językowe trenowane na ogromnych zbiorach danych mogą generować gramatycznie poprawny i płynny tekst. Może im jednak brakować precyzji w niektórych dziedzinach, takich jak medycyna czy prawo. Precyzyjne dostrojenie tych modeli do zestawów danych specyficznych dla domeny pozwala im zinternalizować unikalne cechy tych obszarów, zwiększając ich zdolność do generowania odpowiedniego tekstu.

Dostrajanie LLM może być kosztownym procesem dla małych firm. Jednak rozwiązania firm takich jak Weights & Biases i OctoML mogą pomóc w usprawnionym i wydajnym dostrajaniu. Rozwiązania te zapewniają firmom platformę do dostrajania LLM bez konieczności inwestowania we własną infrastrukturę.

Inne narzędzia

Istnieje wiele innych narzędzi, które mogą być przydatne do tworzenia i uruchamiania aplikacji LLM. Na przykład możesz potrzebować narzędzi do etykietowania, jeśli chcesz dostroić model za pomocą określonych próbek danych. Możesz także chcieć wdrożyć określone narzędzia do monitorowania wydajności aplikacji, ponieważ nawet niewielkie zmiany w modelu podstawowym lub prośby klientów mogą znacząco wpłynąć na wydajność monitów. Wreszcie, istnieją narzędzia, które monitorują bezpieczeństwo modeli, aby pomóc Ci uniknąć promowania nienawistnych treści, niebezpiecznych rekomendacji lub uprzedzeń. Konieczność i znaczenie tych różnych narzędzi będzie zależeć od konkretnego przypadku użycia.

Co dalej w rozwoju aplikacji LLM?

Cztery kroki rozwoju produktu LLM, które tutaj omówiliśmy, stanowią podstawę generatywnej strategii sztucznej inteligencji każdego przedsiębiorstwa, która wykorzystuje duże modele językowe. Są one ważne dla liderów biznesu nietechnicznych, aby je zrozumieli, nawet jeśli masz zespół techniczny wdrażający szczegóły. W przyszłości opublikujemy bardziej szczegółowe samouczki dotyczące wykorzystania szerokiej gamy generatywnych narzędzi sztucznej inteligencji dostępnych na rynku. Na razie możesz Zapisz się do naszego newslettera aby uzyskać najnowsze aktualizacje.

Podoba ci się ten artykuł? Zarejestruj się, aby otrzymywać więcej aktualizacji korporacyjnej sztucznej inteligencji.

Damy Ci znać, gdy wydamy więcej artykułów podsumowujących takich jak ten.

Związane z

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://www.topbots.com/llm-product-development-technology-stack/

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- a

- zdolność

- O nas

- Abu Dabi

- dostęp

- dostęp

- działalność

- Ad

- Dodatkowy

- do tego

- sąsiadujący

- AI

- Strategia AI

- dopuszczać

- dozwolony

- pozwala

- również

- Amazonka

- Amazon Web Services

- ilość

- an

- w czasie rzeczywistym sprawiają,

- i

- Inne

- Antropiczny

- każdy

- ktoś

- api

- Pszczoła

- Zastosowanie

- Application Development

- aplikacje

- podejście

- awanse

- właściwy

- SĄ

- obszary

- artykuł

- towary

- AS

- powiązany

- At

- publiczność

- dostępny

- uniknąć

- Lazur

- baza

- Gruntownie

- BE

- być

- zanim

- w imieniu

- jest

- Benchmarkingu

- Benchmarki

- BEST

- Ulepsz Swój

- pomiędzy

- Poza

- uprzedzenia

- podnieść

- Pudełko

- marka

- markowe

- przerwa

- krótko

- Złamany

- budować

- Budowanie

- wybudowany

- biznes

- Aplikacje biznesowe

- Liderzy biznesu

- biznes

- ale

- by

- obliczenie

- nazywa

- Połączenia

- Kampanie

- CAN

- możliwości

- zdolny

- który

- walizka

- Etui

- pewien

- wyzwanie

- zmieniony

- Zmiany

- chatbot

- ChatGPT

- ZOBACZ

- Frytki

- Dodaj

- Wybierając

- wybrany

- roszczenia

- Chmura

- Cloud Hosting

- Platforma chmurowa

- kod

- handlowy

- wspólny

- przyległy

- społeczność

- Firmy

- sukcesy firma

- Firma

- kompleksowość

- składnik

- składniki

- w składzie

- computing

- Wady

- Rozważać

- skonstruować

- zawiera

- zawartość

- rozmowy

- kopie

- Corner

- skorygowania

- Korekty

- Odpowiedni

- kosztowny

- Twórczy

- Obecnie

- zwyczaj

- klient

- Obsługa klienta

- Obsługa klienta

- Klientów

- dostosowywanie

- dostosować

- Niebezpieczny

- dane

- Baza danych

- Bazy danych

- Pamięci danych

- zbiory danych

- głębiej

- definiowanie

- W zależności

- rozwijać

- wdrażanie

- Wdrożenie

- detal

- szczegółowe

- detale

- rozwijać

- Deweloper

- deweloperzy

- rozwijanie

- oprogramowania

- Dhabi

- Różnice

- różne

- trudny

- dyskutować

- omówione

- dokument

- dokumenty

- Nie

- domena

- domeny

- na dół

- e

- każdy

- łatwo

- edukacyjny

- faktycznie

- efektywność

- wydajny

- elita

- umożliwiając

- wzmacniać

- wzmocnienie

- wzbogacać

- Enterprise

- szczególnie

- niezbędny

- itp

- Eter (ETH)

- Parzyste

- Każdy

- przykład

- przykłady

- Z wyjątkiem

- wykonywania

- kierownictwo

- drogi

- zewnętrzny

- Czynniki

- sokół

- wykonalny

- Korzyści

- opłata

- kilka

- mniej

- finał

- W końcu

- budżetowy

- i terminów, a

- elastyczne

- W razie zamówieenia projektu

- Fundacja

- cztery

- Ramy

- Darmowy

- od

- dalej

- przyszłość

- Ogólne

- Generować

- generujący

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- Dać

- globus

- Go

- będzie

- Google Cloud

- Platforma Google Cloud

- Ziemia

- ręka

- sprzęt komputerowy

- uprząż

- Have

- mający

- opieki zdrowotnej

- pomoc

- tutaj

- na wysokim szczeblu

- wysoko

- Hosting

- W jaki sposób

- How To

- Jednak

- HTML

- HTTPS

- i

- if

- Rezultat

- wykonawczych

- znaczenie

- ważny

- podnieść

- in

- informacje

- zawierać

- obejmuje

- Włącznie z

- przemysł

- Informacja

- Infrastruktura

- Innowacja

- Instytut

- integrować

- najnowszych

- Wprowadzenie

- Inwestuj

- IT

- jpg

- właśnie

- Klawisz

- Uprzejmy

- Wiedzieć

- wiedza

- etykietowanie

- Labs

- Brak

- krajobraz

- język

- duży

- większe

- później

- firmy

- Najnowsze aktualizacje

- Prawo

- warstwa

- Przywódcy

- prowadzący

- UCZYĆ SIĘ

- nauka

- Regulamin

- mniej

- Dźwignia

- wykorzystuje

- lubić

- Ograniczenia

- Ograniczony

- Lama

- długo

- Popatrz

- Partia

- maszyna

- uczenie maszynowe

- Główny

- robić

- WYKONUJE

- zarządzanie

- zarządzający

- wiele

- rynek

- badania rynku

- Marketing

- Kampanie marketingowe

- rynek

- masywny

- materiał

- Maksymalna szerokość

- Może..

- znaczenie

- lekarstwo

- Poznaj nasz

- Meta

- Metryka

- Microsoft

- Azure firmy Microsoft

- może

- moll

- ML

- model

- modele

- monitor

- monitorowanie

- jeszcze

- większość

- Najbardziej popularne posty

- rodzimy

- Naturalny

- Język naturalny

- niezbędny

- Potrzebować

- potrzebne

- wymagania

- ujemny

- Neutralny

- Nowości

- Nowa technologia

- Newsletter

- Następny

- nietechniczne

- już dziś

- numer

- of

- oferta

- on

- ONE

- te

- tylko

- open source

- OpenAI

- działać

- Optymalizacja

- or

- orkiestracja

- organizacja

- Inne

- Pozostałe

- ludzkiej,

- na zewnątrz

- wydajność

- przegląd

- własny

- własność

- wzory

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywania

- Filar

- rurociąg

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- gracze

- punkt

- Popularny

- pozytywny

- możliwy

- power

- mocny

- Detaliczność

- Presentations

- problemy

- wygląda tak

- przetwarzanie

- produkować

- Produkt

- rozwój produktów

- wybitny

- promowanie

- własność

- PROS

- zapewniać

- dostawców

- zapewnia

- że

- publikować

- cele

- Putting

- kwalifikować

- jakość

- zapytania

- pytanie

- pytania

- zasięg

- Czytaj

- otrzymać

- zalecenia

- dokumentacja

- zwolnić

- uwalniając

- rzetelny

- reprezentowane

- zażądać

- wywołań

- wymagać

- Wymaga

- Badania naukowe

- Zasoby

- Odpowiadać

- Ograniczenia

- dalsze

- recenzowanie

- Recenzje

- prawo

- ryzyko

- run

- bieganie

- Bezpieczeństwo

- taki sam

- Zapisz

- Skala

- Sekcja

- bezpieczeństwo

- Półprzewodniki

- sentyment

- oddzielny

- Serie

- usługa

- Usługi

- zestaw

- kilka

- powinien

- znak

- znaczący

- znacznie

- pojedynczy

- Rozmiar

- mały

- mniejszy

- So

- Tworzenie

- Rozwiązania

- kilka

- Źródło

- specyficzny

- Stabilność

- stos

- początek

- pobyt

- Cel

- Nadal

- przechowywanie

- Strategia

- opływowy

- usprawniony

- style

- taki

- wystarczający

- PODSUMOWANIE

- wsparcie

- systemy

- Brać

- trwa

- Talent

- cel

- Zadanie

- zadania

- zespół

- Zespoły

- tech

- Techniczny

- pomoc techniczna

- Technologia

- innowacje technologiczne

- szablon

- Testowanie

- niż

- że

- Połączenia

- Przyszłość

- ich

- Im

- następnie

- Tam.

- Te

- one

- to

- tych

- tysiące

- trzy

- Przez

- czas

- czasochłonne

- do

- TON

- Ton głosu

- Zestaw narzędzi

- narzędzia

- Top

- TOPBOTY

- tradycyjny

- Pociąg

- przeszkolony

- Trening

- Przekształcać

- Transformacja

- przezroczysty

- tutoriale

- drugiej

- typy

- zazwyczaj

- zasadniczy

- zrozumieć

- zrozumienie

- wyjątkowy

- unikalne funkcje

- zaktualizowane

- Nowości

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- zazwyczaj

- różnorodny

- przez

- Głos

- vs

- chcieć

- poszukiwany

- chce

- sposoby

- we

- sieć

- usługi internetowe

- DOBRZE

- były

- jeśli chodzi o komunikację i motywację

- czy

- który

- KIM

- szeroki

- Szeroki zasięg

- będzie

- w

- bez

- słowa

- Praca

- by

- ty

- Twój

- zefirnet