Nøkkelfunksjoner

- Tankeformidling (TP) er en ny metode som forbedrer de komplekse resonneringsevnene til store språkmodeller (LLM).

- TP utnytter analoge problemer og deres løsninger for å forbedre resonnement, i stedet for å få LLM til å resonnere fra bunnen av.

- Eksperimenter på tvers av ulike oppgaver viser at TP overgår baselinemetodene betydelig, med forbedringer som varierer fra 12 % til 15 %.

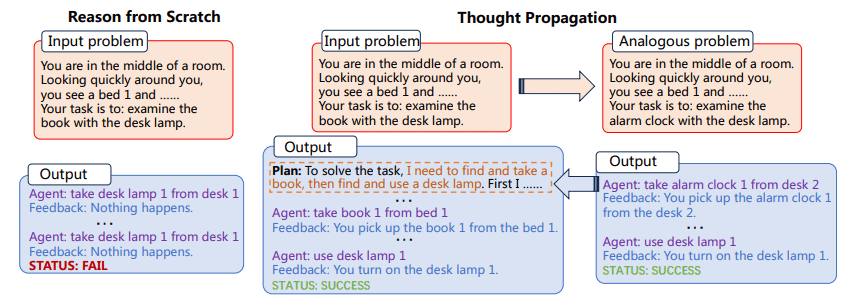

TP ber først LLM-er om å foreslå og løse et sett med analoge problemer som er relatert til inndata. Deretter gjenbruker TP resultatene av analoge problemer for direkte å gi en ny løsning eller utlede en kunnskapsintensiv plan for utførelse for å endre den opprinnelige løsningen oppnådd fra bunnen av.

Allsidigheten og beregningskraften til store språkmodeller (LLM) er ubestridelige, men de er ikke ubegrensede. En av de mest betydningsfulle og konsekvente utfordringene for LLM-er er deres generelle tilnærming til problemløsning, som består av resonnement fra første prinsipper for hver ny oppgave du møter. Dette er problematisk, da det åpner for en høy grad av tilpasningsevne, men øker også sannsynligheten for feil, spesielt i oppgaver som krever flertrinns resonnement.

Utfordringen med å "resonnere fra bunnen av" er spesielt uttalt i komplekse oppgaver som krever flere trinn med logikk og slutninger. For eksempel, hvis en LLM blir bedt om å finne den korteste veien i et nettverk av sammenkoblede punkter, vil den vanligvis ikke utnytte forkunnskaper eller analoge problemer for å finne en løsning. I stedet ville den forsøke å løse problemet isolert, noe som kan føre til suboptimale resultater eller til og med direkte feil. Tast inn Tankeformidling (TP), en metode designet for å øke resonnementmulighetene til LLM-er. TP har som mål å overvinne de iboende begrensningene til LLM-er ved å la dem trekke fra et reservoar av analoge problemer og deres tilsvarende løsninger. Denne innovative tilnærmingen forbedrer ikke bare nøyaktigheten til LLM-genererte løsninger, men forbedrer også deres evne til å takle komplekse resonneringsoppgaver i flere trinn. Ved å utnytte kraften til analogi, gir TP et rammeverk som forsterker de medfødte resonneringsevnene til LLM-er, og bringer oss et skritt nærmere realiseringen av virkelig intelligente kunstige systemer.

Tankeformidling innebærer to hovedtrinn:

- Først blir LLM bedt om å foreslå og løse et sett med analoge problemer relatert til inndataproblemet

- Deretter brukes løsningene på disse analoge problemene til enten å gi en ny løsning direkte eller for å endre den opprinnelige løsningen

Prosessen med å identifisere analoge problemer gjør det mulig for LLM å gjenbruke problemløsningsstrategier og løsninger, og dermed forbedre resonnementevnen. TP er kompatibel med eksisterende spørremetoder, og gir en generaliserbar løsning som kan inkorporeres i ulike oppgaver uten vesentlig oppgavespesifikk konstruksjon.

Figur 1: Tankeformidlingsprosessen (bilde fra papir)

Dessuten bør tilpasningsevnen til TP ikke undervurderes. Dens kompatibilitet med eksisterende spørremetoder gjør det til et svært allsidig verktøy. Dette betyr at TP ikke er begrenset til noen spesifikk type problemløsningsdomene. Dette åpner for spennende muligheter for oppgavespesifikk finjustering og optimalisering, og øker dermed nytten og effektiviteten til LLM-er i et bredt spekter av applikasjoner.

Implementeringen av Thought Propagation kan integreres i arbeidsflyten til eksisterende LLM-er. For eksempel, i en Shortest-path Reasoning-oppgave, kan TP først løse et sett med enklere, analoge problemer for å forstå forskjellige mulige veier. Den vil da bruke denne innsikten til å løse det komplekse problemet, og dermed øke sannsynligheten for å finne den optimale løsningen.

Eksempel 1

- Oppgave: Korteste vei Begrunnelse

- Analoge problemer: Korteste vei mellom punkt A og B, Korteste vei mellom punkt B og C

- Endelig løsning: Optimal vei fra punkt A til C med tanke på løsninger av analoge problemer

Eksempel 2

- Oppgave: Kreativ skriving

- Analoge problemer: Skriv en novelle om vennskap, Skriv en novelle om tillit

- Endelig løsning: Skriv en kompleks novelle som integrerer temaer om vennskap og tillit

Prosessen innebærer å løse disse analoge problemene først, og deretter bruke innsikten til å takle den komplekse oppgaven. Denne metoden har vist sin effektivitet på tvers av flere oppgaver, og viser betydelige forbedringer i ytelsesmålinger.

Tankeutbredelsens implikasjoner går utover bare å forbedre eksisterende beregninger. Denne spørreteknikken har potensial til å endre hvordan vi forstår og distribuerer LLM-er. Metodikken understreker et skifte fra isolert, atomisk problemløsning til en mer helhetlig, sammenkoblet tilnærming. Det ber oss vurdere hvordan LLM-er kan lære ikke bare av data, men fra selve problemløsningsprosessen. Ved å kontinuerlig oppdatere sin forståelse gjennom løsningene på analoge problemer, er LLM-er utstyrt med TP bedre forberedt til å takle uforutsette utfordringer, noe som gjør dem mer robuste og tilpasningsdyktige i raskt utviklende miljøer.

Thought Propagation er et lovende tillegg til verktøykassen med spørremetoder som tar sikte på å forbedre mulighetene til LLM-er. Ved å la LLM-er utnytte analoge problemer og deres løsninger, gir TP en mer nyansert og effektiv resonneringsmetode. Eksperimenter bekrefter dens effektivitet, noe som gjør den til en kandidatstrategi for å forbedre ytelsen til LLM-er på tvers av en rekke oppgaver. TP kan til slutt representere et betydelig skritt fremover i jakten på mer kapable AI-systemer.

Matthew Mayo (@mattmayo13) har en mastergrad i informatikk og en graduate diplom i data mining. Som sjefredaktør for KDnuggets har Matthew som mål å gjøre komplekse datavitenskapelige konsepter tilgjengelige. Hans profesjonelle interesser inkluderer naturlig språkbehandling, maskinlæringsalgoritmer og å utforske nye AI. Han er drevet av et oppdrag om å demokratisere kunnskap i datavitenskapsmiljøet. Matthew har kodet siden han var 6 år gammel.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.kdnuggets.com/thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models?utm_source=rss&utm_medium=rss&utm_campaign=thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models

- : har

- :er

- :ikke

- $OPP

- 15%

- 8

- a

- evner

- evne

- Om oss

- tilgjengelig

- nøyaktighet

- tvers

- tillegg

- AI

- AI-systemer

- sikte

- mål

- algoritmer

- tillate

- tillater

- også

- forsterker

- an

- og

- noen

- søknader

- tilnærming

- ER

- kunstig

- AS

- At

- forsøk

- øke

- veier

- b

- Baseline

- BE

- vært

- Bedre

- mellom

- Beyond

- Bringe

- bred

- men

- by

- CAN

- kandidat

- evner

- stand

- utfordre

- utfordringer

- nærmere

- Koding

- samfunnet

- kompatibilitet

- kompatibel

- komplekse

- beregnings

- regnekraft

- datamaskin

- informatikk

- konsepter

- Bekrefte

- Vurder

- vurderer

- konsistent

- Består

- kontinuerlig

- Tilsvarende

- kunne

- Kreativ

- dato

- data mining

- datavitenskap

- Grad

- Etterspørsel

- demokrat

- demonstrert

- utplassere

- designet

- direkte

- domene

- tegne

- drevet

- redaktør-in-chief

- Effektiv

- effektivitet

- effekten

- enten

- heve

- Emery

- Ingeniørarbeid

- Forbedrer

- styrke

- Enter

- miljøer

- utstyrt

- feil

- spesielt

- Selv

- Hver

- utvikling

- eksempel

- spennende

- gjennomføring

- eksisterende

- eksperimenter

- Utforske

- Finn

- finne

- Først

- Til

- Forward

- Rammeverk

- Vennskap

- fra

- fikk

- general

- Go

- oppgradere

- hånd

- he

- Høy

- svært

- hans

- holder

- helhetlig

- Hvordan

- HTTPS

- identifisering

- if

- bilde

- gjennomføring

- implikasjoner

- forbedre

- forbedringer

- forbedrer

- bedre

- in

- inkludere

- Incorporated

- øker

- økende

- iboende

- innledende

- medfødt

- innovative

- inngang

- innsikt

- i stedet

- integrert

- Integrerer

- Intelligent

- sammenhengende

- interesser

- inn

- innebærer

- isolert

- isolasjon

- IT

- DET ER

- selv

- jpg

- bare

- KDnuggets

- Type

- kunnskap

- Språk

- stor

- føre

- LÆRE

- læring

- Leverage

- utnytter

- utnytte

- sannsynligheten

- BEGRENSE

- begrensninger

- Begrenset

- logikk

- maskin

- maskinlæring

- Hoved

- gjøre

- GJØR AT

- Making

- Master

- matthew

- Kan..

- midler

- bare

- metode

- metodikk

- metoder

- Metrics

- Gruvedrift

- Oppdrag

- modeller

- mer

- mest

- flere

- Naturlig

- Naturlig språk

- Natural Language Processing

- nettverk

- Ny

- ny løsning

- roman

- innhentet

- of

- Gammel

- on

- ONE

- bare

- åpner

- optimal

- optimalisering

- or

- utkonkurrerer

- direkte

- Overcome

- Papir

- spesielt

- banen

- ytelse

- fly

- plato

- Platon Data Intelligence

- PlatonData

- Point

- poeng

- mulig

- potensiell

- makt

- forberedt

- prinsipper

- Før

- Problem

- problemløsning

- problemer

- prosess

- prosessering

- profesjonell

- lovende

- uttales

- forplantning

- foreslå

- gir

- gi

- spenner

- raskt

- heller

- realisering

- grunnen til

- i slekt

- gjengivelse

- representere

- krever

- spenstig

- Resultater

- gjenbruk

- s

- Vitenskap

- skraper

- Søk

- sett

- skift

- Kort

- bør

- Vis

- utstillingsvindu

- signifikant

- betydelig

- siden

- løsning

- Solutions

- LØSE

- løse

- spesifikk

- Spectrum

- Trinn

- Steps

- Story

- strategier

- Strategi

- betydelig

- i det vesentlige

- Systemer

- takle

- Oppgave

- oppgaver

- teknikk

- enn

- Det

- De

- deres

- Dem

- temaer

- deretter

- derved

- Disse

- de

- denne

- trodde

- Gjennom

- til

- verktøy

- Toolbox

- mot

- tp

- virkelig

- Stol

- to

- typisk

- Til syvende og sist

- unektelig

- understreker

- forstå

- forståelse

- uforutsett

- oppdatering

- us

- bruke

- brukt

- ved hjelp av

- verktøyet

- variasjon

- ulike

- allsidig

- allsidighet

- var

- we

- hvilken

- med

- uten

- arbeidsflyt

- ville

- skrive

- skriving

- år

- ennå

- Utbytte

- zephyrnet