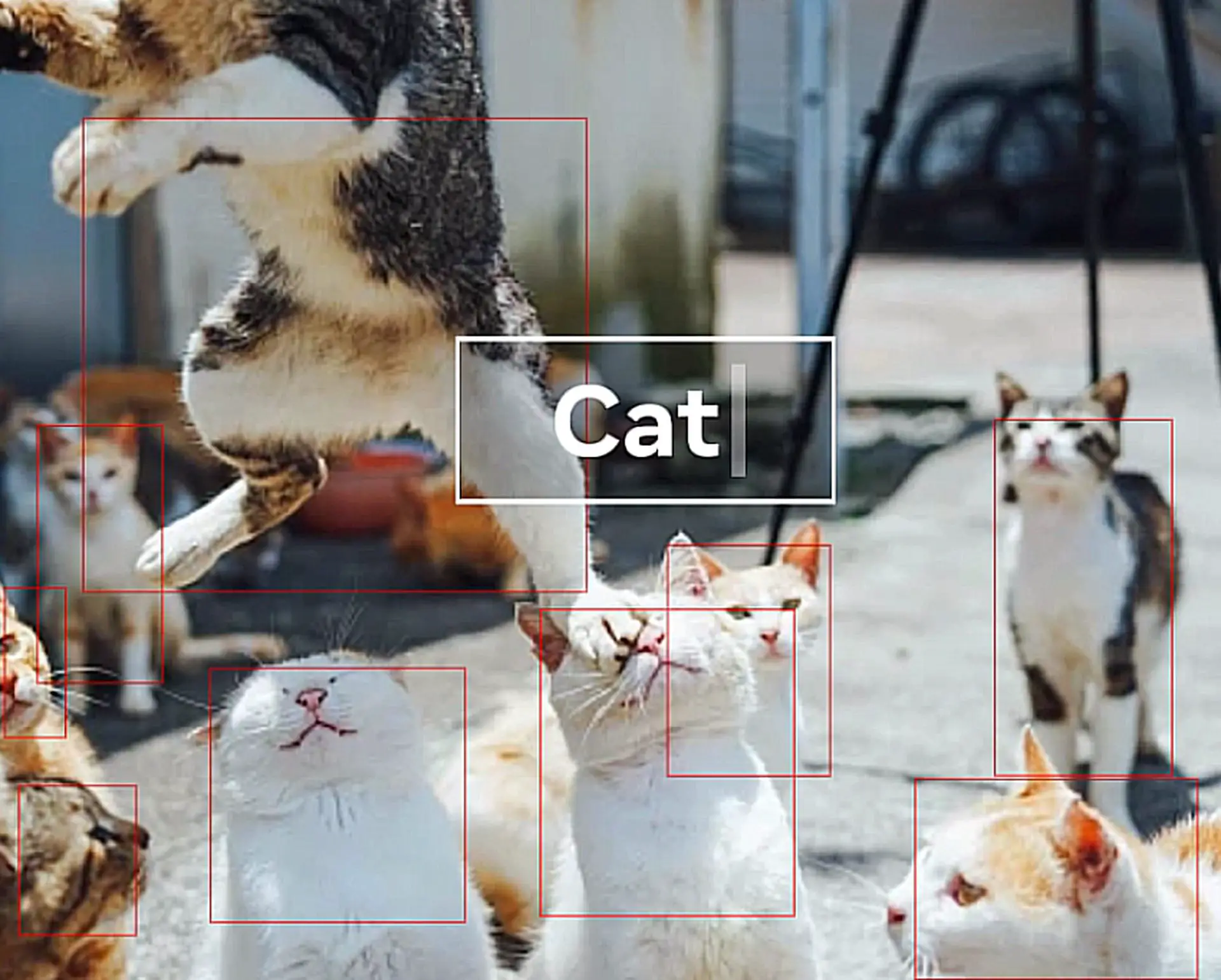

Metas nye Segment Anything Model ble avslørt. SAM-modellen er en ny måte å lage masker av høy kvalitet for bildesegmentering.

påminnelse: Bildesegmentering er en grunnleggende oppgave i datasyn som tar sikte på å dele et bilde inn i regioner som tilsvarer forskjellige objekter eller semantiske kategorier og har mange applikasjoner, som objektgjenkjenning, sceneforståelse, bilderedigering og videoanalyse.

Imidlertid er bildesegmentering også et utfordrende problem, spesielt når man arbeider med komplekse scener som inneholder flere objekter med varierende former, størrelser og utseende. Dessuten krever de fleste eksisterende bildesegmenteringsmetoder store mengder kommenterte data for opplæring, noe som kan være kostbart og tidkrevende å få tak i. Meta ønsker å løse dette problemet med SAM-modellen.

SAM-modell: Hva er Metas nye Segment Anything-modell?

Segment Anything Model (SAM) er en ny og kraftig kunstig intelligens-modell som kan segmentere ethvert objekt i et bilde eller en video med høy kvalitet og effektivitet. Segmentering er prosessen med å skille et objekt fra dets bakgrunn eller andre objekter og lage en maske som skisserer formen og grensene. Med SAM-modellen blir det enklere å redigere, sette sammen, spore, gjenkjenne og analysere.

SAM er forskjellig fra andre segmenteringsmodeller på flere måter, for eksempel:

- SAM er promptbar, noe som betyr at det kan kreve forskjellige inndatameldinger, for eksempel punkter eller bokser, for å spesifisere hvilket objekt som skal segmenteres. Du kan for eksempel tegne en boks rundt ansiktet til en person, og Segment Anything-modellen vil generere en maske for ansiktet. Du kan også gi flere spørsmål om å segmentere flere objekter samtidig. SAM-modellen kan håndtere komplekse scener med okklusjoner, refleksjoner og skygger.

- SAM er trent på et massivt datasett med 11 millioner bilder og 1.1 milliarder masker, som er det største segmenteringsdatasettet til dags dato. Dette datasettet dekker et bredt spekter av objekter og kategorier, som dyr, planter, kjøretøy, møbler, mat og mer. SAM kan segmentere objekter som den aldri har sett før, takket være generaliseringsevnen og datamangfoldet.

- SAM har sterk nullskuddsytelse på en rekke segmenteringsoppgaver. Zero-shot betyr at SAM kan segmentere objekter uten ekstra trening eller finjustering på en spesifikk oppgave eller domene. For eksempel kan SAM segmentere ansikter, hender, hår, klær og tilbehør uten noen forkunnskaper eller tilsyn. SAM kan også segmentere objekter i forskjellige modaliteter, for eksempel infrarøde bilder eller dybdekart.

SAM-modellen oppnår imponerende resultater på ulike bildesegmenteringsbenchmarks, for eksempel COCO. SAM utkonkurrerer eller matcher også tidligere fullt overvåkede metoder på flere nullskuddssegmenteringsoppgaver, for eksempel segmentering av logoer, tekst, ansikter eller skisser. Den demonstrerer sin allsidighet og robusthet på tvers av forskjellige domener og scenarier.

I fremtiden: Prosjektet Segment Anything Model (SAM-modellen) er fortsatt i sine tidlige dager. I følge Meta er dette noen av de fremtidige bruksområdene til Segment Anything-modellen:

- Fremtidige AR-briller kan bruke SAM til å gjenkjenne vanlige gjenstander og gi nyttige påminnelser og instruksjoner.

- SAM har evnen til å påvirke mange andre felt, som landbruk og biologi. En dag kan det til og med komme bønder og forskere til gode.

SAM-modellen kan være et gjennombrudd innen datasyn og forskning på kunstig intelligens. Den demonstrerer potensialet til grunnmodeller for visjon, som er modeller som kan lære av data i stor skala og overføre til nye oppgaver og domener.

Segment Anything Model (SAM-modell) funksjoner

Her er noen av SAM-modellens muligheter:

- Ved å bruke SAM-modellen kan brukere raskt og enkelt segmentere objekter ved å velge individuelle punkter som skal inkluderes eller utelates fra segmenteringen. En grenseboks kan også brukes som stikkord for modellen.

- Når det eksisterer usikkerhet angående elementet som segmenteres, kan SAM-modellen produsere mange gyldige masker, en avgjørende og kritisk ferdighet for å løse segmentering i den virkelige verden.

- Automatisk objektdeteksjon og maskering er nå enkelt med Segment Anything-modellen.

- Etter å ha forhåndsberegnet bildeinnbyggingen, kan Segment Anything-modellen gi en segmenteringsmaske for enhver forespørsel umiddelbart, noe som muliggjør sanntidsinteraksjon med modellen.

Imponerende, ikke sant? Så hva er teknologien bak?

Hvordan fungerer SAM-modellen?

En av de mest spennende oppdagelsene i NLP og, mer nylig, innen datasyn er bruken av "oppfordrende" tilnærminger for å muliggjøre null-skudd og få-skudd læring på nye datasett og oppgaver ved å bruke grunnmodeller. Meta fant motivasjon i dette feltet.

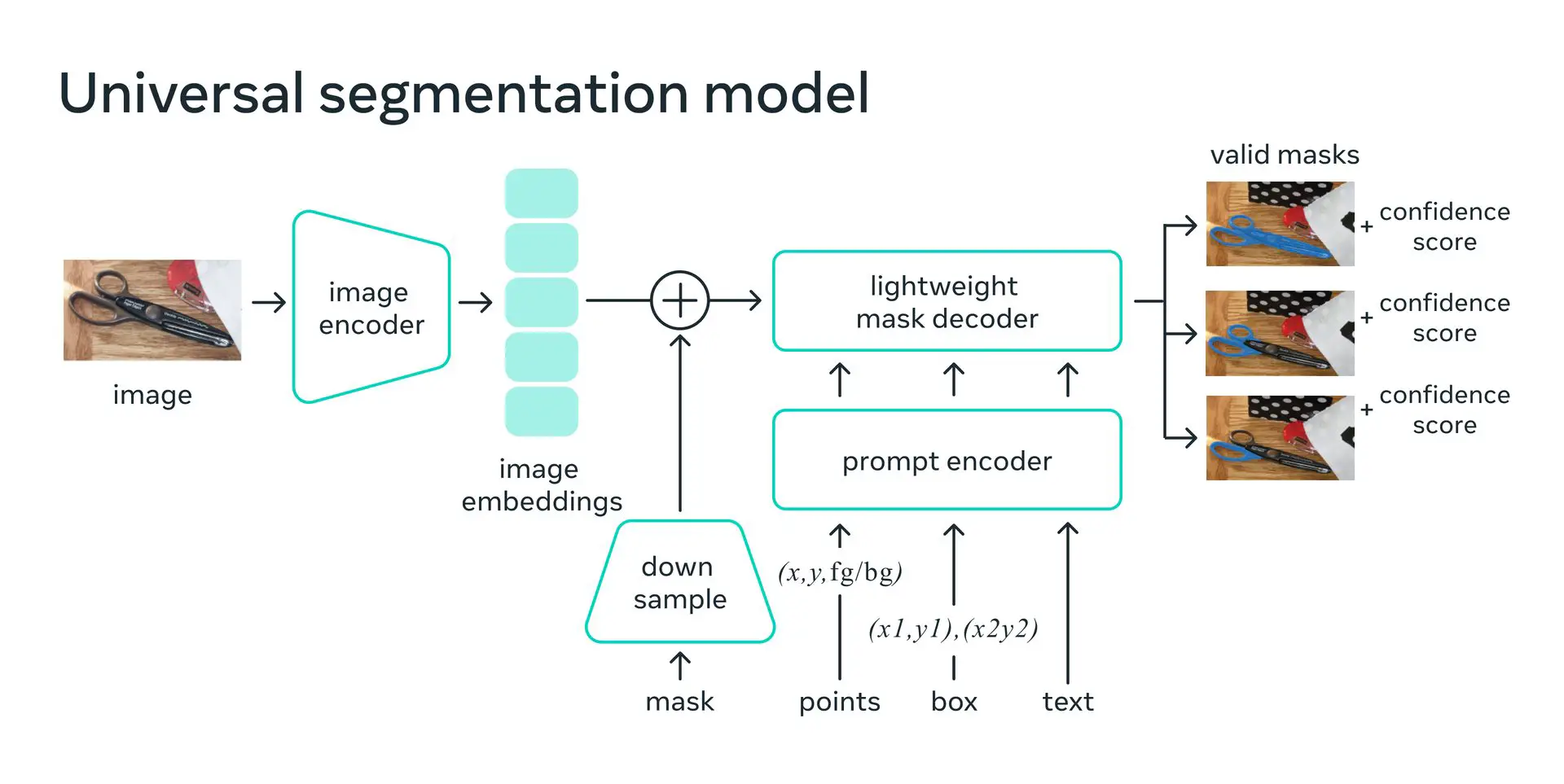

Hvis det ble gitt forgrunns-/bakgrunnspunkter, en grov boks eller maske, friformet tekst eller andre inndata som indikerer hva som skal segmenteres i et bilde, lærte Meta AI-teamet Segment Anything Model å generere en skikkelig segmenteringsmaske. Behovet for en skikkelig maske innebærer bare at utgangen skal være en passende maske for en av tingene som ledeteksten kan referere til (for eksempel kan et punkt på en skjorte representere enten skjorten eller personen som har den på). Denne oppgaven brukes til modellforopplæring og for å veilede løsningen av generiske nedstrøms segmenteringsproblemer.

Meta la merke til at foropplæringsoppgaven og interaktiv datainnsamling la visse begrensninger på modellkonstruksjonen. Spesielt må kommentatorene deres kunne bruke Segment Anything-modellen i en nettleser, interaktivt, i sanntid, på en CPU for at den skal være effektiv. Til tross for at det må være et kompromiss mellom kvalitet og hastighet for å oppfylle kjøretidskravet, oppdager de at en grei tilnærming gir tilfredsstillende resultater.

På baksiden skaper en bildekoder en unik innebygging for bildet, mens en lett koder umiddelbart kan transformere enhver spørring til en innebyggingsvektor. En lettvektsdekoder brukes deretter til å slå sammen disse to datakildene for å forutse segmenteringsmasker. Etter at bildeinnbyggingen er beregnet, kan SAM svare på hvert spørsmål i en nettleser med et segment på ca. 50 ms.

SAM er et nyttig verktøy for kreative fagfolk og entusiaster som ønsker å redigere bilder og videoer med letthet og fleksibilitet. Men først må du lære hvordan du får tilgang til og bruker den.

Hvordan bruke Segment Anything Model (SAM-modellen)?

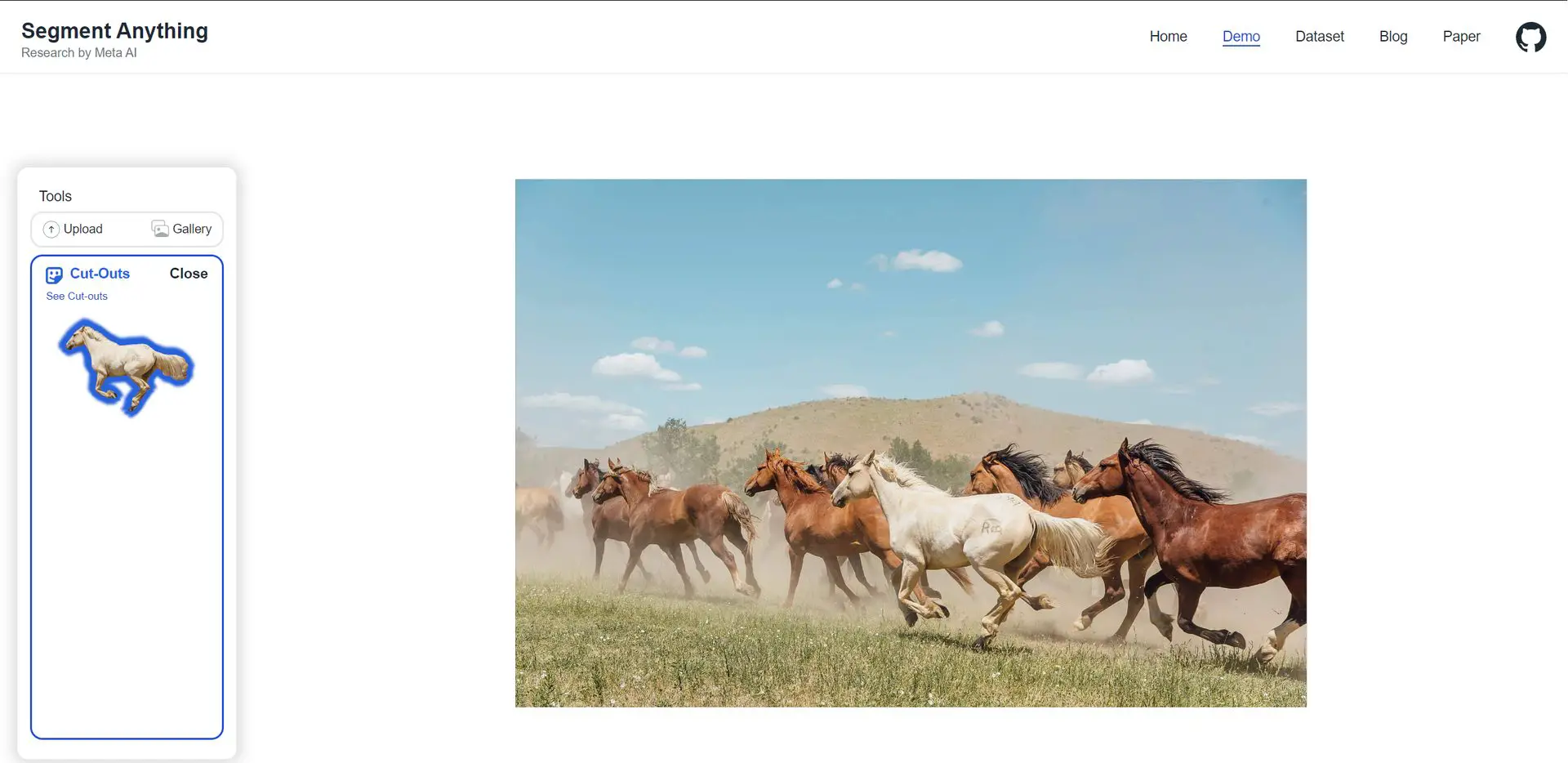

SAM er utviklet av Meta AI Research (tidligere Facebook AI Research), og den er offentlig tilgjengelig på GitHub. Du kan også prøve SAM online med en demo eller last ned datasettet (SA-1B) med 1 milliard masker og 11 millioner bilder. Modellen er ganske enkel å bruke; bare følg disse trinnene:

- Last ned demoen eller gå til Segment Anything Model-demoen.

- Last opp et bilde eller velg et i galleriet.

- Legg til og emneområder

- Masker områder ved å legge til punkter. Velg Legg til område, og velg deretter objektet. Avgrens masken ved å velge Fjern område, og velg deretter området.

Fullfør deretter oppgaven som du vil!

For mer informasjon, klikk her..

Bilde høflighet: Meta

AI 101

Er du ny på AI? Du kan fortsatt sette deg på AI-toget! Vi har laget en detaljert AI-ordliste for de mest brukte termer for kunstig intelligens og forklare grunnleggende om kunstig intelligens samt risikoer og fordeler ved AI. Bruk dem gjerne. Læring hvordan du bruker AI er en game changer! AI-modeller vil forandre verden.

AI-verktøy vi har gjennomgått

Nesten hver dag dukker et nytt verktøy, modell eller funksjon opp og endrer livene våre, som den nye OpenAI ChatGPT-plugins, og vi har allerede anmeldt noen av de beste:

- Tekst-til-tekst AI-verktøy

Vil du lære hvordan bruke ChatGPT effektivt? Vi har noen tips og triks for deg uten å bytte til Chat GPT Plus! Når du vil bruke AI-verktøyet, kan du få feil som "ChatGPT er på kapasitet akkurat nå" og "for mange forespørsler på 1 time prøv igjen senere". Ja, de er virkelig irriterende feil, men ikke bekymre deg; vi vet hvordan vi skal fikse dem. Er ChatGPT plagiat gratis? Det er et vanskelig spørsmål å finne et enkelt svar. Hvis du er redd for plagiering, bruk gjerne AI plagiatkontrollere. Du kan også sjekke andre AI chatbots og AI essay forfattere for bedre resultater.

- Tekst-til-bilde AI-verktøy

Mens det fortsatt er noen debatter om kunstig intelligens-genererte bilder, folk leter fortsatt etter beste AI-kunstgeneratorer. Vil AI erstatte designere? Fortsett å lese og finn ut.

- Andre AI-verktøy

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://dataconomy.com/2023/04/sam-model-meta-segment-anything-model-mask/

- :er

- $OPP

- 1

- 11

- a

- evne

- I stand

- Om oss

- adgang

- tilbehør

- Ifølge

- oppnår

- tvers

- Ytterligere

- påvirke

- Etter

- landbruk

- AI

- ai kunst

- ai forskning

- AI-drevet

- mål

- algoritmer

- allerede

- beløp

- beløp

- analyse

- analysere

- og

- dyr

- besvare

- forutse

- opptredener

- søknader

- tilnærming

- tilnærminger

- hensiktsmessig

- AR

- AR-briller

- ER

- AREA

- områder

- rundt

- Kunst

- kunstig

- kunstig intelligens

- AS

- At

- Automatisere

- tilgjengelig

- tilbake

- bakgrunn

- BE

- før du

- bak

- være

- benchmarks

- nytte

- Fordeler

- BEST

- Bedre

- mellom

- Milliarder

- biologi

- grenser

- Eske

- bokser

- gjennombrudd

- nett~~POS=TRUNC leseren~~POS=HEADCOMP

- by

- beregnet

- CAN

- Kan få

- evner

- Kapasitet

- kategorier

- viss

- utfordrende

- endring

- Endringer

- ChatGPT

- sjekk

- Velg

- klikk

- klær

- Samle

- vanligvis

- fullføre

- komplekse

- kompromiss

- datamaskin

- Datamaskin syn

- konstruksjon

- kunne

- dekker

- prosessor

- skape

- opprettet

- skaper

- Opprette

- Kreativ

- kritisk

- avgjørende

- dato

- datasett

- Dato

- dag

- Dager

- håndtering

- Tilbud

- Demo

- demonstrerer

- dybde

- Til tross for

- detaljert

- Gjenkjenning

- utviklet

- forskjellig

- oppdage

- Mangfold

- domene

- domener

- ikke

- nedlasting

- Tidlig

- enklere

- lett

- redigering

- Effektiv

- effektivt

- effektivitet

- innsats

- enten

- muliggjøre

- muliggjør

- entusiaster

- miljøer

- feil

- spesielt

- ESSAY

- Eter (ETH)

- Selv

- Hver

- hver dag

- eksempel

- eksisterende

- finnes

- Forklar

- Face

- ansikter

- bønder

- Trekk

- Egenskaper

- felt

- Felt

- Finn

- Først

- Fix

- fleksibilitet

- følge

- mat

- Til

- tidligere

- funnet

- Fundament

- Gratis

- fra

- fullt

- fundamental

- framtid

- Galleri

- spill

- gaming

- generere

- få

- Gi

- gitt

- briller

- Go

- veilede

- Hår

- håndtere

- hender

- Hard

- Ha

- hjelpe

- nyttig

- Høy

- høykvalitets

- Hvordan

- Hvordan

- HTTPS

- menneskelig

- identifisere

- bilde

- bildesegmentering

- bilder

- pålagt

- imponerende

- in

- inkludere

- indikerer

- individuelt

- informasjon

- inngang

- instruksjoner

- Intelligens

- interaksjon

- interaktiv

- utstedelse

- IT

- DET ER

- jpg

- Hold

- Vet

- kunnskap

- stor

- storskala

- største

- LÆRE

- læring

- lettvekt

- i likhet med

- begrensninger

- Bor

- ser

- mange

- Kart

- maske

- masker

- massive

- max bredde

- midler

- Møt

- bare

- Flett

- Meta

- metoder

- kunne

- millioner

- modell

- modeller

- mer

- Videre

- mest

- Motivasjon

- MS

- flere

- Trenger

- Ny

- nlp

- roman

- objekt

- Objektdeteksjon

- gjenstander

- få

- of

- on

- ONE

- på nett

- rekkefølge

- Annen

- skisserer

- utkonkurrerer

- produksjon

- Spesielt

- Ansatte

- ytelse

- person

- planter

- plato

- Platon Data Intelligence

- PlatonData

- Point

- poeng

- Pops

- potensiell

- kraftig

- Før

- Problem

- problemer

- prosess

- produsere

- fagfolk

- prosjekt

- ordentlig

- gi

- offentlig

- formål

- kvalitet

- spørsmål

- raskt

- område

- Lesning

- ekte

- virkelige verden

- sanntids

- realistisk

- nylig

- anerkjennelse

- gjenkjenne

- redusere

- avgrense

- Refleksjoner

- om

- regioner

- fjerne

- erstatte

- representere

- forespørsler

- krever

- påkrevd

- behov

- forskning

- Svare

- Resultater

- Avslørt

- anmeldt

- Revolusjonere

- robusthet

- s

- Sam

- scenarier

- scene

- Scener

- forskere

- segmentet

- segmentering

- velge

- separering

- flere

- Form

- figurer

- bør

- Enkelt

- simulering

- enkelt

- størrelser

- ferdighet

- So

- løsning

- LØSE

- løse

- noen

- Kilder

- spesifikk

- fart

- Steps

- Still

- rett fram

- sterk

- emne

- slik

- tilsyn

- Ta

- Oppgave

- oppgaver

- lag

- Teknologi

- Det

- De

- Området

- Fremtiden

- Galleriet

- verden

- deres

- Dem

- Disse

- ting

- tidkrevende

- tips

- tips og triks

- til

- verktøy

- verktøy

- Sporing

- trent

- Kurs

- overføre

- Transform

- Usikkerhet

- forståelse

- unik

- bruke

- Brukere

- bruke

- variasjon

- ulike

- Kjøretøy

- video

- videoer

- virtuelle

- syn

- Vei..

- måter

- web

- nettleser

- VI VIL

- Hva

- Hva er

- hvilken

- mens

- HVEM

- bred

- Bred rekkevidde

- vil

- med

- uten

- Arbeid

- verden

- Din

- zephyrnet