Hvorfor og hvordan skal du lære "Produktiv datavitenskap"?

Hvorfor og hvordan skal du lære "Produktiv datavitenskap"?

Hva er Productive Data Science og hva er noen av dens komponenter?

Bildekilde: Pixabay (Gratis bilde)

Effektivitet i datavitenskapelig arbeidsflyt

Datavitenskap og maskinlæring kan praktiseres med ulik grad av effektivitet og produktivitet. Uavhengig av bruksområde eller spesialisering, bør en dataforsker – nybegynner eller erfaren profesjonell – bestrebe seg på å forbedre hans/hennes effektivitet i alle aspekter av typiske datavitenskapelige oppgaver,

- Statistisk analyse,

- visualisering,

- modellvalg, funksjonsteknikk,

- kodekvalitetstesting, modularisering,

- parallell behandling,

- enkel web-app-implementering

Bildekilde: Pixabay (Gratis bilde)

Dette betyr å utføre alle disse oppgavene,

- i høyere hastighet

- med raskere feilsøking

- på en synkronisert måte

- ved å dra full nytte av alle tilgjengelige maskinvareressurser

Hva bør du forvente å lære i denne prosessen?

La oss forestille oss at noen lærer en "Produktiv datavitenskap” kurs eller skrive en bok om det — ved å bruke Python som språkrammeverket. Hva bør de typiske forventningene være til et slikt kurs eller en slik bok?

Bildekilde: Pixabay (Gratis bilde)

Kurset/boka bør være beregnet på de som ønsker det hoppe over standardmåten å utføre datavitenskap og maskinlæringsoppgaver og utnytte hele spekteret av Python datavitenskapelige økosystem for et mye høyere produktivitetsnivå.

Lesere bør læres hvordan de skal se etter ineffektivitet og flaskehalser i standardprosessen og hvordan de kan tenke utover boksen.

Automatisering av repeterende datavitenskapelige oppgaver er en sentral tankegang som leserne vil utvikle ved å lese denne boken. I mange tilfeller vil de også lære hvordan de kan utvide den eksisterende kodingspraksisen til å håndtere større datasett med høy effektivitet ved hjelp av avanserte programvareverktøy som allerede finnes i Python-økosystemet, men som ikke undervises i noen standard datavitenskap.

Dette bør ikke være en vanlig Python-kokebok som lærer standardbiblioteker som Numpy eller Pandas.

Den bør heller fokusere på nyttige teknikker som hvordan måle minnefotavtrykket og utførelseshastigheten av ML-modeller, kvalitetstest en datavitenskapspipeline, modularisere en datavitenskapspipeline for apputvikling osv. Den bør også dekke Python-biblioteker som er veldig nyttige for Automatisere og akselererer de daglige oppgavene til enhver dataforsker.

Videre bør den berøre verktøy og pakker som hjelper en dataforsker takle store og komplekse datasett på en langt mer optimal måte enn hva som ville vært mulig ved å følge standard Python datavitenskapsteknologisk visdom.

Noen spesifikke ferdigheter å mestre

Bildekilde: Pixabay (Gratis bilde)

For å sette ting konkret, la oss oppsummere noen spesifikke ferdigheter å mestre for å lære og øve Produktiv datavitenskap. Jeg har også prøvd å legge inn lenkene til noen representative artikler som passer til hver ferdighet som referanse.

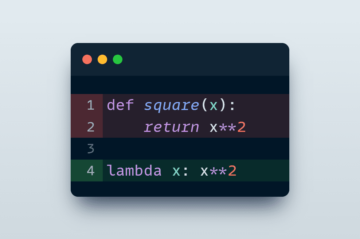

- Hvordan skrive rask og effektiv kode for datavitenskap/ML og hvordan måle hastigheten og effektiviteten deres (se denne artikkelen)

- Hvordan bygge modulariserte og uttrykksfulle datavitenskapspipelines for å forbedre produktiviteten (se denne artikkelen)

- Hvordan skrive testmoduler for datavitenskap og ML-modeller (se denne artikkelen)

- Hvordan håndtere store og komplekse datasett effektivt (noe som ville vært vanskelig med tradisjonelle DS-verktøy)

- Hvordan fullt ut utnytte GPU og flerkjerneprosessorer for alle typer datavitenskap og analyseoppgaver, og ikke bare for spesialisert dyplæringsmodellering (se denne artikkelen)

- Hvordan lage raske GUI-apper for demoen av en datavitenskap/ML-idé eller modellinnstilling (se denne artikkelen), eller hvordan du enkelt (og raskt) kan distribuere ML-modeller og dataanalysekode på app-nivå (se denne artikkelen)

En ideell bok om dette emnet vil...

Bildekilde: Pixabay (Gratis bilde)

- Lær hvordan du ser etter ineffektivitet og flaskehalser i standard datavitenskapskode og hvordan du kan tenke utover boksen for å løse disse problemene.

- Lær hvordan du skriver modularisert, effektiv dataanalyse og maskinlæringskode for å forbedre produktiviteten i en rekke situasjoner – utforskende dataanalyse, visualisering, dyp læring, etc.

- Dekker et bredt spekter av sideemner som programvaretesting, modulutvikling, GUI programmering, ML-modellimplementering som web-app, som er uvurderlige ferdigheter for spirende dataforskere å ha og som er vanskelig å finne samlet i en standard datavitenskapsbok.

- Dekke parallell databehandling (f.eks. Dask, Ray), skalerbarhet (f.eks. Vaex, Modin), og GPU-drevet datavitenskapsstabel (RAPIDS) med praktiske eksempler.

- Utsett og veiled leserne til et større og stadig voksende Python-økosystem av datavitenskapelige verktøy som er koblet til de bredere aspektene av software engineering og distribusjon på produksjonsnivå.

Et konkret eksempel: GPU-drevet og distribuert datavitenskap

Mens bruken av GPUer og distribuert databehandling er mye diskutert i akademiske og forretningskretser for kjerne AI/ML-oppgaver, har de funnet mindre dekning i verktøyet for vanlige datavitenskap og datateknikkoppgaver. Imidlertid kan bruk av GPU-er for vanlige daglige statistiske analyser eller andre datavitenskapelige oppgaver gå en lang vei mot å bli det velkjente "Produktiv dataforsker".

For eksempel RAPIDS -pakken med programvarebiblioteker og API -er gi deg - en vanlig datavitenskapsmann (og ikke nødvendigvis en dypt lærende utøver) - muligheten og fleksibiliteten til å utføre ende-til-ende datavitenskap og analyserørledninger helt på GPUer.

Bildekilde: Forfatter opprettet collage

Når de brukes selv med en beskjeden GPU, viser disse bibliotekene en bemerkelsesverdig forbedring i hastighet i forhold til deres vanlige Python-motstykker. Naturligvis bør vi omfavne disse når vi kan Produktiv datavitenskap arbeidsflyt.

På samme måte er det utmerkede muligheter for åpen kildekode til å gå utover grensene for enkeltkjernenaturen til Python-språket og omfavne det parallelle databehandlingsparadigmet uten å skifte bort fra den typiske dataforsker-personen.

Bildekilde: Forfatter opprettet collage

Oppsummering

Vi diskuterte verktøyene og kjernekomponentene til en Produktiv datavitenskap arbeidsflyt. Vi forestilte oss hva et ideelt kurs eller en ideell bok om dette emnet ville tilby leserne. Vi kom inn på noen konkrete eksempler og illustrerte fordelene. Noen relaterte ressurser ble også gitt i sammenheng med ferdigheter å mestre.

Du kan sjekke forfatterens GitHub repositories for kode, ideer og ressurser innen maskinlæring og datavitenskap. Hvis du, som meg, brenner for AI / maskinlæring / datavitenskap, må du gjerne gjøre det legg meg på LinkedIn or Følg meg på Twitter.

original. Ompostet med tillatelse.

Relatert:

| Topphistorier siste 30 dager | |||||

|---|---|---|---|---|---|

|

|

||||

Kilde: https://www.kdnuggets.com/2021/07/learn-productive-data-science.html

- "

- &

- Fordel

- Alle

- analyse

- analytics

- app

- Apputvikling

- Søknad

- apps

- AREA

- artikler

- Blogg

- Eske

- bygge

- virksomhet

- saker

- kode

- Koding

- databehandling

- Corp

- dato

- dataanalyse

- datavitenskap

- dataforsker

- dyp læring

- utvikle

- Utvikling

- Regissør

- distribuert databehandling

- økosystem

- effektivitet

- ingeniør

- Ingeniørarbeid

- Ingeniører

- etc

- gjennomføring

- FAST

- Trekk

- fleksibilitet

- Fokus

- Rammeverk

- Gratis

- fullt

- Gull

- GPU

- GPU

- veilede

- praktisk

- maskinvare

- Høy

- Hvordan

- Hvordan

- HTTPS

- Hundrevis

- Tanken

- bilde

- IT

- nøkkel

- Språk

- stor

- LÆRE

- læring

- Nivå

- Lang

- maskinlæring

- måle

- medium

- ML

- modell

- modellering

- tilby

- på nett

- åpen

- åpen kildekode

- Muligheter

- Alternativ

- Annen

- paradigmet

- innlegg

- produktivitet

- Python

- kvalitet

- område

- lesere

- Lesning

- Ressurser

- skalerbarhet

- Vitenskap

- forskere

- ferdigheter

- Software

- Testing av programvare

- LØSE

- fart

- Stories

- Undervisning

- Teknologi

- Testing

- topp

- temaer

- berøre

- us

- verktøy

- verktøyet

- visualisering

- Hva er

- HVEM

- arbeidsflyt

- skriving

- X

- år