En teknisk artikkel med tittelen "WWW: What, When, Where to Compute-in-Memory" ble publisert av forskere ved Purdue University.

Abstrakt:

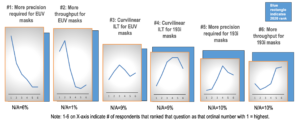

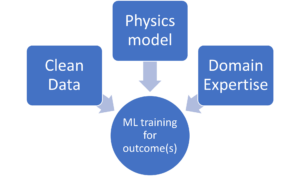

"Compute-in-memory (CiM) har dukket opp som en overbevisende løsning for å redusere høye kostnader for dataflytting i von Neumann-maskiner. CiM kan utføre massivt parallelle generell matrisemultiplikasjonsoperasjoner (GEMM) i minnet, den dominerende beregningen i Machine Learning (ML) inferens. Men ombruk av minne for databehandling stiller nøkkelspørsmål om 1) Hvilken type CiM som skal brukes: Gitt en mengde analoge og digitale CiM-er, er det nødvendig å bestemme deres egnethet fra systemperspektiv. 2) Når skal man bruke CiM: ML-inferens inkluderer arbeidsbelastninger med en rekke minne- og datakrav, noe som gjør det vanskelig å identifisere når CiM er mer fordelaktig enn standard prosesseringskjerner. 3) Hvor skal CiM integreres: Hvert minnenivå har forskjellig båndbredde og kapasitet, som påvirker databevegelsen og lokalitetsfordelene ved CiM-integrasjon.

I denne artikkelen utforsker vi svar på disse spørsmålene angående CiM-integrasjon for ML-inferensakselerasjon. Vi bruker Timeloop-Accelergy for tidlig systemnivåevaluering av CiM-prototyper, inkludert både analoge og digitale primitiver. Vi integrerer CiM i forskjellige cache-minnenivåer i en Nvidia A100-lignende baseline-arkitektur og skreddersyr dataflyten for ulike ML-arbeidsbelastninger. Eksperimentene våre viser at CiM-arkitekturer forbedrer energieffektiviteten, og oppnår opptil 0.12x lavere energi enn den etablerte grunnlinjen med INT-8-presisjon, og opptil 4x ytelsesforbedringer med vektsammenfletting og duplisering. Det foreslåtte arbeidet gir innsikt i hvilken type CiM som skal brukes, og når og hvor det skal integreres optimalt i hurtigbufferhierarkiet for GEMM-akselerasjon."

Finn det teknisk papir her. Publisert desember 2023 (preprint).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty og Kaushik Roy. "WWW: Hva, når, hvor skal man regne i minnet." arXiv forhåndstrykk arXiv:2312.15896 (2023).

Relatert Reading

Øker AI-energieffektiviteten med databehandling i minnet

Hvordan behandle zettascale arbeidsbelastninger og holde seg innenfor et fast strømbudsjett.

Modellering av beregninger i minnet med biologisk effektivitet

Generativ AI tvinger brikkeprodusenter til å bruke dataressurser mer intelligent.

SRAM In AI: The Future Of Memory

Hvorfor SRAM blir sett på som et kritisk element i nye og tradisjonelle dataarkitekturer.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- : har

- :er

- :hvor

- $OPP

- 1

- 2023

- a

- akselerasjon

- oppnå

- AI

- lindre

- an

- og

- svar

- arkitektur

- AS

- At

- Båndbredde

- Baseline

- gunstig

- Fordeler

- både

- budsjett

- by

- cache

- CAN

- Kapasitet

- overbevisende

- beregningen

- Beregn

- Kostnader

- kritisk

- dato

- Desember

- bestemme

- forskjellig

- vanskelig

- digitalt

- dominerende

- hver enkelt

- Tidlig

- effektivitet

- element

- dukket

- energi

- energieffektivitet

- etablert

- evaluering

- eksperimenter

- utforske

- fikset

- Til

- Krefter

- fra

- framtid

- inntjening

- general

- gitt

- her.

- hierarki

- Høy

- Men

- HTTPS

- identifisere

- forbedre

- in

- inkluderer

- Inkludert

- innsikt

- integrere

- integrering

- inn

- IT

- jpg

- nøkkel

- læring

- Nivå

- nivåer

- lavere

- maskin

- maskinlæring

- maskiner

- Making

- massivt

- Matrix

- Minne

- ML

- mer

- bevegelse

- mangfold

- nødvendig

- Ny

- Nvidia

- of

- on

- åpen

- Drift

- vår

- Papir

- Parallel

- utføre

- ytelse

- perspektiv

- plato

- Platon Data Intelligence

- PlatonData

- positurer

- makt

- Precision

- prosess

- prosessering

- foreslått

- prototyper

- gir

- publisert

- spørsmål

- om

- Krav

- forskere

- Ressurser

- roy

- Vis

- løsning

- Standard

- opphold

- egnethet

- Systemer

- Teknisk

- enn

- Det

- De

- Fremtiden

- deres

- Disse

- denne

- tittelen

- til

- tradisjonelle

- typen

- universitet

- bruke

- variasjon

- ulike

- sett

- av

- var

- we

- vekt

- Hva

- når

- med

- innenfor

- Arbeid

- zephyrnet