Blant de viktigste nyere innovasjonene for å forbedre verdien og påliteligheten til store språkmodeller er Tankekjede og dets derivater inkludert Tankens tre og Graf-of-Thought.

Disse strukturene er også ekstremt verdifulle for å designe effektive Mennesker + AI arbeidsflyter for bedre tenkning.

I denne artikkelen vil jeg gi en oversikt på høyt nivå av Chain-of-Thought og deretter se på applikasjoner til AI-utvidet menneskelig intelligens.

Tankekjede

Store språkmodeller (LLMs) er generelt gode til tekstgenerering, men dårlige til alle oppgaver som involverer sekvensiell resonnement.

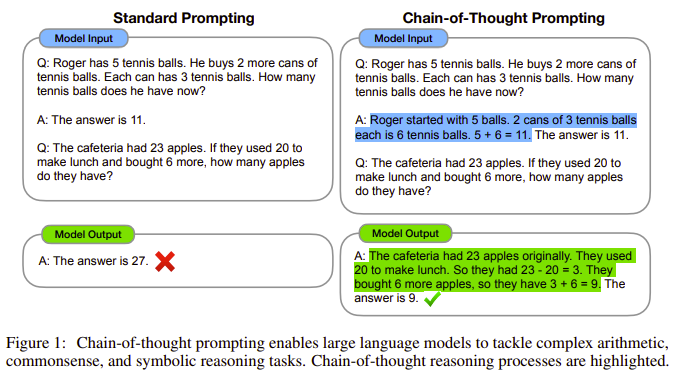

Det landemerke papiret for januar 2022 Tankekjede fremkaller resonnement i store språkmodeller la ut hvordan en tankekjede - "en serie mellomliggende resonnementtrinn" - kunne forbedre LLM-ytelsen betydelig ved resonneringsoppgaver inkludert matematikk og sunne gåter.

Du har sannsynligvis sett dette bildet fra avisen gjør rundene.

Dette konseptet ble raskt tilpasset andre applikasjoner, inkludert tidsmessig resonnement, visuelle språkmodeller, gjenfinning utvidet resonnement, og mange andre måter å forbedre ytelsen til AI-modeller på.

Tankekjede har vist seg spesielt verdifull i praktiske problemløsningsapplikasjoner. Åpenbare eksempler inkluderer medisin, lovog utdanning.

Googles PaLM og Med-PaLM inkorporerer tankekjedestrukturer, og OpenAIs GPT-4 gjør det sannsynligvis, noe som betyr at når du bruker en LLM, er disse tilnærmingene allerede innebygd.

Likevel, berømt oppfordringen "La oss ordne dette på en trinnvis måte for å være sikker på at vi har det riktige svaret" eller varianter av dette gi den beste LLM-ytelsen for mange typer oppgaver.

Evolusjon av Chain-of-Thought

En rekke innovasjoner har dukket opp ved å bygge på Chain-of-Thought.

Effektive resonneringsprosesser følger ikke nødvendigvis en enkelt bane. Dette leder til Tankens tre strukturer, beskrevet i Tankenes tre: Bevisst problemløsning med store språkmodeller.

Som vist i dette diagrammet fra artikkelen, kan Chain-of-Thought gå videre til først å velge den hyppigste veien fra flere utganger, og deretter velge fra den beste av flere veier gjennom tenkeprosessen.

Nyere utviklinger på Chain-of-Thought inkluderer det svært lovende Graf-of-Thought i tillegg til Hypergraph-of-Thought.

Nye "tenke"-strukturer vil være sentrale for generativ AI-fremgang

Chain-of-Thought og relaterte teknikker ble laget for å adressere begrensningene til LLM og forbedre deres evner.

Den fortsatte utviklingen av generative AI-modeller vil stole mye mer på denne typen strukturerte tenkningsteknikker enn beregningskapasitet eller modellstørrelse. Disse tilnærmingene har allerede aktivert små, effektive LLM-er for å oppnå ytelse som kan nærme seg de største modellene.

Chain-of-Thought og lignende modeller fører også direkte til multi-agent kjeder, der kjeder eller tankenettverk legges ut på tvers av flere oppgaveoptimaliserte modeller for å skape langt overlegne resonnementer og resultater enn det som kan oppnås innenfor en enkelt modell.

Økt intelligens er viktigere enn kunstig generell intelligens

"Teknologi bør ikke ta sikte på å erstatte mennesker, snarere forsterke menneskelige evner." — Doug Engelbart

Drivkraften bak nesten all AI-utvikling ser ut til å være å lage maskiner som kan etterligne og potensielt overgå menneskelig intelligens og evner.

Det er en forståelig ambisjon.

Men jeg er langt, mye mer interessert i hvordan AI kan øke menneskelig intelligens.

Vi kan jobbe på begge domenene samtidig.

Men i alle mulige scenarier for fremskritt mot kunstig generell intelligens, vil vi ha det bedre hvis vi har lagt minst like mye energi i bygge, lære og anvende Human + AI-tenkestrukturer.

Humans + AI Thinking Workflows

Begrepet Mennesker + AI er kjernen i arbeidet mitt.

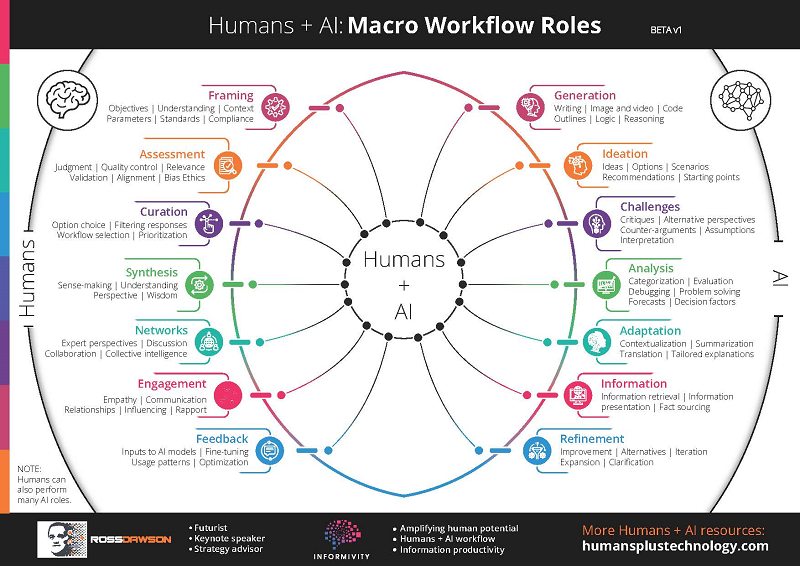

Rammeverket nedenfor jeg opprettet for et år siden viser min tidlige innramming av "Mennesker + AI arbeidsflyter", der mennesker og AI sekvensielt tar opp oppgavene de er best egnet til.

Hvis det er godt utformet, genererer dette uunngåelig resultater som er bedre enn hva hver enkelt kunne alene.

Siden den gang har jeg gravd mer detaljert i hva som spesifikt er de beste tenkningsstrukturene for Humans + AI.

Disse vil være grunnlaget for neste fase av utvidet menneskelig intelligens.

Tankekjede for AI-forbedret menneskelig tenkning

Konseptene som strømmer fra Chain-of-Thought ble utviklet for å forbedre de frittstående egenskapene til LLM-er.

Men de viser seg også å være uhyre verdifulle for å maksimere verdien av mennesker og AI som jobber sammen.

Det finnes en rekke teknikker for å bruke Chain-of-Thought-strukturer på mennesker + AI-tenkearbeidsflyter.

AI-konsepter brukt på utvidet intelligens

LLM-er kan brukes til å foreslå hvordan oppgaver kan dekomponeres i sekvensielle (eller nettverksbaserte) elementer, med enten mennesker eller AI som identifiserer hvor menneskelige eller AI-evner kan være best egnet.

En spesifikk tilnærming er beskrevet i Menneske-i-løkken gjennom Chain-of-Thought, der "manuell korreksjon av underlogikk i begrunnelser kan forbedre LLMs resonnementytelse."

Å «ramme inn» målene, oppgaven og strukturen, som vist i arbeidsflytdiagrammet Humans + AI, driver kvaliteten på resultatene. Dette er vanligvis best overvåket av mennesker, ved å bruke flyter som AI som foreslår eller vurderer parametere.

Jeg inkorporerer disse og andre tilnærminger i et sett med "AI-Enhanced Thinking Patterns".

Mer generelt kan et bredt utvalg av AI-fremskritt, ikke bare Chain-of-Thought, brukes ekstremt nyttig for å øke menneskelig intelligens.

Jeg har tenkt å skrive en lignende artikkel om å anvende begrepene Generative motstandernettverk til Human-AI symbiotisk intelligens strukturer.

Kurs om AI-forbedret tenkning og beslutningstaking

Mitt fulle fokus i 2024 er hvordan AI kan forsterke mennesker.

En av mine sentrale aktiviteter er å kjøre et vanlig kohortkurs på Maven: AI-forbedret tenkning og beslutningstaking. Sjekk ut linken for flere detaljer.

Neste årskull starter 8. februar. Som takk for at du leser gjennom til slutten av denne artikkelen, kan du få 30 % rabatt ved å bruke kupongen: COTARTICLE 🙂.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://rossdawson.com/applying-chain-of-thought-to-ai-enhanced-human-thinking/

- : har

- :er

- :ikke

- :hvor

- 2022

- 2024

- 8

- a

- Om oss

- Oppnå

- oppnådd

- tvers

- Aktiviteter

- tilpasset

- adresse

- avansere

- fremskritt

- motstandere

- siden

- AI

- AI-modeller

- sikte

- Alle

- nesten

- alene

- allerede

- også

- am

- ambisjon

- forsterke

- an

- og

- noen

- søknader

- anvendt

- påføring

- tilnærming

- tilnærminger

- ER

- Artikkel

- kunstig

- kunstig generell intelligens

- AS

- vurdere

- At

- øke

- augmented

- BE

- vært

- bak

- under

- BEST

- Bedre

- både

- Bygning

- bygget

- men

- by

- CAN

- Kan få

- evner

- Kapasitet

- sentral

- kjede

- kjeder

- sjekk

- Cohort

- fullføre

- Beregn

- konsept

- konsepter

- fortsatte

- kunne

- kupong

- kurs

- skape

- opprettet

- Derivater

- beskrevet

- utforme

- detalj

- detaljer

- utviklet

- Utvikling

- utviklingen

- direkte

- Rabatt

- do

- gjør

- gjør

- domener

- doug

- stasjoner

- kjøring

- hver enkelt

- Tidlig

- Effektiv

- effektiv

- enten

- elementer

- dukket

- aktivert

- slutt

- energi

- forbedre

- lik

- Eter (ETH)

- Hver

- eksempler

- stige

- utmerket

- ekstremt

- famously

- langt

- Februar

- Først

- Rennende

- Flows

- Fokus

- følge

- Til

- Tving

- Foundations

- Rammeverk

- hyppig

- fra

- general

- generell intelligens

- generelt

- genererer

- generasjonen

- generative

- Generativ AI

- få

- Ha

- Hjerte

- høyt nivå

- Hvordan

- HTTPS

- menneskelig

- menneskelig intelligens

- Mennesker

- i

- JEG VIL

- identifisering

- if

- bilde

- umåtelig

- viktig

- forbedre

- bedre

- in

- inkludere

- Inkludert

- innlemme

- innlemme

- uunngåelig

- innovasjoner

- Intelligens

- hensikt

- interessert

- Mellom

- inn

- involvere

- DET ER

- Januar

- bare

- Labs

- landemerke

- Språk

- stor

- største

- føre

- Fører

- læring

- minst

- Sannsynlig

- begrensninger

- LINK

- Se

- maskiner

- mange

- Maven

- max bredde

- maksimere

- Kan..

- betyr

- modell

- modeller

- mer

- mest

- flere

- my

- nødvendigvis

- nettverk

- NeurIPS

- neste

- Antall

- mål

- Åpenbare

- of

- off

- on

- gang

- or

- Annen

- ut

- utfall

- utganger

- palm

- Papir

- parametere

- spesielt

- banen

- baner

- Ansatte

- ytelse

- fase

- plato

- Platon Data Intelligence

- PlatonData

- dårlig

- mulig

- potensielt

- Praktisk

- Problem

- problemløsning

- prosess

- Prosesser

- Progress

- lovende

- foreslår

- Bevis

- beviste

- gi

- sette

- Puslespill

- kvalitet

- raskt

- område

- heller

- Lesning

- nylig

- regelmessig

- i slekt

- pålitelighet

- avhengige

- erstatte

- ikke sant

- runder

- rennende

- scenario

- synes

- sett

- velge

- Serien

- sett

- bør

- vist

- Viser

- lignende

- enkelt

- Størrelse

- So

- løse

- spesifikk

- spesielt

- starter

- Trinn

- struktur

- strukturert

- strukturer

- i det vesentlige

- slik

- foreslår

- overlegen

- sikker

- Symbiotisk

- Oppgave

- oppgaver

- teknikker

- tekst

- tekstgenerering

- enn

- takk

- Det

- De

- deres

- deretter

- Disse

- de

- tenker

- denne

- trodde

- Gjennom

- til

- sammen

- mot

- bane

- forståelig

- bruke

- brukt

- ved hjelp av

- vanligvis

- Verdifull

- verdi

- variasjoner

- variasjon

- veldig

- Se

- var

- Vei..

- måter

- we

- VI VIL

- var

- Hva

- når

- hvilken

- bred

- vil

- med

- innenfor

- Arbeid

- arbeidsflyt

- arbeidsflyt

- arbeid

- skrive

- år

- du

- zephyrnet