Suresh er en teknologileder med dyp teknisk ekspertise innen halvledere, kunstig intelligens, cybersikkerhet, internett-of-things, maskinvare, programvare, etc. Han tilbrakte 20 år i bransjen, og fungerte sist som administrerende direktør for åpen kildekode null- stole på brikkeutvikling ved Technology Innovation Institute, Abu Dhabi, og i andre Fortune 500-halvlederselskaper som Intel, Qualcomm og MediaTek i ulike lederroller, hvor han forsket på og utviklet høyytende, energieffektive, post-kvantesikre, trygge mikrobrikker/system-på-brikker (SoCs)/akseleratorer for datasenter-, klient-, smarttelefon-, nettverks-, IoT- og AI/ML-markedene. Han bidro til Falcon LLM (rangert som nummer 1 i huggingface) og var hovedarkitekten for den tilpassede AI-maskinvareplattformen (kansellert – prioriteringer endret). Han har 15+ amerikanske patenter og har publisert/presentert på mer enn 20+ konferanser.

Suresh er en teknologileder med dyp teknisk ekspertise innen halvledere, kunstig intelligens, cybersikkerhet, internett-of-things, maskinvare, programvare, etc. Han tilbrakte 20 år i bransjen, og fungerte sist som administrerende direktør for åpen kildekode null- stole på brikkeutvikling ved Technology Innovation Institute, Abu Dhabi, og i andre Fortune 500-halvlederselskaper som Intel, Qualcomm og MediaTek i ulike lederroller, hvor han forsket på og utviklet høyytende, energieffektive, post-kvantesikre, trygge mikrobrikker/system-på-brikker (SoCs)/akseleratorer for datasenter-, klient-, smarttelefon-, nettverks-, IoT- og AI/ML-markedene. Han bidro til Falcon LLM (rangert som nummer 1 i huggingface) og var hovedarkitekten for den tilpassede AI-maskinvareplattformen (kansellert – prioriteringer endret). Han har 15+ amerikanske patenter og har publisert/presentert på mer enn 20+ konferanser.

Suresh tjener også aktivt i en lederstilling hos RISC-V International hvor han leder Trusted Computing Group for å utvikle RISC-V konfidensiell databehandlingsevne og leder AI/ML Group for å utvikle RISC-V maskinvareakselerasjon for AI/ML arbeidsbelastninger som f.eks. Transformer Large Language Models brukt i ChatGPT-typene applikasjoner. Han gir også råd til startups og venturekapitalfirmaer om investeringsbeslutningsstøtte, produktstrategi, teknologidue diligence, etc.

Han tok en MBA fra INSEAD, en MS fra Birla Institute of Technology & Science Pilani, et Systems Engineering-sertifikat fra MIT, et AI-sertifikat fra Stanford og et funksjonelt sikkerhetssertifikat for biler fra TÜV SÜD.

Fortell oss om din bedrift

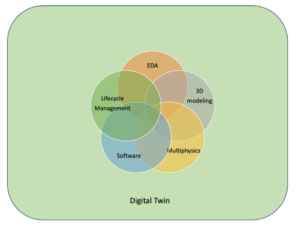

"Mastiṣka AI” (Mastiṣka betyr hjerne på sanskrit) er et AI-selskap som fokuserer på å bygge hjernelignende datamaskiner for å kjøre grunnmodeller mer effektivt for morgendagens Generative AI-bruk.

Hvilke problemer løser du?

Gitt fordelene med AI/GenAI, vil etterspørselen bare øke, og det vil også bivirkningene på planeten vår. Hvordan kan vi redusere eller nøytralisere bivirkningene av AI på planeten vår? Karbonfangst og atomkraft er i riktig retning. Men vi må fundamentalt revurdere måten vi gjør AI på, er det feil måte å gjøre tonnevis av matrisemultiplikasjoner på?

Hjernen vår kan lære og gjøre mange oppgaver parallelt, i og under 10W, men hvorfor bruker disse AI-systemene 10-s megawatt for å trene modeller?

Kanskje fremtiden byr på energieffektive arkitekturer som nevromorfe arkitekturer og piggende nevrale nettverksbaserte transformatorer som er nærmest den menneskelige hjernen, som kan forbruke 100-1000 ganger lavere energi, og dermed redusere kostnadene ved å bruke AI, og dermed demokratisere den og spare våre planet.

De nåværende utfordringene vi står overfor med AI er a) tilgjengelighet, b) tilgjengelighet, c) rimelig og d) miljøsikkerhet sammen med noen anbefalinger for å takle dem.

Hvis vi ser for oss i fremtiden, blir noen nyttige AGI-konsepter demonstrert i filmen «HER», der karakteren «Samantha» – en samtaleagent som er naturlig, forstår følelser, viser empati, er en fantastisk copilot på jobb – og løper videre håndholdte enheter hele dagen, så må vi kanskje løse utfordringene nedenfor akkurat nå.

Problem 1: Å trene en LLM kan koste alt fra 150K til 10+ millioner dollar, og det lar bare de med dypere lommer utvikle AI. På toppen er slutningskostnadene også enorme (koster 10 ganger mer enn et nettsøk)

—> Vi må forbedre energieffektiviteten til modeller/maskinvare for å demokratisere AI til fordel for menneskeheten.

Problem 2: Å kjøre enorme AI-modeller for samtaleagenter eller anbefalingssystemer, setter en toll på miljøet når det gjelder strømforbruk og kjøling.

—> Vi må forbedre energieffektiviteten til modeller/maskinvare for å redde planeten vår for barna våre.

Problem 3: Den menneskelige hjernen er i stand til og kan multitaske, men bruker bare 10 watt i stedet for megawatt.

—> Kanskje vi burde bygge maskiner som hjernen vår og ikke de vanlige matrisemultiplikatorene raskere.

Menneskeheten kan bare trives med bærekraftige innovasjoner, og ikke ved å hogge ned all skog og koke havene i innovasjonens navn. Vi må beskytte planeten vår for barnas velferd og fremtidige generasjoner som kommer...

Hvilke bruksområder er dine sterkeste?

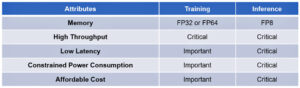

Opplæring og inferencing av transformator (og fremtidig nevral arkitektur) baserte fundamentmodeller, med 50-100 ganger mer energieffektivt sammenlignet med dagens GPU-baserte løsninger.

Hva holder kundene oppe om natten?

Problemer for kunder som for øyeblikket bruker andre produkter:

Strømforbruk for å trene humungous språkmodeller er utenfor taket, for eksempel å trene en 13B parameter LLM på 390B teksttokens på 200 GPUer i 7 dager koster $151,744 XNUMX (Kilde: HuggingFace ny treningsklynge-tjenesteside – https://lnkd.in/g6Vc5cz3). Og enda større modeller med 100+B-parametere koster $10+M bare å trene. Deretter betaler du for slutninger hver gang en ny forespørsel kommer.

Vannforbruk til kjøling, forskere ved University of California, Riverside estimerte miljøpåvirkningen av ChatGPT-lignende tjenester, og sier at den sluker opp 500 milliliter vann (nær det som er i en 16-unse vannflaske) hver gang du spør om en serie med mellom 5 og 50 forespørsler eller spørsmål. Utvalget varierer avhengig av hvor serverne er plassert og sesong. Estimatet inkluderer indirekte vannforbruk som selskapene ikke måler – for eksempel å kjøle ned kraftverk som forsyner datasentrene med strøm. (Kilde: https://lnkd.in/gybcxX8C)

Problemer for ikke-kunder av nåværende produkter:

Har ikke råd til CAPEX å kjøpe maskinvare

Har ikke råd til å bruke skytjenester

Kan ikke innovere eller utnytte AI – sitter fast med tjenestemodellen som eliminerer ethvert konkurransefortrinn

Hvordan ser konkurranselandskapet ut og hvordan skiller man?

- GPU-er dominerer treningsområdet, selv om spesialiserte ASIC-er også konkurrerer i dette segmentet

- Cloud & Edge-inferens har for mange tilgjengelige alternativer

Digital, Analog, Photonic - you name it folk prøver å takle det samme problemet.

Kan du dele tankene dine om den nåværende tilstanden til brikkearkitektur for AI/ML, altså hva ser du på som de viktigste trendene og mulighetene akkurat nå?

Følgende trender:

Trend 1: For 10 år siden blomstret maskinvareaktivert dyplæring, og nå hemmer den samme maskinvaren fremgang. På grunn av de enorme kostnadene for maskinvare og strømkostnader for å kjøre modeller, har det blitt en utfordring å få tilgang til maskinvaren. Bare selskaper med dype lommer har råd til disse og er i ferd med å bli monopoler.

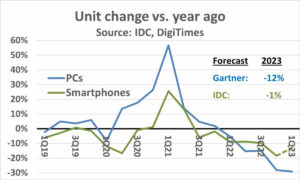

Trend 2: Nå som disse modellene er der, må vi bruke dem til praktiske formål slik at slutningsbelastningen vil øke, slik at CPUer med AI-akseleratorer kan komme frem i rampelyset igjen.

Trend 3: Startups prøver å komme opp med alternative flytende tallrepresentasjoner som det tradisjonelle IEEE-formatet – som logaritmisk og posit-basert – er bra, men ikke nok. PPA$ design plass optimering eksploderer når vi prøver å optimalisere en og annen går for en kast.

Trend 4: Industrien beveger seg bort fra den tjenestebaserte modellen av AI til å være vert for sine egne private modeller i sine egne lokaler – men tilgang til maskinvare er en utfordring på grunn av mangel på forsyninger, sanksjoner osv.

Nåværende tilstand:

Tilgjengelighet av maskinvare og data drev veksten av AI for 10 år siden, nå hindrer den samme maskinvaren den - la meg forklare

Helt siden CPU-er hadde det elendig og GPU-er ble brukt til å gjøre AI, har mange ting skjedd

Bedrifter har adressert 4 segmenter av AI/ML, nemlig – 1) skyopplæring, 2) skyslutning, 3) kantslutning og 4) kantopplæring (føderert læring for personvernsensitive applikasjoner).

Digital og analog

Opplæringssiden – en mengde selskaper som driver med GPU-er, kundeakseleratorer basert på RISC-V, brikker i wafer-skala (850K-kjerner) og så videre der tradisjonelle CPU-er mangler (deres generelle formål). Inferensside – NN-akseleratorer er tilgjengelige fra alle produsenter, i smarttelefoner, bærbare datamaskiner og andre kantenheter.

Analoge memristor-baserte arkitekturer dukket også opp for en tid siden.

Vi tror CPU-er kan være veldig gode til å konkludere hvis vi forbedrer den med akselerasjon som matriseutvidelser

RISC-V-siden av ting:

På RISC-V-siden utvikler vi akseleratorer for matriseoperasjoner og andre ikke-lineære operasjoner for å eliminere mulige flaskehalser for transformatorarbeidsbelastninger. Von Neumann-flaskehalser blir også adressert ved å bygge minner nærmere databehandling, noe som til slutt gjør CPUer med AI-akselerasjon til det riktige valget for inferencing.

Muligheter:

Det finnes unike muligheter for å fylle ut markedet for fundamentmodeller. Eksempel – OpenAI har nevnet at de ikke var i stand til å sikre nok AI-databehandling (GPUer) til å fortsette å presse ChatGPT-tjenestene deres ... og nyhetsrapportene om strømkostnader på 10 ganger av vanlig internettsøk og 500 ml vann for å kjøle ned systemene for hvert søk. Det er et marked å fylle ut her - det er ikke nisje, men hele markedet som vil demokratisere AI og takle alle utfordringene nevnt ovenfor - a) tilgjengelighet, b) tilgjengelighet, c) rimelig og d) miljøsikkerhet

Hvilke nye funksjoner/teknologi jobber du med?

Vi bygger hjerne som datamaskin ved å utnytte nevromodrfiske teknikker og skreddersy modeller for å dra nytte av den energieffektive maskinvaren, gjenbruk av tilgjengelige åpne rammer

Hvordan ser du for deg at AI/ML-sektoren vil vokse eller endre seg i løpet av de neste 12-18 månedene?

Ettersom etterspørselen etter GPU-er har blitt mindre (koster som $30 XNUMX), pluss at enkelte deler av verden står overfor sanksjoner for å kjøpe disse GPU-ene, føler noen deler av verden at de er frosset i AI-forskning og -utvikling uten tilgang til GPUer. Alternative maskinvareplattformer kommer til å fange markedet.

Modeller vil kanskje begynne å krympe - tilpassede modeller eller til og med fundamentalt vil informasjonstettheten vokse

Samme spørsmål, men hva med veksten og endringen de neste 3-5 årene?

a) CPUer med AI-utvidelser vil fange AI-slutningsmarkedet

b) Modeller vil bli smidige, og parametere vil falle ut når informasjonstettheten forbedres fra 16 % til 90 %

c) Energieffektiviteten forbedres, CO2-fotavtrykket reduseres

d) Nye arkitekturer kommer opp

e) maskinvarekostnader og energikostnader går ned, slik at adgangsbarrieren for mindre selskaper til å lage og trene modeller blir rimelig

f) folk snakker om pre-AGI-øyeblikk, men min referanse vil være den karakteriserte Samantha (konversasjons-AI) i filmen "henne".. Det er kanskje usannsynlig gitt de høye kostnadene ved å skalere opp

Hva er noen av utfordringene som kan påvirke eller begrense veksten i AI/ML-sektoren?

a) Tilgang til maskinvare

b) Energikostnader og kjølekostnader og miljøskader

Les også:

CEO Intervju: David Moore fra Pragmatic

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 1

- 10

- 150

- 20

- 20 år

- 200

- 50

- 500

- 7

- a

- I stand

- Om oss

- ovenfor

- Abu Dhabi

- akselerasjon

- akseleratorer

- adgang

- tilgjengelighet

- aktivt

- adresse

- adressert

- adressering

- Fordel

- Affairs

- en gang til

- Agent

- agenter

- AGI

- siden

- AI

- AI-modeller

- ai forskning

- AI-systemer

- ai brukstilfeller

- AI / ML

- justert

- Alle

- tillate

- tillater

- langs

- også

- alternativ

- utrolig

- an

- og

- En annen

- noen

- hvor som helst

- Søknad

- søknader

- arkitektur

- ER

- områder

- ankommer

- kunstig

- kunstig intelligens

- AS

- Asics

- spør

- At

- automotive

- tilgjengelighet

- tilgjengelig

- borte

- b

- barriere

- basert

- BE

- bli

- blir

- bli

- vært

- være

- tro

- under

- benchmark

- nytte

- Fordeler

- mellom

- Beyond

- flaskehalser

- bundet

- Brain

- hjerner

- bygge

- Bygning

- men

- kjøpe

- by

- california

- CAN

- kansellert

- evne

- stand

- hovedstad

- fangst

- karbon

- karbonfangst

- saker

- Sentre

- konsernsjef

- CEO intervju

- sertifikat

- utfordre

- utfordringer

- endring

- endret

- endring

- karakter

- ChatGPT

- Barn

- chip

- chips

- valg

- Chopra

- kunde

- Lukke

- nærmere

- Cloud

- Cluster

- co2

- Kom

- Selskaper

- Selskapet

- sammenlignet

- konkurrere

- konkurranse

- Beregn

- datamaskin

- datamaskiner

- databehandling

- konsepter

- konferanser

- forbruke

- forbruk

- fortsette

- bidratt

- conversational

- samtale AI

- Kul

- Kostnad

- Kostnader

- kunne

- skape

- Gjeldende

- Nåværende situasjon

- I dag

- skikk

- kunde

- Kunder

- skjæring

- Cybersecurity

- dato

- datasentre

- Datacenter

- David

- dag

- Dager

- avgjørelse

- dyp

- dyp læring

- dypere

- Etterspørsel

- demokrat

- Demokratisering

- demonstrert

- tetthet

- avhengig

- utforming

- utvikle

- utviklet

- utvikle

- Utvikling

- Enheter

- Dhabi

- differensiere

- aktsomhet

- retning

- Regissør

- do

- gjør

- gjør

- dollar

- ikke

- ned

- dr

- Drop

- to

- opptjent

- Edge

- effekter

- effektivitet

- effektiv

- effektivt

- elektrisitet

- strømforbruk

- eliminere

- eliminerer

- følelser

- Empati

- energi

- energieffektivitet

- Ingeniørarbeid

- forbedre

- nok

- Hele

- entry

- Miljø

- miljømessige

- se for meg

- anslag

- anslått

- etc

- Eter (ETH)

- Selv

- etter hvert

- Hver

- eksempel

- utøvende

- Direktør

- eksisterer

- ekspertise

- eksploderer

- utvidelser

- Face

- vendt

- falk

- raskere

- følelse

- fyll

- bedrifter

- flytende

- fokuserte

- Fot

- Til

- forutse

- format

- Fortune

- Fundament

- rammer

- fra

- frossen

- drevet

- funksjonelle

- fundamentalt

- framtid

- general

- generasjoner

- generative

- Generativ AI

- gitt

- Go

- Går

- skal

- god

- GPU

- Gruppe

- Økende

- Vekst

- maskinvare

- Ha

- he

- derav

- her.

- Høy

- holder

- Hosting

- Hvordan

- HTTPS

- stort

- Klem ansikt

- menneskelig

- Menneskeheten

- IEEE

- if

- bilde

- Påvirkning

- forbedre

- forbedrer

- in

- I andre

- inkluderer

- Øke

- industri

- informasjon

- innovere

- Innovasjon

- innovasjoner

- i stedet

- Institute

- Intel

- Intelligens

- internasjonalt

- Internet

- Intervju

- investering

- IOT

- IT

- DET ER

- bare

- kids

- Type

- maling

- landskap

- Språk

- bærbare datamaskiner

- stor

- større

- føre

- Ledelse

- LÆRE

- læring

- la

- Leverage

- utnytte

- i likhet med

- rampelyset

- BEGRENSE

- laste

- ligger

- Se

- ser ut som

- lavere

- maskiner

- Making

- Produsent

- mange

- marked

- Markets

- Matrix

- max bredde

- Kan..

- kan være

- MBA

- me

- betyr

- midler

- måle

- Minner

- nevnt

- kunne

- millioner

- millioner dollar

- MIT

- modell

- modeller

- øyeblikk

- monopoler

- måneder

- mer

- mest

- film

- flytting

- MS

- må

- my

- navn

- nemlig

- Naturlig

- Trenger

- nettverksbasert

- nettverk

- neural

- Ny

- nyheter

- neste

- nisje

- natt

- kvikk

- nå

- kjernekraft

- Kjernekraft

- Antall

- havene

- of

- on

- ONE

- bare

- åpen

- åpen kildekode

- OpenAI

- Drift

- Muligheter

- optimalisering

- Optimalisere

- alternativer

- or

- Annen

- vår

- ut

- egen

- side

- Parallel

- parameter

- parametere

- deler

- Patenter

- Betale

- Ansatte

- kanskje

- planet

- planter

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- overflod

- i tillegg til

- lommer

- Point

- posisjon

- mulig

- makt

- kraftverk

- Praktisk

- Skrive ut

- privat

- Problem

- problemer

- Produkt

- Produkter

- Profil

- Progress

- ledetekster

- beskytte

- formål

- formål

- Skyv

- setter

- Qualcomm

- spørsmål

- spørsmål

- område

- rangert

- Lese

- nylig

- Anbefaling

- anbefalinger

- redusere

- redusere

- regelmessig

- Rapporter

- anmode

- forskning

- forskning og utvikling

- forskere

- ikke sant

- Elvebredd

- roller

- tak

- Kjør

- rennende

- går

- trygge

- Sikkerhet

- samme

- sanksjoner

- sandkasse

- Spar

- besparende

- sier

- skalering

- Vitenskap

- Søk

- Årstid

- sektor

- sikre

- se

- segmenter

- halvledere

- Halvledere

- Serien

- servere

- tjeneste

- Tjenester

- servering

- Del

- mangel

- bør

- viste

- Viser

- side

- signifikant

- siden

- mindre

- smarttelefon

- smartphones

- So

- Software

- Solutions

- løse

- noen

- kilde

- Rom

- spesialisert

- brukt

- stanford

- Begynn

- startups

- Tilstand

- Strategi

- sterkeste

- slik

- levere

- støtte

- bærekraftig

- Systemer

- takle

- takling

- sying

- Ta

- Snakk

- oppgaver

- Teknisk

- Teknologi

- teknologiinnovasjon

- vilkår

- tekst

- enn

- Det

- De

- Fremtiden

- informasjonen

- verden

- deres

- Dem

- deretter

- Der.

- derved

- Disse

- de

- ting

- denne

- De

- selv om?

- Thrive

- tid

- til

- dagens

- tokens

- i morgen

- også

- topp

- slenge

- tradisjonelle

- Tog

- Kurs

- transformator

- transformers

- Trender

- klarert

- prøve

- prøver

- etter

- forstår

- universitet

- University of California

- usannsynlig

- us

- bruk

- bruke

- brukt

- ved hjelp av

- ulike

- venture-

- venture kapital

- venturekapitalfirmaer

- veldig

- av

- var

- Vann

- Vei..

- we

- web

- Velferd

- var

- Hva

- når

- hvilken

- HVEM

- hvorfor

- vil

- med

- uten

- Arbeid

- arbeid

- verden

- ville

- Feil

- år

- du

- Din

- zephyrnet