Jay Dawani er medgründer og administrerende direktør i Lemurian Labs, en oppstart som utvikler en akselerert databehandlingsplattform skreddersydd spesielt for AI-applikasjoner. Plattformen bryter gjennom maskinvarebarrierene for å gjøre AI-utvikling raskere, billigere, mer bærekraftig og tilgjengelig for mer enn bare noen få selskaper.

Før han grunnla Lemurian, grunnla Jay to andre selskaper i AI-området. Han er også forfatteren av den topprangerte "Matematikk for dyp læring».

En ekspert på kunstig intelligens, robotikk og matematikk, har Jay fungert som CTO for BlocPlay, et offentlig selskap som bygger en blokkjedebasert spillplattform, og fungerte som direktør for AI hos GEC, hvor han ledet utviklingen av flere klientprosjekter som dekker områder fra detaljhandel, algoritmisk handel, proteinfolding, roboter for romutforskning, anbefalingssystemer og mer. På fritiden har han også vært rådgiver ved NASA Frontier Development Lab, Spacebit og SiaClassic.

Sist gang vi presenterte Lemurian Labs var du fokusert på robotikk og edge AI. Nå er du fokusert på datasenter og skyinfrastruktur. Hva skjedde som gjorde at du ønsket å pivotere?

Faktisk gikk vi over fra å fokusere på å bygge en system-på-brikke med høy ytelse, lav latens for autonome robotapplikasjoner som kunne akselerere hele sense-plan-act-løkken til å bygge en domenespesifikk akselerator for AI med fokus på applikasjoner i datasenterskala. . Men det var ikke bare en vanlig pivot; det var en klar samtale vi følte at vi hadde ansvaret for å svare på.

I 2018 jobbet vi med å trene opp en parametermodell på 2.1 milliarder dollar, men vi forlot innsatsen fordi kostnadene var så ekstraordinært høye at vi ikke kunne rettferdiggjøre det. Så forestill deg min overraskelse over at GPT3, som OpenAI ga ut som ChatGPT i november 2022, var en parametermodell på 175 milliarder dollar. Denne modellen er mer enn 80X større enn det vi jobbet med bare 4 år tidligere, noe som er både spennende og skremmende.

Kostnadene ved å trene opp en slik modell er mildt sagt svimlende. Basert på gjeldende skaleringstrender, kan vi forvente at kostnadene ved å trene en frontier AI-modell vil overstige en milliard dollar i en ikke så fjern fremtid. Selv om egenskapene til disse modellene vil være forbløffende, er kostnadene latterlig høye. Basert på denne banen vil bare en håndfull svært ressurssterke selskaper med egne datasentre ha råd til å trene, distribuere og finjustere disse modellene. Dette er ikke utelukkende fordi databehandling er dyrt og strømkrevende, men også fordi programvarestablene vi stoler på ikke ble bygget for denne verden.

På grunn av geografiske og energimessige begrensninger er det bare så mange steder å bygge datasentre. For å møte datakravene til AI, må vi være i stand til å bygge zettascale-maskiner uten å kreve 20 atomreaktorer for å drive den. Vi trenger en mer praktisk, skalerbar og økonomisk løsning. Vi så oss rundt og så ingen på vei til å løse dette. Og så gikk vi til tegnebrettet for å se på problemet helhetlig som et system av systemer og resonnere om en løsning fra første prinsipper. Vi spurte oss selv hvordan vi ville designe hele stabelen, fra programvare til maskinvare, hvis vi måtte tjene 10 milliarder LLM-spørringer økonomisk om dagen. Vi har siktet oss inn på en zettaskalamaskin på under 200 MW innen 2028.

Trikset er å se på det fra et synspunkt om uforholdsmessig skalering – forskjellige deler av et system følger forskjellige skaleringsregler, så på et tidspunkt slutter ting bare å fungere, begynner å gå i stykker, ellers er kostnads-nytte-avveiningen ikke lenger fornuftig. Når dette skjer, er det eneste alternativet å redesigne systemet. Vår vurdering og løsning omfatter arbeidsmengde, tallsystem, programmeringsmodell, kompilator, kjøretid og maskinvare helhetlig.

Heldigvis ser våre eksisterende investorer og resten av markedet visjonen, og vi samlet inn en startrunde på $9 millioner for å utvikle tallformatet vårt – PAL, for å utforske designområdet og konvergere til en arkitektur for vår domenespesifikke akseleratoren, og arkitekten vår kompilator og kjøretid. I simuleringer har vi vært i stand til å oppnå en 20X gjennomstrømningsgevinst i det mindre energifotavtrykket enn moderne GPUer, og anslår å kunne levere en 8X fordel i systemytelse for totale eierkostnader på samme transistorteknologi.

Det er unødvendig å si at vi har mye arbeid foran oss, men vi er ganske spente på utsiktene til å kunne redefinere datasenterøkonomi for å sikre en fremtid der AI er rikelig tilgjengelig for alle.

Det høres absolutt spennende ut, og de tallene høres imponerende ut. Men du har nevnt tallsystemer, maskinvare, kompilatorer og kjøretider som alle tingene du fokuserer på – det høres ut som mye for ethvert selskap å ta på seg på en gang. Det virker som et veldig risikabelt forslag. Er det ikke meningen at startups skal være mer fokuserte?

Det høres ut som mye forskjellig innsats, men det er faktisk en innsats med mange sammenkoblede deler. Å løse bare én av disse komponentene isolert fra de andre vil bare hindre potensialet for innovasjon fordi det resulterer i å overse de systemiske ineffektivitetene og flaskehalsene. Jensen Huang sa det best, "For å være et akselerert databedrift, må du være et fullstack-selskap", og jeg er helt enig. De er nåværende markedsleder av en grunn. Men jeg vil utfordre forestillingen om at vi ikke er fokuserte. Det er i hvordan vi tenker helhetlig om problemet og hvordan vi best løser det for våre kunder, er der vårt fokus er.

Å gjøre det krever en tverrfaglig tilnærming som vår. Hver del av arbeidet vårt informerer og støtter de andre, slik at vi kan lage en løsning som er langt mer enn summen av delene. Tenk om du måtte bygge en racerbil. Du vil ikke vilkårlig velge et chassis, legge til racingdekk og slippe inn den kraftigste motoren du kan finne og kjøre den, ikke sant? Du kan tenke på aerodynamikken til bilens karosseri for å redusere luftmotstand og forbedre nedkraften, optimalisere vektfordelingen for god håndtering, spesialdesigne motoren for maksimal ytelse, få et kjølesystem for å forhindre overoppheting, spesifisere et rullebur for å holde føreren trygg , osv. Hvert av disse elementene bygger på og informerer det andre.

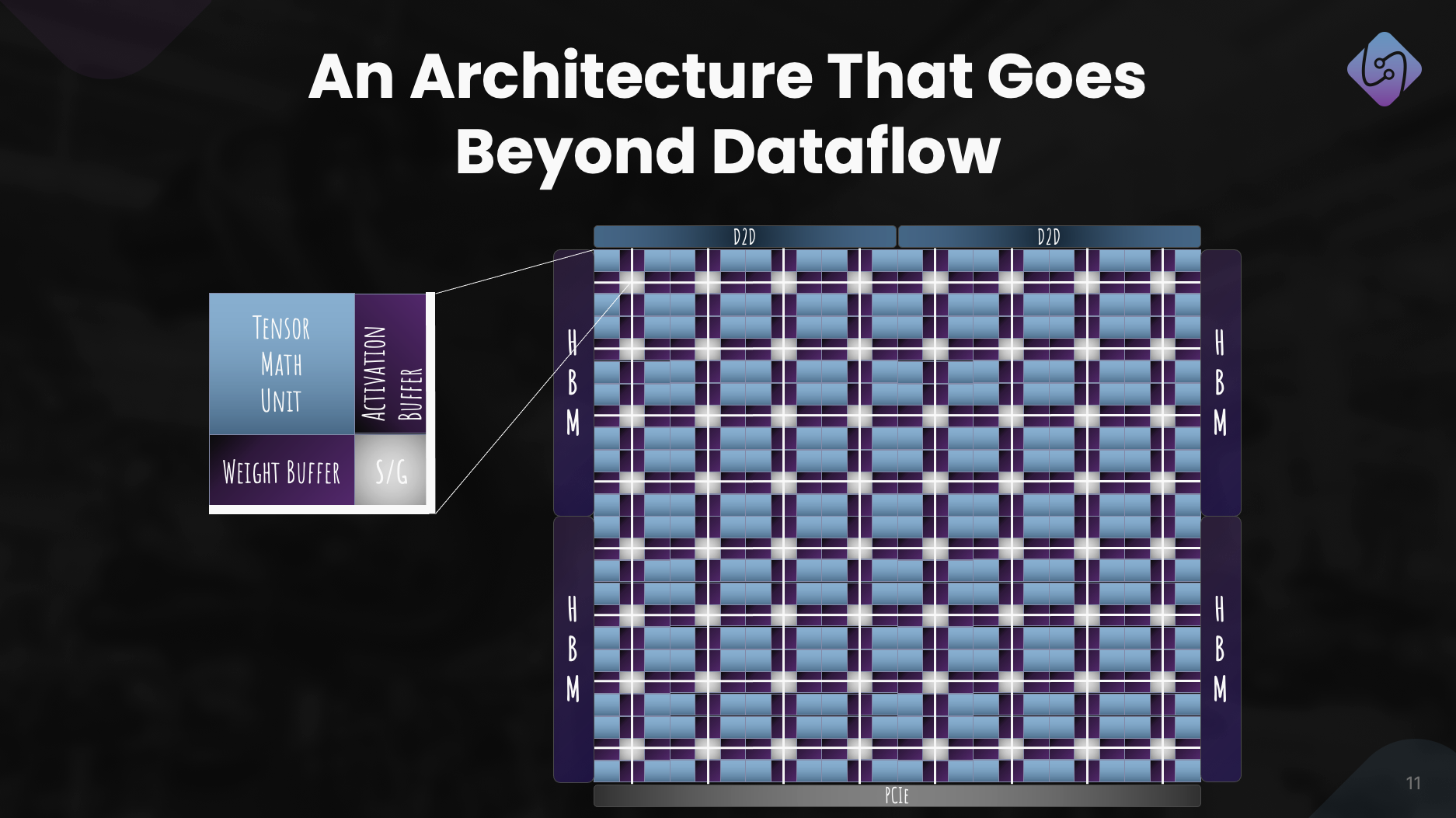

Når det er sagt, er det risikabelt å prøve å gjøre alt på en gang for ethvert selskap i enhver bransje. For å håndtere risikoen tar vi en trinnvis tilnærming, slik at vi kan validere teknologien vår med kunder og justere strategien vår etter behov. Vi har bevist at tallformatet vårt fungerer og at det har bedre effekt-ytelse-areal enn tilsvarende flyttalltyper, samtidig som det har bedre numeriske egenskaper som gjør det lettere å kvantisere nevrale nettverk til mindre bitbredder. Vi har designet en arkitektur som vi føler oss trygge på, og den egner seg for både trening og slutning. Men viktigere enn alt dette er å få programvaren riktig, og det er hoveddelen av vårt umiddelbare fokus. Vi må sikre at vi tar de riktige avgjørelsene i programvarestabelen vår for hvor vi ser at verden er et år eller to eller mer fra i dag.

Å bygge et maskinvarefirma er tøft, dyrt og tar lang tid. Fokuset på programvare høres først ut som en svært levedyktig virksomhet alene, og potensielt mer attraktivt for investorer i dagens klima. Hvorfor driver dere også med maskinvare siden så mange velfinansierte selskaper i området stenger dørene sine, sliter med å få adopsjon hos kunder og større aktører bygger sin egen maskinvare?

Du har helt rett i at programvarebedrifter generelt har vært i stand til å skaffe kapital mye lettere enn maskinvareselskaper, og at maskinvare er veldig tøft. Vårt nåværende fokus er veldig mye på programvare fordi det er der vi ser det større problemet. La meg være klar, problemet er ikke om jeg kan få kjerner til å kjøre på en CPU eller GPU med høy ytelse; det er et lenge løst problem. Problemet i dag er hvordan vi gjør det lettere for utviklere å få mer ytelse, produktivt ut av flere tusen nodeklynger som består av heterogen databehandling uten å be dem om å overhale arbeidsflyten deres.

Det er problemet vi for tiden fokuserer på å løse med en programvarestabel som gir utviklere superkrefter og låser opp full kapasitet til datamaskiner i lagerskala, slik at vi kan trene og distribuere AI-modeller mer økonomisk.

Nå, når det gjelder investeringer, ja, VC-er er mer selektive i den typen selskaper de støtter, men det betyr også at VC-er ser etter selskaper med potensial til å tilby virkelig banebrytende produkter som har en klar vei til kommersialisering samtidig som de har betydelig innvirkning. Vi har lært av andres utfordringer og feil og har aktivt utformet vår forretningsmodell og veikart for å møte risikoene. Det er også viktig å merke seg at det som har gjort startups vellykkede sjelden har vært hvor enkelt de kan skaffe VC-finansiering, men har mer å gjøre med deres oppfinnsomhet, stahet og kundefokus.

Og før du spør, jobber vi fortsatt med maskinvare, men først og fremst med simulering akkurat nå. Vi har ikke tenkt å spille ut på en stund. Men vi kan lagre den samtalen til en annen gang.

Det er absolutt overbevisende, og den trinnvise tilnærmingen din er veldig annerledes sammenlignet med det vi har sett andre maskinvareselskaper gjøre. Jeg forstår problemet du sier at programvarestabelen din vil løse, men hvordan skiller programvaren din seg fra de ulike innsatsene i markedet?

De fleste av selskapene du referer til fokuserer på å gjøre det enklere å programmere GPUer ved å introdusere flisbaserte eller oppgavekartleggingsprogrammeringsmodeller for å få mer ytelse ut av GPUer, eller bygge nye programmeringsspråk for å få høyytelseskjerner planlagt på forskjellige plattformer med støtte for in-line montering. Det er viktige problemer de tar opp, men vi ser på problemet vi løser som nesten ortogonalt.

La oss et øyeblikk tenke på kadensen til maskinvare- og programvareoverganger. Enkjernearkitekturer oppnådde ytelse fra klokkehastighet og transistortetthet, men til slutt traff klokkehastighetene et platå. Parallellisme ved bruk av mange kjerner omgikk dette og ga betydelige hastigheter. Det tok programvaren omtrent et tiår å ta igjen, fordi programmeringsmodeller, kompilatorer og kjøretider måtte revurderes for å hjelpe utviklere med å trekke ut verdien i dette paradigmet. Så begynte GPUer å bli akseleratorer for generelle formål, igjen med en annen programmeringsmodell. Igjen tok det nesten et tiår for utviklere å hente ut verdi her.

Igjen, maskinvare treffer et platå – Moores lov, energi- og termiske begrensninger, minneflaskehalser og mangfoldet av arbeidsbelastninger pluss behovet for eksponentielt mer databehandling presser oss mot å bygge stadig mer heterogene datamaskinarkitekturer for bedre ytelse, effektivitet og totalkostnad. Dette skiftet i maskinvare vil selvfølgelig skape utfordringer for programvare fordi vi ikke har de riktige kompilatorene og kjøretidene for å støtte den neste utviklingen av databehandling. Denne gangen bør vi imidlertid ikke måtte vente i 10 år til på at programvare skal trekke ut verdien av heterogene arkitekturer eller store klynger, spesielt når de blir mer enn 80 % ubrukte.

Det vi fokuserer på er å bygge en heterogenitetsbevisst programmeringsmodell med oppgavebasert parallellitet, adressert bærbar ytelse med kryssprosessoroptimaliseringer, kontekstbevisst kompilering og dynamisk ressursallokering. Og for oss spiller det ingen rolle om det er en CPU, GPU, TPU, SPU (Lemurians arkitektur) eller en mesh av dem alle. Jeg vet det høres ut som mange fancy ord, men det det egentlig sier er at vi har gjort det mulig å programmere alle slags prosessorer med en enkelt tilnærming, og vi kan portere kode fra en type prosessor til en annen med minimalt. innsats uten å måtte ofre ytelse, og planlegge arbeid adaptivt og dynamisk på tvers av noder.

Hvis det du sier er sant, kan du bare omdefinere databehandling fullstendig. La oss snakke om finansiering. Du samlet inn 9 millioner dollar i startfinansiering i fjor, noe som betyr sterk investorstøtte og tro på visjonen din. Hva har du gjort siden?

I løpet av det siste året, drevet av startfinansieringen, har vi gjort betydelige fremskritt. Med teamet vårt nå på 20 medlemmer, tok vi omhyggelig opp utfordringer, engasjerte oss med kunder og foredlet vår tilnærming.

Vi fokuserte på å forbedre PAL for trening og inferens, utforsket datamaskinarkitektur for akseleratoren vår og utviklet en simulator for ytelsesmålinger. Samtidig redesignet vi programvarestabelen vår for datasenterapplikasjoner, med vekt på heterogen databehandling.

Denne innsatsen resulterte i en veldefinert arkitektur som viser PALs effektivitet for AI i stor skala. Utover teknologiske fremskritt, forfulgte vi samarbeid og oppsøking for å demokratisere tilgang. Denne innsatsen posisjonerer Lemurian Labs for å møte umiddelbare kundeutfordringer, og forbereder seg på utgivelsen av produksjonssilisiumet vårt.

Hva er Lemurian Labs' mellomlangsiktige planer angående utvikling av programvarestabel, samarbeid og forbedring av akseleratorens arkitektur?

Vårt umiddelbare mål er å lage en programvarestabel som retter seg mot CPUer, GPUer og våre AI-akseleratorer med bærbar ytelse, som vil bli gjort tilgjengelig for tidlige partnere på slutten av året. Vi er for tiden i samtaler med de fleste av de ledende halvlederselskapene, skytjenesteleverandørene, hyperskalere og AI-selskaper for å gi dem tilgang til kompilatoren og kjøretiden vår. Parallelt fortsetter vi å jobbe med og forbedre akseleratorens arkitektur for et virkelig co-designet system av maskinvare og programvare. Og selvfølgelig har vi nettopp begynt å heve serie A med veldig sterk interesse fra investormiljøet, noe som vil gjøre oss i stand til å utvide teamet vårt og nå målet vårt for levering av programvareprodukter på slutten av året.

Til slutt, hvordan ser du at Lemurian Labs vil bidra til å endre landskapet for AI-utvikling, tilgjengelighet og egenkapital i de kommende årene?

Vi satte oss ikke for å redefinere databehandling kun for kommersiell gevinst eller for moro skyld. Som lemurianere er drivkraften vår at vi tror på det transformative potensialet til AI og at flere enn bare noen få selskaper bør ha ressursene til å definere fremtiden til denne teknologien og hvordan vi bruker den. Vi finner det heller ikke akseptabelt at datasenterinfrastrukturen for AI er på vei til å forbruke så mye som 20 % av verdens energi innen 2030. Vi kom alle sammen fordi vi tror det er en bedre vei fremover for samfunnet hvis vi kan gjøre det. AI mer tilgjengelig ved dramatisk å redusere de tilhørende kostnadene, akselerere innovasjonstakten innen AI og utvide virkningen. Ved å møte utfordringene med dagens maskinvareinfrastruktur, søker vi å bane veien for å styrke en milliard mennesker med evnene til AI, og sikre rettferdig distribusjon av denne avanserte teknologien. Vi håper vår forpliktelse til produktfokuserte løsninger, samarbeid og kontinuerlig innovasjon posisjonerer oss som en drivkraft i å forme fremtiden for AI-utvikling til å være positiv.

Les også:

Del dette innlegget via:

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- : har

- :er

- :ikke

- :hvor

- $ 9 millioner

- $OPP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- I stand

- Om oss

- absolutt

- akselerere

- akselerert

- akselerator

- akseleratorer

- akseptabelt

- adgang

- tilgjengelighet

- tilgjengelig

- Oppnå

- tvers

- aktivt

- legge til

- adresse

- adressert

- adressering

- justere

- Adopsjon

- avansert

- Avansert teknologi

- fremskritt

- rådgiver

- en gang til

- fremover

- AI

- AI-modeller

- algoritmisk

- algoritmisk handel

- Alle

- allokering

- tillate

- nesten

- også

- Amazon

- an

- og

- En annen

- besvare

- noen

- noen

- tiltrekkende

- søknader

- tilnærming

- vilkårlig

- arkitektur

- arkitekturer

- ER

- områder

- rundt

- kunstig

- kunstig intelligens

- AS

- spør

- spør

- Montering

- evaluering

- assosiert

- forbløffende

- At

- forfatter

- autonom

- tilgjengelig

- tilbake

- barrierer

- basert

- BE

- fordi

- bli

- vært

- før du

- være

- tro

- tro

- nytte

- BEST

- Bedre

- Beyond

- større

- Milliarder

- blockchain-baserte

- borde

- kroppen

- både

- flaskehalser

- Breaking

- pauser

- utvide

- bygge

- Bygning

- bygger

- bygget

- bulk

- virksomhet

- forretningsmodell

- bedrifter

- men

- by

- Cadence

- ring

- kom

- CAN

- Kan få

- evner

- evne

- hovedstad

- Catch

- sentrum

- konsernsjef

- CEO intervju

- Gjerne

- utfordre

- utfordringer

- endring

- chassis

- ChatGPT

- billigere

- fjerne

- kunde

- Klima

- klokke

- lukking

- Cloud

- sky infrastruktur

- Med-grunnlegger

- kode

- samarbeid

- samarbeid

- kommer

- kommersiell

- kommersialisering

- engasjement

- samfunnet

- Selskaper

- Selskapet

- sammenlignet

- overbevisende

- kompilatoren

- helt

- komponenter

- Beregn

- datamaskin

- datamaskiner

- databehandling

- trygg

- begrensninger

- forbruke

- fortsette

- kontinuerlig

- medvirkende

- konvergerer

- Samtale

- samtaler

- kjølesystem

- korrigere

- Kostnad

- kunne

- kurs

- dekker

- prosessor

- skape

- Kryss

- CTO

- Gjeldende

- I dag

- skikk

- tilpasset design

- kunde

- Kunder

- dato

- Datasenter

- Datacenter

- dag

- tiår

- avgjørelser

- dyp

- definere

- leverer

- levering

- krav

- demokrat

- tetthet

- utplassere

- utforming

- designet

- utvikle

- utviklet

- utviklere

- utvikle

- Utvikling

- gJORDE

- forskjellig

- differensiere

- Regissør

- Fjern

- distribusjon

- Mangfold

- do

- gjør

- ikke

- gjør

- dollar

- domene

- gjort

- ikke

- dører

- dramatisk

- tegning

- sjåfør

- kjøring

- Drop

- dynamisk

- dynamisk

- hver enkelt

- Tidligere

- Tidlig

- enklere

- lett

- økonomisk

- Økonomi

- Edge

- effekten

- effektivitet

- innsats

- innsats

- elementer

- streker

- myndiggjøring

- muliggjøre

- muliggjør

- Omfatter

- slutt

- energi

- engasjert

- Motor

- forbedre

- styrke

- sikre

- sikrer

- Hele

- rettferdig

- egenkapital

- Tilsvarende

- spesielt

- etc

- etter hvert

- alle

- evolusjon

- stige

- opphisset

- spennende

- eksisterende

- forvente

- dyrt

- Expert

- leting

- utforske

- utforsket

- eksponentielt

- trekke ut

- used

- Faktisk

- fancy

- langt

- raskere

- kjennetegnet

- føler

- feil

- Noen få

- Finn

- Først

- flytende

- Fokus

- fokuserte

- fokusering

- følge

- Fotspor

- Til

- Tving

- format

- Forward

- Stiftet

- grunnleggelsen

- fra

- Frontier

- drevet

- fullt

- Full stabel

- fullt

- moro

- finansiering

- framtid

- Fremtiden for AI

- Gevinst

- fikk

- gaming

- spillplattform

- gearing

- general

- generelt

- geografiske

- få

- få

- Gi

- gitt

- gir

- mål

- skal

- god

- fikk

- GPU

- GPU

- banebrytende

- Grow

- HAD

- håndfull

- Håndtering

- skjedde

- skjer

- maskinvare

- Ha

- å ha

- he

- hjelpe

- her.

- Høy

- hindre

- hans

- hit

- trykke

- håp

- Hvordan

- Hvordan

- HTTPS

- Huang

- Sulten

- i

- if

- forestille

- umiddelbar

- Påvirkning

- viktig

- imponerende

- forbedre

- forbedring

- in

- stadig

- industri

- ineffektivitet

- informerer

- Infrastruktur

- Innovasjon

- Intelligens

- hensikt

- sammenhengende

- interesse

- Intervju

- innføre

- investering

- investor

- Investorer

- isolasjon

- IT

- DET ER

- jensen huang

- jpg

- bare

- Hold

- Type

- Vet

- lab

- Labs

- landskap

- språk

- stor

- større

- Siste

- I fjor

- Ventetid

- Law

- leder

- ledende

- lært

- minst

- Led

- la

- i likhet med

- ll

- llm

- Lang

- lang tid

- lenger

- Se

- så

- ser

- Lot

- Lav

- senking

- maskin

- maskiner

- laget

- gjøre

- GJØR AT

- Making

- administrer

- mange

- marked

- Markedsleder

- matematikk

- Saken

- max bredde

- maksimal

- Kan..

- me

- midler

- Møt

- medlemmer

- Minne

- nevnt

- bare

- mesh

- omhyggelig

- Metrics

- millioner

- minimal

- feil

- modell

- modeller

- Moderne

- øyeblikk

- mer

- mest

- mye

- tverrfaglig

- my

- Nasa

- Trenger

- nødvendig

- trenger

- nettverk

- neural

- nevrale nettverk

- Ny

- neste

- Nei.

- node

- noder

- note

- Forestilling

- November

- nå

- kjernekraft

- Antall

- tall

- of

- tilby

- on

- gang

- ONE

- bare

- OpenAI

- optimaliseringer

- Optimalisere

- Alternativ

- or

- rekkefølge

- vanlig

- Annen

- andre

- vår

- oss selv

- ut

- oppsøk

- enn

- overhaling

- egen

- eierskap

- Fred

- paradigmet

- Parallel

- parameter

- del

- partnere

- deler

- Past

- banen

- vraket

- Ansatte

- ytelse

- faset

- plukke

- Pivot

- steder

- planer

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- i tillegg til

- Point

- Synspunkt

- bærbar

- posisjon

- stillinger

- positiv

- mulig

- Post

- potensiell

- potensielt

- makt

- kraftig

- Praktisk

- pen

- forebygge

- primært

- prinsipper

- Problem

- problemer

- prosessering

- prosessor

- Produkt

- Produksjon

- Produkter

- program

- Programmering

- programmerings språk

- prosjekter

- egenskaper

- proposisjoner

- prospektet

- Protein

- utprøvd

- forutsatt

- tilbydere

- offentlig

- rent

- formål

- Skyver

- spørsmål

- Race

- Racing

- heve

- hevet

- heve

- sjelden

- Lese

- virkelig

- grunnen til

- Anbefaling

- omdefinere

- redesign

- redusere

- henviser

- raffinert

- om

- reimagined

- slipp

- utgitt

- avhengige

- Krever

- ressurs

- Ressurser

- ansvar

- REST

- resulterte

- Resultater

- detaljhandel

- ikke sant

- risikoer

- Risikabelt

- veikart

- robotikk

- roboter

- Rull

- omtrent

- runde

- regler

- rennende

- ofre

- trygge

- Sa

- samme

- Spar

- sier

- sier

- skalerbar

- Skala

- skalering

- planlegge

- planlagt

- se

- seed

- Frøfinansiering

- Frørunde

- Søke

- synes

- sett

- selektiv

- halvledere

- forstand

- Serien

- Serie A

- betjene

- servert

- tjeneste

- tjenestetilbydere

- sett

- flere

- forme

- skift

- bør

- utstillingsvindu

- severdigheter

- signifikant

- betyr

- Silicon

- simulering

- simuleringer

- simulator

- samtidig

- siden

- enkelt

- betydelig

- Skyv

- mindre

- So

- Samfunnet

- Software

- løsning

- Solutions

- LØSE

- løst

- løse

- noen

- Lyd

- lyder

- Rom

- utforsking av verdensrommet

- romlig

- spesifikk

- spesielt

- fart

- hastigheter

- stable

- Stabler

- svimlende

- Begynn

- startet

- oppstart

- startups

- Still

- Stopp

- Strategi

- fremskritt

- sterk

- Sliter

- vellykket

- slik

- egnet

- sum

- støtte

- Støtter

- ment

- overraskelse

- bærekraftig

- system

- systemisk

- Systemer

- skreddersydd

- Ta

- tar

- ta

- Snakk

- tape

- Target

- mål

- lag

- tech

- Teknologi

- enn

- Det

- De

- Fremtiden

- Landskapet

- verden

- deres

- Dem

- deretter

- Der.

- termisk

- Disse

- de

- ting

- tror

- denne

- De

- selv om?

- tusen

- Gjennom

- gjennomstrømning

- tid

- dekk

- til

- i dag

- sammen

- også

- tok

- Totalt

- tøff

- mot

- spor

- trading

- Tog

- Kurs

- bane

- transformative

- overgang

- overganger

- Trender

- trick

- sant

- virkelig

- prøve

- to

- typer

- etter

- forstå

- enhet

- låser opp

- upon

- us

- bruke

- ved hjelp av

- VALIDERE

- verdi

- ulike

- VC

- VC finansiering

- ventureselskaper

- veldig

- av

- levedyktig

- Se

- syn

- vente

- ønsker

- Warehouse

- var

- we

- vekt

- VI VIL

- veldefinerte

- gikk

- var

- Hva

- når

- om

- hvilken

- mens

- hvorfor

- vil

- med

- uten

- ord

- Arbeid

- arbeidsflyt

- arbeid

- virker

- verden

- Verdens

- ville

- år

- år

- ja

- du

- Din

- zephyrnet