Generert med Midjourney

Bedrifter i alle bransjer og hjørner av verden skynder seg å integrere kraften til store språkmodeller (LLM) som OpenAIs ChatGPT, Anthropics Claude og AI12Labs Jurassic for å øke ytelsen i et bredt spekter av forretningsapplikasjoner, som markedsundersøkelser, kundeservice , og innholdsgenerering.

Å bygge en LLM-applikasjon i bedriftsskala krever imidlertid et annet verktøysett og forståelse enn å bygge tradisjonelle maskinlæringsapplikasjoner (ML). Bedriftsledere og ledere som ønsker å bevare merkevarens stemme og pålitelig tjenestekvalitet, må utvikle en dypere forståelse av hvordan LLM-er fungerer og fordeler og ulemper med ulike verktøy i en LLM-applikasjonsstabel.

I denne artikkelen vil vi gi deg en viktig introduksjon til strategien og verktøyene på høyt nivå du trenger for å bygge og kjøre en LLM-applikasjon for virksomheten din.

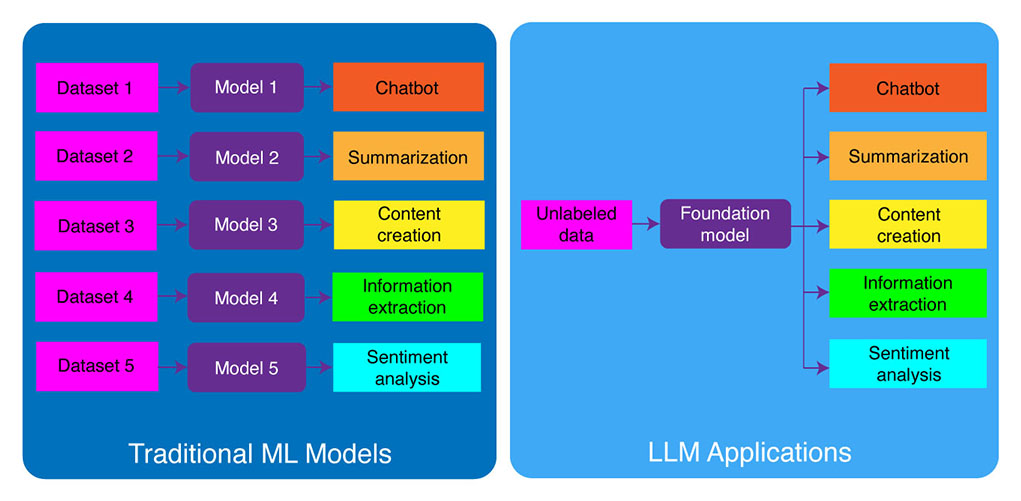

Tradisjonell ML-utvikling vs. LLM-applikasjoner

Tradisjonelle maskinlæringsmodeller var oppgavespesifikke, noe som betyr at du måtte bygge en egen modell for hver oppgave. For eksempel, hvis du ønsker å analysere kundesentiment, må du bygge én modell, og hvis du ønsker å bygge en kundestøtte chatbot, må du bygge en annen modell.

Denne prosessen med å bygge og trene oppgavespesifikke ML-modeller er tidkrevende og krever mye data. Hva slags datasett som trengs for å trene disse forskjellige ML-modellene vil også variere avhengig av oppgaven. For å trene en modell til å analysere kundesentiment, trenger du et datasett med kundeanmeldelser som har blitt merket med en tilsvarende følelse (positiv, negativ, nøytral). For å trene en modell for å bygge en kundestøtte chatbot, trenger du et datasett med samtaler mellom kunder og teknisk støtte.

Store språkmodeller har endret dette. LLM-er er forhåndsopplært på et massivt datasett med tekst og kode, noe som gjør at de kan yte godt på et bredt spekter av oppgaver rett ut av boksen, inkludert:

- Tekstoppsummering

- Innholdsskaping

- Oversettelse

- Informasjonsutvinning

- Svar på spørsmål

- Sentimentanalyse

- Kundestøtte

- Salgs støtte

Prosessen med å utvikle LLM-applikasjoner kan deles inn i fire viktige trinn:

- Velg en passende fundamentmodell. Det er en nøkkelkomponent som definerer ytelsen til LLM-applikasjonen din.

- Tilpass modellen om nødvendig. Du må kanskje finjustere modellen eller utvide den med den ekstra kunnskapsbasen for å møte dine spesifikke behov.

- Sett opp ML-infrastruktur. Dette inkluderer maskinvaren og programvaren som trengs for å kjøre applikasjonen din (dvs. halvledere, brikker, nettskyvert, inferens og distribusjon).

- Utvid søknaden din med tilleggsverktøy. Disse verktøyene kan bidra til å forbedre applikasjonens effektivitet, ytelse og sikkerhet.

La oss nå ta en titt på den tilsvarende teknologistabelen.

Hvis dette inngående pedagogiske innholdet er nyttig for deg, abonner på vår AI-e-postliste å bli varslet når vi slipper nytt materiale.

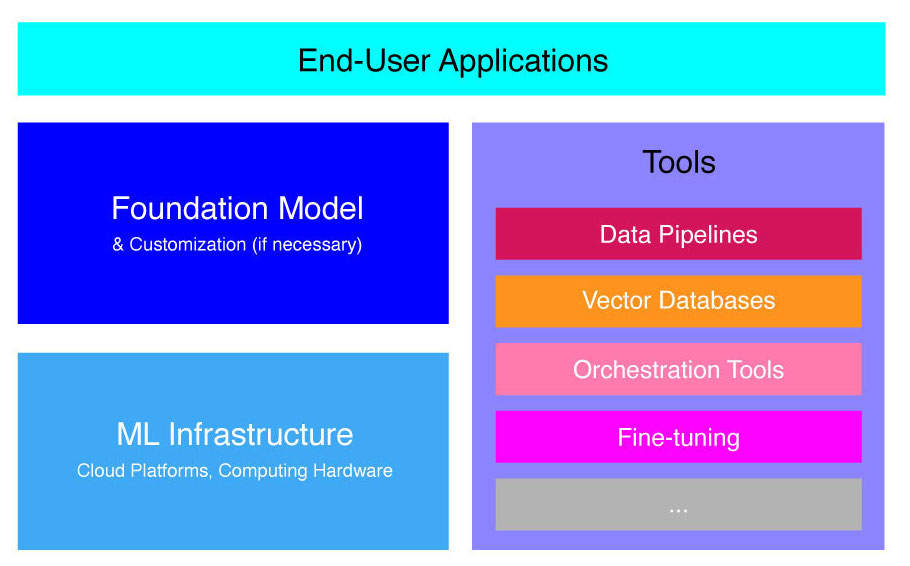

Høynivå LLM-applikasjonsstabel

LLM-applikasjoner er bygget på toppen av flere nøkkelkomponenter, inkludert:

- En grunnmodell, som kan kreve tilpasning i spesifikke brukstilfeller.

- ML-infrastruktur for tilstrekkelige dataressurser via skyplattformer eller bedriftens egen maskinvare.

- Ekstra verktøy, for eksempel datapipelines, vektordatabaser, orkestreringsverktøy, finjustering av ML-plattformer, modellytelsesovervåkingsverktøy, etc.

Vi skal kort veilede deg gjennom disse komponentene slik at du bedre kan forstå verktøysettet som trengs for å bygge og distribuere en LLM-applikasjon.

Hva er fundamentmodeller?

Å bruke en enkelt forhåndsutdannet LLM kan spare deg for mye tid og ressurser. Å trene opp en slik modell fra grunnen av er imidlertid en betimelig og kostbar prosess som ligger utenfor mulighetene til de fleste selskaper bortsett fra noen få teknologiledere.

Flere selskaper og forskningsteam har trent opp disse modellene og lar andre selskaper bruke dem. Ledende eksempler inkluderer ChatGPT, Claude, Llama, Jurassic og T5. Disse offentlig-vendte modellene kalles grunnmodeller. Noen av dem er proprietære og kan nås via API-anrop mot et gebyr. Andre er åpen kildekode og kan brukes gratis. Disse modellene er forhåndsopplært på et massivt datasett med umerkede tekstdata, noe som gjør dem i stand til å utføre et bredt spekter av oppgaver, fra å generere kreative annonsekopier til å kommunisere med kundene dine på deres morsmål på vegne av selskapet.

Det er to hovedtyper av grunnmodeller: proprietære og åpen kildekode.

Proprietære modeller eies av et enkelt selskap eller organisasjon og er vanligvis bare tilgjengelig mot et gebyr. Noen av de mest populære eksemplene på proprietære modeller inkluderer GPT-modeller av OpenAI, Claude-modeller av Anthropic og Jurassic-modeller av AI21 Labs.

Åpen kildekode-modeller er vanligvis tilgjengelig gratis for alle som ønsker å bruke dem. Noen åpen kildekode-modeller har imidlertid begrensninger på bruken, slik som: (1) kun tilgjengelig for forskningsformål, (2) kun tilgjengelig for kommersiell bruk av selskaper av en viss størrelse. Åpen kildekode-fellesskapet hevder at å sette slike begrensninger ikke tillater en modell å kvalifisere som "åpen kildekode". Likevel, de mest fremtredende eksemplene på språkmodeller som kan brukes gratis, inkluderer Llama-modeller av Meta, Falcon-modeller av Technology Innovation Institute i Abu Dhabi og StableLM-modeller av Stability AI. Les mer om åpen kildekode-modeller og de tilhørende risikoene her..

La oss nå diskutere flere faktorer du bør vurdere når du velger en grunnmodell for din LLM-applikasjon.

Velg en grunnmodell

Å velge den beste grunnlagsmodellen for din LLM-applikasjon kan være en utfordrende prosess, men vi kan i utgangspunktet dele den ned i tre trinn:

- Velg mellom proprietære og åpen kildekode-modeller. Proprietære modeller er vanligvis større og mer kapable enn åpen kildekode-modeller, men de kan være dyrere å bruke og mindre fleksible. I tillegg er koden ikke like gjennomsiktig, noe som gjør det vanskelig å feilsøke eller feilsøke problemer med proprietære modellers ytelse. Åpen kildekode-modeller, derimot, får vanligvis færre oppdateringer og mindre støtte fra utviklerne.

- Velg størrelsen på modellen. Større modeller er vanligvis flinkere til å utføre oppgaver som krever mye kunnskap, som å svare på spørsmål eller generere kreativ tekst. Imidlertid er større modeller også mer beregningsmessig dyrere å bruke. Du kan begynne med å eksperimentere med større modeller, og deretter gå til mindre så lenge modellens ytelse er tilfredsstillende for ditt bruk.

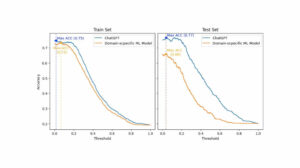

- Velg en spesifikk modell. Du kan starte med å gå gjennom de generelle benchmarkene for å velge modellene for testing. Fortsett deretter med å teste ulike modeller for dine applikasjonsspesifikke oppdrag. For tilpasset benchmarking, vurder å beregne BLEU og ROUGE score, beregningene som hjelper til med å kvantifisere antall korrigeringer som er nødvendige for AI-generert tekst før utdata for human-in-the-loop-applikasjoner frigis.

For en bedre forståelse av forskjellene mellom ulike språkmodeller, sjekk ut vår oversikt over de kraftigste språk (LLM) og visuelle språkmodeller (VLM).

Etter at du har valgt en grunnmodell for applikasjonen din, kan du vurdere om du trenger å tilpasse modellen for enda bedre ytelse.

Tilpass en grunnmodell

I noen tilfeller kan det være lurt å tilpasse en grunnleggende språkmodell for bedre ytelse i ditt spesifikke bruksområde. Det kan for eksempel være lurt å optimalisere for et bestemt:

- Domene. Hvis du opererer i spesifikke domener, for eksempel juridiske, økonomiske eller helsetjenester, kan det være lurt å berike modellens vokabular i dette domenet slik at den bedre kan forstå og svare på forespørsler fra sluttbrukere.

- Oppgave. Hvis du for eksempel vil at modellen skal generere markedsføringskampanjer, kan du gi den spesifikke eksempler på merkevaremarkedsinnhold. Dette vil hjelpe modellen med å lære mønstrene og stilene som passer for din bedrift og målgruppe.

- Tonefall. Hvis du trenger at modellen skal bruke et bestemt tonefall, kan du tilpasse modellen på et datasett som inkluderer eksempler på målspråklige prøver.

Det er tre mulige måter å tilpasse en grunnleggende språkmodell på:

- Finjustering: gir modellen et domenespesifikt merket datasett med omtrent 100-500 poster. Modellvektene oppdateres, noe som bør resultere i bedre ytelse på oppgavene representert av dette datasettet.

- Domenetilpasning: gir modellen et domenespesifikt umerket datasett som inneholder et stort korpus av data fra det tilsvarende domenet. Modellvektene er også oppdatert i dette tilfellet.

- Informasjon gjenfinning: utvider grunnmodellen med kunnskap om lukket domene. Modellen er ikke omtrent, og modellvektene forblir de samme. Modellen har imidlertid lov til å hente informasjon fra en vektordatabase som inneholder relevante data.

De to første tilnærmingene krever betydelige dataressurser for å omskolere modellen, noe som vanligvis bare er mulig for store selskaper med passende tekniske talenter til å administrere tilpasningen. Mindre selskaper bruker vanligvis den mer vanlige tilnærmingen med å utvide modellen med domenekunnskap gjennom en vektordatabase, som vi beskriver senere i denne artikkelen i delen om LLM-verktøy.

Sett opp ML Infrastructure

ML-infrastrukturkomponenten i LLMOPS-landskapet inkluderer skyplattformer, datamaskinvare og andre ressurser som er nødvendige for å distribuere og kjøre LLM-er. Denne komponenten er spesielt relevant hvis du velger å bruke en åpen kildekode-modell eller tilpasse modellen for applikasjonen din. I dette tilfellet kan det hende du trenger betydelige dataressurser for å finjustere modellen, om nødvendig, og kjøre den.

Det finnes en rekke skyplattformer som tilbyr tjenester for distribusjon av LLM-er, inkludert Google Cloud Platform, Amazon Web Services og Microsoft Azure. Disse plattformene har en rekke funksjoner som gjør det enkelt å distribuere og kjøre LLM-er, inkludert:

- Forhåndsutdannede modeller som kan finjusteres for din spesifikke applikasjon

- Administrert infrastruktur som tar seg av underliggende maskinvare og programvare

- Verktøy og tjenester for overvåking og feilsøking av LLM-ene dine

Mengden dataressurser du trenger vil avhenge av størrelsen og kompleksiteten til modellen din, oppgavene du vil at den skal utføre, og omfanget av forretningsaktiviteten der du vil distribuere denne modellen.

Forsterk med verktøy

Ytterligere LLM-tilstøtende verktøy kan brukes til å forbedre ytelsen til LLM-applikasjonen ytterligere.

Datarørledninger

Hvis du trenger å bruke dataene dine i LLM-produktet ditt, vil dataforbehandlingspipelinen være en viktig pilar i den nye teknologistabelen din, akkurat som i den tradisjonelle AI-stakken for bedrifter. Disse verktøyene inkluderer koblinger for å innta data fra enhver kilde, et datatransformasjonslag og nedstrøms koblinger. Ledende leverandører av datapipeline, som Databricks og Snowflake, og nye aktører, som Unstructured, gjør det enkelt for utviklere å peke på store og svært heterogene korpora av naturlig språkdata (f.eks. tusenvis av PDF-er, PowerPoint-presentasjoner, chat-logger, skrapet HTML, etc.) til et enkelt tilgangspunkt eller til og med til et enkelt dokument som kan brukes videre av LLM-applikasjoner.

Vektordatabaser

Store språkmodeller er begrenset til å behandle noen få tusen ord om gangen, så de kan ikke effektivt behandle store dokumenter på egen hånd. For å utnytte kraften til store dokumenter, må bedrifter bruke vektordatabaser.

Vektordatabaser er lagringssystemer som transformerer store dokumenter som de mottar gjennom datarørledninger til håndterbare vektorer, eller innebygging. LLM-applikasjoner kan deretter spørre disse databasene for å finne de riktige vektorene, og trekke ut bare de nødvendige informasjonsklumpene.

Noen av de mest fremtredende vektordatabasene som for tiden er tilgjengelige er Pinecone, Chroma og Weaviate.

Orkestreringsverktøy

Når en bruker sender en forespørsel til LLM-applikasjonen din, for eksempel et spørsmål til kundeservice, må applikasjonen konstruere en rekke spørsmål før denne spørringen sendes til språkmodellen. Den endelige forespørselen til språkmodellen er vanligvis sammensatt av en ledetekstmal hardkodet av utvikleren, eksempler på gyldige utdata kalt få-skuddseksempler, all nødvendig informasjon hentet fra eksterne APIer, og et sett med relevante dokumenter hentet fra vektordatabasen . Orkestreringsverktøy fra selskaper som LangChain eller LlamaIndex kan bidra til å strømlinjeforme denne prosessen ved å tilby rammeverk som er klare til bruk for å administrere og utføre forespørsler.

Finjustering

Store språkmodeller trent på massive datasett kan produsere grammatisk korrekt og flytende tekst. Imidlertid kan de mangle presisjon på visse områder, for eksempel medisin eller juss. Ved å finjustere disse modellene på domenespesifikke datasett kan de internalisere de unike egenskapene til disse områdene, og forbedre deres evne til å generere relevant tekst.

Finjustering av en LLM kan være en kostnadskrevende prosess for små bedrifter. Imidlertid kan løsninger fra selskaper som Weights & Biases og OctoML hjelpe med strømlinjeformet og effektiv finjustering. Disse løsningene gir en plattform for bedrifter å finjustere LLM uten å måtte investere i sin egen infrastruktur.

Andre verktøy

Det er mange andre verktøy som kan være nyttige for å bygge og kjøre LLM-applikasjoner. For eksempel kan det hende du trenger merkeverktøy hvis du vil finjustere modellen med dine spesifikke dataeksempler. Det kan også være lurt å distribuere spesifikke verktøy for å overvåke ytelsen til applikasjonen din, ettersom selv mindre endringer i grunnmodellen eller forespørsler fra kunder kan påvirke ytelsen til forespørsler betydelig. Til slutt er det verktøy som overvåker modellsikkerhet for å hjelpe deg med å unngå å fremme hatefullt innhold, farlige anbefalinger eller skjevheter. Nødvendigheten og viktigheten av disse forskjellige verktøyene vil avhenge av din spesifikke brukssituasjon.

Hva er det neste innen LLM-applikasjonsutvikling?

De fire trinnene for LLM-produktutvikling som vi diskuterte her, er et viktig grunnlag for enhver bedrifts generative AI-strategi som utnytter store språkmodeller. De er viktige for ikke-tekniske bedriftsledere å forstå, selv om du har et teknisk team som implementerer detaljene. Vi vil publisere mer detaljerte veiledninger i fremtiden om hvordan du kan utnytte det brede utvalget av generative AI-verktøy på markedet. Foreløpig kan du Abonner på vårt nyhetsbrev for å få de siste oppdateringene.

Liker du denne artikkelen? Registrer deg for flere enterprise AI-oppdateringer.

Vi gir beskjed når vi gir ut flere sammendragsartikler som denne.

I slekt

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://www.topbots.com/llm-product-development-technology-stack/

- :er

- :ikke

- :hvor

- $OPP

- 1

- a

- evne

- Om oss

- Abu Dhabi

- adgang

- aksesseres

- aktivitet

- Ad

- Ytterligere

- I tillegg

- ved siden av

- AI

- AI strategi

- tillate

- tillatt

- tillater

- også

- Amazon

- Amazon Web Services

- beløp

- an

- analysere

- og

- En annen

- Antropisk

- noen

- noen

- api

- APIer

- Søknad

- Applikasjonutvikling

- søknader

- tilnærming

- tilnærminger

- hensiktsmessig

- ER

- områder

- Artikkel

- artikler

- AS

- assosiert

- At

- publikum

- tilgjengelig

- unngå

- Azure

- basen

- I utgangspunktet

- BE

- vært

- før du

- vegne

- være

- referansemåling

- benchmarks

- BEST

- Bedre

- mellom

- Beyond

- skjevheter

- øke

- Eske

- merke

- branded

- Break

- kort

- Brutt

- bygge

- Bygning

- bygget

- virksomhet

- Business Applications

- Bedriftsledere

- bedrifter

- men

- by

- beregning

- som heter

- Samtaler

- Kampanjer

- CAN

- evner

- stand

- hvilken

- saken

- saker

- viss

- utfordrende

- endret

- Endringer

- chatbot

- ChatGPT

- sjekk

- chips

- Velg

- velge

- valgt ut

- krav

- Cloud

- Cloud Hosting

- Skyplattform

- kode

- kommersiell

- Felles

- kommunisere

- samfunnet

- Selskaper

- Selskapet

- Selskapets

- kompleksitet

- komponent

- komponenter

- komponert

- databehandling

- Ulemper

- Vurder

- konstruere

- inneholder

- innhold

- samtaler

- kopier

- Corner

- korrigere

- Korreksjoner

- Tilsvarende

- kostbar

- Kreativ

- I dag

- skikk

- kunde

- Kundeservice

- Kundeservice

- Kunder

- tilpasning

- tilpasse

- Dangerous

- dato

- Database

- databaser

- Databaser

- datasett

- dypere

- definere

- avhengig

- utplassere

- utplasserings

- distribusjon

- detalj

- detaljert

- detaljer

- utvikle

- Utvikler

- utviklere

- utvikle

- Utvikling

- Dhabi

- forskjeller

- forskjellig

- vanskelig

- diskutere

- diskutert

- dokument

- dokumenter

- ikke

- domene

- domener

- ned

- e

- hver enkelt

- lett

- pedagogisk

- effektivt

- effektivitet

- effektiv

- elite

- muliggjør

- forbedre

- styrke

- berike

- Enterprise

- spesielt

- avgjørende

- etc

- Eter (ETH)

- Selv

- Hver

- eksempel

- eksempler

- Unntatt

- utførende

- ledere

- dyrt

- utvendig

- faktorer

- falk

- gjennomførbart

- Egenskaper

- gebyr

- Noen få

- færre

- slutt~~POS=TRUNC

- Endelig

- finansiell

- Først

- fleksibel

- Til

- Fundament

- fire

- rammer

- Gratis

- fra

- videre

- framtid

- general

- generere

- genererer

- generasjonen

- generative

- Generativ AI

- få

- Gi

- globus

- Go

- skal

- Google Cloud

- Google Cloud Platform

- Ground

- hånd

- maskinvare

- seletøy

- Ha

- å ha

- helsetjenester

- hjelpe

- her.

- høyt nivå

- svært

- Hosting

- Hvordan

- Hvordan

- Men

- HTML

- HTTPS

- i

- if

- Påvirkning

- implementere

- betydning

- viktig

- forbedre

- in

- dyptgående

- inkludere

- inkluderer

- Inkludert

- industri

- informasjon

- Infrastruktur

- Innovasjon

- Institute

- integrere

- inn

- Introduksjon

- Investere

- IT

- jpg

- bare

- nøkkel

- Type

- Vet

- kunnskap

- merking

- Labs

- maling

- landskap

- Språk

- stor

- større

- seinere

- siste

- Siste oppdateringer

- Law

- lag

- ledere

- ledende

- LÆRE

- læring

- Lovlig

- mindre

- Leverage

- utnytter

- i likhet med

- begrensninger

- Begrenset

- Llama

- Lang

- Se

- Lot

- maskin

- maskinlæring

- Hoved

- gjøre

- GJØR AT

- administrer

- administrerende

- mange

- marked

- markedsundersøkelser

- Marketing

- Markedsføringskampanjer

- markedsplass

- massive

- materiale

- max bredde

- Kan..

- betyr

- medisin

- Møt

- Meta

- Metrics

- Microsoft

- Microsoft Azure

- kunne

- mindre

- ML

- modell

- modeller

- Overvåke

- overvåking

- mer

- mest

- Mest populær

- innfødt

- Naturlig

- Naturlig språk

- nødvendig

- Trenger

- nødvendig

- behov

- negativ

- Nøytral

- Ny

- Ny teknikk

- Nyhetsbrev

- neste

- ikke-teknisk

- nå

- Antall

- of

- tilby

- on

- ONE

- seg

- bare

- åpen kildekode

- OpenAI

- betjene

- Optimalisere

- or

- orkestre

- organisasjon

- Annen

- andre

- vår

- ut

- produksjon

- oversikt

- egen

- eide

- mønstre

- utføre

- ytelse

- utfører

- Pillar

- rørledning

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- spillere

- Point

- Populær

- positiv

- mulig

- makt

- kraftig

- Precision

- Presentasjoner

- problemer

- prosess

- prosessering

- produsere

- Produkt

- produktutvikling

- fremtredende

- fremme

- proprietær

- PROS

- gi

- tilbydere

- gir

- gi

- publisere

- formål

- Sette

- kvalifisere

- kvalitet

- spørsmål

- spørsmål

- spørsmål

- område

- Lese

- motta

- anbefalinger

- poster

- slipp

- frigjør

- relevant

- pålitelig

- representert

- anmode

- forespørsler

- krever

- Krever

- forskning

- Ressurser

- Svare

- restriksjoner

- resultere

- gjennomgå

- Anmeldelser

- ikke sant

- risikoer

- Kjør

- rennende

- Sikkerhet

- samme

- Spar

- Skala

- Seksjon

- sikkerhet

- Halvledere

- sentiment

- separat

- Serien

- tjeneste

- Tjenester

- sett

- flere

- bør

- undertegne

- signifikant

- betydelig

- enkelt

- Størrelse

- liten

- mindre

- So

- Software

- Solutions

- noen

- kilde

- spesifikk

- Stabilitet

- stable

- Begynn

- opphold

- Steps

- Still

- lagring

- Strategi

- effektivisere

- strømlinjeformet

- stiler

- slik

- tilstrekkelig

- SAMMENDRAG

- støtte

- Systemer

- Ta

- tar

- Talent

- Target

- Oppgave

- oppgaver

- lag

- lag

- tech

- Teknisk

- teknisk støtte

- Teknologi

- teknologiinnovasjon

- mal

- Testing

- enn

- Det

- De

- Fremtiden

- deres

- Dem

- deretter

- Der.

- Disse

- de

- denne

- De

- tusener

- tre

- Gjennom

- tid

- tidkrevende

- til

- TONE

- Tonefall

- verktøykasse

- verktøy

- topp

- TOPPBOTS

- tradisjonelle

- Tog

- trent

- Kurs

- Transform

- Transformation

- gjennomsiktig

- tutorials

- to

- typer

- typisk

- underliggende

- forstå

- forståelse

- unik

- unike egenskaper

- oppdatert

- oppdateringer

- bruke

- bruk sak

- brukt

- Bruker

- vanligvis

- ulike

- av

- Voice

- vs

- ønsker

- ønsket

- ønsker

- måter

- we

- web

- webtjenester

- VI VIL

- var

- når

- om

- hvilken

- HVEM

- bred

- Bred rekkevidde

- vil

- med

- uten

- ord

- Arbeid

- ville

- du

- Din

- zephyrnet