추론이 데이터 센터에서 네트워크 에지로 이동함에 따라 메모리 처리 속도와 짧은 대기 시간이 중요합니다.

AI/ML은 매우 빠른 속도로 발전하고 있습니다. 이 분야에서 새롭고 흥미로운 개발이 없이는 일주일도 지나지 않았으며 ChatGPT와 같은 애플리케이션은 생성 AI 기능을 대중의 관심의 최전선에 확고히 가져왔습니다.

AI/ML은 실제로 훈련과 추론이라는 두 가지 애플리케이션입니다. 각각은 메모리 성능에 의존하며 최상의 메모리 솔루션을 선택하는 데 필요한 고유한 요구 사항이 있습니다.

훈련을 통해 메모리 대역폭과 용량이 중요한 요구 사항입니다. 이는 특히 연간 10배의 속도로 증가하고 있는 신경망 데이터 모델의 크기와 복잡성을 고려할 때 더욱 그렇습니다. 신경망 정확도는 훈련 데이터 세트의 예시 품질과 수량에 따라 달라지며, 이는 엄청난 양의 데이터가 필요하다는 의미이며, 따라서 메모리 대역폭과 용량도 필요합니다.

훈련을 통해 창출된 가치를 고려할 때, 훈련 실행을 최대한 빨리 완료하려는 강력한 인센티브가 있습니다. 전력과 공간이 점점 더 제한된 데이터 센터에서 교육 애플리케이션을 실행함에 따라 전력 효율성과 더 작은 크기를 제공하는 솔루션이 선호됩니다. 이러한 모든 요구 사항을 고려할 때 HBM3은 AI 훈련 하드웨어를 위한 이상적인 메모리 솔루션입니다. 뛰어난 대역폭과 용량 기능을 제공합니다.

신경망 훈련의 결과는 광범위하게 배포할 수 있는 추론 모델입니다. 이 모델을 사용하면 추론 장치가 훈련 데이터 범위 밖의 입력을 처리하고 해석할 수 있습니다. 추론을 위해서는 특히 실시간 작업이 필요한 경우 메모리 처리 속도와 낮은 대기 시간이 중요합니다. 점점 더 많은 AI 추론이 데이터 센터의 중심에서 네트워크 에지로 이동함에 따라 이러한 메모리 기능은 더욱 중요해지고 있습니다.

설계자는 AI/ML 추론을 위해 다양한 메모리를 선택할 수 있지만 대역폭이라는 중요한 매개변수에서는 GDDR6 메모리가 정말 빛을 발합니다. 24Gb/s(초당 기가비트)의 데이터 속도와 32비트 폭 인터페이스에서 GDDR6 장치는 다른 DDR 또는 LPDDR 솔루션. GDDR96 메모리는 AI/ML 추론, 특히 에지에서의 추론을 위한 속도, 대역폭 및 대기 시간 성능의 뛰어난 조합을 제공합니다.

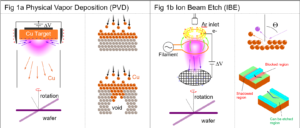

Rambus GDDR6 메모리 인터페이스 하위 시스템은 24Gb/s의 성능을 제공하며 GDDR30을 고속으로 작동하는 데 중요한 6년 이상의 고속 신호 무결성 및 전력 무결성(SI/PI) 전문 지식을 기반으로 구축되었습니다. PHY와 디지털 컨트롤러로 구성되어 완전한 GDDR6 메모리 인터페이스 하위 시스템을 제공합니다.

이번 달 Rambus 웹 세미나에 참여하세요.24G GDDR6 메모리를 사용한 고성능 AI/ML 추론” GDDR6이 AI/ML 추론 워크로드의 메모리 및 성능 요구 사항을 지원하는 방법을 알아보고 GDDR6 메모리 인터페이스 하위 시스템의 일부 주요 설계 및 구현 고려 사항에 대해 알아봅니다.

자료 :

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoAiStream. Web3 데이터 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 미래 만들기 w Adryenn Ashley. 여기에서 액세스하십시오.

- PREIPO®로 PRE-IPO 회사의 주식을 사고 팔 수 있습니다. 여기에서 액세스하십시오.

- 출처: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- :있다

- :이다

- :아니

- 24

- 26

- 27

- 30

- 8

- a

- 소개

- 동작

- AI

- AI 교육

- AI / ML

- All

- 모든 게시물

- 대안

- 금액

- an

- 과

- 어떤

- 어플리케이션

- 있군요

- AS

- At

- 주의

- 대역폭

- BE

- 되고

- 된

- BEST

- 대체로

- 가져

- 내장

- 비자 면제 프로그램에 해당하는 국가의 시민권을 가지고 있지만

- by

- CAN

- 기능

- 생산 능력

- 센터

- 센터

- ChatGPT

- 선택

- 선택

- 결합

- 완전한

- 복잡성

- 고려 사항

- 제어 장치

- 만든

- 임계

- 데이터

- 데이터 센터

- 데이터 센터

- 데이터 세트

- 배달하다

- 제공

- 따라

- 배포

- 디자인

- 개발

- 장치

- 디지털

- 책임자

- 발견

- 더블

- 드라이브

- 마다

- Edge

- 효율성

- 거대한

- 특히

- 조차

- 진화하는

- 예

- 우수한

- 흥미 진진한

- 전문적 지식

- 특징

- 들

- 단단히

- 럭셔리

- 중심

- Foundation

- 에

- 생성적인

- 제너레이티브 AI

- 주어진

- 간다

- 큰

- 성장하는

- 하드웨어

- 있다

- 심장

- 금후

- 높은

- 방법

- HTTPS

- 이상

- 이행

- in

- 자극

- 더욱 더

- 입력

- 보전

- 인터페이스

- 으로

- IP

- IT

- JPG

- 키

- 숨어 있음

- 배우다

- 번개

- 처럼

- 낮은

- 마케팅

- 메모리

- 모델

- 모델

- 달

- 배우기

- 필요

- 필요

- 네트워크

- 네트워크 데이터

- 신경

- 신경망

- 신제품

- 지금

- 번호

- of

- 제공

- 제공

- on

- 운영

- or

- 출력

- 외부

- 위에

- 평화

- 매개 변수

- 특별한

- 특별히

- 성능

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 인기

- 가능한

- 게시물

- 힘

- 강한

- 방법

- 프로덕트

- 제공

- 제공

- 공개

- 품질

- 양

- 빨리

- 율

- 실시간

- 정말

- 요구조건 니즈

- 연락해주세요

- 열

- 달리기

- 둘째

- 연장자

- 세트

- 이동

- 교대

- 신호

- 크기

- 작은

- So

- 해결책

- 솔루션

- 일부

- 스페이스 버튼

- 속도

- 속도

- 지원

- 보다

- 그

- XNUMXD덴탈의

- 그곳에.

- Bowman의

- 이

- 을 통하여

- 처리량

- 미리보기

- 에

- 트레이닝

- 두

- 유일한

- 가치

- 웹 세미나

- 주

- 언제

- 어느

- 넓은

- 과

- 없이

- year

- 년

- 제퍼 넷