가격 페이지 정보를 얻기 위해 경쟁사 웹사이트를 긁어내고 싶다고 가정해 보십시오. 당신은 무엇을 할 것인가? 수동으로 데이터를 복사하여 붙여넣거나 입력하는 것은 너무 느리고 시간이 많이 걸리며 오류가 발생하기 쉽습니다. Python을 사용하여 쉽게 자동화할 수 있습니다.

이 자습서에서 Python을 사용하여 웹 페이지를 스크랩하는 방법을 살펴보겠습니다.

다른 Python 웹 스크래핑 라이브러리는 무엇입니까?

Python은 복잡한 HTML 구조를 스크랩하고, 텍스트를 구문 분석하고, HTML 형식과 상호 작용할 수 있는 풍부한 타사 라이브러리로 인해 웹 스크래핑에 널리 사용됩니다. 여기에 최고의 Python 웹 스크래핑 라이브러리가 나열되어 있습니다.

- Urllib3 Python을 위한 강력한 HTTP 클라이언트 라이브러리입니다. 이렇게 하면 프로그래밍 방식으로 HTTP 요청을 쉽게 수행할 수 있습니다. HTTP 헤더, 재시도, 리디렉션 및 기타 낮은 수준의 세부 정보를 처리하므로 웹 스크래핑을 위한 훌륭한 라이브러리가 됩니다. 또한 SSL 확인, 연결 풀링 및 프록싱을 지원합니다.

- 아름다운 수프 HTML 및 XML 문서를 구문 분석할 수 있습니다. API를 사용하여 HTML 문서 트리를 쉽게 탐색하고 태그, 메타 제목, 속성, 텍스트 및 기타 콘텐츠를 추출할 수 있습니다. BeautifulSoup은 강력한 오류 처리로도 유명합니다.

- MechanicalSoup 웹 브라우저와 웹 사이트 간의 상호 작용을 효율적으로 자동화합니다. 인간의 행동을 시뮬레이션하는 웹 스크래핑을 위한 고급 API를 제공합니다. MechanicalSoup를 사용하면 HTML 양식과 상호 작용하고, 버튼을 클릭하고, 실제 사용자와 같은 요소와 상호 작용할 수 있습니다.

- 요청 HTTP 요청을 만들기 위한 간단하면서도 강력한 Python 라이브러리입니다. 깨끗하고 일관된 API로 사용하기 쉽고 직관적으로 설계되었습니다. 요청을 사용하면 GET 및 POST 요청을 쉽게 보내고 쿠키, 인증 및 기타 HTTP 기능을 처리할 수 있습니다. 또한 단순성과 사용 편의성으로 인해 웹 스크래핑에서 널리 사용됩니다.

- 셀레니움 Chrome, Firefox 및 Safari와 같은 웹 브라우저를 자동화하고 웹 사이트와의 인간 상호 작용을 시뮬레이션할 수 있습니다. 버튼을 클릭하고, 양식을 작성하고, 페이지를 스크롤하고, 기타 작업을 수행할 수 있습니다. 또한 웹 응용 프로그램을 테스트하고 반복 작업을 자동화하는 데 사용됩니다.

- 판다 CSV, Excel, JSON 및 SQL 데이터베이스를 포함한 다양한 형식으로 데이터를 저장하고 조작할 수 있습니다. Pandas를 사용하면 웹 사이트에서 추출한 데이터를 쉽게 정리, 변환 및 분석할 수 있습니다.

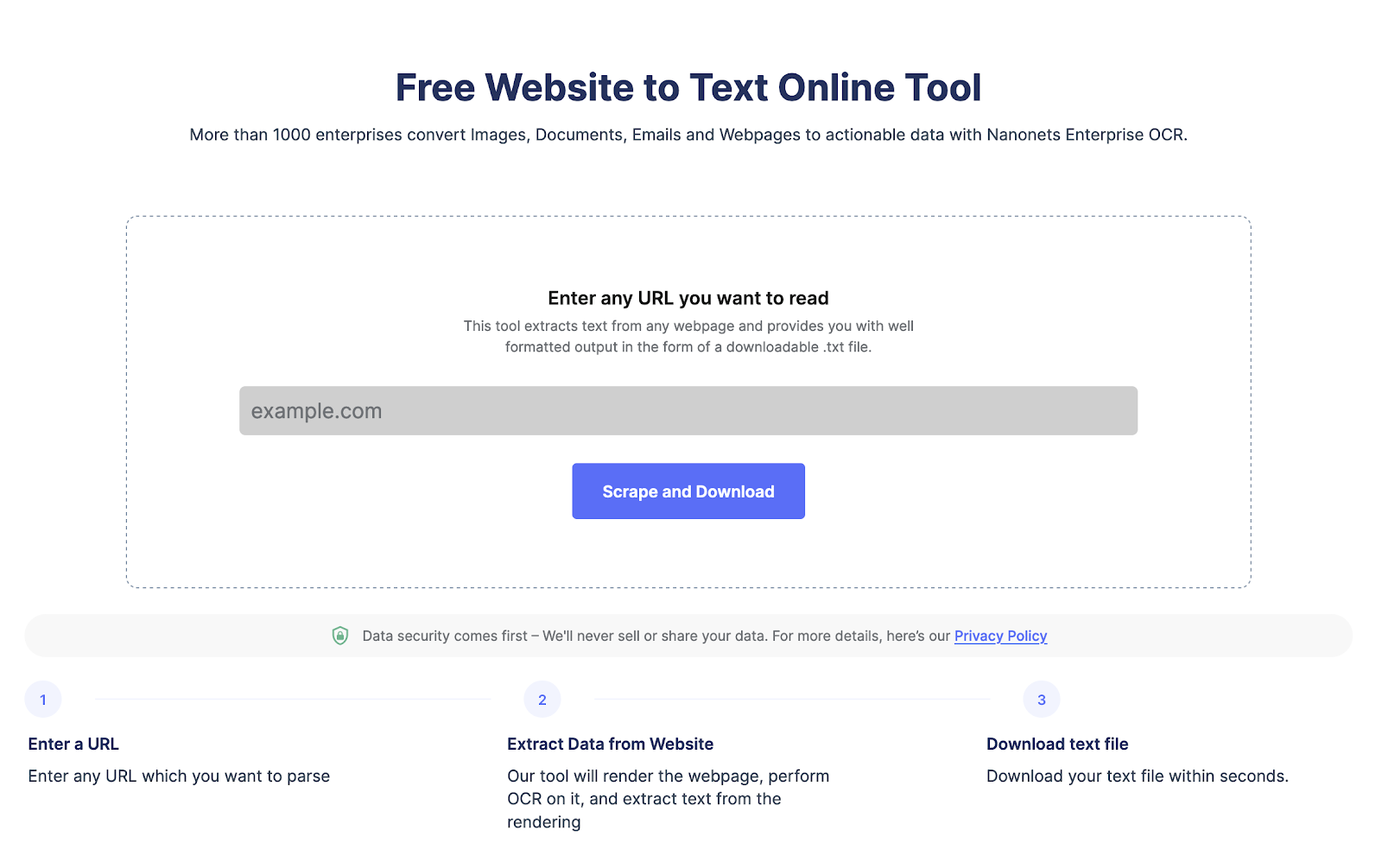

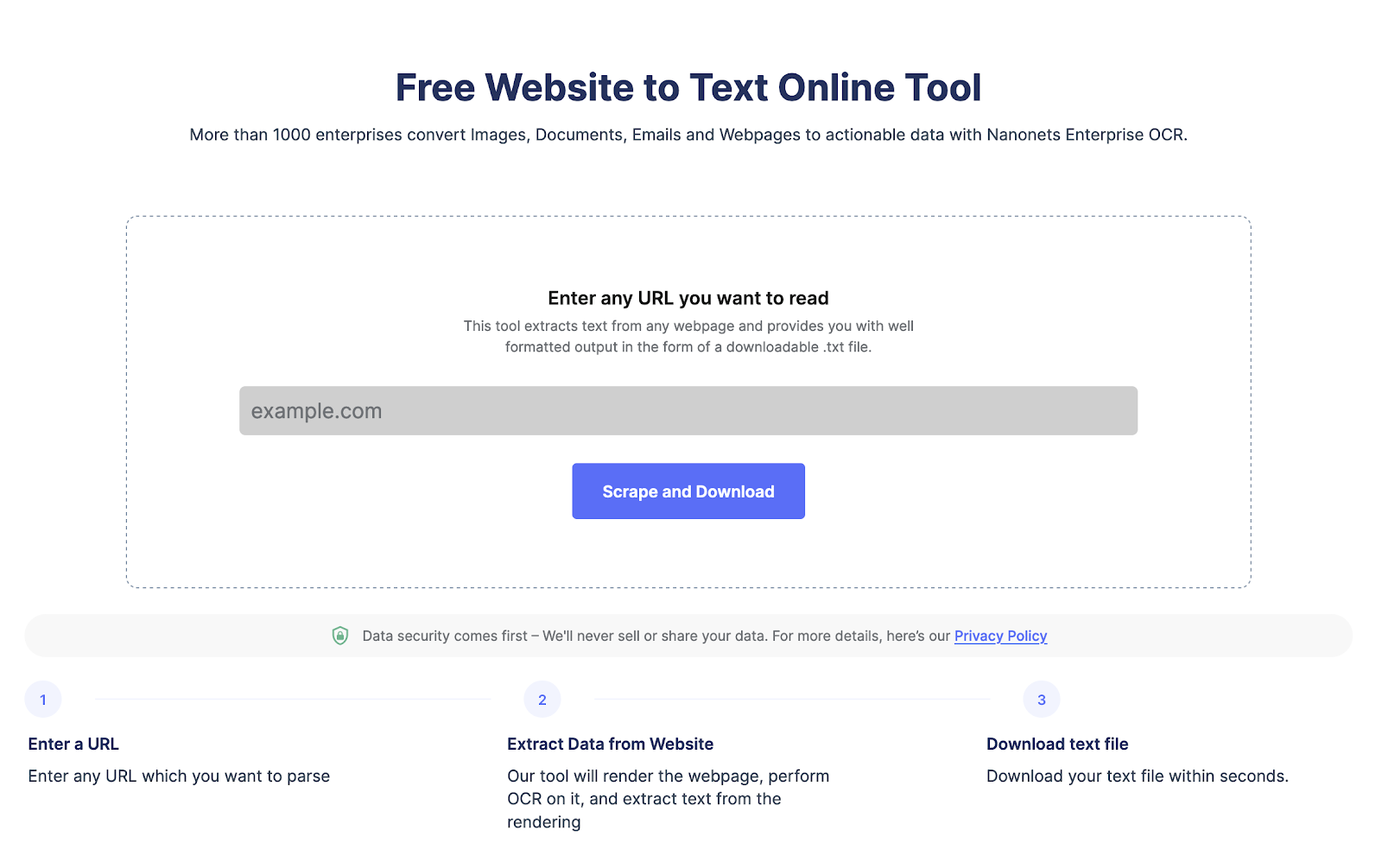

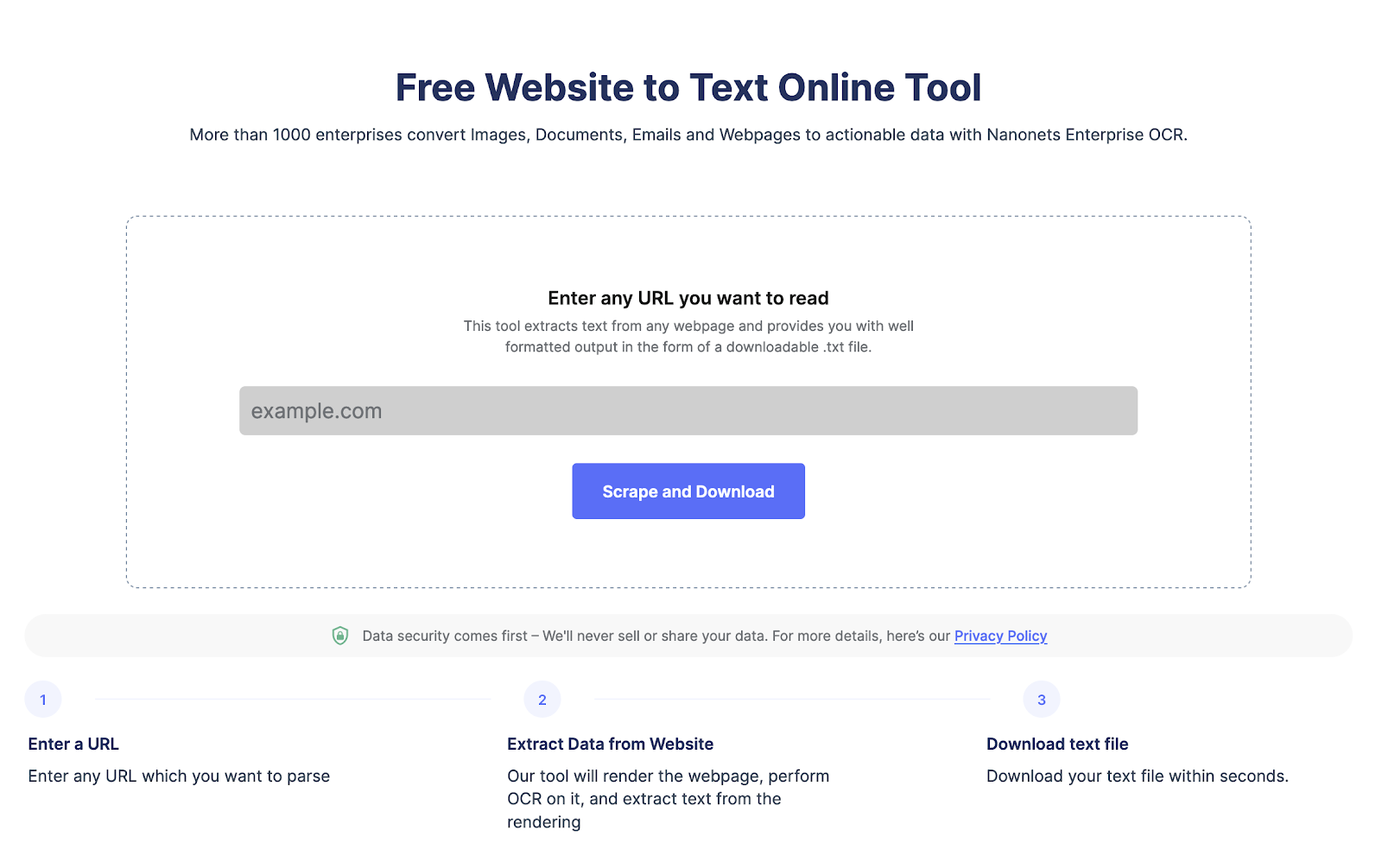

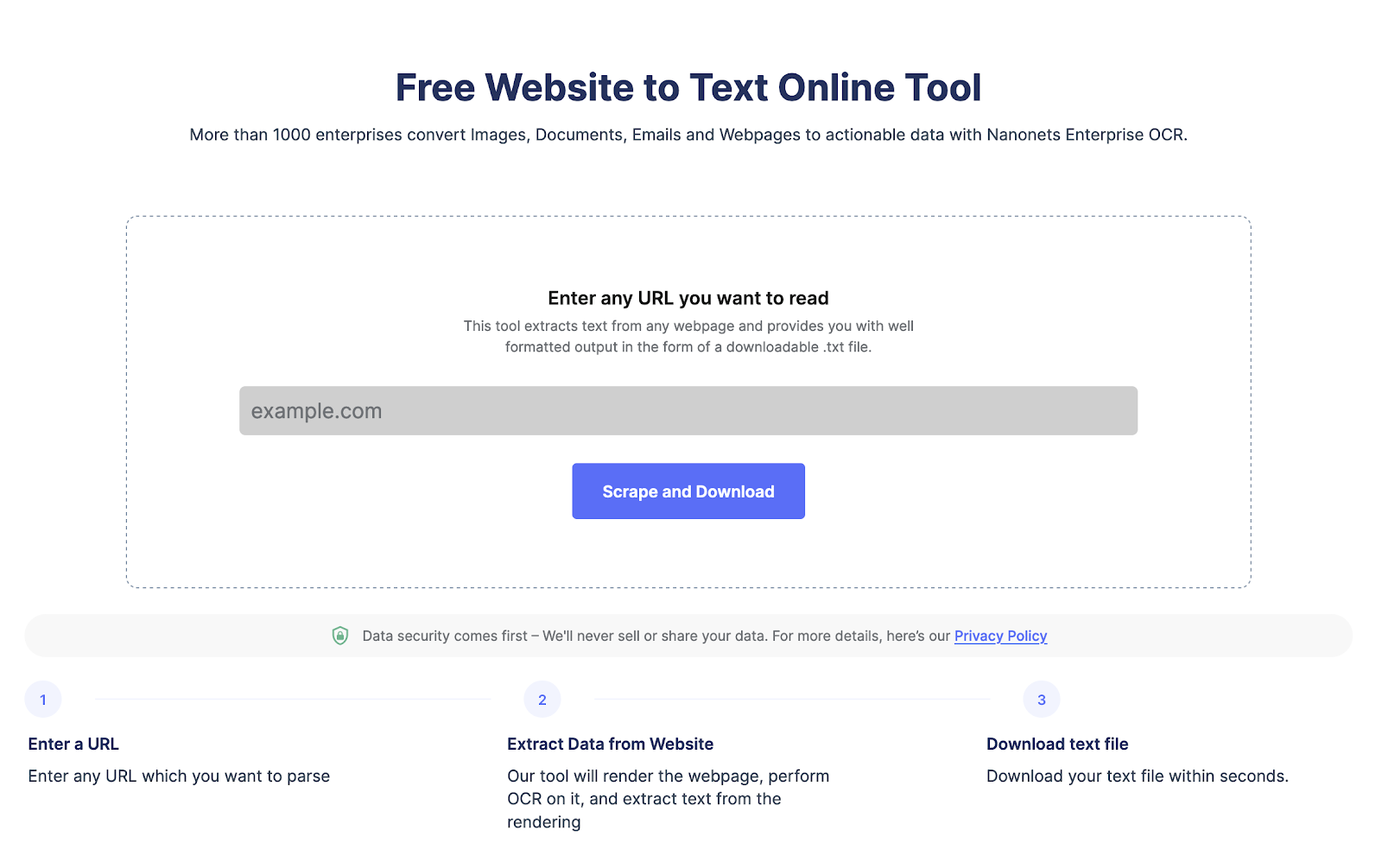

단 한 번의 클릭으로 모든 웹페이지에서 텍스트를 추출합니다. 로 이동 나노넷 웹사이트 스크레이퍼, URL을 추가하고 "스크랩"을 클릭하고 웹 페이지 텍스트를 파일로 즉시 다운로드하십시오. 지금 무료로 사용해 보세요.

Python을 사용하여 웹 사이트에서 데이터를 스크랩하는 방법은 무엇입니까?

Python을 사용하여 웹 사이트 데이터를 스크랩하는 단계별 프로세스를 살펴보겠습니다.

1단계: 웹사이트 및 웹페이지 URL 선택

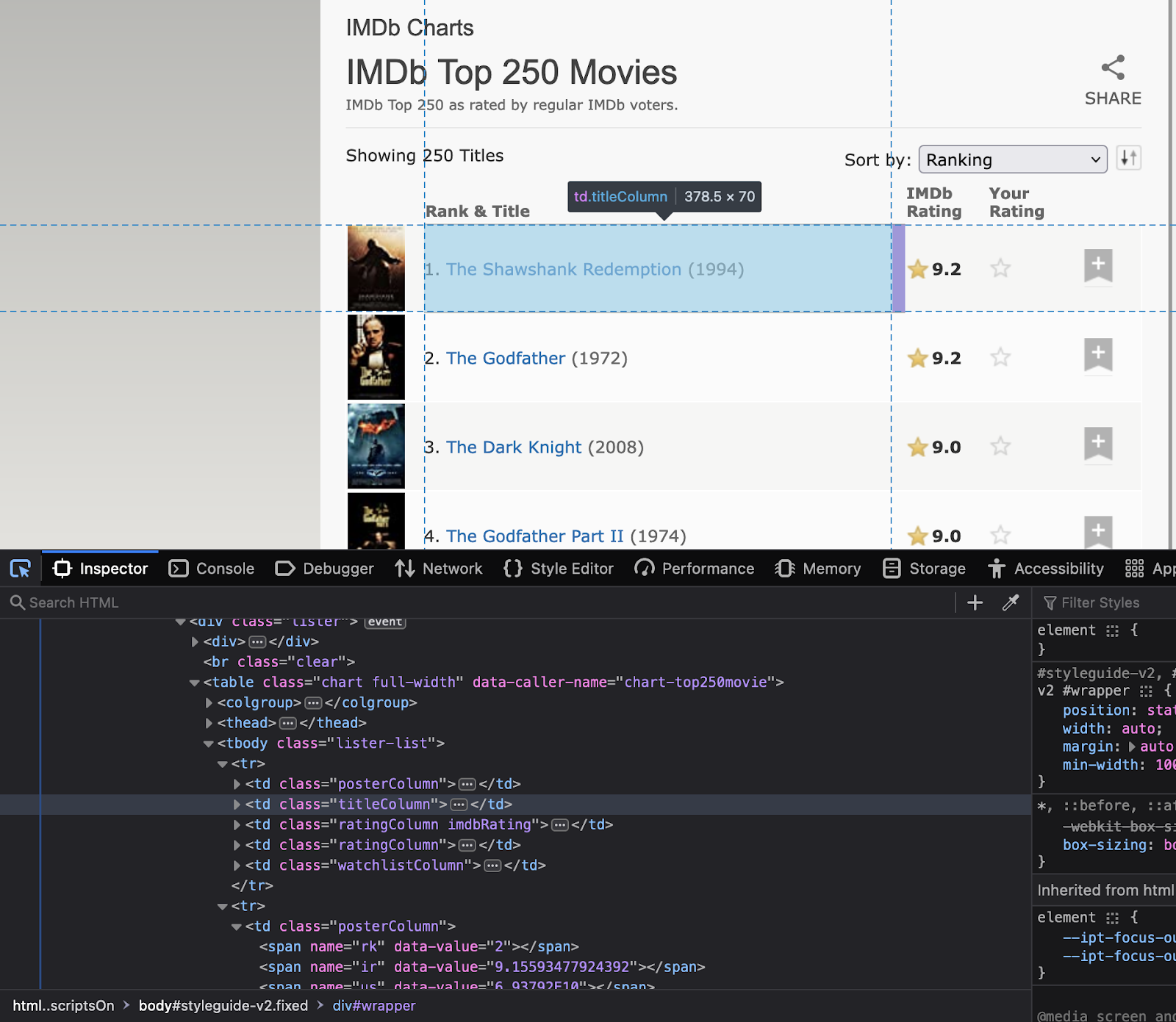

첫 번째 단계는 스크랩하려는 웹사이트를 선택하는 것입니다. 이 특정 자습서에서는 긁어 보겠습니다. https://www.imdb.com/. 우리는 웹사이트에서 최고 등급 영화에 대한 데이터를 추출하려고 노력할 것입니다.

2단계: 웹사이트 검사

이제 다음 단계는 웹 사이트 구조를 이해하는 것입니다. 관심 있는 요소의 속성이 무엇인지 이해합니다. 웹 사이트를 마우스 오른쪽 버튼으로 클릭하여 "검사"를 선택합니다. 이렇게 하면 HTML 코드가 열립니다. 인스펙터 도구를 사용하여 코드에서 사용할 모든 요소의 이름을 확인하십시오.

이러한 요소의 클래스 이름과 ID는 Python 코드에서 사용되므로 기록해 두십시오.

3단계: 중요한 라이브러리 설치

앞에서 설명한 것처럼 Python에는 여러 웹 스크래핑 라이브러리가 있습니다. 오늘은 다음 라이브러리를 사용할 것입니다.

- 요청 – 웹사이트에 HTTP 요청을 하기 위해

- 아름다운 수프 – HTML 코드를 파싱하기 위해

- 팬더 – 스크랩한 데이터를 데이터 프레임에 저장하기 위해

- 시간 – 요청으로 인해 웹사이트가 과부하되는 것을 방지하기 위해 요청 사이에 지연을 추가하기 위해

다음 명령을 사용하여 라이브러리를 설치합니다.

pip install requests beautifulsoup4 pandas time4단계: Python 코드 작성

이제 메인 파이썬 코드를 작성할 차례입니다. 코드는 다음 단계를 수행합니다.

- 요청을 사용하여 HTTP GET 요청 보내기

- BeautifulSoup을 사용하여 HTML 코드 구문 분석

- HTML 코드에서 필요한 데이터 추출

- pandas 데이터 프레임에 정보 저장

- 요청으로 인해 웹 사이트가 과부하되지 않도록 요청 사이에 지연을 추가하십시오.

다음은 IMDb에서 최고 등급의 영화를 스크랩하는 Python 코드입니다.

import requests

from bs4 import BeautifulSoup

import pandas as pd

import time

# URL of the website to scrape

url = "https://www.imdb.com/chart/top"

# Send an HTTP GET request to the website

response = requests.get(url)

# Parse the HTML code using BeautifulSoup

soup = BeautifulSoup(response.content, 'html.parser')

# Extract the relevant information from the HTML code

movies = []

for row in soup.select('tbody.lister-list tr'):

title = row.find('td', class_='titleColumn').find('a').get_text()

year = row.find('td', class_='titleColumn').find('span', class_='secondaryInfo').get_text()[1:-1]

rating = row.find('td', class_='ratingColumn imdbRating').find('strong').get_text()

movies.append([title, year, rating])

# Store the information in a pandas dataframe

df = pd.DataFrame(movies, columns=['Title', 'Year', 'Rating'])

# Add a delay between requests to avoid overwhelming the website with requests

time.sleep(1)5단계: 추출된 데이터 내보내기

이제 데이터를 CSV 파일로 내보내겠습니다. 우리는 pandas 라이브러리를 사용할 것입니다.

# Export the data to a CSV file

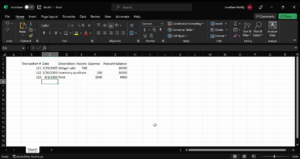

df.to_csv('top-rated-movies.csv', index=False)6단계: 추출된 데이터 확인

CSV 파일을 열어 데이터가 성공적으로 스크랩되고 저장되었는지 확인합니다.

이 튜토리얼이 웹 페이지에서 데이터를 쉽게 추출하는 데 도움이 되기를 바랍니다.

단 한 번의 클릭으로 모든 웹페이지에서 텍스트를 추출합니다. 로 이동 나노넷 웹사이트 스크레이퍼, URL을 추가하고 "스크랩"을 클릭하고 웹 페이지 텍스트를 파일로 즉시 다운로드하십시오. 지금 무료로 사용해 보세요.

웹 사이트에서 텍스트를 구문 분석하는 방법은 무엇입니까?

BeautifulSoup 또는 lxml을 사용하여 웹 사이트 텍스트를 쉽게 구문 분석할 수 있습니다. 다음은 코드와 관련된 단계입니다.

- URL에 HTTP 요청을 보내고 웹 페이지의 HTML 콘텐츠를 가져옵니다.

- HTML 구조가 있으면 BeautifulSoup의 find() 메서드를 사용하여 특정 HTML 태그 또는 속성을 찾습니다.

- 그런 다음 text 속성으로 텍스트 콘텐츠를 추출합니다.

다음은 BeautifulSoup을 사용하여 웹사이트에서 텍스트를 구문 분석하는 방법에 대한 코드입니다.:

import requests

from bs4 import BeautifulSoup

# Send an HTTP request to the URL of the webpage you want to access

response = requests.get("https://www.example.com")

# Parse the HTML content using BeautifulSoup

soup = BeautifulSoup(response.content, "html.parser")

# Extract the text content of the webpage

text = soup.get_text()

print(text)Python을 사용하여 HTML 양식을 긁는 방법은 무엇입니까?

Python을 사용하여 HTML 양식을 스크랩하려면 BeautifulSoup, lxml 또는 mechanize와 같은 라이브러리를 사용할 수 있습니다. 일반적인 단계는 다음과 같습니다.

- 스크랩하려는 양식이 있는 웹 페이지의 URL로 HTTP 요청을 보냅니다. 서버는 웹 페이지의 HTML 콘텐츠를 반환하여 요청에 응답합니다.

- HTML 콘텐츠에 액세스한 후에는 HTML 파서를 사용하여 스크랩하려는 양식을 찾을 수 있습니다. 예를 들어 BeautifulSoup의 find() 메서드를 사용하여 양식 태그를 찾을 수 있습니다.

- 양식을 찾으면 HTML 구문 분석기를 사용하여 입력 필드와 해당 값을 추출할 수 있습니다. 예를 들어 BeautifulSoup의 find_all() 메서드를 사용하여 양식 내에서 모든 입력 태그를 찾은 다음 해당 이름 및 값 특성을 추출할 수 있습니다.

- 그런 다음 이 데이터를 사용하여 양식을 제출하거나 추가 데이터 처리를 수행할 수 있습니다.

다음은 mechanize를 사용하여 HTML 양식을 스크랩하는 방법의 예입니다.

import mechanize

# Create a mechanize browser object

browser = mechanize.Browser()

# Send an HTTP request to the URL of the webpage with the form you want to scrape

browser.open("https://www.example.com/form")

# Select the form to scrape

browser.select_form(nr=0)

# Extract the input fields and their corresponding values

for control in browser.form.controls:

print(control.name, control.value)

# Submit the form

browser.submit()모든 웹페이지에서 텍스트 추출 단 한 번의 클릭으로. Nanonets 웹사이트 스크레이퍼로 이동하여 URL을 추가하고 "스크래핑"을 클릭하고 웹페이지 텍스트를 파일로 즉시 다운로드합니다. 지금 무료로 사용해 보세요.

모든 Python 웹 스크래핑 라이브러리 비교

모든 파이썬 웹 스크래핑 라이브러리를 비교해 봅시다. 모두 훌륭한 커뮤니티 지원을 제공하지만 블로그 시작 부분에서 언급한 것처럼 사용 편의성과 사용 사례가 다릅니다.

|

도서관 |

사용의 용이성 |

퍼포먼스 |

유연성 |

커뮤니티 지원 |

법적/윤리적 고려 사항 |

|

아름다운 수프 |

Easy |

보통 |

높은 |

높은 |

이용약관 준수 |

|

치료 |

보통 |

높은 |

높은 |

높은 |

이용약관 준수 |

|

셀레니움 |

Easy |

보통 |

높은 |

높은 |

모범 사례를 따르십시오 |

|

요청 |

Easy |

높은 |

높은 |

높은 |

이용약관 준수 |

|

파이 쿼리 |

Easy |

높은 |

높은 |

높은 |

이용약관 준수 |

|

LXML |

보통 |

높은 |

높은 |

높은 |

이용약관 준수 |

|

MechanicalSoup |

Easy |

보통 |

높은 |

높은 |

이용약관 준수 |

|

아름다운 수프 4 |

Easy |

보통 |

높은 |

높은 |

이용약관 준수 |

|

파이스파이더 |

Easy |

높은 |

높은 |

높은 |

이용약관 준수 |

결론

Python은 웹 사이트 데이터를 실시간으로 스크랩할 수 있는 훌륭한 옵션입니다. 또 다른 대안은 자동화를 사용하는 것입니다. 웹사이트 스크래핑 도구 l아이크 나노넷. 다음을 사용할 수 있습니다. 무료 웹사이트-텍스트 도구. 그러나 더 큰 프로젝트를 위해 웹 스크래핑을 자동화해야 하는 경우 Nanonets에 문의할 수 있습니다.

단 한 번의 클릭으로 모든 웹페이지에서 텍스트를 추출합니다. Nanonets 웹사이트 스크레이퍼로 이동하여 URL을 추가하고 "스크래핑"을 클릭하고 웹페이지 텍스트를 파일로 즉시 다운로드합니다. 지금 무료로 사용해 보세요.

자주 묻는 질문

Python을 사용하여 웹 스크래핑에 HTML 파서를 사용하는 방법은 무엇입니까?

Python에서 웹 스크래핑에 HTML 파서를 사용하려면 BeautifulSoup 또는 lxml과 같은 라이브러리를 사용할 수 있습니다. 일반적인 단계는 다음과 같습니다.

- 액세스하려는 웹 페이지의 URL로 HTTP 요청을 보냅니다. 서버는 웹 페이지의 HTML 콘텐츠를 반환하여 요청에 응답합니다.

- HTML 콘텐츠에 액세스한 후에는 HTML 파서를 사용하여 필요한 데이터를 추출할 수 있습니다. 예를 들어 BeautifulSoup의 find() 메서드를 사용하여 특정 HTML 태그 또는 속성을 찾은 다음 text 속성으로 텍스트 콘텐츠를 추출할 수 있습니다.

다음은 웹 스크래핑에 BeautifulSoup을 사용하는 방법의 예입니다.

파이썬

수입 요청

bs4에서 가져 오기 BeautifulSoup

# 액세스하려는 웹 페이지의 URL로 HTTP 요청을 보냅니다.

응답 = requests.get("https://www.example.com")

# BeautifulSoup을 사용하여 HTML 콘텐츠를 구문 분석

수프 = BeautifulSoup(response.content, "html.parser")

# 웹 페이지에서 특정 데이터 추출

제목 = 수프.제목

인쇄(제목)

이 예제에서는 BeautifulSoup을 사용하여 웹페이지의 HTML 콘텐츠를 구문 분석하고 title 속성을 사용하여 페이지의 제목을 추출합니다.

웹 스크래핑이 사용되는 이유는 무엇입니까?

웹 스크래핑은 자동화된 도구나 스크립트를 사용하여 웹 사이트 데이터를 스크랩하는 데 사용됩니다. 여러 용도로 사용할 수 있습니다

- 여러 웹 페이지에서 데이터를 추출하고 추가 분석을 위해 데이터를 집계합니다.

- 다양한 타임스탬프에 대한 실시간 데이터를 스크래핑하여 트렌드를 도출합니다.

- 경쟁사 가격 추세 모니터링.

- 웹사이트에서 이메일을 스크랩하여 리드를 생성합니다.

웹 스크래핑이란?

웹 스크래핑 비정형 HTML 웹사이트에서 정형 데이터를 추출하는 데 사용했습니다. 웹 스크래핑에는 자동화된 사용이 포함됩니다. 웹 스크래핑 도구 또는 복잡한 웹 페이지를 구문 분석하는 스크립트.

웹 스크래핑은 합법적입니까?

웹 스크래핑은 웹사이트에서 공개적으로 사용 가능한 데이터를 구문 분석하려고 할 때 합법적입니다. 일반적으로 개인용 또는 비상업적 목적의 웹 스크래핑은 합법입니다. 그러나 저작권으로 보호되거나 기밀 또는 비공개로 간주되는 데이터를 스크랩하면 법적 문제가 발생할 수 있습니다.

경우에 따라 웹 스크래핑은 웹사이트의 서비스 약관을 위반할 수 있습니다. 많은 웹사이트에는 콘텐츠의 자동 스크랩을 금지하는 용어가 포함되어 있습니다. 웹사이트 소유자는 누군가가 자신의 콘텐츠를 스크랩하고 있음을 발견하면 이를 중지하기 위해 법적 조치를 취할 수 있습니다.

파이썬이 웹 스크래핑에 좋은 이유는 무엇입니까?

Python은 다음과 같은 몇 가지 장점을 제공하기 때문에 웹 스크래핑에 널리 사용되는 프로그래밍 언어입니다.

- Python은 간단하고 읽기 쉬운 구문을 가지고 있으며 초보자가 배우기 쉽습니다.

- Python에는 웹 스크래핑과 같은 다양한 작업을 위한 도구를 개발하는 거대한 개발자 커뮤니티가 있습니다.

- Python에는 Beautiful Soup 및 Scrapy와 같은 많은 웹 스크래핑 라이브러리가 있습니다.

- Python은 스크래핑과 같은 많은 작업을 수행할 수 있습니다. 웹사이트 데이터를 엑셀로 추출, HTML 양식과의 상호 작용 등.

- Python은 확장 가능하므로 대량의 데이터를 스크래핑하는 데 적합합니다.

웹 스크래핑의 예는 무엇입니까?

웹 스크래핑은 자동화된 스크립트 또는 도구를 사용하여 웹 페이지에서 데이터를 추출하는 것입니다. 예를 들어 웹 스크래핑은 리드 생성을 위해 웹사이트에서 이메일을 스크랩하는 데 사용됩니다. 또 다른 웹 스크래핑 예는 가격 구조를 개선하기 위해 경쟁사 가격 정보를 추출하는 것입니다.

웹 스크래핑에 코딩이 필요합니까?

웹 스크래핑은 구조화되지 않은 웹사이트 데이터를 구조화된 형식으로 변환합니다. 코딩을 사용하여 웹사이트를 스크랩하는 것 외에도 코딩이 전혀 필요하지 않은 완전히 코드 없는 웹 스크래핑 도구를 사용할 수 있습니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- 플라토 블록체인. Web3 메타버스 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 출처: https://nanonets.com/blog/web-scraping-with-python-tutorial/

- :이다

- 1

- 11

- 7

- 77

- a

- 풍부

- ACCESS

- 액세스

- 동작

- 행위

- 장점

- All

- 수

- 대안

- 분석

- 분석하다

- 및

- 다른

- 분리

- API를

- 어플리케이션

- 있군요

- AS

- At

- 속성

- 인증

- 자동화

- 자동화

- 오토마타

- 자동화

- 가능

- BE

- 아름다운

- 때문에

- 초급

- BEST

- 사이에

- 블로그

- 브라우저

- 브라우저

- by

- CAN

- 가지 경우

- 왼쪽 메뉴에서

- 크롬

- 수업

- 클릭

- 클라이언트

- 닫기

- 암호

- 코딩

- COM

- 커뮤니티

- 비교

- 경쟁자

- 완전히

- 복잡한

- 결론

- 연결

- 고려

- 일관된

- CONTACT

- 함유량

- 제어

- 컨트롤

- 쿠키

- 저작권

- 동

- 만들

- 데이터

- 데이터 처리

- 데이터베이스

- 지연

- 설계

- 세부설명

- 개발

- 개발자

- 다르다

- 다른

- 발견

- 논의 된

- 문서

- 서류

- 다운로드

- 이전

- 사용의 용이성

- 용이하게

- 효율적으로

- 요소

- 이메일

- 오류

- 에테르 (ETH)

- 예

- 뛰어나다

- 우수한

- 수출

- 추출물

- 데이터 추출

- 특징

- Fields

- 입양 부모로서의 귀하의 적합성을 결정하기 위해 미국 이민국에

- 채우기

- 파이어 폭스

- 먼저,

- 수행원

- 럭셔리

- 형태

- 체재

- 양식

- 무료

- 에

- 추가

- 일반

- 세대

- 얻을

- 좋은

- 핸들

- 처리

- 처리

- 있다

- 머리

- 헤더

- 도움

- 여기에서 지금 확인해 보세요.

- 고수준

- 기대

- 방법

- How To

- 그러나

- HTML

- HTTP

- HTTPS

- 거대한

- 사람의

- i

- import

- 중대한

- 개선

- in

- 포함

- 포함

- 정보

- 입력

- 설치

- 설치

- 상호 작용하는

- 상호 작용

- 상호 작용

- 관심

- 직관적인

- 참여

- 문제

- IT

- 그

- JSON

- 딱 하나만

- 알려진

- 언어

- 넓은

- 큰

- 리드

- 오퍼

- 배우다

- 이용약관

- 법적 조치

- 법적인 문제

- 도서관

- 도서관

- 처럼

- 상장 된

- 위치한

- 보기

- 롯

- 본관

- 제작

- 유튜브 영상을 만드는 것은

- 조작하는

- 수동으로

- .

- 말하는

- 메타

- 방법

- 배우기

- 영화 산업

- 여러

- name

- 이름

- 이동

- 필요

- 다음 것

- 비상업적

- 대상

- of

- 제공

- on

- ONE

- 열 수

- 선택권

- 기타

- 소유자

- 페이지

- 팬더

- 특별한

- 수행

- 확인

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 인기 문서

- 게시하다

- 강한

- 가격

- 사설

- 방법

- 처리

- 프로그램 작성

- 금지하다

- 프로젝트

- 보호

- 제공

- 공개적으로

- 목적

- Python

- 평가

- 현실

- 실시간

- 실시간 데이터

- 정규병

- 관련된

- 반복적 인

- 의뢰

- 요청

- 필요

- 필수

- 응답

- 반환

- 마우스 오른쪽 단추로 클릭

- 강력한

- 열

- s

- Safari

- 확장성

- 스크 레이 핑

- 스크립트

- 스크롤

- 서비스

- 몇몇의

- 단순, 간단, 편리

- 간단

- 느리게

- 일부

- 어떤 사람

- 기간

- 구체적인

- SQL

- SSL

- 스타트

- 단계

- 단계

- 중지

- 저장

- 저장

- 강한

- 구조

- 구조화

- 제출

- 성공적으로

- 이러한

- 적당한

- SUPPORT

- 지원

- 구문

- TAG

- 받아

- 작업

- TD

- 조건

- 서비스 약관

- 지원

- 그

- XNUMXD덴탈의

- 정보

- 그들의

- 그들

- Bowman의

- 타사

- 을 통하여

- 시간

- 시간이 많이 걸리는

- Title

- 제목들

- 에

- 오늘

- 너무

- 수단

- 검색을

- 상단

- 변환

- 트렌드

- 지도 시간

- 이해

- URL

- 사용

- 사용자

- 가치

- 마케팅은:

- 여러

- 확인

- 확인

- 볼륨

- 웹

- 웹 애플리케이션

- 웹 브라우저

- 웹 브라우저

- 웹 스크래핑

- 웹 사이트

- 웹 사이트

- 뭐

- 어느

- 크게

- 의지

- 과

- 이내

- 쓰다

- XML

- year

- 너의

- 제퍼 넷