퍼듀대학교 연구진이 “WWW: What, When, Where to Compute-in-Memory”라는 기술 논문을 발표했습니다.

요약 :

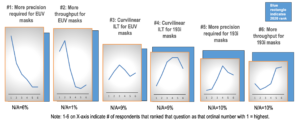

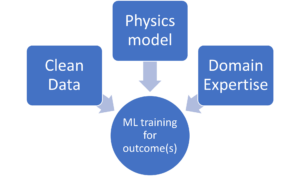

“CiM(Compute-in-Memory)은 von Neumann 시스템의 높은 데이터 이동 비용을 완화하는 강력한 솔루션으로 부상했습니다. CiM은 기계 학습(ML) 추론의 주요 계산인 메모리에서 대규모 병렬 일반 행렬 곱셈(GEMM) 작업을 수행할 수 있습니다. 그러나 컴퓨팅을 위한 메모리 용도 변경은 1) 사용할 CiM 유형: 다수의 아날로그 및 디지털 CiM이 주어지면 시스템 관점에서 적합성을 결정해야 한다는 주요 질문을 제기합니다. 2) CiM을 사용하는 경우: ML 추론에는 다양한 메모리 및 컴퓨팅 요구 사항이 있는 워크로드가 포함되므로 CiM이 표준 처리 코어보다 더 유용한 시기를 식별하기 어렵습니다. 3) CiM 통합 위치: 각 메모리 수준에는 대역폭과 용량이 다르며 이는 CiM 통합의 데이터 이동 및 지역성 이점에 영향을 미칩니다.

이 문서에서는 ML 추론 가속화를 위한 CiM 통합과 관련된 이러한 질문에 대한 답변을 살펴봅니다. 우리는 아날로그 및 디지털 프리미티브를 모두 포함하는 CiM 프로토타입의 초기 시스템 수준 평가에 Timeloop-Accelergy를 사용합니다. 우리는 CiM을 Nvidia A100과 유사한 기본 아키텍처의 다양한 캐시 메모리 수준에 통합하고 다양한 ML 워크로드에 맞게 데이터 흐름을 조정합니다. 우리의 실험에서는 CiM 아키텍처가 에너지 효율성을 향상시켜 INT-0.12 정밀도로 설정된 기준보다 최대 8배 더 낮은 에너지를 달성하고 가중치 인터리빙 및 복제를 통해 최대 4배의 성능 향상을 달성하는 것으로 나타났습니다. 제안된 작업은 사용할 CiM 유형과 GEMM 가속화를 위해 캐시 계층 구조에서 CiM을 언제, 어디서 최적으로 통합할지에 대한 통찰력을 제공합니다.”

찾기 여기에 기술 문서가 있습니다. 2023년 XNUMX월 출판(사전 인쇄).

샤르마, 탄비, 무스타파 알리, 인드라닐 차크라보르티, 카우식 로이. “WWW: 무엇을, 언제, 어디서 메모리 내 컴퓨팅을 수행할 것인가.” arXiv 사전 인쇄 arXiv:2312.15896(2023).

관련 독서

메모리 내 컴퓨팅을 통해 AI 에너지 효율성 향상

제타스케일 워크로드를 처리하고 고정 전력 예산 내에서 유지하는 방법

생물학적 효율성을 갖춘 메모리 내 컴퓨팅 모델링

Generative AI는 칩 제조업체가 컴퓨팅 리소스를 보다 지능적으로 사용하도록 합니다.

AI의 SRAM: 메모리의 미래

SRAM이 새로운 컴퓨팅 아키텍처와 기존 컴퓨팅 아키텍처에서 중요한 요소로 간주되는 이유.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :있다

- :이다

- :어디

- $UP

- 1

- 2023

- a

- 가속

- 달성

- AI

- 덜다

- an

- 및

- 답변

- 아키텍처

- AS

- At

- 대역폭

- 기준

- 유익한

- 혜택

- 두

- 예산

- by

- 캐시

- CAN

- 생산 능력

- 강요하는

- 계산

- 계산

- 비용

- 임계

- 데이터

- XNUMX월

- 결정

- 다른

- 어려운

- 디지털

- 지배적 인

- 마다

- 초기의

- 효율성

- 요소

- 등장

- 에너지

- 에너지 효율

- 확립 된

- 평가

- 실험

- 탐험

- 고정

- 럭셔리

- 군

- 에

- 미래

- 이익

- 일반

- 주어진

- 여기에서 지금 확인해 보세요.

- 계층

- 높은

- 그러나

- HTTPS

- 확인

- 개선

- in

- 포함

- 포함

- 통찰력

- 통합

- 완성

- 으로

- IT

- JPG

- 키

- 배우기

- 레벨

- 레벨

- 절감

- 기계

- 기계 학습

- 기계

- 유튜브 영상을 만드는 것은

- 거대한

- 매트릭스

- 메모리

- ML

- 배우기

- 운동

- 다수

- 필요

- 신제품

- 엔비디아

- of

- on

- 열 수

- 행정부

- 우리의

- 서

- 평행

- 수행

- 성능

- 관점

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 포즈

- 힘

- Precision

- 방법

- 처리

- 제안 된

- 프로토 타입

- 제공

- 출판

- 문의

- 에 관한

- 요구조건 니즈

- 연구원

- 제품 자료

- 로이

- 표시

- 해결책

- 표준

- 유지

- 적당

- 시스템은

- 테크니컬

- 보다

- 그

- XNUMXD덴탈의

- 미래

- 그들의

- Bowman의

- 이

- 제목의

- 에

- 전통적인

- 유형

- 대학

- 사용

- 종류

- 여러

- 열람 한

- 의

- 였다

- we

- 무게

- 뭐

- 언제

- 과

- 이내

- 작업

- 제퍼 넷