これは、Qualcomm AI の AK Roy によるゲスト投稿です。

Amazon Elastic Compute Cloud(Amazon EC2) Qualcomm AI 2 Standard アクセラレータを搭載した DL100q インスタンスを使用すると、コスト効率よくクラウドにディープ ラーニング (DL) ワークロードをデプロイできます。 また、Qualcomm デバイスにデプロイされる DL ワークロードのパフォーマンスと精度を開発および検証するために使用することもできます。 DL2q インスタンスは、クアルコムの人工知能 (AI) テクノロジーをクラウドに導入した最初のインスタンスです。

100 つの Qualcomm AI 128 Standard アクセラレータと合計 2 GiB のアクセラレータ メモリにより、お客様は DL100q インスタンスを使用して、コンテンツ生成、テキスト要約、仮想アシスタントなどの一般的な生成 AI アプリケーションや、自然言語処理用のクラシック AI アプリケーションを実行することもできます。そしてコンピュータービジョン。 さらに、Qualcomm AI 2 アクセラレータは、スマートフォン、自動運転、パーソナル コンピュータ、拡張現実ヘッドセットで使用されているものと同じ AI テクノロジーを備えているため、DLXNUMXq インスタンスを使用して、展開前にこれらの AI ワークロードを開発および検証できます。

新しい DL2q インスタンスのハイライト

各 DL2q インスタンスには 100 つの Qualcomm Cloud AI2.8 アクセラレータが組み込まれており、Int8 推論パフォーマンスで 1.4 PetaOps、FP16 推論パフォーマンスで 112 PetaFlops を超える合計パフォーマンスを実現します。 このインスタンスには、合計 128 個の AI コア、アクセラレータ メモリ容量 1.1 GB、メモリ帯域幅 XNUMX TB/秒があります。

各 DL2q インスタンスには 96 個の vCPU、768 GB のシステム メモリ容量があり、100 Gbps のネットワーク帯域幅をサポートします。 Amazon Elastic Block Store (Amazon EBS) 19Gbpsのストレージ。

| インスタンス名 | vCPU | クラウド AI100 アクセラレータ | アクセラレータメモリ | アクセラレータ メモリ BW (集約) | インスタンスメモリ | インスタンスネットワーキング | ストレージ (Amazon EBS) の帯域幅 |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB /秒 | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 アクセラレータのイノベーション

Cloud AI100 アクセラレータ システムオンチップ (SoC) は、専用に構築されたスケーラブルなマルチコア アーキテクチャであり、データセンターからエッジに至る幅広いディープラーニングのユースケースをサポートします。 この SoC は、業界をリードする 126 MB のオンダイ SRAM 容量を備えたスカラー、ベクトル、およびテンソルのコンピューティング コアを採用しています。 コアは、高帯域幅、低遅延のネットワークオンチップ (NoC) メッシュで相互接続されています。

AI100 アクセラレータは、広範囲かつ包括的なモデルとユースケースをサポートします。 以下の表は、サポートされるモデルの範囲を示しています。

| モデルカテゴリ | モデルの数 | 例 |

| NLP | 157 | BERT、BART、FasterTransformer、T5、Z コード MOE |

| 生成 AI – NLP | 40 | LLaMA、CodeGen、GPT、OPT、BLOOM、Jais、Luminous、StarCoder、XGen |

| 生成 AI – 画像 | 3 | 安定した拡散 v1.5 および v2.1、OpenAI CLIP |

| CV – 画像分類 | 45 | ViT、ResNet、ResNext、MobileNet、EfficientNet |

| CV – 物体検出 | 23 | YOLO v2、v3、v4、v5、および v7、SSD-ResNet、RetinaNet |

| 履歴書 – その他 | 15 | LPRNet、超解像度/SRGAN、ByteTrack |

| 車載ネットワーク* | 53 | 知覚と LIDAR、歩行者、車線、信号機の検出 |

| 合計 | > 300 ,war | ,war |

※自動車ネットワークの多くは、個々のネットワークが融合して構成される複合ネットワークです。

DL2q アクセラレータ上の大容量オンダイ SRAM により、重みを保存するための MX6 マイクロ指数精度やアクセラレータ間の通信のための MX9 マイクロ指数精度などの高度なパフォーマンス技術を効率的に実装できます。 マイクロ指数テクノロジーについては、次の Open Compute Project (OCP) 業界発表で説明されています。 AMD、Arm、Intel、Meta、Microsoft、NVIDIA、Qualcomm が AI 用の次世代狭精度データ形式を標準化 » オープン コンピューティング プロジェクト.

インスタンス ユーザーは、次の戦略を使用して、コストあたりのパフォーマンスを最大化できます。

- MX6 マイクロ指数精度を使用して重みをアクセラレータ上の DDR メモリに保存します。 MX6 精度を使用すると、利用可能なメモリ容量とメモリ帯域幅が最大限に活用され、クラス最高のスループットとレイテンシが実現します。

- FP16 で計算して、必要なユースケースの精度を実現しながら、カード上の優れたオンチップ SRAM と予備の TOP を使用して、高性能、低遅延の MX6 から FP16 カーネルを実装します。

- オンチップのアクティベーションを可能な限り最大限に維持しながら、重みの再利用を最大化するために利用可能な大規模なオンチップ SRAM を使用して、最適化されたバッチ戦略とより大きなバッチ サイズを使用します。

DL2q AI スタックとツールチェーン

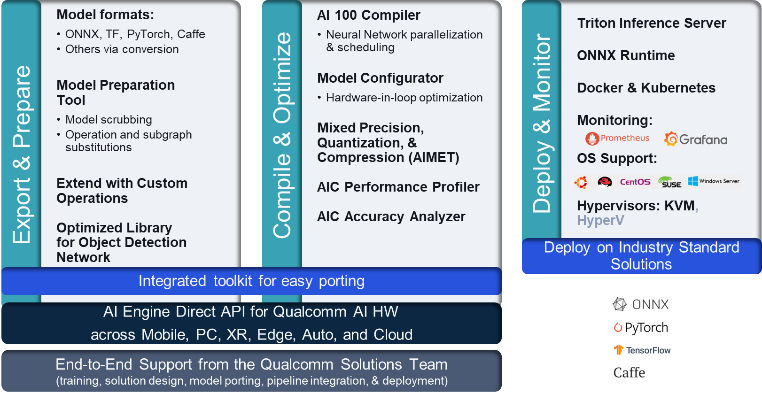

DL2q インスタンスには、クラウド上の Qualcomm AI および他の Qualcomm 製品にわたって一貫した開発者エクスペリエンスを提供する Qualcomm AI スタックが付属しています。 同じ Qualcomm AI スタックとベース AI テクノロジーが DL2q インスタンスと Qualcomm エッジ デバイス上で実行され、クラウド、自動車、パーソナル コンピューター、拡張現実、スマートフォンの開発環境全体で統一された API を使用して、一貫した開発者エクスペリエンスを顧客に提供します。

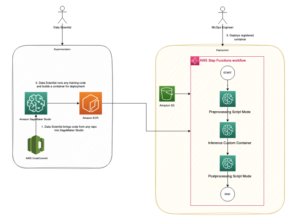

ツールチェーンを使用すると、インスタンス ユーザーは、次の図に示す XNUMX つのステップで、以前にトレーニングされたモデルを迅速にオンボードし、インスタンスの機能に合わせてモデルをコンパイルおよび最適化し、その後、コンパイルされたモデルを本番推論のユースケースにデプロイできます。

モデルのパフォーマンスの調整の詳細については、「 Cloud AI 100 の主要なパフォーマンス パラメータ ドキュメンテーション。

DL2q インスタンスを使ってみる

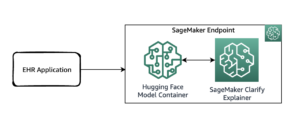

この例では、事前トレーニングされた BERTモデル から ハグ顔 事前に構築された利用可能な DL2q AMI を使用して、EC2 DL2q インスタンスを XNUMX つのステップで実行します。

事前に構築されたいずれかを使用できます クアルコム DLAMI インスタンス上で実行するか、Amazon Linux2 AMI から開始して、このサービスで利用可能な Cloud AI 2 プラットフォームとアプリ SDK を使用して独自の DL100q AMI を構築します。 Amazon Simple Storage Service(Amazon S3) バケツ: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

次の手順では、事前に構築された DL2q AMI を使用します。 クアルコムベース AL2 DLAMI.

SSH を使用して、Qualcomm Base AL2 DLAMI AMI で DL2q インスタンスにアクセスし、手順 1 ~ 4 に従います。

ステップ 1. 環境をセットアップし、必要なパッケージをインストールする

- Python3.8をインストールします。

- Python 3.8 仮想環境をセットアップします。

- Python 3.8 仮想環境をアクティブ化します。

- に示されている必要なパッケージをインストールします。 要件.txt ドキュメント クアルコムのパブリック Github サイトから入手できます。

- 必要なライブラリをインポートします。

ステップ 2. モデルをインポートする

- モデルをインポートしてトークン化します。

- サンプル入力を定義し、

inputIdsおよびattentionMask. - モデルを ONNX に変換すると、コンパイラに渡すことができます。

- モデルを FP16 精度で実行します。 したがって、モデルに FP16 の範囲を超える定数が含まれているかどうかを確認する必要があります。 モデルをに渡します

fix_onnx_fp16必要な修正を含む新しい ONNX ファイルを生成する機能。

ステップ 3. モデルをコンパイルする

qaic-exec モデルのコンパイルにはコマンド ライン インターフェイス (CLI) コンパイラ ツールが使用されます。 このコンパイラへの入力は、手順 2 で生成された ONNX ファイルです。コンパイラは、バイナリ ファイル ( QPC、用 クアルコムプログラムコンテナ) によって定義されたパス内 -aic-binary-dir 引数。

以下のコンパイル コマンドでは、XNUMX つの AI コンピューティング コアと XNUMX のバッチ サイズを使用してモデルをコンパイルします。

QPC は次の場所で生成されます。 bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc フォルダにコピーします。

ステップ 4. モデルを実行する

DL100q インスタンスの Cloud AI2 Qualcomm アクセラレータで推論を実行するセッションをセットアップします。

Qualcomm qaic Python ライブラリは、Cloud AI100 アクセラレータでの推論の実行のサポートを提供する API セットです。

- セッション API 呼び出しを使用して、セッションのインスタンスを作成します。 セッション API 呼び出しは、qaic Python ライブラリを使用するためのエントリ ポイントです。

- 次のように出力バッファからデータを再構築します。

output_shapeおよびoutput_type. - 生成された出力をデコードします。

以下は、入力文「マットの上の犬 [マスク]」の出力です。

それでおしまい。 わずか数ステップで、Amazon EC2 DL2q インスタンス上で PyTorch モデルをコンパイルして実行できました。 DL2q インスタンスでのモデルのオンボーディングとコンパイルの詳細については、「 Cloud AI100 チュートリアル ドキュメント。

どの DL モデル アーキテクチャが AWS DL2q インスタンスに適しているか、および現在のモデル サポート マトリックスの詳細については、 クアルコム クラウド AI100 ドキュメント.

利用可能になりました

現在、米国西部 (オレゴン) とヨーロッパ (フランクフルト) の AWS リージョンで DL2q インスタンスを起動できます。 オンデマンドセミナー, 予約済み, スポットインスタンス、またはの一部として 貯蓄プラン。 Amazon EC2 では通常どおり、使用した分だけお支払いいただきます。 詳細については、「」を参照してください。 AmazonEC2の価格.

DL2q インスタンスは、次を使用してデプロイできます。 AWS ディープラーニング AMI (DLAMI)、コンテナー イメージは、次のようなマネージド サービスを通じて利用できます。 アマゾンセージメーカー, Amazon エラスティック Kubernetes サービス (Amazon EKS), Amazon Elastic Container Service(Amazon ECS), AWS パラレルクラスター.

詳細については、 Amazon EC2 DL2q インスタンス ページにアクセスし、フィードバックを送信してください EC2 用の AWS re:Post または、通常の AWS サポートの連絡先を通じて。

著者について

AKロイ クアルコムの製品管理ディレクターであり、クラウドおよびデータセンター AI 製品とソリューションを担当しています。 彼は製品戦略と開発において 20 年以上の経験があり、現在は幅広いユースケースに対応する、クラウドでの AI 推論のためのクラス最高のパフォーマンスとパフォーマンス/コストのエンドツーエンド ソリューションに焦点を当てています。 GenAI、LLM、自動 AI、ハイブリッド AI が含まれます。

AKロイ クアルコムの製品管理ディレクターであり、クラウドおよびデータセンター AI 製品とソリューションを担当しています。 彼は製品戦略と開発において 20 年以上の経験があり、現在は幅広いユースケースに対応する、クラウドでの AI 推論のためのクラス最高のパフォーマンスとパフォーマンス/コストのエンドツーエンド ソリューションに焦点を当てています。 GenAI、LLM、自動 AI、ハイブリッド AI が含まれます。

ラング・ジャンイン AWS Worldwide Specialist Organization (WWSO) の主任ソリューションアーキテクトです。 彼女は HPC および AI 分野で 15 年以上の実務経験があります。 AWS では、顧客が高速化されたコンピューティング インスタンス上で AI/ML ワークロードをデプロイ、最適化、拡張できるよう支援することに重点を置いています。 彼女は、HPC と AI 分野の技術を組み合わせることに情熱を注いでいます。 Jianying は、コロラド大学ボルダー校で計算物理学の博士号を取得しています。

ラング・ジャンイン AWS Worldwide Specialist Organization (WWSO) の主任ソリューションアーキテクトです。 彼女は HPC および AI 分野で 15 年以上の実務経験があります。 AWS では、顧客が高速化されたコンピューティング インスタンス上で AI/ML ワークロードをデプロイ、最適化、拡張できるよう支援することに重点を置いています。 彼女は、HPC と AI 分野の技術を組み合わせることに情熱を注いでいます。 Jianying は、コロラド大学ボルダー校で計算物理学の博士号を取得しています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :持っている

- :は

- $UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15年

- 視聴者の38%が

- 17

- 19

- 20

- 20年

- 22

- 23

- 46

- 7

- 75

- 8

- 84

- a

- 私たちについて

- 上記の.

- 加速された

- 加速器

- 加速器

- アクセス

- 付随する

- 精度

- 越えて

- アクティベーション

- さらに

- 高度な

- 集計

- AI

- AI / ML

- すべて

- また

- Amazon

- Amazon EC2

- Amazon Webサービス

- an

- および

- お知らせ

- どれか

- API

- API

- アプリ

- 建築

- です

- 引数

- ARM

- 人工の

- AS

- アシスタント

- At

- オート

- 自動車

- 自律的

- 利用できます

- AWS

- 軸

- 帯域幅

- ベース

- バッチング

- BE

- 以下

- 越えて

- BIN

- ブロック

- ブルーム

- 持って来る

- 広い

- バッファ

- ビルド

- by

- コール

- 呼ばれます

- 缶

- 機能

- 容量

- カード

- 場合

- チェック

- クラシック

- クラウド

- コロラド州

- 結合

- コミュニケーション

- コンパイル

- 包括的な

- 計算的

- 計算

- コンピュータ

- Computer Vision

- コンピューター

- コンピューティング

- 整合性のある

- からなる

- コンタクト

- コンテナ

- 含まれています

- コンテンツ

- 作ります

- 電流プローブ

- Customers

- データ

- データセンター

- 深いです

- 深い学習

- 定義済みの

- 度

- 配信する

- 提供します

- 展開します

- 展開

- 展開

- 記載された

- 開発する

- Developer

- 開発

- デバイス

- Devices

- 取締役

- ドキュメント

- 犬

- 運転

- ダイナミック

- EBS

- エッジ(Edge)

- 効率的な

- どちら

- 従業員

- 可能

- 端から端まで

- エントリ

- 環境

- 環境

- エーテル(ETH)

- ヨーロッパ

- 例

- 体験

- 拡張現実

- エキス

- false

- 特徴

- フィードバック

- 少数の

- フィールド

- フィールズ

- フィギュア

- File

- 名

- フィット

- 修正

- フォーカス

- 焦点を当てて

- フォロー中

- 発見

- 4

- フランクフルト

- から

- function

- 融合

- 一般に

- 生成する

- 生成された

- 世代

- 生々しい

- 生成AI

- GitHubの

- 与えられた

- 良い

- ゲスト

- ゲストのポスト

- he

- ヘッドセット

- 助け

- こちら

- ハイパフォーマンス

- より高い

- ハイライト

- 保持している

- hpc

- HTML

- HTTPS

- ハイブリッド

- i

- IDX

- if

- 画像

- 画像

- 実装する

- 実装

- import

- in

- 含めて

- 組み込む

- 個人

- 産業を変えます

- 業界をリードする

- 情報

- install

- インスタンス

- インテル

- インテリジェント-

- 相互接続

- インタフェース

- IT

- JPG

- ただ

- キー

- Kubernetes

- レーン

- 言語

- 大

- レイテンシ

- 起動する

- LEARN

- 学習

- ライブラリ

- 図書館

- 対処

- 光

- LINE

- 負荷

- マネージド

- 管理

- mask

- マトリックス

- マックス

- 最大化します

- 最大化する

- メモリ

- メッシュ

- Meta

- Microsoft

- 分

- モデル

- 修正されました

- 他には?

- 最も

- 名

- ナチュラル

- 自然言語

- 自然言語処理

- 必要

- 必要

- ネットワーク

- ネットワーキング

- ネットワーク

- 新作

- 次世代

- 今

- numpy

- Nvidia

- オブジェクト

- of

- on

- オンボード

- 新人研修

- ONE

- の

- 開いた

- OpenAI

- 最適化

- 最適化

- or

- オレゴン

- 組織

- OS

- その他

- でる

- 出力

- outputs

- が

- 自分の

- パッケージ

- ページ

- 部

- パス

- 渡された

- 情熱的な

- path

- 支払う

- 以下のために

- パフォーマンス

- 個人的な

- パソコン

- 博士号

- 物理学

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- ポイント

- 人気

- 可能

- ポスト

- パワード

- 精度

- 前に

- 校長

- 処理

- 生産された

- 生産する

- プロダクト

- 製品管理

- 生産

- 製品

- 演奏曲目

- プロジェクト

- は、大阪で

- 提供

- 公共

- Python

- パイトーチ

- クアルコム

- すぐに

- 範囲

- RE

- リーディング

- 現実

- 地域

- の提出が必要です

- 要件

- 保持

- return

- 再利用

- ロイ

- ラン

- ランニング

- runs

- 同じ

- Save

- 節約

- ド電源のデ

- 規模

- SDDK

- 二番

- 送信

- 文

- シーケンス

- サービス

- サービス

- セッション

- セッションに

- 彼女

- 示す

- 簡単な拡張で

- 簡素化する

- ウェブサイト

- サイズ

- スマートフォン

- スマートフォン

- So

- ソリューション

- 緊張

- 専門家

- スタック

- 標準

- start

- 開始

- 手順

- ステップ

- ストレージ利用料

- 店舗

- 戦略

- 続いて

- そのような

- 優れた

- サポート

- 支援する

- サポート

- テーブル

- テクニック

- テクノロジー

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- それ

- アプリ環境に合わせて

- その後

- ボーマン

- 彼ら

- この

- 三

- 介して

- スループット

- スルー

- 〜へ

- 今日

- トークン化する

- ツール

- トップス

- トーチ

- トータル

- トラフィック

- 訓練された

- トランスフォーマー

- true

- チュートリアル

- 統一

- 大学

- us

- つかいます

- 使用事例

- ユースケース

- 中古

- ユーザー

- いつもの

- v1

- VAL

- 検証

- 値

- バーチャル

- ビジョン

- 訪問

- we

- ウェブ

- Webサービス

- WELL

- ウェスト

- この試験は

- which

- while

- ワイド

- 広い範囲

- 意志

- Word

- ワーキング

- 年

- 貴社

- あなたの

- ゼファーネット