Generato con Midjourney

Le aziende di ogni settore e angolo del globo si stanno affrettando a integrare la potenza di modelli di linguaggio di grandi dimensioni (LLM) come ChatGPT di OpenAI, Claude di Anthropic e Jurassic di AI12Lab per migliorare le prestazioni in un'ampia gamma di applicazioni aziendali, come ricerche di mercato, servizio clienti e generazione di contenuti.

Tuttavia, la creazione di un'applicazione LLM su scala aziendale richiede un set di strumenti e una comprensione diversi rispetto alla creazione di applicazioni di machine learning (ML) tradizionali. I leader aziendali e i dirigenti che desiderano preservare la voce del marchio e la qualità del servizio affidabile devono sviluppare una comprensione più profonda di come funzionano gli LLM e dei pro e dei contro dei vari strumenti in uno stack di applicazioni LLM.

In questo articolo, ti forniremo un'introduzione essenziale alla strategia e agli strumenti di alto livello di cui avrai bisogno per creare ed eseguire un'applicazione LLM per la tua azienda.

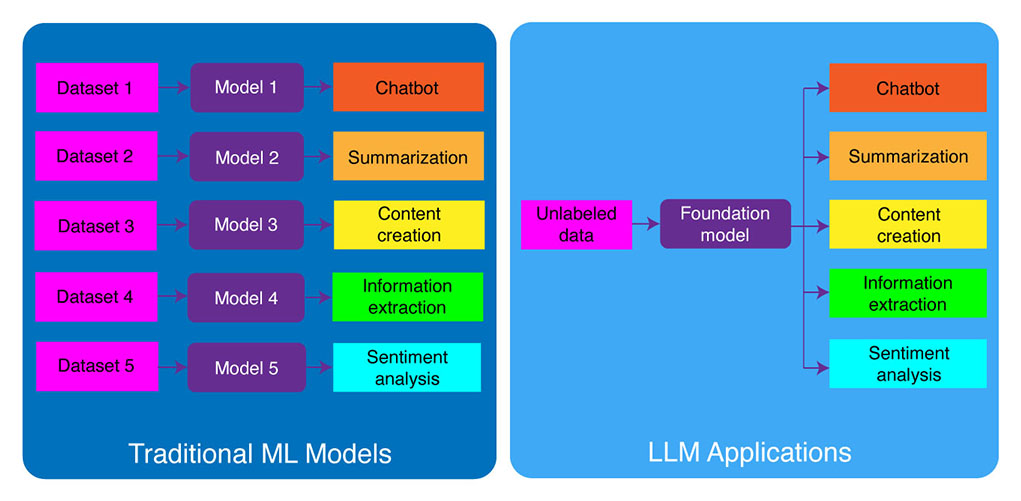

Sviluppo ML tradizionale rispetto alle applicazioni LLM

I modelli di machine learning tradizionali erano specifici per attività, il che significa che era necessario creare un modello separato per ogni attività diversa. Ad esempio, se si desidera analizzare il sentimento del cliente, è necessario creare un modello e se si desidera creare un chatbot di assistenza clienti, è necessario creare un altro modello.

Questo processo di creazione e addestramento di modelli ML specifici per attività richiede molto tempo e molti dati. Anche il tipo di set di dati necessari per addestrare questi diversi modelli ML varierebbe a seconda dell'attività. Per addestrare un modello per analizzare il sentimento del cliente, è necessario un set di dati di recensioni dei clienti che sono state etichettate con un sentimento corrispondente (positivo, negativo, neutro). Per addestrare un modello per creare un chatbot di assistenza clienti, avresti bisogno di un set di dati di conversazioni tra clienti e supporto tecnico.

I grandi modelli linguistici hanno cambiato questo. Gli LLM sono pre-addestrati su un enorme set di dati di testo e codice, che consente loro di eseguire bene su una vasta gamma di attività fuori dagli schemi, tra cui:

- Riepilogo del testo

- Creazione contenuti

- Traduzione

- Estrazione di informazioni

- Risposta alla domanda

- Analisi del sentimento

- Supporto clienti

- Supporto alle vendite

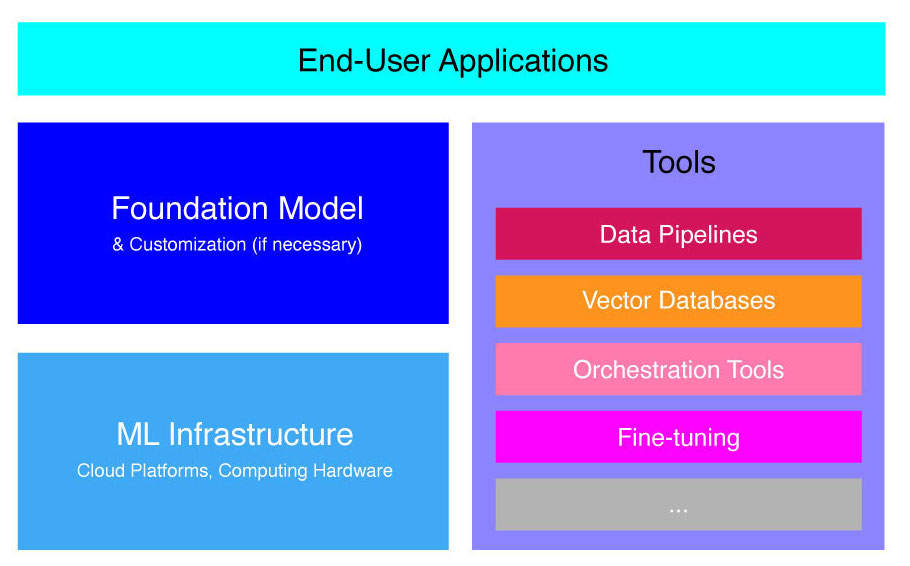

Il processo di sviluppo delle applicazioni LLM può essere suddiviso in quattro passaggi essenziali:

- Scegli un modello di fondazione appropriato. È un componente chiave, che definisce le prestazioni della tua applicazione LLM.

- Personalizza il modello, se necessario. Potrebbe essere necessario perfezionare il modello o ampliarlo con la knowledge base aggiuntiva per soddisfare le proprie esigenze specifiche.

- Configurare l'infrastruttura ML. Ciò include l'hardware e il software necessari per eseguire l'applicazione (ad esempio, semiconduttori, chip, cloud hosting, inferenza e distribuzione).

- Potenzia la tua applicazione con strumenti aggiuntivi. Questi strumenti possono contribuire a migliorare l'efficienza, le prestazioni e la sicurezza dell'applicazione.

Ora diamo un'occhiata allo stack tecnologico corrispondente.

Se questo contenuto educativo approfondito è utile per te, iscriviti alla nostra mailing list AI per essere avvisato quando rilasciamo nuovo materiale.

Stack di applicazioni LLM di alto livello

Le applicazioni LLM si basano su diversi componenti chiave, tra cui:

- Un modello di base, che potrebbe richiedere la personalizzazione in casi d'uso specifici.

- Infrastruttura ML per risorse informatiche sufficienti tramite piattaforme cloud o hardware dell'azienda.

- Strumenti aggiuntivi, come pipeline di dati, database vettoriali, strumenti di orchestrazione, piattaforme ML di fine tuning, strumenti di monitoraggio delle prestazioni dei modelli, ecc.

Ti guideremo brevemente attraverso questi componenti in modo che tu possa comprendere meglio il toolkit necessario per creare e distribuire un'applicazione LLM.

Cosa sono i modelli di base?

L'utilizzo di un singolo LLM pre-addestrato può farti risparmiare molto tempo e risorse. Tuttavia, l'addestramento di un tale modello da zero è un processo tempestivo e costoso che va oltre le capacità della maggior parte delle aziende, ad eccezione di pochi leader tecnologici d'élite.

Diverse aziende e gruppi di ricerca hanno addestrato questi modelli e consentono ad altre aziende di utilizzarli. Esempi principali includono ChatGPT, Claude, Llama, Jurassic e T5. Questi modelli rivolti al pubblico sono chiamati modelli di base. Alcuni di essi sono proprietari e sono accessibili tramite chiamate API a pagamento. Altri sono open source e possono essere utilizzati gratuitamente. Questi modelli sono preaddestrati su un enorme set di dati di dati testuali non etichettati, consentendo loro di eseguire un'ampia gamma di attività, dalla generazione di copie pubblicitarie creative alla comunicazione con i clienti nella loro lingua madre per conto dell'azienda.

Esistono due tipi principali di modelli di base: proprietari e open-source.

Modelli proprietari sono di proprietà di una singola azienda o organizzazione e in genere sono disponibili solo a pagamento. Alcuni degli esempi più popolari di modelli proprietari includono i modelli GPT di OpenAI, i modelli Claude di Anthropic e i modelli Jurassic di AI21 Labs.

Modelli open source di solito sono disponibili gratuitamente per chiunque voglia usarli. Tuttavia, alcuni modelli open source hanno limitazioni sul loro utilizzo, come ad esempio: (1) sono disponibili solo per scopi di ricerca, (2) sono disponibili solo per uso commerciale da parte di aziende di una certa dimensione. La comunità open source afferma che l'applicazione di tali restrizioni non consente a un modello di qualificarsi come "open source". Tuttavia, gli esempi più importanti di modelli linguistici che possono essere utilizzati gratuitamente includono i modelli Llama di Meta, i modelli Falcon del Technology Innovation Institute di Abu Dhabi e i modelli StableLM di Stability AI. Ulteriori informazioni sui modelli open source e sui rischi associati qui.

Ora discutiamo diversi fattori da considerare quando si sceglie un modello di base per la tua applicazione LLM.

Scegli un modello di base

La selezione del miglior modello di base per la tua applicazione LLM può essere un processo impegnativo, ma possiamo sostanzialmente suddividerlo in tre passaggi:

- Scegli tra modelli proprietari e open source. I modelli proprietari sono in genere più grandi e più capaci dei modelli open source, ma possono essere più costosi da usare e meno flessibili. Inoltre, il codice non è così trasparente, il che rende difficile il debug o la risoluzione dei problemi con le prestazioni dei modelli proprietari. I modelli open source, d'altra parte, di solito ricevono meno aggiornamenti e meno supporto da parte degli sviluppatori.

- Scegli la taglia del modello. I modelli più grandi di solito sono migliori nell'esecuzione di attività che richiedono molte conoscenze, come rispondere a domande o generare testo creativo. Tuttavia, i modelli più grandi sono anche più computazionalmente costosi da utilizzare. Puoi iniziare sperimentando con modelli più grandi e poi passare a quelli più piccoli purché le prestazioni di un modello siano soddisfacenti per il tuo caso d'uso.

- Seleziona un modello specifico. Puoi iniziare esaminando i benchmark generali per selezionare i modelli da testare. Quindi, procedi con il test di diversi modelli per le tue assegnazioni specifiche dell'applicazione. Per il benchmarking personalizzato, prendi in considerazione il calcolo BLEU e ROUGE segnano, le metriche che aiutano a quantificare il numero di correzioni necessarie al testo generato dall'intelligenza artificiale prima di rilasciare l'output per le applicazioni human-in-the-loop.

Per una migliore comprensione delle differenze tra i vari modelli linguistici, dai un'occhiata la nostra panoramica del linguaggio più potente (LLM) e dei modelli di linguaggio visivo (VLM).

Dopo aver scelto un modello di base per la tua applicazione, puoi considerare se è necessario personalizzare il modello per prestazioni ancora migliori.

Personalizza un modello di base

In alcuni casi, potresti voler personalizzare un modello linguistico di base per prestazioni migliori nel tuo caso d'uso specifico. Ad esempio, potresti voler ottimizzare per un determinato:

- Dominio. Se operi in domini specifici, ad esempio legale, finanziario o sanitario, potresti voler arricchire il vocabolario del modello in questo dominio in modo che possa comprendere meglio e rispondere alle domande degli utenti finali.

- Task. Ad esempio, se desideri che il modello generi campagne di marketing, puoi fornirgli esempi specifici di contenuti di marketing di marca. Ciò aiuterà il modello ad apprendere i modelli e gli stili appropriati per la tua azienda e il tuo pubblico.

- Tono di voce. Se hai bisogno che il modello utilizzi un tono di voce specifico, puoi personalizzare il modello su un set di dati che include esempi dei tuoi campioni linguistici di destinazione.

Esistono tre modi possibili per personalizzare un modello linguistico di base:

- Ritocchi: fornisce al modello un set di dati etichettato specifico del dominio di circa 100-500 record. I pesi del modello vengono aggiornati, il che dovrebbe comportare prestazioni migliori per le attività rappresentate da questo set di dati.

- Adattamento del dominio: fornisce al modello un set di dati senza etichetta specifico del dominio che contiene un ampio corpus di dati dal dominio corrispondente. Anche in questo caso vengono aggiornati i pesi del modello.

- Recupero delle informazioni: aumenta il modello di base con la conoscenza a dominio chiuso. Il modello non viene riaddestrato e i pesi del modello rimangono gli stessi. Tuttavia, il modello può recuperare informazioni da un database vettoriale contenente dati rilevanti.

I primi due approcci richiedono notevoli risorse di calcolo per riaddestrare il modello, che di solito è fattibile solo per le grandi aziende con il talento tecnico appropriato per gestire la personalizzazione. Le aziende più piccole in genere utilizzano l'approccio più comune di aumentare il modello con la conoscenza del dominio attraverso un database vettoriale, che descriveremo in dettaglio più avanti in questo articolo nella sezione sugli strumenti LLM.

Configurare l'infrastruttura ML

Il componente dell'infrastruttura ML del panorama LLMops include le piattaforme cloud, l'hardware di elaborazione e altre risorse necessarie per distribuire ed eseguire LLM. Questo componente è particolarmente rilevante se si sceglie di utilizzare un modello open source o di personalizzare il modello per la propria applicazione. In questo caso, potrebbero essere necessarie notevoli risorse di elaborazione per mettere a punto il modello, se necessario, ed eseguirlo.

Esistono numerose piattaforme cloud che offrono servizi per la distribuzione di LLM, tra cui Google Cloud Platform, Amazon Web Services e Microsoft Azure. Queste piattaforme forniscono una serie di funzionalità che semplificano la distribuzione e l'esecuzione di LLM, tra cui:

- Modelli pre-addestrati che possono essere ottimizzati per la tua applicazione specifica

- Infrastruttura gestita che si occupa dell'hardware e del software sottostante

- Strumenti e servizi per il monitoraggio e il debug dei tuoi LLM

La quantità di risorse di elaborazione necessarie dipenderà dalle dimensioni e dalla complessità del modello, dalle attività che si desidera eseguire e dalla portata dell'attività aziendale in cui si desidera distribuire questo modello.

Aumentare con gli strumenti

Ulteriori strumenti adiacenti LLM possono essere utilizzati per migliorare ulteriormente le prestazioni della tua applicazione LLM.

Pipeline di dati

Se hai bisogno di utilizzare i tuoi dati nel tuo prodotto LLM, la pipeline di pre-elaborazione dei dati sarà un pilastro essenziale del tuo nuovo stack tecnologico, proprio come nel tradizionale stack AI aziendale. Questi strumenti includono connettori per acquisire dati da qualsiasi origine, un livello di trasformazione dei dati e connettori downstream. I principali fornitori di pipeline di dati, come Databricks e Snowflake, e i nuovi attori, come Unstructured, consentono agli sviluppatori di puntare facilmente corpora ampi e altamente eterogenei di dati in linguaggio naturale (ad esempio, migliaia di PDF, presentazioni di PowerPoint, registri di chat, HTML raschiato, ecc.) a un unico punto di accesso o anche in un unico documento che può essere ulteriormente utilizzato dalle applicazioni LLM.

Database vettoriali

I modelli di linguaggio di grandi dimensioni sono limitati all'elaborazione di poche migliaia di parole alla volta, quindi non possono elaborare efficacemente documenti di grandi dimensioni da soli. Per sfruttare la potenza di documenti di grandi dimensioni, le aziende devono utilizzare database vettoriali.

I database vettoriali sono sistemi di archiviazione che trasformano documenti di grandi dimensioni che ricevono tramite pipeline di dati in vettori gestibili o incorporamenti. Le applicazioni LLM possono quindi interrogare questi database per individuare i vettori giusti, estraendo solo le pepite di informazioni necessarie.

Alcuni dei database vettoriali più importanti attualmente disponibili sono Pinecone, Chroma e Weaviate.

Strumenti di orchestrazione

Quando un utente invia una query all'applicazione LLM, ad esempio una domanda per il servizio clienti, l'applicazione deve creare una serie di prompt prima di inviare questa query al modello linguistico. La richiesta finale al modello linguistico è in genere composta da un modello di prompt hardcoded dallo sviluppatore, esempi di output validi chiamati esempi di pochi scatti, qualsiasi informazione necessaria recuperata da API esterne e un insieme di documenti pertinenti recuperati dal database vettoriale . Gli strumenti di orchestrazione di aziende come LangChain o LlamaIndex possono aiutare a semplificare questo processo fornendo framework pronti all'uso per la gestione e l'esecuzione dei prompt.

Ritocchi

I modelli linguistici di grandi dimensioni addestrati su enormi set di dati possono produrre testi grammaticalmente corretti e fluenti. Tuttavia, possono mancare di precisione in alcune aree, come la medicina o la legge. La messa a punto di questi modelli su set di dati specifici del dominio consente loro di interiorizzare le caratteristiche uniche di tali aree, migliorando la loro capacità di generare testo pertinente.

La messa a punto di un LLM può essere un processo costoso per le piccole aziende. Tuttavia, le soluzioni di aziende come Weights & Biases e OctoML possono aiutare con una messa a punto semplificata ed efficiente. Queste soluzioni forniscono una piattaforma per le aziende per mettere a punto gli LLM senza dover investire nella propria infrastruttura.

Altri strumenti

Esistono molti altri strumenti che possono essere utili per la creazione e l'esecuzione di applicazioni LLM. Ad esempio, potresti aver bisogno di strumenti di etichettatura se desideri ottimizzare il modello con i tuoi campioni di dati specifici. Potresti anche voler distribuire strumenti specifici per monitorare le prestazioni della tua applicazione, poiché anche modifiche minime al modello di base o richieste dei clienti possono influire in modo significativo sulle prestazioni dei prompt. Infine, ci sono strumenti che monitorano la sicurezza del modello per aiutarti a evitare di promuovere contenuti che incitano all'odio, raccomandazioni pericolose o pregiudizi. La necessità e l'importanza di questi diversi strumenti dipenderà dal tuo caso d'uso specifico.

Quali sono le prospettive nello sviluppo di applicazioni LLM?

I quattro passaggi per lo sviluppo del prodotto LLM che abbiamo discusso qui, sono una base essenziale della strategia di intelligenza artificiale generativa di qualsiasi azienda che sfrutta modelli di linguaggio di grandi dimensioni. Sono importanti da comprendere per i leader aziendali non tecnici, anche se si dispone di un team tecnico che implementa i dettagli. In futuro pubblicheremo tutorial più dettagliati su come sfruttare l'ampia gamma di strumenti di intelligenza artificiale generativa sul mercato. Per ora puoi Iscriviti alla nostra Newsletter per ricevere gli ultimi aggiornamenti.

Ti piace questo articolo? Registrati per ricevere altri aggiornamenti sull'intelligenza artificiale aziendale.

Ti faremo sapere quando pubblicheremo altri articoli di riepilogo come questo.

Leggi Anche

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://www.topbots.com/llm-product-development-technology-stack/

- :È

- :non

- :Dove

- $ SU

- 1

- a

- capacità

- WRI

- Abu Dhabi

- accesso

- accessibile

- attività

- Ad

- aggiuntivo

- Inoltre

- adiacente

- AI

- Strategia di intelligenza artificiale

- consentire

- permesso

- consente

- anche

- Amazon

- Amazon Web Services

- quantità

- an

- analizzare

- ed

- Un altro

- Antropico

- in qualsiasi

- chiunque

- api

- API

- Applicazioni

- Sviluppo di applicazioni

- applicazioni

- approccio

- approcci

- opportuno

- SONO

- aree

- articolo

- news

- AS

- associato

- At

- pubblico

- disponibile

- evitare

- azzurro

- base

- fondamentalmente

- BE

- stato

- prima

- per conto

- essendo

- analisi comparativa

- parametri di riferimento

- MIGLIORE

- Meglio

- fra

- Al di là di

- pregiudizi

- Incremento

- Scatola

- marca

- marcato

- Rompere

- brevemente

- Rotto

- costruire

- Costruzione

- costruito

- affari

- Applicazioni aziendali

- Dirigenti d'impresa

- aziende

- ma

- by

- calcolo

- detto

- Bandi

- Responsabile Campagne

- Materiale

- funzionalità

- capace

- che

- Custodie

- casi

- certo

- impegnativo

- cambiato

- Modifiche

- chatbot

- ChatGPT

- dai un'occhiata

- Chips

- Scegli

- la scelta

- scelto

- Cloud

- cloud hosting

- cloud Platform

- codice

- Uncommon

- comunicare

- comunità

- Aziende

- azienda

- Società

- complessità

- componente

- componenti

- composto

- informatica

- Svantaggi

- Prendere in considerazione

- costruire

- contiene

- contenuto

- Conversazioni

- copie

- Angolo

- correggere

- Correzioni

- Corrispondente

- costoso

- Creative

- Attualmente

- costume

- cliente

- Servizio clienti

- Assistenza clienti

- Clienti

- personalizzazione

- personalizzare

- Pericoloso

- dati

- Banca Dati

- banche dati

- Databricks

- dataset

- più profondo

- definizione

- Dipendente

- schierare

- distribuzione

- deployment

- dettaglio

- dettagliati

- dettagli

- sviluppare

- Costruttori

- sviluppatori

- in via di sviluppo

- Mercato

- Dhabi

- differenze

- diverso

- difficile

- discutere

- discusso

- documento

- documenti

- non

- dominio

- domini

- giù

- e

- ogni

- facile

- educativo

- in maniera efficace

- efficienza

- efficiente

- elite

- consentendo

- accrescere

- migliorando

- arricchire

- Impresa

- particolarmente

- essential

- eccetera

- Etere (ETH)

- Anche

- Ogni

- esempio

- Esempi

- Tranne

- esecuzione

- dirigenti

- costoso

- esterno

- Fattori

- falco

- fattibile

- Caratteristiche

- tassa

- pochi

- meno

- finale

- Infine

- finanziario

- Nome

- flessibile

- Nel

- Fondazione

- quattro

- quadri

- Gratis

- da

- ulteriormente

- futuro

- Generale

- generare

- la generazione di

- ELETTRICA

- generativo

- AI generativa

- ottenere

- Dare

- globo

- Go

- andando

- Google cloud

- Google Cloud Platform

- Terra

- cura

- Hardware

- cintura da arrampicata

- Avere

- avendo

- assistenza sanitaria

- Aiuto

- qui

- alto livello

- vivamente

- di hosting

- Come

- Tutorial

- Tuttavia

- HTML

- HTTPS

- i

- if

- Impact

- Implementazione

- importanza

- importante

- competenze

- in

- Uno sguardo approfondito sui miglioramenti dei pneumatici da corsa di Bridgestone.

- includere

- inclusi

- Compreso

- industria

- informazioni

- Infrastruttura

- Innovazione

- Istituto

- integrare

- ai miglioramenti

- Introduzione

- Investire

- IT

- jpg

- ad appena

- Le

- Genere

- Sapere

- conoscenze

- etichettatura

- Labs

- Dipingere

- paesaggio

- Lingua

- grandi

- superiore, se assunto singolarmente.

- dopo

- con i più recenti

- Ultimi aggiornamenti

- Legge

- strato

- capi

- principale

- IMPARARE

- apprendimento

- Legale

- meno

- Leva

- leveraggi

- piace

- limiti

- Limitato

- Lama

- Lunghi

- Guarda

- lotto

- macchina

- machine learning

- Principale

- make

- FA

- gestire

- gestione

- molti

- Rappresentanza

- ricerche di mercato

- Marketing

- Campagne di marketing

- mercato

- massiccio

- materiale

- max-width

- Maggio..

- significato

- medicina

- Soddisfare

- Meta

- Metrica

- Microsoft

- Microsoft Azure

- forza

- minore

- ML

- modello

- modelli

- Monitorare

- monitoraggio

- Scopri di più

- maggior parte

- Più popolare

- nativo

- Naturale

- Linguaggio naturale

- necessaria

- Bisogno

- di applicazione

- esigenze

- negativo.

- Neutres

- New

- Nuova tecnologia

- Newsletter

- GENERAZIONE

- non tecnico

- adesso

- numero

- of

- offrire

- on

- ONE

- quelli

- esclusivamente

- open source

- OpenAI

- operare

- OTTIMIZZA

- or

- orchestrazione

- organizzazione

- Altro

- Altri

- nostro

- su

- produzione

- panoramica

- proprio

- Di proprietà

- modelli

- eseguire

- performance

- esecuzione

- Pilastro

- conduttura

- piattaforma

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- giocatori

- punto

- Popolare

- positivo

- possibile

- energia

- potente

- Precisione

- presentazioni

- problemi

- processi

- lavorazione

- produrre

- Prodotto

- sviluppo del prodotto

- prominente

- promuovere

- proprio

- PROS

- fornire

- fornitori

- fornisce

- fornitura

- pubblicare

- fini

- Mettendo

- qualificarsi

- qualità

- query

- domanda

- Domande

- gamma

- Leggi

- ricevere

- raccomandazioni

- record

- rilasciare

- rilascio

- pertinente

- affidabile

- rappresentato

- richiesta

- richieste

- richiedere

- richiede

- riparazioni

- Risorse

- Rispondere

- restrizioni

- colpevole

- revisione

- Recensioni

- destra

- rischi

- Correre

- running

- Sicurezza

- stesso

- Risparmi

- Scala

- Sezione

- problemi di

- Semiconduttori

- sentimento

- separato

- Serie

- servizio

- Servizi

- set

- alcuni

- dovrebbero

- segno

- significativa

- significativamente

- singolo

- Taglia

- piccole

- inferiore

- So

- Software

- Soluzioni

- alcuni

- Fonte

- specifico

- Stabilità

- pila

- inizia a

- soggiorno

- Passi

- Ancora

- conservazione

- Strategia

- snellire

- aerodinamico

- stili

- tale

- sufficiente

- SOMMARIO

- supporto

- SISTEMI DI TRATTAMENTO

- Fai

- prende

- Talento

- Target

- Task

- task

- team

- le squadre

- Tech

- Consulenza

- supporto tecnico

- Tecnologia

- innovazione tecnologica

- modello

- Testing

- di

- che

- Il

- Il futuro

- loro

- Li

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- migliaia

- tre

- Attraverso

- tempo

- richiede tempo

- a

- TONE

- Tono di voce

- toolkit

- strumenti

- top

- TOPBOT

- tradizionale

- Treni

- allenato

- Training

- Trasformare

- Trasformazione

- trasparente

- esercitazioni

- seconda

- Tipi di

- tipicamente

- sottostante

- capire

- e una comprensione reciproca

- unico

- caratteristiche uniche

- aggiornato

- Aggiornamenti

- uso

- caso d'uso

- utilizzato

- Utente

- generalmente

- vario

- via

- Voce

- vs

- volere

- ricercato

- vuole

- modi

- we

- sito web

- servizi web

- WELL

- sono stati

- quando

- se

- quale

- OMS

- largo

- Vasta gamma

- volere

- con

- senza

- parole

- Lavora

- sarebbe

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro