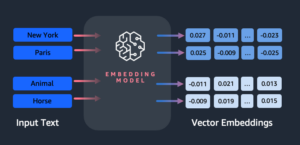

Hari ini, kami dengan gembira mengumumkan bahwa Campuran-8x7B model bahasa besar (LLM), yang dikembangkan oleh Mistral AI, tersedia untuk pelanggan melalui Mulai Lompatan Amazon SageMaker untuk diterapkan dengan satu klik untuk menjalankan inferensi. Mixtral-8x7B LLM adalah campuran model pakar yang telah dilatih sebelumnya, berdasarkan tulang punggung 7 miliar parameter dengan delapan pakar per lapisan feed-forward. Anda dapat mencoba model ini dengan SageMaker JumpStart, hub pembelajaran mesin (ML) yang menyediakan akses ke algoritme dan model sehingga Anda dapat memulai ML dengan cepat. Dalam postingan ini, kami membahas cara menemukan dan menerapkan model Mixtral-8x7B.

Apa itu Mixtral-8x7B

Mixtral-8x7B adalah model dasar yang dikembangkan oleh Mistral AI, mendukung teks bahasa Inggris, Prancis, Jerman, Italia, dan Spanyol, dengan kemampuan pembuatan kode. Ini mendukung berbagai kasus penggunaan seperti peringkasan teks, klasifikasi, penyelesaian teks, dan penyelesaian kode. Ini berperilaku baik dalam mode obrolan. Untuk mendemonstrasikan model yang dapat disesuaikan secara langsung, Mistral AI juga telah merilis model instruksi Mixtral-8x7B untuk kasus penggunaan obrolan, yang disempurnakan menggunakan berbagai kumpulan data percakapan yang tersedia untuk umum. Model mixtral memiliki panjang konteks yang besar hingga 32,000 token.

Mixtral-8x7B memberikan peningkatan kinerja yang signifikan dibandingkan model canggih sebelumnya. Campuran arsitektur pakar yang sedikit memungkinkannya mencapai hasil kinerja yang lebih baik pada 9 dari 12 tolok ukur pemrosesan bahasa alami (NLP) yang diuji oleh AI Mistral. Mixtral menyamai atau melampaui performa model hingga 10 kali lipat ukurannya. Dengan hanya memanfaatkan sebagian kecil parameter per token, ia mencapai kecepatan inferensi yang lebih cepat dan biaya komputasi yang lebih rendah dibandingkan model padat dengan ukuran setara—misalnya, dengan total 46.7 miliar parameter tetapi hanya 12.9 miliar yang digunakan per token. Kombinasi kinerja tinggi, dukungan multibahasa, dan efisiensi komputasi menjadikan Mixtral-8x7B pilihan yang menarik untuk aplikasi NLP.

Model ini tersedia di bawah lisensi Apache 2.0 yang permisif, untuk digunakan tanpa batasan.

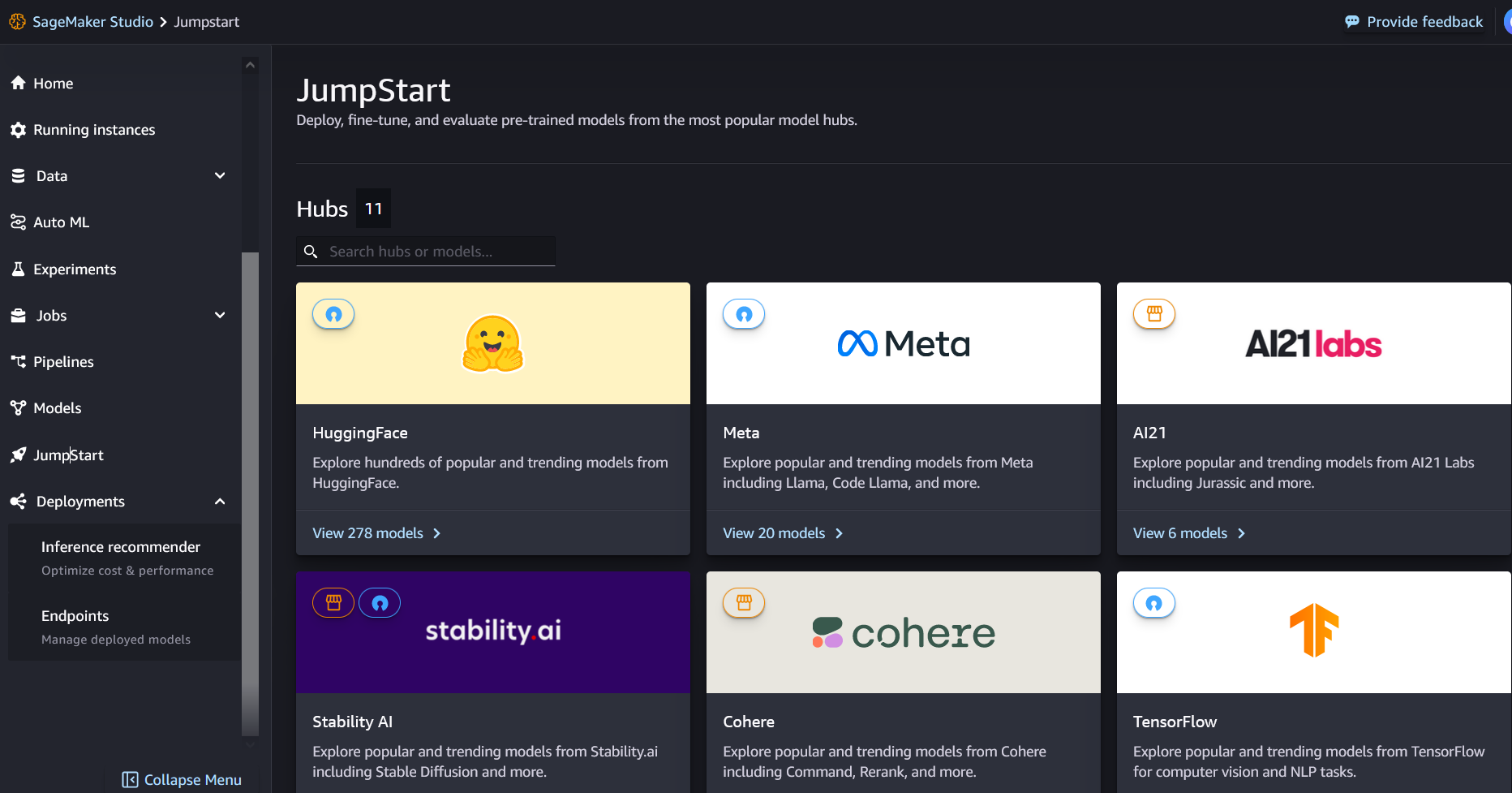

Apa itu SageMaker JumpStart

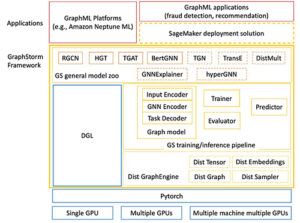

Dengan SageMaker JumpStart, praktisi ML dapat memilih dari daftar model alas bedak berperforma terbaik yang terus bertambah. Praktisi ML dapat menerapkan model dasar ke model khusus Amazon SageMaker contoh dalam lingkungan jaringan yang terisolasi, dan sesuaikan model menggunakan SageMaker untuk pelatihan dan penerapan model.

Anda sekarang dapat menemukan dan menerapkan Mixtral-8x7B hanya dengan beberapa klik Studio Amazon SageMaker atau secara terprogram melalui SageMaker Python SDK, memungkinkan Anda memperoleh performa model dan kontrol MLOps dengan fitur SageMaker seperti Pipa Amazon SageMaker, Debugger Amazon SageMaker, atau log kontainer. Model ini diterapkan di lingkungan aman AWS dan di bawah kendali VPC Anda, membantu memastikan keamanan data.

Temukan model

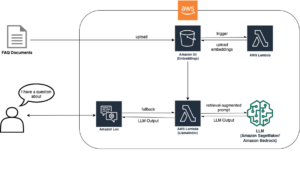

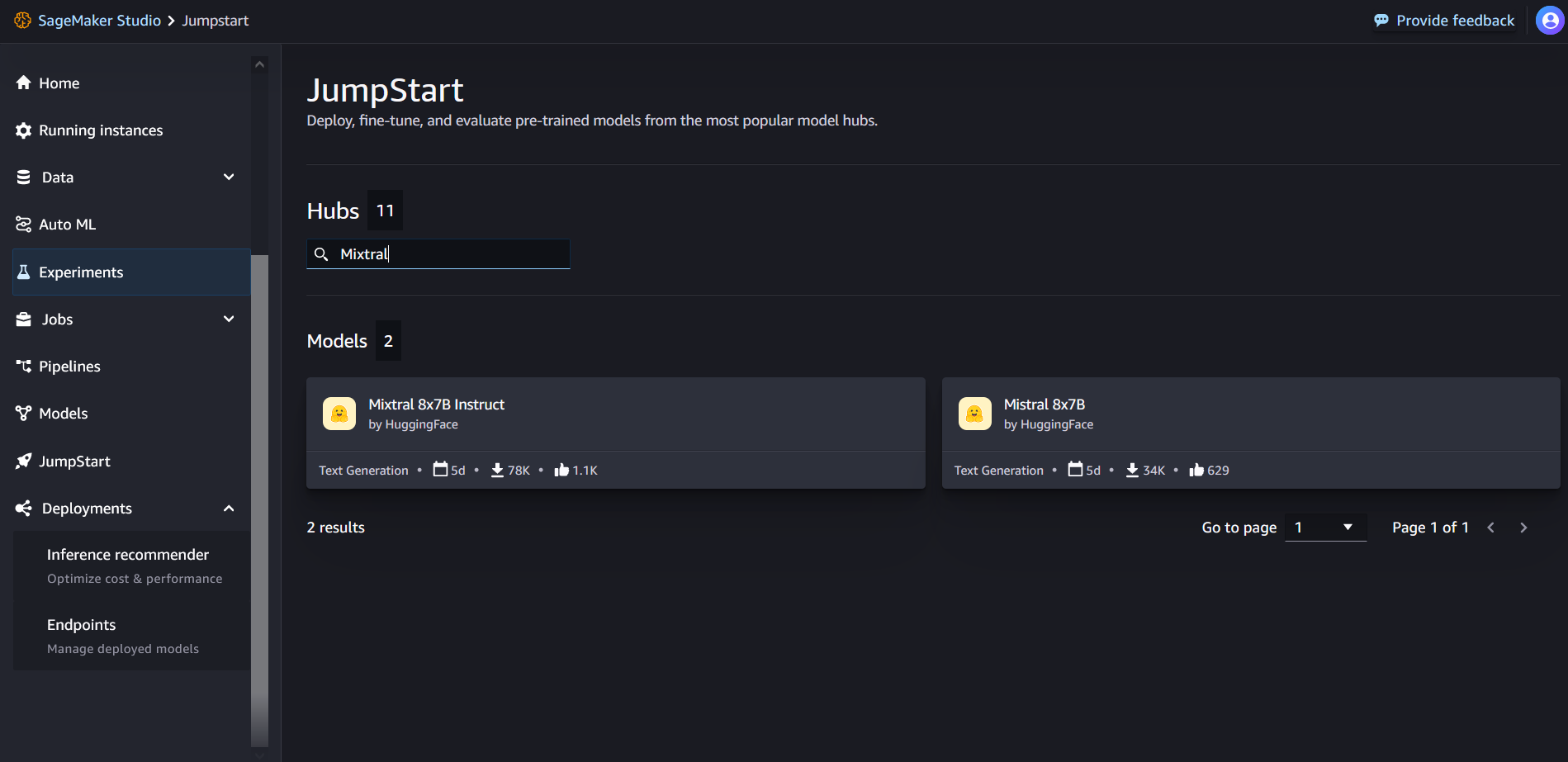

Anda dapat mengakses model fondasi Mixtral-8x7B melalui SageMaker JumpStart di UI SageMaker Studio dan SageMaker Python SDK. Di bagian ini, kita akan membahas cara menemukan model di SageMaker Studio.

SageMaker Studio adalah lingkungan pengembangan terintegrasi (IDE) yang menyediakan antarmuka visual berbasis web tunggal tempat Anda dapat mengakses alat yang dibuat khusus untuk melakukan semua langkah pengembangan ML, mulai dari menyiapkan data hingga membangun, melatih, dan menerapkan model ML Anda. Untuk detail selengkapnya tentang cara memulai dan menyiapkan SageMaker Studio, lihat Studio Amazon SageMaker.

Di SageMaker Studio, Anda dapat mengakses SageMaker JumpStart dengan memilih Tingkatkan di panel navigasi.

Dari halaman arahan SageMaker JumpStart, Anda dapat mencari “Mixtral” di kotak pencarian. Anda akan melihat hasil pencarian yang menunjukkan Mixtral 8x7B dan Mixtral 8x7B Instruct.

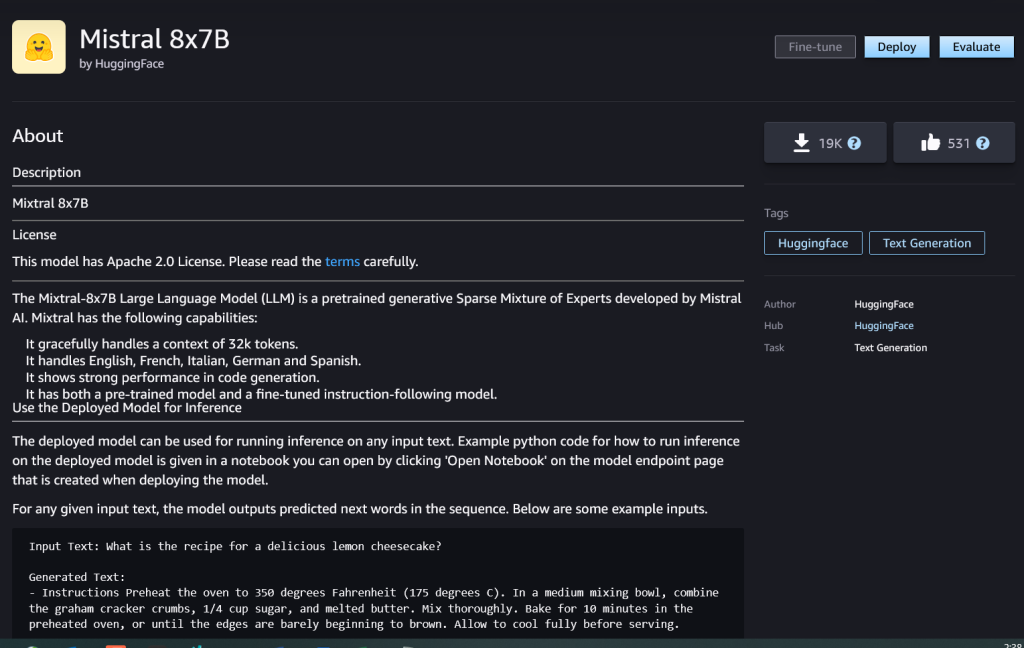

Anda dapat memilih kartu model untuk melihat detail tentang model seperti lisensi, data yang digunakan untuk melatih, dan cara penggunaan. Anda juga akan menemukan Menyebarkan tombol, yang dapat Anda gunakan untuk menyebarkan model dan membuat titik akhir.

Terapkan model

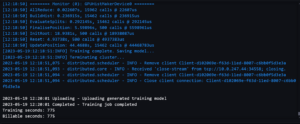

Penerapan dimulai saat Anda memilih Menyebarkan. Setelah penerapan selesai, titik akhir Anda telah dibuat. Anda dapat menguji titik akhir dengan meneruskan sampel payload permintaan inferensi atau memilih opsi pengujian menggunakan SDK. Saat Anda memilih opsi untuk menggunakan SDK, Anda akan melihat kode contoh yang dapat Anda gunakan di editor buku catatan pilihan Anda di SageMaker Studio.

Untuk menerapkan menggunakan SDK, kita mulai dengan memilih model Mixtral-8x7B, yang ditentukan oleh model_id with value huggingface-llm-mixtral-8x7b. Anda dapat menerapkan salah satu model yang dipilih di SageMaker dengan kode berikut. Demikian pula, Anda dapat menerapkan instruksi Mixtral-8x7B menggunakan ID modelnya sendiri:

Ini menyebarkan model pada SageMaker dengan konfigurasi default, termasuk jenis instans default dan konfigurasi VPC default. Anda dapat mengubah konfigurasi ini dengan menentukan nilai non-default di JumpStartModel.

Setelah diterapkan, Anda dapat menjalankan inferensi terhadap titik akhir yang diterapkan melalui prediktor SageMaker:

Contoh petunjuknya

Anda dapat berinteraksi dengan model Mixtral-8x7B seperti model pembuatan teks standar lainnya, yang mana model tersebut memproses urutan masukan dan mengeluarkan prediksi kata berikutnya dalam urutan tersebut. Di bagian ini, kami memberikan contoh petunjuknya.

Pembuatan kode

Dengan menggunakan contoh sebelumnya, kita dapat menggunakan perintah pembuatan kode seperti berikut:

Anda mendapatkan output berikut:

Permintaan analisis sentimen

Anda dapat melakukan analisis sentimen menggunakan perintah seperti berikut dengan Mixtral 8x7B:

Anda mendapatkan output berikut:

Petunjuk menjawab pertanyaan

Anda dapat menggunakan prompt menjawab pertanyaan seperti berikut dengan Mixtral-8x7B:

Anda mendapatkan output berikut:

Instruksi Mixtral-8x7B

Versi Mixtral-8x7B yang disesuaikan dengan instruksi menerima instruksi yang diformat di mana peran percakapan harus dimulai dengan perintah pengguna dan bergantian antara instruksi pengguna dan asisten (jawaban model). Format instruksi harus dipatuhi dengan ketat, jika tidak, model akan menghasilkan keluaran yang kurang optimal. Templat yang digunakan untuk membuat prompt untuk model Instruct didefinisikan sebagai berikut:

Perhatikan bahwa <s> dan </s> adalah token khusus untuk awal string (BOS) dan akhir string (EOS), sedangkan [INST] dan [/INST] adalah string biasa.

Kode berikut menunjukkan bagaimana Anda dapat memformat prompt dalam format instruksi:

Pengambilan pengetahuan

Anda dapat menggunakan kode berikut untuk prompt pengambilan pengetahuan:

Anda mendapatkan output berikut:

Pengkodean

Model Mixtral dapat menunjukkan kekuatan yang dijadikan tolok ukur untuk tugas pengkodean, seperti yang ditunjukkan dalam kode berikut:

Matematika dan penalaran

Model mixtral juga melaporkan keunggulan dalam akurasi matematika:

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26

- 30

- 32

- 46

- 50

- 600

- 7

- 72

- 8

- 9

- a

- kemampuan

- Tentang Kami

- atas

- mempercepat

- Menerima

- mengakses

- Akun

- ketepatan

- Mencapai

- Mencapai

- di seluruh

- aktif

- menambahkan

- menambahkan

- Setelah

- terhadap

- AI

- AI / ML

- algoritma

- Semua

- juga

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- jumlah

- an

- analisis

- dan

- dan infrastruktur

- Mengumumkan

- menjawab

- Apa pun

- Apache

- menarik

- aplikasi

- terapan

- Menerapkan

- arsitektur

- ADALAH

- argumen

- artikel

- AS

- Asisten

- At

- tersedia

- AWS

- kembali

- Tulang punggung

- berdasarkan

- menampar

- baterai

- Bayesian

- BE

- karena

- menjadi

- sebelum

- Awal

- percaya

- Bel

- benchmark

- Benchmark

- Lebih baik

- antara

- tagihan

- penagihan

- Milyar

- pin

- membeli

- Kotak

- Istirahat

- membawa

- membangun

- Bangunan

- built-in

- bisnis

- tapi

- by

- menghitung

- panggilan

- bernama

- Panggilan

- CAN

- kartu

- kasus

- kasus

- sel

- perubahan

- mengobrol

- pilihan

- Pilih

- memilih

- chris

- klasifikasi

- Klik

- kode

- Pengkodean

- kombinasi

- dibandingkan

- dikompilasi

- penyelesaian

- komputasi

- menghitung

- komputer

- Visi Komputer

- konferensi

- terus-menerus

- Wadah

- Konten

- konteks

- terus

- terus menerus

- kontrol

- Percakapan

- Biaya

- Biaya

- bisa

- Krim

- membuat

- dibuat

- sangat penting

- Cangkir

- terbaru

- pelanggan

- kustomisasi

- menyesuaikan

- data

- keamanan data

- kumpulan data

- hari

- Hari

- dedicated

- Default

- didefinisikan

- Demokratisasi

- mendemonstrasikan

- padat

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- menyebarkan

- memperoleh

- rincian

- mengembangkan

- dikembangkan

- Pengembang

- Pengembangan

- DICT

- MELAKUKAN

- menemukan

- do

- tidak

- dolar

- domain

- dilakukan

- turun

- Menjatuhkan

- Duke

- universitas adipati

- setiap

- Ekonomis

- editor

- efisiensi

- Telur

- lain

- aktif

- memungkinkan

- memungkinkan

- akhir

- Titik akhir

- Teknik

- Inggris

- memastikan

- Lingkungan Hidup

- EOS

- sama

- Setara

- Eter (ETH)

- etis

- contoh

- melebihi

- gembira

- tidak termasuk

- ahli

- ahli

- Menjelaskan

- penjelasan

- perpanjangan

- keluarga

- lebih cepat

- Fitur

- beberapa

- File

- filter

- Menemukan

- Pertama

- berikut

- berikut

- Untuk

- format

- Prinsip Dasar

- pecahan

- Perancis

- dari

- fungsi

- masa depan

- tujuan umum

- menghasilkan

- dihasilkan

- generasi

- generatif

- AI generatif

- Jerman

- mendapatkan

- Go

- baik

- mendapat

- Pertumbuhan

- benci

- Memiliki

- he

- membantu

- membantu

- membantu

- dia

- di sini

- High

- mendaki

- Hills

- -nya

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- Pusat

- i

- ES

- es krim

- ICLR

- ID

- if

- Illinois

- penyakit

- mengimpor

- penting

- memperbaiki

- perbaikan

- in

- memasukkan

- Termasuk

- Tergabung

- Infrastruktur

- bahan

- memasukkan

- input

- contoh

- contoh

- instruksi

- mengintegrasikan

- terpadu

- berinteraksi

- kepentingan

- Antarmuka

- Jadian

- terpencil

- IT

- Italia

- NYA

- Diri

- jpg

- anak

- pengetahuan

- kyle

- Labs

- pendaratan

- halaman arahan

- bahasa

- besar

- Terakhir

- lapisan

- Memimpin

- pengetahuan

- Panjang

- membiarkan

- Lisensi

- 'like'

- 'like

- batas

- LINK

- Daftar

- Listening

- sedikit

- logika

- mencari

- menurunkan

- mesin

- Mesin belajar

- terbuat

- MEMBUAT

- Membuat

- manajer

- banyak

- korek api

- matematika

- matematika

- me

- medium

- campuran

- ML

- MLOps

- mode

- model

- model

- dimodifikasi

- Bulan

- lebih

- sepeda motor

- banyak

- dikalikan

- musik

- harus

- my

- Alam

- Bahasa Alami

- Pengolahan Bahasa alami

- Navigasi

- negatif

- jaringan

- NeuroIPS

- Netral

- New

- berikutnya

- nLP

- None

- mencatat

- buku catatan

- sekarang

- jumlah

- of

- Minyak

- on

- sekali

- ONE

- hanya

- operasi

- sistem operasi

- pilihan

- or

- Lainnya

- jika tidak

- di luar

- keluaran

- output

- di luar

- lebih

- sendiri

- halaman

- dibayar

- pane

- dokumen

- parameter

- parameter

- Lewat

- gairah

- bergairah

- jalan

- untuk

- melakukan

- prestasi

- phd

- telepon

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- portabel

- positif

- Pos

- mendahului

- diprediksi

- Predictor

- disukai

- mempersiapkan

- sebelumnya

- Utama

- Mencetak

- proses

- proses

- pengolahan

- Produk

- program

- Pemrograman

- meminta

- kemakmuran

- memberikan

- penyedia

- menyediakan

- di depan umum

- diterbitkan

- Ular sanca

- Perempat

- pertanyaan

- segera

- RE

- Bacaan

- resep

- Rekursif

- menurunkan

- lihat

- reguler

- dirilis

- melaporkan

- permintaan

- penelitian

- peneliti

- Sumber

- dihormati

- tanggapan

- tanggung jawab

- pembatasan

- mengakibatkan

- Hasil

- kembali

- Pengembalian

- naik

- Risiko

- Peran

- peran

- Kamar

- Run

- berjalan

- s

- SA

- pembuat bijak

- garam

- terukur

- Skala

- Ilmu

- ilmuwan

- SDK

- Pencarian

- Bagian

- aman

- keamanan

- melihat

- memilih

- terpilih

- memilih

- seleksi

- senior

- sentimen

- terpisah

- Urutan

- Seri

- Layanan

- set

- menunjukkan

- menunjukkan

- ditunjukkan

- Pertunjukkan

- penting

- Demikian pula

- Sederhana

- sejak

- tunggal

- Ukuran

- So

- Sosial

- Masyarakat

- Perangkat lunak

- larutan

- Spanyol

- khusus

- spesialis

- ditentukan

- kecepatan

- Pengeluaran

- standar

- awal

- mulai

- dimulai

- state-of-the-art

- statistik

- Langkah

- Tangga

- Masih

- terhenti

- menyimpan

- mudah

- Strategis

- aliran

- kekuatan

- Tali

- tersusun

- studio

- seperti itu

- mendukung

- pendukung

- Mendukung

- sistem

- Dibutuhkan

- tugas

- rasa

- tim

- Teknologi

- Template

- uji

- diuji

- pengujian

- teks

- pembuatan teks

- bahwa

- Grafik

- Masa depan

- kemudian

- Ini

- mereka

- ini

- Melalui

- waktu

- Seri waktu

- kali

- untuk

- bersama

- token

- Token

- terlalu

- alat

- Total

- Pelatihan VE

- Pelatihan

- benar

- mencoba

- menciak

- mengetik

- ui

- bawah

- universitas

- unix

- membuka kunci

- sampai

- menggunakan

- gunakan case

- bekas

- Pengguna

- kegunaan

- menggunakan

- Memanfaatkan

- Lembah

- nilai

- Nilai - Nilai

- variasi

- versi

- Video

- View

- penglihatan

- Mengunjungi

- visual

- berjalan

- adalah

- air

- we

- jaringan

- layanan web

- berbasis web

- BAIK

- Apa

- Apa itu

- ketika

- sedangkan

- yang

- putih

- SIAPA

- akan

- dengan

- dalam

- tanpa

- kata

- Kerja

- akan

- menulis

- tertulis

- kamu

- Anda

- zephyrnet.dll

Rakhna Chadha adalah Arsitek Solusi Utama AI/ML dalam Akun Strategis di AWS. Rachna adalah seorang optimis yang percaya bahwa penggunaan AI secara etis dan bertanggung jawab dapat meningkatkan masyarakat di masa depan dan membawa kemakmuran ekonomi dan sosial. Di waktu luangnya, Rachna suka menghabiskan waktu bersama keluarganya, mendaki gunung, dan mendengarkan musik.

Rakhna Chadha adalah Arsitek Solusi Utama AI/ML dalam Akun Strategis di AWS. Rachna adalah seorang optimis yang percaya bahwa penggunaan AI secara etis dan bertanggung jawab dapat meningkatkan masyarakat di masa depan dan membawa kemakmuran ekonomi dan sosial. Di waktu luangnya, Rachna suka menghabiskan waktu bersama keluarganya, mendaki gunung, dan mendengarkan musik. Dr.Kyle Ulrich adalah Ilmuwan Terapan dengan

Dr.Kyle Ulrich adalah Ilmuwan Terapan dengan  Christopher Whitten adalah pengembang perangkat lunak di tim JumpStart. Dia membantu menskalakan pemilihan model dan mengintegrasikan model dengan layanan SageMaker lainnya. Chris bersemangat untuk mempercepat keberadaan AI di berbagai domain bisnis.

Christopher Whitten adalah pengembang perangkat lunak di tim JumpStart. Dia membantu menskalakan pemilihan model dan mengintegrasikan model dengan layanan SageMaker lainnya. Chris bersemangat untuk mempercepat keberadaan AI di berbagai domain bisnis. Dr.Fabio Nonato de Paula adalah Manajer Senior, Spesialis GenAI SA, yang membantu penyedia model dan pelanggan menskalakan AI generatif di AWS. Fabio memiliki hasrat untuk mendemokratisasi akses terhadap teknologi AI generatif. Di luar pekerjaan, Anda bisa menemukan Fabio mengendarai sepeda motornya di perbukitan Lembah Sonoma atau membaca ComiXology.

Dr.Fabio Nonato de Paula adalah Manajer Senior, Spesialis GenAI SA, yang membantu penyedia model dan pelanggan menskalakan AI generatif di AWS. Fabio memiliki hasrat untuk mendemokratisasi akses terhadap teknologi AI generatif. Di luar pekerjaan, Anda bisa menemukan Fabio mengendarai sepeda motornya di perbukitan Lembah Sonoma atau membaca ComiXology. Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP. Karl Albertsen memimpin produk, teknik, dan sains untuk Algoritma Amazon SageMaker dan JumpStart, pusat pembelajaran mesin SageMaker. Dia bersemangat menerapkan pembelajaran mesin untuk membuka nilai bisnis.

Karl Albertsen memimpin produk, teknik, dan sains untuk Algoritma Amazon SageMaker dan JumpStart, pusat pembelajaran mesin SageMaker. Dia bersemangat menerapkan pembelajaran mesin untuk membuka nilai bisnis.