Makalah teknis berjudul “Solusi inferensi LLM yang Efisien pada GPU Intel” diterbitkan oleh para peneliti di Intel Corporation.

Abstrak:

“Model Bahasa Besar (LLM) berbasis transformator telah banyak digunakan di banyak bidang, dan efisiensi inferensi LLM menjadi topik hangat dalam aplikasi nyata. Namun, LLM biasanya dirancang secara rumit dalam struktur model dengan operasi besar-besaran dan melakukan inferensi dalam mode regresi otomatis, sehingga merancang sistem dengan efisiensi tinggi merupakan tugas yang menantang.

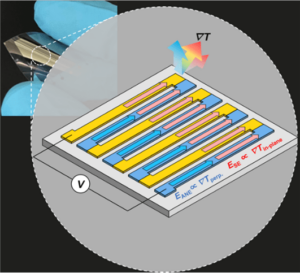

Dalam makalah ini, kami mengusulkan solusi inferensi LLM yang efisien dengan latensi rendah dan throughput tinggi. Pertama, kami menyederhanakan lapisan dekoder LLM dengan menggabungkan pergerakan data dan operasi berbasis elemen untuk mengurangi frekuensi akses memori dan menurunkan latensi sistem. Kami juga mengusulkan kebijakan cache KV segmen untuk menyimpan kunci/nilai token permintaan dan respons dalam memori fisik terpisah untuk manajemen memori perangkat yang efektif, membantu memperbesar ukuran batch runtime dan meningkatkan throughput sistem. Kernel Scaled-Dot-Product-Attention yang disesuaikan dirancang agar sesuai dengan kebijakan fusi kami berdasarkan solusi cache KV segmen. Kami menerapkan solusi inferensi LLM pada GPU Intel dan mempublikasikannya secara publik. Dibandingkan dengan implementasi standar HuggingFace, solusi yang diusulkan mencapai latensi token hingga 7x lebih rendah dan throughput 27x lebih tinggi untuk beberapa LLM populer pada GPU Intel.”

Cari makalah teknis di sini. Diterbitkan Desember 2023 (pracetak).

Wu, Hui, Yi Gan, Feng Yuan, Jing Ma, Wei Zhu, Yutao Xu, Hong Zhu, Yuhua Zhu, Xiaoli Liu, dan Jinghui Gu. “Solusi inferensi LLM yang efisien pada GPU Intel.” arXiv pracetak arXiv:2401.05391 (2023).

Bacaan Terkait

Inferensi LLM Pada CPU (Intel)

Makalah teknis berjudul “Inferensi LLM Efisien pada CPU” diterbitkan oleh para peneliti di Intel.

AI Berlomba Menuju Keunggulan

Inferensi dan beberapa pelatihan didorong ke perangkat yang lebih kecil seiring penyebaran AI ke aplikasi baru.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://semiengineering.com/llm-inference-on-gpus-intel/

- :adalah

- $NAIK

- 2023

- a

- mengakses

- Mencapai

- AI

- juga

- an

- dan

- aplikasi

- ADALAH

- AS

- At

- berdasarkan

- menjadi

- menjadi

- makhluk

- by

- Cache

- menantang

- dibandingkan

- PERUSAHAAN

- disesuaikan

- data

- Desember

- Mendesain

- dirancang

- alat

- Devices

- Efektif

- efisiensi

- efisien

- memperbesar

- Fields

- Untuk

- Frekuensi

- sekering

- fusi

- GPU

- GPU

- Memiliki

- membantu

- di sini

- High

- lebih tinggi

- Hong

- PANAS

- Namun

- HTTPS

- MemelukWajah

- melaksanakan

- implementasi

- memperbaiki

- in

- Intel

- IT

- jpg

- Menjaga

- bahasa

- besar

- Latensi

- lapisan

- lm

- Rendah

- menurunkan

- Membuat

- pengelolaan

- banyak

- besar-besaran

- Cocok

- Memori

- mode

- model

- model

- gerakan

- New

- of

- on

- Buka

- Operasi

- kami

- kertas

- melakukan

- fisik

- plato

- Kecerdasan Data Plato

- Data Plato

- kebijaksanaan

- Populer

- mengusulkan

- diusulkan

- di depan umum

- menerbitkan

- diterbitkan

- terdorong

- balapan

- nyata

- menurunkan

- permintaan

- peneliti

- tanggapan

- ruas

- terpisah

- menyederhanakan

- Ukuran

- lebih kecil

- larutan

- beberapa

- Spread

- standar

- struktur

- sistem

- tugas

- Teknis

- Grafik

- ini

- keluaran

- berjudul

- untuk

- token

- Token

- tema

- Pelatihan

- bekas

- biasanya

- adalah

- we

- sangat

- dengan

- Yuan

- zephyrnet.dll