Jay Dawani a társaság társalapítója és vezérigazgatója Lemurian Labs, egy startup, amely egy kifejezetten mesterséges intelligencia alkalmazásokhoz szabott gyorsított számítási platformot fejleszt. A platform áttöri a hardveres akadályokat, hogy a mesterséges intelligencia fejlesztését gyorsabbá, olcsóbbá, fenntarthatóbbá és több vállalat számára elérhetővé tegye.

A Lemurian megalapítása előtt Jay két másik céget alapított a mesterséges intelligencia területén. Ő a szerzője a legjobban értékelt „Matematika a mély tanuláshoz. "

A mesterséges intelligencia, a robotika és a matematika szakértőjeként Jay a blokklánc-alapú játékplatformot építő közvállalat, a BlocPlay technológiai igazgatójaként dolgozott, és a GEC mesterséges intelligencia igazgatójaként dolgozott, ahol számos különböző területet lefedő ügyfélprojekt fejlesztését vezette. a kiskereskedelemtől, az algoritmikus kereskedéstől, a fehérjehajtogatástól, az űrkutatási robotoktól, az ajánlórendszerektől és még sok mástól. Szabadidejében a NASA Frontier Development Lab, a Spacebit és a SiaClassic tanácsadója is volt.

Amikor legutóbb bemutattuk a Lemurian Labs-t, Ön a robotikára és az élvonalbeli AI-ra összpontosított. Most az adatközpontokra és a felhőinfrastruktúrára összpontosít. Mi történt, ami miatt elfordulni akartál?

Valójában áttértünk a nagy teljesítményű, alacsony késleltetésű, rendszer-chip kialakítására az autonóm robotikai alkalmazásokhoz, amelyek felgyorsíthatnák a teljes érzékelési terv-cselekvés hurkot, egy tartományspecifikus gyorsító felépítésére az AI számára, amely az adatközponti méretű alkalmazásokra összpontosít. . De ez nem csak egy közönséges forgáspont volt; harsány hívás volt, úgy éreztük, hogy felelősségünk van válaszolni.

2018-ban egy 2.1 milliárd dolláros paramétermodell kiképzésén dolgoztunk, de feladtuk az erőfeszítést, mert a költségek olyan rendkívül magasak voltak, hogy nem tudtuk indokolni. Képzelje el a meglepetésemet, hogy a GPT3, amelyet az OpenAI ChatGPT néven 2022 novemberében adott ki, 175 milliárd dolláros paramétermodell volt. Ez a modell több mint 80-szor nagyobb, mint amin mindössze 4 évvel korábban dolgoztunk, ami egyszerre izgalmas és ijesztő.

Egy ilyen modell kiképzésének költsége enyhén szólva megdöbbentő. A jelenlegi skálázási trendek alapján arra számíthatunk, hogy a határ menti AI-modell képzésének költsége a nem túl távoli jövőben meghaladhatja az egymilliárd dollárt. Bár ezeknek a modelleknek a képességei elképesztőek lesznek, a költségek nevetségesen magasak. Ezen a pályán alapulva csak néhány, saját adatközponttal rendelkező, jól erőforrásokkal rendelkező vállalat engedheti meg magának, hogy betanítsa, telepítse és finomhangolja ezeket a modelleket. Ez nem pusztán azért van így, mert a számítások drága és energiaéhesek, hanem azért is, mert a szoftverkészleteket, amelyekre támaszkodunk, nem erre a világra készültek.

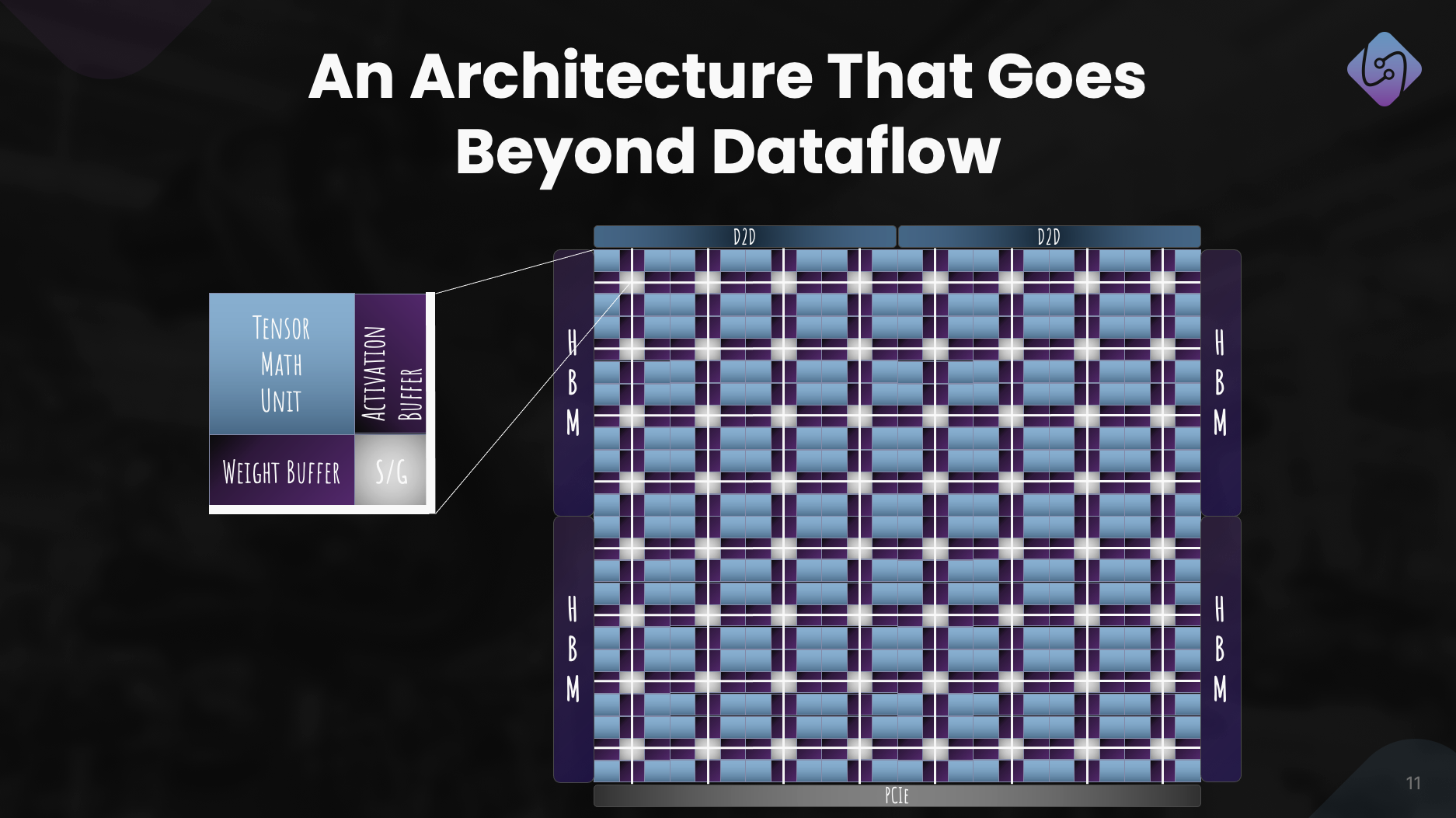

A földrajzi és energiakorlátok miatt csak nagyon sok hely van az adatközpontok építésére. A mesterséges intelligencia számítási igényeinek kielégítéséhez képesnek kell lennünk zetta méretű gépek megépítésére anélkül, hogy 20 atomreaktorra lenne szükségük az energiaellátáshoz. Praktikusabb, skálázhatóbb és gazdaságosabb megoldásra van szükségünk. Körülnéztünk, és nem láttunk senkit a megoldás felé vezető úton. Így hát elmentünk a rajzasztalhoz, hogy holisztikusan, mint rendszerek rendszereként szemléljük a problémát, és az első elvek alapján okoskodjunk a megoldásról. Feltettük magunknak a kérdést, hogyan terveznénk meg a teljes stacket a szoftvertől a hardverig, ha napi 10 milliárd LLM-lekérdezést kellene gazdaságosan kiszolgálnunk. 200-ra egy 2028 MW alatti zettaméretű gépet tűztünk ki célul.

A trükk az, hogy az aránytalan skálázás szemszögéből nézzük – a rendszer különböző részei eltérő skálázási szabályokat követnek, így egy ponton a dolgok egyszerűen leállnak, tönkremennek, vagy a költség-haszon kompromisszumnak nincs értelme. Ha ez megtörténik, az egyetlen lehetőség a rendszer újratervezése. Értékelésünk és megoldásunk holisztikusan felöleli a munkaterhelést, a számrendszert, a programozási modellt, a fordítót, a futásidőt és a hardvert.

Szerencsére meglévő befektetőink és a piac többi része látja a jövőképet, és 9 millió dollárt gyűjtöttünk össze számformátumunk – PAL – fejlesztésére, hogy feltárjuk a tervezési teret, és konvergáljunk a tartományspecifikus gyorsítónk architektúrájához, és megtervezzük fordító és futtatókörnyezet. A szimulációk során 20-szoros átviteli teljesítménynövekedést tudtunk elérni a modern GPU-knál kisebb energiahordozó mellett, és azt tervezzük, hogy ugyanazon tranzisztortechnológián a teljes birtoklási költség mellett 8-szoros előnyt biztosítunk a rendszer teljesítményében.

Mondanunk sem kell, hogy sok munka vár ránk, de nagyon izgatottak vagyunk az adatközponti gazdaságosság újradefiniálása miatt, hogy biztosítsuk a jövőt, ahol az AI mindenki számára bőségesen elérhető.

Ez minden bizonnyal izgalmasan hangzik, és ezek a számok lenyűgözően hangzanak. De említetted a számrendszereket, a hardvert, a fordítókat és a futtatókörnyezetet, mint minden olyan dolgot, amelyre összpontosítasz – ez minden cég számára nagyon sok dolognak tűnik egyszerre. Nagyon kockázatos ajánlatnak tűnik. Nem kellene a startupoknak jobban összpontosítaniuk?

Nagyon sokféle erőfeszítésnek hangzik, de valójában ez egy erőfeszítés sok egymással összefüggő részből. Ha csak az egyik összetevőt oldjuk meg a többitől elkülönítve, az csak hátráltatja az innovációs potenciált, mert figyelmen kívül hagyja a rendszerszintű hatástalanságokat és szűk keresztmetszeteket. Jensen Huang ezt mondta a legjobban: „Ahhoz, hogy gyorsított számítástechnikai vállalat legyen, teljes stack vállalatnak kell lennie”, és ezzel teljes mértékben egyetértek. Nem okkal a jelenlegi piacvezetők. De megkérdőjelezném azt az elképzelést, hogy nem vagyunk összpontosítva. Arra összpontosítunk, hogy hogyan gondolkodunk holisztikusan a problémáról, és hogyan tudjuk azt a legjobban megoldani ügyfeleink számára.

Ehhez olyan multidiszciplináris megközelítésre van szükség, mint a miénk. Munkánk minden része tájékoztatja és támogatja a többieket, lehetővé téve számunkra, hogy olyan megoldást alkossunk, amely sokkal több, mint a részek összege. Képzeld el, ha versenyautót kellene építened. Nem választana önkényesen egy alvázat, adna hozzá versenyabroncsokat, és nem dobná be a talált legerősebb motort, és versenyezne vele, igaz? Gondolkodni kellene az autó karosszériájának aerodinamikáján a légellenállás csökkentése és a leszorítóerő növelése érdekében, a súlyeloszlás optimalizálása a jó kezelhetőség érdekében, a motor egyedi tervezése a maximális teljesítmény érdekében, a túlmelegedés megelőzése érdekében hűtőrendszer kialakítása, a vezető biztonsága érdekében bukóketrec kialakítása stb. Ezen elemek mindegyike a másikra épül, és tájékoztatja a másikat.

Ennek ellenére kockázatos mindent egyszerre megtenni bármely iparág bármelyik vállalatánál. A kockázatok kezelése érdekében szakaszos megközelítést alkalmazunk, lehetővé téve számunkra, hogy technológiánkat hitelesítsük az ügyfelekkel, és szükség szerint módosítsuk stratégiánkat. Bebizonyítottuk, hogy a számformátumunk működik, és jobb teljesítmény-teljesítmény-területtel rendelkezik, mint az egyenértékű lebegőpontos típusok, ugyanakkor jobb numerikus tulajdonságokkal rendelkezik, amelyek megkönnyítik a neurális hálózatok kisebb bitszélességekre történő kvantálását. Olyan architektúrát terveztünk, amiben magabiztosnak érezzük magunkat, és amely mind képzésre, mind következtetésre alkalmas. De mindezeknél még fontosabb a megfelelő szoftver beszerzése, és ez áll a figyelmünk nagy részében. Gondoskodnunk kell arról, hogy a megfelelő döntéseket hozzuk meg a szoftverkészletünkben ahhoz képest, ahol a világot látjuk egy-két év múlva vagy még tovább.

Egy hardvergyártó cég felépítése nehéz, drága és sok időt vesz igénybe. A szoftverre való összpontosítás először önmagában is életképes üzletnek tűnik, és a jelenlegi helyzetben vonzóbb lehet a befektetők számára. Miért csinálsz hardvert is, mivel a térségben olyan sok jól finanszírozott cég bezárja kapuit, nehezen veszik át az ügyfeleket, és a nagyobb szereplők saját hardvert építenek?

Abban teljesen igazad van, hogy a szoftvervállalkozások általában sokkal könnyebben tudtak tőkét bevonni, mint a hardvercégek, és a hardver nagyon kemény. Jelenleg nagy hangsúlyt fektetünk a szoftverekre, mert ott látjuk a nagyobb problémát. Hadd mondjak tisztán, a probléma nem az, hogy képes-e nagy teljesítményű CPU-n vagy GPU-n futtatni a kerneleket; ez egy régóta megoldott probléma. Napjaink problémája az, hogy hogyan könnyíthetjük meg a fejlesztők számára, hogy több ezer, heterogén számításokból álló csomópontfürtből több ezer csomóponti fürtből produktívan nagyobb teljesítményt érjenek el anélkül, hogy munkafolyamatuk felülvizsgálatára kérnénk őket.

Ez az a probléma, amelynek megoldására jelenleg egy olyan szoftverkészlettel összpontosítunk, amely szuperképességeket biztosít a fejlesztőknek, és felszabadítja a raktári méretű számítógépek teljes képességét, így gazdaságosabban oktathatjuk és telepíthetjük az AI-modelleket.

Nos, ami a befektetést illeti, igen, a kockázatitőke-társaságok szelektívebben választják ki, hogy milyen cégeket támogatnak, de ez azt is jelenti, hogy a kockázatitőke-társaságok olyan vállalatokat keresnek, amelyek képesek igazán úttörő termékeket kínálni, amelyeknek egyértelmű útja van a kereskedelmi forgalomba hozatalhoz, miközben jelentős hatásuk van. Tanultunk mások kihívásaiból és hibáiból, és aktívan alakítottuk ki üzleti modellünket és ütemtervenket a kockázatok kezelése érdekében. Azt is fontos megjegyezni, hogy az induló vállalkozásokat ritkán az tette sikeressé, hogy milyen könnyen tudnak kockázatitőke-finanszírozást szerezni, hanem inkább a találékonyságukhoz, makacsságukhoz és ügyfélközpontúságukhoz van köze.

És mielőtt megkérdeznéd, még mindig dolgozunk a hardveren, de jelenleg elsősorban a szimuláción. Egy darabig nem áll szándékunkban rögzíteni. De ezt a beszélgetést elmenthetjük egy másik alkalomra.

Ez minden bizonnyal meggyőző, és az Ön szakaszos megközelítése nagyon eltér attól, amit más hardvergyártó cégeknél láttunk. Megértem a problémát, amelyet a szoftververem megoldani fog, de miben különbözik az Ön szoftvere a piac különböző erőfeszítéseitől?

A legtöbb cég, amelyre hivatkozik, a GPU-k programozásának megkönnyítésére összpontosít azáltal, hogy csempe-alapú vagy feladatleképező programozási modelleket vezet be a GPU-k teljesítményének növelése érdekében, vagy új programozási nyelveket épít a nagy teljesítményű kernelek ütemezése érdekében különböző rendszerekre. platformok soron belüli összeszerelés támogatásával. Ezek fontos problémák, amelyekkel foglalkoznak, de a megoldandó problémát szinte ortogonálisnak látjuk.

Gondoljunk egy pillanatra a hardveres és szoftveres átmenetek ütemére. Az egymagos architektúrák teljesítménye az órajel és a tranzisztorsűrűség miatt nőtt, de végül az órajelek elérte a platót. A sok magot használó párhuzamosság megkerülte ezt, és jelentős gyorsításokat biztosított. A szoftvereknek nagyjából egy évtizedbe telt, mire felzárkóztak, mert újra kellett gondolni a programozási modelleket, a fordítókat és a futtatókörnyezeteket, hogy segítsék a fejlesztőket ebben a paradigmában. Ezután a GPU-k általános célú gyorsítókká kezdtek válni, ismét egy másik programozási modellel. Ismét csaknem egy évtizedbe telt, mire a fejlesztők itt értéket tudtak kitermelni.

A hardver ismét egy fennsíkra ér – a Moore-törvény, az energia- és hőkorlátok, a memória szűk keresztmetszete, a munkaterhelések sokfélesége, valamint az exponenciálisan több számításigény arra késztet bennünket, hogy egyre heterogénebb számítógép-architektúrákat építsünk a jobb teljesítmény, hatékonyság és összköltség érdekében. Ez a hardverváltás természetesen kihívásokat fog jelenteni a szoftverek számára, mivel nem rendelkezünk megfelelő fordítókkal és futtatókörnyezetekkel, amelyek támogatnák a számítástechnika következő fejlődését. Ezúttal azonban nem kell további 10 évet várnunk arra, hogy a szoftverek kivonják a heterogén architektúrák vagy nagy klaszterek értékét, különösen akkor, ha azok több mint 80%-ban kihasználatlanok.

Arra összpontosítunk, hogy heterogenitás-tudatos programozási modellt építsünk fel feladatalapú párhuzamossággal, a hordozható teljesítményt több processzor optimalizálásával, környezettudatos fordítással és dinamikus erőforrás-elosztással kezeljük. Számunkra pedig teljesen mindegy, hogy CPU, GPU, TPU, SPU (Lemúriai architektúra) vagy mindegyik háló. Tudom, hogy ez sok fantáziadús szónak hangzik, de valójában az az, hogy lehetővé tettük bármilyen processzor programozását egyetlen megközelítéssel, és minimális költséggel átvihetjük a kódot egyik processzorfajtáról a másikra. erőfeszítést anélkül, hogy fel kellene áldoznia a teljesítményt, és a munkát adaptívan és dinamikusan ütemezheti a csomópontokon keresztül.

Ha igaz, amit mond, akkor teljesen újradefiniálhatja a számítástechnikát. Beszéljünk a finanszírozásról. Tavaly 9 millió dollárnyi magvető finanszírozást gyűjtött össze, ami erős befektetői támogatást és az Ön elképzelésébe vetett hitet jelzi. Mit csináltál azóta?

Az elmúlt évben, a magvető finanszírozásnak köszönhetően jelentős előrelépéseket tettünk. Jelenleg 20 tagú csapatunkkal aprólékosan kezeltük a kihívásokat, kapcsolatba léptünk az ügyfelekkel, és finomítottuk megközelítésünket.

A PAL fejlesztésére összpontosítottunk a képzés és a következtetések levonására, megvizsgáltuk a gyorsítónk számítógépes architektúráját, és kifejlesztettünk egy szimulátort a teljesítménymérőkhöz. Ezzel párhuzamosan újragondoltuk az adatközponti alkalmazásokhoz szükséges szoftvercsomagunkat, hangsúlyozva a heterogén számítástechnikát.

Ez az erőfeszítés egy jól definiált architektúrát eredményezett, amely a PAL hatékonyságát mutatja be a mesterséges intelligencia terén. A technológiai fejlődésen túlmenően a hozzáférés demokratizálása érdekében együttműködést és kapcsolatfelvételt folytattunk. Ezek az erőfeszítések arra késztetik a Lemurian Labs-t, hogy megbirkózzanak az ügyfelek azonnali kihívásaival, és felkészüljenek a termelési szilícium kiadására.

Mik a Lemurian Labs középtávú tervei a szoftververem fejlesztésével, együttműködésével és a gyorsító architektúrájának fejlesztésével kapcsolatban?

Közvetlen célunk egy olyan szoftvercsomag létrehozása, amely a hordozható teljesítményű CPU-kat, GPU-kat és AI-gyorsítóinkat célozza meg, és amelyet az év végén elérhetővé teszünk a partnereink számára. Jelenleg a legtöbb vezető félvezető-gyártó céggel, felhőszolgáltatóval, hiperskálázóval és mesterséges intelligencia-céggel folytatunk párbeszédet, hogy hozzáférést biztosítsunk fordítóinkhoz és futtatókörnyezetünkhöz. Ezzel párhuzamosan tovább dolgozunk és fejlesztjük gyorsítónk architektúráját egy valóban közösen tervezett hardver- és szoftverrendszer érdekében. És természetesen most kezdtük meg az A sorozatunk emelését a befektetői közösség nagy érdeklődése mellett, ami lehetővé teszi számunkra, hogy bővítsük csapatunkat, és teljesítsük a szoftvertermékek év végi szállítására vonatkozó célunkat.

Végezetül, hogyan látja, hogy a Lemurian Labs hozzájárul a mesterséges intelligencia fejlesztésének, a hozzáférhetőségnek és a méltányosságnak a megváltoztatásához az elkövetkező években?

Nem szándékoztunk újradefiniálni a számítástechnikát csak kereskedelmi haszonszerzés vagy szórakozás céljából. Lemúriaiakként az a hajtóerőnk, hogy hiszünk a mesterséges intelligencia átalakító potenciáljában, és abban, hogy néhány vállalatnál többnek kell rendelkeznie azokkal az erőforrásokkal, amelyek meghatározhatják e technológia jövőjét és felhasználási módját. Azt sem tartjuk elfogadhatónak, hogy a mesterséges intelligencia adatközponti infrastruktúrája jó úton halad afelé, hogy 20-ra a világ energiájának akár 2030%-át is elfogyassza. Mindannyian azért jöttünk össze, mert hiszünk abban, hogy a társadalom számára jobb út vezet, ha megtehetjük. A mesterséges intelligencia elérhetőbbé válik azáltal, hogy jelentősen csökkenti a kapcsolódó költségeket, felgyorsítja az AI innovációjának ütemét és kiterjeszti annak hatását. A jelenlegi hardver-infrastruktúra kihívásainak megoldásával arra törekszünk, hogy egymilliárd embert lássunk el az AI képességeivel, biztosítva ennek a fejlett technológiának a méltányos elosztását. Reméljük, hogy a termékközpontú megoldások, az együttműködés és a folyamatos innováció iránti elkötelezettségünk hajtóerőt jelent az AI-fejlesztés jövőjének pozitív alakításában.

Is Read:

Oszd meg ezt a bejegyzést ezen keresztül:

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :van

- :is

- :nem

- :ahol

- 9 millió $

- $ UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Képes

- Rólunk

- teljesen

- gyorsul

- felgyorsult

- gázpedál

- gyorsítók

- elfogadható

- hozzáférés

- megközelíthetőség

- hozzáférhető

- Elérése

- át

- aktívan

- hozzá

- cím

- címzett

- címzés

- állítsa

- Örökbefogadás

- fejlett

- Fejlett technológia

- fejlesztések

- tanácsadó

- újra

- előre

- AI

- AI modellek

- algoritmikus

- algoritmikus kereskedés

- Minden termék

- kiosztás

- lehetővé téve

- majdnem

- Is

- amazon

- an

- és a

- Másik

- válasz

- bármilyen

- bárki

- tetszetős

- alkalmazások

- megközelítés

- önkényesen

- építészet

- architektúrák

- VANNAK

- területek

- körül

- mesterséges

- mesterséges intelligencia

- AS

- kérdez

- kér

- Assembly

- értékelés

- társult

- meghökkentő

- At

- szerző

- autonóm

- elérhető

- vissza

- akadályok

- alapján

- BE

- mert

- egyre

- óta

- előtt

- hogy

- hit

- Hisz

- haszon

- BEST

- Jobb

- Túl

- nagyobb

- Billió

- blockchain alapú

- bizottság

- test

- mindkét

- szűk

- Törés

- szünetek

- bővül

- épít

- Épület

- épít

- épült

- ömlesztett

- üzleti

- üzleti modell

- vállalkozások

- de

- by

- hanglejtés

- hívás

- jött

- TUD

- Kaphat

- képességek

- képesség

- tőke

- Fogás

- Központ

- vezérigazgató

- Vezérigazgatói interjú

- biztosan

- kihívás

- kihívások

- változó

- alváz

- ChatGPT

- olcsóbb

- világos

- vásárló

- Klíma

- óra

- záró

- felhő

- felhő infrastruktúra

- Társalapító

- kód

- együttműködés

- együttműködések

- érkező

- kereskedelmi

- kereskedelmi

- elkötelezettség

- közösség

- Companies

- vállalat

- képest

- kényszerítő

- fordítóprogram

- teljesen

- alkatrészek

- Kiszámít

- számítógép

- számítógépek

- számítástechnika

- magabiztos

- korlátok

- fogyaszt

- folytatódik

- folyamatos

- hozzájáruló

- konvergálni

- Beszélgetés

- beszélgetések

- hűtőrendszer

- kijavítására

- Költség

- tudott

- tanfolyam

- fedő

- CPU

- teremt

- Kereszt

- CTO

- Jelenlegi

- Jelenleg

- szokás

- egyéni tervezés

- vevő

- Ügyfelek

- dátum

- Adatközpont

- Datacenter

- nap

- évtized

- határozatok

- mély

- meghatározott

- szállít

- kézbesítés

- igények

- demokratizálni

- sűrűség

- telepíteni

- Design

- tervezett

- Fejleszt

- fejlett

- fejlesztők

- fejlesztése

- Fejlesztés

- DID

- különböző

- különbséget

- Igazgató

- Távoli

- terjesztés

- Sokféleség

- do

- nem

- Nem

- Ennek

- dollár

- domain

- csinált

- ne

- ajtók

- drámaian

- rajz

- gépkocsivezető

- vezetés

- Csepp

- dinamikus

- dinamikusan

- minden

- Korábban

- Korai

- könnyebb

- könnyen

- gazdaságosan

- Közgazdaságtan

- él

- hatékonyság

- hatékonyság

- erőfeszítés

- erőfeszítések

- elemek

- hangsúlyozva

- képessé

- lehetővé

- lehetővé téve

- felöleli

- végén

- energia

- elkötelezett

- Motor

- növelése

- fokozása

- biztosítására

- biztosítása

- Egész

- igazságos

- részvény

- Egyenértékű

- különösen

- stb.

- végül is

- mindenki

- evolúció

- haladja meg

- izgatott

- izgalmas

- létező

- vár

- drága

- szakértő

- kutatás

- feltárása

- feltárt

- exponenciálisan

- kivonat

- rendkívüli módon

- tény

- képzelet

- messze

- gyorsabb

- jellegű

- érez

- hiba

- kevés

- Találjon

- vezetéknév

- úszó

- Összpontosít

- összpontosított

- összpontosítás

- következik

- Lábnyom

- A

- Kényszer

- formátum

- Előre

- Alapított

- alapító

- ból ből

- Határ

- táplálta

- Tele

- Teljes verem

- teljesen

- móka

- finanszírozás

- jövő

- Az AI jövője

- Nyereség

- szerzett

- szerencsejáték

- játékplatform

- hajtómű

- általános

- általában

- földrajzi

- kap

- szerzés

- Ad

- adott

- ad

- cél

- megy

- jó

- kapott

- GPU

- GPU

- úttörő

- Nő

- kellett

- maréknyi

- Kezelés

- történt

- megtörténik

- hardver

- Legyen

- tekintettel

- he

- segít

- itt

- Magas

- akadályozzák

- övé

- Találat

- ütő

- remény

- Hogyan

- How To

- HTTPS

- huang

- Éhes

- i

- if

- kép

- azonnali

- Hatás

- fontos

- hatásos

- javul

- javulás

- in

- egyre inkább

- ipar

- elégtelenségek

- tájékoztatja

- Infrastruktúra

- Innováció

- Intelligencia

- szándékozik

- összekapcsolt

- kamat

- Interjú

- bevezetéséről

- beruházás

- befektető

- Befektetők

- szigetelés

- IT

- ITS

- jensen huang

- jpg

- éppen

- Tart

- Kedves

- Ismer

- labor

- Labs

- táj

- Nyelvek

- nagy

- nagyobb

- keresztnév

- Tavaly

- Késleltetés

- Törvény

- vezető

- vezető

- tanult

- legkevésbé

- Led

- hadd

- mint

- ll

- llm

- Hosszú

- hosszú idő

- hosszabb

- néz

- nézett

- keres

- Sok

- Elő/Utó

- leeresztés

- gép

- gép

- készült

- csinál

- KÉSZÍT

- Gyártás

- kezelése

- sok

- piacára

- Piacvezető

- matematika

- Anyag

- max-width

- maximális

- Lehet..

- me

- eszközök

- Találkozik

- Partnerek

- Memory design

- említett

- csupán

- háló

- aprólékosan

- Metrics

- millió

- minimális

- hibákat

- modell

- modellek

- modern

- pillanat

- több

- a legtöbb

- sok

- multidiszciplináris

- my

- Nasa

- Szükség

- szükséges

- igénylő

- hálózatok

- ideg-

- neurális hálózatok

- Új

- következő

- nem

- csomópont

- csomópontok

- megjegyezni

- fogalom

- november

- Most

- nukleáris

- szám

- számok

- of

- ajánlat

- on

- egyszer

- ONE

- csak

- OpenAI

- optimalizáció

- Optimalizálja

- opció

- or

- érdekében

- rendes

- Más

- Egyéb

- mi

- magunkat

- ki

- megkereső

- felett

- Nagyjavítás

- saját

- tulajdon

- Béke

- paradigma

- Párhuzamos

- paraméter

- rész

- partnerek

- alkatrészek

- múlt

- ösvény

- egyengetni

- Emberek (People)

- teljesítmény

- A szakaszos

- vedd

- tengely

- Helyek

- tervek

- emelvény

- Platformok

- Plató

- Platón adatintelligencia

- PlatoData

- plusz

- pont

- Nézőpont

- hordozható

- pozíció

- pozíciók

- pozitív

- lehetséges

- állás

- potenciális

- potenciálisan

- hatalom

- erős

- Gyakorlati

- szép

- megakadályozása

- elsősorban

- elvek

- Probléma

- problémák

- feldolgozás

- Processzor

- Termékek

- Termelés

- Termékek

- Program

- Programozás

- programozási nyelvek

- projektek

- ingatlanait

- ajánlat

- kilátás

- Fehérje

- igazolt

- feltéve,

- szolgáltatók

- nyilvános

- tisztán

- cél

- Toló

- lekérdezések

- Futam

- verseny

- emel

- emelt

- emelés

- ritkán

- Olvass

- tényleg

- ok

- Ajánlást

- újradefiniál

- újratervezés

- csökkenteni

- utaló

- kifinomult

- tekintettel

- újragondolt

- engedje

- felszabaduló

- támaszkodnak

- megköveteli,

- forrás

- Tudástár

- felelősség

- REST

- eredményezett

- Eredmények

- kiskereskedelem

- jobb

- kockázatok

- Kockázatos

- ütemterv

- robotika

- robotok

- Tekercs

- nagyjából

- körül

- szabályok

- futás

- sacrificar

- biztonságos

- Mondott

- azonos

- Megtakarítás

- azt mondják

- mondás

- skálázható

- Skála

- skálázás

- menetrend

- tervezett

- lát

- mag

- Magvető finanszírozás

- Vetőmag kerek

- Keresnek

- Úgy tűnik,

- látott

- szelektív

- félvezető

- értelemben

- Series of

- A sorozat

- szolgál

- szolgált

- szolgáltatás

- szolgáltatók

- készlet

- számos

- formálás

- váltás

- kellene

- kirakatba

- Látnivalók

- jelentős

- jelzi

- Szilícium

- tettetés

- szimulációk

- szimulátor

- egyszerre

- óta

- egyetlen

- jókora

- Csúszik

- kisebb

- So

- Társadalom

- szoftver

- megoldások

- Megoldások

- SOLVE

- megoldott

- Megoldása

- néhány

- hang

- hangok

- Hely

- űrkutatás

- térbeli

- különleges

- kifejezetten

- sebesség

- sebesség

- verem

- Stacks

- tántorgó

- kezdet

- kezdődött

- indítás

- Startups

- Még mindig

- megáll

- Stratégia

- léptekkel

- erős

- küzd

- sikeres

- ilyen

- megfelelő

- összeg

- támogatás

- Támogatja

- feltételezett

- meglepetés

- fenntartható

- rendszer

- szisztémás

- Systems

- szabott

- Vesz

- tart

- bevétel

- Beszél

- szalag

- cél

- célok

- csapat

- tech

- Technológia

- mint

- hogy

- A

- A jövő

- A táj

- a világ

- azok

- Őket

- akkor

- Ott.

- termikus

- Ezek

- ők

- dolgok

- Szerintem

- ezt

- azok

- bár?

- ezer

- Keresztül

- áteresztőképesség

- idő

- gumiabroncsok

- nak nek

- Ma

- együtt

- is

- vett

- Végösszeg

- kemény

- felé

- vágány

- Kereskedés

- Vonat

- Képzések

- röppálya

- átalakító

- átmenet

- átmenetek

- Trends

- trükk

- igaz

- valóban

- megpróbál

- kettő

- típusok

- alatt

- megért

- egység

- kinyitja

- upon

- us

- használ

- segítségével

- ÉRVÉNYESÍT

- érték

- különféle

- VC

- VC finanszírozás

- VC

- nagyon

- keresztül

- életképes

- Megnézem

- látomás

- várjon

- akar

- Raktár

- volt

- we

- súly

- JÓL

- jól definiált

- ment

- voltak

- Mit

- amikor

- vajon

- ami

- míg

- miért

- lesz

- val vel

- nélkül

- szavak

- Munka

- munkafolyamat

- dolgozó

- művek

- világ

- világ

- lenne

- év

- év

- Igen

- te

- A te

- zephyrnet